企业级规模化AI模型训练实践参考指南

企业级规模化AI模型训练实践参考指南

·

文章目录

企业级规模化AI模型微调最佳实践指南

引言:在数字世界中培育智能的浪漫

-

当我们谈论企业级AI模型微调时,我们其实是在见证一场跨越硅基与碳基边界的浪漫邂逅——将冰冷的数学模型,培育成能够理解业务需求、感知市场脉搏的智能伙伴。就像园丁精心照料每一株植物,我们用数据灌溉模型,用算法修剪参数,用耐心等待它成长为独当一面的"数字员工"。

-

在这个过程中,分布式训练是我们与时间的浪漫赛跑,容错机制是对长期陪伴的承诺,智能调度是平衡热情与理性的艺术,而参数高效微调则是心有灵犀的默契——无需从零开始,只需在关键处轻轻点拨,便能让模型与业务需求完美契合。

-

这不仅仅是技术的堆叠,更是一场关于信任、耐心与创新的旅程。当我们将这些实践经验凝结成指南时,我们也在记录着人类与AI携手共进的浪漫篇章。

- 以下是企业级AI模型微调的核心实践要点,让我们一同开启这段智能培育之旅:

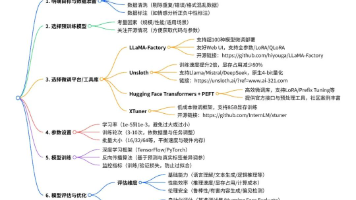

- 分布式训练架构设计:资源利用率与训练效率双提升。

- 高可用容错恢复机制:保障长期训练任务连续性。

- 智能训练调度策略:成本优化与效率平衡。

- 精细化资源管理与内存优化:最大化硬件投资回报。

- 多源异构数据处理框架:适配复杂业务数据场景。

- 参数高效微调(PEFT)实践:快速业务适配与成本控制。

- 全生命周期模型版本管理:风险管控与团队协作。

- 实时可观测性与监控体系:运营风险预警与透明化。

- 企业级安全合规保障:数据安全与监管要求落地。

- 模型部署与推理优化:从训练到生产的全链路优化。

分布式训练架构设计

企业级模型微调优先采用分布式训练的核心考量:

- 资源利用率最大化:充分利用现有GPU集群资源,避免昂贵硬件闲置,降低单位训练成本。

- 训练效率显著提升:模型单卡训练需15-20天,4卡分布式训练可压缩至4-8天,大幅度减少训练时间。

- 大模型训练可行性:分布式架构突破单卡硬件(如显存)瓶颈。

企业级分布式训练实践配置:

# 主流分布式框架配置示例

from transformers import TrainingArguments

# DeepSpeed分布式训练配置

training_args = TrainingArguments(

output_dir="./finetune_output",

per_device_train_batch_size=4, # 每卡训练批次大小

gradient_accumulation_steps=8, # 梯度累积步数,等效扩大总批次

learning_rate=2e-5,

num_train_epochs=3,

deepspeed="ds_config.json", # DeepSpeed配置文件

fp16=True, # 混合精度训练

)

高可用容错恢复机制

企业级长期训练任务必须具备高容错能力的原因:

- 业务连续性保障:多日/周级训练任务中断将导致巨大时间与成本损失

- 资源成本控制:GPU资源按小时计费,中断重启意味着直接经济损失与资源排队等待

- 训练稳定性要求:企业级任务对训练结果可靠性要求极高,容不得意外中断

企业级容错恢复策略:

# 智能断点检测与恢复机制

import os

from transformers import Trainer

def resume_training(trainer, checkpoint_dir="./finetune_output"):

"""自动检测最新 checkpoint 并恢复训练"""

if os.path.exists(checkpoint_dir):

# 获取所有 checkpoint 目录

checkpoints = [d for d in os.listdir(checkpoint_dir)

if d.startswith("checkpoint-")]

if checkpoints:

# 按步骤号排序,获取最新 checkpoint

latest_checkpoint = sorted(checkpoints,

key=lambda x: int(x.split("-")[-1]))[-1]

latest_checkpoint_path = os.path.join(checkpoint_dir, latest_checkpoint)

print(f"检测到最新 checkpoint: {latest_checkpoint_path}")

return trainer.train(resume_from_checkpoint=latest_checkpoint_path)

# 无 checkpoint 则从头开始训练

return trainer.train()

智能训练调度策略

企业级训练需要智能调度的核心原因:

- 成本优化:避免过度训练导致的GPU资源浪费与模型过拟合

- 效率平衡:在模型性能与训练时间之间找到最优平衡点

- 自动化运营:减少人工监控成本,提升训练流程自动化程度

企业级智能调度实践:

# 智能早停与学习率调度集成

from transformers import EarlyStoppingCallback, get_linear_schedule_with_warmup

# 智能早停配置

earliestopping_callback = EarlyStoppingCallback(

early_stopping_patience=5, # 连续5次评估无改善则停止

early_stopping_threshold=0.002, # 性能改善阈值

metric_for_best_model="eval_loss"

)

# 动态学习率调度

total_steps = len(train_dataloader) * training_args.num_train_epochs \

// training_args.gradient_accumulation_steps

lr_scheduler = get_linear_schedule_with_warmup(

optimizer=optimizer,

num_warmup_steps=total_steps * 0.1, # 10%步数用于热身

num_training_steps=total_steps

)

精细化资源管理与内存优化

企业级模型微调需精细化资源管理的原因:

- 硬件投资回报最大化:通过内存优化技术,将80GB显存需求的任务压缩到24GB显存完成

- 集群资源高效利用:支持更多并发训练任务,提高集群整体吞吐量

- 降低硬件采购成本:减少对高端GPU的依赖,降低企业硬件投入

企业级内存优化策略:

# 综合内存优化配置

from transformers import AutoModelForCausalLM

# 模型加载时的内存优化

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-2-70b-hf",

torch_dtype=torch.float16, # 半精度加载

low_cpu_mem_usage=True, # 低CPU内存占用模式

device_map="auto", # 自动设备映射

load_in_8bit=True, # 8-bit量化加载(可选)

)

# 训练时的内存优化技术

training_args = TrainingArguments(

output_dir="./finetune_output",

per_device_train_batch_size=2,

gradient_accumulation_steps=16,

gradient_checkpointing=True, # 梯度检查点技术

remove_unused_columns=True, # 移除未使用的数据列

fp16=True, # 混合精度训练

)

多源异构数据处理框架

企业级模型微调必须支持多源异构数据的原因:

- 业务数据复杂性:企业数据来源多样(结构化/非结构化、文本/图像、实时/离线)

- 数据孤岛问题解决:统一处理管道整合所有数据源,实现数据价值最大化

- 业务场景覆盖全面:支持多业务线数据融合,提升模型泛化能力

企业级数据处理实践:

# 多源异构数据处理框架

from datasets import Dataset, concatenate_datasets

import pandas as pd

class EnterpriseDataProcessor:

"""企业级多源异构数据处理器"""

def __init__(self, data_paths):

self.data_paths = data_paths

def process_single_turn_data(self, item):

"""处理单轮对话数据"""

return {

"input": item["question"],

"output": item["answer"]

}

def process_multi_turn_data(self, item):

"""处理多轮对话数据"""

conversation = []

for msg in item["messages"]:

conversation.append(f"{msg['role']}: {msg['content']}")

return {

"input": "\n".join(conversation[:-1]),

"output": conversation[-1].split(": ")[-1]

}

def load_and_process(self):

"""加载并处理所有数据源"""

datasets = []

for path in self.data_paths:

if path.endswith(".json"):

ds = Dataset.from_json(path)

elif path.endswith(".csv"):

df = pd.read_csv(path)

ds = Dataset.from_pandas(df)

# 根据数据类型自动选择处理方式

if "messages" in ds.column_names:

ds = ds.map(self.process_multi_turn_data)

else:

ds = ds.map(self.process_single_turn_data)

datasets.append(ds)

# 合并所有数据集

return concatenate_datasets(datasets)

# 使用示例

data_processor = EnterpriseDataProcessor([

"./data/single_turn_data.json",

"./data/multi_turn_data.csv",

"./data/enterprise_knowledge.json"

])

train_dataset = data_processor.load_and_process()

参数高效微调(PEFT)实践

企业级场景采用PEFT技术的核心优势:

- 快速业务适配:基础大模型训练成本高昂,PEFT可在预训练模型基础上快速适配特定业务场景

- 成本大幅降低:仅训练0.1%-5%的模型参数,训练成本降低95%以上

- 模型管理便捷:一个基础模型+多个LoRA适配器,比维护多个完整模型更经济高效

- 多业务线并行支持:支持同时为多个业务线训练轻量级适配器

企业级PEFT配置实践:

# 基于LoRA的参数高效微调配置

from peft import LoraConfig, TaskType, get_peft_model

from transformers import AutoModelForCausalLM

# 加载基础模型

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-2-70b-hf",

torch_dtype=torch.float16,

device_map="auto"

)

# LoRA配置优化

def get_optimal_lora_config(model_type="llama"):

"""根据模型类型返回最优LoRA配置"""

if model_type == "llama":

target_modules = [

"q_proj", "v_proj", "k_proj", "o_proj",

"gate_proj", "up_proj", "down_proj"

]

elif model_type == "mistral":

target_modules = ["q_proj", "v_proj"]

return LoraConfig(

task_type=TaskType.CAUSAL_LM,

r=32, # 低秩分解维度,平衡性能与效率

lora_alpha=64, # 缩放因子,通常为r的2倍

target_modules=target_modules, # 目标适配模块

lora_dropout=0.1, # Dropout率,防止过拟合

bias="none", # 不训练偏置项

inference_mode=False # 训练模式

)

# 获取PEFT模型

lora_config = get_optimal_lora_config("llama")

peft_model = get_peft_model(model, lora_config)

# 查看可训练参数比例

trainable_params = sum(p.numel() for p in peft_model.parameters() if p.requires_grad)

total_params = sum(p.numel() for p in peft_model.parameters())

print(f"可训练参数: {trainable_params/total_params*100:.3f}%")

全生命周期模型版本管理

企业级模型必须具备完善版本管理的原因:

- 业务风险管控:支持快速回滚到稳定版本,应对新模型上线性能回退风险

- 监管合规要求:完整记录模型开发、训练、部署全流程,满足审计需求

- 团队协作效率:支持多团队并行开发,清晰的版本分支管理

- A/B测试支持:便于同时维护多个模型版本,支持在线对比测试

企业级模型版本管理实践:

# 模型版本管理与自动化保存

import os

from datetime import datetime

class ModelVersionManager:

"""企业级模型版本管理器"""

def __init__(self, base_dir="./model_registry"):

self.base_dir = base_dir

os.makedirs(base_dir, exist_ok=True)

def get_version_dir(self, model_name, version=None):

"""生成版本目录路径"""

if version is None:

# 自动生成版本号(基于时间戳)

version = datetime.now().strftime("v%Y%m%d_%H%M%S")

return os.path.join(self.base_dir, model_name, version)

def save_model(self, model, tokenizer, model_name, metadata=None):

"""保存模型并记录元数据"""

version_dir = self.get_version_dir(model_name)

os.makedirs(version_dir, exist_ok=True)

# 保存模型与分词器

model.save_pretrained(version_dir)

tokenizer.save_pretrained(version_dir)

# 保存元数据

if metadata:

import json

with open(os.path.join(version_dir, "metadata.json"), "w") as f:

json.dump(metadata, f, indent=2, ensure_ascii=False)

return version_dir

def get_latest_version(self, model_name):

"""获取最新模型版本"""

model_dir = os.path.join(self.base_dir, model_name)

if not os.path.exists(model_dir):

return None

versions = sorted(os.listdir(model_dir), reverse=True)

return versions[0] if versions else None

# 使用示例

version_manager = ModelVersionManager()

metadata = {

"base_model": "meta-llama/Llama-2-70b-hf",

"peft_type": "lora",

"train_dataset": "enterprise_all_data_v1",

"eval_loss": 0.852,

"training_duration": "2d 12h 30m",

"git_commit": "a1b2c3d4e5f6"

}

# 保存训练完成的模型

model_dir = version_manager.save_model(

peft_model,

tokenizer,

"enterprise_chatbot",

metadata

)

finetune_output/

├── checkpoint-300/ # 训练检查点

├── checkpoint-600/

├── best_lora_model/ # 最佳LoRA模型

├── best_complete_model/ # 最佳完整模型

├── final_lora_model/ # 最终LoRA模型

├── final_complete_model/ # 最终完整模型

└── best_model_info.txt # 最佳模型元信息

实时可观测性与监控体系

企业级训练需要全方位监控的原因:

- 运营风险预警:实时发现训练异常,避免资源浪费

- 资源使用优化:监控GPU/CPU/内存使用情况,优化资源配置

- 模型性能跟踪:实时跟踪训练指标,及时调整训练策略

- 团队协作透明化:训练进度与结果可视化,便于团队协作

企业级监控实践配置:

# 多维度训练监控配置

from transformers import TrainingArguments

from transformers.integrations import TensorBoardCallback

# 训练参数配置

training_args = TrainingArguments(

output_dir="./finetune_output",

per_device_train_batch_size=4,

gradient_accumulation_steps=8,

logging_dir="./logs", # TensorBoard日志目录

logging_steps=10, # 每10步记录一次日志

eval_steps=500, # 每500步评估一次

save_steps=1000, # 每1000步保存一次模型

save_total_limit=5, # 最多保存5个检查点

metric_for_best_model="eval_loss", # 最佳模型评估指标

load_best_model_at_end=True, # 训练结束加载最佳模型

report_to=["tensorboard", "wandb"], # 同时支持多个监控平台

fp16=True,

deepspeed="ds_config.json",

)

# 自定义监控回调

class EnterpriseTrainingCallback:

def on_step_end(self, args, state, control, **kwargs):

"""每步结束时执行"""

if state.global_step % 100 == 0:

# 记录系统资源使用情况

import psutil

import torch

cpu_usage = psutil.cpu_percent()

memory_usage = psutil.virtual_memory().percent

gpu_memory = torch.cuda.memory_allocated() / 1024**3 if torch.cuda.is_available() else 0

# 可将监控数据发送到企业监控系统

print(f"Step {state.global_step}: CPU={cpu_usage}%, Memory={memory_usage}%, GPU Mem={gpu_memory:.2f}GB")

# 初始化训练器

from transformers import Trainer

trainer = Trainer(

model=peft_model,

args=training_args,

train_dataset=train_dataset,

eval_dataset=eval_dataset,

data_collator=data_collator,

callbacks=[

TensorBoardCallback(),

EnterpriseTrainingCallback(),

EarlyStoppingCallback(early_stopping_patience=5)

]

)

企业级安全合规保障

企业级模型训练必须满足安全合规要求的原因:

- 数据安全保护:训练数据可能包含敏感信息,需防止数据泄露

- 模型权重安全:核心模型权重是企业重要资产,需加密存储与传输

- 合规监管要求:满足GDPR、CCPA等数据保护法规要求

- 访问权限控制:严格控制模型训练、访问、部署的权限

企业级安全合规配置:

# 企业级安全合规配置示例

from transformers import TrainingArguments

# 训练安全配置

training_args = TrainingArguments(

output_dir="./finetune_output",

per_device_train_batch_size=4,

gradient_accumulation_steps=8,

# 数据安全相关配置

remove_unused_columns=True, # 移除未使用的敏感数据列

load_best_model_at_end=True,

# 模型安全相关配置

save_strategy="steps",

save_steps=1000,

save_total_limit=5, # 限制保存的模型数量,减少泄露风险

# 日志安全配置

logging_steps=10,

logging_strategy="steps",

report_to=["tensorboard"], # 避免敏感数据上传到第三方平台

# 硬件安全配置

fp16=True,

deepspeed="ds_config.json",

)

# 企业级模型加密保存

def save_model_with_encryption(model, save_dir, encryption_key):

"""使用企业密钥加密保存模型"""

import torch

import hashlib

# 生成加密密钥的哈希值

key_hash = hashlib.sha256(encryption_key.encode()).digest()

# 保存模型状态字典

model_state = model.state_dict()

# 简单加密示例(企业级场景建议使用更安全的加密算法)

encrypted_state = {}

for k, v in model_state.items():

encrypted_state[k] = v + torch.tensor([int(key_hash[i%32]) for i in range(v.numel())]).reshape(v.shape).to(v.device)

# 保存加密后的模型

torch.save(encrypted_state, os.path.join(save_dir, "model_encrypted.bin"))

# 访问权限控制示例

def check_user_permission(user_id, action):

"""检查用户是否有权执行特定操作"""

# 企业级权限管理系统集成

permission_matrix = {

"admin": ["train", "deploy", "delete"],

"engineer": ["train", "deploy"],

"researcher": ["train"]

}

user_role = get_user_role(user_id) # 从企业身份系统获取用户角色

return action in permission_matrix.get(user_role, [])

模型部署与推理优化

企业级模型从训练到生产的最后一公里:

- 推理效率优化:模型量化、蒸馏、图优化等技术提升推理速度,降低部署成本

- 部署架构设计:支持高并发、低延迟的服务部署架构

- 动态扩缩容:根据业务流量自动调整服务资源

- A/B测试支持:方便进行模型版本对比测试

企业级模型部署优化:

# 模型量化与推理优化示例

from transformers import AutoModelForCausalLM, AutoTokenizer

import torch

from peft import PeftModel

# 加载并合并基础模型与LoRA适配器

def load_and_merge_model(base_model_path, lora_path):

"""加载并合并基础模型与LoRA适配器"""

# 加载基础模型

base_model = AutoModelForCausalLM.from_pretrained(

base_model_path,

torch_dtype=torch.float16,

device_map="auto",

)

# 加载分词器

tokenizer = AutoTokenizer.from_pretrained(base_model_path)

# 加载LoRA适配器

model = PeftModel.from_pretrained(

base_model,

lora_path,

torch_dtype=torch.float16,

)

# 合并LoRA权重到基础模型

model = model.merge_and_unload()

return model, tokenizer

# 模型量化优化

def quantize_model(model):

"""对模型进行量化优化,提升推理效率"""

from transformers import BitsAndBytesConfig

# 4-bit量化配置

bnb_config = BitsAndBytesConfig(

load_in_4bit=True,

bnb_4bit_quant_type="nf4",

bnb_4bit_compute_dtype=torch.float16,

bnb_4bit_use_double_quant=True,

)

# 动态量化

quantized_model = torch.quantization.quantize_dynamic(

model,

{torch.nn.Linear}, # 仅量化线性层

dtype=torch.qint8 # 8-bit量化

)

return quantized_model

# 推理优化配置

def optimize_for_inference(model):

"""优化模型推理性能"""

if torch.cuda.is_available():

# 使用TorchScript优化

model = torch.jit.trace(model, torch.randint(0, 1000, (1, 10)).to(model.device))

model = torch.jit.freeze(model)

# 启用模型评估模式

model.eval()

return model

# 使用示例

# 加载并合并模型

model, tokenizer = load_and_merge_model(

"meta-llama/Llama-2-70b-hf",

"./model_registry/enterprise_chatbot/v20240101_120000"

)

# 模型优化

model = quantize_model(model)

model = optimize_for_inference(model)

# 推理服务部署(企业级场景建议使用FastAPI、Triton等框架)

from fastapi import FastAPI

from pydantic import BaseModel

app = FastAPI()

class InferenceRequest(BaseModel):

input: str

max_length: int = 512

@app.post("/inference")

def inference(request: InferenceRequest):

"""推理API端点"""

inputs = tokenizer(request.input, return_tensors="pt").to(model.device)

with torch.no_grad():

outputs = model.generate(

**inputs,

max_length=request.max_length,

temperature=0.7,

top_p=0.9

)

response = tokenizer.decode(outputs[0], skip_special_tokens=True)

return {"output": response}

总结

- 企业级模型微调是一个系统工程,需要综合考虑分布式架构、容错机制、资源管理、数据处理、PEFT技术、版本管理、监控体系、安全合规以及部署优化等多个维度。本文提供了企业级模型微调的实践指南,涵盖了从训练到部署的全生命周期管理,在保障模型质量的同时,最大化硬件投资回报,提升训练效率,降低运营成本。

- 在实际应用中,应根据自身业务场景、硬件资源、团队能力等因素,选择合适的技术方案与实践策略,持续优化模型微调流程,打造高效、可靠、安全的企业级AI训练体系。

更多推荐

已为社区贡献64条内容

已为社区贡献64条内容

所有评论(0)