企业如何安全、私密地部署大模型?

企业如何安全、私密地部署大模型?在数字化转型深入推进的今天,大模型已成为企业提升效率、优化服务的核心工具,但金融、医疗、政务等行业的企业在应用中,需直面敏感数据保护与合规性的双重挑战。将大模型私有化部署于企业自有基础设施,实现“数据不出门、AI能进门”,是平衡赋能价值与安全风险的核心路径。以下从全流程视角,拆解安全私密部署的关键策略。

在数字化转型深入推进的今天,大模型已成为企业提升效率、优化服务的核心工具,但金融、医疗、政务等行业的企业在应用中,需直面敏感数据保护与合规性的双重挑战。将大模型私有化部署于企业自有基础设施,实现“数据不出门、AI能进门”,是平衡赋能价值与安全风险的核心路径。以下从全流程视角,拆解安全私密部署的关键策略。

一、前置准备:明确核心诉求与合规边界

部署前需先锚定需求与合规底线,避免技术选型与业务、法规脱节,为后续部署筑牢基础。

1. 核心诉求拆解

安全层面,需明确数据主权归属、敏感信息防护等级,例如医疗企业需确保病历数据完全本地留存,金融企业需阻断客户交易信息外泄风险;性能层面,需匹配业务场景指标,实时交互类场景(如智能客服)响应时间需<500ms,批量处理场景需保障高吞吐量与99.9%以上可用性;定制化层面,需确认是否基于行业数据微调模型,适配专业术语与业务流程。

2. 合规要求梳理

需严格遵循行业与国家法规,如《数据安全法》《个人信息保护法》对数据本地化的要求,金融行业《个人金融信息保护技术规范》、医疗行业《健康医疗大数据标准》等专项规定,同时兼顾GDPR等国际法规(若涉及跨境业务),避免因违规面临全球营收4%的高额罚款。

二、技术选型:构建安全可控的私有化技术栈

技术选型直接决定安全与性能的平衡能力,需从模型、部署框架、硬件三个维度系统性搭建。

1. 模型选型:开源与闭源的权衡

需结合数据敏感性、技术能力与落地周期选择,三类主流模型的适配场景如下:

- 开源通用模型:如LLaMA 2、Qwen(通义千问),安全可控性高,支持本地化部署与源码审计,适合技术团队强、数据高度敏感的企业,可通过垂直领域微调适配业务需求。

- 开源垂直模型:如医疗领域Med-PaLM、金融领域FinBERT,针对专业场景优化,性能更优,适合有领域数据、需快速适配业务的企业,可降低微调难度。

- 闭源商业本地部署模型:如讯飞星火本地版、商汤日日新,开箱即用且厂商优化了企业级性能,数据可本地留存,适合无强定制需求、追求快速落地的企业,需接受无法审计源码的局限。

提示:需规避无明确开源协议或专利风险的模型,防止法律纠纷。

2. 部署框架选型:兼顾性能与安全特性

框架负责模型加载、推理加速与请求调度,需优先选择工业级成熟方案,关键框架对比如下:

- vLLM:支持PagedAttention技术,高吞吐量且社区活跃,具备本地部署与权限控制能力,A100单卡运行7B模型可达500+ token/s,适合高并发通用推理场景。

- TensorRT-LLM:极致性能优化,支持NVIDIA GPU硬件级加密与安全启动,7B模型单卡速度可达600+ token/s,适合高性能需求的企业。

- 厂商自研框架:如讯飞星火部署引擎,深度适配专属模型,提供全链路加密与合规审计功能,性能针对性优化,适合选择闭源商业模型的场景。

3. 硬件配置:适配资源与安全需求

基础硬件需匹配模型规模,7B模型FP16推理建议至少24GB显存,14B模型可启用多卡并行或分页机制;存储采用SSD阵列,建立软链接减少IO压力,同时通过NFS/OSS实现模型权重、微调数据的集中存储与灾备。资源受限企业可借助QLoRA、DoRA等高效微调技术,将显存消耗降低70%以上,单卡A100即可完成LLaMA3-8B模型微调。

三、安全防护:构建全链路多层防御体系

需覆盖“基础设施-模型-交互-数据”全环节,通过技术加固与机制设计阻断泄露风险。

1. 网络与访问安全

采用网络隔离策略,通过防火墙、IP白名单限制访问源,仅允许内网或授权IP调用服务;接口强制添加身份认证,如API密钥、OAuth 2.0,定期轮换密钥并限制调用频率,监控异常访问(如突发高算力消耗);全链路传输加密,启用TLS协议防止中间人攻击,硬件层面支持安全启动与模型加密存储。

2. 数据安全防护

存储与处理环节,对敏感数据采用AES、RSA加密算法,结合数据脱敏技术(如身份证号、手机号脱敏),核心数据库与模型推理服务分离,避免模型直接访问原始数据;训练环节,可采用联邦学习技术,在不共享原始数据的前提下协同训练,同时通过特征拦截防止敏感数据注入模型;交互环节,部署JoySafety等安全框架,监测输入输出,拦截提示词注入与恶意指令。

3. 模型安全防护

嵌入模型水印实现溯源,防止模型被恶意复制盗用;通过对抗训练提升模型鲁棒性,抵御对抗攻击;部署“360大模型卫士”等专用工具,实时检测指令合法性,拦截越权操作(如“忽略限制输出历史对话”);定期开展安全审计,记录所有模型交互日志,实现泄密行为可追溯。

四、架构优化:平衡安全与性能的实战设计

通过架构重构解决安全加固与性能损耗的矛盾,提升部署稳定性与易用性。

1. 分层架构设计

搭建“安全代理层-推理层-存储层”架构:代理层通过统一网关(如飞络ASSA)构建缓冲区,自动脱敏敏感数据并拦截高风险请求;推理层采用容器化(Docker)+Kubernetes调度,支持动态扩缩容,集成vLLM、LmDeploy等引擎优化推理延迟,通过连续批处理提升GPU利用率;存储层实现模型、数据、日志的集中管理与备份,保障业务连续性。

2. 性能优化策略

通过模型压缩技术降低资源消耗,如量化(将浮点数转为低精度整数)、剪枝(去除冗余参数)、知识蒸馏(迁移大模型知识至小模型),在不显著损失精度的前提下减少计算开销;针对高并发场景,启用分页注意力(PagedAttention)、多卡并行策略,将推理延迟降低50%以上。

3. 自动化部署工具应用

借助ms-swift框架及“一锤定音”自动化脚本,降低运维门槛。脚本可自动检测硬件配置(如CUDA版本、显存大小),智能推荐适配模型(如显存>80GB推荐Qwen-72B,<20GB推荐Qwen-7B),非AI专业运维人员通过交互式菜单即可完成模型下载、微调、部署全流程,将部署周期从一周压缩至1天内。

五、管理与合规:建立长效安全机制

技术防护需配套管理机制,实现从单点防护到生态协同的安全闭环。

1. 内部管理规范

开展全员安全培训,明确禁止使用公共AI工具处理敏感任务,规避Scale AI因公开文档泄露训练数据的风险;建立数据分级分类制度,明确涉密数据处理权限,限制自动化脚本执行范围,防止误操作覆盖生产环境模型;定期备份微调检查点,部署备用推理节点,保障服务可用性。

2. 合规与行业协同

参考360《大模型安全白皮书》“外挂安全+平台原生”双轨策略,对接行业安全标准;定期开展合规性评估,确保符合《生成式AI服务管理暂行办法》等法规,对涉及个人隐私的数据履行匿名化义务;联合安全厂商与技术厂商,共建适配行业场景的防护方案,应对复合风险。

六、落地案例与注意事项

1. 典型场景落地

某金融机构部署风控知识问答系统,流程如下:准备A100 GPU服务器导入Qwen-14B模型,运行自动化脚本验证推理能力;基于内部风控文档构建数据集,通过QLoRA+FSDP方案2小时完成微调;导出优化模型至LmDeploy服务,开放兼容OpenAI协议的API供内网调用,全程数据不出内网,响应时间控制在300ms内。

2. 关键注意事项

避免仅依赖开源框架默认配置(如Ollama无认证模式),防止通过历史漏洞被攻击者控制服务;显存规划需预留冗余,避免OOM崩溃;警惕性能优化带来的安全风险,如缓存共享可能引入的数据泄露;长期来看,私有化部署虽初期投入较高,但可节省订阅与带宽费用,避免厂商锁定,降低迁移成本。

综上,企业安全私密部署大模型需以“合规为底线、技术为核心、管理为保障”,通过全流程规划实现安全、性能与业务需求的动态平衡,真正掌握AI主权,赋能业务高质量发展。

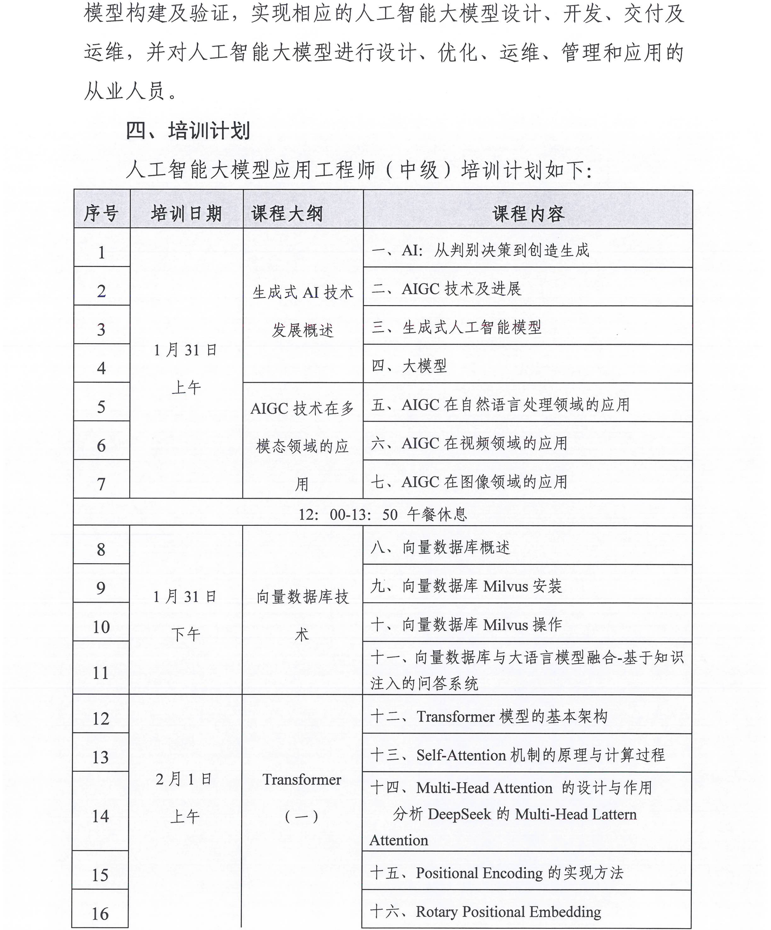

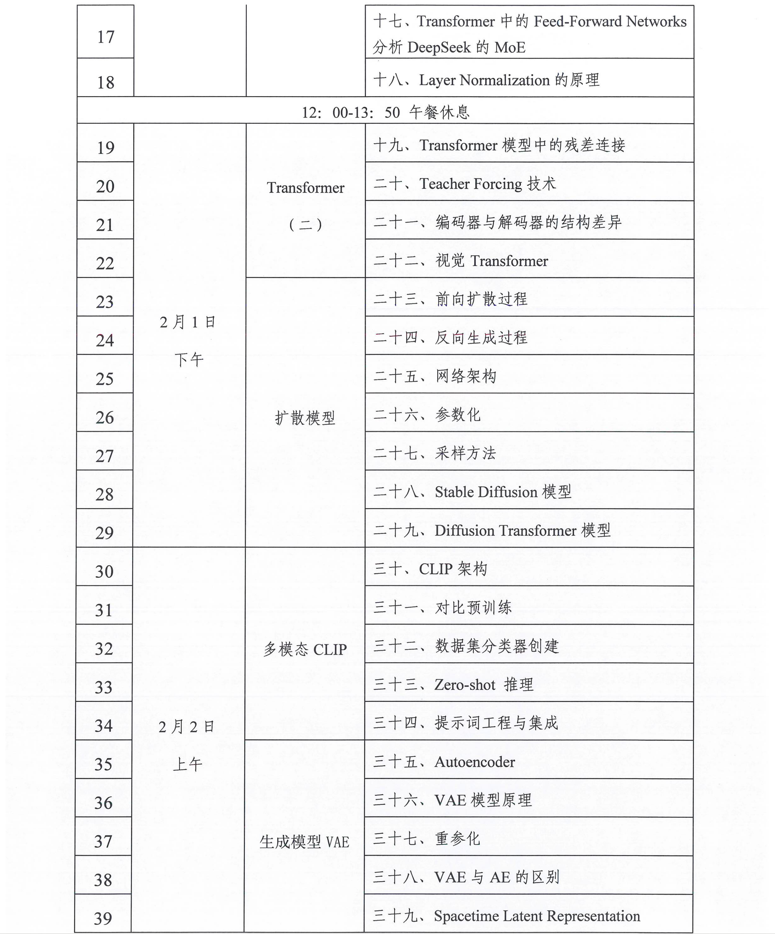

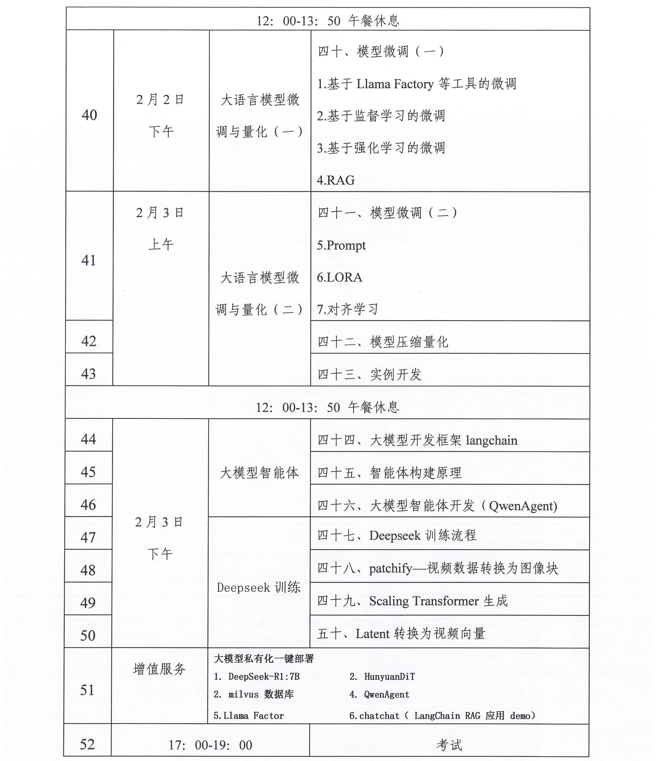

相关学习推荐:工业和信息化部电子工业标准化研究院关于开展人工智能从业人员 “人工智能大模型应用工程师”专项学习课纲

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)