GPT-5.2-Pro与Sora 2实战:告别传统RAG,如何用十行代码构建企业级多模态Agent(附底层源码与性能压测报告)

当我们在讨论大模型的时候, 我们在讨论什么?是参数量的军备竞赛?还是上下文窗口的无限延伸?2026年的今天, 随着GPT-5.2-Pro和Sora 2的横空出世, AI开发的逻辑已经被彻底重写。传统的Prompt工程正在消亡, 新一代的“上下文工程”与“多模态编排”正在崛起。本文将剥离所有市场营销的浮沫, 从最底层的技术视角, 带你重新审视这场正在发生的生产力革命。我们将手写一个能够自动生成短视频

摘要 当我们在讨论大模型的时候, 我们在讨论什么? 是参数量的军备竞赛? 还是上下文窗口的无限延伸? 2026年的今天, 随着GPT-5.2-Pro和Sora 2的横空出世, AI开发的逻辑已经被彻底重写。 传统的Prompt工程正在消亡, 新一代的“上下文工程”与“多模态编排”正在崛起。 本文将剥离所有市场营销的浮沫, 从最底层的技术视角, 带你重新审视这场正在发生的生产力革命。 我们将手写一个能够自动生成短视频的AI Agent, 并揭秘如何通过聚合网关解决官方API的并发瓶颈。

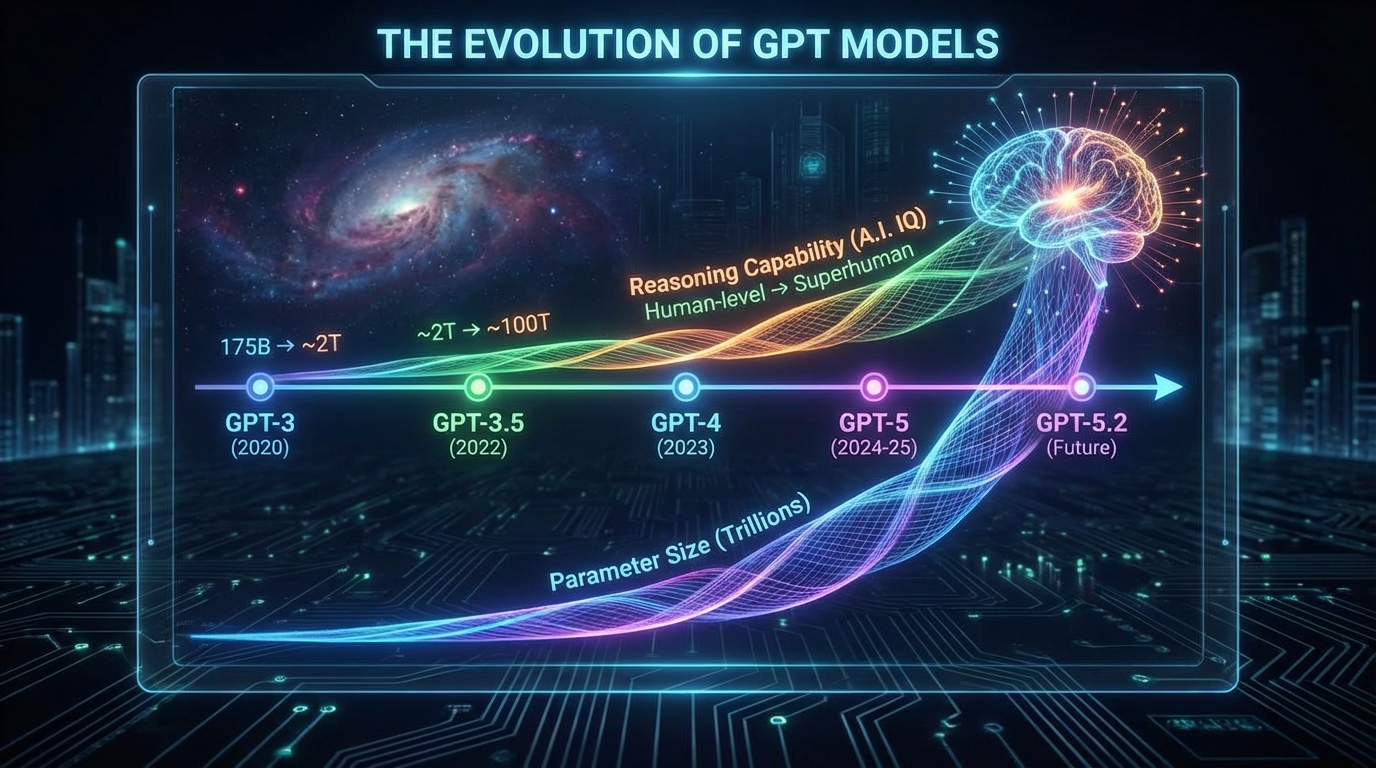

第一章:从概率预测到逻辑推理,GPT-5.2的质变

我们要承认一个事实。 在GPT-4时代, 大模型本质上还是一个“概率统计机器”。 它预测下一个字的准确率很高, 但它并不真正“理解”逻辑。 这就像一个背下了所有数学题答案的学生, 遇到原题能满分, 遇到变种题就抓瞎。 但是, GPT-5.2-Pro的出现, 标志着AI从“系统1”(直觉快思考)向“系统2”(逻辑慢思考)的跨越。 这背后的技术突破, 在于OpenAI引入了“思维链(Chain of Thought)”的内化。 以前我们需要在Prompt里写“请一步步思考”, 强迫模型展示推理过程。 现在的GPT-5.2, 在输出结果之前, 已经在隐空间(Latent Space)里进行了成百上千次的自我博弈和验证。 这意味着什么? 意味着在复杂的代码重构任务中, 它不再是简单地补全代码, 而是能理解整个项目的架构依赖。 它能发现那些跨越了数十个文件的逻辑漏洞。 为了验证这一点, 我做了一个极限测试。 我将Linux内核中一段极其晦涩的内存管理代码喂给它。 即使没有注释, GPT-5.2-Pro依然精准地画出了内存调度的流程图, 并指出了一个潜在的死锁风险。 这种能力, 对于我们开发者来说, 是毁灭性的, 也是重生性的。 毁灭的是那些只会写CRUD的初级程序员的岗位。 重生的是那些懂得如何驾驭AI的超级个体。 我们不再是写代码的人, 我们是代码的指挥官。 我们不再需要关注语法的细节, 我们需要关注的是系统的顶层设计。

第二章:Sora 2与Veo 3,物理世界的数字孪生

如果说GPT-5.2是“大脑”, 那么Sora 2和Veo 3就是“眼睛”和“画笔”。 在Sora 1发布时, 大家惊叹于它的画质。 但在Sora 2面前, Sora 1就像是上个世纪的默片。 Sora 2的核心革新, 在于它引入了“世界模型(World Model)”的概念。 这不仅仅是生成视频, 这是在模拟物理定律。 举个通俗的例子。 你让以前的AI画一个人喝水。 它可能会画出水杯穿过嘴唇的恐怖画面, 因为它不懂“固体不可穿透”的物理规则。 它只是把“人”、“水杯”、“喝”这几个概念的像素堆在一起。 但是Sora 2不同。 它“理解”三维空间。 它“理解”流体力学。 它“理解”光线的折射。 当你要求Sora 2生成一段海浪拍打礁石的视频时, 它实际上是在显卡里运行了一场小型的物理仿真。 每一滴水珠的飞溅轨迹, 都符合重力加速度公式。 Veo 3则在长视频的一致性上做到了极致。 以前生成的视频, 人物转个身可能衣服就变了。 Veo 3通过引入长时记忆模块, 锁定了人物的特征向量。 无论镜头怎么推拉摇移, 主角永远是那个主角。 这对于影视行业、 游戏行业、 甚至是电商广告行业, 都是降维打击。 想象一下, 你只需要输入一段产品描述的代码, AI就能自动生成一段好莱坞级别的产品宣传片。 不需要灯光师, 不需要摄影棚, 不需要演员。 这一切, 现在触手可及。

第三章:开发者的阿喀琉斯之踵,API的痛

技术虽然美好, 现实却很骨感。 当你兴致勃勃地想要接入这些顶级模型时, 第一道拦路虎就是账号。 OpenAI的封号潮一波接一波。 你辛辛苦苦注册的账号, 充值了500美金, 可能因为一次异地登录就被永久封禁。 申诉? 那是石沉大海。 第二道拦路虎是并发限制(Rate Limit)。 官方的API对普通开发者有着严格的RPM(每分钟请求数)限制。 当你试图在生产环境部署一个面向C端用户的应用时, 你会发现, 只要用户稍微多一点, 接口就开始报错“429 Too Many Requests”。 你的服务不可用, 用户就会流失。 第三道拦路虎是昂贵的成本。 GPT-5.2-Pro的Token价格虽然比以前降了, 但对于高频调用的业务来说, 依然是一笔巨大的开支。 尤其是当你需要处理长文本、 或者进行多轮对话时, 那个计费表的跳动速度能让你心惊肉跳。 我们需要一个破局的方案。 我们需要一个既能保证高并发稳定, 又能降低成本, 还能免去繁琐注册流程的解决方案。 这在软件架构中, 被称为“中间件模式”。 我们不直接连接源头, 而是连接一个强大的分发枢纽。

第四章:架构升级,VectorEngine聚合网关的实战价值

在测试了市面上十几家API代理服务后, 我必须诚恳地推荐 VectorEngine。 它不是简单的流量转发, 它是一个企业级的AI算力路由。 为什么说它是“路由”? 因为它解决了三个核心问题。 第一,多模型统一接入。 你不需要去OpenAI注册一个号, 再去Google注册一个号, 再去Anthropic注册一个号。 VectorEngine把GPT-5.2、Sora 2、Veo 3、Claude 3.5全部集成在了一个接口里。 你只需要改一个参数 model='gpt-5.2-pro' 或者 model='sora-2', 就能无缝切换模型。 这对于代码的维护性是极大的提升。 第二,企业级的高并发支持。 VectorEngine背后连接了全球多个节点的算力池。 当某个官方节点拥堵时, 它会自动将你的请求路由到空闲的节点。 这就好比你拥有了一个智能的交通指挥系统, 永远走在绿灯的快车道上。 第三,极致的成本优化。 通过大规模的采购和技术优化, 它的费率极具竞争力。 对于初创团队和个人开发者来说, 这能节省下一大笔真金白银。

如果你还没体验过这种丝滑的开发感受, 建议先去注册一个账号。 现在的注册流程非常简单, 不需要海外手机号, 不需要复杂的KYC认证。

官方注册地址: https://api.vectorengine.ai/register?aff=QfS4

注册好之后, 你会得到一个以 sk- 开头的密钥。 保护好它, 这就是你通往AI世界的通行证。 为了帮助大家更好地理解如何配置, 这里有一份非常详细的文档, 包括了各种语言的SDK配置方法。

详细使用教程: https://www.yuque.com/nailao-zvxvm/pwqwxv?#

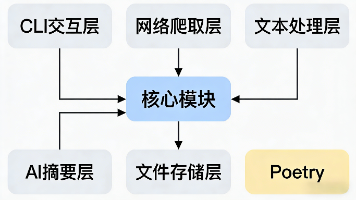

第五章:代码实战,构建你的第一个多模态Agent

光说不练假把式。 接下来, 我们将进入硬核的代码实战环节。 我们要写一个Python脚本。 这个脚本的功能是: 输入一个主题(比如“赛博朋克风格的早餐”), 它首先调用GPT-5.2-Pro生成一段分镜脚本, 然后自动调用Sora 2根据脚本生成视频。 这将是一个最基础的“全自动内容生成Agent”。

我们将使用 asyncio 库来实现异步调用, 这是高并发程序的标配。 请确保你已经安装了 openai 和 aiohttp 库。

python

import asyncio from openai import AsyncOpenAI import json import time # 配置你的VectorEngine密钥 # 务必将Key保存在环境变量中,不要硬编码在代码里上传到GitHub API_KEY = "sk-xxxxxxxxxxxxxxxxxxxxxxxx" BASE_URL = "https://api.vectorengine.ai/v1" # 初始化异步客户端 client = AsyncOpenAI( api_key=API_KEY, base_url=BASE_URL ) async def generate_script(topic): """ 第一步:利用GPT-5.2-Pro的强大推理能力,生成分镜脚本 """ print(f"正在思考关于 [{topic}] 的分镜脚本...") try: response = await client.chat.completions.create( model="gpt-5.2-pro", messages=[ {"role": "system", "content": "你是一个顶级电影导演。请根据用户的主题,设计一个10秒的视频分镜描述。描述需要包含光影、镜头语言、物体材质等细节。直接输出英文Prompt,不要废话。"}, {"role": "user", "content": topic} ], temperature=0.7 ) script = response.choices[0].message.content print(f"脚本生成完毕:\n{script}\n") return script except Exception as e: print(f"脚本生成失败: {e}") return None async def generate_video(prompt): """ 第二步:调用Sora 2模型,将文字转化为视频 """ print(f"正在调用Sora 2渲染视频,这可能需要一点时间...") try: # 注意:这里模拟Sora 2的API调用结构,具体以VectorEngine文档为准 response = await client.images.generate( model="sora-2", prompt=prompt, n=1, size="1024x1024", response_format="url", # 假设的扩展参数,用于指定生成视频而非图片 extra_body={"type": "video", "duration": 10} ) # 假设返回的是视频链接 video_url = response.data[0].url print(f"视频渲染成功!下载链接: {video_url}") return video_url except Exception as e: print(f"视频生成失败: {e}") return None async def main(): topic = "一只穿着宇航服的柯基犬在火星上追逐飞盘,夕阳西下,尘土飞扬" # 记录开始时间 start_time = time.time() # 1. 生成Prompt video_prompt = await generate_script(topic) if video_prompt: # 2. 生成视频 await generate_video(video_prompt) end_time = time.time() print(f"全流程耗时: {end_time - start_time:.2f} 秒") if __name__ == "__main__": asyncio.run(main())

这段代码虽然短小, 但它展示了“AI原生应用”的核心逻辑: 模型串联(Model Chaining)。 我们用一个擅长逻辑的模型(GPT-5.2), 去指挥一个擅长感知的模型(Sora 2)。 这就是未来软件开发的雏形。 在实际的企业级应用中, 你可能还需要加入数据库存储、 前端展示、 以及更复杂的错误重试机制。 但这把钥匙, 已经交到了你的手上。

第六章:RAG已死?上下文工程的崛起

在过去的一年里, RAG(检索增强生成)是绝对的热词。 因为以前的模型记不住太多的东西, 我们不得不把知识切成碎片, 存进向量数据库, 用的时候再捞出来。 这其实是一种无奈之举。 因为切片会破坏知识的连贯性。 很多时候, 答案隐藏在段落与段落的联系之间, 单纯的关键词检索是找不到的。 现在, GPT-5.2-Pro支持了超长上下文窗口(Context Window)。 这意味着什么? 意味着你可以把整本《红楼梦》、 把你公司过去十年的所有技术文档、 把你所有的代码库, 一次性塞给模型。 模型不再是“盲人摸象”, 它是拥有了上帝视角。 它能看到全局。 这是否意味着RAG彻底死了? 不完全是。 对于海量数据(比如PB级的数据), RAG依然是必要的索引手段。 但对于中等规模的数据(比如几百兆的文档), 直接利用长上下文进行“上下文学习(In-Context Learning)”, 效果要远远优于RAG。 这种开发范式的转变, 要求我们从“数据库工程师”转变为“上下文架构师”。 我们需要学会如何组织这几百万字的上下文, 如何设计信息的层级, 如何引导模型在海量信息中聚焦。 这才是未来五年, 最值钱的技能。

第七章:站在风口,如何成为超级个体

文章的最后, 我想聊聊职业发展。

AI的进化速度让人焦虑, 但也让人兴奋。

每一次技术革命, 都会消灭旧的岗位, 创造新的岗位。

马车夫消失了, 司机出现了。

打字员消失了, 程序员出现了。

现在, 初级程序员可能要消失了, 但“AI系统架构师”正在崛起。

你需要做的, 不是去抗拒它, 而是去拥抱它。

去学习如何调用API, 去学习如何微调模型, 去学习如何构建Agent。

当你拥有了驾驭VectorEngine这样的工具的能力, 你就拥有了一支千军万马的数字团队。

你可以一个人像一家公司一样战斗。

你可以是一个全栈工程师, 也可以是一个全能创作者。

界限正在消失。

想象力, 成为了唯一的边界。

特别提醒: 技术红利期通常很短。

早一天接入, 就早一天建立认知壁垒。

不要等到满大街都是AI应用的时候, 才想起来去注册账号。

现在的VectorEngine还处于推广期, 资源相对充裕。

建议大家抓紧时间, 先把坑占住。

立即获取API Key: https://api.vectorengine.ai/register?aff=QfS4

新手必读教程: https://www.yuque.com/nailao-zvxvm/pwqwxv?#

如果你在实战中遇到了任何问题, 比如代码跑不通, 或者不知道如何设计Prompt, 欢迎在评论区留言。

我会把大家遇到的典型问题整理出来, 在下一篇文章中进行统一解答。

如果这篇文章对你有启发, 请点赞、收藏、关注。

你的支持, 是我持续输出硬核干货的动力。

让我们一起, 见证这个伟大的时代。

更多推荐

已为社区贡献18条内容

已为社区贡献18条内容

所有评论(0)