手把手教学Windows部署Ollama+DeepSeek-R1+Cherry Studio打造本地AI聊天助手

本文提供Windows系统下从零部署本地AI问答系统的完整教程,包含Ollama框架安装、DeepSeek-R1模型部署和Cherry Studio配置三个核心步骤。教程详细说明硬件要求(16GB+内存、20GB存储)、软件下载地址及安装注意事项,指导用户完成模型拉取、测试验证及可视化界面连接。通过图文结合方式标注关键操作节点和常见问题,帮助用户快速搭建基于开源大模型的私有化知识问答系统,所有数据

本文为Windows系统下,从0到1完成Ollama安装、DeepSeek-R1模型部署、Cherry Studio安装个人AI聊天助手的完整教程,全程遵循“零基础能看懂、每步可复现”原则,标注关键注意事项和避坑点,助力快速搭建本地私有化问答系统。

一、前置准备:明确环境要求

部署前先确认电脑满足基础条件,避免后续踩坑:

-

系统版本:Windows 10/11 64位(优先推荐Windows 11,兼容性更优)

-

硬件要求:

-

内存:至少16GB(推荐32GB+,DeepSeek-R1运行需足够内存支撑,避免卡顿)

-

显卡:NVIDIA显卡(带CUDA核心)最佳,可开启GPU加速;无独显也可运行(纯CPU模式,推理速度稍慢)

-

硬盘:至少20GB空闲空间(Ollama框架+DeepSeek-R1模型约占用10-15GB,预留冗余空间)

-

-

网络要求:需能访问外网(用于拉取模型,访问慢可配置国内镜像)

-

其他:暂时关闭电脑杀毒软件实时防护(部分操作可能被误判为风险行为)

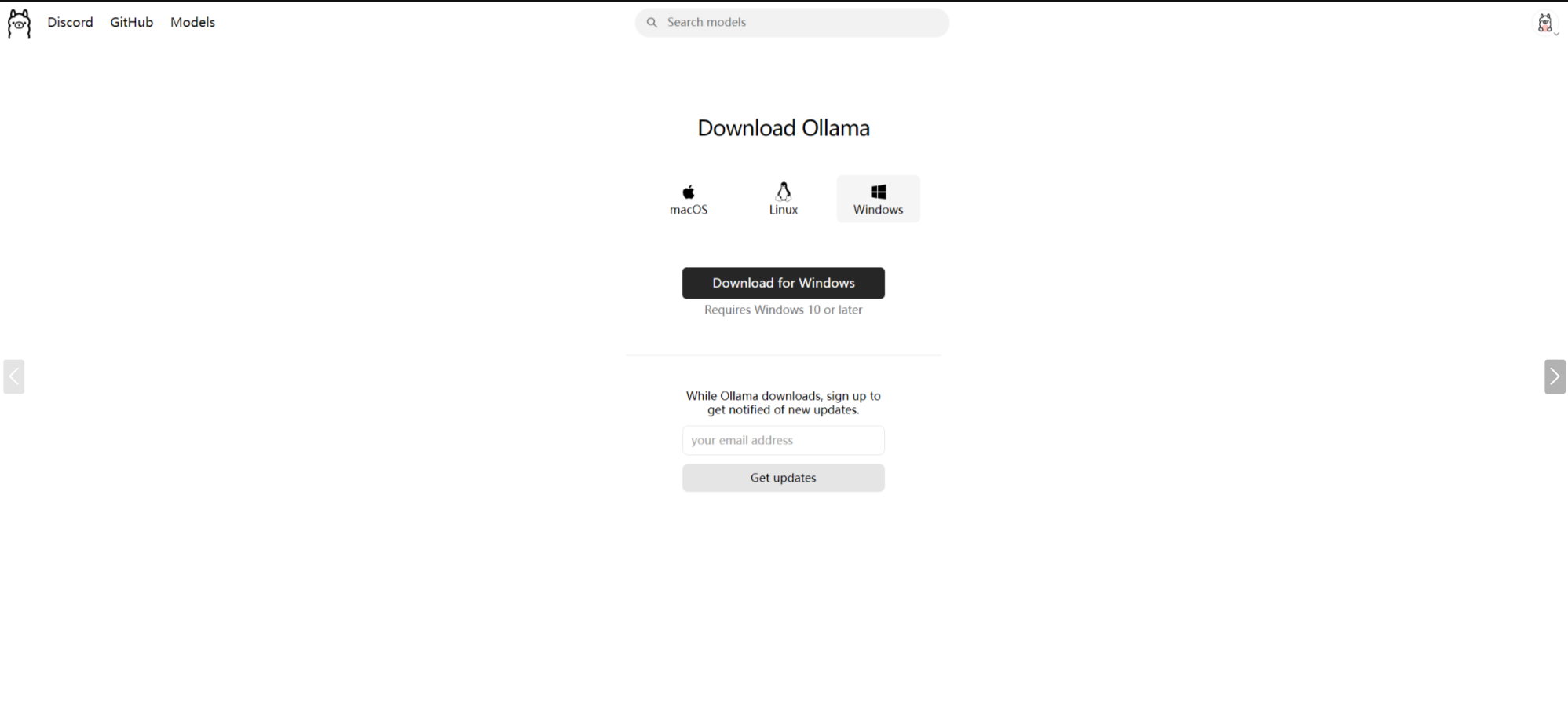

二、第一步:安装Ollama(本地大模型运行核心)

Ollama是轻量级大模型管理框架,支持一键完成模型的下载、运行、推理,是部署DeepSeek-R1的基础工具。

1. 下载Ollama安装包

2. 安装Ollama(全程默认,重点关注路径)

-

双击「OllamaSetup.exe」,弹出安装界面后点击「Next」,全程默认即可(新手为了不必要的麻烦建议不要更改安装路径);

-

点击「Install」开始安装,等待1-2分钟(安装过程会自动配置系统环境变量,无需手动操作);

-

安装完成后点击「Finish」,Ollama会自动在后台启动,任务栏右下角可看到Ollama图标。

3. 验证Ollama安装成功

-

按下「Win+R」,输入「cmd」,回车打开命令提示符(无需管理员权限);

-

输入命令:

ollama -v; -

若输出类似「ollama version 0.5.7」的版本信息,说明安装成功;若提示“不是内部或外部命令”,则是环境变量未生效,可能安装时修改了路径。

三、第二步:部署DeepSeek-R1模型

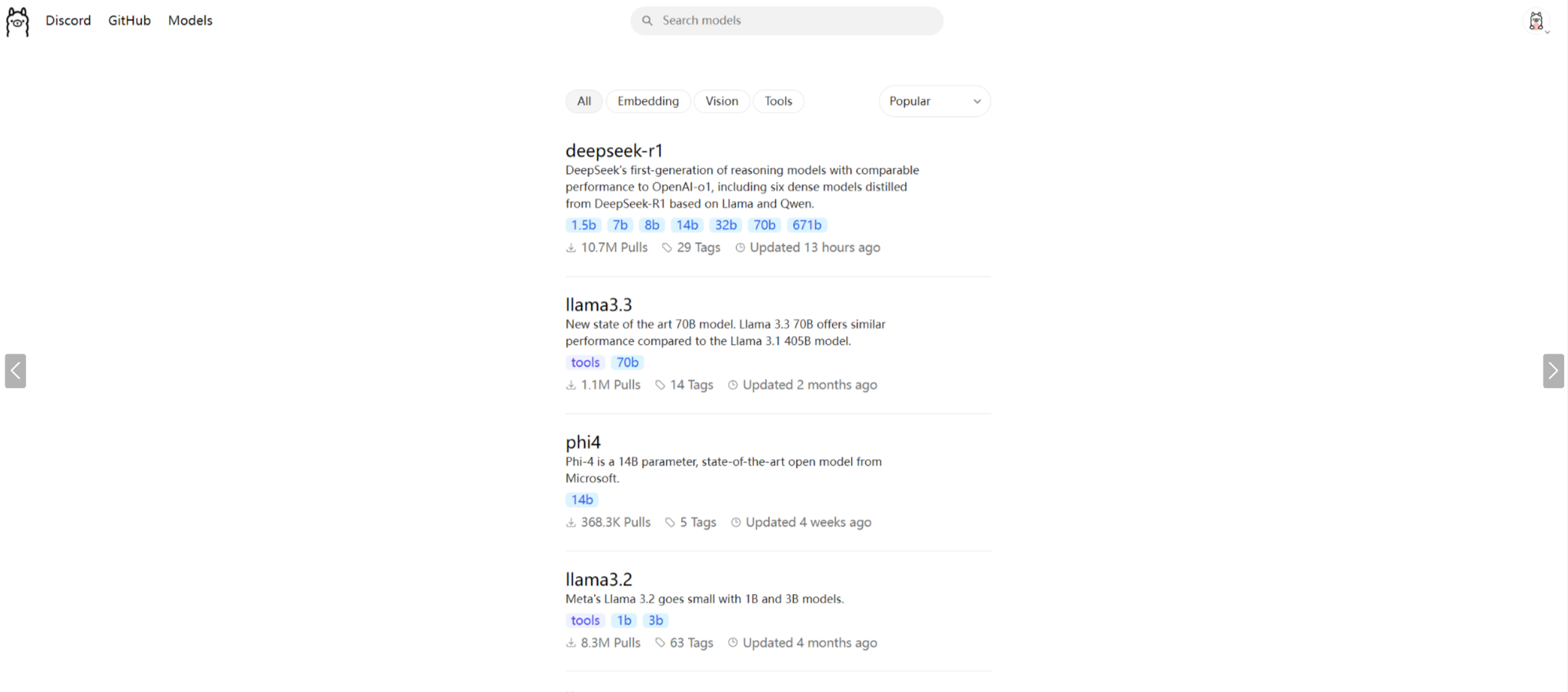

Ollama官网上查找模型

DeepSeek-R1是深度求索推出的开源大模型,中文理解能力强、适配个人知识库场景,Ollama已原生适配该模型,可一键拉取部署。

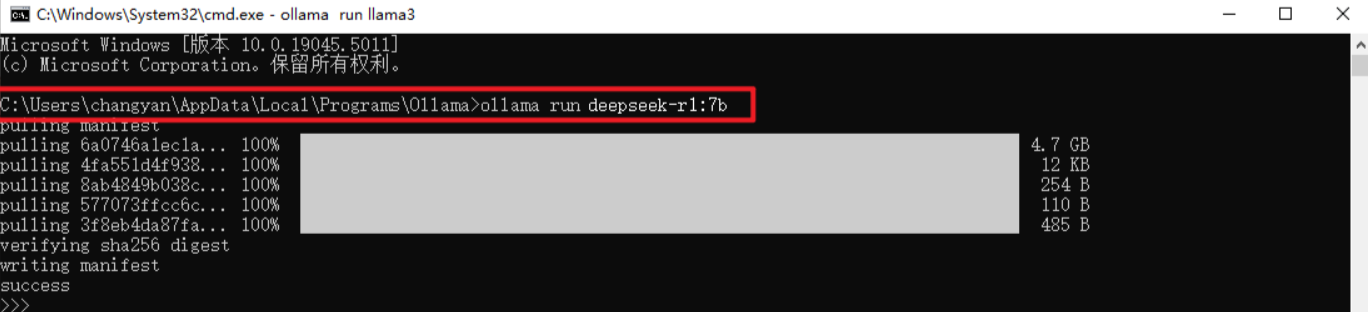

1. 拉取DeepSeek-R1模型(核心步骤)

- 保持命令提示符窗口打开,输入对应参数的拉取命令:

基础版(7B参数,适合16GB内存)

ollama run deepseek-r1:7b

2. 验证DeepSeek-R1模型运行正常

-

命令提示符中输入:

ollama run deepseek-r1:7b(若拉取的是16B版本,替换为对应命令);

-

等待模型加载完成(首次加载约30秒,出现「>>> 」提示符即代表就绪);

-

输入测试问题(如“你好,介绍一下自己”),回车后模型给出回复,说明运行正常;

-

退出模型:输入「/bye」回车即可。

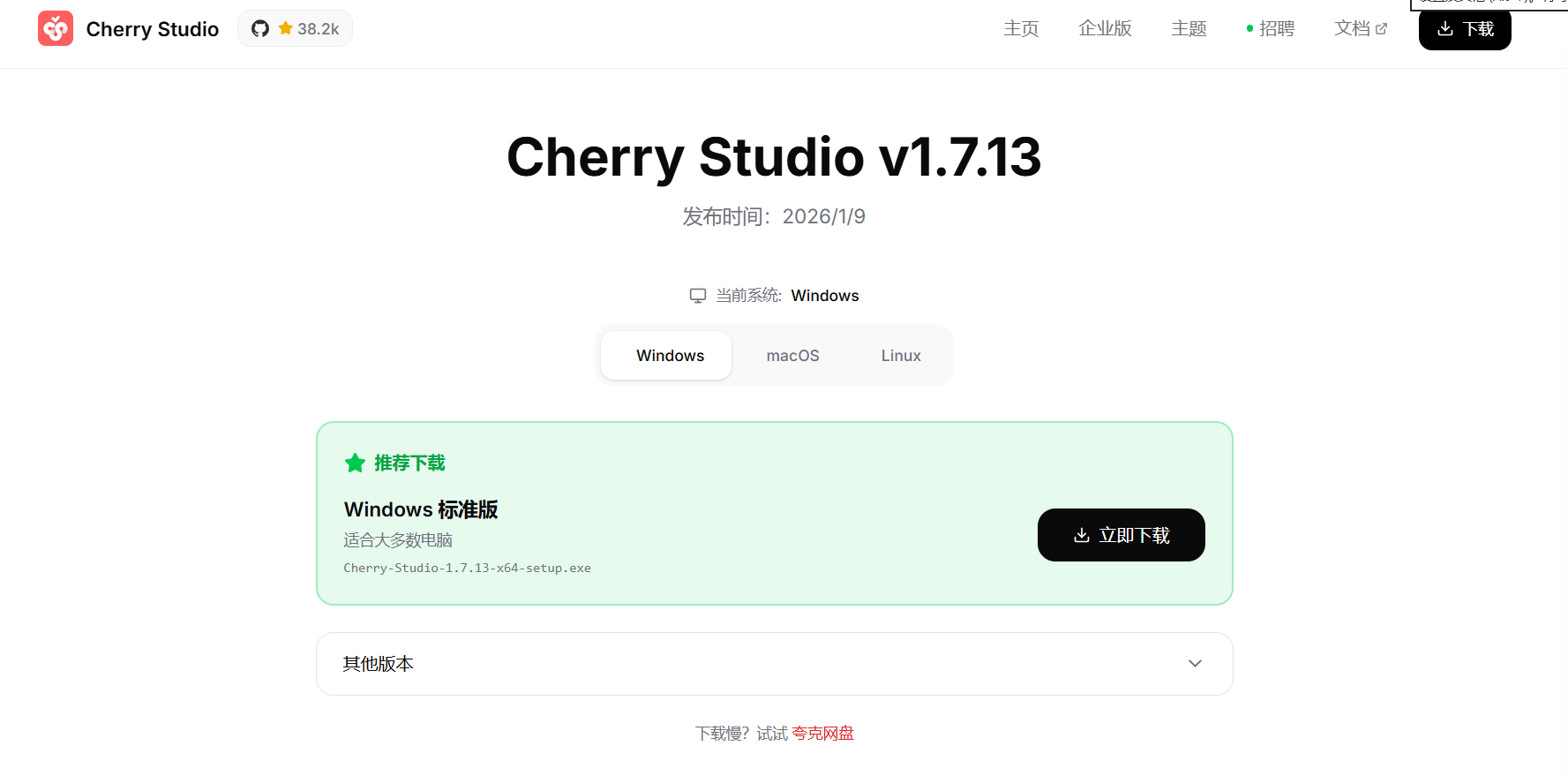

四、第三步:安装配置Cherry Studio

Cherry Studio是开源本地知识库工具,支持导入PDF/Word/TXT等格式文档,结合本地大模型实现私有化问答,所有数据存储在本地,无需担心泄露。

1. 下载Cherry Studio

选择Windows版本,下载至无中文、无空格路径(如「D:\CherryStudio」)。

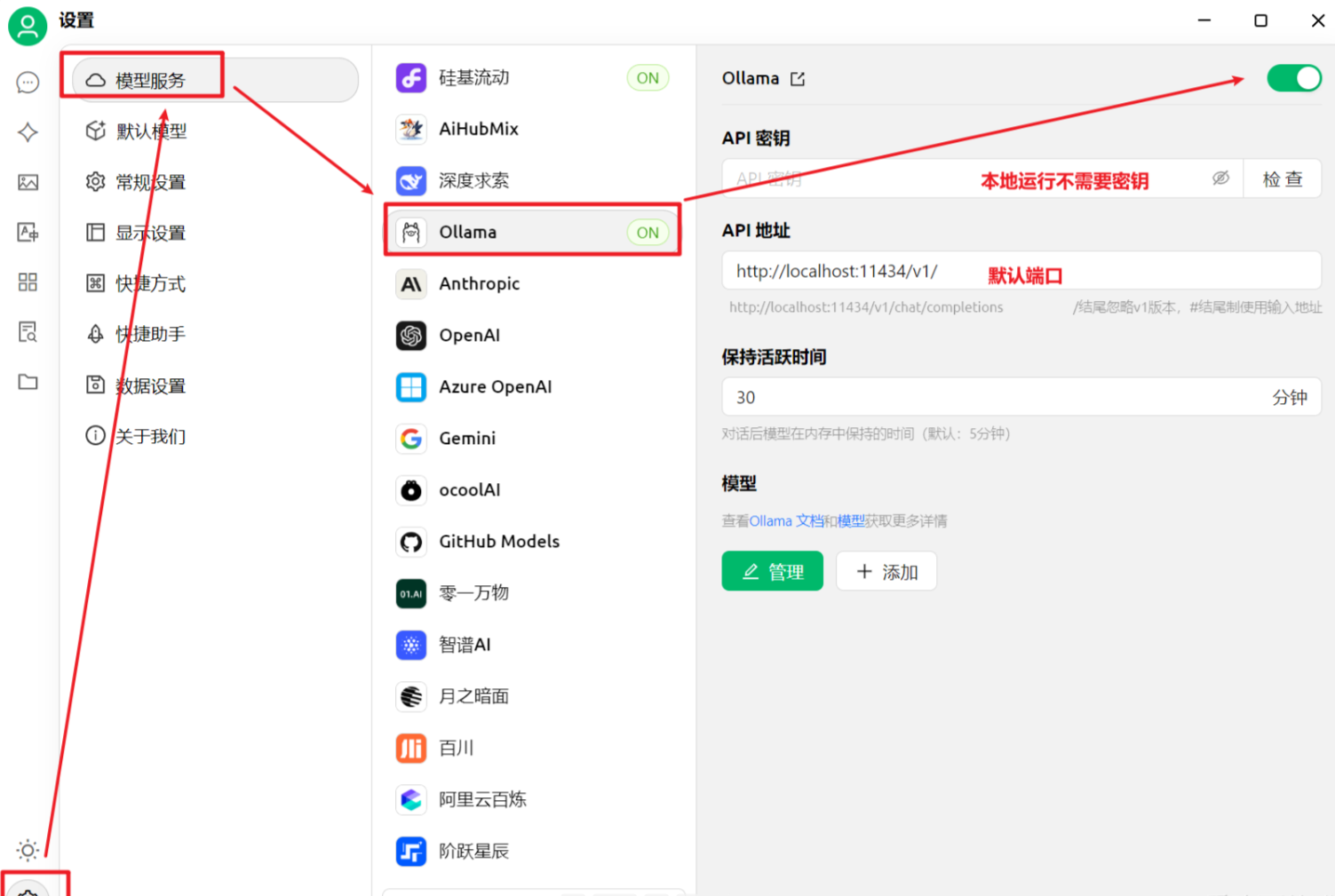

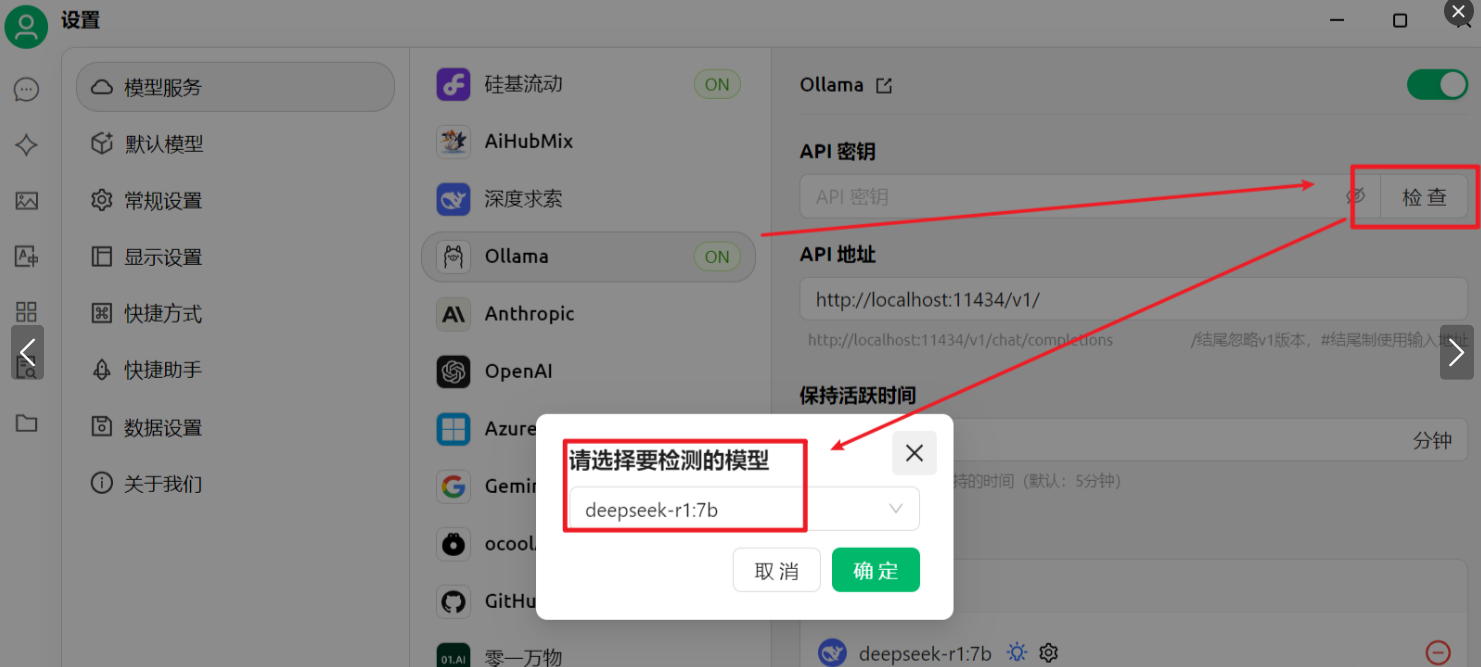

2. 启动Cherry Studio并连接Ollama

-

进入主界面后,点击左侧「设置」→「模型服务」;

-

配置模型连接参数(核心步骤,务必准确):

-

模型类型:选择「Ollama」;

-

Ollama地址:填写「http://localhost:11434」(Ollama默认端口,无需修改);

-

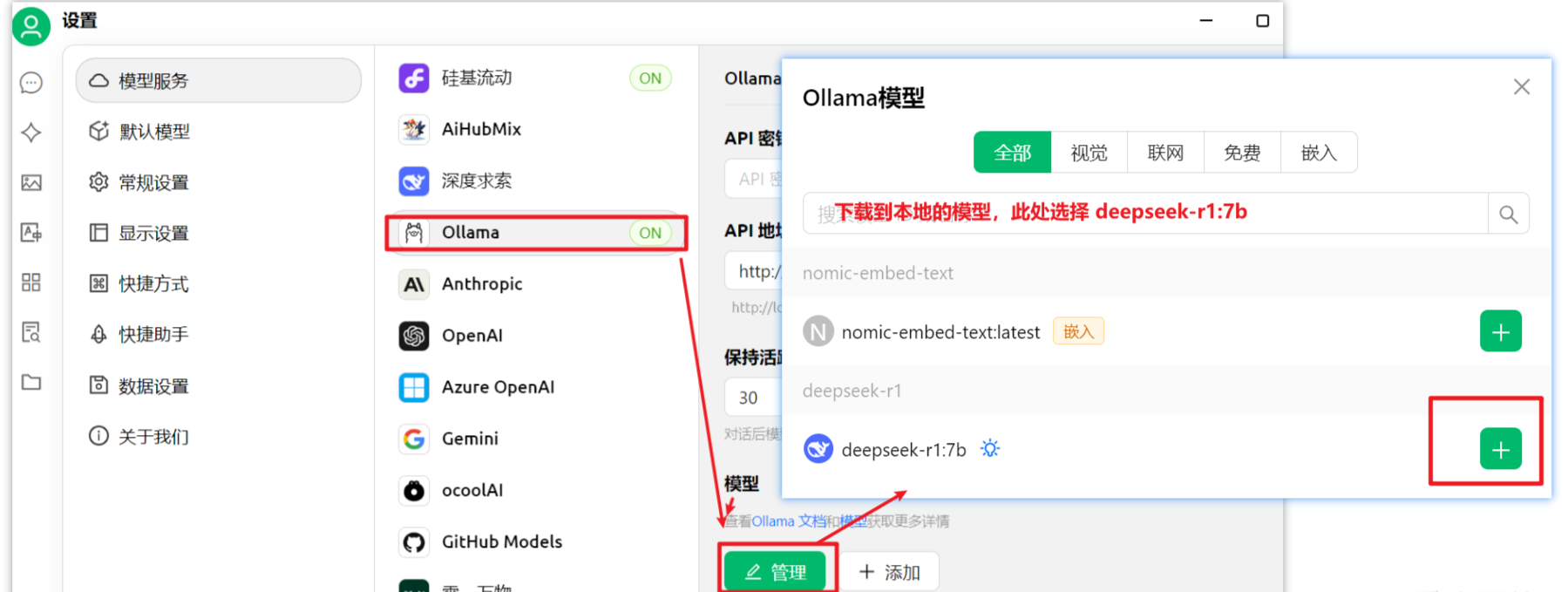

模型管理:选择「deepseek-r1:7b」(与拉取的模型版本完全一致);

-

检查模型:点击检查,选择自己需要的模型

-

3. 进入聊天模式

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)