Ubuntu24.04/Dify+Ollama 本地部署

本文介绍了Dify和Ollama的配置方法。首先通过Git拉取Dify镜像,修改环境变量和配置文件后启动服务。然后安装Ollama,配置环境变量并拉取模型。最后详细说明了如何在Dify中配置本地大模型,包括安装插件、添加工作流节点、设置LLM模型等步骤,并展示了如何查看主机IP和已安装的模型列表。文章提供了完整的配置流程,帮助用户快速搭建本地AI开发环境。

·

Dify 配置

-

拉取 Dify 镜像:

git clone https://ghfast.top/https://github.com/langgenius/dify.git -

进入

/dify/docker目录中,对 .env、docker-compose.yaml 配置文件部分内容进行修改:cp .env.example .env #复制实例环境配置文件 -

配置环境变量:参考Dify部署;主要是Nginx端口号、上传文件大小限制(提供的 .env、docker-compose.yaml 文件已经配置端口号为8010和4433,大小限制为 1500M,可按需修改)

# 修改端口 NGINX_PORT=8010 NGINX_SSL_PORT=4433 # 修改上传文件大小 UPLOAD_FILE_SIZE_LIMIT=1500 NGINX_CLIENT_MAX_BODY_SIZE=1500M# docker-compose.yaml NGINX_PORT: ${NGINX_PORT:-8010} NGINX_SSL_PORT: ${NGINX_SSL_PORT:-4433} UPLOAD_FILE_SIZE_LIMIT: ${UPLOAD_FILE_SIZE_LIMIT:-1500} NGINX_CLIENT_MAX_BODY_SIZE: ${NGINX_CLIENT_MAX_BODY_SIZE:-1500M}docker compose up -d #启动 Dify 服务 docker compose down #停止服务

Ollama 配置

- 手动安装参考:Ollama安装

- 镜像站ollama | newbe获取安装 tgz 文件:镜像站可能会出现不稳定情况,可以先尝试访问几个版本的镜像源链接;最好是解压到

/usr目录中wget https://gh.ddlc.top/https://github.com/ollama/ollama/releases/download/v0.13.2/ollama-linux-amd64.tgz mkdir -p /usr/ollama tar -xzvf ollama-linux-amd64.tgz -C /usr/ollama # 解压程序包 - 配置环境变量(相对路径):在

/etc/profile中添加#ollama 环境 export PATH=/usr/ollama/bin:$PATHsource /etc/profile #激活配置 - 拉取模型:以 qwen3:1.7b 为例

ollama pull qwen3:1.7b

配置本地大模型

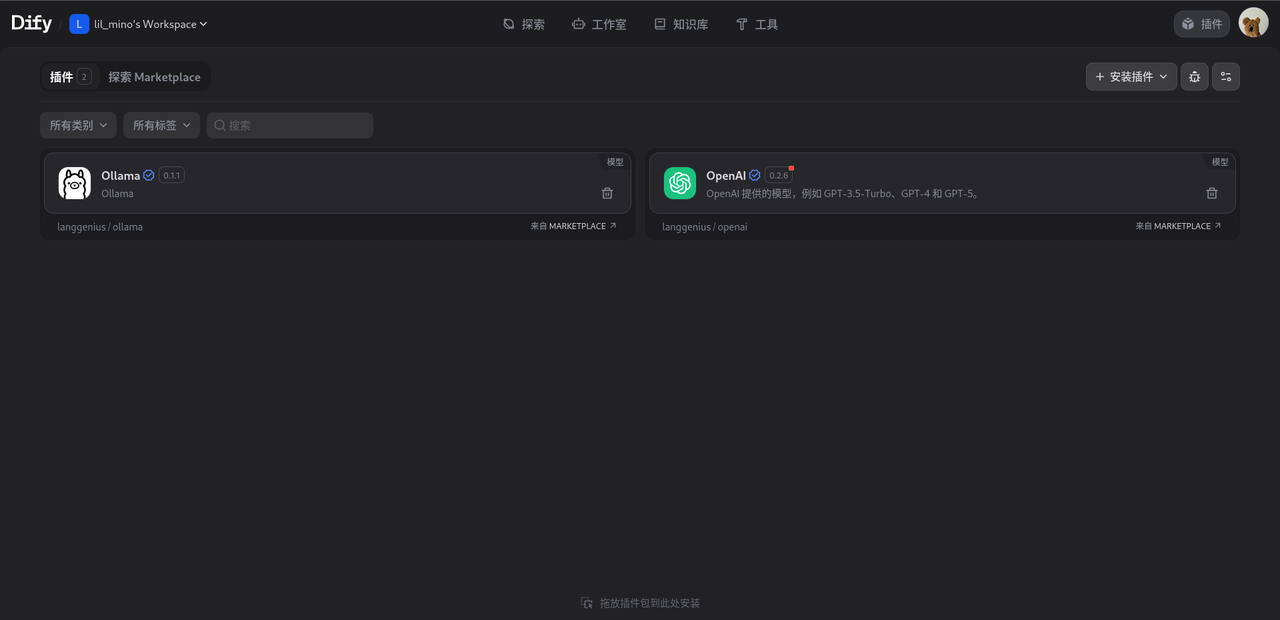

- 安装 Ollama插件:

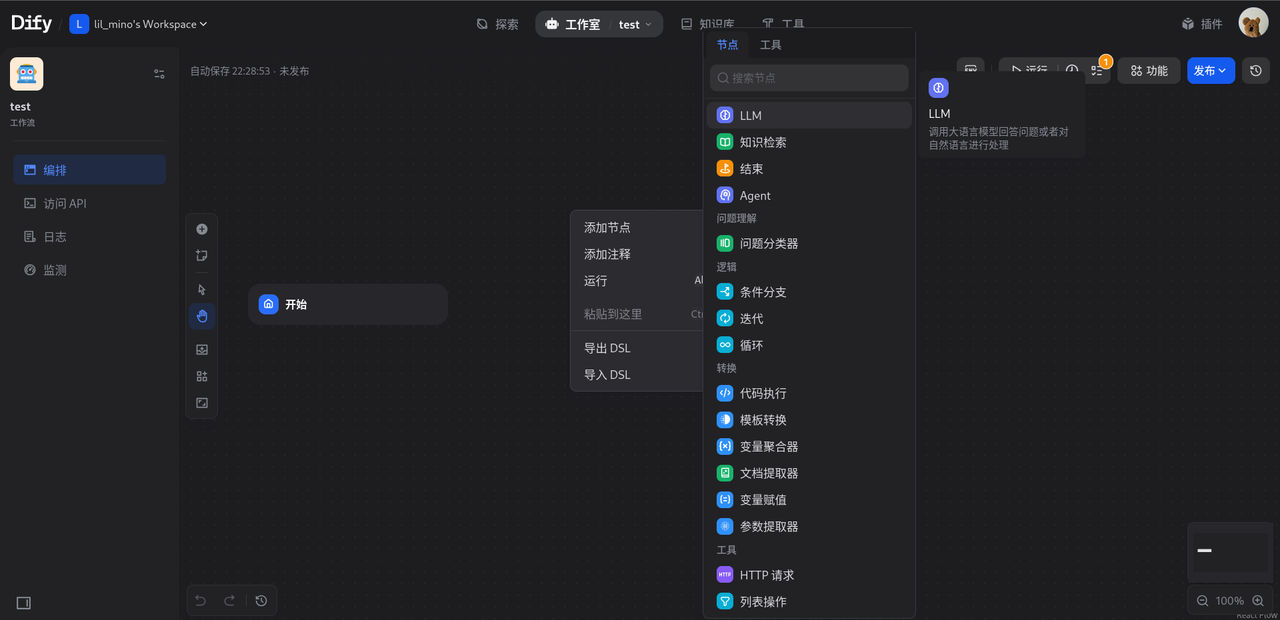

- 新建工作流、添加节点:

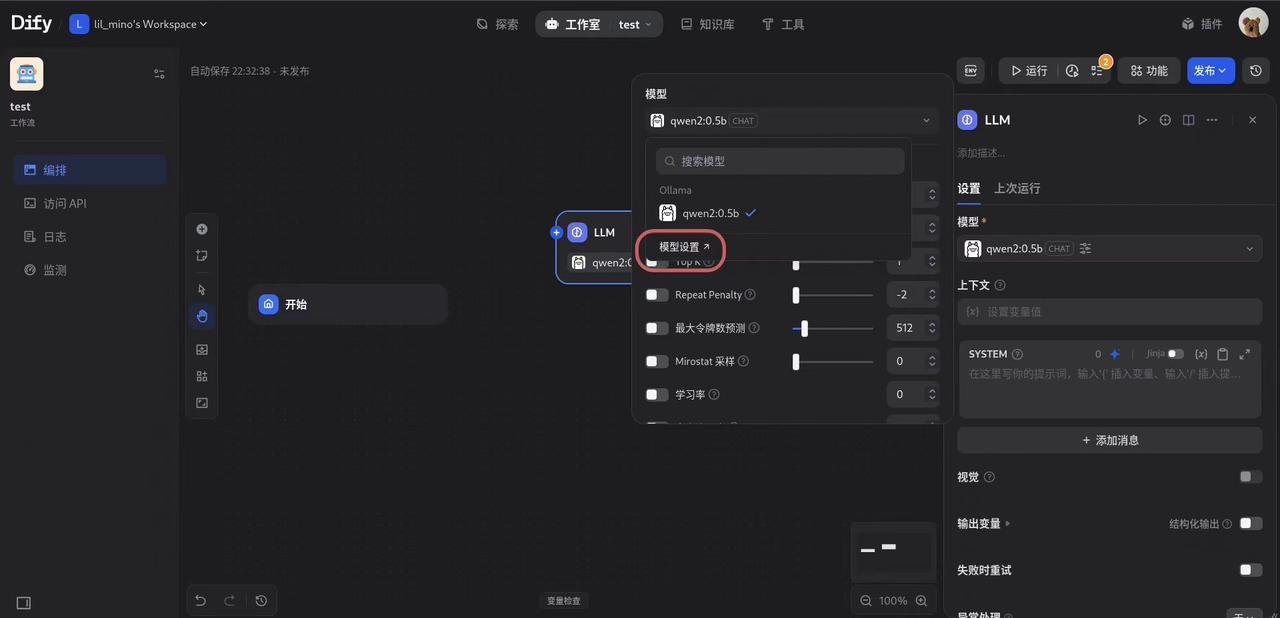

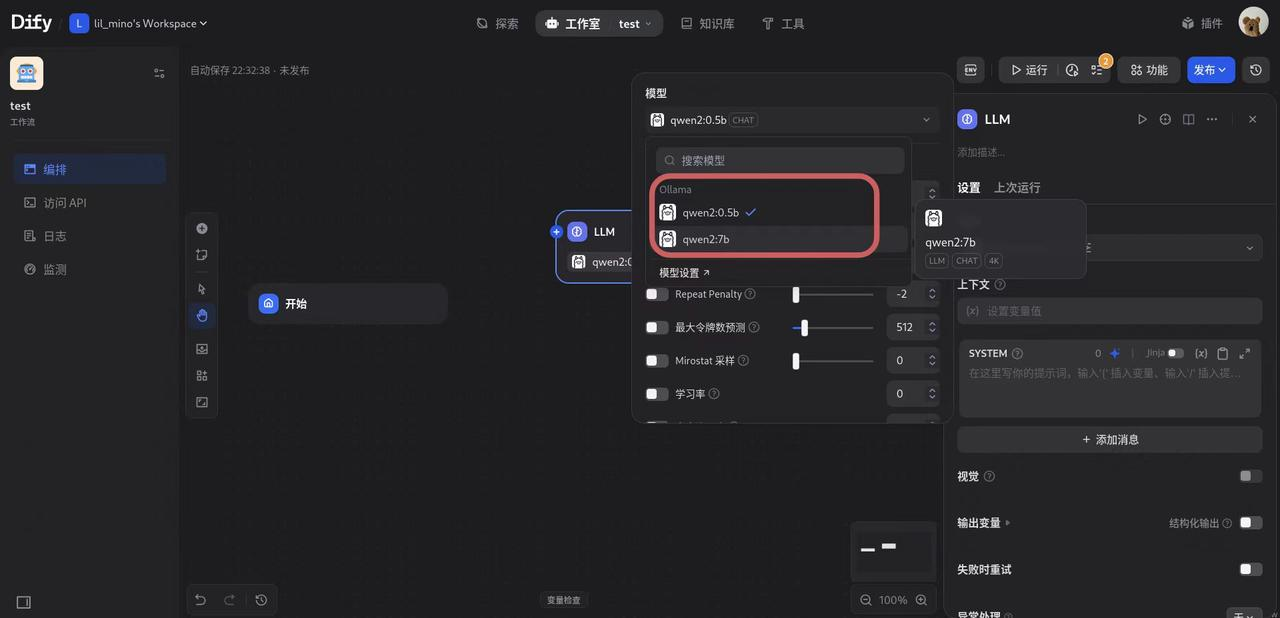

- 修改 LLM 节点中的模型设置

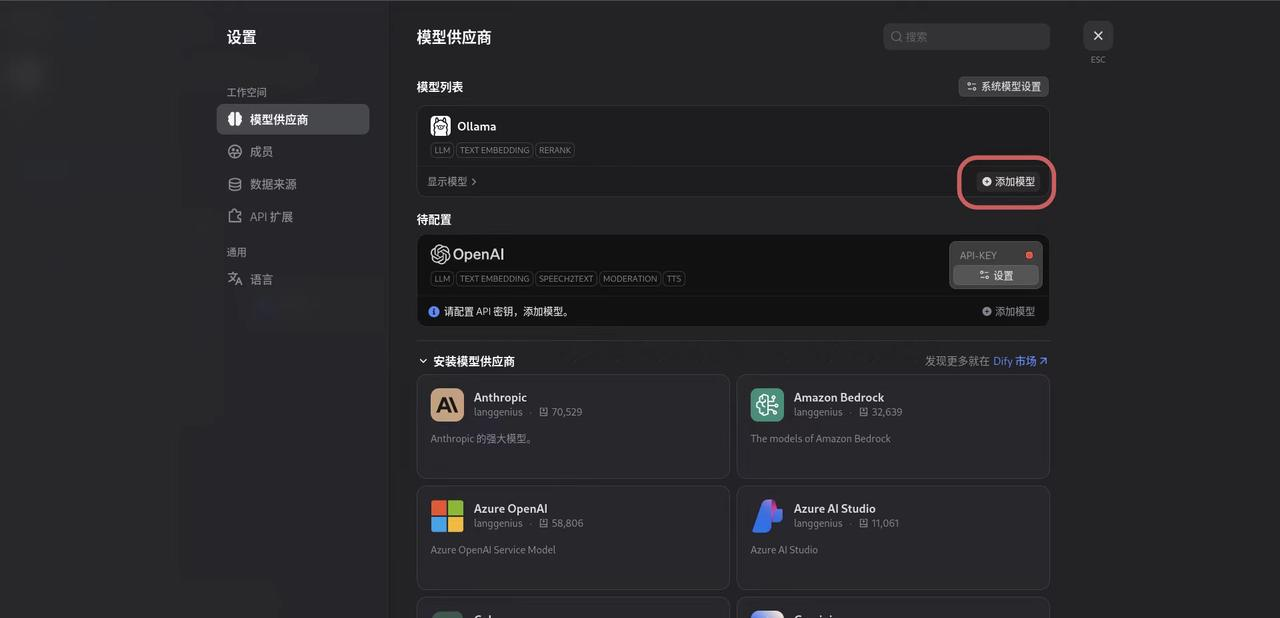

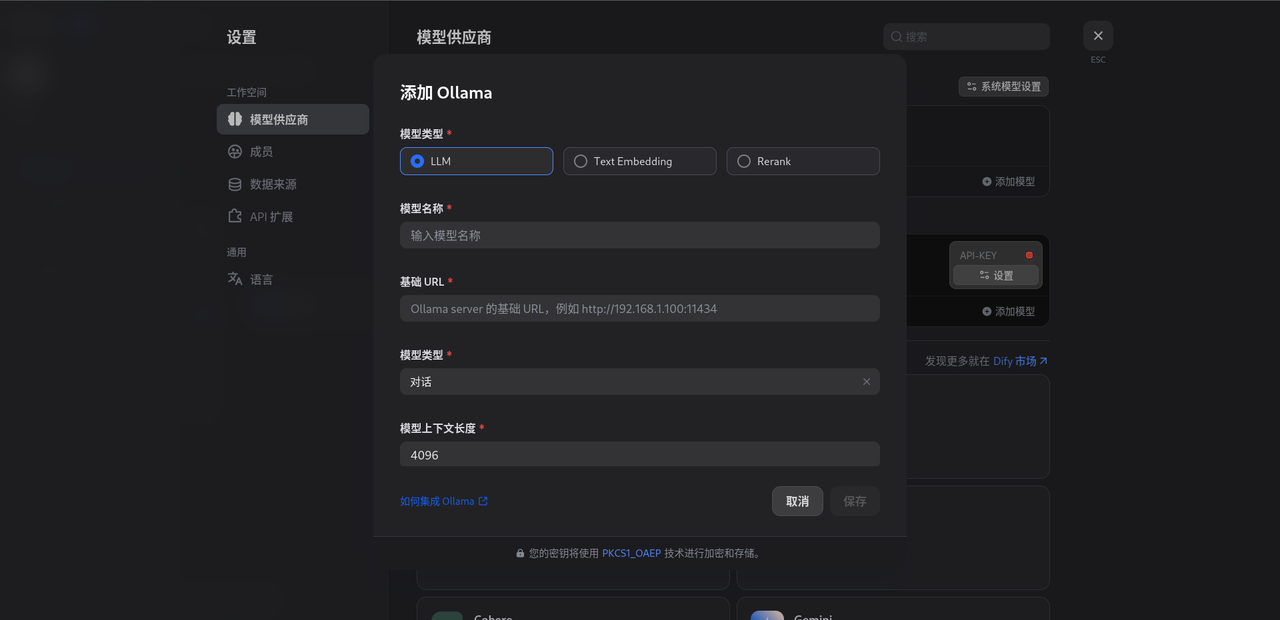

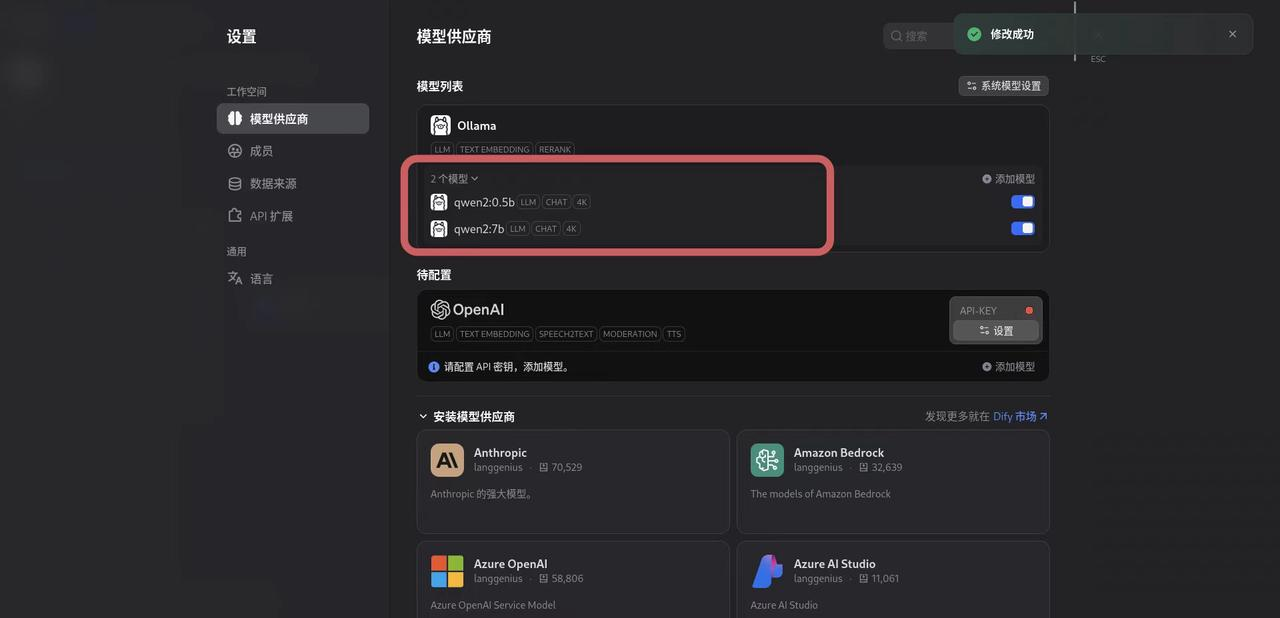

- 添加 Ollama 在本地拉取的模型:

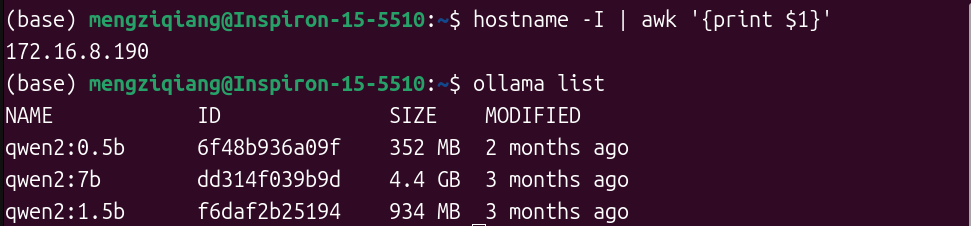

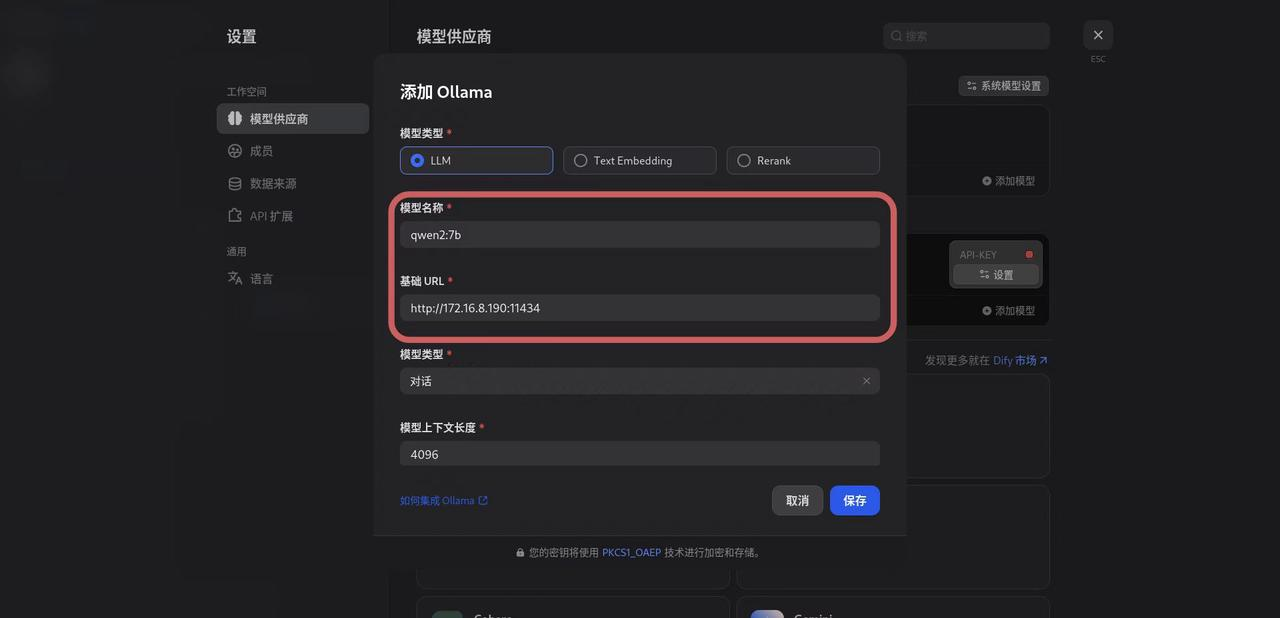

- 终端查看主机 IP 以及本地大模型:

hostname -I | awk '{print $1}' ollama list

- 填写相关配置后保存:(以

qwen2:7b为例)

- Ollama 支持的模型列表:

- 配置 LLM 节点的模型:

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)