Google发布AI智能体权威指南:从概念到落地的全流程开发指南

Google《AI智能体权威指南》解析:从基础架构到自进化系统 Google最新发布的《Introduction to Agents》系统阐述了AI智能体的完整框架,将AI范式从被动预测转向自主解决问题。指南提出智能体由模型(大脑)、工具(双手)、编排层(神经系统)和部署服务组成,通过"思考-行动-观察"循环实现目标。文章构建了五级分类体系:从Level 0基础推理系统到Lev

本文解析Google发布的《Introduction to Agents》权威指南,详细介绍了AI智能体的定义、组成要素及"思考-行动-观察"的问题解决流程。文章构建了从Level 0核心推理系统到Level 4自进化系统的四级分类体系,阐述了模型、工具与编排层三大核心架构,并探讨了智能体的部署与运维策略,为开发者提供了从概念到落地的全流程指导。

Google在2025年11月发布了《Introduction to Agents》权威指南,由谷歌的机器学习研究人员和工程师精心打造,旨在帮助开发者探索AI智能体的基础原理和实际应用。

值得一读!个人觉得是智能体开发设计与使用者的必读篇章:

从框架介绍到细节举例,从模型解构到概念分析,从流程梳理到设计要点,思路都很清晰,关键是从概念、设计、部署、运维全流程指南。

《Introduction to Agents》系统阐述了 AI 智能体(Agents)从概念到落地的全流程,指出 AI 正从被动预测型向自主解决问题型范式转变,AI 智能体是融合推理模型(大脑)、工具(双手) 与编排层(神经系统) 的完整应用,通过 “思考 - 行动 - 观察” 循环实现目标;文章还构建了从Level 0(核心推理系统)到 Level 4(自进化系统) 的智能体分类体系,详解了核心架构设计、多智能体协作模式、Agent Ops 运营体系、安全与治理策略,并以Google Co-Scientist和AlphaEvolve Agent为例展示高级智能体应用,为开发者和架构师提供了从原型到企业级部署的完整指南。

AI智能体组成

简单来说,AI智能体可以定义为模型、工具、编排层和运行服务的组合,它通过循环使用语言模型来实现某个目标。这四个元素构成了任何自主系统的基本架构:

- 模型(“大脑”):作为智能体核心推理引擎的核心语言模型(LM)或基础模型,用于处理信息、评估选项和做出决策。模型的类型(通用型、微调型或多模态型)决定了智能体的认知能力。智能体系统是语言模型输入上下文窗口的最终管理者。

- 工具(“双手”):这些机制将智能体的推理与外部世界连接起来,使其能够执行文本生成之外的操作。它们包括API扩展、代码函数以及用于访问实时、事实性信息的数据存储(如数据库或向量存储)。智能体系统允许语言模型规划使用哪些工具、执行工具,并将工具结果放入下一次语言模型调用的输入上下文窗口中。

- 编排层(“神经系统”):管理智能体运行循环的控制流程,它负责规划、记忆(状态)和推理策略的执行。

- 部署(“身体与腿部”):这包括将智能体部署在安全、可扩展的服务器上,并集成监控、日志记录和管理的基本生产服务。一旦部署,用户可以通过图形界面访问该智能体,或者其他智能体可以通过智能体到智能体(A2A)API以编程方式访问它。

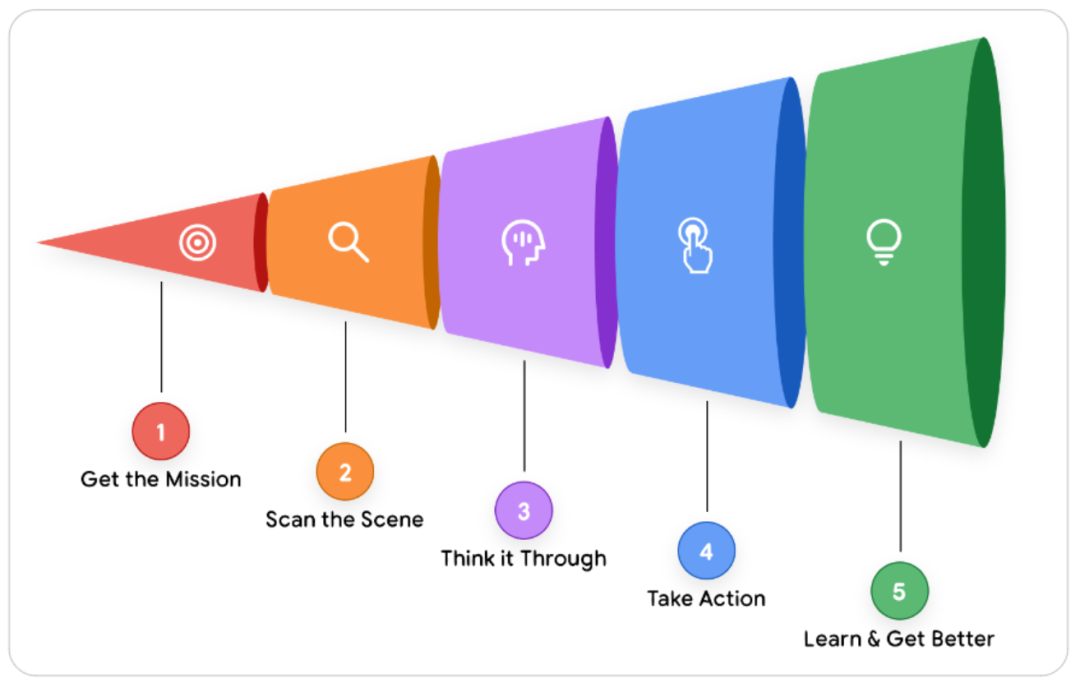

智能体问题解决流程

从本质上来说,智能体依靠一套持续循环的流程来达成目标,它可以拆解为五个基本步骤:

- 接收任务目标:整个流程由一个具体且宏观的目标触发。该目标可由用户提出(例如:“为团队即将召开的会议安排差旅事宜”),也可由自动化程序触发(例如:“收到一张新的高优先级客户工单”)。

- 扫描环境场景:智能体感知所处环境以收集相关背景信息。这一步需要编排层调用其可用资源,思考一系列问题:“用户的请求具体是什么?”“我的短期记忆中存有哪些信息?这项任务我之前是否尝试过?用户上周是否给出过相关指导?”“我能从日历、数据库、应用程序编程接口等工具中获取哪些内容?”

- 分析规划方案:这是智能体由推理模型驱动的核心 “思考” 环节。智能体结合第一步的任务目标与第二步的环境场景进行分析,并制定执行计划。这并非单一的思维活动,而是往往呈现为一连串的推理过程,例如:“要完成差旅预订,我首先得确认团队成员名单,需要调用

get_team_roster工具;之后,我还得通过calendar_api查询他们的空闲时间。” - 执行具体操作:编排层落实计划的首个具体步骤。它会选择并调用合适的工具 —— 可以是调用应用程序编程接口、运行代码函数,或是查询数据库。这一步是智能体突破自身内部推理范畴,与外部世界产生交互的关键环节。

- 观察结果并迭代:智能体观察操作的执行结果。例如调用

get_team_roster工具后,得到了一份包含五个人名的名单,这份新信息会被纳入智能体的上下文或 “记忆” 中。随后,循环流程回到第三步,进入新一轮迭代:“既然已经获取了团队名单,下一步我要查询这五人的日程,需要调用calendar_api。”

这个“思考、行动、观察”循环会持续进行——由编排层管理、由模型推理、由工具执行,直到智能体的内部计划完成并达成初始任务。

智能体系统分类体系

Level 0: The Core Reasoning System 核心推理系统

在构建智能体之前,我们必须从最基础形态的 “大脑” 起步 —— 即推理引擎本身。在这一配置下,语言模型(LM)独立运行,仅依托其海量预训练知识做出响应,无需任何工具、记忆支持,也不与实时环境产生交互。

其优势源于深厚的训练基础,能够深入阐释已确立的概念,并详细规划问题解决路径。但相应的代价是完全缺乏实时感知能力:对于训练数据之外的任何事件或事实,它在功能上等同于 “失明” 状态。

例如,它可以讲解职业棒球的规则以及纽约洋基队的完整历史,但如果你问 “昨晚洋基队比赛的最终比分是多少?”,它将无法给出答案。这场比赛是训练数据采集后发生的具体现实事件,因此相关信息并未存在于其知识库中。

Level 1: The Connected Problem-Solver 连接型问题解决者

在这一级别中,推理引擎通过对接并运用外部工具 —— 即我们架构中的**“双手” 组件**,正式成为具备实用价值的智能体。其问题解决能力不再局限于静态的预训练知识。

借助五步循环机制,该智能体如今能够解答我们此前提出的问题。以 “任务目标”——“昨晚洋基队比赛的最终比分是多少?” 为例,其 “思考” 阶段会识别出这一需求需要实时数据支撑;随后在 “行动” 阶段调用工具(如配置了正确日期和检索词的谷歌搜索 API);在 “观察” 阶段获取搜索结果(例如 “洋基队 5-3 获胜”),并将该事实整合为最终答案。

这种与外部世界交互的基础能力 —— 无论是通过搜索工具查询比分、调用金融 API 获取实时股价,还是借助检索增强生成(RAG)技术访问数据库 —— 正是第 1 级智能体的核心能力所在。

Level 2: The Strategic Problem-Solver 策略型问题解决者

第 2 级标志着智能体能力的显著拓展 —— 从执行简单任务升级为对复杂、多环节目标进行策略性规划。

这一级别核心新增的关键能力是上下文工程:智能体能够主动为其计划的每个步骤,筛选、整合并管理最相关的信息。

智能体的准确性依赖于聚焦且高质量的上下文。上下文工程通过精准调控模型的有限注意力,避免信息过载,确保高效运行。

举个例子,假设 “任务目标” 为:“在我位于山景城圆形剧场公园路 1600 号的办公室,与客户位于旧金山市场街 1 号的办公室之间,找一家不错的咖啡店。”

第 2 级别的智能体将启动如下规划:

-

思考:“我必须先找到两地的中点。”

-

行动:调用地图工具,输入两个地址。

-

观察:“中点位于加利福尼亚州米尔布雷市(Millbrae, CA)。”

-

思考:“现在我需要在米尔布雷市找咖啡店。用户要求‘不错的’,所以我要搜索评分 4 星级以上的店铺。”

-

行动:调用谷歌地图服务工具(google_places),查询参数为 “加利福尼亚州米尔布雷市的咖啡店”(query=“coffee shop in Millbrae, CA”)、最低评分 4.0(min_rating=4.0)。(这正是上下文工程的体现 —— 智能体自动根据上一步的输出,生成了全新且目标明确的搜索指令。)

-

观察:“搜索结果返回‘米尔布雷咖啡店(Millbrae Coffee)’和‘每日研磨咖啡店(The Daily Grind)’。”

-

思考:“我将整合这些结果,呈现给用户。”

这种策略规划能力还支持主动协助场景,例如:智能体读取冗长的航班确认邮件后,通过上下文工程提取关键信息(航班号、日期),并自动将其添加到你的日历中。

Level 3: The Collaborative Multi-Agent System 协作式多智能体系统

在这一最高级别,范式发生了彻底转变。

我们不再追求构建单一、全能的 “超级智能体”,而是转向由 “专业智能体团队” 协同工作的模式 —— 这一模型与人类组织架构高度契合,系统的集体优势正源于这种分工协作。

在此模式下,智能体将其他智能体视为工具。

试想一款 “项目经理智能体” 接到如下 “任务目标”:“启动新款‘Solaris’耳机的上市工作。”

该项目经理智能体不会独自完成所有工作,而是像现实场景中那样,为其专业智能体团队分配新的子任务:

- 委派给市场调研智能体(MarketResearchAgent):“分析降噪耳机的竞品定价,明日前提交总结报告。”

- 委派给营销智能体(MarketingAgent):“以‘Solaris’产品规格说明书为依据,起草三份新闻稿。”

- 委派给网页开发智能体(WebDevAgent):“根据附带的设计原型图,生成新产品页面的 HTML 代码。”

尽管受限于当前语言模型的推理能力,这种协作模式仍代表着自动化领域的前沿方向 —— 能够实现复杂商业流程从起点到终点的全链路自动化。

Level 4: The Self-Evolving System 自进化系统

第 4 级标志着智能体**从 “任务委派” 向 “自主创造与适应”**的深刻跨越。

在这一级别,智能体系统能够识别自身的能力缺口,并动态创建新工具乃至新智能体来填补这些空白 —— 它不再局限于使用固定的资源集合,而是主动拓展自身的能力边界。

延续前文的案例:负责 “Solaris” 耳机上市任务的 “项目经理智能体” 可能会意识到,需要监测社交媒体上的相关舆情,但团队中暂无此类工具或智能体。此时它会启动如下流程:

- 思考(元推理):“我必须追踪‘Solaris’的社交媒体热度,但目前缺乏该能力。”

- 行动(自主创造):它不会就此失败,而是调用一款高级的智能体创建工具(AgentCreator),并赋予其新任务:“构建一个新智能体,用于监测社交媒体中‘Solaris 耳机’相关关键词,执行情感分析,并每日提交总结报告。”

- 观察:一个全新的专业型情感分析智能体(SentimentAnalysisAgent)被即时创建、测试,并加入团队,随时可为原始任务提供支持。

这种能够动态拓展自身能力的自主性,将一组智能体转变为一个真正具备学习与进化能力的组织。

核心智能体架构:模型、工具与编排

语言模型(LM)是智能体的推理核心,其选型是一项关键的架构决策,直接决定智能体的认知能力、运营成本与响应速度。

然而,将选型简单等同于挑选基准测试分数最高的模型,是常见的误区。智能体在生产环境中的成功,很少由通用学术基准决定。

实际场景的成功,要求模型精通智能体的核心基础能力:一是出色的推理能力,能够应对复杂的多步骤问题;二是可靠的工具使用能力,能够与外部世界有效交互。

要做好模型选型,首先需明确业务问题,再针对该问题的核心目标设计评估指标,用这些指标测试候选模型。(这一条建议说得很干)

例如,若智能体需执行代码编写任务,就应在私有代码库上测试模型;若需处理保险理赔,就需评估模型从特定格式文档中提取信息的能力。之后,还需结合成本与延迟等实际因素进行交叉验证。所谓 “最优” 模型,是在特定任务中,于质量、速度和价格三者间达到最佳平衡的模型。

你也可以选择多个模型,构建 “专家团队”—— 无需用大锤敲核桃。

稳健的智能体架构可能会采用前沿模型(如 Gemini 2.5 Pro)来承担初始规划、复杂推理等 “重活”,同时将用户意图分类、文本摘要等简单且高并发的任务,智能路由至更快、更具成本效益的模型(如 Gemini 2.5 Flash)。模型路由可采用自动触发或硬编码方式,却是优化性能与成本的关键策略。

最后需注意,AI 领域正处于持续快速演进的状态 —— 如今选用的模型,六个月后就可能被淘汰。“一劳永逸” 的思路已不再可行。应对这一现实,需要构建灵活的运营框架,即 “智能体运维(Agent Ops)” 体系。通过稳健的 CI/CD 流水线,持续用核心业务指标评估新模型,既能降低升级风险,又能加速迭代进程,确保智能体始终搭载当前最优的 “大脑”,而无需进行彻底的架构重构。

如果说模型是智能体的“大脑”,那么工具就是将其推理与现实世界连接起来的“双手”。

它们让智能体得以突破静态训练数据的局限,获取实时信息并在现实中采取行动。

一个稳健的工具接口包含三部分循环流程:明确工具的功能范围、调用工具执行操作、观察工具返回结果。

以下为开发者常为智能体配备的几类核心工具。

2.1信息检索:扎根现实世界

最基础的工具能力是获取最新信息。检索增强生成(RAG)技术为智能体提供了一把 “图书馆借阅证”,使其能够查询外部知识 —— 这些知识通常存储在向量数据库(Vector Databases)或知识图谱(Knowledge Graphs)中,范围涵盖企业内部文档,到通过谷歌搜索获取的网络知识等。

对于结构化数据,自然语言转 SQL(NL2SQL)工具可让智能体直接查询数据库,解答诸如 “上季度我们最畅销的产品是什么?” 这类分析性问题。通过在输出结论前主动查证(无论是查阅文档还是数据库),智能体能够扎根于事实依据,大幅减少幻觉现象的发生。

2.2执行行动:改变现实世界

智能体的真正力量,在其从 “读取信息” 迈向 “主动作为” 时得以释放。通过将现有 API 和代码函数封装为工具,智能体能够发送邮件、安排会议,或在 ServiceNow(服务管理平台)中更新客户记录。

对于更具动态性的任务,智能体可即时编写并执行代码。在安全沙箱环境中,它能生成 SQL 查询语句或 Python 脚本,解决复杂问题或完成计算任务 —— 这使其从 “知识渊博的助手” 转变为 “自主行动的执行者”。

2.3函数调用:为智能体连接工具

智能体要可靠地实现 “函数调用” 与工具使用,需要明确的指令、安全的连接以及编排调度能力。OpenAPI 规范等成熟标准为此提供了支撑,它为智能体提供一份结构化协议,清晰描述工具的用途、所需参数及预期响应。

这份 schema(模式定义)能确保模型每次都生成正确的函数调用,并准确解析 API 返回结果。对于更简便的工具发现与连接需求,**模型上下文协议(MCP)**等开放标准因便捷性已广泛普及。此外,部分模型自带原生工具,例如集成了原生谷歌搜索功能的 Gemini—— 其函数调用过程直接作为语言模型(LM)调用的一部分完成。

若说模型是智能体的“大脑”、工具是其“双手”,那么编排层就是连接二者的“中枢神经系统”。

它是驱动**“思考 - 行动 - 观察” 循环的核心引擎**,是调控智能体行为的状态机,更是开发者精心设计的逻辑得以落地的关键载体。这一层绝非单纯的 “管道架构”,而是整场智能体协同运作的 “指挥家”—— 它决定模型何时进行推理、何种工具执行动作,以及该动作的结果如何为下一步流程提供参考。

3.1核心设计选择

首要的架构决策是确定智能体的自主程度。这一选择呈梯度分布:一端是确定性、可预测的工作流 —— 将语言模型(LM)作为特定任务的工具调用,仅用少量 AI 能力增强现有流程;另一端则是语言模型主导全局,动态适配、规划并执行任务以达成目标。

无论采用何种方式,生产级框架都是核心必备,且需满足三大要求:

**一是开放性,**支持接入任意模型或工具,避免供应商锁定;

**二是精准可控,**支持混合模式 —— 用硬编码业务规则约束语言模型的非确定性推理;

**三是可观测性(这一点最为重要),**当智能体行为异常时,无法直接在模型的 “思考过程” 中设置断点,而稳健的框架会生成详细轨迹与日志,完整暴露其推理路径:包括模型的内部思考、选择的工具、生成的参数及观察到的结果。

3.2注入领域知识与设定角色形象

在该框架中,开发者最有力的调控手段,是为智能体注入领域知识并设定鲜明的角色形象。这一目标可通过系统提示词(system prompt)或一组核心指令实现 —— 这绝非简单的命令,而是智能体的 “行为准则”。

在此环节中,你需要明确告知智能体:“你是 Acme 公司的一名乐于助人的客户支持智能体……”,同时提供约束条件、期望的输出格式、交互规则、特定语气风格,以及何时、为何使用工具的明确指引。在指令中加入若干示例场景,通常能达到极佳效果。

3.3补充上下文信息

智能体的 “记忆” 会在运行时被整合到语言模型(LM)的上下文窗口中。

短期记忆是智能体的动态 “草稿本”,用于留存当前会话的实时历程。它会追踪当前循环中 “行动 - 观察”(Action, Observation)的成对序列,为模型提供下一步决策所需的即时上下文。这一功能通常可**通过状态(state)、工件(artifacts)、会话(sessions)或线程(threads)**等抽象概念实现。

长期记忆则支持跨会话的信息持久化。从架构上看,它几乎都以专用工具的形式实现 —— 即一个对接向量数据库或搜索引擎的检索增强生成(RAG)系统。

编排层赋予智能体预加载和主动查询自身历史信息的能力,使其能够 “记住” 用户偏好或数周前类似任务的结果,从而提供真正个性化且连贯的交互体验。

3.4多智能体系统与设计模式

随着任务复杂度提升,构建单一、全能的 “超级智能体” 会逐渐变得低效。更有效的解决方案是采用 “专家团队” 模式,这一模式与人类组织架构高度相似。

多智能体系统的核心逻辑正在于此:将复杂流程拆解为若干独立子任务,再为每个子任务分配一款专属的专业智能体。

这种分工模式能让每个智能体的功能更简洁、目标更聚焦,同时降低构建、测试与维护的难度,非常适用于动态变化或长期运行的业务流程。

架构师可借鉴一些经过验证的智能体设计模式,不过智能体的能力边界与对应的设计模式仍在快速演进。针对动态或非线性任务,协调者模式必不可少。该模式会设置一款 “管理者智能体”,由它分析复杂需求、拆分主任务,并将各子任务智能分配给对应的专业智能体(例如研究员、撰稿人或程序员智能体)。之后,协调者智能体会汇总所有专业智能体的反馈结果,整合出一份完整详实的最终答案。

对于更偏向线性的工作流,顺序执行模式是更佳选择。这种模式就像一条数字化流水线,前一个智能体的输出结果会直接作为下一个智能体的输入数据。

此外,还有两类关键模式聚焦于质量与安全管控:迭代优化模式会构建一个反馈闭环,由 “生成型智能体” 产出内容,再由 “评审型智能体” 对照质量标准进行评估优化;针对高风险任务,人机协同模式(HITL) 至关重要 —— 它会在工作流中设置一个可控暂停节点,智能体执行关键操作前必须先获得人类的审批许可。

智能体的部署与配套服务

当你在本地完成智能体的构建后,下一步通常是将其部署到服务器,使其能够全天候运行,并供其他用户或智能体调用。沿用前文的比喻,部署与配套服务就相当于智能体的躯干与腿脚。一款智能体要实现高效运转,需要依托多项配套服务的支撑,比如会话历史管理、记忆持久化存储等。作为智能体开发者,你还需负责制定日志记录策略,并采取相应的安全措施,保障数据隐私、满足数据存储地域要求以及合规性监管规定。上述所有服务,均属于智能体生产环境部署工作的核心范畴。

智能体运维:应对不确定性的结构化方案

当你构建首款智能体时,需要反复手动测试它的行为表现:新增一项功能后,它能否正常运转?修复一个漏洞后,是否会引发其他问题?测试在软件开发过程中本是常态,但在生成式人工智能领域,测试的逻辑和方式截然不同。

从传统的确定性软件,向非确定性的智能体系统转型,需要全新的运维理念。传统软件的单元测试,只需简单验证输出结果是否与预期一致即可;但智能体的响应本质上带有概率性,这种测试方法显然不再适用。此外,由于自然语言本身具有复杂性,评估智能体响应的 “质量”—— 即是否完成所有应尽职责、无多余内容输出、且语气恰当 —— 往往需要借助语言模型来实现。

智能体运维(Agent Ops)正是应对这一新现实的标准化、结构化方案。它脱胎于开发运维(DevOps)与机器学习运维(MLOps)体系,针对 AI 智能体在构建、部署与治理过程中面临的独特挑战量身打造,能够将不确定性从 “隐患” 转化为可管控、可度量、可信赖的特性。

6.1量化关键指标:以 A/B 实验思路衡量成效

要优化智能体,首先必须结合自身业务场景,明确 “更优” 的定义标准。

不妨将可观测性策略设计成一次 A/B 实验,并自问:哪些关键绩效指标(KPIs)能够证明智能体正在创造价值?

这些指标不能只局限于技术层面的准确性,更要衡量智能体对实际业务的影响,具体包括:目标达成率、用户满意度评分、任务处理延迟、单次交互的运营成本,以及最重要的一点—— 对营收、转化率、客户留存率等核心业务目标的影响。

这种自上而下的指标设计思路,将指导后续所有测试工作,让你走上数据驱动的开发路径,同时还能精准计算智能体投入的投资回报率(ROI)。

6.2重质不重 “合格 / 不合格”:使用语言模型评判

业务指标无法反映智能体的行为是否合规。既然简单的 “合格 / 不合格” 二元判定不再适用,我们便转向采用 “语言模型评审机制” 评估智能体的输出质量。具体操作是借助一个高性能模型,对照预设的评分标准来评判智能体的输出结果:回答是否准确?内容是否基于事实?是否严格遵循指令要求?基于标准提示数据集执行的这类自动化评估,能够为智能体输出质量提供统一的衡量依据。

构建评估数据集 —— 其中包含标准问题(或称 “基准问题”)与正确答案 —— 是一项繁琐的工作。在搭建数据集时,应当从智能体现有的生产或开发交互场景中抽样选取案例。数据集必须覆盖用户可能遇到的全部使用场景,同时额外纳入一些边缘场景。尽管投入精力构建评估体系的收效十分显著,但评估结果在被认定有效之前,必须经由领域专家审核。如今,在领域专家的协助下,评估数据集的构建与维护,正逐渐成为产品经理的一项核心职责。

6.3数据驱动开发:智能体部署的决策依据

当你完成数十种评估场景的自动化配置,并建立起可靠的质量评分体系后,就可以信心十足地对开发版智能体的改动进行测试了。整个流程十分简洁:让新版本智能体在完整的评估数据集上运行,再将其评分与现行生产版本直接对比。这套稳健的体系能彻底排除主观臆断的干扰,确保每次部署都有理有据、令人信服。

尽管自动化评估至关重要,但也不要忽略延迟时长、运营成本、任务成功率等其他关键指标。为了最大程度保障部署安全,可采用 A/B 部署策略逐步推出新版本,同时将真实生产环境中的这些指标数据,与模拟测试评分进行对照分析。

6.4借助 OpenTelemetry 追踪调试:定位问题根源

当指标出现下滑,或用户反馈故障时,你需要弄清问题的根本原因。OpenTelemetry 追踪功能,能以高保真度、按步骤记录智能体的完整执行路径(轨迹),助力开发者对智能体的运行步骤开展调试。

通过追踪记录,你可以清晰查看以下关键信息:发送给模型的精确提示词、模型的内部推理过程(若支持查看)、智能体选定调用的具体工具、为该工具生成的精准参数,以及工具返回的原始观测数据。初次接触追踪记录时,你可能会觉得其内容较为复杂,但它恰恰提供了诊断并修复各类问题根源所需的详细信息。追踪记录中的重要细节可转化为指标数据,但查看追踪记录的核心用途是调试,而非对性能进行宏观概览。

6.5重视人工反馈:为自动化优化指明方向

人工反馈绝非需要应付的麻烦事,而是你优化智能体的最具价值、数据维度最丰富的资源。当用户提交故障报告,或是点击 “差评” 按钮时,他们其实是在为你提供一份宝贵的信息:一个真实场景下的边缘案例 —— 这类案例恰好是你的自动化评估场景未能覆盖到的。

收集并整合这些反馈数据至关重要。当你发现某类相似反馈的数量达到统计学显著水平,或是相关指标出现下滑时,必须将这些情况关联至数据分析平台,以此提炼洞察,并针对运维问题触发告警机制。一套高效的智能体运维流程,能够形成闭环优化链路:捕捉人工反馈、复现对应问题、将该具体场景转化为评估数据集中一项全新的永久性测试用例。这一流程不仅能帮你修复已发现的漏洞,更能为系统建立 “免疫屏障”,杜绝同类问题再次发生。

如何学习AI大模型?

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献586条内容

已为社区贡献586条内容

所有评论(0)