打通AI任督二脉:一文读懂MCP协议,手把手带你构建下一代智能助手架构

在AI大模型(LLM)狂飙突进的今天,我们不仅惊叹于其推理能力,更受困于其“高塔孤岛”的现状。大模型虽强,却难以直接触达本地数据、企业数据库或复杂的业务系统。传统的解决方案是编写无数的“胶水代码”,导致维护成本指数级上升。应运而生,它像当年的USB标准一样,试图统一AI与世界连接的接口。本文将从协议原理出发,深入剖析MCP的“客户端-主机-服务器”架构,并通过构建一个企业级SQLite数据分析Ag

打通AI任督二脉:一文读懂MCP协议,手把手带你构建下一代智能助手架构

🚀 打通AI任督二脉:一文读懂MCP协议,手把手带你构建下一代智能助手架构

📝 摘要 (Abstract)

在AI大模型(LLM)狂飙突进的今天,我们不仅惊叹于其推理能力,更受困于其“高塔孤岛”的现状。大模型虽强,却难以直接触达本地数据、企业数据库或复杂的业务系统。传统的解决方案是编写无数的“胶水代码”,导致维护成本指数级上升。Model Context Protocol (MCP) 应运而生,它像当年的USB标准一样,试图统一AI与世界连接的接口。本文将从协议原理出发,深入剖析MCP的“客户端-主机-服务器”架构,并通过构建一个企业级SQLite数据分析Agent的实战案例,展示如何利用MCP打破数据壁垒。我们将探讨从资源(Resources)定义到工具(Tools)调用的全流程,并对安全性、鉴权机制及未来生态进行深度思考。

🛠️ 第一章:告别“胶水代码”——为什么世界需要MCP?

1.1 从“各自为战”到“通用标准”的进化痛点

过去,如果你想让Claude访问你的本地日历,或者让ChatGPT查询公司内部的Jira工单,开发者必须为每个模型、每个平台单独编写API集成代码。这不仅是 O ( N × M ) O(N \times M) O(N×M)的复杂度噩梦,更是数据安全的黑洞。

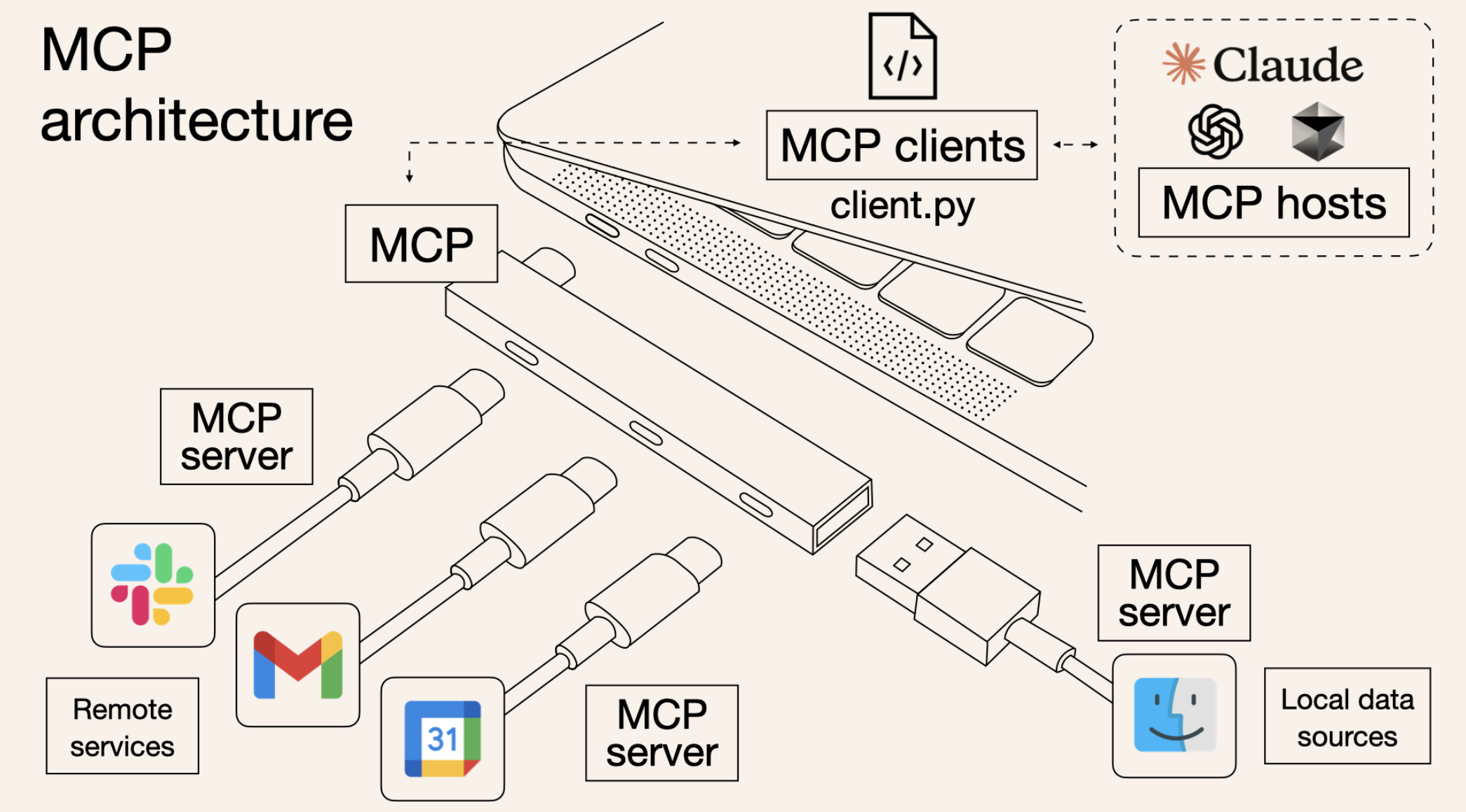

MCP的出现,旨在建立一种通用开放标准。它不关心你用的是Claude、OpenAI还是本地的Llama 3,只要符合MCP标准,模型就能像插上USB设备一样,即插即用,获取上下文(Context)。

1.2 MCP的核心隐喻:AI时代的USB-C接口

想象一下,在USB出现之前,鼠标有鼠标的接口,打印机有打印机的并口。MCP就是AI时代的USB-C。

- 标准化连接:无论后端是PostgreSQL、Slack还是本地文件系统,对外暴露的都是统一的MCP协议。

- 热插拔:用户可以在客户端(如Claude Desktop)中动态配置服务器,无需重新编译模型。

- 双向流:不仅仅是AI调用工具,服务器也可以主动向AI推送资源更新(如日志变动)。

1.3 生态位解析:Client, Host, Server的三国演义

理解MCP,必须厘清三个核心角色的关系:

- MCP Host (宿主):发起请求的程序,通常是AI桌面应用(如Claude Desktop)或IDE(如Cursor)。它是“大脑”的容器。

- MCP Client (客户端):Host内部负责与Server通讯的模块,维持1:1的连接。

- MCP Server (服务器):真正的干活方。它是一个轻量级服务,负责通过MCP协议暴露数据(Resources)、模板(Prompts)和能力(Tools)。

🧩 第二章:解剖协议——JSON-RPC与传输层的秘密

2.1 基于JSON-RPC 2.0的消息基石

MCP并不神秘,其底层通信依赖于成熟的JSON-RPC 2.0规范。这意味着它是无状态的、轻量级的。

每一次交互都是一次标准的Request/Response循环。例如,列出可用工具的请求仅仅是一个简单的JSON包。这种设计保证了协议的跨语言兼容性——你可以用Python写Server,用Rust写Client,完全无缝对接。

2.2 传输层的抉择:Stdio vs SSE

MCP支持两种主要的传输方式,适用于不同场景:

- Stdio (标准输入输出):适用于本地集成。Host直接启动Server进程,通过

stdin/stdout通信。优点是配置简单、安全性高(仅本地可见),延迟极低。 - SSE (Server-Sent Events):适用于远程服务。通过HTTP长连接推送消息。优点是可以跨网络部署,适合企业级微服务架构,但需要处理更复杂的认证和网络安全问题。

2.3 生命周期管理:握手、能力协商与保活

连接建立之初,双方会进行一次Initialize握手。

- 能力协商 (Capabilities):Server告诉Client:“我支持资源订阅,但不支持Prompt模板”;Client告诉Server:“我支持采样(Sampling),可以帮你生成辅助代码”。

- 这种协商机制保证了协议的向前兼容性,老旧的Client依然可以连接功能强大的新Server,只是无法使用高级特性。

💎 第三章:MCP的三大支柱——Resources, Prompts, Tools

3.1 Resources(资源):赋予AI“阅读”的能力

资源是数据的直接映射。它类似于GET请求,用于读取文件、数据库记录或API日志。

- URI定位:每个资源都有唯一的URI(如

postgres://db/users/schema)。 - MIME Types:明确告诉LLM这是文本、图片还是JSON数据。

- 订阅机制:这是MCP的一大亮点。Client可以订阅某个资源,当Server端数据变化时,主动通知Client刷新上下文,这对于实时日志监控至关重要。

3.2 Prompts(提示词):标准化的交互模板

不要让用户每次都手写复杂的Prompt。Server可以预设“最佳实践”。

例如,一个Git Server可以提供一个 analyze-commit 的Prompt模板,自动抓取当前的diff信息并包装好提示词,用户只需点击应用。这实现了Prompt Engineering的代码化和复用。

3.3 Tools(工具):赋予AI“行动”的手脚

这是最像Function Calling的部分。

- Schema定义:使用JSON Schema严格定义参数结构(必填项、类型)。

- 执行逻辑:Server端运行实际的Python/Go代码,产生副作用(写库、发邮件)。

- 错误处理:MCP规定了标准的错误返回格式,让LLM能理解是“参数错了”还是“服务器崩了”,从而进行自我修正。

💻 第四章:环境搭建——工欲善其事,必先利其器

4.1 技术栈选型:Python vs TypeScript

虽然MCP协议本身与语言无关,但官方提供了两套成熟的SDK:

- TypeScript SDK:适合前端开发者,利用Zod进行类型定义,体验丝滑。

- Python SDK:数据科学和后端首选。鉴于Python在AI领域的统治地位,本文后续实战将采用Python。

我们需要安装mcp库:pip install mcp。

4.2 调试神器:MCP Inspector

开发MCP Server是不可见的后台进程,如何调试?

官方提供了 MCP Inspector。它是一个Web界面,可以模拟Client端,直接连接你的Server。

你可以手动触发工具调用,查看JSON-RPC消息的原始载荷(Payload),这是排查“为什么模型不调用工具”的终极法宝。

4.3 配置Claude Desktop进行本地联调

为了看到实际效果,我们需要配置Claude Desktop的配置文件(通常位于 ~/Library/Application Support/Claude/claude_desktop_config.json)。

通过配置 command 和 args,我们让Claude启动我们编写的Python脚本作为子进程,从而接管所有的MCP通信。

⚙️ 第五章:深度实战(一)——构建基础架构与协议握手

5.1 项目初始化与依赖注入

我们将构建一个 “Enterprise Data Acolyte” (EDA) —— 一个企业数据侍从。

首先,创建一个标准的Python项目结构。我们将使用 FastMCP (一种高层封装) 或者标准 Server 类。为了展示深度,我们使用标准 Server 类来手动控制细节。

5.2 核心服务器代码骨架

这是MCP Server的心脏。我们需要处理 stdio 连接并初始化Server实例。

import asyncio

from mcp.server import Server

from mcp.server.stdio import stdio_server

from mcp.types import Tool, TextContent, ImageContent, EmbeddedResource

# 定义服务器名称和版本

app = Server("enterprise-data-acolyte")

# 5.3 定义入口函数

async def main():

# 使用标准输入输出作为传输层

async with stdio_server() as (read_stream, write_stream):

await app.run(

read_stream,

write_stream,

app.create_initialization_options()

)

if __name__ == "__main__":

asyncio.run(main())

5.3 注册处理程序(Handlers)

MCP是事件驱动的。我们需要为“列出工具”、“调用工具”、“列出资源”注册回调函数。

这一章重点在于让服务器“跑通”,能够被Inspector识别到,并成功完成握手。

🛡️ 第六章:深度实战(二)——实现动态SQLite数据分析工具

6.1 场景定义:不仅是查询,更是洞察

简单的SELECT *没有意义。我们要实现一个工具,它能接受自然语言意图,将其转化为安全的SQL,执行并返回分析结果。

这里涉及两个关键MCP概念:

- Tool:

execute_query(执行SQL)。 - Resource:

database_schema(动态暴露表结构给LLM)。

6.2 动态Schema资源注入

LLM必须知道数据库长什么样才能写SQL。我们定义一个Resource,动态读取SQLite的sqlite_master表。

@app.list_resources()

async def list_resources():

return [

Resource(

uri=AnyUrl("sqlite://main/schema"),

name="Main Database Schema",

mimeType="text/plain",

description="The current schema of the business database including tables and columns."

)

]

@app.read_resource()

async def read_resource(uri: AnyUrl):

if str(uri) == "sqlite://main/schema":

# 伪代码:连接数据库获取DDL

schema_text = get_database_schema_as_text()

return ReadResourceResult(

contents=[TextContent(uri=uri, mimeType="text/plain", text=schema_text)]

)

raise ValueError("Resource not found")

6.3 构建鲁棒的SQL执行工具

这里体现专业思考:不能直接让LLM执行任意SQL(SQL注入风险、DELETE风险)。我们需要在Tool层做拦截和校验。

@app.list_tools()

async def list_tools():

return [

Tool(

name="query_business_data",

description="Execute a readonly SQL query to analyze business data.",

inputSchema={

"type": "object",

"properties": {

"sql_query": {

"type": "string",

"description": "The SQL query to execute. Must be SELECT only."

}

},

"required": ["sql_query"]

}

)

]

@app.call_tool()

async def call_tool(name: str, arguments: dict):

if name == "query_business_data":

query = arguments.get("sql_query")

# 安全性检查 (深度实践)

if not query.strip().upper().startswith("SELECT"):

return [TextContent(

type="text",

text="Error: Security Alert! Only SELECT queries are allowed."

)]

try:

results = execute_safe_query(query)

# 将结果格式化为Markdown表格返回,便于LLM理解

return [TextContent(type="text", text=format_as_markdown(results))]

except Exception as e:

return [TextContent(type="text", text=f"Query Execution Error: {str(e)}")]

raise ValueError(f"Tool {name} not found")

🧠 第七章:高阶话题——安全性、上下文窗口与多Agent协同

7.1 上下文窗口管理:Token的经济学

MCP极大地扩展了LLM获取信息的能力,但也带来了Token爆炸的问题。如果直接把整个数据库Schema扔进去,Context Window瞬间爆炸。

最佳实践:

- 分级资源:先提供表名列表(Summary),LLM需要查具体表时,再请求具体表的Resource。

- 采样(Sampling):Server端可以通过MCP协议反向请求LLM压缩数据摘要。

7.2 安全沙箱与人机回环(HITL)

在企业环境,MCP Server拥有极大的权限。

- 只读原则:默认情况下,Server应设计为只读。

- 敏感操作确认:对于写操作(如

update_record),MCP Host(如Claude)通常会弹窗请求用户批准。作为Server开发者,应在Tool描述中明确标注副作用,触发Host的安全机制。

7.3 多Server协同架构

一个复杂的系统往往不是单体的。你可以配置Claude连接多个MCP Server:

- Server A: 负责Postgres数据库。

- Server B: 负责读取Git代码库。

- Server C: 负责执行Python脚本。

LLM作为编排者(Orchestrator),会根据用户问题,先问Server B代码逻辑,再问Server A数据情况,最后综合回答。这就是MCP带来的组合式AI能力。

🔮 第八章:未来展望——MCP将把我们带向何方?

8.1 从“Chat”到“Action”的质变

MCP标志着LLM从单纯的聊天机器人(Chatbot)向真正的智能代理(Agent)进化。它不再只是“知道”世界,而是能“感知”并“改变”世界。

8.2 社区驱动的Protocol Economy

未来会出现公共的MCP Server市场。你不需要自己写Google Calendar集成,直接安装官方提供的 mcp-server-gcal 即可。软件开发范式将从“提供API文档”转变为“提供标准MCP Server”。

8.3 写在最后:开发者的机遇

对于开发者而言,掌握MCP不仅是学会了一个新协议,更是掌握了定义AI如何与你的应用交互的话语权。在这个新时代,如果你不为AI提供MCP接口,你的应用在AI眼中就是隐形的。

让我们开始动手,用MCP连接智慧的孤岛,构建万物互联的智能未来。🚀

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)