我们是否用错误的方式测试AI智能?

我们是否用错误的方式测试AI智能?

当人们想要对人工智能的现状及其意义有一个清醒的认识时,他们往往会求助于圣塔菲研究所的计算机科学家和教授梅兰妮·米切尔。她在2019年出版的《人工智能:思考人类指南》一书,帮助定义了关于当今AI系统能做什么和不能做什么的现代讨论。

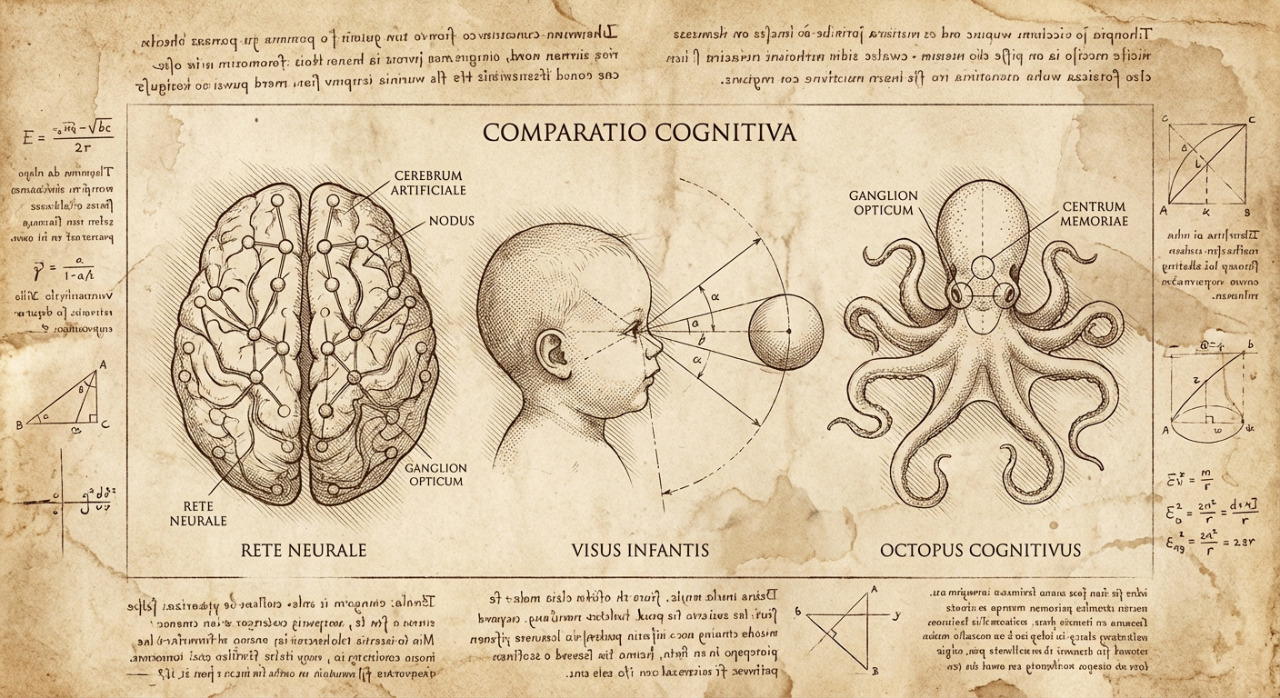

今天,在NeurIPS这一年度最大的AI专业人士聚会上,她发表了题为"关于'外星智能'的科学:评估婴儿、动物和AI的认知能力"的主题演讲。在演讲之前,她与IEEE Spectrum讨论了演讲的主题:为什么今天的AI系统应该像研究非语言思维一样被研究,发展心理学和比较心理学能教给AI研究人员什么,以及更好的实验方法如何重塑我们测量机器认知的方式。

外星智能的概念

你用"外星智能"这个词来形容AI和生物思维,比如婴儿和动物。你是什么意思?

米切尔:希望你注意到了"外星智能"周围的引号。我引用的是神经网络先驱特伦斯·塞伊诺夫斯基的一篇论文,他把ChatGPT比作能与我们交流并看起来智能的外星人。然后还有发展心理学家迈克尔·弗兰克的另一篇论文,他延续了这个主题,说我们在发展心理学中研究外星智能,即婴儿。我们有一些方法,认为可能有助于分析AI智能。这就是我所玩味的概念。

当人们谈论评估AI智能时,他们试图测量什么样的智能?推理、抽象、世界建模还是其他什么?

米切尔:以上所有。人们使用"智能"这个词时意思不同,智能本身有所有这些不同的维度,正如你所说。所以,我使用了"认知能力"这个术语,这更具体一些。我正在研究发展心理学和比较心理学中如何评估不同的认知能力,并试图将这些领域的一些原则应用到AI中。

当前AI评估的问题

你说AI领域缺乏评估认知的良好实验协议。今天的AI评估是什么样的?

米切尔:评估AI系统的典型方法是有一些基准测试集,在这些基准任务上运行你的系统并报告准确性。但通常事实证明,即使我们现在拥有的这些AI系统在基准测试上表现出色,超越了人类,这种性能往往不能转化为现实世界中的性能。如果一个AI系统通过了律师资格考试,这并不意味着它在现实世界中会成为一个好律师。通常机器在那些特定问题上表现良好,但不能很好地泛化。此外,为评估人类而设计的测试对AI系统做出的假设不一定相关或正确,比如关于系统记忆能力的假设。

作为一名计算机科学家,我没有接受过实验方法学的训练。对AI系统进行实验已经成为评估系统的核心部分,而大多数通过计算机科学成长起来的人都没有接受过这种训练。

心理学的实验方法启示

发展心理学家和比较心理学家在探测认知方面知道什么,AI研究人员也应该知道?

米切尔:作为心理学学生,特别是在发展心理学和比较心理学等领域,你会学到各种实验方法学,因为这些是非语言智能体。你必须真正创造性地思考如何探测它们。所以他们有各种方法,包括非常仔细的对照实验和对刺激进行大量变化以检查鲁棒性。他们仔细观察失败模式,系统为什么可能失败,因为这些失败比成功能提供更多关于正在发生什么的洞察。

你能给我一个具体的例子,说明这些实验方法在发展心理学或比较心理学中是什么样的吗?

米切尔:一个经典例子是聪明汉斯。有一匹马叫聪明汉斯,它似乎能够做各种算术、计数和其他数字任务。这匹马会用蹄子敲出答案。多年来,人们研究它并说:"我认为这是真的。这不是骗局。"但后来一位心理学家来了,说:"我要认真思考正在发生的事情,做一些对照实验。"他的对照实验是:首先,给马蒙上眼罩,其次,在马和提问者之间放一个屏幕。结果发现,如果马看不到提问者,它就无法完成任务。他发现马实际上是在感知提问者非常微妙的面部表情线索,以知道何时停止敲击。所以想出对正在发生的事情的替代解释很重要。不仅要对其他人的研究持怀疑态度,甚至可能对你自己的研究、你自己最喜欢的假设持怀疑态度。我认为这在AI中发生得不够。

你有来自婴儿研究的案例研究吗?

米切尔:我有一个案例研究,声称婴儿有天生的道德感。实验向他们展示了视频,其中有一个卡通角色试图爬上山丘。在一种情况下,有另一个角色帮助他们上山,在另一种情况下,有一个角色把他们推下山。所以有帮助者和阻碍者。评估婴儿更喜欢哪个角色——他们有几种方法来做到这一点——压倒性地,他们更喜欢帮助者角色。

但另一个研究小组非常仔细地观察了这些视频,发现在所有帮助者视频中,被帮助的攀登者很兴奋地到达山顶并上下弹跳。所以他们说:"好吧,如果在阻碍者的情况下,我们让攀登者在山底弹跳会怎样?"这完全扭转了结果。婴儿总是选择弹跳的那个。

再次,即使你有你最喜欢的假设,想出替代方案也是我们做科学的方式。在AI中总是让我有点震惊的一件事是,人们把"怀疑论者"这个词用作负面词汇:"你是大语言模型怀疑论者。"但我们的工作就是成为怀疑论者,这应该是一种赞美。

AI研究的科学方法改进

这两个例子都说明了寻找反解释的主题。你认为AI研究人员应该从心理学中汲取的其他重要教训是什么?

米切尔:嗯,在科学中,复制实验的想法真的很重要,还有建立在其他人工作基础上。但在AI世界中,这有点令人遗憾地不受欢迎。例如,如果你向NeurIPS提交一篇论文,你复制了某人的工作,然后你做了一些增量的事情来理解它,审稿人会说:"这缺乏新颖性,而且是增量的。"这对你的论文来说是死亡之吻。我觉得这应该得到更多赞赏,因为这是做好科学的方式。

回到测量AI的认知能力,有很多关于我们如何测量朝向通用人工智能进展的讨论。这是另一批问题吗?

米切尔:嗯,通用人工智能这个术语有点模糊。人们以不同的方式定义它。我认为很难为没有很好定义的东西测量进展。我们对它的概念一直在变化,部分是为了回应AI中发生的事情。在AI的早期,人们会谈论人类水平的智能和机器人能够做人类做的所有物理事情。但人们看了机器人技术后说:"好吧,它不会很快到达那里。让我们只谈论人们所说的智能的认知方面,"我认为这并不是真正可分离的。所以我是一个通用人工智能怀疑论者,如果你愿意的话,以最好的方式。

Q&A

Q1:为什么当前的AI基准测试方法存在问题?

A:当前AI评估主要依赖基准测试,虽然AI系统在这些测试上表现出色甚至超越人类,但这种性能往往无法转化为现实世界的表现。比如AI通过律师资格考试不意味着它能成为好律师。机器通常只在特定问题上表现良好,但泛化能力差。

Q2:心理学实验方法能为AI研究提供什么启示?

A:心理学特别是发展心理学和比较心理学有丰富的实验方法,因为它们研究非语言智能体。这些方法包括仔细的对照实验、对刺激进行多种变化检查鲁棒性,以及重点关注失败模式。失败往往比成功能提供更多关于系统运作机制的洞察。

Q3:聪明汉斯的例子说明了什么问题?

A:聪明汉斯是一匹看似会算术的马,通过蹄子敲击给出答案。心理学家通过对照实验发现,当给马蒙眼或在马和提问者间放屏幕时,马就无法完成任务。原来马是通过感知提问者微妙的面部表情来知道何时停止敲击,这说明寻找替代解释的重要性。

更多推荐

已为社区贡献360条内容

已为社区贡献360条内容

所有评论(0)