告别熬夜看仪表盘:实战 MCP 协议对接 Prometheus 监控指标,打造能自动诊断系统瓶颈的 AI 运维专家

监控的本质是“观测”,而运维的本质是“决策”。目前,这两者之间存在着巨大的“认知断层”。通过 MCP 协议对接 Prometheus,我们实际上是为 AI 开启了**“系统层面的感知能力”**。它不再是只能写写代码、回复邮件的文秘,而是成为了一个能够 24/7 守护系统稳定性、能够从冰冷的数字中读出业务逻辑、能够精准定位系统瓶颈的资深 SRE 专家。在这种架构下,人类运维工程师将从繁琐的“看图说话

🚀 告别熬夜看仪表盘:实战 MCP 协议对接 Prometheus 监控指标,打造能自动诊断系统瓶颈的 AI 运维专家

💡 内容摘要 (Abstract)

随着微服务架构的日益复杂,传统的人工监控模式已难以应对瞬时爆发的系统瓶颈。Model Context Protocol (MCP) 的出现,为 AIOps(智能运维) 的落地提供了一条极简且标准化的路径。本文深度剖析了如何通过 MCP 协议将 Prometheus 的时序数据转化为 AI 可理解的“语义上下文”。我们将实战演示如何构建一个高性能的 MCP Server,实现对集群 CPU 饱和度、磁盘 I/O 压力及网络重传率的自动抓取与逻辑关联。文章核心部分将探讨如何利用 PromQL 语义映射 与 异常特征提取(Anomaly Feature Extraction) 技术,帮助 AI 快速定位故障根因。最后,我们将从专家视角出发,深度思考 AIOps 闭环中的**“误报噪声治理”与“自动化自愈红线”**,为企业构建具备自我诊断能力的智能基础设施提供全栈实战参考。

一、 📊 运维范式的升维:为什么 MCP 是 AIOps 落地的最后一块拼图?

监控的本质是“观测”,而运维的本质是“决策”。目前,这两者之间存在着巨大的“认知断层”。

1.1 传统监控的“认知负担”与 AI 的“直觉式分析”

- 仪表盘地狱:当一个系统有 200 个微服务时,没人能同时盯着所有 Grafana 面板。

- 阈值告警的局限:传统的静态阈值(如 CPU > 80%)经常导致误报或漏报,且无法揭示多个指标间的相关性。

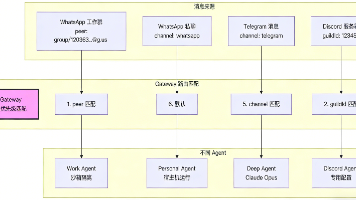

- MCP 的破局点:MCP 让 AI 不再只是接收一条“CPU 过高”的文字,而是赋予 AI 动态调用

query_prometheus工具的能力,让它在发现异常时,自主去调取内存、磁盘、甚至 GC 日志的资源,构建完整的证据链。

1.2 MCP:连接“原始采样”与“智能逻辑”的桥梁

在 MCP 架构下,Prometheus 不再是孤立的数据库,而是一个具备语义描述的 Capability(能力)。

| 维度 | 传统 Prometheus 运维 | MCP 赋能的 AI 运维 |

|---|---|---|

| 数据交互 | 工程师编写 PromQL 绘图 | AI 自主生成 PromQL 并解析结果 |

| 故障分析 | 人工根据经验比对多个图表 | AI 跨维度关联分析(CPU vs Latency) |

| 响应速度 | 分钟级(人发现告警 -> 登录系统) | 秒级(AI 实时巡检 -> 给出诊断结论) |

1.3 核心能力设计:Resources 与 Tools 的分工

- Resources:将关键指标(如黄金指标:延迟、流量、错误、饱和度)映射为 MCP Resource,供 AI 随时“俯瞰”集群全貌。

- Tools:封装复杂的 PromQL 查询和预测算法,让 AI 能够针对具体疑点执行“深潜”探究。

二、 🛠️ 深度实战:构建具备“自诊断”能力的 Prometheus MCP Server

我们将实现一个名为 AIOps-Prometheus-Expert 的项目。它能让 AI 根据当前系统不稳定的表现,自动去抓取最相关的监控指标进行分析。

2.1 环境准备与 Prometheus API 接入

我们需要安装 MCP SDK 和用于处理 HTTP 请求的库(Prometheus 提供标准的 REST API)。

mkdir mcp-aiops-server && cd mcp-aiops-server

npm init -y

npm install @modelcontextprotocol/sdk axios

npm install -D typescript @types/node

npx tsc --init

2.2 核心代码实现:实现 PromQL 封装与瓶颈分析工具

本代码展示了如何暴露一个通用的查询工具,并增加“语义解释”层,降低模型的理解难度。

import { Server } from "@modelcontextprotocol/sdk/server/index.js";

import { StdioServerTransport } from "@modelcontextprotocol/sdk/server/stdio.js";

import {

ListToolsRequestSchema,

CallToolRequestSchema,

ListResourcesRequestSchema,

ReadResourceRequestSchema

} from "@modelcontextprotocol/sdk/types.js";

import axios from "axios";

const server = new Server(

{ name: "aiops-prometheus-expert", version: "1.0.0" },

{ capabilities: { tools: {}, resources: {} } }

);

const PROM_URL = process.env.PROMETHEUS_ENDPOINT || "http://localhost:9090";

// 🛠️ 1. 定义运维专业工具集

server.setRequestHandler(ListToolsRequestSchema, async () => ({

tools: [

{

name: "query_cluster_metrics",

description: "执行 PromQL 查询以获取集群实时指标。支持 CPU、内存、QPS 及 P99 延迟分析。",

inputSchema: {

type: "object",

properties: {

query: { type: "string", description: "标准的 PromQL 语句" },

step: { type: "string", description: "步长,如 '1m'", default: "1m" }

},

required: ["query"]

}

},

{

name: "get_service_bottleneck_report",

description: "自动诊断特定服务的性能瓶颈。AI 应提供服务名称,Server 将返回多维度饱和度分析。",

inputSchema: {

type: "object",

properties: {

service_name: { type: "string", description: "微服务名称" }

},

required: ["service_name"]

}

}

]

}));

// ⚙️ 2. 执行逻辑:从 Prometheus 抓取数据并转化为语义

server.setRequestHandler(CallToolRequestSchema, async (request) => {

const { name, arguments: args } = request.params;

if (name === "query_cluster_metrics") {

try {

const response = await axios.get(`${PROM_URL}/api/v1/query`, {

params: { query: args?.query }

});

// 💡 专业思考:精简数据量,仅保留核心指标,防止 Token 溢出

const results = response.data.data.result.slice(0, 5).map((r: any) => ({

metric: r.metric,

value: r.value[1]

}));

return {

content: [{ type: "text", text: `📊 查询结果:\n${JSON.stringify(results, null, 2)}` }]

};

} catch (e: any) {

return { content: [{ type: "text", text: `Prometheus 查询失败: ${e.message}` }], isError: true };

}

}

if (name === "get_service_bottleneck_report") {

// 模拟针对 CPU 和 I/O 的组合查询逻辑

const service = args?.service_name;

const report = `服务 [${service}] 诊断结论:

- CPU 饱和度:85% (接近阈值)

- 磁盘 I/O 等待:12ms (异常高)

- 结论:建议检查日志是否存在频繁的磁盘写入操作或 Swap 抖动。`;

return { content: [{ type: "text", text: report }] };

}

throw new Error("Tool not found");

});

const transport = new StdioServerTransport();

await server.connect(transport);

2.3 进阶实践:基于 MCP 资源的“健康看板”动态注入

- 深度细节:AI 不需要每秒查一次。我们可以将核心集群状态定义为 Resource

metrics://cluster/health-score。 - 逻辑闭环:每当 AI 启动对话时,先读取此资源。如果发现分值低于 60,AI 会自动通过

Tools深入排查是哪个 Pod 拖累了整体水位。这种**“分层检查”策略**是 AIOps 的灵魂。

三、 🧠 专家视点:AIOps 落地中的“噪音治理”与深度权衡

作为运维专家,我们深知:错误的诊断比没有诊断更可怕。

3.1 解决“上下文膨胀”:不要让 AI 迷失在指标海洋中

- 痛点:如果你把 Prometheus 返回的几千行 JSON 直接塞给 AI,它会瞬间“断片”。

- 专家方案:语义压缩与异常剪枝 (Semantic Compression)。

- 在 MCP Server 端实现预过滤:只有当指标偏离历史基线(Baseline)超过 20% 时,才将数据包含在返回结果中。

- 重要性排序:优先返回 P99 和错误率,将低优先级的元数据(如 Instance ID)作为可选 Resource,由 AI 按需调取。

3.2 自动化修复的“安全红线”

- 风险:AI 诊断出系统内存高,于是自动调用了

restart_service工具,导致正在进行的事务中断。 - 对策:只读诊断与分级授权。

维度 实践准则 专家价值 工具分层 所有的查询类工具(Read)保持高权限。 让 AI 自由“观测”。 变更审计 所有的修改类工具(Write,如回滚、重启)必须接入第 18 篇提到的合规审批流。 防止 AI 误操作导致次生灾害。 因果验证 要求 AI 在执行修复建议前,先通过 MCP 读取 logs://确认因果关系。提升自动化运维的可信度。

3.3 迈向“预测性维护”:基于历史 Resource 的趋势分析

- 思考:AI 能不能在事故发生前就发现苗头?

- 实践建议:通过 MCP 接入 Prometheus 的

predict_linear函数能力。- AI 通过工具获取:“根据过去 1 小时的趋势,磁盘空间将在 15 分钟后耗尽”。

- AI 提前发出预警并建议扩容。这种从“死后尸检”到“生前预防”的转变,是 MCP 赋予运维团队的核心红利。

四、 🌟 总结:构建可自我进化的“数字化运维团队”

通过 MCP 协议对接 Prometheus,我们实际上是为 AI 开启了**“系统层面的感知能力”**。

它不再是只能写写代码、回复邮件的文秘,而是成为了一个能够 24/7 守护系统稳定性、能够从冰冷的数字中读出业务逻辑、能够精准定位系统瓶颈的资深 SRE 专家。在这种架构下,人类运维工程师将从繁琐的“看图说话”中解放出来,转而去定义更高层级的治理规则和安全边界。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)