腾讯云部署bisheng毕昇

本文介绍了开源大模型开发平台毕昇(Bisheng)的部署流程。首先在腾讯云服务器上安装基础依赖,包括Docker、Docker Compose和Git。然后克隆毕昇项目并启动服务,配置安全组规则后即可通过公网IP访问Web界面。接着安装Milvus向量数据库和ElasticSearch搜索引擎,为平台提供数据存储和检索支持。整个部署过程详细展示了从环境准备到服务启动的关键步骤,最终实现了一个可登录

小白学习记录,如有错误,请大家多多指教。

文章目录

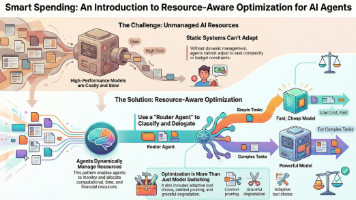

毕昇bisheng项目介绍

毕昇(Bisheng)是 DataElement 团队开发的开源大模型应用开发平台,专为企业级场景设计。

毕昇基于 Langchain、Langflow 等流行的开源技术栈构建,以中国古代活字印刷术发明人毕昇命名,寓意推动知识和智能应用的广泛传播与高效开发。它是完全开源的项目,允许企业进行二次开发和定制化,免费使用,目标是降低大模型应用的开发门槛,满足企业级需求。

项目文档:https://dataelem.feishu.cn/wiki/ZxW6wZyAJicX4WkG0NqcWsbynde

项目地址:https://github.com/dataelement/bisheng

前置准备

进入腾讯云服务器CVM,点击“立即选购”

租用云服务器,我租用的配置如图

创建实例后进行登录

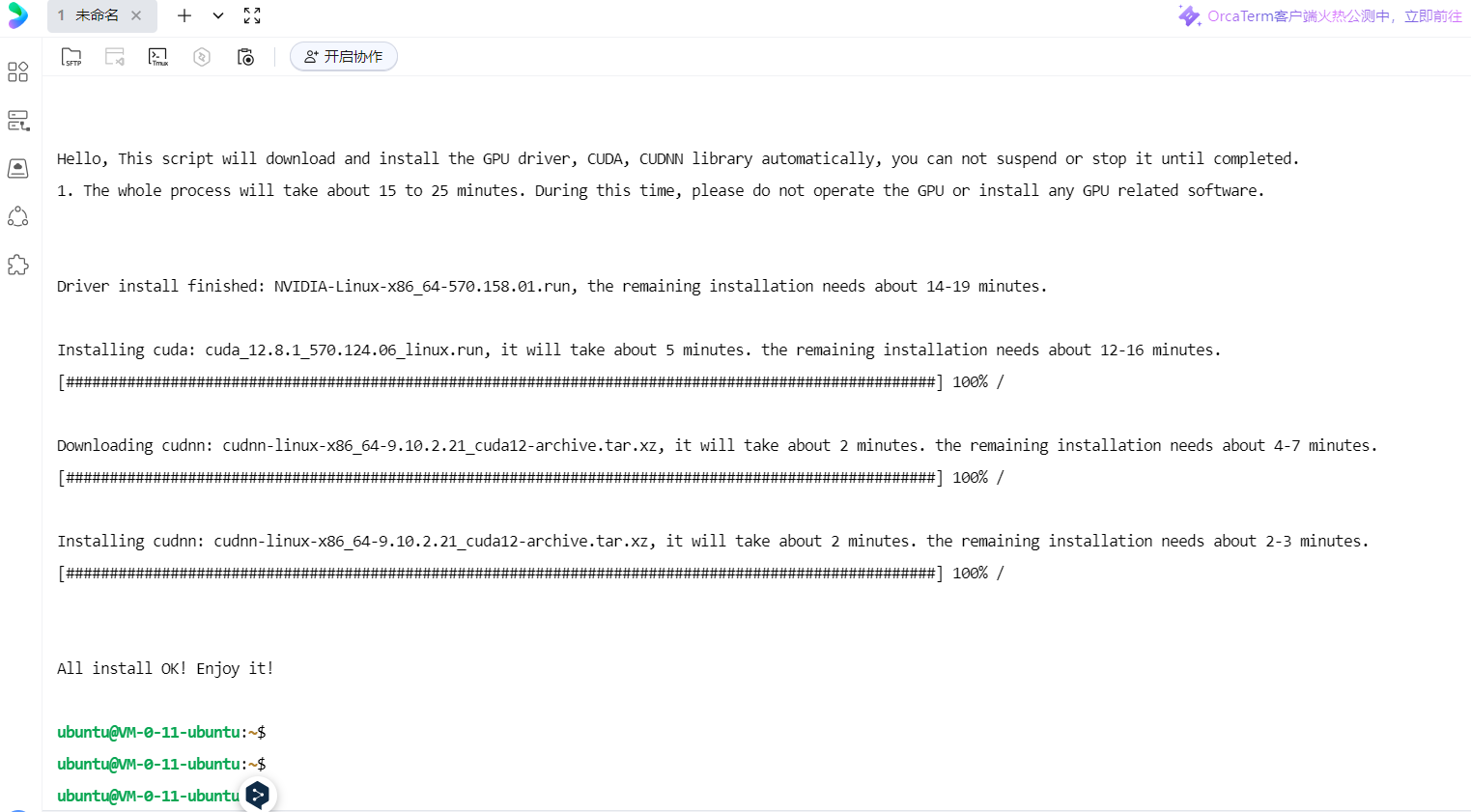

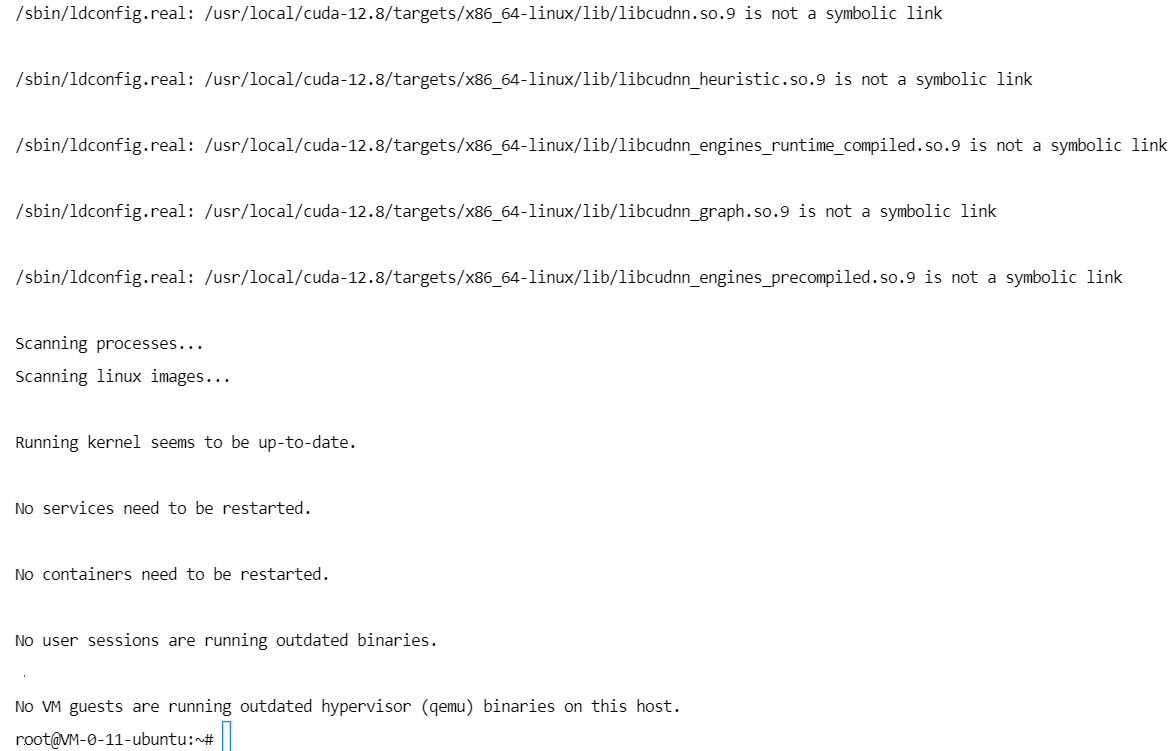

至此,显卡驱动和一些依赖已安装成功。

一、安装基础依赖

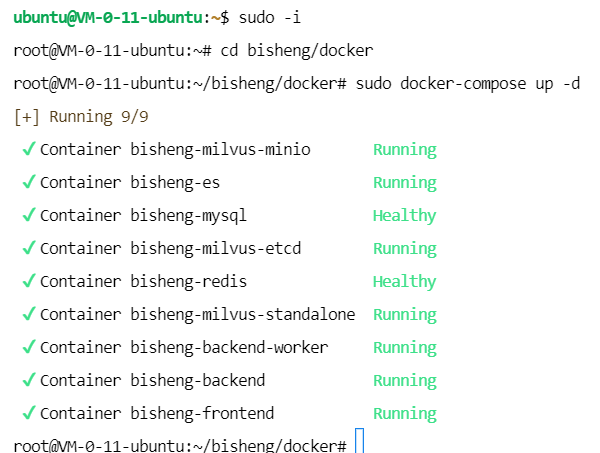

首先输入sudo -i 获得权限,接下来,需要安装Docker、Docker Compose、Git。

1、Docker 安装

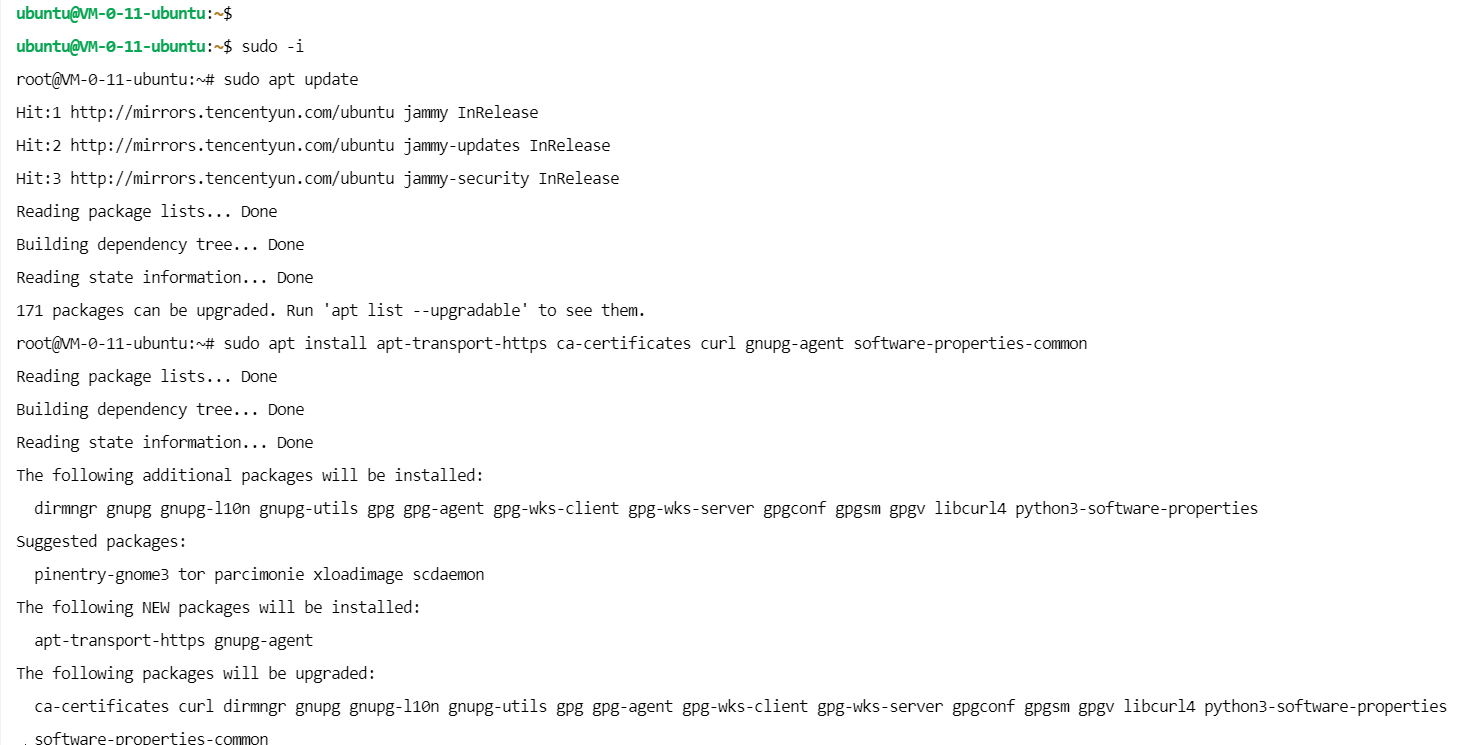

更新软件包索引

sudo apt update

sudo apt install apt-transport-https ca-certificates curl gnupg-agent software-properties-common

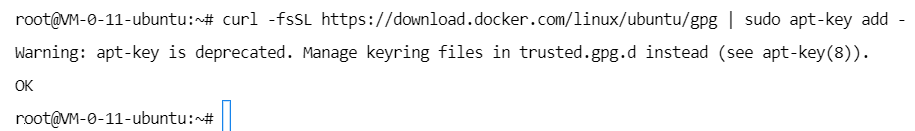

使用下面的 curl 导入源仓库的 GPG key

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add -

将 Docker APT 软件源添加到系统

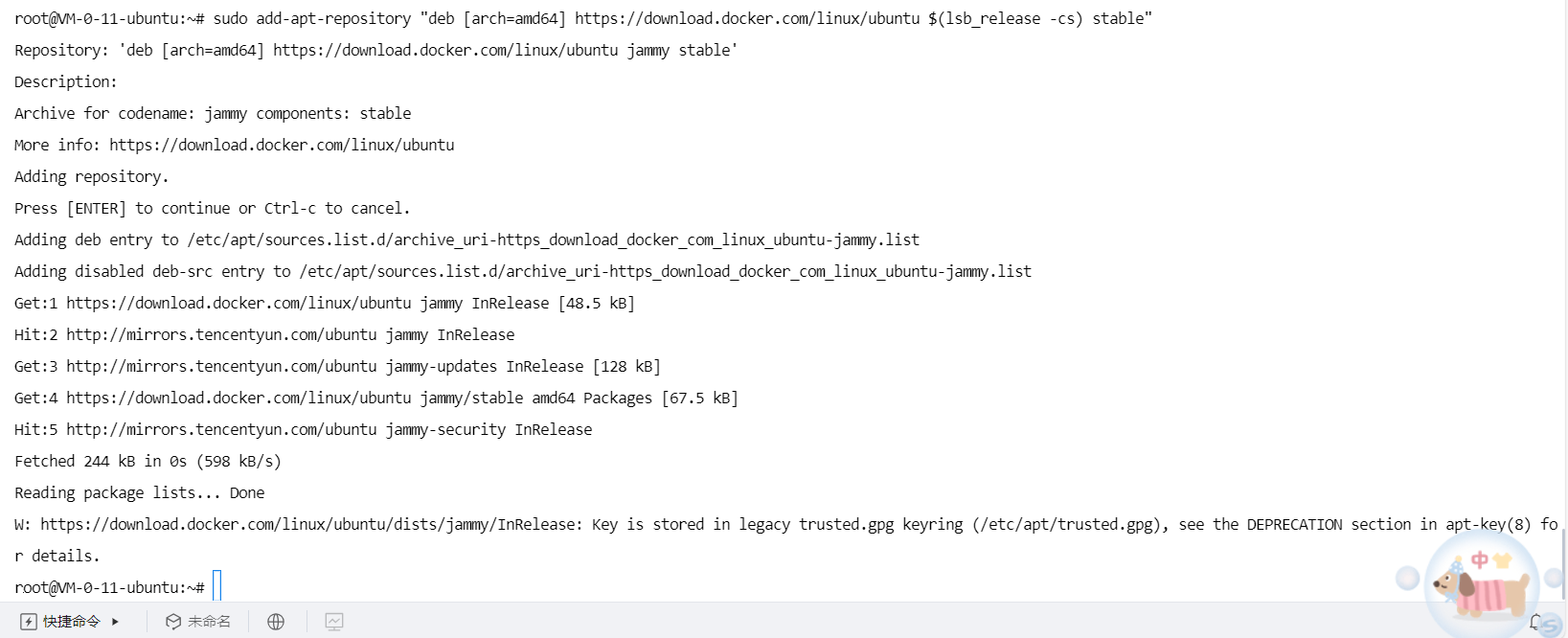

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable"

再次更新软件包索引

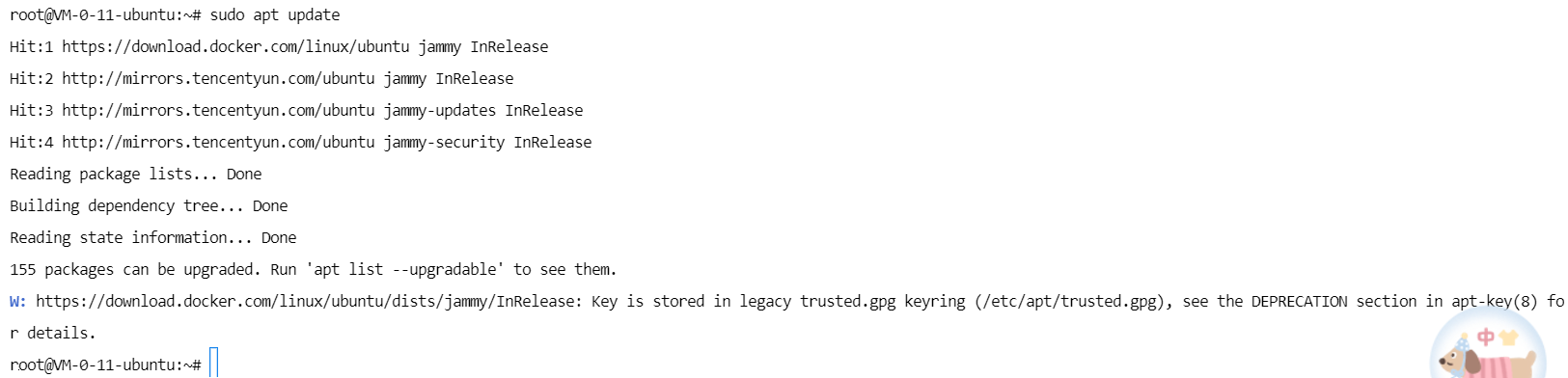

sudo apt update

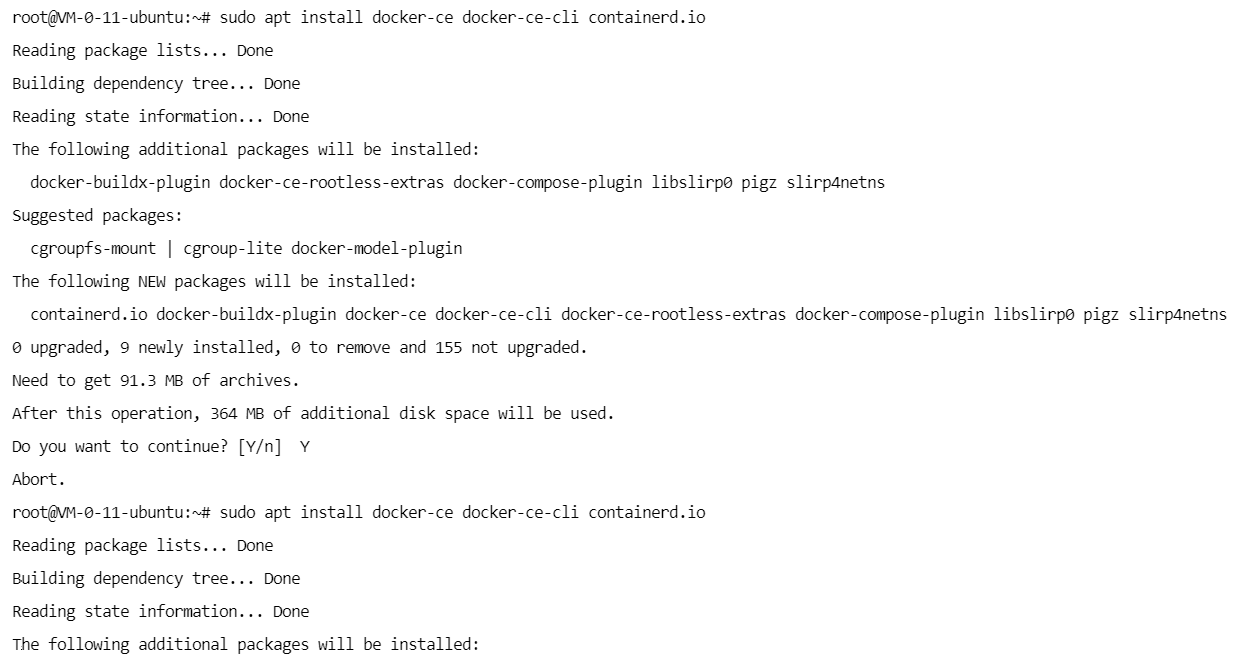

安装docker

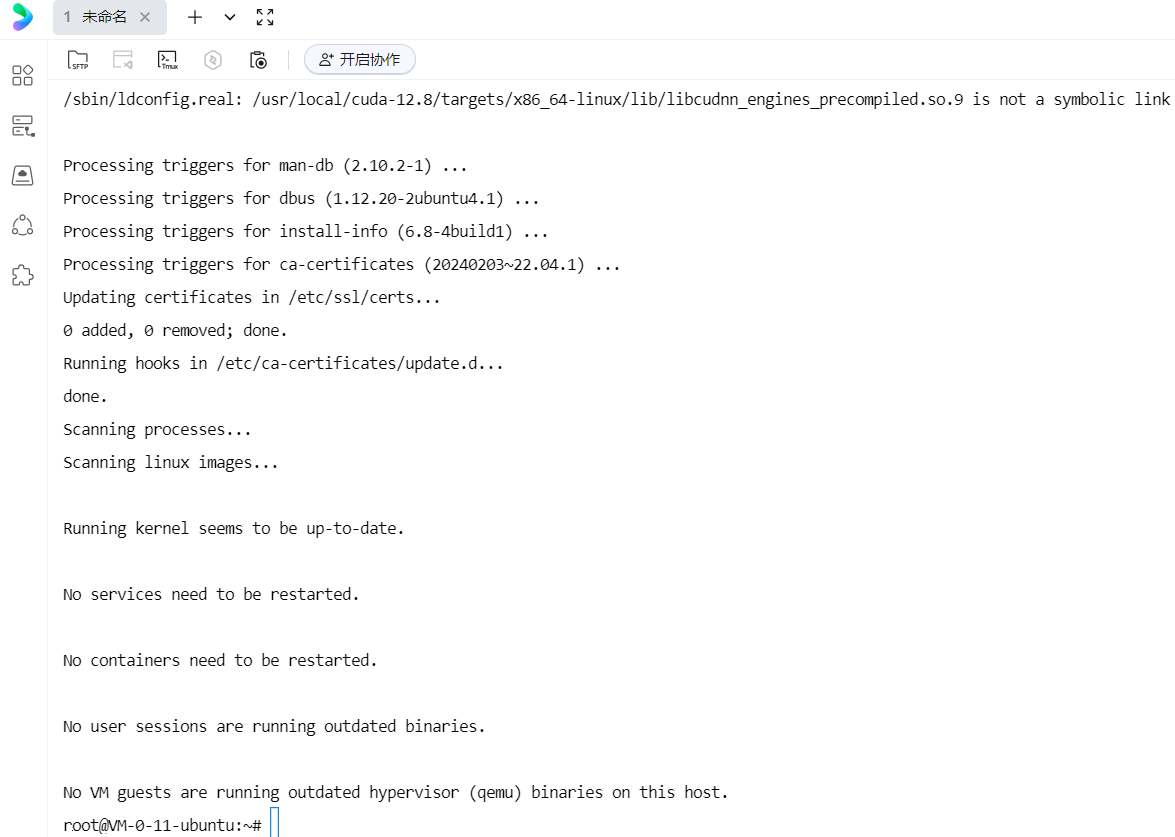

sudo apt install docker-ce docker-ce-cli containerd.io

查看是否安装成功

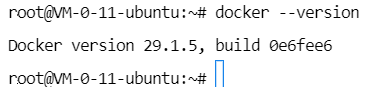

docker --version

至此,Docker安装成功。

2、docker-compose 安装

安装

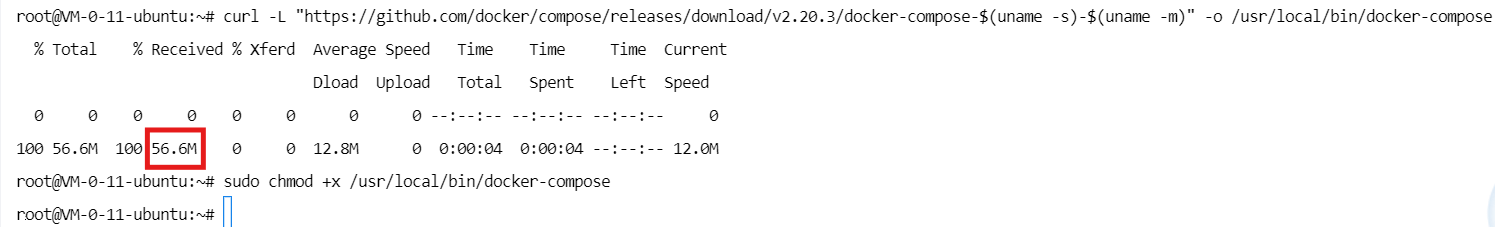

curl -L "https://github.com/docker/compose/releases/download/v2.20.3/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose

查看是否安装成功

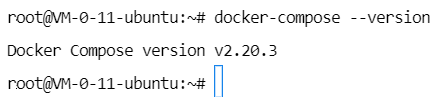

docker-compose --version

安装成功。

3、Git 安装并克隆项目

安装git

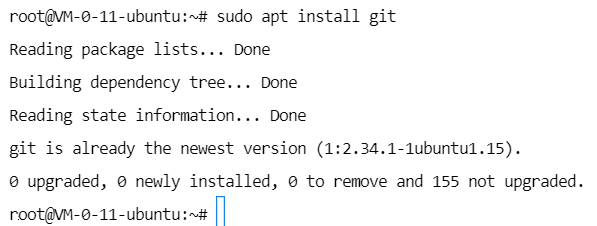

sudo apt install git

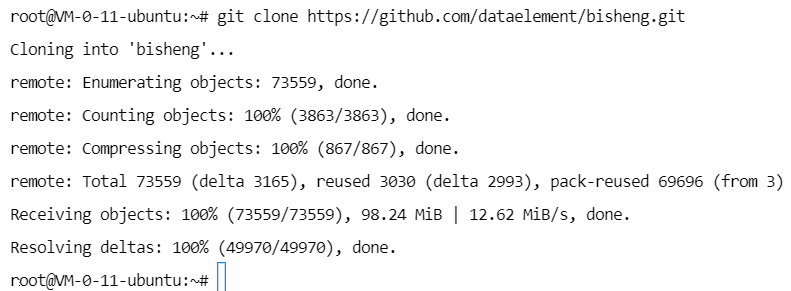

克隆项目

git clone https://github.com/dataelement/bisheng.git

进入项目目录

cd bisheng/docker

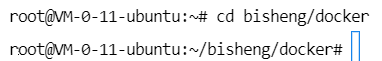

安装项目

sudo docker-compose up -d

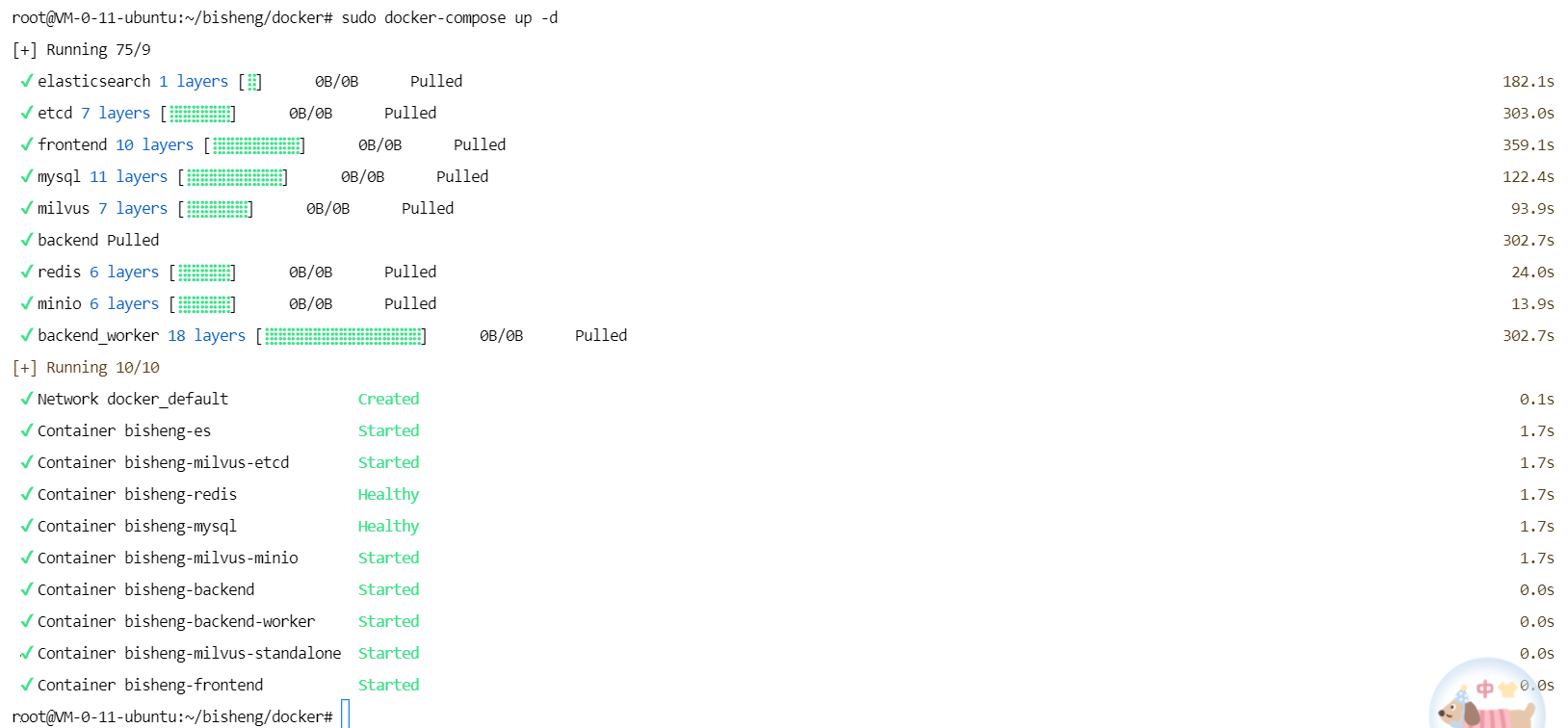

此时可以复制公网IP

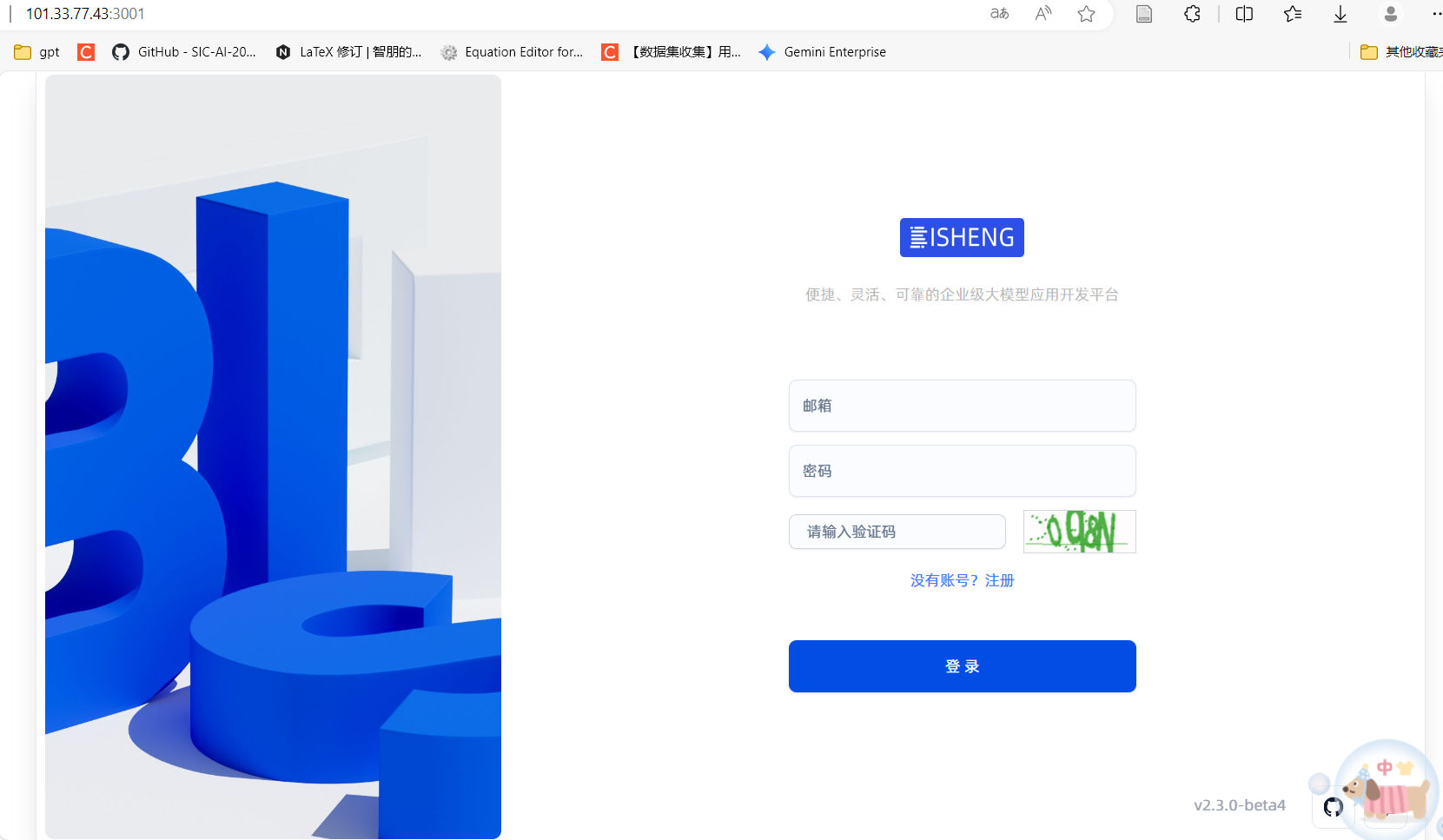

访问http://101.33.77.43:3001/,页面无法访问。

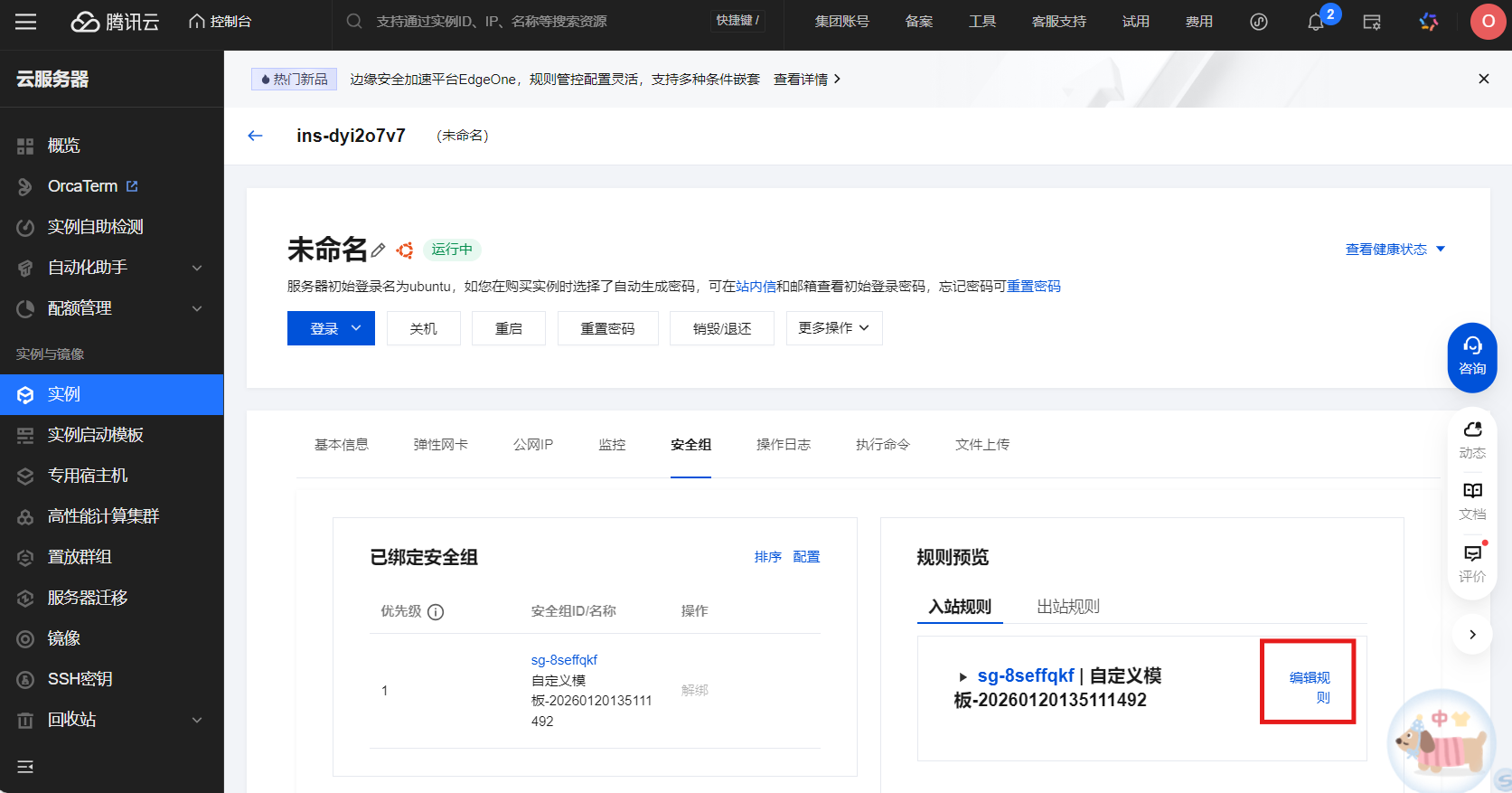

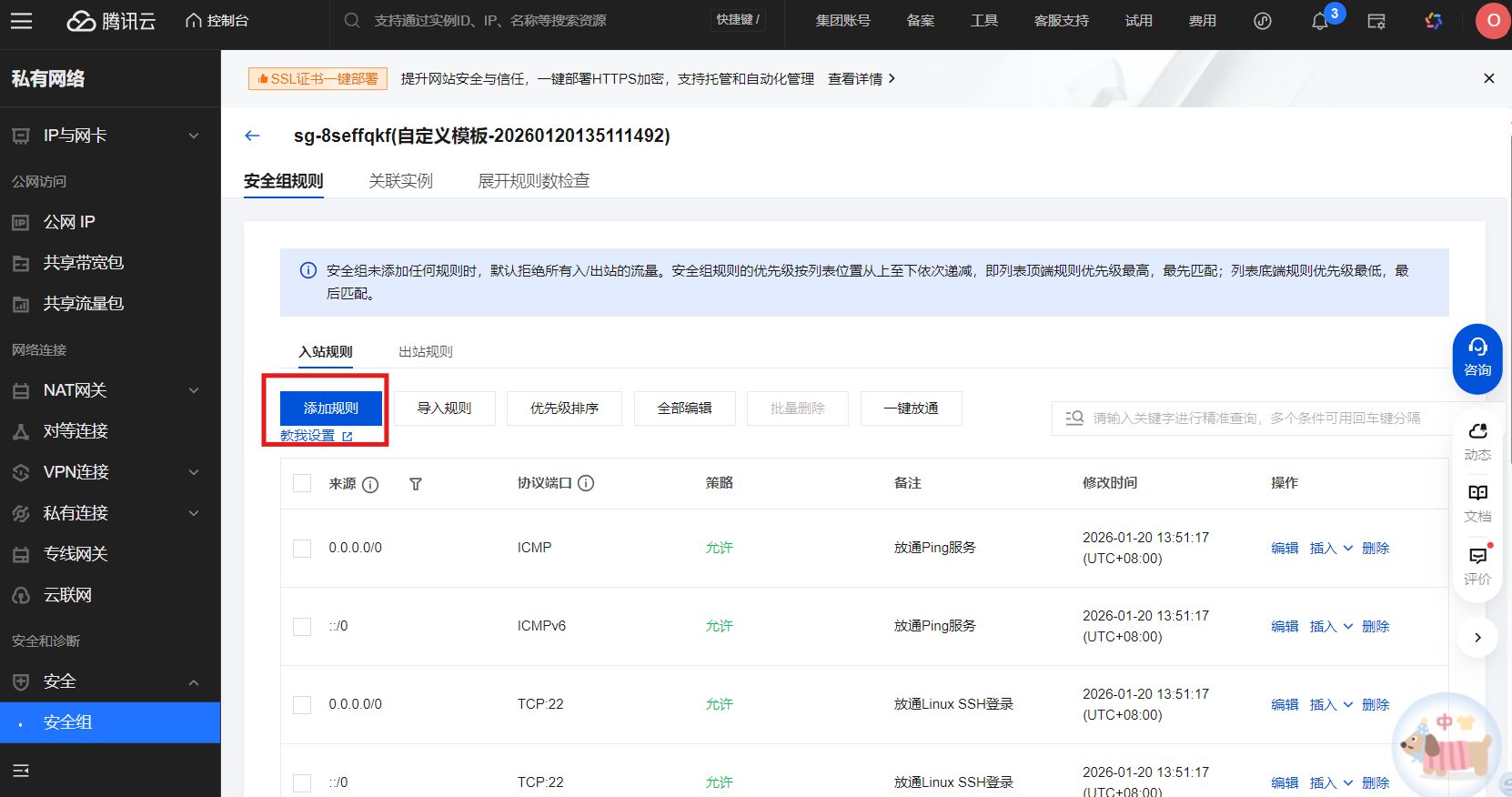

进入实例,新建安全组规则

重新刷新http://101.33.77.43:3001/,这时可以访问。

若刷新后页面还是无法访问,可以回到终端,重启nginx服务

docker restart docker-nginx-1

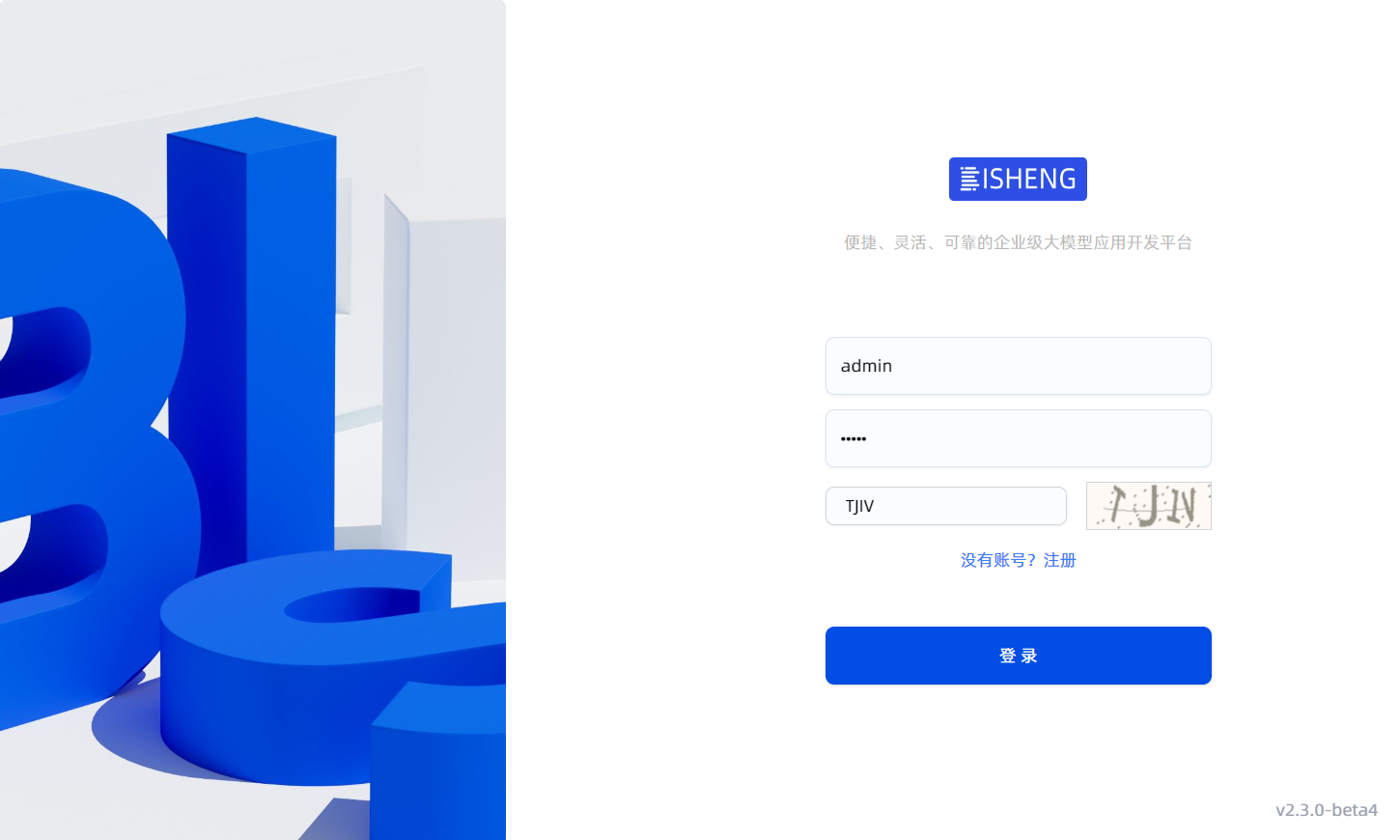

下面注册账号密码并进行登录

登录成功后可以开始对话

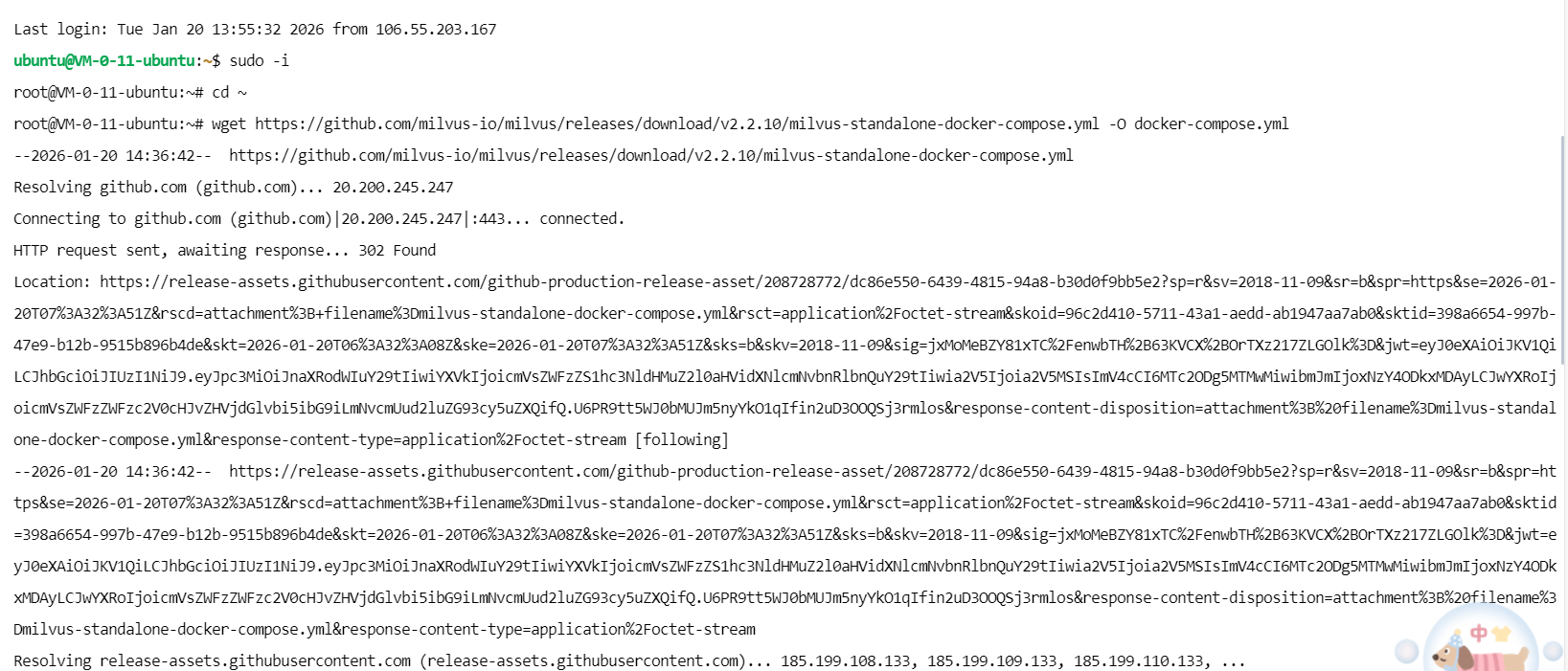

二、安装 Milvus(向量数据库)

到根目录下,安装Milvus

cd ~

wget https://github.com/milvus-io/milvus/releases/download/v2.2.10/milvus-standalone-docker-compose.yml -O docker-compose.yml

运行Milvus

sudo docker-compose up -d

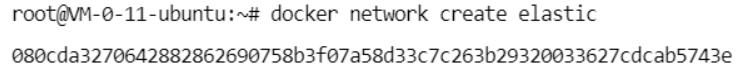

三、安装 ElasticSearch(搜索引擎)

创建一个新的Docker网络

docker network create elastic

拉取指定版本的Elasticsearch Docker镜像

docker pull docker.elastic.co/elasticsearch/elasticsearch:8.9.2

运行Elasticsearch容器

docker run --name elasticsearch --net elastic -p 9200:9200 -p 9300:9300 -e "discovery.type=single-node" -it -d docker.elastic.co/elasticsearch/elasticsearch:8.9.2

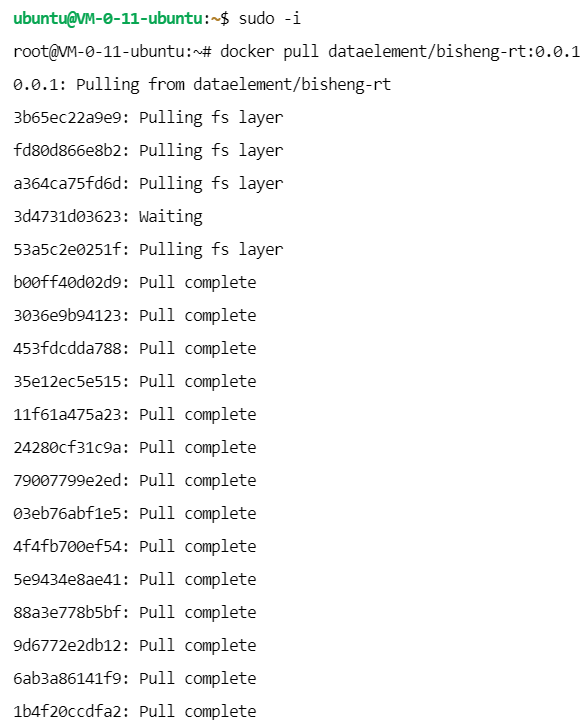

五、BISHENG-RT 安装

拉取项目

docker pull dataelement/bisheng-rt:0.0.1

创建目录

mkdir -p model_repository

进入目录

cd model_repository

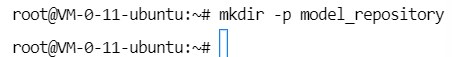

更新索引

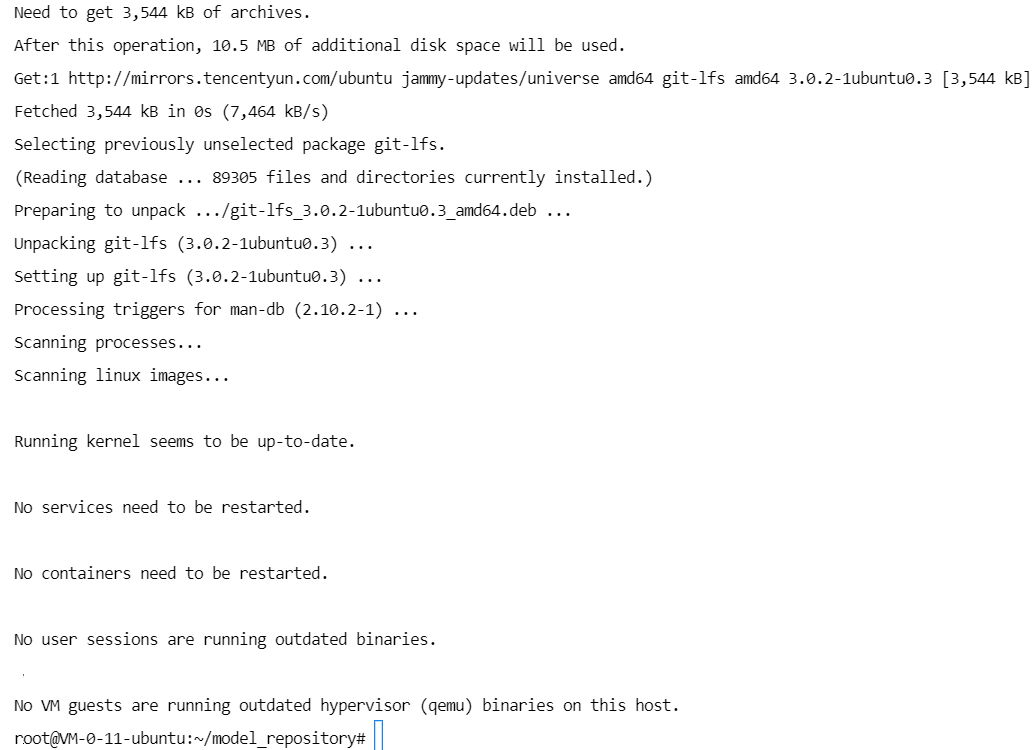

sudo apt update

安装git-lfs

sudo apt install git-lfs

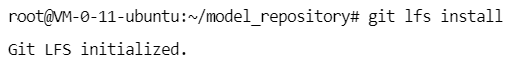

初始化lfs

git lfs install

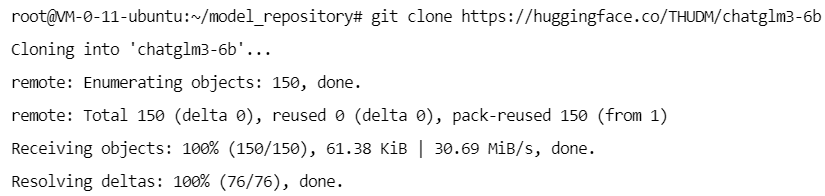

拉取模型

git clone https://huggingface.co/THUDM/chatglm3-6b

看一下有哪些文件

ls

进入你要下载的模型文件目录

cd chatglm3-6b

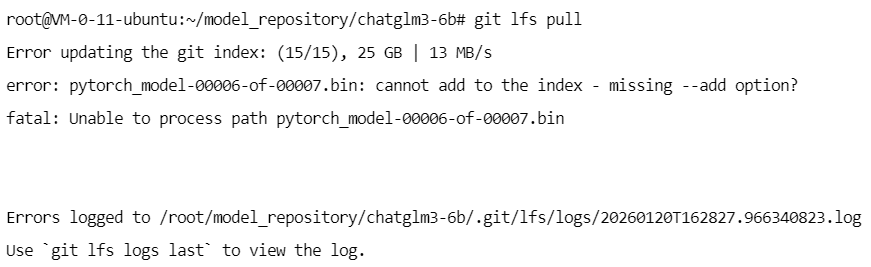

拉取仓库里的大文件

git lfs pull

检查 LFS 对象是否存在

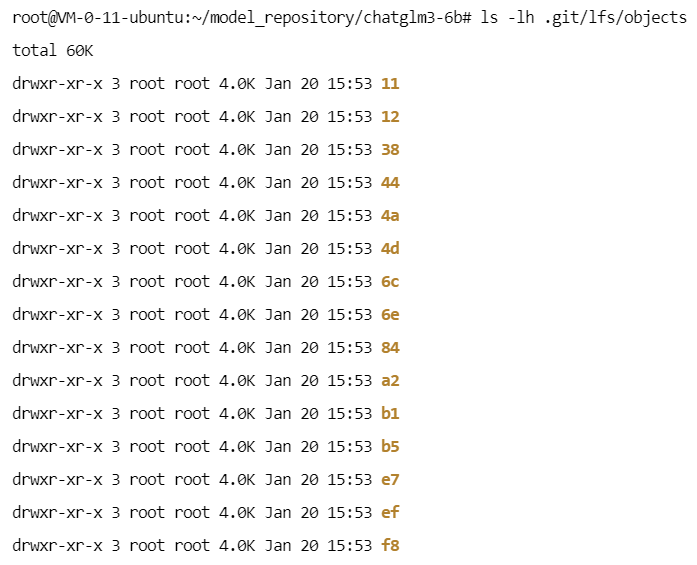

ls -lh .git/lfs/objects

检查文件完整性

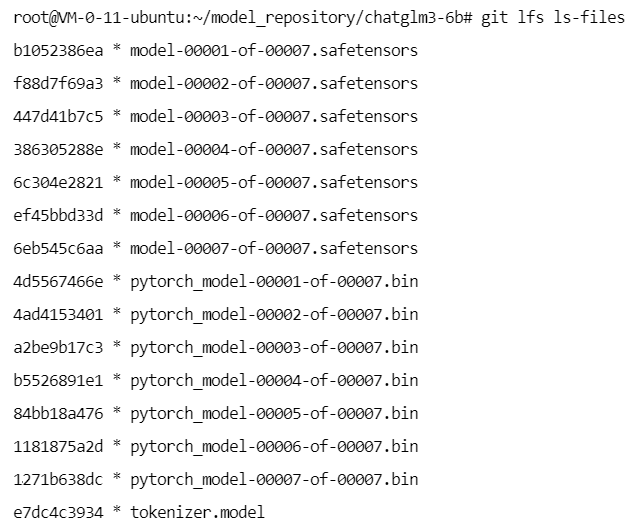

git lfs ls-files

前面有*说明文件是完整的,若不完整,也可以尝试重新下载:git lfs fetch --all

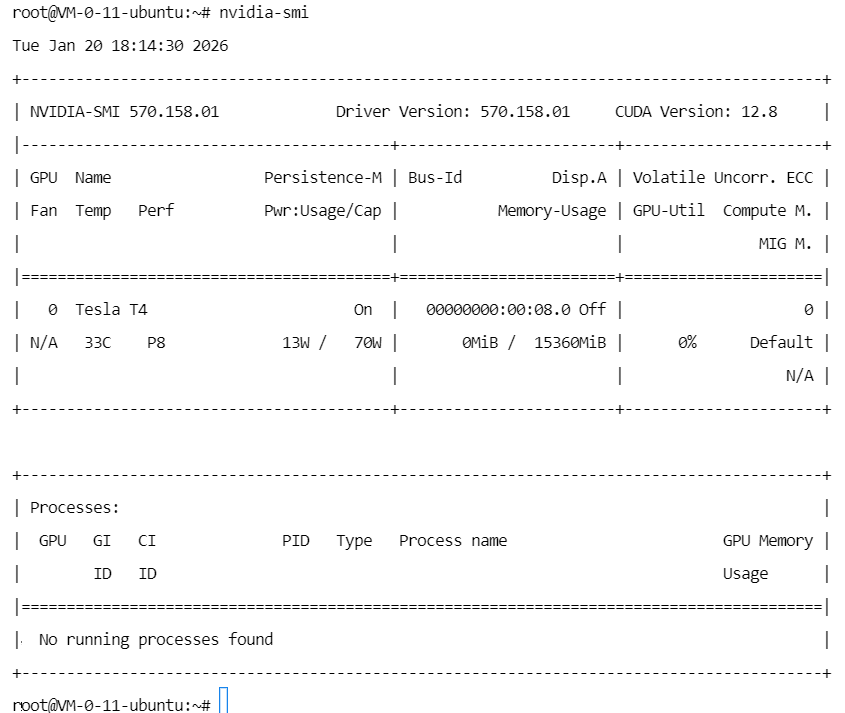

接下来查看NVIDIA显卡驱动和GPU状态

nvidia-smi

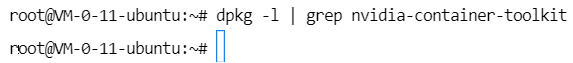

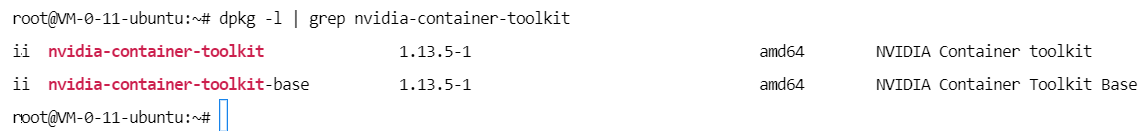

检查 nvidia-container-toolkit 是否已经安装

dpkg -l | grep nvidia-container-toolkit

说明目前没有安装

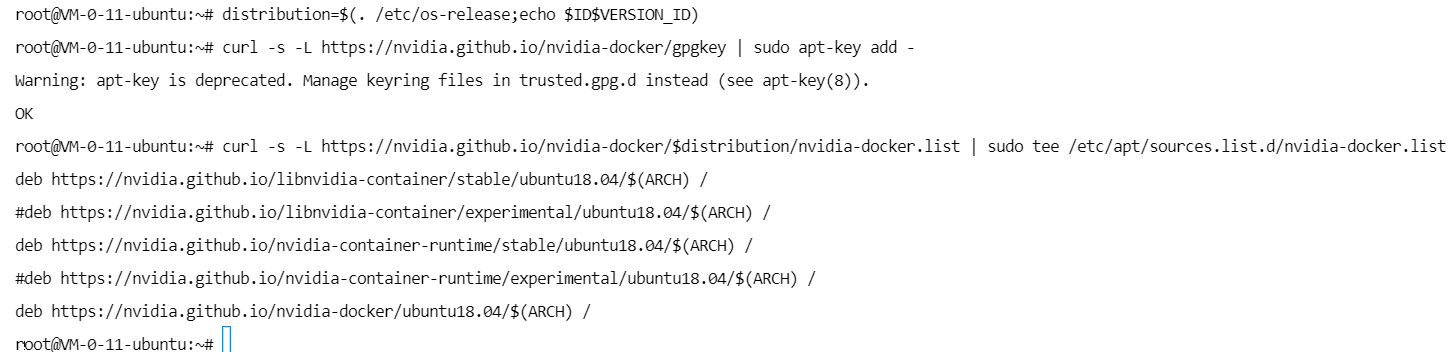

添加NVIDIA的软件包仓库

distribution=$(. /etc/os-release;echo $ID$VERSION_ID)

curl -s -L https://nvidia.github.io/nvidia-docker/gpgkey | sudo apt-key add -

curl -s -L https://nvidia.github.io/nvidia-docker/$distribution/nvidia-docker.list | sudo tee /etc/apt/sources.list.d/nvidia-docker.list

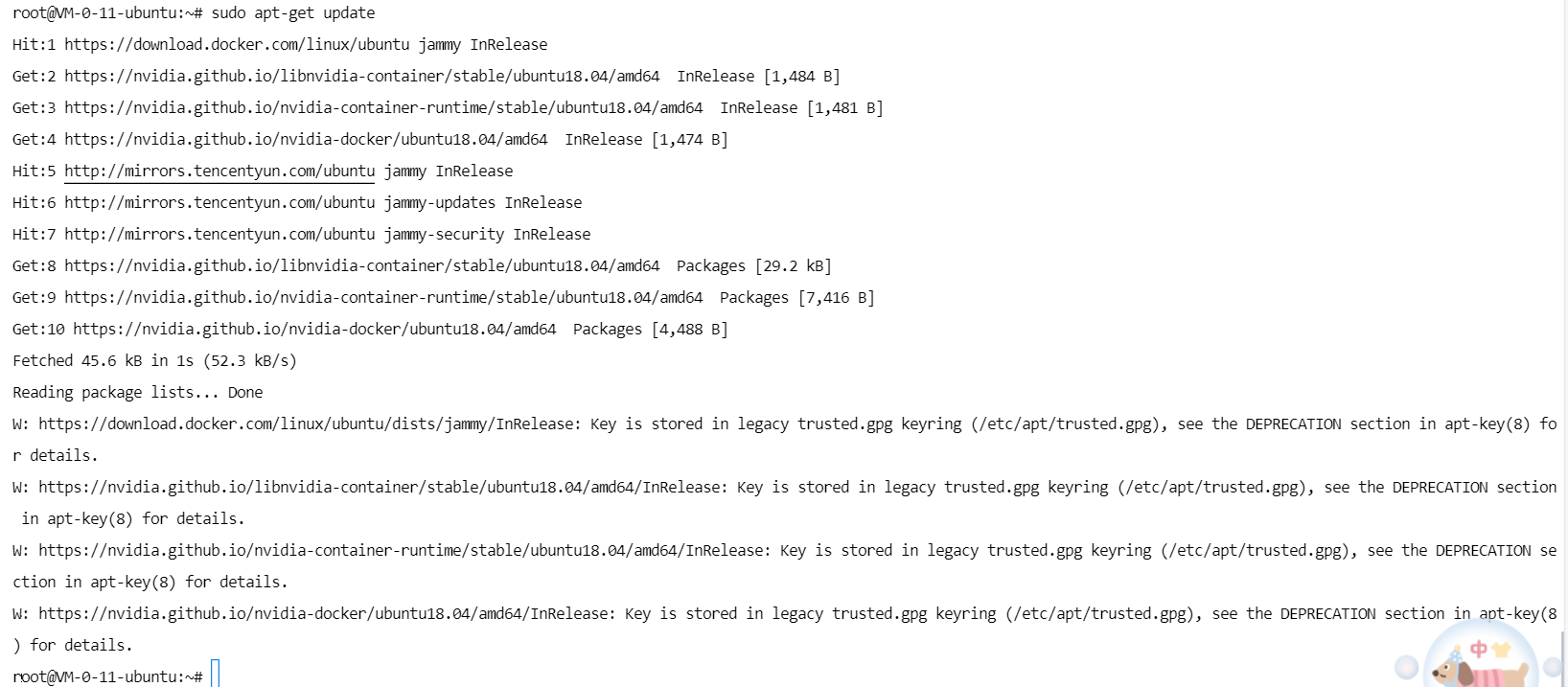

更新索引

sudo apt-get update

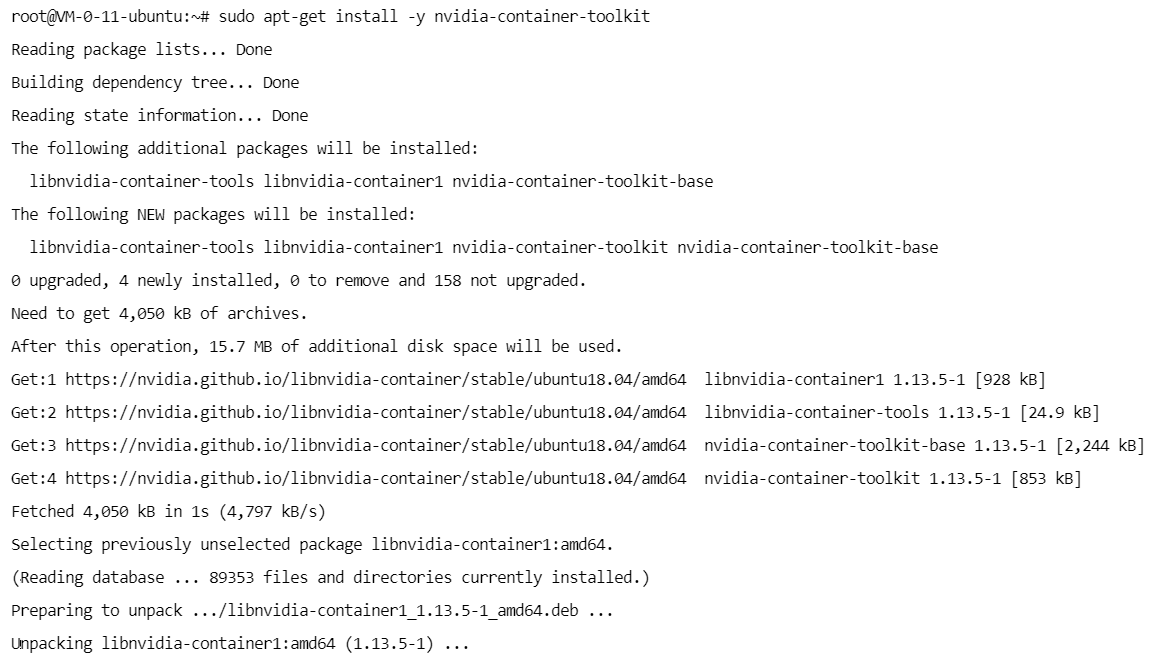

安装nvidia-container-toolkit

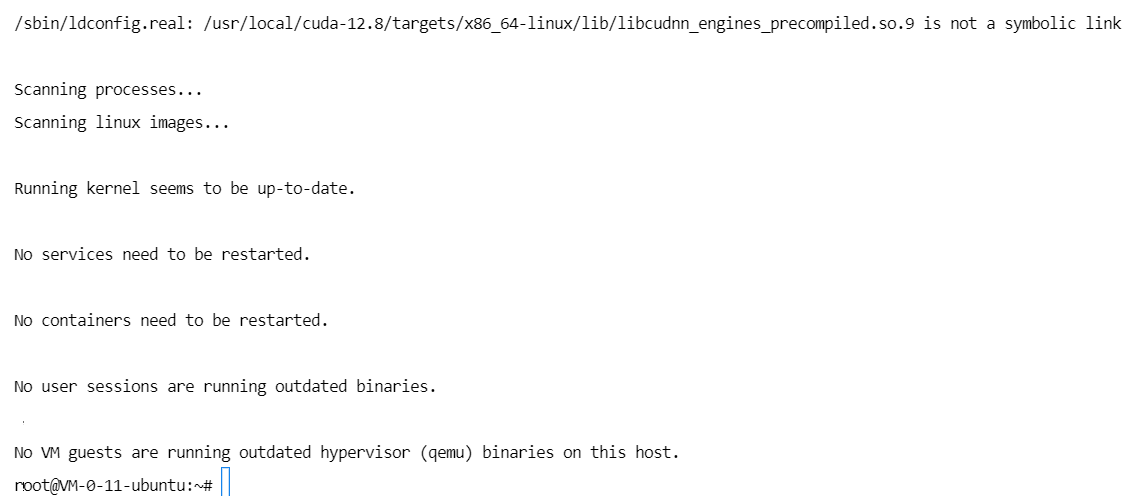

sudo apt-get install -y nvidia-container-toolkit

再次检查 nvidia-container-toolkit 是否已经安装

如图,成功安装。

重启docker

sudo systemctl restart docker

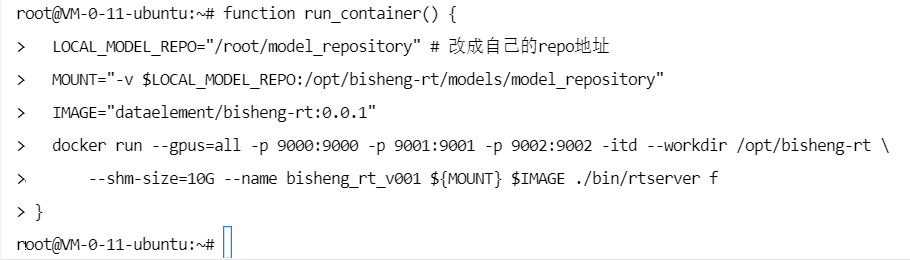

function run_container() {

LOCAL_MODEL_REPO="/root/model_repository" # 改成自己的repo地址

MOUNT="-v $LOCAL_MODEL_REPO:/opt/bisheng-rt/models/model_repository"

IMAGE="dataelement/bisheng-rt:0.0.1"

docker run --gpus=all -p 9000:9000 -p 9001:9001 -p 9002:9002 -itd --workdir /opt/bisheng-rt \

--shm-size=10G --name bisheng_rt_v001 ${MOUNT} $IMAGE ./bin/rtserver f

}

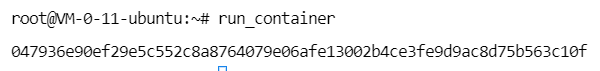

run_container

若这一步报错,可以执行下面的命令

# 移除bisheng_rt_v001

docker rm bisheng_rt_v001

# 重启bisheng_rt_v001

docker restart bisheng_rt_v001

# 启动bisheng_rt_v001

docker start bisheng_rt_v001

# 停止bisheng_rt_v001

docker stop bisheng_rt_v001

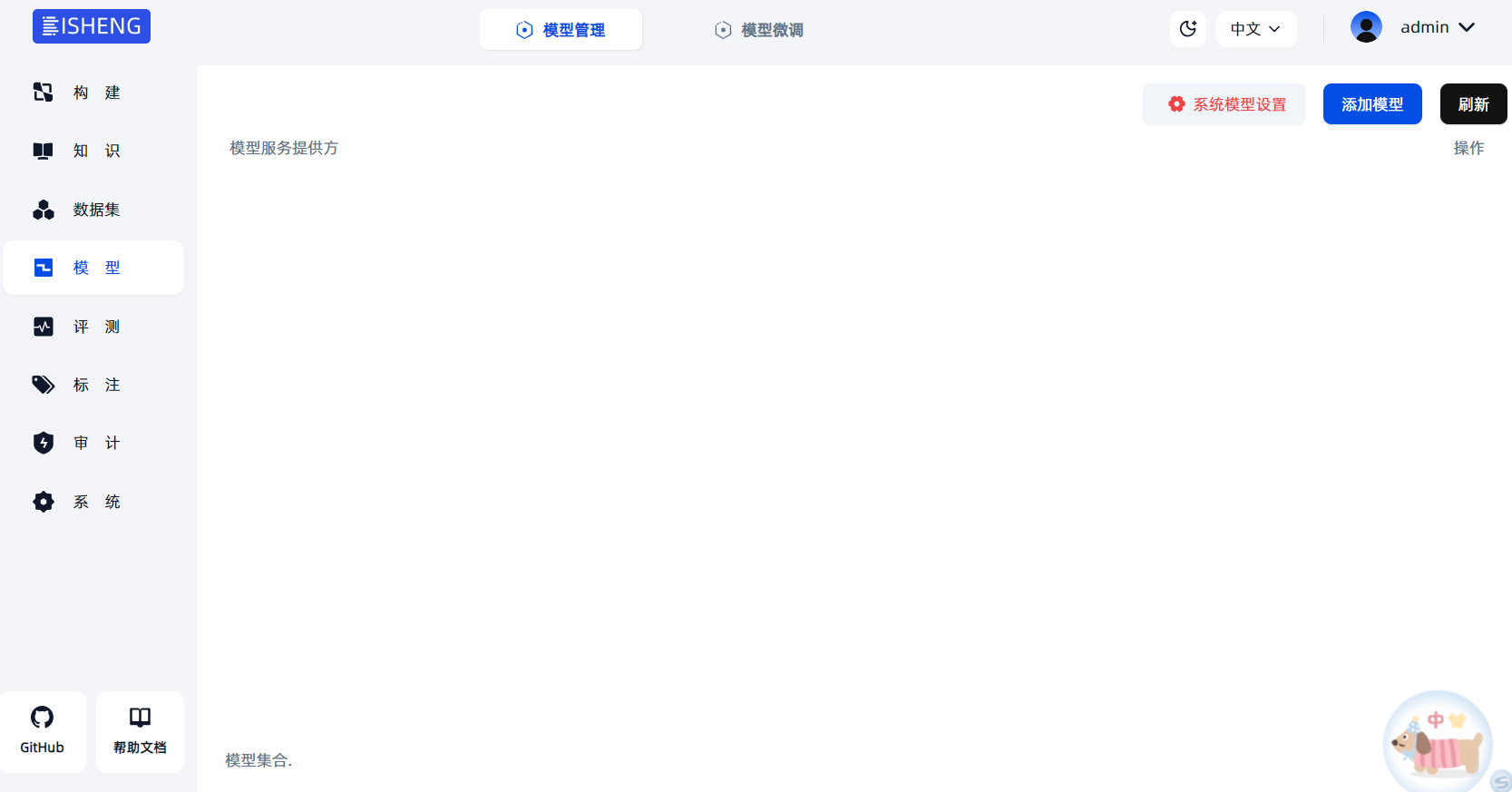

这时模型服务地址:http://101.33.77.43:3001/model

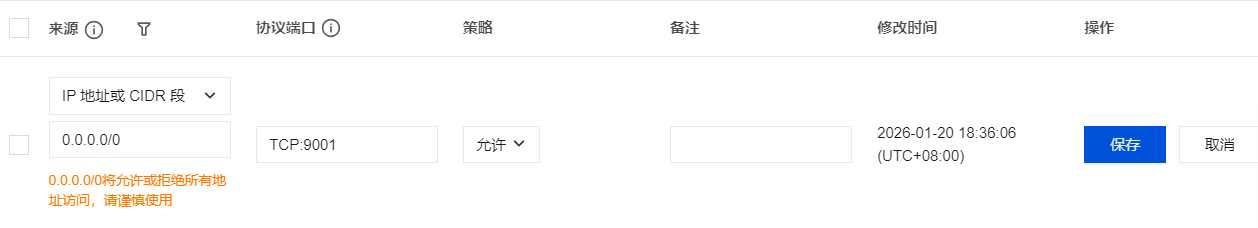

若报错,需要先在安全组中添加入站规则,过程如下:

若还是无法打开网页,可以重新启动项目:

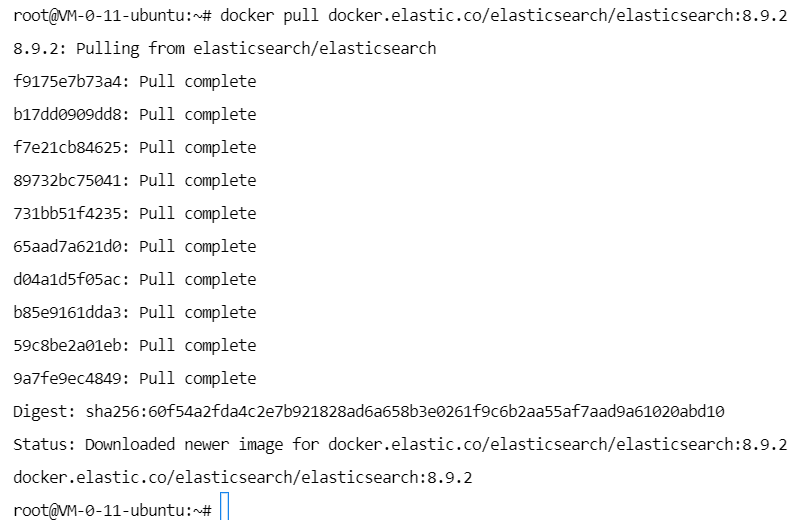

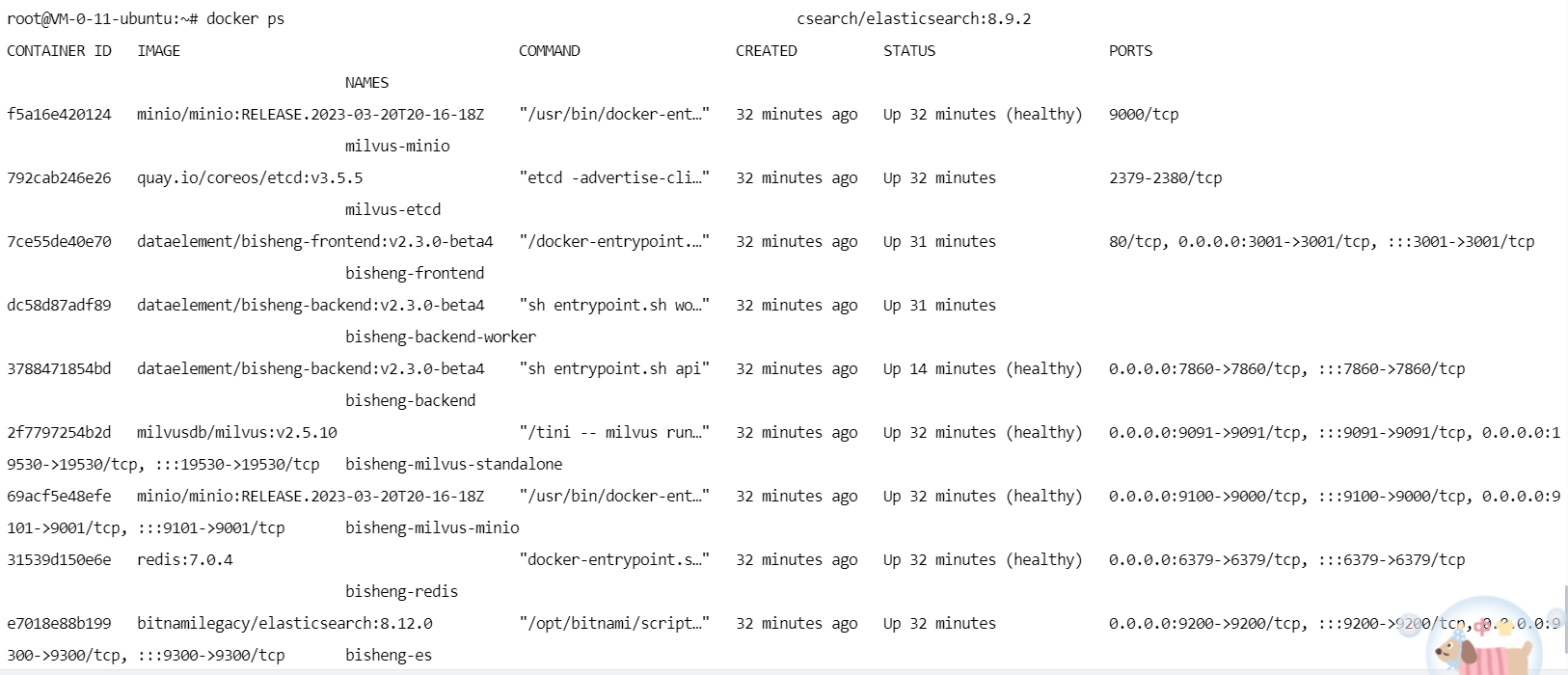

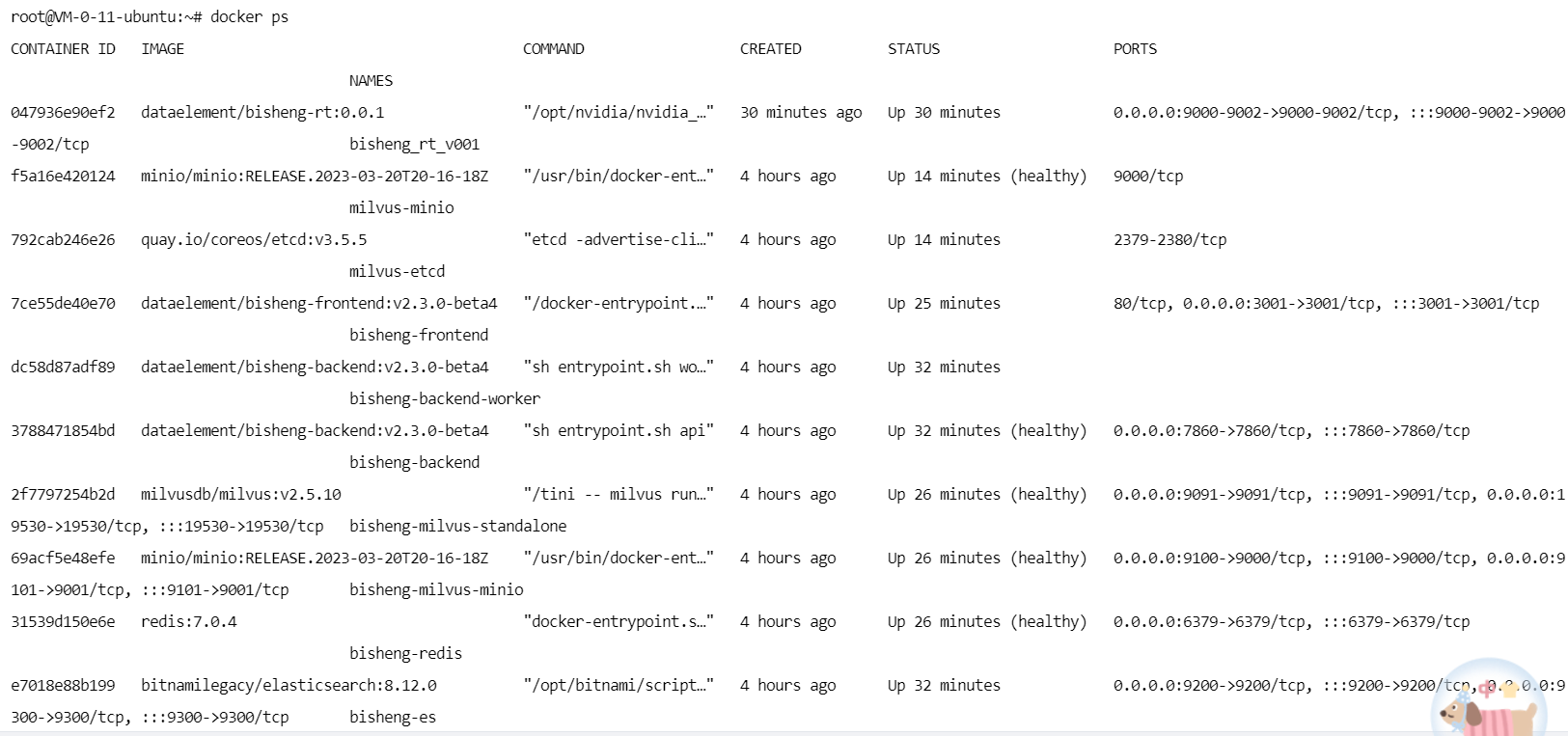

此时查看启动了哪些服务

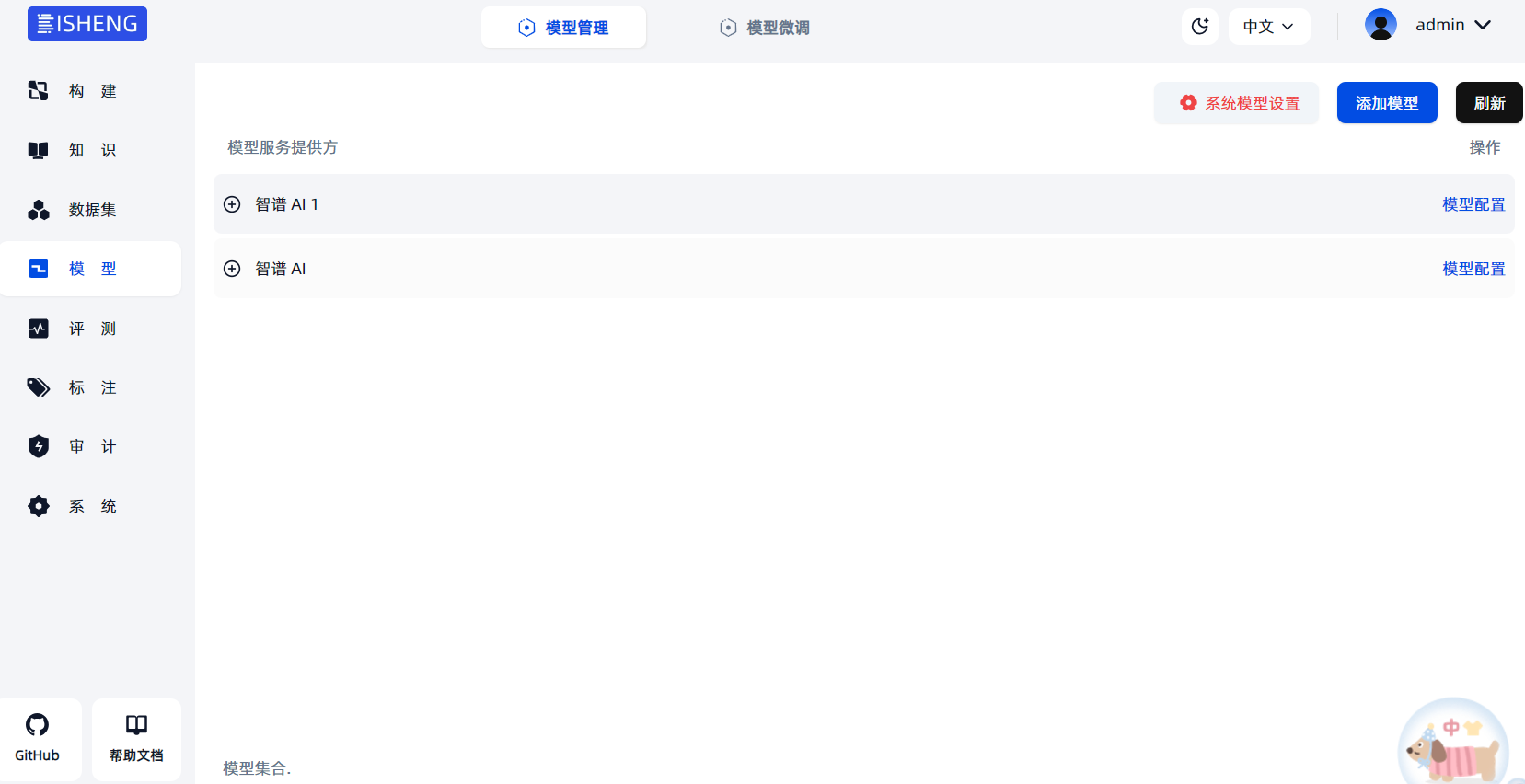

可以看到,模型管理、搜索模块、向量数据库、整个项目全部启动。

模型名称:chatglm3-6b

添加好模型并上线后,就可以使用啦

最后,关闭服务

docker-compose down # 在对应的目录下运行

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)