如何持续、安全地向大模型注入新知识?

如何持续、安全地向大模型注入新知识?向大模型持续、安全地注入新知识,核心是解决“知识时效性更新”与“原有能力保护”的平衡问题,同时规避过拟合、事实偏差、灾难性遗忘等风险。需结合参数更新、非参数补充、安全管控三大体系,形成全流程解决方案。

向大模型持续、安全地注入新知识,核心是解决“知识时效性更新”与“原有能力保护”的平衡问题,同时规避过拟合、事实偏差、灾难性遗忘等风险。需结合参数更新、非参数补充、安全管控三大体系,形成全流程解决方案。

一、核心技术路径:按场景选择适配方案

根据知识更新频率、资源成本、安全需求,可分为参数更新型、非参数补充型两大类,实际应用中常采用混合策略。

(一)非参数补充型:低风险动态注入

不修改模型核心权重,通过外部知识关联实现实时更新,安全性高、成本低,适合高频动态知识场景。

- 检索增强生成(RAG):构建实时更新的外部知识库,推理时先检索相关知识作为上下文输入模型,实现“即用即更”。关键优化包括混合语义检索(向量相似度)与关键词检索(BM25)提升准确性,通过置信度过滤低质量结果,搭配上下文压缩适配模型输入长度限制。实验表明,RAG可将时效问题准确率从12%提升至89%,但需配套向量数据库保障响应效率。

- 知识编辑与连续提示:如RECIPE方法,将新知识转换为简短连续提示嵌入,结合知识哨兵机制动态判断检索库相关性,联合训练检索器与提示编码器,在不干扰模型原始能力的前提下实现精准编辑。该方法在终身编辑场景中表现优于传统参数修改方式,能有效维持模型通用性与局部性。

- 提示工程与上下文学习:通过零样本/少样本提示将新知识注入推理过程,无需训练成本,适合小范围知识更新。需注意提示设计的简洁性与准确性,避免上下文冗余导致推理偏差。

(二)参数更新型:深度固化知识

通过调整模型参数实现知识内化,适合高频复用、需深度融合的领域知识,需搭配防遗忘机制降低风险。

- 参数高效微调(PEFT):冻结模型主干参数,仅训练少量新增模块或参数子集,平衡知识注入与遗忘防护。主流方式包括在Transformer层间插入Adapter小型模块、通过LoRA/QLoRA对关键层权重进行低秩适配,以及基于Fisher信息矩阵的EWC正则化(对核心参数施加惩罚,防止被新任务覆盖)。Adapter结构通过残差连接设计,可在不修改原始权重的前提下注入领域知识,显著降低遗忘风险。

- 增量训练与防遗忘机制:针对批量新知识,采用“记忆回放+知识蒸馏”混合策略。记忆回放通过缓冲区存储历史样本或生成伪样本(生成式回放),与新数据联合训练;知识蒸馏以旧模型为“教师”,通过KL散度损失约束新模型输出分布,保留原有能力。某金融风控场景实验显示,引入蒸馏后旧规则识别准确率仅下降2.1%,而纯微调下降达18.7%。

二、安全保障体系:全流程风险管控

安全注入需覆盖数据、训练、推理全环节,重点防范遗忘、偏差、过拟合、合规风险。

(一)防灾难性遗忘管控

核心是隔离新旧知识对参数的影响,可采用参数隔离(如Progressive Neural Networks为新任务创建独立参数列)、动态权重调整(根据任务相似度分配训练权重)、遗忘监控模块(定期评估旧任务性能衰减,触发预警)等机制。

(二)数据与事实安全

1. 数据预处理:对注入知识进行去重、降噪、事实核查,过滤低质、错误、偏见内容,尤其警惕AI生成内容导致的“模型崩溃”;2. 结构化知识集成:结合知识图谱注入实体关系知识,提升知识准确性与可追溯性;3. 合规审计:建立知识版本管理与变更日志,记录每次注入的内容、来源、时间,满足监管追溯要求。

(三)性能与鲁棒性保障

1. 双轨验证:通过A/B测试对比新旧模型在核心指标(准确率、召回率、推理一致性)的差异,避免性能退化;2. 自动回滚机制:当检测到严重遗忘、过拟合或事实偏差时,立即回滚至稳定版本;3. 泛化性评估:在编辑知识后,通过CSQA、MMLU、SQuAD等基准数据集验证模型通用能力,防止局部知识编辑损害整体性能。

三、工程实践建议:落地架构与优化策略

(一)推荐架构设计

采用“RAG+PEFT+蒸馏”混合架构:通过RAG承接高频动态知识,PEFT实现领域知识深度注入,蒸馏保障原有能力不退化。配套组件包括:知识仓库(实时更新+版本管理)、遗忘监控模块、双轨验证系统、自动回滚机制、合规审计日志。

(二)分场景落地策略

- 高频动态知识(如新闻、政策):优先采用RAG+提示工程,搭配向量数据库与实时检索优化,无需修改模型参数,降低风险。

- 低频深度知识(如医疗指南、行业规范):采用PEFT(Adapter/LoRA)+ 记忆回放蒸馏,分批次微调,每次更新后进行全量验证。

- 跨机构协同更新:基于联邦学习框架,在保护数据隐私的前提下实现分布式知识融合,避免核心数据泄露。

(三)未来技术方向

当前Transformer架构在持续学习中存在性能饱和问题,Sakana AI提出的“持续思维机器(CTM)”架构有望突破瓶颈,通过动态参数调整与知识记忆机制,实现更高效的终身学习。此外,知识编辑技术(如RECIPE)的迭代的,将进一步提升低资源场景下的精准编辑能力。

四、总结

持续安全注入新知识的核心逻辑是“分层注入、全程管控”:非参数方法保障动态性与安全性,参数方法实现深度融合,搭配防遗忘、验证、合规机制构建闭环。需根据知识特性、资源预算、安全需求选择适配方案,通过混合架构平衡更新效率、知识深度与模型稳定性。

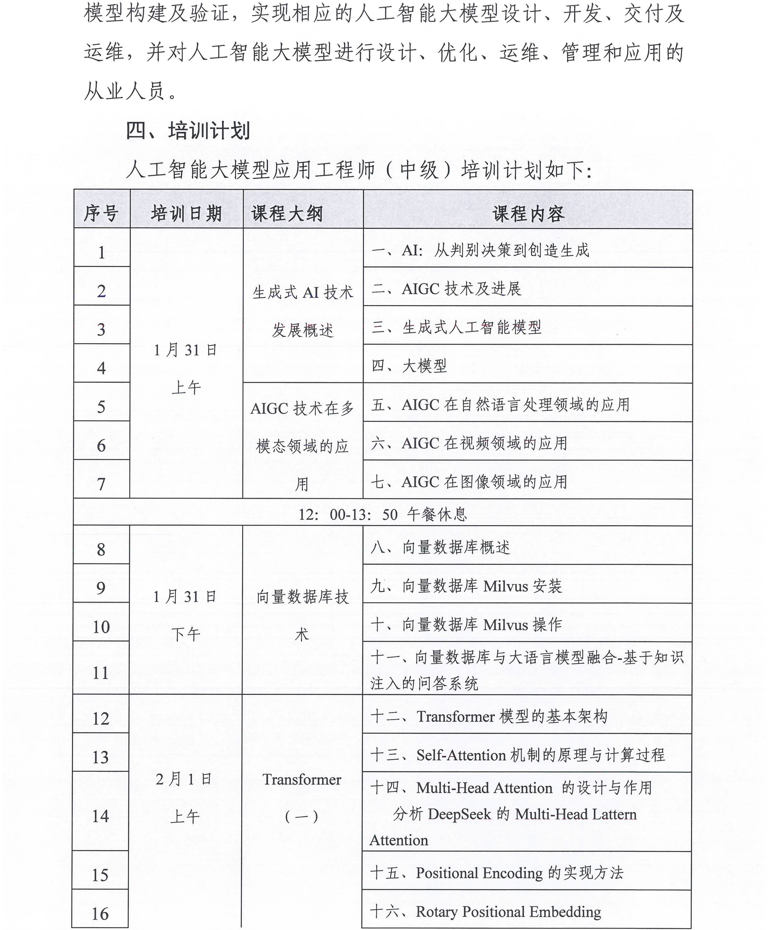

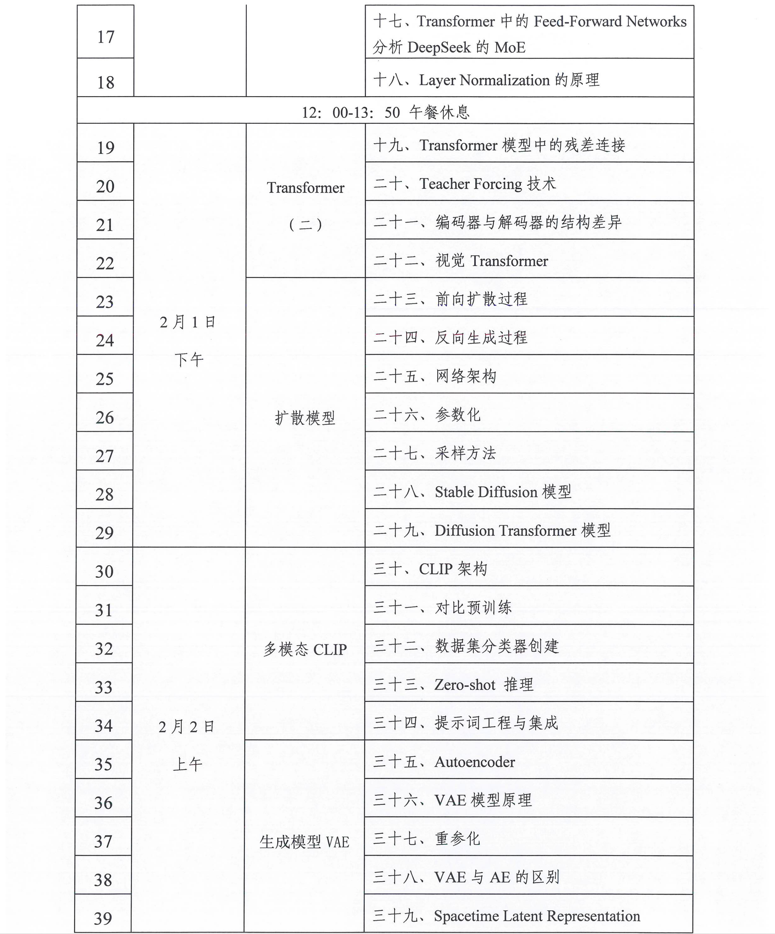

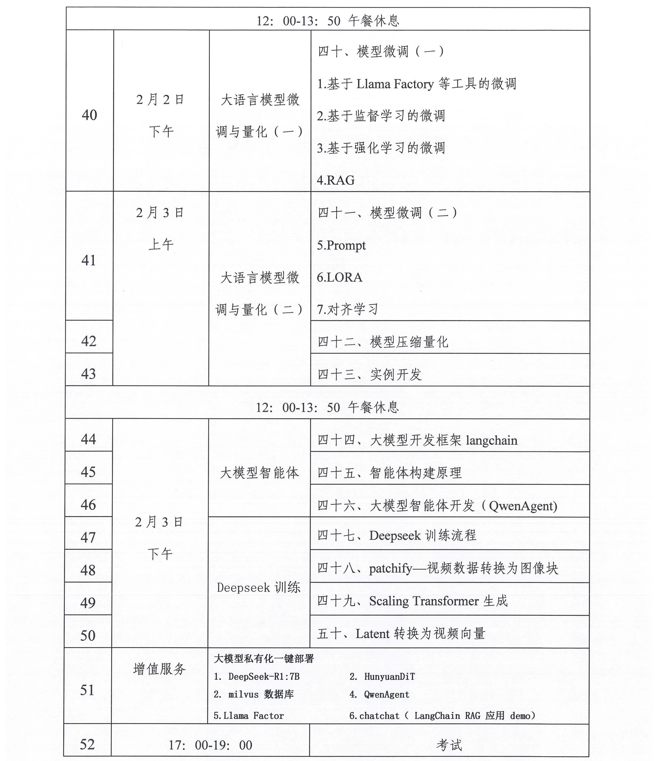

相关学习推荐:工业和信息化部电子工业标准化研究院关于开展人工智能从业人员 “人工智能大模型应用工程师”专项学习课纲

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)