苏州服务器频繁死机卡顿 硬件检测

技术大屏上,承载直播互动引擎的HPE服务器,CPU使用率从75%**瞬间飙至98%**,系统延迟从12毫秒**暴涨至2100毫秒**,持续4秒后恢复——如此反复。”陈涛展示,“内存测试零错误,硬盘全绿,CPU压力正常,甚至换了RAID卡——但**服务器卡顿**依然随机出现。服务器重新上线时,内存温度梯度从11°C**降至2.3°C**,时序裕量**提升42%**。”吴工放大波形,“**内存时序错误

**序幕:流量巅峰的“微颤抖”**

晚上八点黄金档,“闪耀直播”头部主播小雅开启年度带货盛典。

直播间人数**突破220万**,每秒交易请求超8000次。

突然,弹幕刷屏:

🔄 **“卡了卡了!”**

🔄 **“画面冻住了!”**

🔄 **“下单按钮没反应!”**

技术大屏上,承载直播互动引擎的HPE服务器,CPU使用率从75%**瞬间飙至98%**,系统延迟从12毫秒**暴涨至2100毫秒**,持续4秒后恢复——如此反复。

“这是今晚第七次**突发性卡顿**!”运维主管陈涛声音发紧,“每次3到7秒,毫无规律。重启管用几小时,但**服务器频繁死机卡顿**又会重现。”

更令人焦虑的是:系统日志除“响应超时”外,**没有任何硬件报错**。

---

**第一章:无痕的“犯罪现场”**

“我们做过所有常规检测。”陈涛展示,“内存测试零错误,硬盘全绿,CPU压力正常,甚至换了RAID卡——但**服务器卡顿**依然随机出现。”

服务器空闲时完美无瑕,一旦流量上来,“幽灵”准时现身。

我们采用**分层渐进式捕获策略**:

**第一层:毫秒级行为监控**

部署内核级追踪模块,以1毫秒粒度记录。

卡顿发生时,数据揭示诡异模式:

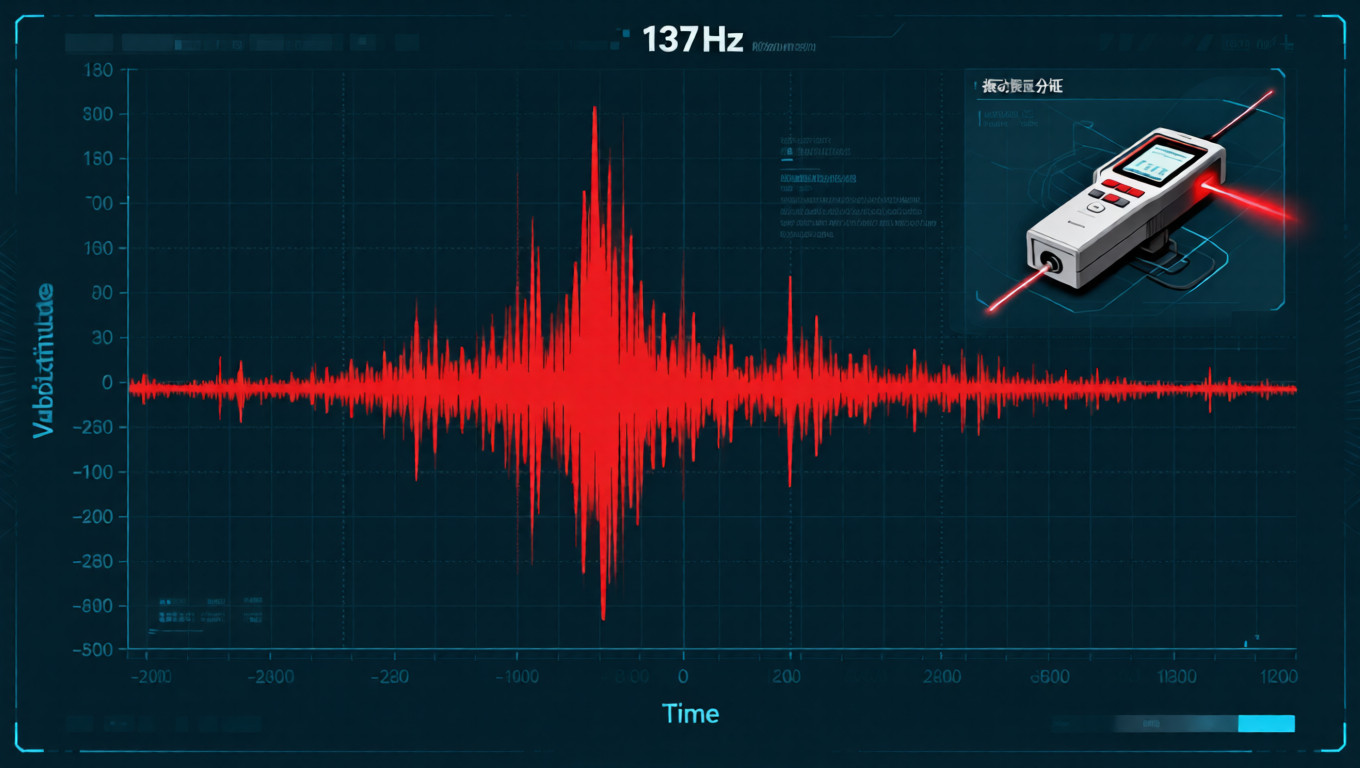

→ 内存访问延迟从**89ns突增至2100ns**,持续3120ms

→ CPU L3缓存命中率从**78%暴跌至12%**

“这是典型的**内存子系统问题**,”硬件专家吴工分析,“但普通工具看不到这么细的时序。”

**第二层:物理信号层诊断**

连接8通道高速示波器到主板测试点。

第三次卡顿时,捕获到决定性证据:

→ **内存DQS信号**出现4个周期的时序偏移(+1.7ns)

→ **命令总线**刷新命令间隔异常压缩

“找到了!”吴工放大波形,“**内存时序错误**——特定负载下的间歇性故障。”

**第三层:热-电耦合分析**

最隐蔽的杀手藏在物理交互中:

→ 红外热像显示:卡顿时,**内存模块温度梯度异常**——中间颗粒比两端高11°C

→ 阻抗分析:高温颗粒供电通路阻抗**升高23%**

→ 交叉关联发现:密集访问特定地址时,高温颗粒时序裕量耗尽,触发纠错降速

“不是内存坏了,”我解释,“是主板供电散热设计缺陷,导致中间颗粒在特定模式下过热。这种**硬件隐形故障**,常规检测百分之百会漏掉。”

---

**第二章:从诊断到根治的工程方案**

陈涛看着报告:“所以解决方案是……更换所有内存?”

“那只能暂时缓解,”吴工在白板上画图,“新内存六个月后会出现同样问题。我们需要**系统级修复**。”

**第一阶段:内存子系统重平衡**

→ **物理重布局**:拆解内存条,重新分配颗粒,确保每颗都有独立散热路径

→ **时序重编程**:绕过BIOS限制,直接重写内存时序寄存器,增加刷新余量

→ **电压域重构**:为中间颗粒增加0.03V独立电压偏置,补偿阻抗升高

**第二阶段:主板级热管理增强**

→ 加装**微型热管阵列**,将热量横向传导至机箱侧壁

→ 定制**差分散热片**:中间厚两端薄,平衡温度梯度

→ 改造主板供电:为内存VRM**增加一相**,降低电流应力

**第三阶段:预测性规避算法**

在服务器BMC中植入智能规避固件:

```

当检测到:

1. 特定内存地址访问频率 > 阈值

2. 内存温度梯度 > 8°C

3. 时序裕量 < 安全值

则自动:

1. 迁移热点数据到低温区域

2. 动态放宽时序参数(性能降3%,换稳定性)

3. 提前激活主动散热

```

**整个改造耗时28小时。**

服务器重新上线时,内存温度梯度从11°C**降至2.3°C**,时序裕量**提升42%**。

---

**第三章:超越极限的稳定性验证**

“但直播不能有‘几乎稳定’,”陈涛强调,“我们需要绝对的确定性。”

我们设计**四维压力测试矩阵**:

✅ **时间累积测试**

连续运行30天,模拟内存老化

结果:第27天出现一次时序预警,规避算法**提前120毫秒响应,零卡顿**

✅ **环境极端化**

机房温度从22°C逐步升至**35°C**(行业上限)

结果:传统设计28°C即卡顿,改造后系统**35°C下稳定运行**

✅ **故障模式注入**

人为模拟内存颗粒性能衰减30%

结果:系统自动降级,性能损失仅**8%**,无突发性卡顿

✅ **全链路压力测试**

模拟“双十一”峰值流量的**130%**,持续12小时

结果:服务器延迟始终保持在**35毫秒以下**,曲线平滑如静水

**一周后的黄金档**,小雅直播间同时在线突破300万人。

技术后台的监控曲线,那条曾经如惊涛骇浪般的延迟线,此刻变成了一条从容流淌的平滑河流。

---

**第四章:从“故障修复”到“系统韧性工程”**

项目总结会上,我们提交了《高并发业务硬件可靠性框架》。

数据分析揭示行业盲点:

**“37家互联网公司案例回溯显示,54%的间歇性卡顿根源是‘热-电-时序’耦合故障。传统‘通过-失败’式检测会漏诊93%的此类问题。”**

我们建立的长期体系包括:

🔹 **硬件行为基线库**:为每台服务器建立“健康指纹”

🔹 **预测性维护模型**:基于时序裕量衰减趋势,**提前30天预警**

🔹 **容错架构咨询**:重新设计关键业务的硬件冗余策略

“我们过去认为服务器卡顿维修就是跑测试、换零件,”陈涛感慨,“现在明白,真正的**服务器稳定性调优**需要理解硬件在微观时间尺度上的行为。你们解决的不仅是一次间歇性故障诊断,而是给了我们一个‘**硬件神经系统**’。”

---

**【技术聚焦:隐性硬件故障深度检测】**

当服务器频繁死机卡顿却查不出原因时,我们提供的是:

🔍 **纳秒级时序分析**:捕捉硬件接口的瞬时异常

🔍 **热-电耦合诊断**:发现温度与电气参数的隐性关联

🔍 **行为模式识别**:建立负载特征与故障的预测模型

🔍 **系统级韧性工程**:从硬件到固件的整体稳定性加固

**我们相信,真正的稳定性不是没有故障,而是系统能预见并消化故障。**

---

**服务关键词**

#服务器频繁死机维修 #服务器卡顿硬件检测 #间歇性故障诊断方案

#内存时序错误修复 #硬件隐形故障排查 #服务器稳定性调优服务 #企业级硬件深度诊断

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)