Memory —— 让 Agent 拥有连贯人格与无限上下文的关键拼图

大模型天生无状态,Memory 是突破 Token 限制的关键。本文详解从滑动窗口到向量检索的分级策略,结合 LangGraph 与 SQLite 实战,手把手教你打造具备长期记忆、能主动读写用户偏好的高阶 Agent。

一、 引言:患有“健忘症”的大模型

在人工智能的浪潮中,我们常常惊叹于 LLM(大语言模型)浩如烟海的知识储备与近乎反直觉的推理能力。它仿佛博览群书、洞悉世事,是一位随叫随到的“智者”。

但这位智者,在出厂设置下,却有一个极其致命的缺陷——

它几乎不记得任何事。

准确地说,它患有一种严重的、结构性的“短期健忘症”。

1.1 Stateless(无状态)的本质:永远停留在“第一次见面”

如果你曾通过 API 与 GPT-4、Claude 等模型进行多轮交互,很快就会触碰到一个底层事实:

大模型本质上是无状态(Stateless)的。

对模型而言,每一次 API 调用,都是一次彼此隔离、毫无关联的独立事件。

它不知道你是谁,也不记得上一轮对话的内容,甚至不记得刚刚自己说过什么。

无论你们上一轮聊得多么深入,当下一次请求发出时——

一切重新开始。

对模型来说,每一次交互,都是“第一次见面”;

每一次对话,都是“初恋”。

这一点,其实并不陌生。

它与早期互联网的 HTTP 协议高度相似。

HTTP 天生无状态。服务器并不知道第 1 次请求和第 2 次请求是否来自同一个用户。为了解决这个问题,Web 世界引入了 Cookie 与 Session:

浏览器在每一次请求中携带身份凭证,服务器才能认出——

“哦,原来还是你。”

LLM 的交互机制亦是如此,只不过代价更高。

模型没有内建的“服务端 Session”。为了让这位“健忘”的智者维持最基本的连贯性,我们只能在每一次请求中,手动将历史对话打包进 Prompt,塞进有限的 Context Window(上下文窗口)里一并发送。

如果没有这层人为构建的“记忆假肢”,

大模型将永远被困在第一回合。

1.2 为什么 Agent 必须有记忆?

如果只是“一问一答”的聊天机器人,健忘或许只是体验问题。

但当我们谈论 AI Agent(智能体) ——

一种需要理解上下文、规划步骤、执行动作并持续纠偏的系统时,情况就完全不同了。

对 Agent 来说,记忆不是加分项,而是生存条件。

没有记忆的 Agent,本质上只是一个不断“重生”的新手,永远无法胜任复杂任务:

-

1. 连续语义的承接能力

用户问:“北京今天天气怎么样?”

紧接着追问:“那上海呢?”

如果没有记忆,Agent 根本无法理解“那”指向的是什么问题域。 -

2. 跨会话的个性化能力

一个真正好用的 Agent,理应“越用越顺手”。

它需要记住用户是偏好 Python 还是 Java,是习惯结构化报告,还是接受随意讨论。

没有长期记忆,Agent 永远只能是通用工具,而无法进化为私人助理。 -

3. 多步骤任务的状态保持能力

当 Agent 执行复杂任务(搜索 → 分析 → 调用工具 → 汇总输出)时,

它必须清楚:- 当前处在哪一步

- 上一步的结果是什么

- 是否已经调用过某个 Skill 或 Tool

一旦记忆断裂,任务就会重复、偏航,甚至彻底失控。

Agent 一旦失忆,就不再是 Agent,只是一个会调用工具的随机应答器。

1.3 本文定位:Token 与 Agent 之间的“缓冲带”

既然记忆如此重要,一个看似直接的想法是:

把所有历史都塞进 Context,不就行了吗?

答案是:不行。

Context Window 是昂贵的、有限的、且高度敏感的资源。

随着对话拉长:

- Token 成本急剧上升

- 推理速度显著下降

- 噪音信息干扰注意力

- 幻觉风险同步放大

更关键的是——

原始历史并不等于有价值的记忆。

正是在这里,Memory(记忆模块) 扮演了 Agent 架构中不可替代的角色:

- 它位于 Token 约束 与 Agent 能力需求 之间

- 负责对信息进行 提炼、压缩、索引、检索与遗忘

- 决定了 Agent 是“越用越聪明”,还是“越聊越混乱”

可以说:

Memory 是连接 Token 与 Agent 的中间层操作系统。

在接下来的章节中,我们将拆解这套“记忆神经系统”——

看清什么该记、怎么记、什么时候忘,

以及一个 Agent,究竟是在哪一刻,开始真正“长出人格”的。

二、 记忆的物理限制:Context Window(上下文窗口)

在上一节我们已经明确了一点:

Agent 如果没有记忆,就不可能真正工作。

但只要你尝试把这个想法落到工程层面,很快就会撞上一堵绕不开的物理高墙——

Context Window(上下文窗口)。

它定义了大模型在单次推理中,究竟“能看见多少东西”。

理解这个上限,是设计任何 Memory 系统之前,必须先接受的现实。

2.1 “短期记忆”的真实载体:一切都写在 Prompt 里

人类的大脑有海马体,负责把短期记忆转化为长期记忆;

而今天主流的大模型架构(Transformer),要简单粗暴得多:

模型所谓的“记得住”,本质上只是“你有没有把信息再发给它一遍”。

模型并不会真的记得你十分钟前说过什么。

它只是——在你发送最新问题时——

同时收到了你(或程序)帮它拼接好的那一整段历史文本。

这就像一场“允许携带小抄”的考试:

- 模型并没有背书

- 它只是当场读你递过去的那张纸

从工程角度看,这意味着:

- 本质: 所谓“短期记忆”,只是不断变长的 Prompt 字符串

- 现实: 即便 Context Window 已经扩展到 100k、200k Token,也不等于可以随意堆信息

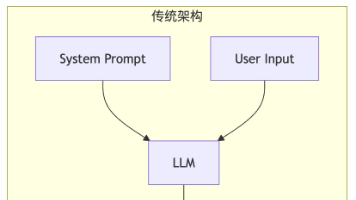

核心概念辨析:Memory ≠ Context ≠ Prompt

在继续往下之前,必须先把这三个常被混用的概念彻底分开。

这是后续所有 Memory 架构设计的地基。

Prompt = System Instruction + Relevant Memory + Current Query

1. Memory(记忆|仓库)

- 全量信息集合

- 包括历史对话、用户偏好、文件、事件记录

- 理论上可无限增长,通常存放在数据库中(向量库 / KV 存储)

类比:一整座图书馆

2. Context(上下文|桌面)

- 模型单次推理可处理的最大信息量

- 由模型能力决定(如 128k token)

- 是一个硬上限

类比:你面前那张有限大小的书桌

3. Prompt(提示词|当前读物)

- 实际发送给模型的请求内容

- 是从 Memory 中筛选、裁剪、拼装后的结果

- 必须严格受 Context Window 约束

类比:你最终摊在桌面上、正在读的那几页纸

一句话结论:

Memory 系统的核心问题,从来不是“存不存”,而是——

如何从无限的仓库里,挑出最该被看到的那几页。

2.2 痛苦的权衡:Context 限制不仅仅是“钱”的问题

既然 Context Window 越来越大,一个看似合理的念头自然会出现:

“那我把所有历史都塞进去,不就万事大吉了?”

答案是否定的,而且问题不止一个。

2.2.1 Token 成本与延迟:规模带来的直接代价

-

成本线性叠加

大模型按输入 Token 计费。

如果你在每一次请求中都携带 5,000 字历史记录,那么这 5,000 字会在每一次交互中被重复计费。这不是优化问题,而是烧钱问题。

-

响应时间显著拉长

Transformer 的 Attention 机制,对序列长度极其敏感。

Context 越长,模型“读完再开始思考”的时间就越久。用户只发了一句“你好”,

系统却在后台消化几万字历史——

这在体验上是不可接受的。

2.2.2 “迷失在中间”:效果比成本更致命

更糟糕的是,长 Context 并不一定带来更好的效果。

大量研究已经表明:

模型的注意力分布并不均匀。

-

首尾效应

- 对 Prompt 开头(System Prompt)最敏感

- 对结尾(最新 Query)最敏感

-

中段衰减

- 当 Context 过长时

- 被夹在中间的关键信息,极容易被忽略

这意味着什么?

如果你把整本小说都塞进 Prompt,再去问中间的某个细节——

模型可能准确复述开头和结尾,

却对中段情节含糊其辞。

结论非常残酷:

盲目堆 Context,不但没让模型“记得更多”,

反而制造了噪音,降低了判断质量。

2.3 小结:我们需要的不是“更多记忆”,而是“更好的选择”

面对 Context Window 这道不可突破的物理上限,有一个结论已经非常清晰:

我们既不能,也不应该,把所有历史直接塞进 Context。

因此,Memory 模块的角色,绝不只是一个“记录器(Recorder)”,

而必须是一个“编辑器(Editor)”:

- 什么信息值得长期保留?

- 什么信息需要被压缩成摘要?

- 什么信息应该随着时间自然遗忘?

从这一刻开始,Memory 不再是存储问题,而是策略问题。

三、记忆的分类学 (Memory Types)

在认知科学领域,人类记忆系统通常划分为感觉记忆、短期记忆(工作记忆)和长期记忆三类。为突破 AI Agent 在 Context Window (上下文窗口)方面的资源限制,我们借鉴这一分类体系,发展出了类似的"记忆分类学"。

LangChain 等框架将这些策略标准化为不同的模块,本质上都是在解决同一个问题:如何在有限的空间里,放下最有价值的信息?

3.1 缓冲区记忆 (Conversation Buffer Memory)

——“过目不忘的速记员”

- 原理:

这是最原始、最直观的实现方式。它没有任何花哨的策略,就是简单粗暴地将所有的历史对话(User Input + AI Response)按时间顺序追加(Append)到 Prompt 中。 - 类比:

就像拥有“超忆症”的人,或者是法庭上的速记员,每一个标点符号、每一句废话都完整保留,不做任何筛选。 - 缺点:

- Token 爆炸: 这是不可持续的。对于一个长对话,可能只需 10 轮交互就会消耗掉大量的 Token 配额。

- 成本高昂: 随着对话变长,每一轮新的问答都在重复为之前所有的废话付费。

- 适用场景: 开发调试阶段,或者预期很快就会结束的短对话。

3.2 滑动窗口记忆 (Conversation Window Memory)

——“只有7秒记忆的金鱼”

- 原理:

既然存不下所有,那就只存最近的。系统维护一个固定长度的队列(Queue),遵循 FIFO(先进先出) 原则。只保留最近的 K K K 轮对话(例如 K = 5 K=5 K=5),一旦有新对话进来,最久远的那条记录就会被挤出窗口丢弃。 - 类比:

这对应人类的“工作记忆”。就像你在心算一道复杂的数学题,你只关注当前的数字运算,算完一步就忘掉上一步的中间结果。 - 致命缺陷:

“早期关键信息遗失”。如果用户在对话第 1 轮说:“我的名字叫龙傲天,我是 Python 程序员。”,而在第 10 轮时模型已经把第 1 轮的信息“滑”出去了,此时模型会彻底忘记用户的名字和职业。 - 适用场景: 不需要上下文依赖的简单指令交互,或即用即走的客服问答。

3.3 摘要记忆 (Conversation Summary Memory)

——“善于做会议纪要的秘书”

-

原理:

这是一种“以时间换空间”的高级策略。当对话积累到一定程度时,系统会调用 LLM 自身(通常是一个更小、更便宜的模型),让它阅读旧的对话记录,并生成一份高度浓缩的摘要(Summary)。

在构建 Prompt 时,我们不再传入原始对话,而是传入:System Prompt + [上一段对话的摘要] + 最近几轮原始对话。 -

逻辑/代码示例:

假设原始对话长达 1000 Token,充满了口语化的废话:User: 嘿,你好啊,吃了没?

AI: 你好!作为 AI 我不需要吃饭。

User: 哈哈也是。那个,我想问下,如果我想学 Python,应该先看什么书?我有 Go 基础。

AI: 既然你有 Go 基础,推荐直接看《Fluent Python》…

(…经过多轮闲聊…)经过 Summary Memory 处理后的 Prompt (仅占用 50 Token):

Current Summary: 用户是一位有 Go 基础的开发者,正在咨询 Python 进阶学习路线,AI 推荐了《Fluent Python》。

New User Input: 那这本书有中文版吗? -

优点: 极大地压缩了 Token 占用,同时保留了对话的脉络和关键事实。

-

缺点: 丢失了对话的“微观细节”和语言风格。模型可能记得“用户喜欢苹果”,但记不住用户当时是用多么激动的语气表达的。

3.4 长期记忆 (Vector Store / RAG)

——“拥有无限书架的图书馆”

-

原理:

这是 Agent 迈向“拥有无限记忆”的关键一步。它利用 Embedding(向量化) 技术,将每一次的历史对话转化为向量,存储在 Vector Database(向量数据库) 中。

当新问题到来时,系统不是回溯最近的几句话,而是去数据库中检索(Retrieve) 与当前问题语义最相似的过往片段(Top-K),并将这些片段作为“背景知识”注入 Prompt。 -

核心区别:记忆 RAG vs 文档 RAG

- 文档 RAG (Semantic Memory): 检索的是外部知识库(如公司维基、法律文档),不仅限于当前对话。

- 记忆 RAG (Episodic Memory): 检索的是过去发生的对话历史。

-

场景举例:

用户在 3 天前聊过:“我对他汀类药物过敏”。

今天用户问:“我感冒了,给我开点药。”- Buffer Memory 早忘了 3 天前的事。

- Vector Memory 会根据“开药”这个关键词/语义,检索出“过敏史”相关的历史记录,从而生成:“推荐服用感冒灵,注意避免使用含他汀类成分…”

-

结论: 这是目前实现个性化(Personalization)和超长跨度记忆的最佳方案。

四、 进阶:如何构建“无限记忆”的 Agent?

简单的“向量检索”只能解决“找回过去”的问题。但一个真正成熟的 Agent,应该像人类一样,懂得取舍:什么该长期记住,什么只需暂存,什么应当被遗忘;甚至还能通过反思,逐步形成对用户和世界的稳定认知。

为了突破 Context Window 的物理极限,业界(以 MemGPT 为代表)提出了一种更具系统论意味的设计范式:

将大模型视为操作系统(OS),将记忆视为分级存储系统。

4.1 像操作系统一样管理记忆(MemGPT 理念)

在计算机体系结构中,CPU 无法直接处理硬盘(Hard Drive)中的数据,所有计算都必须发生在内存(RAM)中。MemGPT 将这一经典模型,完整映射到了 Agent 的认知架构中:

- CPU(Processor): LLM 本身,负责推理、规划与决策

- RAM(Context Window): 昂贵且极其有限的即时工作区

- Hard Drive(External Storage): 廉价但近乎无限的外部存储(向量数据库、KV 存储、文件系统)

在这一范式下,Agent 的记忆被明确划分为两个核心层级。

A. Core Memory(核心记忆 / 常驻内存)

这是常驻于 Context Window 的“置顶信息”,不会被滑动窗口机制淘汰,类似操作系统中的关键配置区。

它就像贴在显示器边框上的便签,Agent 每一次“睁眼”(推理)都能看到,通常只存放最高价值、最高复用率的信息:

-

用户画像(Persona)

Name:AlexRole:Data ScientistPreference:偏好简洁直接的回答,厌恶冗余解释

-

当前系统状态(System State)

Current Goal:协助用户调试 Go 程序Progress:已定位 panic 根因,正在验证修复方案

原则只有一个:

能放进 Core Memory 的,必须是“每一轮推理都值得占用 Token 的信息”。

B. Archival Memory(档案记忆 / 外部存储)

这是 Agent 的“长期记忆库”,对应 OS 中的硬盘或 SSD。

- 内容: 全量历史对话、事件记录、知识片段

- 特性: 默认不在 Context 中,LLM 不可见、不可直接访问

- 访问方式:

Agent 必须通过 工具调用(Function Call) 主动发起检索请求,类似操作系统执行一次Page In,将所需内容临时加载进 Context Window

这意味着一个关键转变:

记忆是否被“看见”,不再由时间顺序决定,而由当前任务的“相关性”决定。

4.2 记忆的生命周期:一个“读–写–悟”的闭环

有了分级存储还不够,真正拉开差距的是记忆如何流转。

一个高级 Agent 的 Memory 系统,不是静态的文本仓库,而是一个持续运行的闭环:

Write(写入) → Retrieve(检索) → Reflect(反思)

1. 写入(Write / Encoding):从“记流水账”到“结构化沉淀”

初级 Agent 只是把对话原文作为字符串存下来;

高级 Agent 在写入阶段就开始理解、清洗和建模信息。

我们以一句更复杂的用户指令为例:

用户输入: “帮我订一张下周去上海的高铁票,正好去见见老朋友。虽然我不喜欢上海潮湿的天气,但外滩的夜景真的太迷人了。”

面对这段话,Agent 的记忆模块会进行如下的分流处理:

-

A. 实体抽取(Entity Extraction) → 捕捉“事件”

- 提取关键的客观数据,通常用于短期任务执行。

{ "intent": "book_ticket", "destination": "Shanghai", "time": "Next Week", "transport": "High-speed train" } -

B. 记忆分层(Memory Stratification)

-

这是记忆清洗的关键。我们需要区分“发生了什么事”和“用户是什么样的人”。

-

📌 事实(Fact / Event): “用户下周要去上海见朋友。”

- 特征: 客观发生的事件。

- 用途: 存入短期记忆或日程表,任务完成后其重要性会降低。

-

👤 偏好(User Profile / Preference): “用户不喜欢潮湿的环境。”

- 特征: 关于用户的长期属性,虽然是主观的,但被系统视为“关于用户的客观事实(Fact about User)”。

- 用途: 存入长期记忆(Core Memory)。下次订酒店时,Agent 会自动根据此偏好筛选“干湿分离”或“有除湿服务”的房间。

-

💬 观点(Opinion / Sentiment): “用户觉得外滩夜景迷人。”

- 特征: 瞬时的情绪表达或审美评价。

- 用途: 存入摘要。未来推荐景点时,Agent 知道用户偏好“城市景观”而非“自然山水”。

-

-

C. 总结(Conclusion):

通过这种结构化处理,一句混沌的自然语言被拆解成了:可执行的指令(Action)、可复用的用户画像(Persona) 和 可供参考的审美偏好(Taste)。

2. 检索(Retrieve):精准克制的“大海捞针”

当用户问:

“我上周提到的那本书叫什么来着?”

-

纯向量检索的问题:

可能会把“我最近在看书”“我喜欢技术书籍”这类闲聊一并捞出来。 -

更成熟的做法(Hybrid Search):

-

意图解析:

category = book -

时间约束:

time_range = last_week -

检索策略:

- 语义相似度(Vector Search)

- 关键词匹配(Keyword Search)

- 元数据过滤(Metadata Filter)

-

只有满足多重条件的记忆,才有资格被“分页”进 Context。

3. 反思(Reflection):从“记住发生过什么”到“理解为什么”

这是斯坦福 Generative Agents 论文中最具分水岭意义的一步,也是 Chatbot 与 Intelligent Agent 的本质差异。

-

机制:

Agent 在空闲时或定期,对一段时间内的记忆进行二次加工,生成更高层次的洞察(Insight)。 -

示例过程:

-

观察(Observation)

- 周一早上用户点了咖啡

- 周二早上用户点了咖啡

- 周三用户抱怨没咖啡精神不济

-

反思(Reflection)

- 归纳行为模式,形成稳定特征判断

-

写入洞察(Insight → Core Memory)

Trait: 用户对咖啡因高度依赖,早晨需要咖啡唤醒状态

-

-

结果:

下周一清晨,Agent 可能会主动开场:“早安 Alex,要先来一杯咖啡吗?”

此时,Memory 不再是冷冰冰的存储介质,而是对用户行为模式的内化理解。

4.3 小结:Memory 的终极形态

当引入 分级存储 + 主动检索 + 周期反思 后,Agent 的记忆系统完成了质变:

- 它不再依赖无限 Context

- 不再被时间线束缚

- 也不再只是“记得发生过什么”

而是开始回答一个更高级的问题:

“我对你,究竟了解多少?”

这一刻,Agent 才真正拥有了“无限记忆”的雏形。

五、记忆与 MCP 的结合

如果您看过我之前写的关于 MCP (Model Context Protocol) 的博文,您可能已经意识到:MCP 的核心使命是标准化 AI 与数据之间的连接。

那么,当我们把 “Memory” 也看作一种 “数据资源” 时,事情就变得有趣起来了。

5.1 数据孤岛问题:破碎的“数字人格”

在前几章,我们费尽心力设计了一套完美的 Memory 系统(向量库、反思机制、长期画像)。但这里存在一个巨大的痛点:这份记忆被锁死在了单一的应用里。

- 现状:

- 你在 ChatGPT 里告诉它:“我是 Python 开发者,喜欢用 FastAPI。”

- 当你打开 Cursor (IDE) 写代码时,它依然会傻乎乎地给你推荐 Flask,因为 Cursor 根本不知道你在 ChatGPT 里说了什么。

- 当你用 Perplexity 搜索文档时,它也不知道你正在写什么项目。

- 后果:

尽管每个 AI 都很强,但对用户来说,它们是割裂的。你就像面对着 10 个不同的助理,每换一个房间,就得重新自我介绍一遍。你的“数字人格”被撕裂成了无数个碎片,散落在不同的数据库孤岛中。

5.2 MCP 的角色:打造“可携带”的通用记忆层

MCP 的出现,为打破这些孤岛提供了一把标准化的钥匙。

在 MCP 的架构下,Memory 不再是某个 Client(如 Chatbot App)内部私有的变量,而是一个独立的 MCP Server。

- 架构变革:

- Before:

App(LLM + Memory DB)—— 记忆是应用的一部分,应用死则记忆亡。 - After:

App(LLM) <== MCP Protocol ==> Memory Server—— 记忆独立存在,应用只是接入端。

- Before:

这意味着,我们可以部署一个 “Personal Memory MCP Server”(个人记忆服务器)。无论你使用哪个支持 MCP 的客户端(Claude Desktop, Cursor, Zed, 或者是自建的 Agent),它们都可以连接同一个记忆服务,读取(Read) 你过去的偏好,写入(Write) 新的经历。

场景畅想:跨应用的神奇联动

让我们通过一个具体的开发者场景,看看打通了“任督二脉”后的体验:

场景:全栈开发的无缝流转

-

浏览器环境 (Browser Agent):

- 你在 Chrome 中阅读一篇关于 “React Server Components (RSC) 最佳实践” 的技术博客。

- 你让浏览器插件(作为 Agent A)总结这篇文章。

- 动作: Agent A 通过 MCP 将总结出的“RSC 核心要点”和“你的阅读笔记”写入 Shared Memory Server。

-

IDE 环境 (IDE Agent):

- 十分钟后,你打开 VS Code 开始写代码。你输入:“帮我创建一个新的组件,要符合我刚才看的 RSC 规范。”

- 动作: 虽然你从未在 VS Code 里提过那篇文章,但 IDE Agent(Agent B)通过 MCP 协议连接了同一个 Memory Server。

- 它检索到了那条“RSC 核心要点”的记忆。

- 结果: 它生成的代码完美契合了你刚才在浏览器里学到的知识。

-

终端环境 (Terminal Agent):

- 你试图部署项目,但报错了。你对终端助手说:“这和上次那个端口占用的错误一样吗?”

- 动作: 终端 Agent 检索记忆,发现你上周在 ChatGPT 里处理过类似的 Docker 端口问题。

- 结果: 它直接给出了针对性的修复建议,而不需要你把错误日志再复制粘贴一遍。

5.3 小结

通过 MCP,Memory 变成了一种基础设施(Infrastructure),而非应用功能(Feature)。这才是 Agent 真正融入人类工作流,成为“第二大脑”的完全体形态。

六、 实战:常用的记忆工具与模式

纸上得来终觉浅。理解了 Memory 的原理后,我们并不需要从零手写一个向量数据库连接器。开源社区已经为我们准备好了成熟的工具链。

6.1 常用库:站在巨人的肩膀上

在构建 Memory 系统时,根据系统复杂度与工程成熟度,通常有三个层级的工具可供选择:

1. LangChain Memory(基础组件层)

-

定位: LLM 应用开发的通用基础框架。

-

特点:

提供了最完整的 Memory 抽象与实现。我们在第 3 章中提到的各类策略(Buffer、Window、Summary、VectorStoreRetriever)在 LangChain 中都有现成的类可以直接使用。 -

适用场景:

- 快速原型开发(MVP)

- 需要高度自定义 Memory 行为或与其他 Chain 深度耦合的场景

-

不足:

抽象层级较多,版本演进较快,在复杂链路下调试成本偏高。

2. Zep(专为 Agent 设计的长期记忆服务)

-

定位: 独立的 Long-term Memory 基础设施。

-

特点:

- Zep 并非单纯的 SDK,而是一个可独立部署的服务(通常基于 PostgreSQL + 向量索引)。

- 它将 Memory 管理从业务逻辑中剥离:自动完成摘要生成、向量化与基础检索。

-

适用场景:

- 生产环境

- 需要稳定持久化、多会话历史管理的应用

- 不希望在应用层反复实现 Memory 工程细节的团队

3. Mem0 (前身为 EmbedChain)

- 定位: 专注于“个性化记忆”的智能管理工具。

- 特点:

- Mem0 非常擅长解决我们第 4 章提到的“写入结构化”问题。

- 它能智能识别用户输入中的变化。例如用户说“我搬家去杭州了”,Mem0 会自动更新旧的“居住地:北京”的记录,而不是简单地追加一条矛盾的数据。

- 适用场景: 构建类似 Jarvis 的个人助理,强依赖用户画像(User Profile)管理的应用。

6.2 坑点分享:那些只有上线后才暴露的问题

在真实环境中,Memory 系统的风险往往不是“不好用”,而是用久了会失控。以下两个问题尤为常见。

1. 脏数据污染(Poisoning the Well)

——“一旦记错,就会不断强化错误。”

-

现象:

模型产生幻觉(例如:“你之前说过你喜欢吃香菜”),该信息被写入长期记忆。

后续生成又以此为前提,形成错误自增强循环。 -

应对策略:

- 人机回环(Human-in-the-loop):

为用户提供记忆可视化与删除能力,让错误可以被显式纠正。 - 写入前校验:

在进入长期记忆前,引入轻量级校验逻辑(或 Checker Agent),区分“明确事实”与“即时生成内容”。

- 人机回环(Human-in-the-loop):

2. 隐私与隔离问题(Privacy & Isolation)

——“记得太多,反而成为风险源。”

-

主要风险:

- PII 泄露:

电话号码、身份证号、API Key 等敏感信息被原样向量化并长期存储。 - 多租户污染:

检索时 metadata 过滤失效,导致不同用户的记忆交叉命中。

- PII 泄露:

-

工程对策:

- PII 清洗管道:

在 Embedding 之前进行敏感信息识别与脱敏(如使用 Presidio),将原始值替换为占位符。 - 严格的命名空间隔离:

所有检索操作必须显式绑定user_id/tenant_id,必要时为高价值客户使用独立索引或实例。

- PII 清洗管道:

6.3 小结

Memory 是 Agent 能力跃迁的关键基础设施,但它必须被约束、治理和审计。

工程上的核心原则不是“记得更多”,而是只记该记的、能改可删、边界清晰。

七、 总结与展望

当我们谈论大模型的“记忆”时,我们谈论的远不止是一个简单的数据库读写操作。经过前文的层层拆解,我们可以将构建 AI 记忆系统的核心奥义浓缩为一个公式。

7.1 总结:记忆的“三位一体”公式

Memory = Context Management + Storage + Retrieval

如果把 Agent 比作一个正在处理复杂案件的侦探,那么:

-

Context Management (上下文管理 —— 桌面策略)

- 这是“当下”的艺术。

- 面对昂贵且有限的 Context Window(办公桌),我们不能把所有卷宗都堆上来。我们需要学会压缩(Summary)、遗忘(Sliding Window) 和 筛选。好的管理策略,就是确保桌面上永远只放着对当前推理最关键的那几页纸。

-

Storage (存储 —— 档案室)

- 这是“过去”的沉淀。

- 我们通过结构化写入和向量化(Embedding),将非结构化的对话流变成了有序的知识资产。无论是简单的 JSON 文件,还是高性能的 Vector DB,或者是通过 MCP 连接的外部服务,它们构成了 Agent 坚实的“长期记忆”。

-

Retrieval (检索 —— 索引机制)

- 这是“连接”的桥梁。

- 存下来只是第一步,能精准地找出来才是本事。通过语义检索、关键词混合检索以及元数据过滤,我们确保 Agent 能在毫秒间从海量数据中“大海捞针”,找回那个决定性的线索。

只有当这三个齿轮完美啮合时,大模型才能从一只只有 7 秒记忆的“金鱼”,进化为一位博闻强识的“智者”。

7.2 下一篇预告:Agent 做得好不好,谁说了算?

至此,我们的 Agent 已经拥有了:

- 🧠 大脑(LLM 模型,具备推理能力)

- 🛠️ 双手(Tools / Skills,具备执行能力)

- 📓 记事本(Memory,具备历史连贯性)

看起来我们已经打造出了一个完美的智能体。但是,你敢直接把它部署到生产环境吗?

- 它的记忆检索真的准确吗?会不会搜出了错误的背景资料?

- 它在执行任务时,中间步骤有没有逻辑崩塌?

- 面对用户的提问,它是真的“知道”,还是在自信地“胡说八道”(幻觉)?

目前,大多数开发者还在依靠 “Vibe Check”(凭感觉测试)——“我看它回答得挺通顺,应该没问题”。但这在工程领域是远远不够的。

在下一篇博文中,我们将进入深水区:Evaluation & Observability (评测与观测)。

我们将探讨:

- 如何用 RAGAS 等框架给记忆检索质量打分?

- 如何追踪 Agent 的思考链(Chain of Thought)?

- 如何从“炼金术”走向严谨的“软件工程”?

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)