物联网 AI 选型指南:从边缘离线到云端调用,三种模型部署方案深度对比

本文对比分析了轻量级离线模型、本地部署大模型和云端API调用大模型三大技术方案。从模型体量、部署位置、算力需求、隐私性等维度进行详细对比,指出轻量级模型适合MCU级设备实现简单感知,本地大模型适用于边缘设备处理复杂推理,云端API则适合大规模低成本部署场景。针对嵌入式领域,重点阐述了本地化部署大模型的技术路径,包括7B以下模型选型、量化工具选择(GPTQ/AWQ/TensorRT等)以及三类典型硬

在嵌入式 / 物联网领域,离线模型、大模型本地部署、大模型 API 云端调用是三种核心的 AI 模型应用方案,核心差异体现在 模型体量、算力依赖、网络需求、隐私性 四个维度,适配不同资源约束和业务场景。

下面从技术架构和典型应用两方面展开对比,帮你清晰区分三者的适用边界。

一、 核心技术架构区别

|

对比维度 |

轻量级离线模型 |

大模型本地部署 |

大模型 API 云端调用 |

|

模型体量 |

轻量级模型(KB/MB 级)如:CNN 轻量版、Tiny-LSTM、离线语音识别模型 |

中大型模型(GB 级,量化后)如:7B/13B 参数 LLM、多模态轻量化模型 |

超大型模型(TB 级)如:GPT-4、文心一言、通义千问等云端大模型 |

|

部署位置 |

直接部署在嵌入式终端(MCU、低功耗 SOC) |

部署在高性能边缘设备(带 NPU/GPU 的边缘盒子、车载中控) |

部署在云端服务器集群,设备端无模型 |

|

算力需求 |

极低,仅需CPU 算力即可运行(适合单片机) |

较高,需NPU/GPU 硬件加速(算力≥1 TOPS) |

设备端无算力要求,仅需数据采集 / 传输能力 |

|

网络依赖 |

完全离线,零网络需求 |

完全离线,零网络需求 |

强依赖网络(4G/5G/Wi-Fi),需稳定带宽 |

|

数据隐私 |

数据本地处理,隐私性极高(数据不出设备) |

数据本地处理,隐私性极高(数据不出边缘节点) |

数据需上传云端,隐私风险高(需加密传输) |

|

延迟表现 |

亚毫秒级延迟(实时响应,如语音指令识别) |

毫秒级延迟(复杂推理,如对话生成) |

百毫秒~秒级延迟(受网络波动影响大) |

|

成本结构 |

终端硬件成本极低,无后续费用 |

边缘设备硬件成本较高(需算力芯片),无后续费用 |

设备硬件成本低,需持续支付云端 API 服务费 + 流量费 |

|

升级维护 |

需烧录固件更新模型,维护成本高 |

支持本地 OTA 升级模型,维护难度中等 |

云端模型自动升级,设备端零维护 |

二、 典型应用场景(嵌入式 / 物联网领域)

1. 离线模型:资源受限的低功耗终端场景

核心特点:适配电池供电、算力极度有限的设备,实现简单的感知与控制。架构逻辑:模型直接固化在嵌入式终端固件中,设备采集数据后本地推理,直接触发执行动作。

典型场景

- 智能家居离线语音控制:智能灯控面板、离线语音开关中部署 TinyASR 轻量语音模型,本地识别 “开灯 / 关灯” 指令,无需联网即可执行,断网不影响使用。

- 工业传感器异常检测:在设备振动传感器节点中部署 Tiny-LSTM 模型,本地分析振动数据,实时识别设备故障特征,触发本地报警(无需上传云端)。

- 穿戴设备健康监测:智能手环中部署轻量级心率异常检测模型,本地分析心率数据,实时提醒用户,保护健康数据隐私。

适配设备:STM32 系列 MCU、ESP32-S3、低功耗蓝牙传感器节点。

2. 大模型本地部署:高隐私 + 复杂智能的边缘场景

核心特点:在边缘设备上实现复杂的 AI 推理,兼顾隐私性与智能性,摆脱网络依赖。架构逻辑:通过模型量化、剪枝、蒸馏技术,将大模型压缩适配边缘硬件,数据在边缘节点本地完成推理,不与云端交互。

典型场景

- 车载离线智能座舱:在车载中控(如 RK3588 平台)部署量化后的 7B 大语言模型,实现离线语音对话(如 “规划离线路线”“解释故障码”)、驾驶员疲劳检测,偏远路段无网络也能使用。

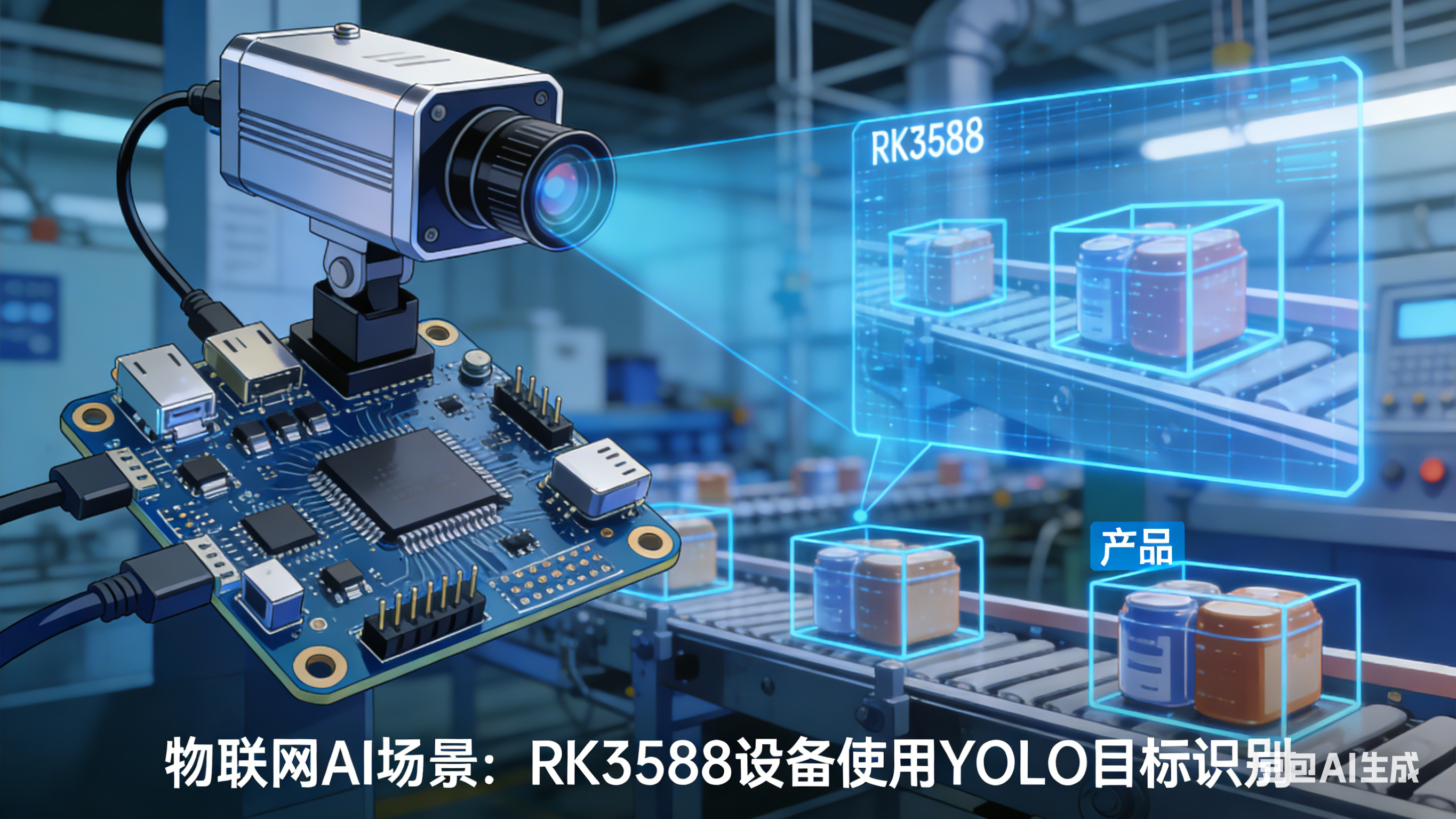

- 工业质检边缘分析:在产线边缘计算盒中部署轻量化多模态大模型,本地分析产品外观图像 + 传感器数据,实时识别缺陷,无需上传敏感的产品数据到云端。

- 安防摄像头离线识别:智能摄像头内置大模型(如 YOLOv8+ 轻量化 LLM),本地识别可疑行为(如翻墙、遗留物),实时触发警报,避免视频流上传云端的带宽成本与隐私风险。

适配设备:树莓派 5、RK3588 边缘盒、Jetson Nano、地平线 X3 开发板。

3. 大模型 API 在线调用:低成本 + 广覆盖的规模化场景

核心特点:借助云端大模型的超强算力与通用性,降低设备端硬件成本,适合大规模部署。架构逻辑:嵌入式设备仅负责采集数据(图像、语音、传感器数据),通过网络上传到云端,调用大模型 API 获取推理结果,再执行本地动作。

典型场景

- 农业物联网病虫害识别:农田低功耗摄像头采集作物叶片图像,通过 4G 上传到云端,调用大模型 API 识别病虫害类型,云端返回防治建议,再由网关控制喷药设备精准作业,无需田间设备具备复杂算力。

- 智能家居云端语义理解:入门级智能音箱采集用户语音,上传到云端调用大模型 API,理解复杂语义(如 “明天降温,帮我把空调调高 2 度”),再下发指令到设备,降低音箱硬件成本。

- 城市井盖状态监测:井盖传感器采集倾角、振动数据,上传到云端调用大模型 API,分析井盖是否移位 / 破损,实现城市基础设施规模化监测,无需每个传感器节点部署复杂模型。

适配设备:低成本摄像头、LoRa 传感器节点、入门级智能音箱。

三、 技术选型决策树

- 若设备 电池供电、算力≤0.1 TOPS、需求是简单感知 / 控制 → 选 离线模型

- 若需 复杂对话 / 多模态推理、隐私性要求高、无网络环境 → 选 大模型本地部署

- 若 设备规模大、硬件成本敏感、允许联网且延迟可接受 → 选 大模型 API 在线调用

四、大模型本地化部署

聚焦低功耗、算力受限的嵌入式场景,围绕模型量化工具、适配硬件、部署流程三大核心模块整理,适配主流嵌入式设备(MCU/SOC/ 边缘计算板),优先选择开源、轻量化、易部署的技术方案。

1、 核心前提:嵌入式大模型选型原则

- 模型规模:优先选择 7B 及以下参数的模型(量化后可压缩至 2-8GB),避免超过嵌入式设备内存上限。

- 模型类型:优先选专为边缘优化的模型(如 Qwen-2、Llama 2 轻量化版、Phi-2、Baichuan-2 ),支持中英文对话 / 推理场景。

- 量化精度:推荐 INT4/INT8 量化(平衡精度与性能),极端资源受限场景可选 NF4 量化。

2、 模型量化与转换工具(核心必备)

量化是嵌入式部署的关键步骤,目的是压缩模型体积、降低算力 / 内存占用,以下是主流工具选型:

|

工具名称 |

核心优势 |

适用场景 |

适配硬件 |

使用门槛 |

|

GPTQ |

开源,支持 LLM 的 INT4/INT8 量化,量化后精度损失小,支持主流模型(Llama/Qwen) |

大语言模型本地推理 |

带 NPU/GPU 的嵌入式 SOC(如 RK3588、Jetson) |

中等(需 Python 环境) |

|

AWQ |

量化速度比 GPTQ 快,显存占用更低,适合资源极度受限设备 |

7B 及以下模型快速量化 |

MCU+NPU 加速板 |

中等 |

|

TensorRT |

NVIDIA 官方工具,支持模型编译优化,推理速度提升显著 |

搭载 NVIDIA GPU/NPU 的嵌入式设备(Jetson 系列) |

Jetson Nano/TX2/Orin |

中等偏高(需熟悉 CUDA) |

|

ONNX Runtime |

跨平台,支持多框架模型(PyTorch/TensorFlow)转换为 ONNX 格式,内置量化工具 |

通用嵌入式 SOC(树莓派、RK3588) |

几乎所有嵌入式设备 |

低(提供 C++/Python API) |

|

Tengine |

国产开源推理框架,专为嵌入式优化,支持 INT8/FP16 量化,轻量级(体积 < 1MB) |

低功耗 MCU/SOC(STM32、全志 T527) |

单片机、边缘传感器节点 |

低(提供嵌入式 C SDK) |

工具使用优先级建议

- 若用 NVIDIA 嵌入式硬件 → 优先 TensorRT

- 若用 国产 SOC(RK / 地平线) → 优先 ONNX Runtime/Tengine

- 若仅做 LLM 量化 → 优先 GPTQ/AWQ

3、 嵌入式适配硬件选型

根据算力等级和应用场景,将嵌入式硬件分为 3 类,对应不同模型规模:

|

硬件等级 |

代表产品 |

算力参数 |

支持模型规模(量化后) |

典型应用场景 |

|

MCU 级(极低功耗) |

STM32H7、ESP32-S3、全志 D1 |

0.1-1 TOPS(CPU 算力) |

1B 以下参数模型(如 TinyLlama-1B-int4) |

离线语音助手、传感器数据本地推理 |

|

嵌入式 SOC 级(中等算力) |

树莓派 4/5、RK3588、全志 T527 |

1-10 TOPS(NPU 算力) |

4B-7B 参数模型(如 Qwen-4B-int4、Llama-2-7B-int8) |

智能家居中控、车载离线语音 |

|

边缘计算板级(高性能) |

Jetson Nano/Orin Nano、地平线 X3、寒武纪思元 220 |

10-100 TOPS(NPU/GPU 算力) |

7B-13B 参数模型(如 Qwen-7B-Chat-int4) |

车载智能座舱、工业质检、机器人视觉 |

4、硬件选型关键指标

- 内存容量:至少预留 2 倍于量化后模型体积 的内存(如 4GB 量化模型需 8GB 内存)。

- NPU/GPU 加速:优先选带专用 AI 加速芯片的硬件,推理速度比纯 CPU 快 10-100 倍。

- 功耗:电池供电场景优先选 <5W 低功耗硬件(如 RK3588、ESP32-S3)。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)