【程序员必看】DeepSeek开源Engram:O(1)查表代替多层计算,大模型效率革命来了!

DeepSeek与北大合作开源Engram,提出大模型"条件内存"新范式,作为与MoE互补的第二条稀疏化轴。通过O(1)查表代替多层计算,实现Tokenizer压缩、多哈希头检索和上下文门控三大核心功能。实验显示,将20%~25%预算分配给Engram可显著提升模型性能,在知识、推理、代码数学等任务全面超越传统MoE架构,且长上下文处理能力大幅提升(NIAH从84→97)。项目已开源,为开发者提供

https://github.com/deepseek-ai/EngramConditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models DeepSeek-AI × 北大

今天,DeepSeek开源 Engram &论文,做的是模型内部的 parametric memory(参数化记忆),RAG 是模型外部的 non-parametric memory(非参数化记忆)。两者可以叠加,形成“内外双记忆”系统。

Conditional Memory via Scalable Lookup: A New Axis of Sparsity for Large Language Models

一、MoE 之后,稀疏化还能怎么卷?

自从 MoE(Mixture-of-Experts)把“条件计算”做成主流,大模型就靠“只激活一部分专家”把参数量推高到百亿甚至千亿,而每 token 计算量几乎不变。

但作者指出:语言信号里还有大量“静态局部模式”——人名、成语、公式、代码片段——它们根本不需要层层 Attention 去“推理”,查表就能解决。

Transformer 没有原生的 lookup 原语,只能把“查字典”硬算成“矩阵乘法”,浪费深度、浪费 FLOPs,还占用宝贵的 Attention 带宽。

Engram已开源

于是团队提出第二条稀疏轴:

条件内存(Conditional Memory)——用 O(1) 查表代替多层计算,与 MoE 的“条件计算”互补。

二、方案:Engram = 现代版 N-gram + 哈希表 + 上下文门控

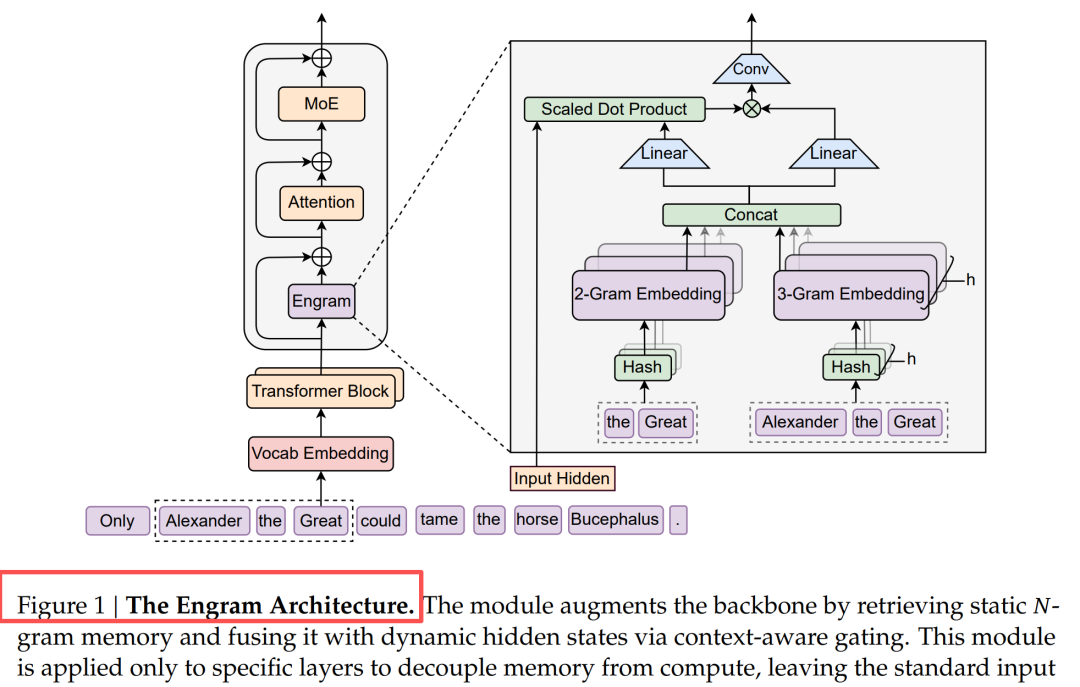

2.1 总体架构

图1:Engram 插在 Transformer 中间层,先查表再与隐藏态融合。

核心三步:

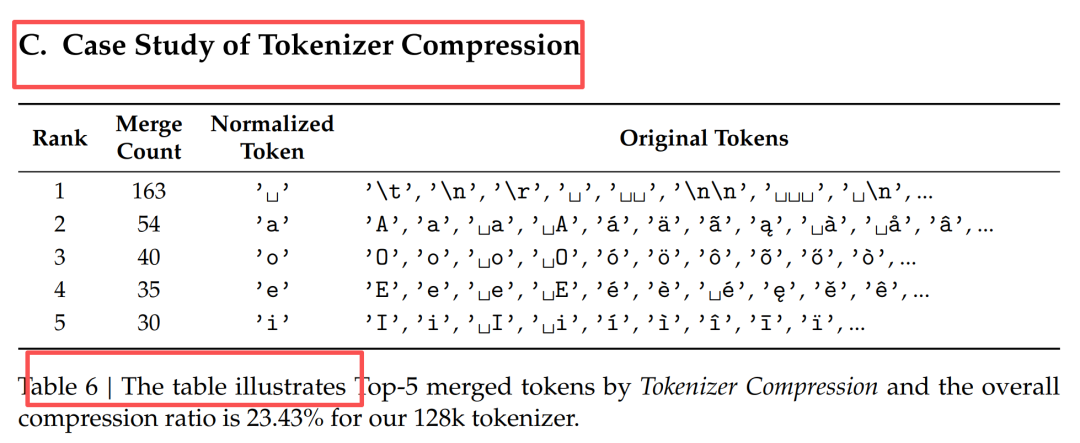

- Tokenizer 压缩:把 128 k 词表先映射到“语义等价类”,减少 23 % 冗余

- 多哈希头检索:2~3-gram 分别用 8 个独立哈希函数映射到 5.7 B 个 slot,几乎无碰撞。

- 上下文门控:用当前隐藏态做 Query,对查到的 Value 做 RMSNorm-点积-σ 门控,抑制歧义或冲突条目。

2.2 系统级设计:把 100 B 参数搬去 CPU 也毫无压力

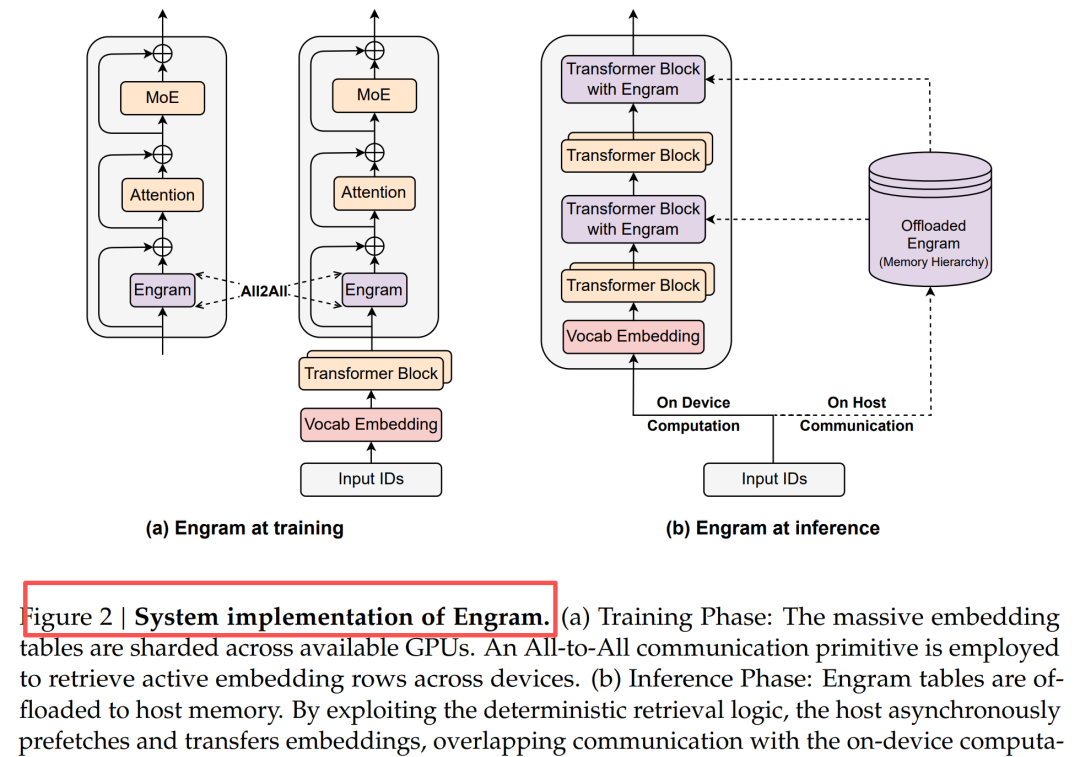

图2:训练时表分片 All-to-All;推理时利用确定性地址预取,PCIe 延迟被计算掩盖。

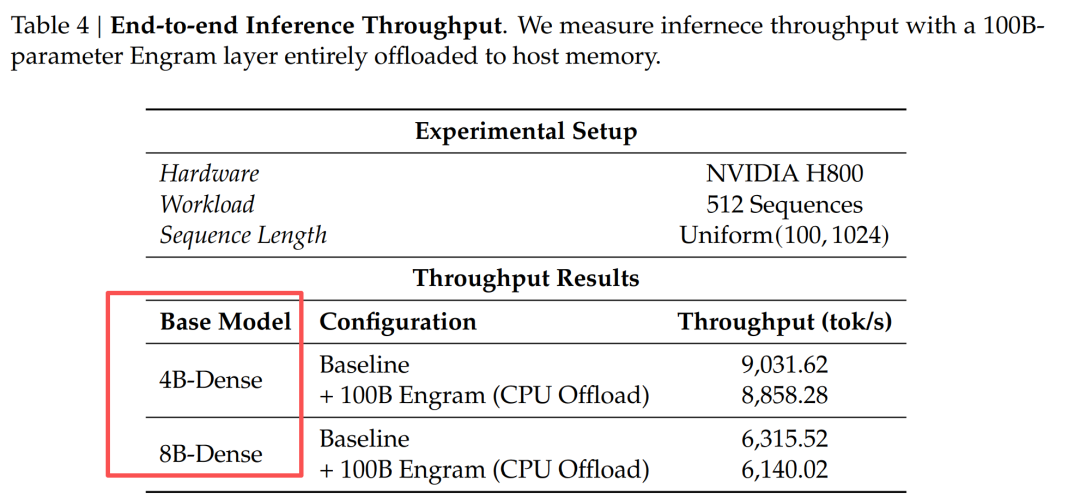

- 推理把整张表放主机内存,GPU 算前几层的同时异步搬数据,**吞吐损失 < 3 %**(见表4)。

- 利用 N-gram 的 Zipf 分布做多级缓存,热 slot 常驻 GPU HBM,冷 slot 放 SSD,进一步降低延迟。

三、结论:27B 外挂内存,全面碾压同参数 MoE

3.1 稀疏预算怎么分?U 形曲线给出答案

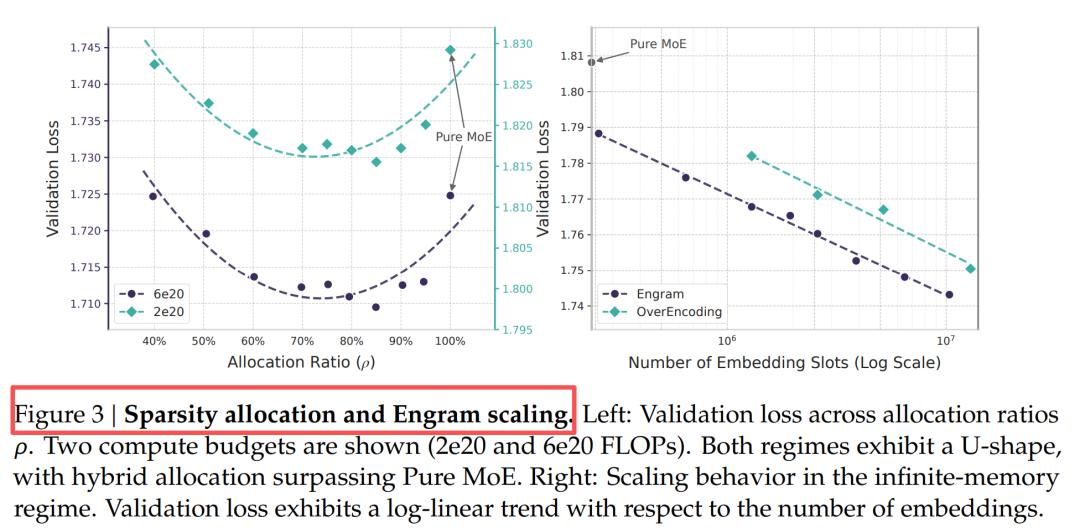

图3:固定总参数 + 固定激活量,纯 MoE(ρ=100 %)并非最优,把 20 %~25 % 预算挪给 Engram 后验证损失最低。

3.2 大模型实战成绩

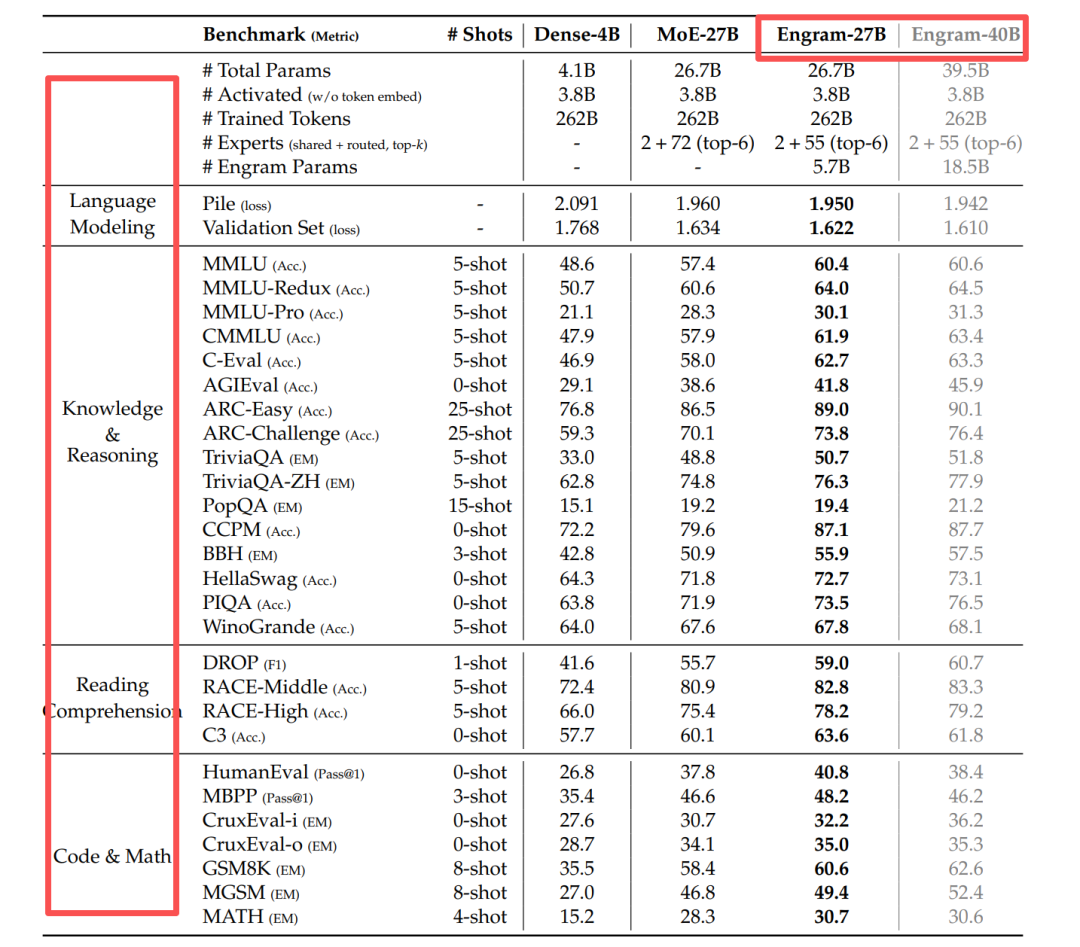

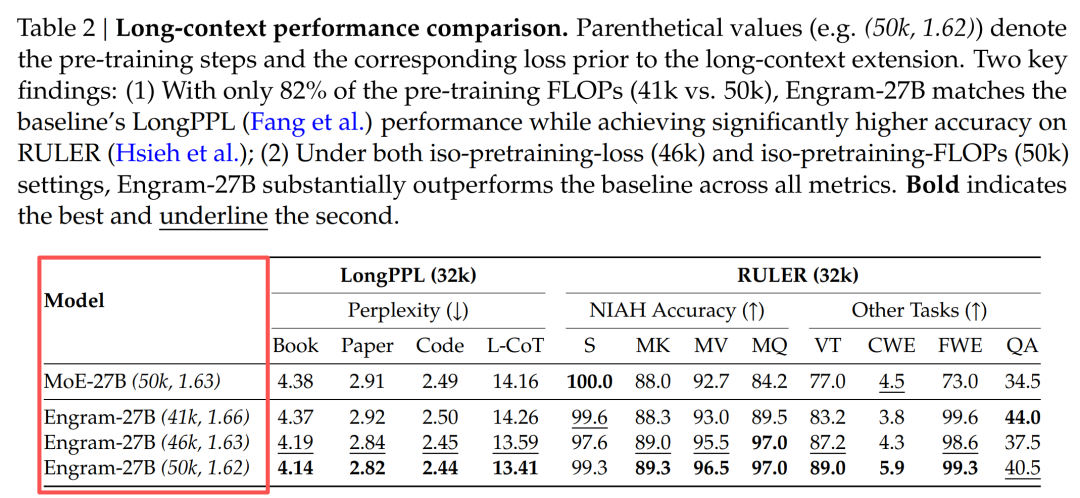

表1 给出 26.7 B 总参数 / 3.8 B 激活量 下的对比:

知识任务涨、推理任务涨、代码数学也涨——说明“查表”不仅背知识,还让 backbone 更早聚焦高阶语义。

3.3 长上下文bonus:NIAH 从 84 → 97

表2 示,把 Engram-27B 拉到 32 k 上下文后,Multi-Query NIAH 准确率 97.0,远超 MoE 的 84.2。

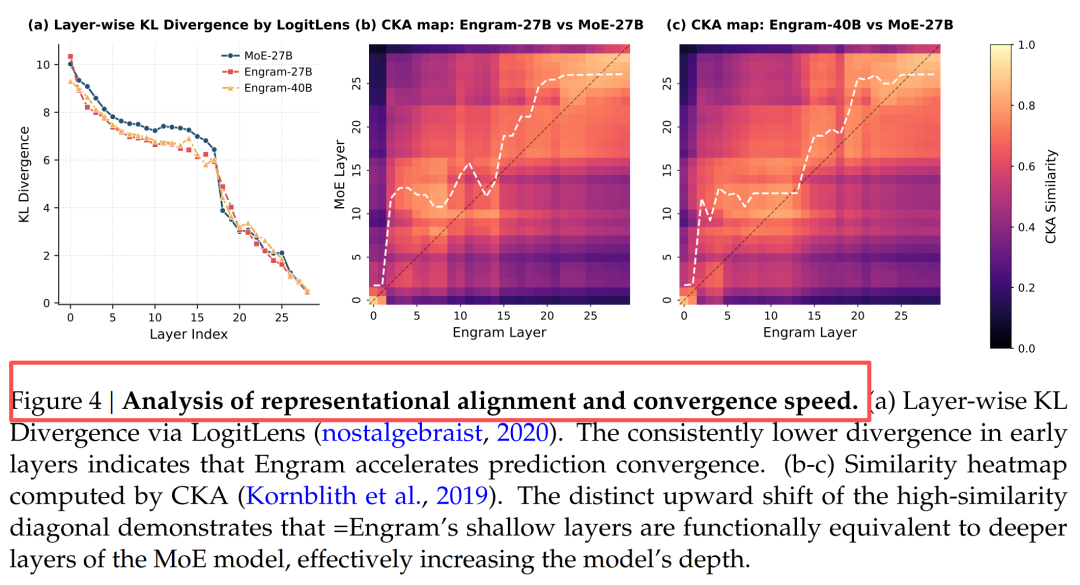

机理:局部依赖被 lookup 接管,Attention 专注全局,等效深度增加。

四、一图看懂“等效深度”

左:LogitLens 显示 Engram 在第 5 层就达到 MoE 第 12 层的预测置信度;右:CKA 热力图对角线明显上移。

五、总结

“让模型记住的归查表,让模型推理的归计算”——Engram 把 N-gram 老想法做成可扩展基础设施,给下一代稀疏大模型提供了内存轴的新范式。

学AI大模型的正确顺序,千万不要搞错了

🤔2026年AI风口已来!各行各业的AI渗透肉眼可见,超多公司要么转型做AI相关产品,要么高薪挖AI技术人才,机遇直接摆在眼前!

有往AI方向发展,或者本身有后端编程基础的朋友,直接冲AI大模型应用开发转岗超合适!

就算暂时不打算转岗,了解大模型、RAG、Prompt、Agent这些热门概念,能上手做简单项目,也绝对是求职加分王🔋

📝给大家整理了超全最新的AI大模型应用开发学习清单和资料,手把手帮你快速入门!👇👇

学习路线:

✅大模型基础认知—大模型核心原理、发展历程、主流模型(GPT、文心一言等)特点解析

✅核心技术模块—RAG检索增强生成、Prompt工程实战、Agent智能体开发逻辑

✅开发基础能力—Python进阶、API接口调用、大模型开发框架(LangChain等)实操

✅应用场景开发—智能问答系统、企业知识库、AIGC内容生成工具、行业定制化大模型应用

✅项目落地流程—需求拆解、技术选型、模型调优、测试上线、运维迭代

✅面试求职冲刺—岗位JD解析、简历AI项目包装、高频面试题汇总、模拟面经

以上6大模块,看似清晰好上手,实则每个部分都有扎实的核心内容需要吃透!

我把大模型的学习全流程已经整理📚好了!抓住AI时代风口,轻松解锁职业新可能,希望大家都能把握机遇,实现薪资/职业跃迁~

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献457条内容

已为社区贡献457条内容

所有评论(0)