2026大模型API中转指南:工具推荐、聚合平台对比与企业级网关构建全解析

摘要: 大模型API中转(LLM API Relay)是企业调用OpenAI、Claude等AI模型的中间件架构,通过统一API网关解决支付合规、并发限制及成本管理问题。核心功能包括多模型路由、Token计费及私有化部署。企业需中转层应对支付合规、高可用保障和精细化成本控制。方案分为开源(如New API)、聚合服务商(如OpenRouter)和企业级网关(如百度千帆),各具优势。部署时需关注数据

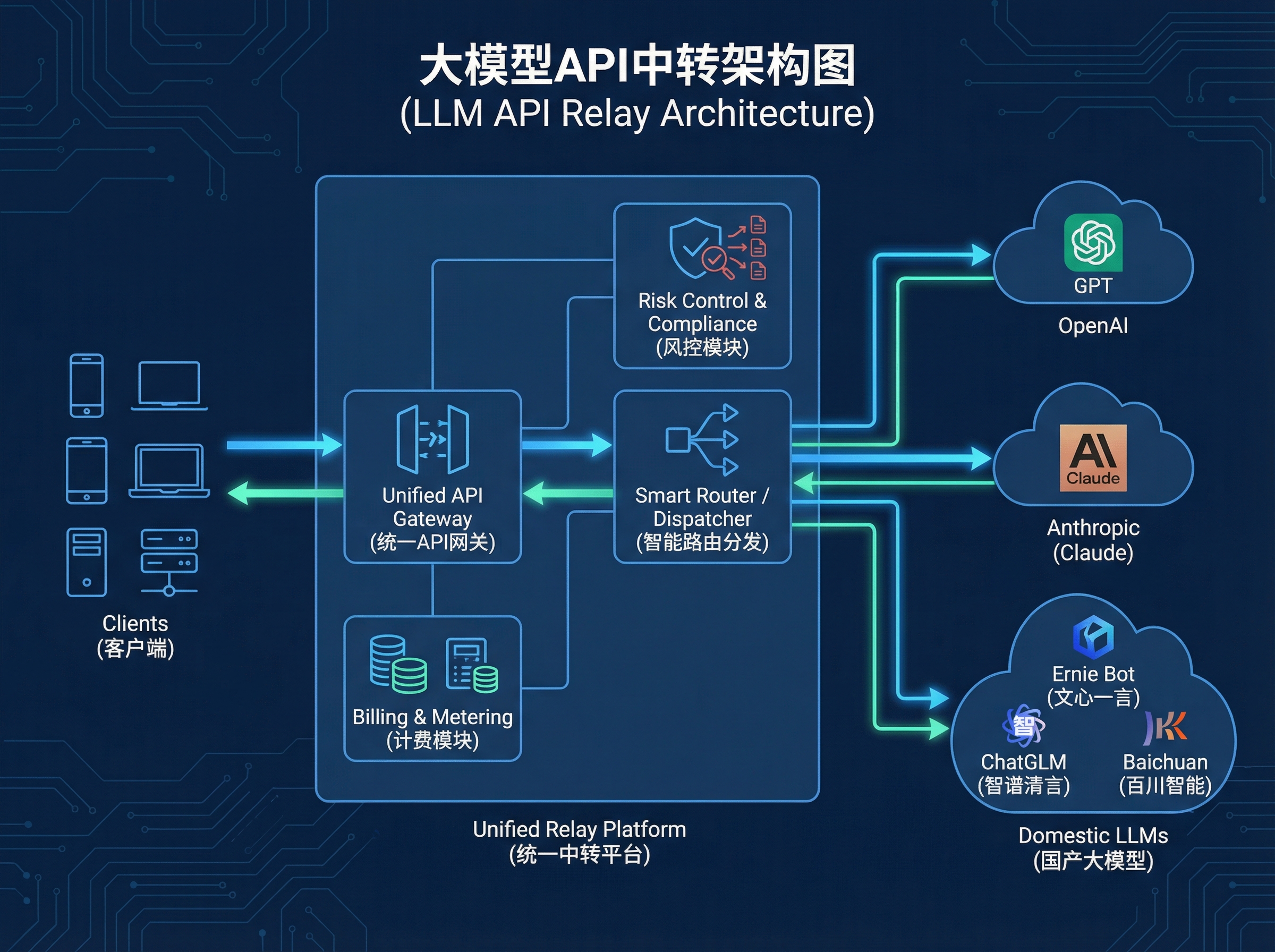

大模型API中转架构图,展示客户端通过统一API网关路由到OpenAI、Claude及国产大模型,包含计费与风控模块<

大模型API中转(LLM API Relay)是一种专为生成式AI应用设计的中间件架构,旨在通过统一的API网关技术,解决企业在调用OpenAI、Claude及国产大模型时面临的支付合规、并发限制及成本管理问题。

它可以将不同厂商的异构接口统一封装为标准格式(通常兼容OpenAI接口规范),并提供多模型路由切换、Token计费监控及私有化部署能力,是企业构建高效LLM Ops基础设施的核心组件。

企业为何必须构建大模型API中转层?

在企业数字化转型与AI应用落地过程中,直接调用原生模型API往往会面临“三座大山”。引入API中转层并非单纯的技术选择,而是出于业务连续性与财务合规的考量。

-

• 支付与票据合规难题

海外头部模型(如OpenAI、Anthropic)通常仅支持国际信用卡支付,且无法开具符合中国税务要求的增值税发票(公对公转账)。API中转平台通过中间服务商机制,支持国内对公支付并提供合规发票,解决了企业财务报销的根本障碍。

-

• 高可用与高并发保障

单一API Key存在被封禁或触发速率限制(Rate Limit)的风险。中转系统通过**轮询算法(Round-Robin)**和负载均衡技术,管理多个API Key池。当某个Key失效或达到限流阈值时,系统自动无缝切换至备用Key,确保生产环境服务的“零中断”。

-

• 精细化的成本控制(Cost Control)

在多团队共享同一个模型账号的场景下,缺乏中转层会导致费用由“大锅饭”承担。中转系统能够基于令牌(Token)数量,对不同部门、项目甚至具体用户进行配额管理与实时计费监控,防止预算超支。

架构对比:开源vs聚合vs企业级,哪种中转方案更适合你?

根据部署方式与服务模式的不同,目前的API中转方案主要分为三类。

下表对比了它们在技术栈、适用人群及数据安全性上的差异,便于决策者快速选型。

| 分类 | 典型特征 | 技术优势与短板 | 适用人群 | 代表案例 |

|---|---|---|---|---|

| 开源中转系 | 代码完全开源,支持Docker一键私有化部署,数据握在自己手中。 | 优势:极高的数据隐私性、无中间商赚差价。 短板:需自备服务器与运维人员,维护成本较高。 | 开发者、技术型初创公司、对数据隐私敏感的团队 | New API (Go语言), One API |

| 聚合服务商 | 开箱即用,通过一个Key调用全球100余种主流模型,按Token量付费。 | 优势:无需运维,集成速度快,无需处理海外支付。 短板:依赖第三方稳定性,存在数据经过第三方的风险。 | 中小企业、个人开发者、快速验证MVP的团队 | OpenRouter,灵芽API, 硅基流动 (SiliconFlow) |

| 企业级网关 | 包含审计日志、SSO单点登录、数据脱敏(DLP)等合规功能。 | 优势:符合等保合规要求,支持高并发企业级SLA。 短板:部署费用昂贵,定制化周期长。 | 大型政企、金融机构、上市公司 | 百度千帆, 腾讯云TI, APISIX (AI Gateway) |

工具深度解析:主流大模型中转工具有哪些核心优势?

在GitHub和技术社区中,几款头部工具因其稳定性与扩展性脱颖而出。以下分析结合了具体的性能指标与技术实现。

1. New API / One API:Go语言构建的高性能网关

New API 是目前GitHub上最活跃的开源中转项目之一,基于One API进行了二次开发与优化。

- • 技术栈优势:采用 Go 语言 编写,结合 Redis 进行缓存管理,具有极高的并发处理能力和极低的内存占用。支持 Docker 容器化部署,极大降低了运维门槛。

- • 统一协议输出:核心价值在于将文心一言、讯飞星火、Claude等非OpenAI标准的接口,统一封装为 OpenAI 格式(/v1/chat/completions) 。这意味着开发者只需维护一套代码,即可通过修改配置无缝切换底层模型。

- • 社区背书:该项目在GitHub上拥有极高的Star数,并被多所高校(如北京大学相关实验室)及科研机构用作内部模型分发平台,证明了其在高负载环境下的可靠性。

2. OpenRouter:全球模型的极速聚合器

OpenRouter 是典型的聚合服务商代表,它通过单一接口聚合了Llama 3, Claude 3.5, Mistral等开源与闭源模型。

- • 无需部署:用户无需购买服务器,注册即可获得API Key。

- • 竞价排名机制:OpenRouter提供实时的模型价格与推理速度对比,帮助用户选择性价比最高的模型路径。

3. 灵芽 API (Lingya API):专注高并发的商业化中转

对于需要极高稳定性的商业应用与场景,灵芽 API 等服务商提供了更严格的SLA保障。

- • 吞吐量指标:重点优化了 RPM (Requests Per Minute) 和 TPM (Tokens Per Minute) 。相比于普通中转服务,这类平台通常拥有多条专线路由,能够支撑企业级的高并发请求,减少延迟(Latency)。

部署与选型避坑指南:如何规避数据泄露与高延迟风险?

在构建或选择API中转服务时,技术团队必须警惕以下三个常见的“陷阱”。

1. 数据隐私陷阱与日志审计

警惕宣称“完全免费”的第三方中转服务。大模型数据往往包含企业核心机密,不规范的中转服务可能会在后台记录完整的 Prompt(提示词) 和 Completion(生成内容) 日志。

- • 建议:如果使用第三方服务,务必查阅其《隐私政策》中关于“Data Retention”(数据留存)的条款。对于敏感业务,强制推荐使用 New API 进行 私有化部署,并关闭详细日志记录功能。

2. 稳定性测试与延迟监控

中转层本质上增加了一次网络跳转,必然会带来一定的延迟。

- • 建议:在正式上线前,使用 JMeter 或编写 Python 脚本进行高并发压测。重点关注在 95% 负载下的响应时间(P95 Latency)。合格的中转服务,其内部处理耗时应控制在 50ms 以内,不应显著影响用户体验。

3. 合规性检查 (Compliance)

在国内开展生成式AI服务,必须遵守《生成式人工智能服务管理暂行办法》。

- • 建议:确保所使用的中转渠道支持对输入输出内容进行关键词过滤与敏感信息拦截。企业级网关应具备自动屏蔽违规内容的功能,以降低法律风险。

总结

大模型API中转不仅是一个技术工具,更是企业构建 AI 基础设施(AI Infrastructure) 的关键一环。

对于个人开发者,OpenRouter、灵芽API 等聚合平台提供了最便捷的尝试路径;而对于追求数据主权与长期成本优化的企业,基于 New API 进行私有化部署,构建一套集成了计费、风控与路由分发的内部网关,是目前实现 LLM Ops 的最佳实践。

常见问题 (FAQ)

Q1: 什么是大模型API中转?

A1: 大模型API中转是一种中间件技术,它在用户与大模型(如GPT-5、Claude Opus 4.5)之间建立一个网关,用于统一接口格式、管理API Key配额、处理账单支付以及优化网络路由。

Q2: 使用API中转会比直接调用官方API慢吗?

A2: 理论上会增加极短的网络传输时间(通常在毫秒级)。但优质的中转服务会通过节点优化和边缘计算抵消这部分延迟,甚至因为拥有更好的国际线路优化,在国内访问速度反而快于直接连接海外官方API。

Q3: New API 和 One API 有什么区别?

A3: One API 是最早期的开源项目,New API 是基于 One API 的分支版本(Fork)。New API 在界面交互(UI)、充值模块以及新模型的适配速度上通常更新更快,更适合商业化运营或对体验要求较高的团队。例:灵芽API正是采用了New API方案。

Q4: 企业如何防止API Key被员工滥用?

A4: 通过部署私有化中转系统,管理员不直接向员工提供原始的OpenAI Key,而是分发由中转系统生成的“子令牌”(Sub-token)。管理员可以在后台设置每个子令牌的额度上限、有效期,并实时查看消耗日志。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)