告别在线大模型数据泄露风险:Ollama 本地化部署全指南(适配企业私密数据场景)

Ollama是一款开源跨平台工具,简化本地大语言模型(LLM)的部署与管理。它支持Windows/macOS/Linux系统,通过极简命令实现模型运行、下载和管理,无需复杂配置。核心特性包括隐私优先的本地离线运行、硬件自动适配和丰富的模型支持(兼容30+主流开源模型)。提供安装目录自定义、模型版本管理、后台服务控制等功能,并支持创建和分享自定义模型。常用命令包括ollama run启动模型、oll

对于企业而言,调用 GPT、文心一言等在线大模型时,核心痛点永远是私密数据安全—— 业务数据、客户信息、内部文档一旦上传至第三方服务器,就存在泄露、合规违规的风险。而 Ollama 的出现,正是为企业提供了 “数据不出内网” 的本地大模型运行方案:无需复杂配置,一条命令即可在公司内网部署开源 LLM,所有数据本地处理,彻底规避隐私泄露风险。本文不再仅讲基础安装,而是从企业数据安全视角,详解 Ollama 的部署、配置与实战,适配企业私密数据处理场景。

一、Ollama特点

Ollama 是一款开源跨平台工具,核心价值是让用户用极简命令在本地快速部署、运行和管理开源大语言模型(LLM),无需复杂配置与依赖,主打隐私优先、本地离线运行与硬件自动适配,被称为 “LLM 领域的 Docker”。以下从核心定位、关键特性、核心功能、适用场景等维度展开介绍。

官网描述为 “Get up and running with large language models locally”,核心是封装底层推理、硬件调度与模型管理,降低本地 LLM 使用门槛,支持消费级硬件运行量化模型。

2023 年 6 月在 GitHub 上线,2023 年底推出首个稳定版,支持 Windows/macOS/Linux 全平台,2025 年已兼容 30 + 主流开源模型,开源协议为 MIT,社区活跃且持续迭代。

本地运行保障数据隐私、离线可用、低延迟,同时大幅简化部署流程,无需手动配置 CUDA、PyTorch 等依赖。

你公司要在本地运行一个LLM,开发者通常需要:

第一步:手动从Hugging Face下载模型权重。

第二步:编写复杂的Python脚本,使用transformers库加载模型。(我只懂java,还要硬着头皮学习Python)

第三步:处理繁琐的依赖、CUDA版本和硬件兼容性问题。(开发笔记本和linux各种兼容、Python版本、包依赖问题)

第四步:如果需要API服务,还需要额外使用FastAPI等框架进行封装。

Ollama的核心动机,就是将所有这些繁琐的步骤自动化和标准化,让开发者可以像运行一个Docker容器一样,用一条命令就启动并与一个大模型进行交互。其设计哲学是简单、可及、本地优先。

二、OllamaSetup win10 自定义安装目录

Ollama 的 Windows 安装包默认会安装到系统盘(通常是 C:\Users <你的用户名>\AppData\Local\Programs\Ollama),安装的时候指定其他文件夹。

1. 下载并解压 Ollama 安装包

- 先下载 Ollama 的 Windows 安装包:Ollama 官方下载(文件名为

OllamaSetup.exe)。

2. 移动文件到自定义目录

- 新建你想要的安装目录,比如

E:\ai\aicode; - 将解压得到的所有文件(主要是

OllamaSetup.exe)复制 / 剪切到这个自定义目录下

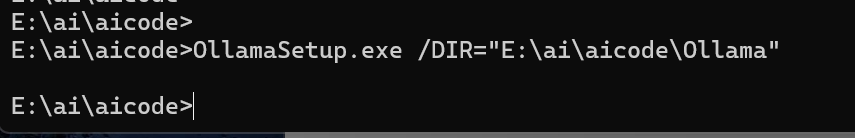

3.安装到自定义文件夹

按下 Win + R,输入 cmd,按住 Ctrl + Shift 并回车,以管理员身份打开 CMD:OllamaSetup.exe /DIR="E:\ai\aicode\Ollama"

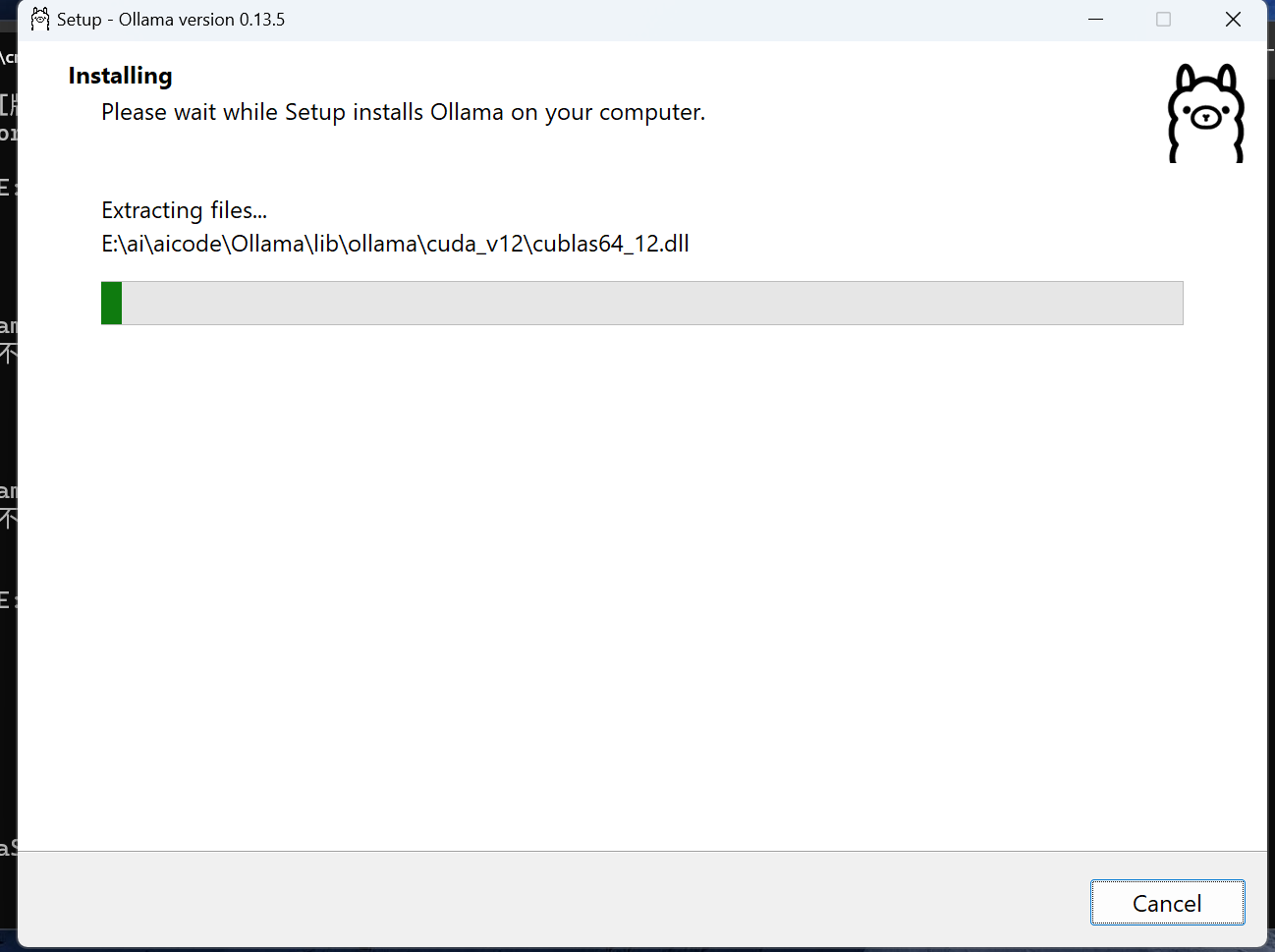

4.OllamaSetup安装进度显示安装具体目录

5.OllamaSetup验证

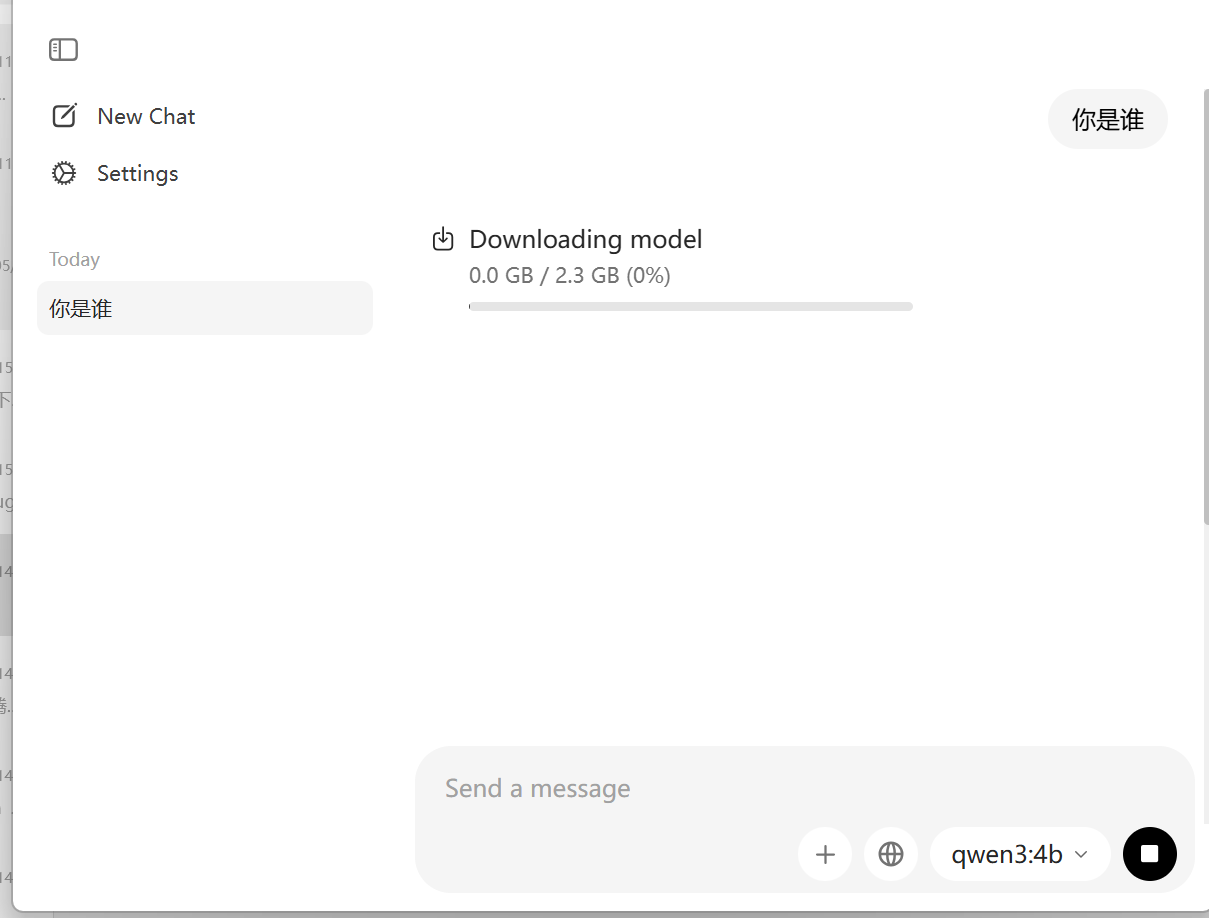

OllamaSetup安装之后,选择模型,提问问题

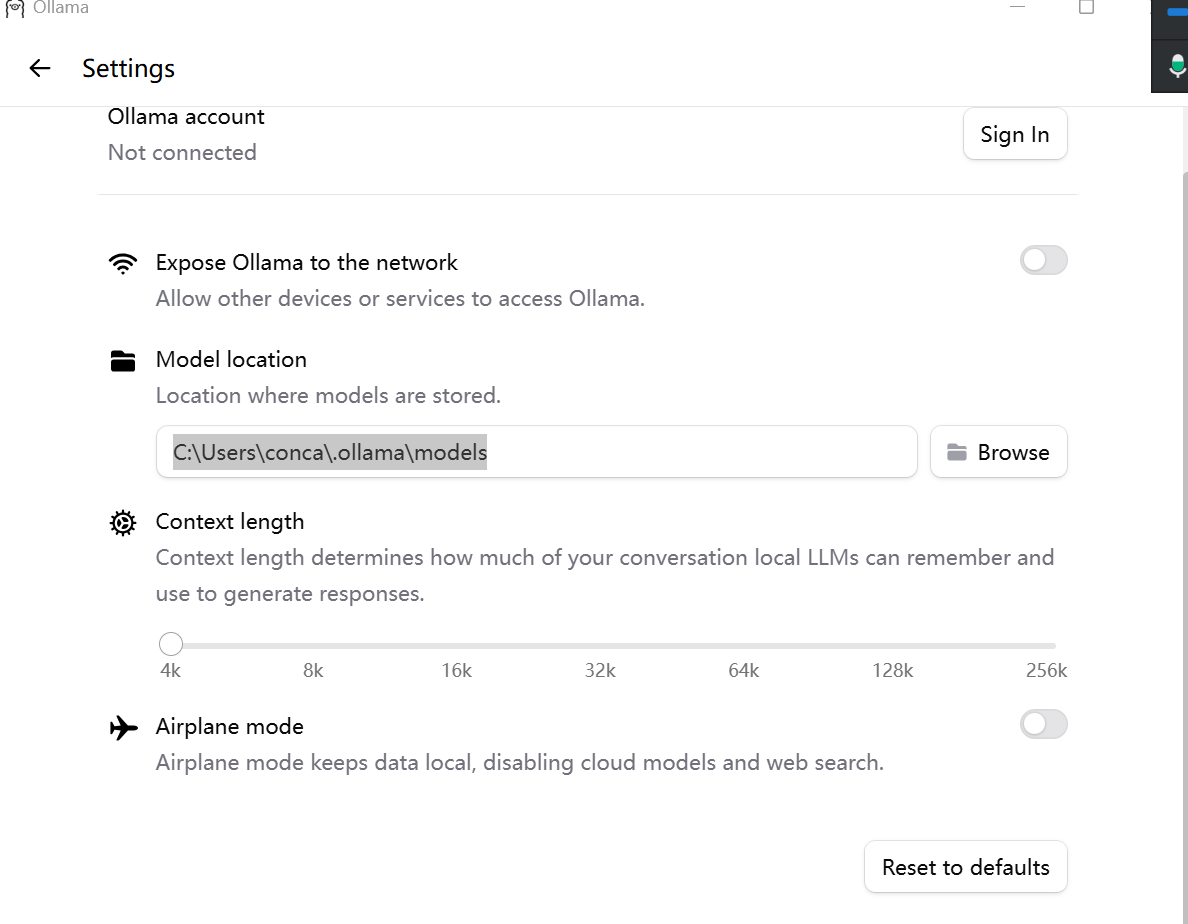

6.查看模型默认下载目录

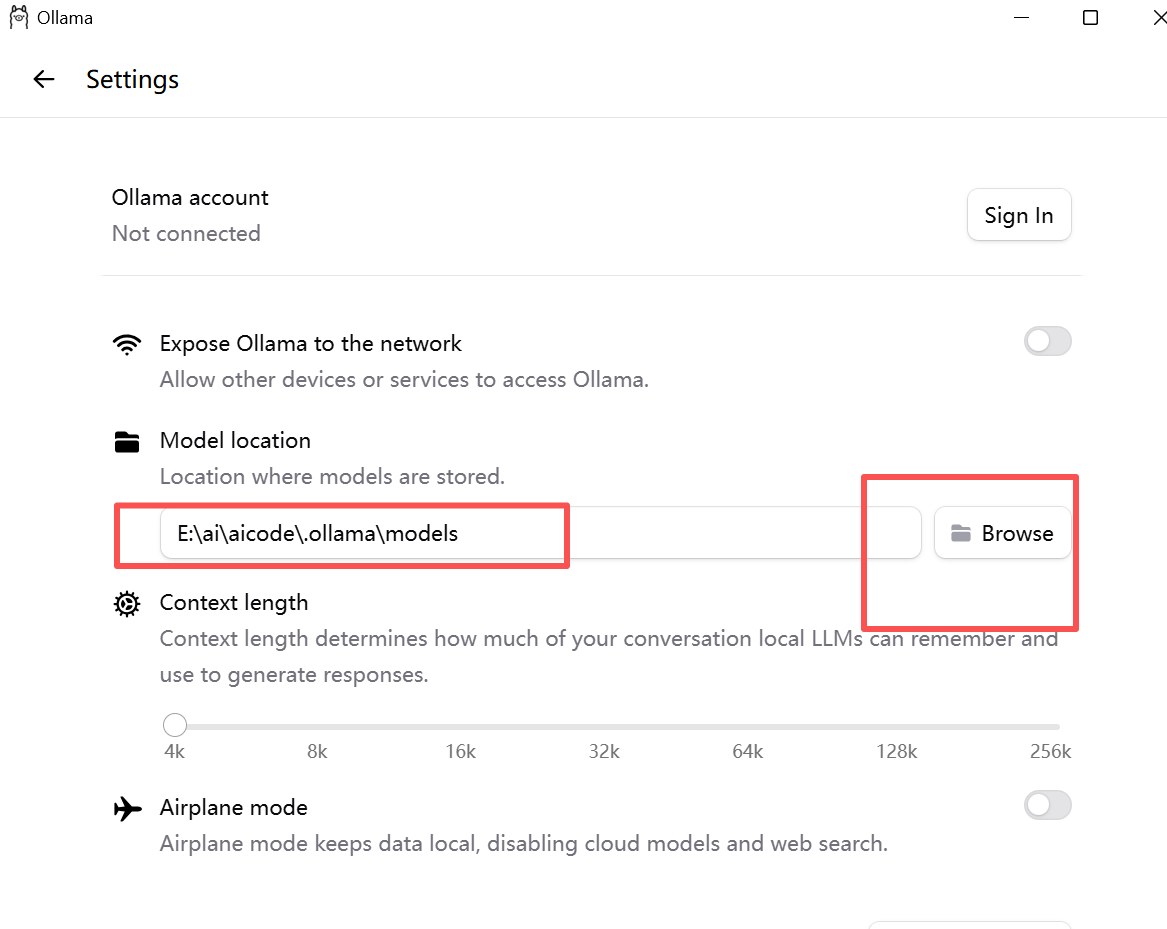

7.修改模型默认下载目录

三、Ollama常用命令

| 命令分类 | 具体命令 | 作用说明 | 示例 |

|---|---|---|---|

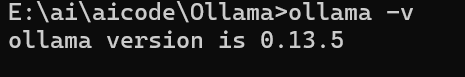

| 基础信息 | ollama -v / ollama version |

查看 Ollama 版本,验证安装是否成功 | ollama -v |

ollama help |

查看所有命令的帮助文档 | ollama help run |

|

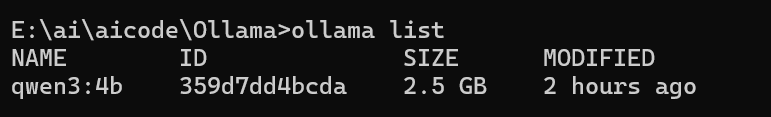

ollama list |

列出本地已下载的所有模型(含名称、ID、大小、修改时间) | ollama list |

|

ollama show <模型名> |

查看模型的详细信息(描述、参数、模板等) | ollama show llama3 |

|

ollama show <模型名> --modelfile |

查看模型的 Modelfile 配置内容 | ollama show llama3 --modelfile |

|

| 模型运行 | ollama run <模型名> |

启动模型交互对话(无本地模型则自动拉取) | ollama run llama3 |

ollama run <模型名>:<版本标签> |

运行指定版本的模型 | ollama run llama3:8b-instruct-q4_0 |

|

| 模型管理 | ollama pull <模型名> |

仅拉取模型到本地,不启动对话 | ollama pull llama3:7b |

ollama pull <用户名>/<模型名> |

拉取 Ollama 库中他人分享的自定义模型 | ollama pull username/my-llama |

|

ollama rm <模型名> |

删除本地指定模型(可加版本标签删除单个版本) | ollama rm llama3:7b |

|

ollama cp <原模型名> <新模型名> |

复制模型,用于重命名或创建自定义副本 | ollama cp llama3 my-custom-llama |

|

| 服务控制 | ollama service install |

安装 Ollama 后台服务(首次部署需执行) | ollama service install |

ollama service start |

启动 Ollama 后台服务 | ollama service start |

|

ollama service stop |

停止 Ollama 后台服务 | ollama service stop |

|

ollama service restart |

重启 Ollama 后台服务 | ollama service restart |

|

ollama service uninstall |

卸载 Ollama 后台服务(保留模型和程序) | ollama service uninstall |

|

| 高级自定义 | ollama create <模型名> -f <Modelfile路径> |

基于 Modelfile 配置创建自定义模型 | ollama create my-llama -f ./Modelfile |

ollama push <模型名> |

将自定义模型推送到 Ollama 库(需先登录) | ollama push my-llama |

|

ollama config show |

查看 Ollama 当前配置(存储路径、端口等) | ollama config show |

查看版本

查看运行的模型

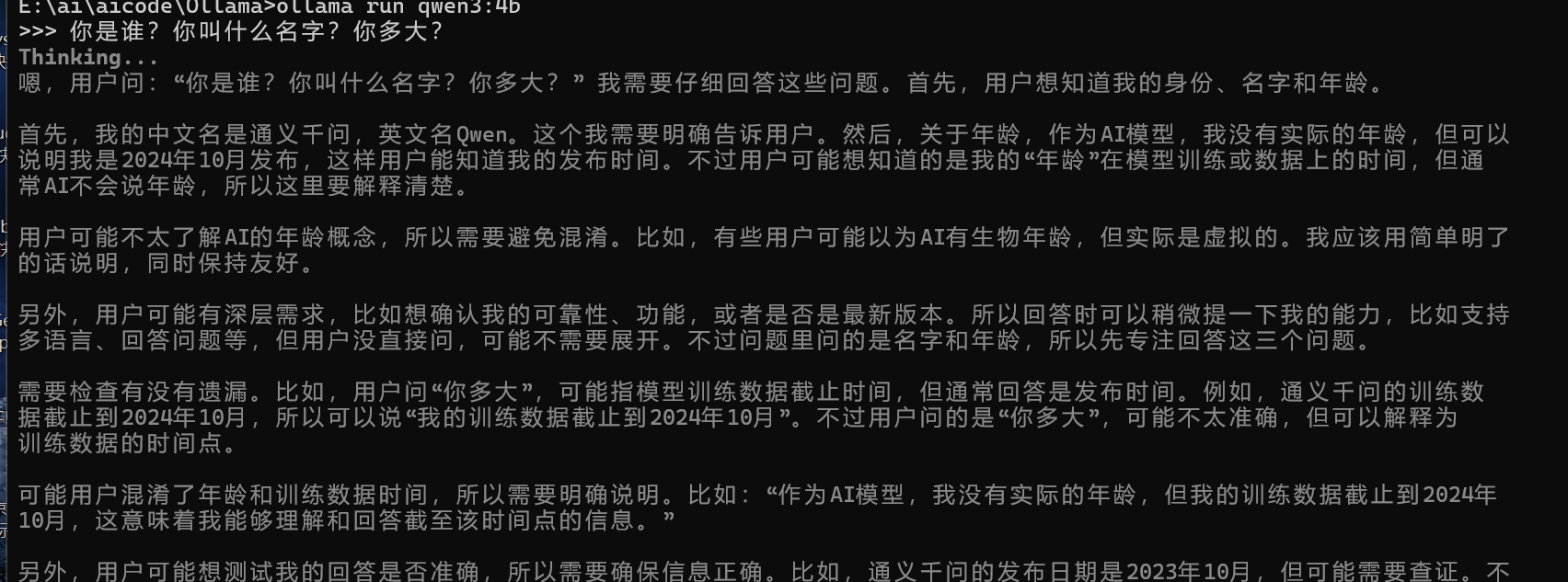

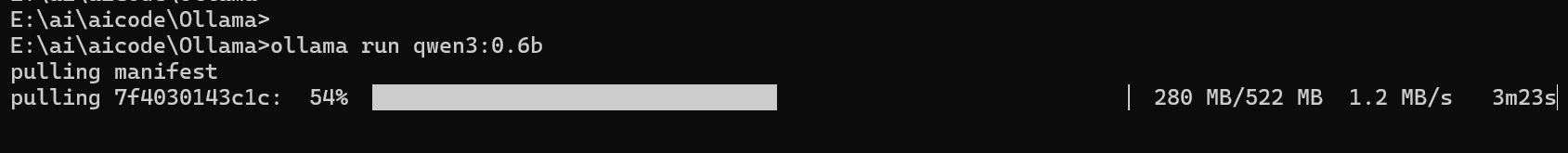

运行某个模型E:\ai\aicode\Ollama>ollama run qwen3:4b

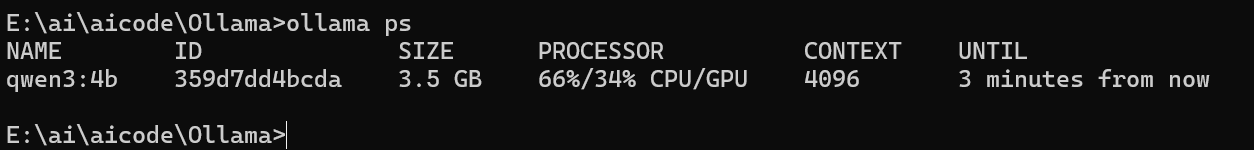

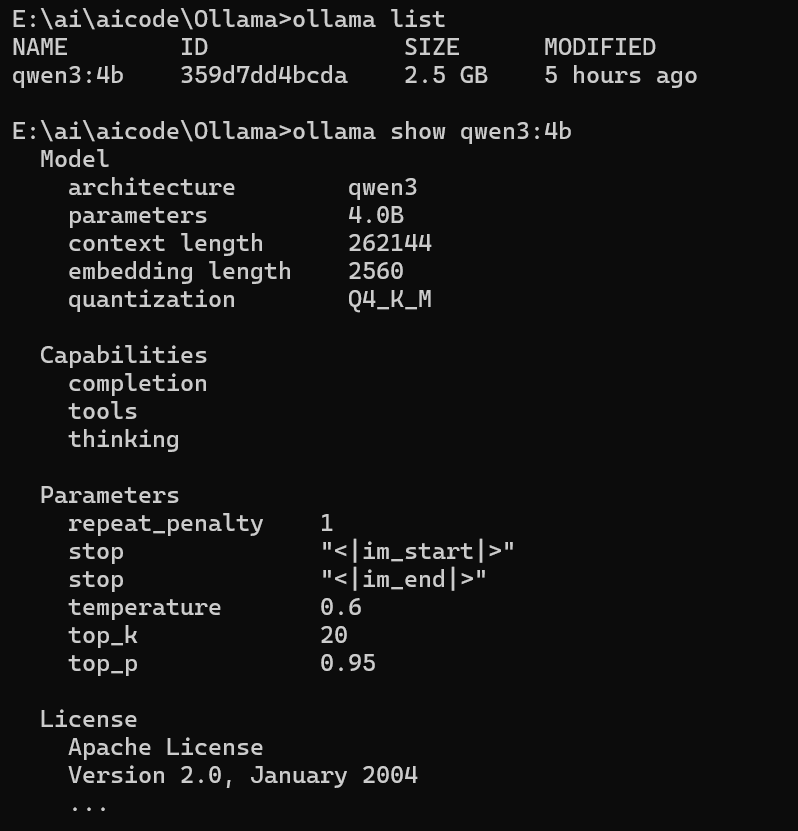

查看正在运行的模型ollama ps

查看模型信息ollama show qwen3:4b

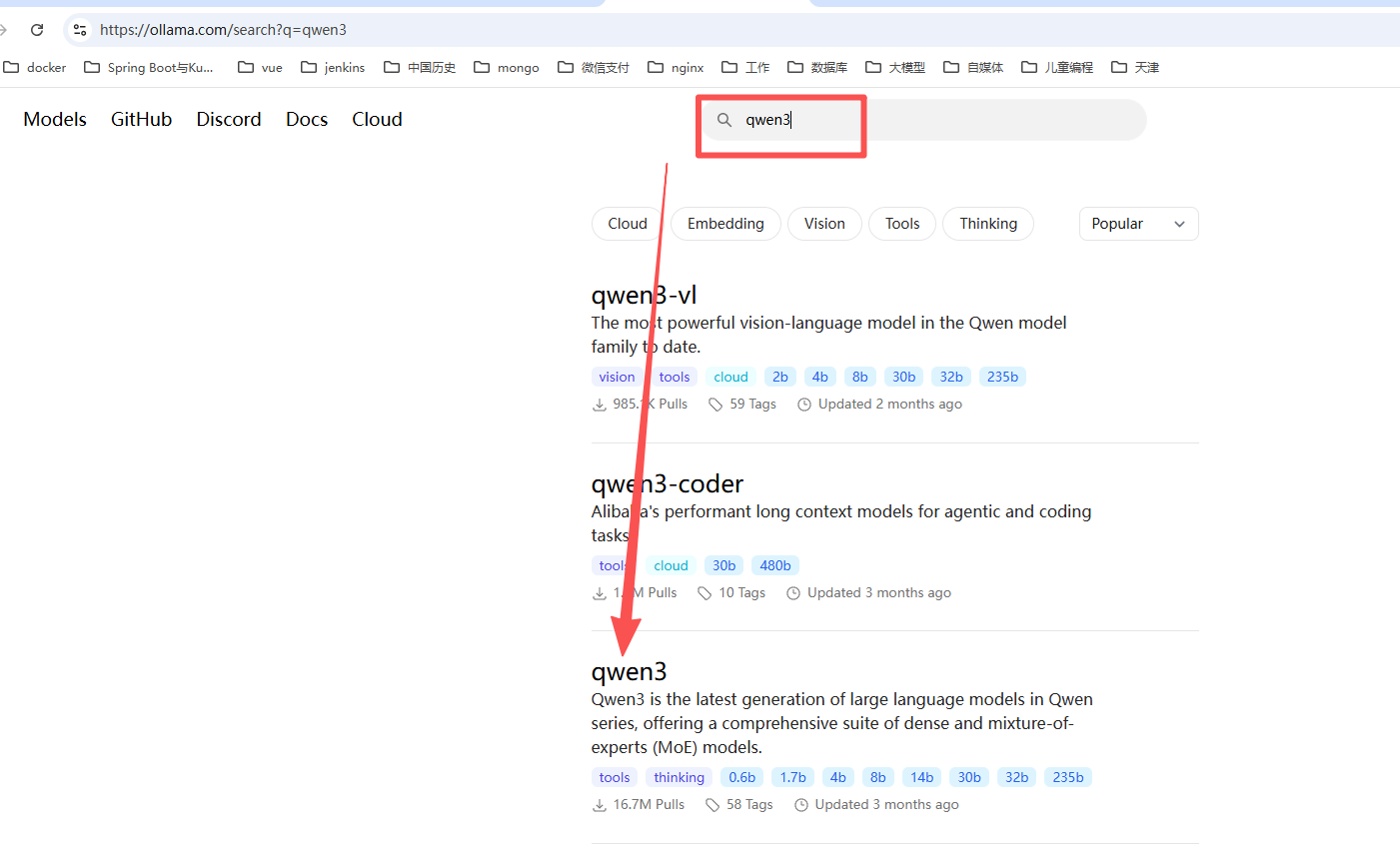

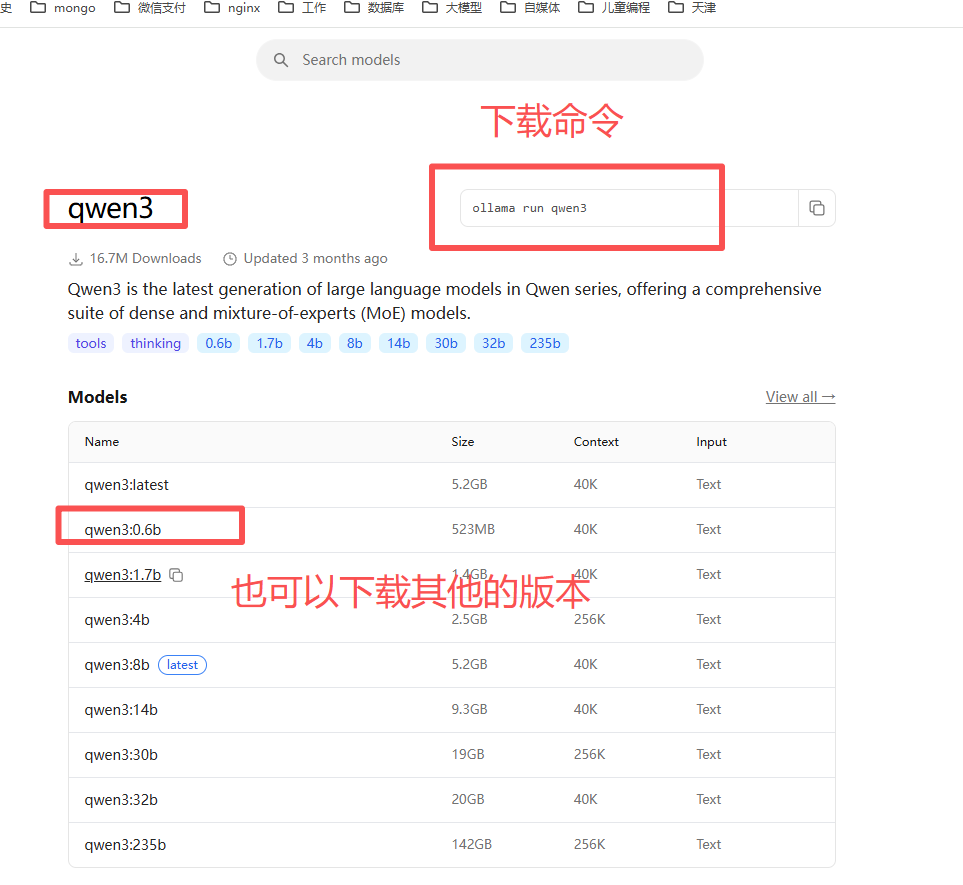

四、寻找和下载模型

登录ollama官网https://ollama.com/,搜索自己想要的模型名字。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)