AI写代码更快,但你的工作仍是证明它能用

积极的一面是,团队报告在某些情况下捕获了95%以上的错误——空指针异常、缺失的测试覆盖率、反模式。消极的一面是,一些开发者认为AI审查评论是“文本噪音”——没有增加任何价值的通用观察。尽管快速推进,但看到丑陋的代码时要修复它,而不是让混乱累积。在AI时代,最好的代码审查者将拥抱这一转变——让AI加速机械性工作,同时坚守问责制。代码不一定糟糕,但没有人有精力审查如此巨大的变更,而且审查AI生成的代码

AI没有杀死代码审查,而是让证明责任变得明确。发布变更时要附带手动验证和自动化测试等证据,然后利用审查来评估风险、意图和问责制。独立开发者依赖自动化来跟上AI的速度,而团队则利用审查来建立共享上下文和所有权。

如果你的拉取请求不包含证明其有效的证据,你并没有更快地发布——你只是把工作推给了下游。

到2026年初,超过30%的高级开发者报告称他们主要发布AI生成的代码。挑战在于:AI擅长草拟功能,但在逻辑、安全和边缘情况方面表现不佳——仅在逻辑错误方面就比人类高出75%。这导致了工作流的分化:独立开发者以“推理速度”凭感觉工作,依赖测试套件作为安全网;而团队则要求人工审查以确保上下文和合规性。如果处理得当,两者都将AI视为加速器,但验证——由谁、验证什么、何时验证——定义了差异。

正如我之前所说:如果你没有亲眼看到代码正常工作,那它就是无效的。AI放大了这一规则,而不是为其找借口。

开发者如何利用AI进行审查

- 临时LLM检查:在提交前将差异粘贴到Claude、Gemini或GPT中进行快速错误/风格扫描。

- IDE集成:使用Cursor、Claude Code或Gemini CLI等工具在编码过程中提供内联建议和重构。

- PR机器人和扫描器:使用GitHub Copilot或自定义代理标记PR中的问题;结合Snyk等静态/动态分析工具进行安全检查。

- 自动化测试循环:使用AI生成和运行测试,强制执行覆盖率>70%作为门槛。

- 多模型审查:通过不同的LLM运行代码(例如,用Claude生成,用专注于安全的模型进行审计)以发现偏差。

根据你是独立开发者还是在团队中工作(其他人需要维护你的代码),工作流和思维方式会有显著差异。

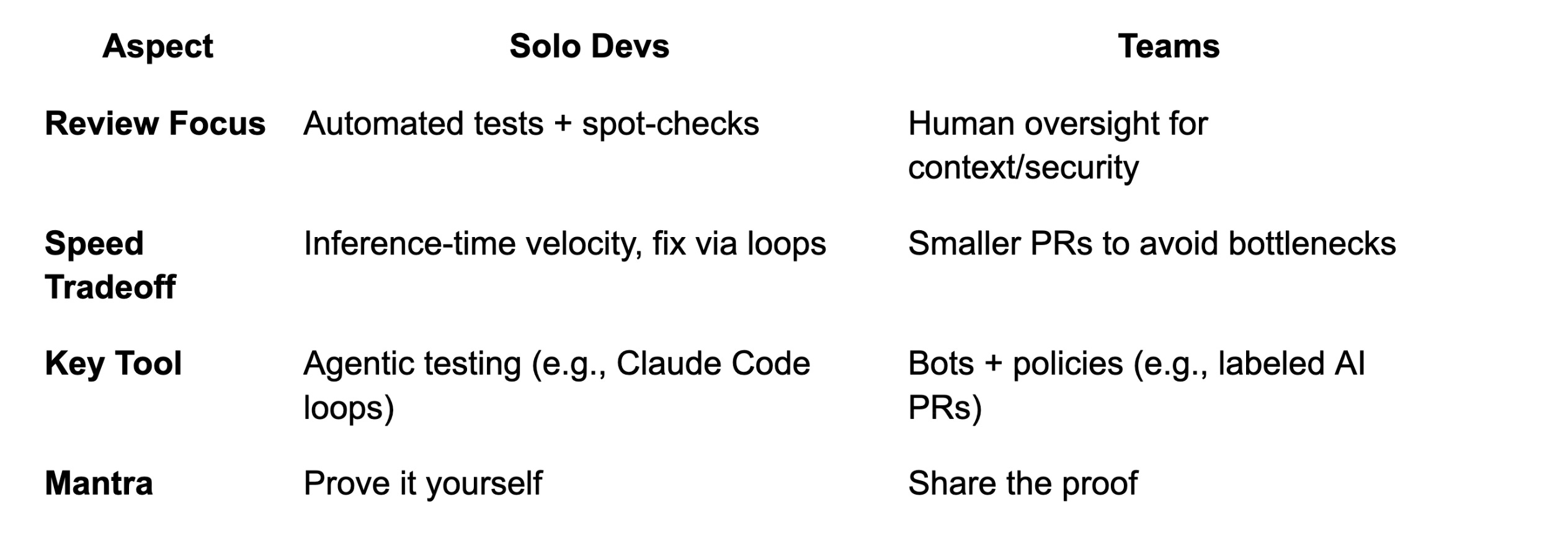

独立开发者 vs. 团队:快速对比

独立开发者:以“推理速度”发布

独立开发者越来越“信任感觉”来接受AI生成的代码——通过仅审查关键部分并依赖测试来发现问题,从而快速发布功能。

这种工作流将编码助手视为强大的实习生,可以独立处理大规模重构。正如Peter Steinberger承认的:“我不再阅读太多代码。我观察代码流,有时查看关键部分,但大多数代码我不读。”瓶颈变成了推理时间——等待AI生成输出——而不是打字。

但有一个陷阱:如果没有强大的测试实践,感知到的速度提升就会消失。 先建立这些实践。如果你跳过审查,你并没有消除工作——你只是推迟了它。那些在高速度下成功使用AI的开发者,并不是盲目信任AI的人;而是那些建立了验证系统,在问题进入生产环境之前就能捕获问题的人。

这并不是说独立开发者会完全不顾风险。负责任的开发者会广泛使用自动化测试作为安全网——追求高覆盖率(通常>70%),并使用AI生成实时捕获错误的测试。现代编码助手在设计复杂的端到端测试方面出人意料地出色。

对于独立开发者来说,改变游戏规则的是语言无关、数据驱动的测试。 如果测试全面,它们可以让助手用任何语言构建(或修复)实现,并在过程中进行验证。我通常从AI草拟的spec.md开始项目,批准它,然后循环:编写→测试→修复。

关键的是,独立开发者仍然会对最终产品进行手动测试和批判性思考。运行应用程序,点击UI,自己使用功能。当涉及更高风险时,阅读更多代码并添加额外检查。尽管快速推进,但看到丑陋的代码时要修复它,而不是让混乱累积。

即使在这种前沿的范式中:你的工作是交付你已证明有效的代码。

团队:AI转移了审查瓶颈

在团队环境中,AI是代码审查的强大助手,但无法取代质量、安全性和可维护性所需的人类判断。

当多名工程师协作时,错误的成本和代码的长期性成为更重要的关注点。团队已开始使用基于AI的审查机器人对PR进行初步检查,但仍需要人工签字批准。正如Graphite的Greg Foster所说:“我从不认为[AI代理]会成为实际工程师签署拉取请求的替代品。”

最大的实际问题不是AI审查器会遗漏风格问题,而是AI增加了代码量并将负担转移给了人类。 PR变得更大(随着AI采用率增加,新增代码量增加约18%),每个PR的事件数增加约24%,变更失败率增加约30%。当输出增长速度快于验证能力时,审查就成为速率限制器。正如Foster指出的:“如果我们发布的代码从未被其他人类真正阅读或理解,我们就是在冒巨大的风险。”

在团队中,AI会带来大量代码,因此要强制实施增量开发:将AI输出分解为易于消化的提交。人工签字不会消失——它正在演变为专注于AI遗漏的内容,比如路线图对齐和AI无法掌握的制度背景。

安全:AI的可预测弱点

一个绝对需要人工监督的领域是安全。 大约45%的AI生成代码包含安全漏洞。逻辑错误出现的频率是人类编写代码的1.75倍,XSS漏洞出现的频率高出2.74倍。

除了代码问题,代理工具和AI集成IDE还创造了新的攻击路径——提示注入、数据泄露,甚至RCE漏洞。AI扩大了攻击面,因此混合方法更有效:AI标记,人类验证。

规则:如果代码涉及身份验证、支付、密钥或不受信任的输入,将AI视为高速实习生,并要求在合并前进行人工威胁模型审查和安全工具检查。

审查作为知识传递

代码审查也是团队共享系统上下文的方式。如果AI编写了代码而没有人能解释它,待命工作就会变得昂贵。

当开发者提交他们不完全理解的AI生成代码时,他们破坏了使团队具有弹性的知识传递机制。如果原作者无法解释代码为何有效,待命工程师如何在凌晨2点调试它?

OCaml维护者拒绝一个13,000行AI生成的PR就凸显了这个问题。代码不一定糟糕,但没有人有精力审查如此巨大的变更,而且审查AI生成的代码比审查人类代码“更费力”。教训是:AI可以让你淹没在代码中,但团队必须管理数量以避免审查瓶颈。

让AI审查工具发挥作用

用户对AI审查工具的体验褒贬不一。积极的一面是,团队报告在某些情况下捕获了95%以上的错误——空指针异常、缺失的测试覆盖率、反模式。消极的一面是,一些开发者认为AI审查评论是“文本噪音”——没有增加任何价值的通用观察。

教训:AI审查工具需要深思熟虑的配置。 调整敏感度级别,禁用无帮助的评论类型,并建立明确的加入/退出策略。如果配置得当,AI审查器可以捕获70-80%的低悬果实,让人类专注于架构和业务逻辑。

许多团队鼓励更小、可堆叠的拉取请求,即使AI可以一次性完成巨大变更。尽早并频繁提交——将每个自包含的变更视为具有清晰消息的独立提交/PR。

重要的是,团队保持严格的人工问责制。 无论AI贡献了多少,人类必须承担责任。正如IBM的一句老培训格言所说:“计算机永远无法被问责。这是你作为人类在循环中的工作。”

PR契约:作者对审查者的责任

无论是独立开发者还是团队,新兴的最佳实践是将AI生成的代码视为有用的草稿,必须进行验证。

最成功的团队已经形成了一个简单的框架:

PR契约

- 内容/原因:用1-2句话说明意图。

- 证明有效:通过的测试、手动步骤(截图/日志)。

- 风险+AI角色:风险等级以及哪些部分是AI生成的(例如,高风险=支付)。

- 审查重点:需要人工输入的1-2个领域(例如,架构)。

这不是官僚主义——这是对审查者时间的尊重,也是强制作者问责的手段。如果你无法填写这些内容,说明你对自己的变更理解不够深入,无法要求他人批准。

核心原则

坚持证据,而非承诺。 让“有效代码”成为基线。提示AI代理在生成后执行代码或运行单元测试。要求证据:日志、截图、结果。没有新测试或变更工作演示的PR不得提交。

将AI用作初步审查者,而非最终裁决者。 将AI审查输出视为建议性意见——一个AI编写代码,另一个审查,人类协调修复的对话。将AI审查视为拼写检查,而非编辑。

专注于AI遗漏的内容进行人工审查。 变更是否引入了安全漏洞?是否重复了现有代码(AI的常见缺陷)?方法是否可维护?AI处理简单问题;人类处理难题。

强制执行增量开发。 将工作分解为小块——AI更容易生成,人类也更容易审查。具有清晰消息的小提交可作为检查点。绝不提交你无法解释的代码。

保持高测试标准。 那些从编码助手中获益最多的人拥有强大的测试实践。要求AI草拟测试——它擅长生成你可能想不到的边缘情况测试。

展望未来:瓶颈已经转移

AI正在将代码审查从逐行把关转变为更高级别的质量控制——但人类判断仍然是安全关键组件。

我们看到的是工作流的演变,而非消除。代码审查现在涉及审查AI与作者之间的对话或计划,与代码差异本身同样重要。人类审查者的角色变得更像编辑或架构师:专注于重要内容,并信任自动化处理日常检查。

对于独立开发者来说,前方的道路令人兴奋——新工具将进一步简化开发。即便如此,明智的开发者也会“信任但要验证”。

在大型团队中,预计将越来越重视AI治理。公司将正式制定关于AI贡献的政策,要求员工签署确认代码已审查。像“AI代码审计员”这样的角色将会出现。企业平台将演进以提供更好的多仓库上下文和自定义策略执行。

无论技术如何进步,核心原则仍然不变:代码审查确保软件满足需求、安全、健壮且可维护。AI没有改变这些基本原则——它只是改变了我们实现目标的方式。

瓶颈从编写代码转移到了证明代码有效。在AI时代,最好的代码审查者将拥抱这一转变——让AI加速机械性工作,同时坚守问责制。他们将让AI加速过程,绝不放弃责任。正如工程师们正在学习的,编码是关于“证据胜过感觉”。

代码审查并未消亡,而是变得更加战略性。无论你是在凌晨2点部署的独立黑客,还是签署关键系统变更的团队领导,一个真理始终成立:人类最终对AI交付的内容负责。

拥抱AI,但永远不要忘记双重检查工作。

AI拉呱,🤖 大厂 P8级别 资深算法研究员 / 某双一流硕导🎖️ 政府领军创新人才 | 资深 AI 实战家

专注于 AI 前沿技术洞察与技术脉络梳理。主张“从算法深度到应用价值”的闭环思考。在这里,分享硬核干货与 AI 效率工具。💡 关注我一起交流,在 AI 浪潮中迭代成长💡 。

AI拉呱介绍:连接前沿算法与商业落地的深度桥梁。

我们立足于全球 AI 技术爆发的最前沿,不仅致力于深度拆解 AI 技术底层脉络,更专注于将复杂的算法演进转化为可落地的商业决策参考。

- 前沿洞察: 追踪生成式 AI、大模型架构及多模态技术的最新动态,提供极具深度的行业分析。

- 咨询服务: 依托大厂资深实战背景,为企业与个人提供定制化的 AI 转型方案与项目技术指导。

- 效能革命: 严选全球尖端 AI 效率工具,助力用户实现从“体力劳动”到“智能创作”的范式迁移。

AI拉呱,让技术不再悬浮,让创新触手可及。

更多推荐

已为社区贡献26条内容

已为社区贡献26条内容

所有评论(0)