AI学习笔记整理(52)——大模型之Agent 智能体

Agent是人工智能领域中的一个概念,指的是具有自主性、反应性、主动性和社交能力等特性的计算实体。这种ai能够使用传感器感知周围环境,做出决策,然后使用执行器采取行动。大模型在AI Agent相关研究中得到了快速发展,它被视为通往AGI(Artificial General Intelligence,通用人工智能,是人工智能领域的终极目标,指具备与人类相当甚至超越人类的综合认知能力,能自主适应复杂

什么是智能体Agent

Agent是人工智能领域中的一个概念,指的是具有自主性、反应性、主动性和社交能力等特性的计算实体。这种ai能够使用传感器感知周围环境,做出决策,然后使用执行器采取行动。大模型在AI Agent相关研究中得到了快速发展,它被视为通往AGI(Artificial General Intelligence,通用人工智能,是人工智能领域的终极目标,指具备与人类相当甚至超越人类的综合认知能力,能自主适应复杂动态环境、跨领域解决问题的智能系统,核心是 “通用性” 与 “自主性”,堪称智能领域的 “全才”。)的主要探索路线。

大模型大家都知道,比如我们常见的 ChatGPT、DeepSeek 等,但是,这些大模型都有一个关键的问题,那就是他们没办法用工具,比如我想要让大模型帮我查询一个接口,他是做不到的。

Agent是具备感知、决策与行动能力的智能体,通过大模型(LLM)结合记忆(Memory)和工具(Tools)调用,实现自主规划与执行任务,如小爱同学自动点餐。其核心为:LLM + Memory + Tools + Planning。Agent 翻译成中文是智能体,或者叫做助理更合适,比如说这就是个 Agent:你对你的小爱同学说,我想吃肯德基,他就能分析出你可能想吃什么,然后让你确认后,直接就帮你把肯德基点好了。

这个过程需要:

1、小爱同学知道你想吃什么,了解你的口味。

2、小爱同学知道点餐需要打开先软件,然后搜索,然后付款

3、小爱同学可以帮你自动完成这些操作

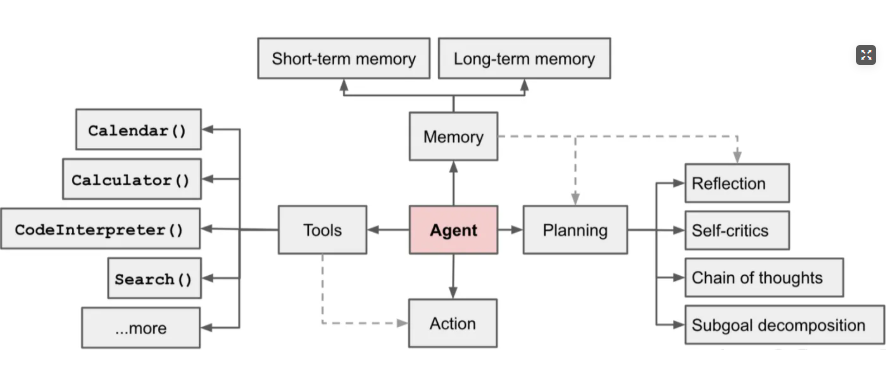

该怎么实现这样的功能呢?下面这张图就是非常出名的 Agent 的图:

可以看到,这里面包括了 Tools、Action、Planning 以及 Memory,Tools 就是我们前面说过的工具,而 Action 就可以理解为是对工具的调用。

剩下的 Memory 这个好理解,就是需要有记忆的能力,包括了长期记忆和短期记忆,短期记忆可以理解为上下文记忆,就像你打开一个 ChatGPT 的对话窗口,这个就是个短期记忆,换个窗口记忆就清除了。长期记忆一般是通过一些其他的方式,比如数据库做存储,在每次对话前先让模型读取这些信息,作为长期记忆。

还有一个 Plan 的功能,这其实是在 Agent 有了记忆,会了工具之后,还需要他知道什么时候该调用哪些工具,这就是所谓的规则的能力。

那么总结下,Agent=LLM+Memory+Tools+ Planning(使用 + 规划)

基于以上介绍,差不多就能总结出一个 Agent 具备的能力。主要包括了:

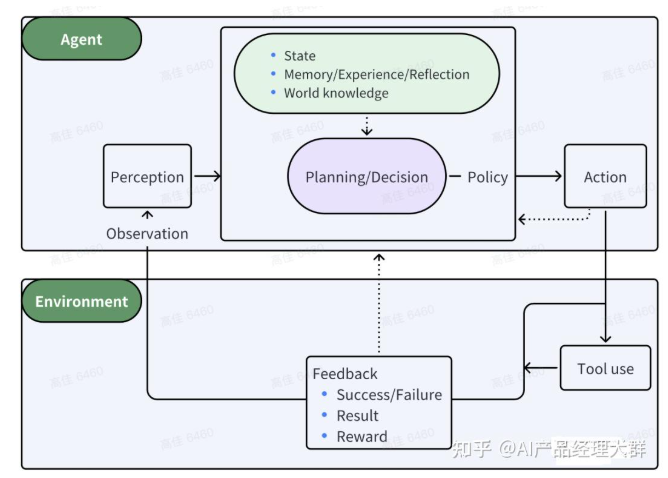

• 感知(Perception):Agent 能够接收来自环境的输入信息,包括用户输入的问题,以及 Memory。

• 决策(Decision-making):Agent 根据感知到的信息和内部状态,选择合适(Planning)的行动(包括 Tools)。

• 行动(Action):指Agent基于环境和规划做出的动作,以实现特定目标。

Agent并非ChatGPT升级版,它不仅告诉你“如何做”,更会帮你去做。如果CoPilot是副驾驶,那么Agent就是主驾驶。

AI小镇开源,含25个Agent,构建"西部世界"AI Town,模拟文明演进。OpenAI创始人Karpathy称AI Agent将颠覆未来。Agent源自拉丁语,意为“行动”,在LLM中指自主执行复杂任务的程序。

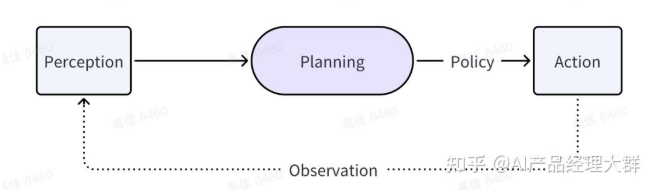

一个精简的Agent决策流程,用函数表达式:

Agent:P(感知)—> P(规划)—>A(行动)类似人类「做事情」的过程,Agent的核心功能,可以归纳为三个步骤的循环:感知(Perception)、规划(Planning)和行动(Action)。

感知(Perception)是指Agent从环境中收集信息并从中提取相关知识的能力,规划(Planning)是指Agent为了某一目标而作出的决策过程,行动(Action)是指基于环境和规划做出的动作。其中,Policy是Agent做出Action的核心决策,而行动又通过观察(Observation)成为进一步Perception的前提和基础,形成自主地闭环学习过程。

一个完整的Agent,一定是与环境充分交互的,它包括两部分——一是Agent的部分,二是环境的部分。此刻的Agent就如同物理世界中的「人类」,物理世界就是人类的「外部环境」。

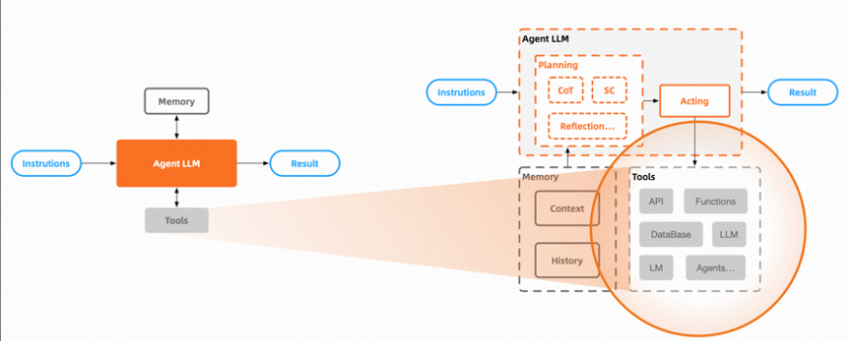

对于业界,新的共识正在逐渐形成:第一是Agent需要调用外部工具,第二是调用工具的方式就是输出代码——由LLM大脑输出一种可执行的代码,像是一个语义分析器,由它理解每句话的含义,然后将其转换成一种机器指令,再去调用外部的工具来执行或生成答案。

什么是Planning,Action, Tools

Planning

参考链接:https://zhuanlan.zhihu.com/p/718959013

Agent Planning是Agent能力的核心,一个好的规划决定了Agent能否顺利执行以及解决问题。规划能够将大型任务分解为较小、可管理的子目标,以便高效的处理复杂任务;Agent可以对过去的行为进行自我批评和反省,从错误中吸取经验教训,并为接下来的行动进行分析、总结和提炼,这种反思和细化可以帮助Agent提高资深的智能和适应性,从而提高最终结果的质量。

- 任务分解:把大任务划分成小任务,进而解决复杂问题;

- 反思和提炼:基于已有动作做自我批评和自我反思,从错误中学习优化接下来的动作。

任务分解的典型实现方案是 CoT(Chain of thought)和 ToT(Tree of thoughts)。

一项复杂任务包括多个子步骤,智能体需要提前将任务分解,并进行规划。

规划模块分类

- 无反馈规划:大语言模型在做推理的过程中无需外界环境的反馈。这类规划进一步细分为三种类型:

- 单路推理,仅一次大语言模型调用就输出完整的推理步骤;

- 多路推理,借鉴众包思想,让大语言模型生成多个推理路径,进而确定最佳路径;

- 借用外部的规划器。

- 有反馈规划:外界环境提供反馈,而大语言模型需要基于环境的反馈进行下一步以及后续的规划。这类规划反馈的提供者来自三个方面:环境反馈、人类反馈和模型反馈

Action

Action模块是AI Agent架构中的核心组件之一。它的主要职责是将智能体的规划和决策转化为具体的操作,以实现预定的目标。这一过程类似于人类将大脑中的想法付诸实践,通过肢体动作与外界交互。

Action模块的核心要素

- 行动目标:指导智能体要达成的结果,例如完成特定任务、进行交流或探索环境。

- 行动生成:根据当前状态和目标,生成具体的行动计划。

- 行动空间:智能体可执行的所有可能动作的集合。

- 行动影响:评估所采取行动对环境和智能体自身的影响,以便进行反馈和调整。

Action模块的功能

在AI Agent的运行过程中,Action模块承担以下关键功能:

- 任务分解:将复杂任务分解为一系列可执行的子任务。

- 执行动作:根据规划模块的指令,执行具体的操作,如调用外部API、控制机器人执行物理动作等。

- 反馈循环:监测行动结果,并根据反馈调整后续行动策略。

Tools

Tools是一组工具集或者Agent可以利用的所有外部资源。这是Agent可调用、可执行的能力,它既可以是一个函数、API,还可以是其它任何大模型,包括另一个Agent应用等等。

Agent 的主要类型

-

规则式Agent:基于预设规则决策,逻辑透明、稳定性高,适合场景固定的任务。例如,快递分拣Agent根据“地址关键词-区域”规则将包裹分配至对应货架,无学习能力,规则需人工维护。

-

反应式Agent:仅根据当前环境状态响应,不存储历史信息,结构简单。例如,恒温Agent仅监测当前温度,低于阈值则启动加热,高于阈值则关闭。

-

目标驱动型Agent:结合当前状态与目标计算最优动作,引入“目标函数”指导决策。例如,导航Agent根据“当前位置-目的地-路况”计算最短路线。

-

学习型Agent:基于机器学习/深度学习模型,通过历史数据或实时反馈优化策略,适合动态复杂场景。例如,推荐Agent通过用户点击、购买数据不断优化推荐内容,是当前AI领域的核心应用类型。

-

多Agent系统(MAS):多个独立Agent通过通信协议协作,分工处理子任务,实现“1+1>2”的效果。例如,智慧城市中,交通Agent、能源Agent、安防Agent协同保障城市运行。

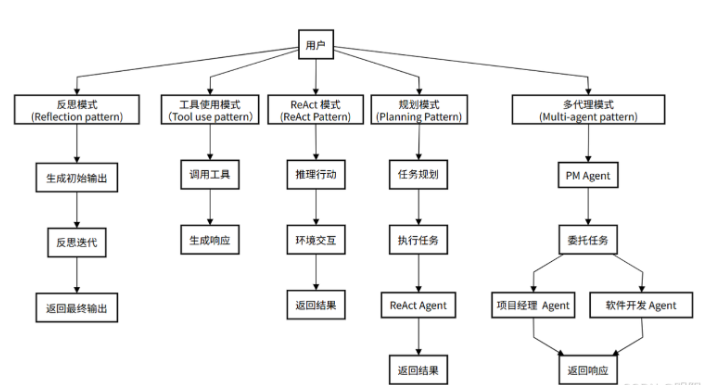

Agent五种模式

参考链接:https://blog.csdn.net/qq_45735139/article/details/156370112

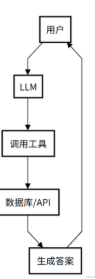

(一)工具使用模式(Tool use pattern)

核心精髓: 工具使用模式可以看作是 ReAct 模式的前身或简化版。它允许 Agent 调用外部工具来弥补自身知识的不足,但通常缺乏 ReAct 模式中那种细致入微的“思考-行动-观察”循环。它的局限在于其推理能力较弱,通常只适用于单步、直接的任务,缺乏动态调整和迭代的能力。

工作流程(像请教专家):

- 用户问问题:提出一个问题。

- LLM 想想:小助手判断需要外援。

- 调用工具:它找来数据库或 API 查资料。

- 给出答案:根据查到的东西,生成回复。

- 交给你:答案回到你手里。

应用场景示例:

智能客服:一个客服 Agent 接到“查询我的订单状态”的请求。它不会胡乱猜测,而是思考需要查询订单信息,然后行动调用 query_order_status(order_id) 这个工具(API),最后根据返回的结果回答用户。

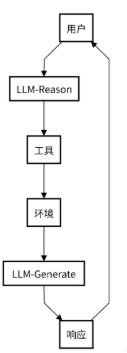

(二)ReAct模式(ReAct Pattern)

几乎所有高级的 Agent 模式都离不开一个核心思想——ReAct (Reason + Act)。这是 Agent 实现“思考”与“行动”循环的基础。

核心精髓: ReAct(Reasoning and Acting)模式是Agentic思想的 奠基性贡献 。它将“思考”(Reasoning)和 “行动”(Acting)紧密地结合在一起,形成一个动态的循环。这个模式让Agent不再是简单地调用工具,而是像人类一样“边想边做”。 ReAct 模式最早由 Yao 等人于 2022 年提出(论文《ReAct: Synergizing Reasoning and Acting in Language Models》),并在 Lilian Weng 的博客中得到系统阐述,成为Agentic系统设计的基础。

工作流程:

- 思考: Agent接收用户请求,推理任务需求并制定初步行动计划。

- 行动: 根据思考结果,决定并执行具体行动(如调用工具)。

- 行动输入: 为选定的工具提供必要参数。

- 观察: 接收工具执行结果,作为对环境的“观察”。

- 循环迭代: 将观察结果反馈给自己,再次思考并决定下一步,直到达到目标。

应用场景示例:

研究助理agent:任务是“查找关于‘大型语言模型在教育领域的应用’的最新研究论文”。

- Thought: 我需要去学术搜索引擎搜索相关论文。

- Action: search_arxiv(“large language models in education”)

- Observation: (返回了10篇论文的标题和摘要)

- Thought: 结果太多了,我需要筛选出最近一年且被引用次数最多的论文。

- Action: filter_papers(results, min_year=2023, sort_by=“citations”)

- Observation: (返回了3篇最相关的论文)

- Thought: 我已经找到了最相关的论文,现在可以总结并回答用户了。

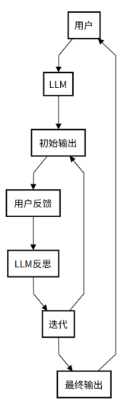

(三)反思模式(Reflection pattern)

为了提高任务完成的质量,Agent 在完成一个步骤或整个任务后,会进行 自我评估和反思 ,并根据反思结果进行修正。

核心精髓: 反思模式是 ReAct 模式中“思考”环节的深化。它强调 Agent 在完成任务后,能够像人类一样进行自我审查和评估。这个过程让 Agent 能够从错误中学习,持续优化自己的表现。

工作流程:

- 用户问问题:你给小助手提个问题。

- LLM 给出初稿:小助手先试着回答,写个初步答案。

- 用户反馈:用户查看答案行不行,提出意见。

- LLM 自己反思:小助手想想哪里不对,改改答案。

- 反复调整:可能来回改几次,直到你满意。

- 交给你:最终答案交到你手里。

应用场景示例:

AI代码生成器:任务是“写一个 Python 函数来计算斐波那契数列”。

- Action: Agent 快速生成了一个使用递归实现的函数。

- Reflection (Self-Critique): Agent 开始反思生成的代码。“这个递归实现在计算较大数值时,会因为重复计算而导致性能低下。我应该优化它。”

- Action (Refinement): Agent 重新编写代码,使用了带缓存(memoization)的动态规划方法,大大提高了效率,然后将优化后的代码作为最终答案。

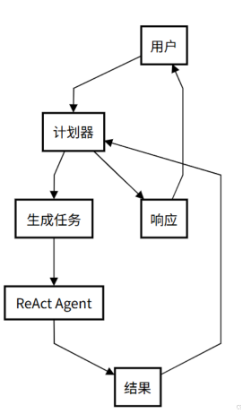

(四)规划模式(Planning Pattern)

当任务非常复杂,无法通过简单的 ReAct 循环一步到位时,Agent 需要先进行 宏观规划 。

**核心思想:**先将一个大目标分解成一个详细的、有序的计划(Plan),然后再逐一执行计划中的每个步骤(每个步骤可能是一个 ReAct 循环)。

应用场景示例:

AI旅行规划师:任务是“帮我规划一个为期五天的巴黎家庭亲子游”。

- Planning Phase: Agent 首先生成一个计划:

步骤一:确定旅行日期和预算。

步骤二:根据亲子游的特点,搜索并筛选合适的景点(如迪士尼、卢浮宫儿童区)。

步骤三:规划每日行程,确保节奏轻松,并预订门票。

步骤四:搜索并推荐适合家庭入住的酒店和餐厅。

步骤五:汇总所有信息,生成一份详细的旅行计划文档。 - Execution Phase: Agent 开始按顺序执行上述步骤,每一步都可能调用搜索、预订等工具。

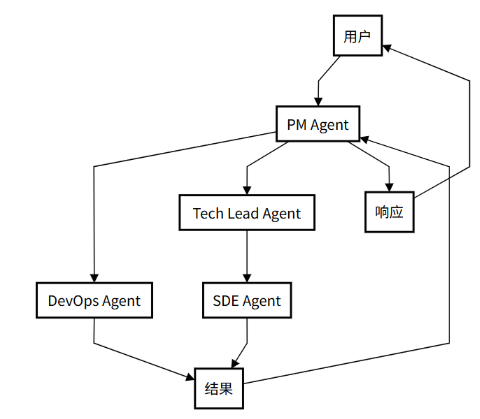

(五)多智能体模式(Multi-agent Pattern)

对于极其复杂的系统性任务,单个 Agent 可能难以胜任。这时,可以设计多个具有不同角色和能力的 Agent,让它们协同工作。

核心精髓: 多智能体模式是Agentic思想的 终极体现 ,它模拟了人类团队协作的工作方式。它不再依赖一个Agent单打独斗,而是创建多个具有不同专长的Agent,让它们各司其职、相互协作,共同完成一个复杂的任务。尽管多智能体模式功能强大,但实现时需要解决Agent间的通信效率、任务冲突等问题,这对系统设计提出了更高要求。

应用场景示例:

软件开发过程:

- 用户问问题:用户提个大需求(比如开发一个软件项目)。

- PM Agent:项目经理 Agent 分析需求并分配任务(协调整个团队)。

- 委托任务:任务交给 DevOps 和 Tech Lead(DevOps 负责运维,Tech Lead 负责技术领导)。

- 执行任务:DevOps(处理部署和测试) 和 SDE(编写代码)干活(具体实施任务)。

- 结果汇总:大家干完后,把结果汇报给 PM Agent(统一收集反馈)。

- 交给你:PM Agent 整合所有结果,给用户最终答案(交付完成的项目)。

这个流程通过多个智能体协作,模拟真实团队工作,确保复杂任务高效完成。

更多推荐

已为社区贡献41条内容

已为社区贡献41条内容

所有评论(0)