《CPU 是法拉利,GPU 是火车?AI 算力的终极比喻来了》

摘要:本文用"超级厨房"比喻解析AI硬件分工:CPU是统筹主厨,GPU是并行切菜团,显存则是关键灶台案板。以7B大模型为例,显存容量决定能否运行(门槛),GPU核心数影响速度(TFLOPS),CPU处理数据供给(防短板),而显存带宽(如HBM)对大规模训练尤为关键。完整流程展示了数据从CPU预处理到GPU计算的流转过程,指出硬件配置需平衡各环节,避免因显存不足或CPU瓶颈导致G

引言:

“你是不是也遇到过这种情况:兴冲冲下载了 7B 大模型,一运行就报‘显存不足’;花大价钱买了 RTX 4090,训练速度却还是慢得像蜗牛?

别再只盯着‘多少 G 显存’看了,AI 硬件的底层逻辑,其实就像一个‘超级厨房’:CPU 是统筹全局的行政主厨,GPU 是千人切菜团,而显存就是那个决定你能不能放下一口大锅的灶台案板。

今天我就用这个比喻,带你彻底搞懂 CPU、GPU、显存到底怎么分工,用真实的数值算清楚 7B 模型推理和训练到底要多少显存,再告诉你为什么说‘显存带宽比核心数更重要’。看完这篇,下次配硬件、训模型再也不会踩坑。”

1. 逻辑上的理解:超级厨房类比

为了直观理解,我们将训练/推理一个 AI 模型的过程比作**“在一个高压厨房里做一道极其复杂的满汉全席”**。

| 硬件组件 | 角色类比 | 逻辑功能 |

| CPU | 行政主厨 (Chef) | 统筹与调度。它很聪明,擅长处理复杂的逻辑(如看菜谱、指挥流程、洗菜切菜的预处理),但它只有几只手(核心少),没法同时切一万个土豆。 |

| GPU | 千人切菜团 (Workers) | 并行计算。它由成千上万个“头脑简单但手速极快”的小工组成(CUDA Cores)。主厨一声令下“切土豆”,几千人同时下刀,瞬间完成大规模重复性工作(矩阵运算)。 |

| 显存 (VRAM) | 灶台案板 (Countertop) | 高速缓存区。这是最关键的瓶颈。切菜团(GPU)手速太快,必须把立刻要用的食材(模型权重、输入数据)放在手边的案板上。如果案板太小,放不下大锅(大模型),那就完全没法做菜。 |

| 内存 (RAM) | 仓库/冷库 (Pantry) | 数据中转站。存放从硬盘取出的所有原始食材。由于案板(显存)空间昂贵且有限,我们通常把大量数据先堆在仓库(内存),然后分批次送到案板上。 |

| PCIe 通道 | 传菜走廊 | 传输通道。连接仓库(内存)和案板(显存)的通道。如果走廊太窄(带宽低),切菜团就会没事干等着食材送过来(GPU 利用率低)。 |

2. 原理上的理解:为什么是 GPU 而不是 CPU?

深度学习的本质是矩阵乘法 (Matrix Multiplication)。

-

CPU (MIMD/SISD): 设计初衷是为了处理复杂的逻辑分支(If-Else)、操作系统调度。它的核心(Core)强大但数量少,为了降低延迟(Latency)而设计。

-

GPU (SIMD - Single Instruction, Multiple Data): 单指令多数据流。深度学习计算中,我们在做的事情通常是:对一百万个数字同时乘以 2。GPU 不需要复杂的逻辑,只需要几千个核心同时做这一个动作。

一句话总结原理: CPU 是法拉利(跑得快但只能拉几个人),GPU 是一列长长的火车(单次拉货量巨大)。

3. 数值计算举例:显存 (VRAM) 到底怎么算?

这是理解硬件关联最“硬核”的部分。显存大小决定了生死的界限(OOM - Out of Memory)。

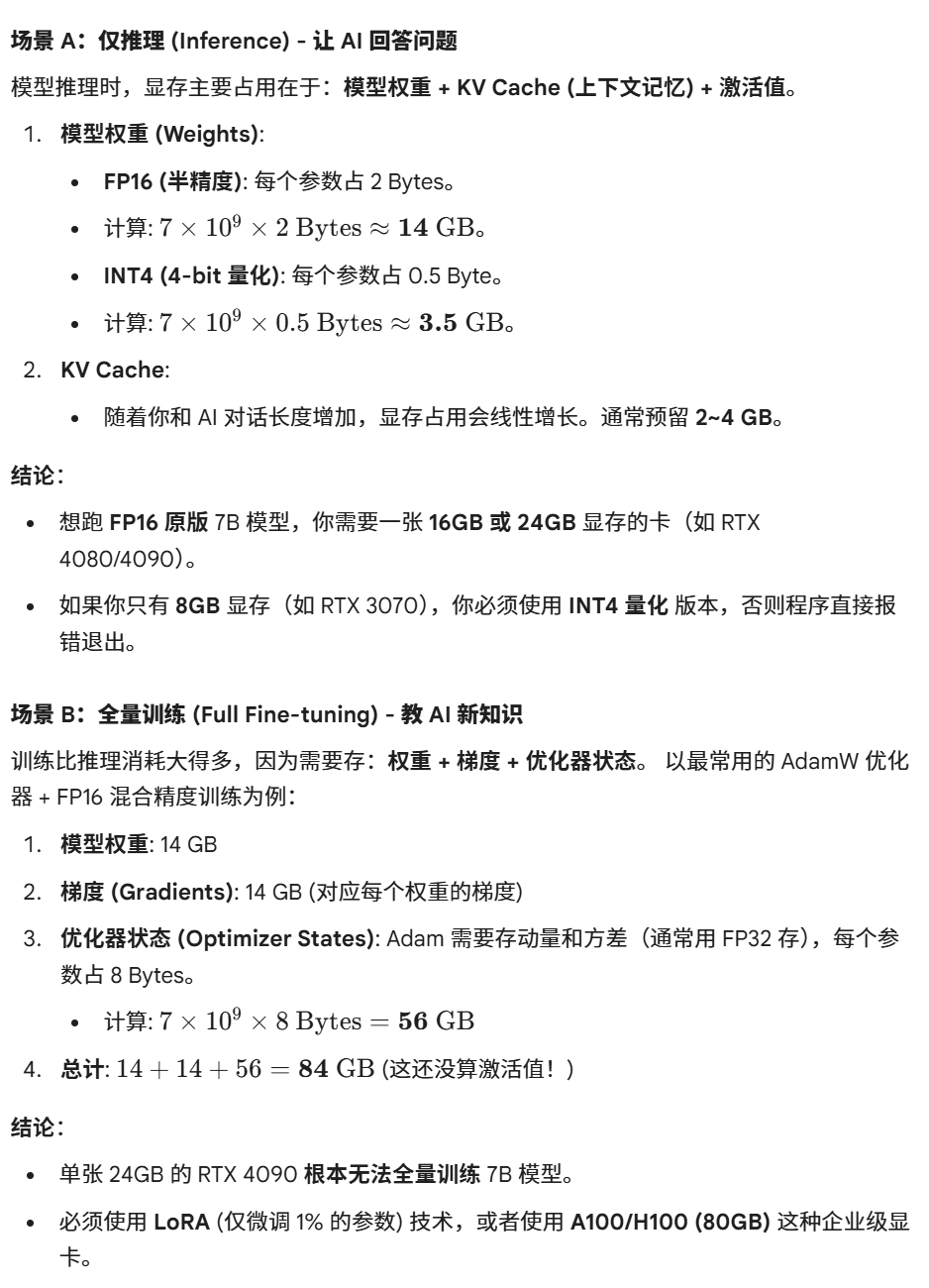

假设我们要运行一个 7B (70 亿参数) 的大语言模型(如 Llama 3 8B 或 Qwen 7B)。

4. 流程定位:数据在各步骤的流转

整个深度学习流程就是数据在这些硬件之间的“接力跑”。

Step 1: 预处理 (CPU + 内存)

-

动作: Python 代码读取硬盘上的图片或文本,解码,进行 Resize、归一化等操作。

-

位置: CPU 计算,数据存放在 内存 (RAM)。

-

瓶颈: 如果 CPU 太弱(核数少),或者硬盘读取慢,GPU 就会闲置等待数据(GPU 利用率 0%)。

Step 2: 搬运 (PCIe 总线)

-

动作: 将处理好的一批数据 (Batch) 从内存拷贝到显存。

-

位置: PCIe 通道。

-

代码体现:

data.to('cuda')。

Step 3: 前向/反向传播 (GPU + 显存)

-

动作:

-

GPU 核心从 显存 读取权重和数据。

-

GPU 核心进行矩阵运算。

-

将计算结果(Feature Map / Loss)写回 显存。

-

-

位置: GPU 核心 与 显存 之间的高频交互。

-

瓶颈: 显存带宽 (Memory Bandwidth)。如果显存读写速度跟不上计算速度,GPU 核心就会空转。这也就是为什么高端卡(H100)用 HBM 显存而不用普通 DDR 显存的原因。

5. 总结与意义

| 步骤/组件 | 核心意义 | 一句话判断标准 |

| 显存 (VRAM) | 决定“能不能跑” | 容量是门槛。显存不够,模型直接加载失败,一切免谈。 |

| GPU 核心 | 决定“跑得快不快” | 时间就是金钱。CUDA 核心越多,TFLOPS 越高,训练模型从 10 天缩短到 1 天。 |

| CPU | 决定“有没有短板” | 喂料员。如果你用最强的 GPU 配了一个十年前的 CPU,数据处理不过来,GPU 只能干瞪眼(木桶效应)。 |

| 显存带宽 | 决定“高速性能” | 吞吐量。大模型训练中,带宽往往比核心算力更重要。 |

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)