注意力机制--大模型输入的上下文

摘要:注意力机制是大模型处理上下文的核心,其本质是让模型智能地选择性地关注历史信息。2026年主流大模型采用多种注意力策略,如标准全注意力、窗口滑动、稀疏注意力等,各有优缺点。当前商用模型的上下文能力分级显示,从4k到10M+不等,Gemini、Claude、GPT等在不同场景下表现各异。关键挑战在于如何在更长距离上精准回忆重要信息。

·

注意力机制 —— 大模型输入上下文的“真正核心”

在2025~2026年的大语言模型里,几乎所有最强的模型,其性能差距的核心其实已经不是Transformer架构本身,而是“它如何使用注意力机制来处理上下文”。

下面用最直白的方式,把注意力机制在“上下文处理”这件事上真正扮演的角色讲清楚:

1. 注意力机制最本质的作用(一句话版)

让模型在处理当前token时,能“智能地、有选择地、按重要程度”去看之前所有出现过的token,而不是平均看待或按固定窗口看。

用更形象的比喻:

想象你在开一个超长的线上会议,已经讲了3个小时,现在轮到你总结发言:

- 你不可能把前面3小时每句话都平等对待

- 你会重点回忆:开头定调的部分、刚才激烈争论的点、老板刚才强调的三句话、数据最关键的那几处…

- 而其他很多废话、重复的内容,你几乎自动忽略了

注意力机制就是在模仿这个“人类开会时的大脑注意力分配”。

2. 当前主流大模型处理超长上下文的几种注意力策略对比(2026主流)

| 策略名称 | 上下文长度能力(常见商用) | 计算复杂度 | 记忆质量 | 代表模型(2025-2026) | 主要优点 | 主要缺点/代价 |

|---|---|---|---|---|---|---|

| 标准全注意力 | 8k32k | O(n²) | ★★★★★ | 早期GPT-3、LLaMA1/2早期 | 理论上最强记忆 | 长度一长就爆炸 |

| 窗口+滑动(Sliding Window) | 32k~128k | O(n·w) | ★★★☆ | Mistral 7B、Phi-3-medium | 性价比高 | 远距离信息严重衰减 |

| 稀疏注意力(Sparse) | 64k~256k | O(n·log n)~O(n√n) | ★★★★ | Longformer、BigBird、Reformer | 较好的长距离捕捉 | 实现复杂、有些位置信息丢失 |

| 环形/多尺度窗口 | 128k~1M | O(n·w) | ★★★★☆ | Mistral Nemo、Qwen2.5-72B-Instruct | 性价比极高,长文本表现不错 | 仍存在一定距离衰减 |

| 动态稀疏/重要性采样 | 128k~512k | 近似O(n) | ★★★★~★★★★★ | DeepSeek-V3、Grok系列部分版本 | 速度快、性能够用 | 极端长距离偶尔丢关键信息 |

| 状态空间+注意力混合 | 256k~2M+ | O(n) | ★★★★☆~★★★★★ | Mamba-2、Jamba、RWKV-v6、xLSTM | 理论无限长、推理极快 | 目前长文本理解质量仍稍逊纯Transformer |

| 分层/压缩+全注意力 | 1M~10M+(理论无限) | O(n)~O(n log n) | ★★★★~★★★★★ | Gemini 1.5、Claude 3.5/4、GPT-4o-long | 目前商用最长+质量最好组合 | 训练/推理成本高,压缩可能丢信息 |

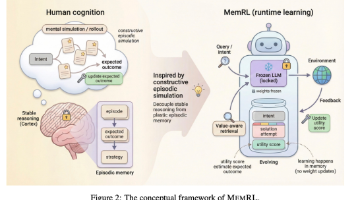

| 外部记忆+检索式 | 理论无限 | 取决于检索 | ★★★~★★★★★ | RWKV + RAG、MemGPT、Infinite-LLM | 可扩展到文档级、知识库级 | 依赖检索质量,上下文连续性较差 |

3. 2026年最现实的“上下文理解能力分级”认知

上下文长度 实际能比较稳定记住的有效信息量(人类类比) 主流商用模型代表(2026年1月)

4k~8k ≈ 大学一篇毕业论文 + 能记住主要论点和数据 GPT-3.5、LLaMA2-7B

32k ≈ 一本薄教材或中篇小说,能记住主要情节+人物关系 GPT-4-32k、Claude 2

128k~200k ≈ 厚一点的专业书籍+几篇论文,能记住章节大纲+关键论证 GPT-4o、Claude 3.5、Gemini 1.5 Flash

500k~1M ≈ 几本书 + 大量代码仓库 + 完整项目文档 Claude 3.7/4、Gemini 2.0、DeepSeek-R1

2M~10M+ ≈ 一个人几年的工作文档/邮件/代码/论文全集 Gemini 1.5 Pro 2M、某些实验10M+模型

4. 简单总结:当前最主流的“上下文处理真相”(2026年1月)

大多数人实际体验到的上下文能力排序(质量×长度综合)大概是:

- Gemini 1.5 / 2.0 系列(超长+质量相对最均衡)

- Claude 3.5 Sonnet → Claude 4(逻辑连贯性极强,但长度稍逊)

- GPT-4o / o1系列(聪明,但长度一般)

- Qwen2.5-Max / DeepSeek-V3 / Grok-3(性价比之王,128k~512k区间很强)

- LLaMA-3.3 / 4系列开源模型(社区优化后中长文本也很不错)

一句话总结2026年的注意力机制现状:

“谁能用更少的计算量,在更长的距离上,更精准地回忆起真正重要的那几个token,谁就暂时领先。”

你现在主要使用的模型是什么?

或者你更关心哪种场景下的上下文表现?(超长文档、代码仓库、角色扮演长对话、多轮复杂推理、RAG增强等)

可以告诉我你的具体使用痛点,我可以更针对性地讲讲当前最有效的应对方案~

更多推荐

已为社区贡献128条内容

已为社区贡献128条内容

所有评论(0)