给ClaudeCode配置“中国芯“,手把手教你切换国产大模型

现在国产大模型也越来越好了,只需简单配置,就能将ClaudeCode底层模型替换为智谱GLM、DeepSeek等国产大模型,实现“中国芯”替代,大幅提升访问速度与稳定性,降低使用费用~

本文将手把手教你如何将ClaudeCode的默认模型切换为国产大模型——智谱GLM、DeepSeek等,实现“中国芯”替代,提升访问速度与稳定性。

为什么要给ClaudeCode换“芯”?

ClaudeCode默认调用的是Anthropic的Claude系列模型,由于网络与政策原因,国内用户在使用时常常会遇到:连接超时、响应慢、API调用不稳定等问题。

实际上ClaudeCode不仅仅可以调用Anthropic的Claude系列模型,我们还可以将ClaudeCode的底层模型替换为智谱GLM系列模型或者DeepSeek模型来完成一些简单的任务。

安装ClaudeCode

ClaudeCode的安装方式与基础配置已在如何在服务器使用ClaudeCode中详细介绍,这里不再赘述。若尚未完成安装,请先参考教程完成环境准备后再继续本篇操作。

接入智谱GLM

智谱(Z.AI)成立于2019年,由清华大学计算机系知识工程实验室(KEG)技术成果转化而来,其推出的GLM系列模型(General Language Model)在多项中文评测中成绩与GPT-4比肩,且全栈自主可控,已经发展成为中国最大的独立大模型厂商。

- 官方接入手册:https://docs.bigmodel.cn/cn/guide/develop/claude

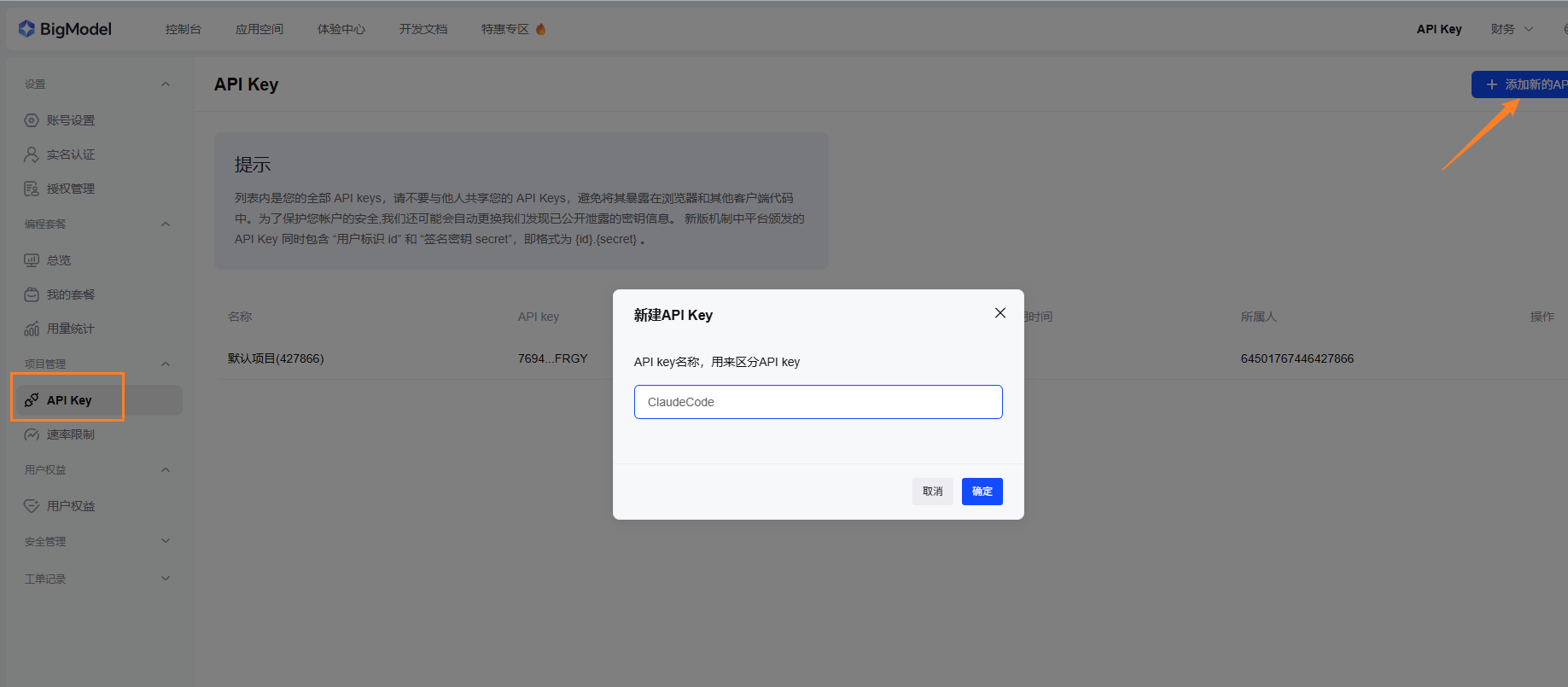

创建API-KEY

- 访问智谱平台,完成注册:https://open.bigmodel.cn/

- 登录后,进入控制台→API Key→点击【添加新的API Key】

配置环境变量

- ClaudeCode通过读取 ~/.claude/settings.json中的env字段注入模型调用所需的所有参数。以下步骤先备份旧配置,再一次性写入四个关键变量;保存后立即生效,无需重启系统。

# 如果之前有ClaudeCode的配置文件,建议复制备份一下

mkdir ccbk

cp ~/.claude/settings.json ccbk/

# 编辑配置文件,配置API KEY

vim ~/.claude/settings.json

# 填入如下内容

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "上一步创建的API KEY",

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1

}

}

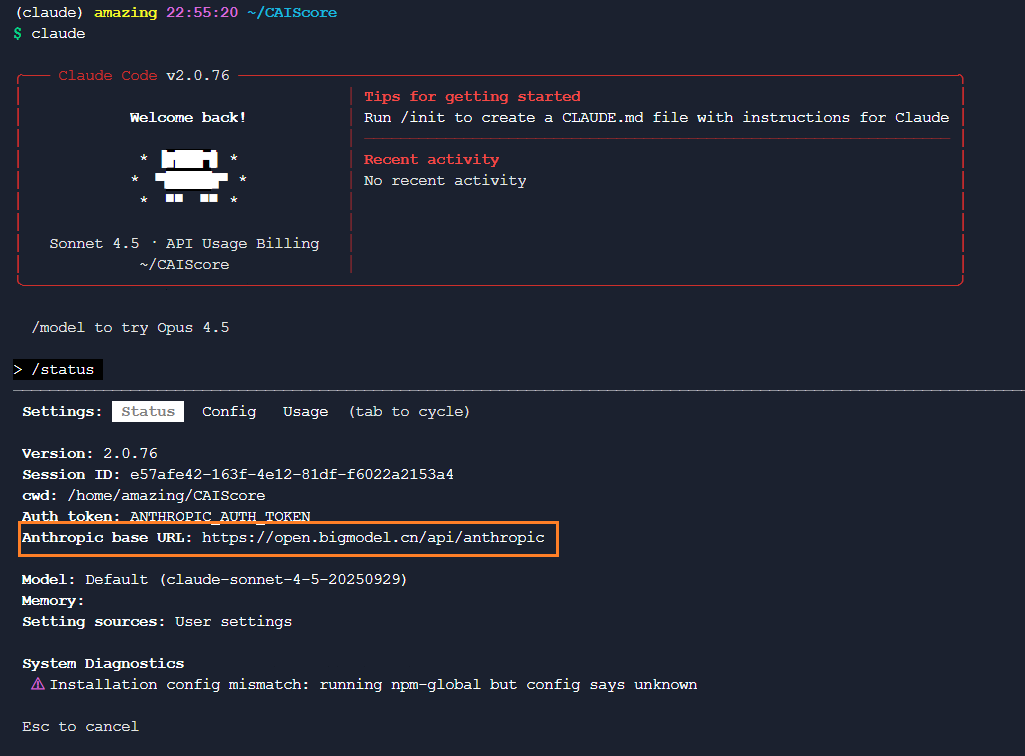

验证测试

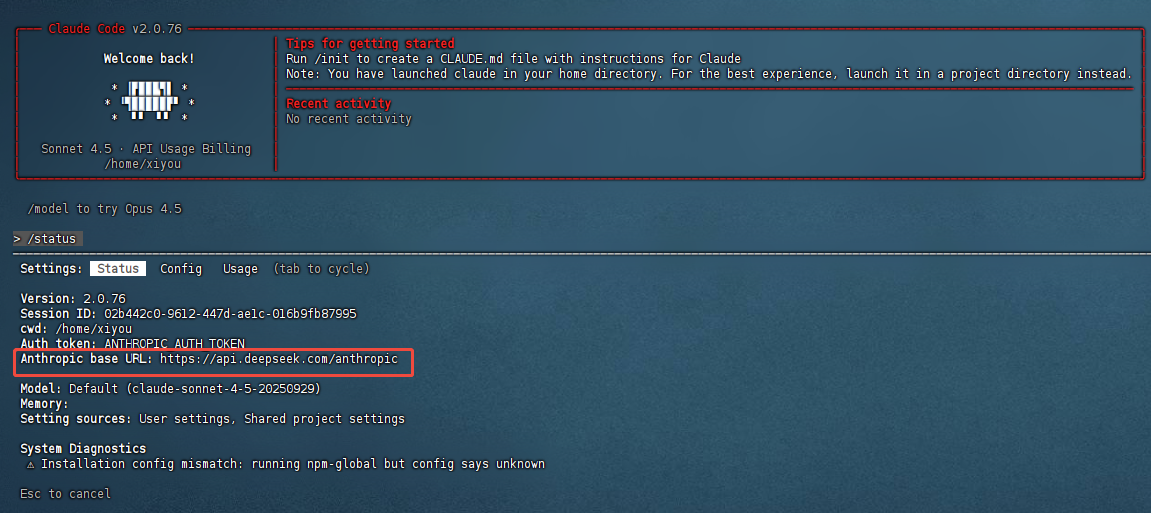

- 进入claude后,输入/status查看状态

接入DeepSeek

DeepSeek由幻方量化旗下深度求索团队开源,提供与OpenAI/Anthropic对齐的Chat&Completion API。其完全兼容Claude协议,仅需替换base_url与token。

- 官方接入手册:https://api-docs.deepseek.com/zh-cn/guides/anthropic_api

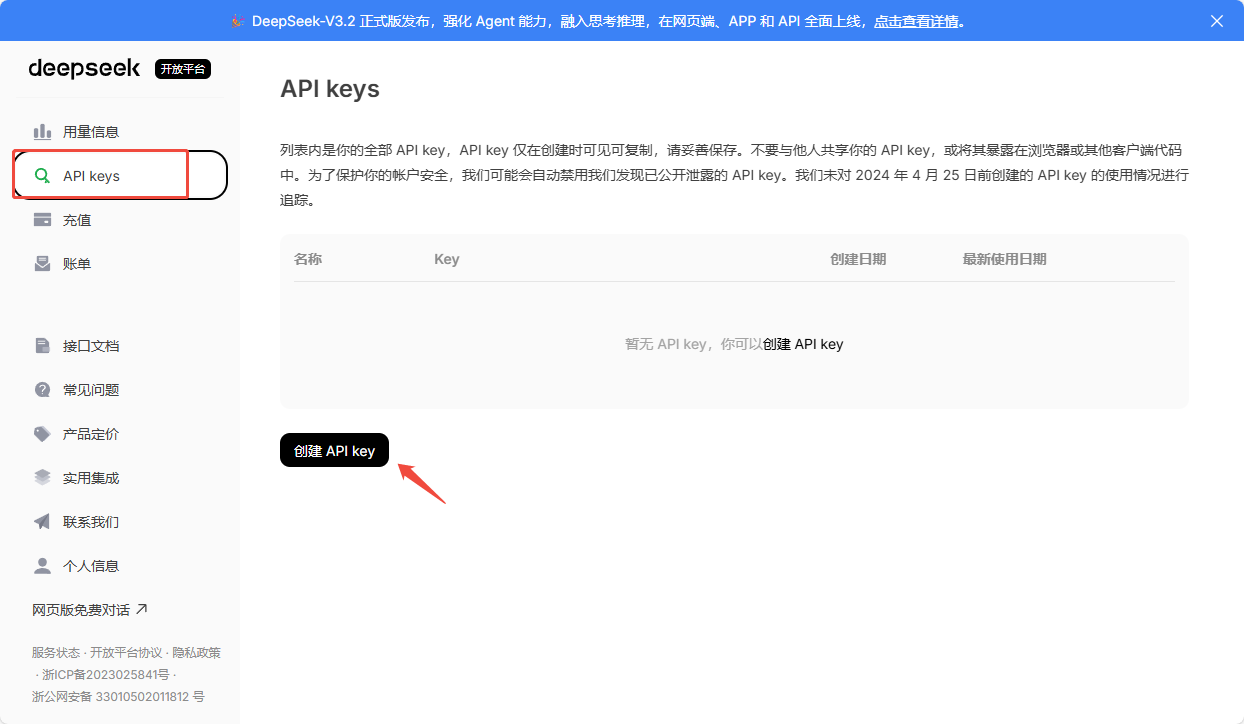

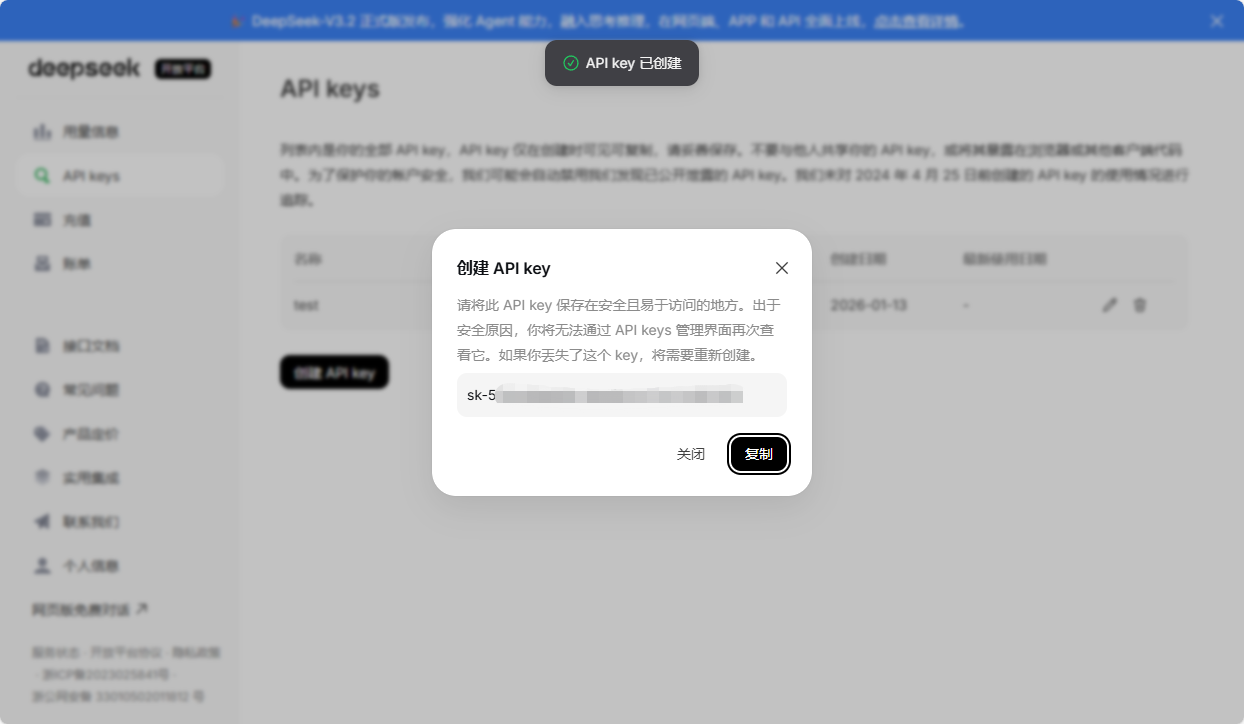

创建API-KEY

- 注册并登录 https://platform.deepseek.com

- 创建API key,创建后会生成一串以 sk- 开头的密钥,妥善保存,后续配置环境变量会用到

配置环境变量

- 和上述智谱GLM篇配置环境变量章节类似,依旧是备份后新建~/.claude/settings.json,添加如下内容:

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "上一步创建的API KEY",

"ANTHROPIC_BASE_URL": "https://api.deepseek.com/anthropic",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1

}

}

验证测试

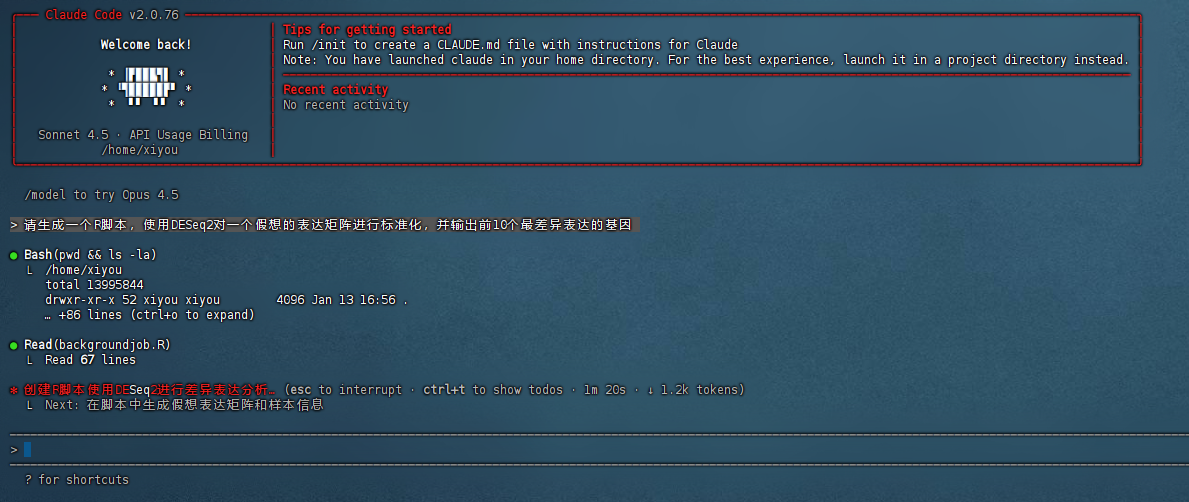

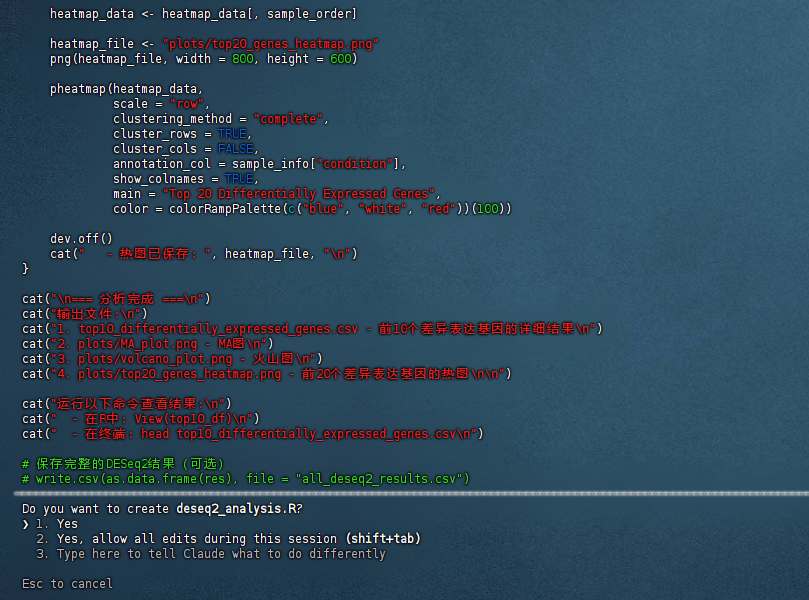

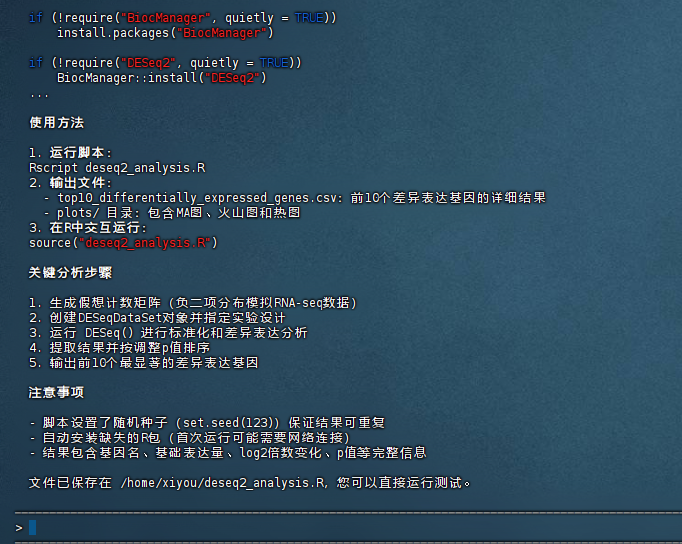

- 使用测试

- 选择Yes后即可保存生成的脚本并运行测试

结语

完成上述配置后,ClaudeCode将通过智谱GLM或DeepSeek提供持续、低延迟的模型服务。如遇接口变更,请同步更新配置文件,后续只需保持配置文件和token有效即可持续使用模型服务。这样我们就能使用实惠的国产大模型啦,也希望国产大模型越来越好!

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)