【未来智能】阿里林俊旸:让 AI 拥有“耳目口”,Qwen-Omni 全模态演进与 VLA 具身智能展望

从像素级精准的图像编辑,到能理解环境的语音交互,再到对具身智能的清晰展望,Qwen 系列的每一步突破,都在打破“AI 局限于数字世界”的边界。林俊旸的分享传递出一个核心信号:AGI 不是“悬浮的大脑”,而是需要“耳目口手”的完整智能体——它将通过多模态能力感知真实世界,通过具身能力改造真实世界,最终成为连接数字技术与物理场景的核心桥梁。当 AI 真正拥有“感知、创造、行动”的能力,人类与智能的交互

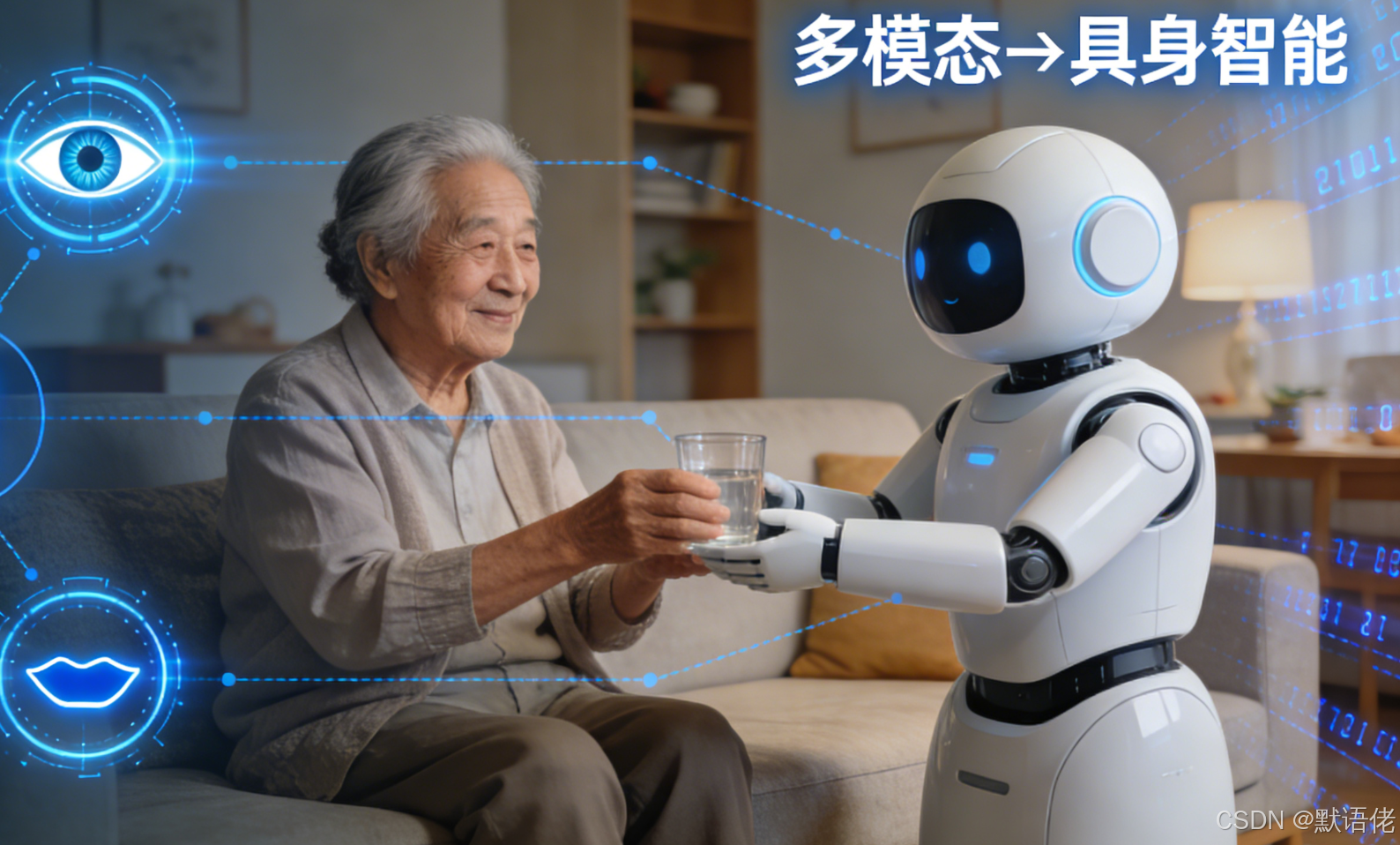

前言:如果说大语言模型(LLM)构建了 AI 的“核心大脑”,多模态技术就是赋予 AI 感知世界的“眼睛”、聆听环境的“耳朵”、表达想法的“嘴巴”,更是其创造价值的“双手”。在 AGI-Next 峰会上,阿里千问负责人林俊旸深度拆解了 Qwen 系列在视觉理解、图像生成与编辑、语音交互三大领域的突破性进展,并明确了“从全模态融合到物理世界交互”的核心路径——最终让 AI 成为能感知、会创造、可行动的具身智能体(VLA)。这不仅是技术迭代的方向,更是 AGI 走向现实的关键一步。

一、 核心追求:构建“Multimodal Foundation Agent”,打破模态割裂

林俊旸开篇点明,阿里千问的技术布局从未局限于“优化单一模型”,而是直指更宏大的目标——构建一个Multimodal Foundation Agent(多模态基础智能体)。其核心逻辑在于:

-

智能的天然属性是多模态:人类对世界的认知从不是“单通道输入”——我们用眼睛看画面、耳朵听声音、嘴巴交流、双手行动,多感官协同才构成完整的智能体验。通用 AI 要真正理解世界,必须具备同样的多模态感知能力。

-

统一的“大脑”是关键:理想的 AGI 不应是“视觉模型+语言模型+语音模型”的简单拼接,而需一个统一的核心框架,实现不同模态信息的“统一理解、统一推理、统一生成”。这意味着文本、图像、音频等信息进入模型后,能被转化为统一的语义表征,再通过同一套逻辑输出结果——这正是 Qwen 系列的核心技术方向。

二、 视觉理解:给 AI 装上“高清眼+空间脑”,突破“降智”与精度难题

要让 AI 融入人类场景,第一步是让它“看懂”——无论是屏幕上的界面、纸上的文字,还是物理世界的空间关系。Qwen 在视觉理解(VL)领域的突破,重点解决了两大行业痛点:

1. 攻克“多模态降智”魔咒

行业普遍存在一个难题:当模型引入视觉模态后,其原本的语言理解、逻辑推理能力会出现明显下滑(即“降智”)。而 Qwen 通过优化模态融合架构,成功实现多模态模型的语言智力与 235B 纯语言模型持平——这意味着 AI 既能“看懂图”,又不会“变笨”,为复杂场景的跨模态推理奠定了基础。

2. 从“能看到”到“看得准、能理解”

Qwen 不仅突破了常规视觉任务的精度限制,更实现了对“极端场景”和“空间逻辑”的精准把控:

-

极限细节识别:攻克褶皱纸张的 OCR 识别(解决图像畸变难题)、微小印章/低分辨率字体识别(逼近人类视觉极限),甚至能精准识别屏幕上的模糊水印、复杂表格中的细小程序文字——这类能力直接适配办公自动化、档案数字化等商业场景。

-

空间与物理常识理解:彻底解决 AI“前后左右不分”的尴尬。例如,模型能准确判断“杯子在桌子上、书本在杯子左边”,甚至能根据图片推断物体的空间尺寸比例(如“这个箱子比椅子高”)——这是 AI 后续实现物理世界交互的核心前提。

三、 图像生成与编辑:从“逼真创作”到“精准协作”,构建“世界模型”

如果说视觉理解是“感知世界”,图像生成与编辑就是“创造世界”。Qwen-Image 系列的迭代,不仅追求“真实感”,更瞄准“实用性”,实现了从“单向生成”到“双向协作”的跨越。

1. 图像生成:向“照片级真实”无限趋近

经过数月密集迭代,Qwen-Image 在内部盲测中稳居前列,真实感提升速度令人惊叹:从 8 月份仍带明显“AI 感”的生成图,到 12 月份已能生成“接近离谱的真实场景”——例如“宿舍女生刚睡醒揉眼睛拍照”的画面,不仅人物神态、皮肤质感自然,连背景中凌乱的书桌、窗帘的光影细节都与真实照片无差。

更关键的是,Qwen 实现了精准文字嵌入能力——不仅能在生成图中嵌入清晰可辨的文字,还能支持“12 格分镜图+每格专属文字注解”的一次性生成,直接适配广告设计、剧本可视化等商业需求。

2. 图像编辑:解决用户最核心的“精准度”痛点

林俊旸特别强调:“用户对图像编辑的核心诉求,从来不是‘不模糊’,而是‘修改后和原图完全契合’”。传统模型在执行“P 掉背景的人”“移动物体位置”等操作时,常出现背景衔接断层、原图元素位移等问题——本质是模型只在“像素层面”操作,没有理解图像中的物理逻辑。

Qwen 2511 版本彻底解决了这一痛点:无论是删除多余元素、移动物体位置,还是替换背景,都能实现“无缝衔接、零位移”。这背后的关键突破是:模型不再是简单的像素拼接,而是开始构建符合物理规律的“世界模型”——它能理解“物体背后的背景应该是什么样”“移动后光影如何变化”,从而让编辑结果更符合真实世界逻辑。

四、 Qwen-Omni:不止“能听会说”,更能“理解环境”

视觉让 AI“看见”,语音则让 AI 实现“自然交流”。Qwen-Omni 作为全栈语音交互方案,打破了“ASR(语音转文字)+TTS(文字转语音)”的传统框架,核心突破在于“环境理解”与“交互自然度”:

-

从“识别语音”到“理解场景”:Qwen-Omni 不仅能精准转写人类对话,还能识别“事件环境音”——例如区分“敲门声+说话声”“下雨声+咳嗽声”,甚至能通过语气、背景音判断用户情绪(如“用户在嘈杂环境中着急提问”),从而调整回应的语速和语气。

-

个性化与稳定性兼得:支持“一句话定制声音”——用户只需描述“温柔的职场女性,带点轻微鼻音”,就能生成专属语音;更关键的是,在实现全栈语音交互的同时,模型语言智力仅轻微下降,基本持平 Qwen-2.5 文本模型水平,避免了“能说却变笨”的问题。

五、 终极方向:全模态融合→Agent→具身智能,AI 走向物理世界

林俊旸明确了 Qwen 系列的下一步演进路径:从“多模态”走向“全模态”,再通过 Agent 架构实现“虚拟世界操作”,最终落地“物理世界具身智能”。

1. 全模态模型:实现“三进三出”的统一

Qwen 的终极目标是实现“文本、视觉、音频”三模态的双向统一——即“输入任意模态(文字/图片/声音),都能输出任意模态(文字/图片/声音)”。例如,输入一段“海浪声+风声”的音频,模型既能生成对应的文字描述,也能绘制出海边场景图;输入一张风景照,既能生成配文,也能合成对应的环境音。

为实现这一目标,Qwen 团队正在测试Linear Context 等新一代架构——核心优势是用更高效的计算方式处理长上下文(如超长视频、万字文档+多图),同时降低算力消耗,为全模态模型的规模化应用奠定基础。

2. Agent 架构:从“被动响应”到“主动行动”

Qwen 正在通过“多轮强化学习+环境反馈”的训练范式,让模型从“被动回答问题”升级为“主动解决问题”:

-

Digital Agent(数字助手):已实现 GUI 自动操作、API 调用等能力——例如用户下达“整理本周销售数据并生成图表”,Agent 能自动打开 Excel、筛选数据、调用绘图工具,最终输出结果,两天内就能完成人类需两个月的重复性工作。

-

具身智能(VLA):这是最终愿景。林俊旸表示,未来的 Qwen 不仅能在虚拟世界操作,更能通过机器人硬件接口,在物理世界中完成具体动作——比如抓取话筒、为客人斟茶倒水、检修设备故障。这需要模型将视觉、语音、动作控制能力深度融合,真正实现“感知-推理-行动”的闭环。

结语:AI 正在成为连接数字与物理世界的“桥梁”

从像素级精准的图像编辑,到能理解环境的语音交互,再到对具身智能的清晰展望,Qwen 系列的每一步突破,都在打破“AI 局限于数字世界”的边界。林俊旸的分享传递出一个核心信号:AGI 不是“悬浮的大脑”,而是需要“耳目口手”的完整智能体——它将通过多模态能力感知真实世界,通过具身能力改造真实世界,最终成为连接数字技术与物理场景的核心桥梁。

当 AI 真正拥有“感知、创造、行动”的能力,人类与智能的交互方式将被彻底重构——这一天,正随着 Qwen 等系列模型的演进,逐步走近。

💬 默语互动:

如果 AI 真的具备“看、听、说、动”的完整能力,你最想让它解决生活/工作中的哪个痛点?是帮你整理杂乱的书房,还是替代人工完成工厂巡检?欢迎在评论区留下你的想象!

更多推荐

已为社区贡献32条内容

已为社区贡献32条内容

所有评论(0)