收藏!传统RAG与Agentic RAG全解析:从原理到代码,小白也能轻松上手大模型检索增强

检索增强生成(RAG, Retrieval-Augmented Generation)的核心价值,在于精准解决大语言模型两大致命痛点——知识过时与幻觉生成。其核心逻辑是将"外部信息检索"与"文本生成"深度绑定,让模型在生成答案前,先从实时/专业知识库中获取权威信息,从而输出更精准、更具时效性的内容。

本文深度拆解传统RAG与Agentic RAG两大主流检索增强生成技术,从架构设计、工作流程到核心特性进行系统化对比,清晰梳理二者的适用边界与技术取舍。传统RAG以轻量化线性架构实现快速响应,低成本适配基础信息查询需求,但在复杂场景下准确性受限;Agentic RAG借助智能代理系统实现多步推理与动态检索,大幅提升答案精准度与可解释性,却伴随更高的计算成本与实现复杂度。文末配套完整可运行代码与针对性选型指南,帮助小白开发者、程序员快速掌握技术核心,结合业务需求、性能指标与成本预算做出最优技术选型。

概述:为什么RAG是大模型落地的核心技术?

检索增强生成(RAG, Retrieval-Augmented Generation)的核心价值,在于精准解决大语言模型两大致命痛点——知识过时与幻觉生成。其核心逻辑是将"外部信息检索"与"文本生成"深度绑定,让模型在生成答案前,先从实时/专业知识库中获取权威信息,从而输出更精准、更具时效性的内容。

随着大模型应用从简单问答走向复杂业务场景(如企业知识库问答、专业领域咨询、多步骤问题求解),RAG技术也完成了关键迭代:从早期"输入-检索-生成"的静态线性模式(传统RAG),演进为具备自主任务分析、策略规划、多轮迭代能力的智能决策模式(Agentic RAG),全方位适配复杂业务的实际需求。

传统RAG与Agentic RAG的核心差异直观展示:

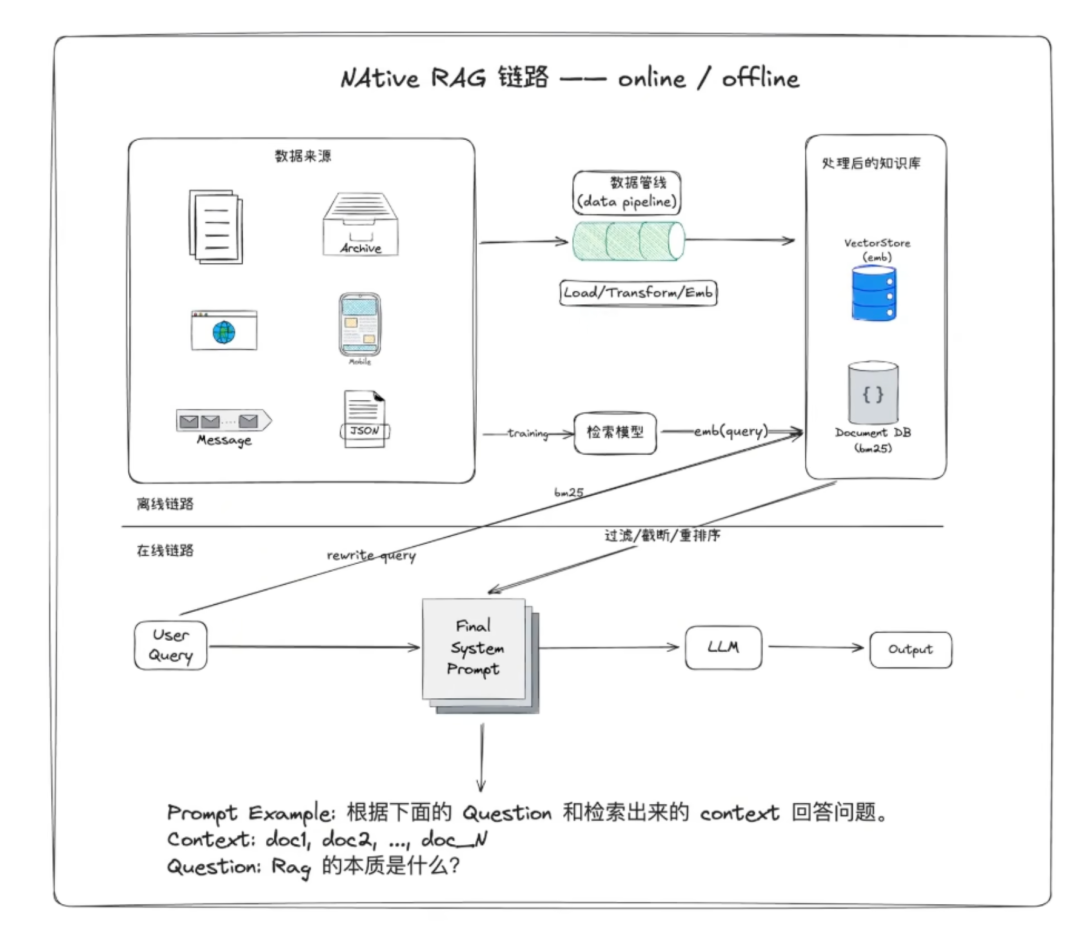

传统RAG的执行逻辑:

传统RAG的执行逻辑

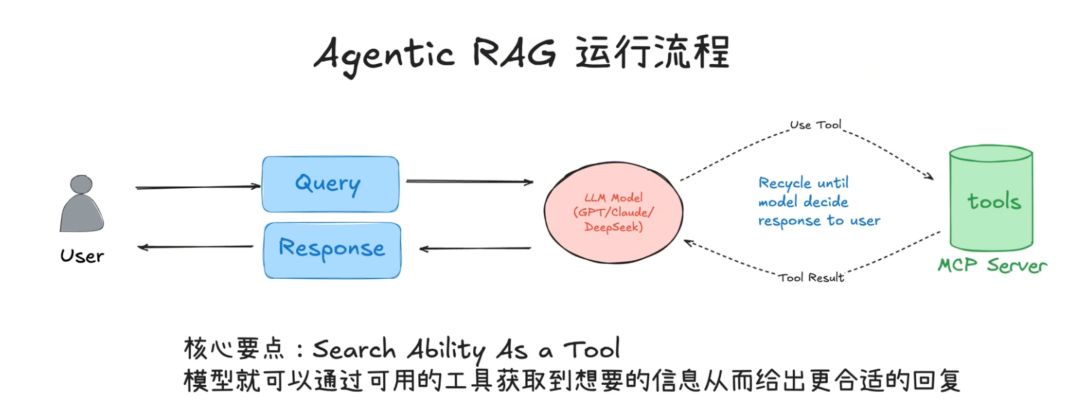

Agentic RAG的执行逻辑

核心区别对比

1. 架构设计

| 维度 | 传统 RAG | Agentic RAG |

|---|---|---|

| 架构复杂度 | 简单线性流水线 | 多层次智能代理系统 |

| 组件构成 | 检索器 + 生成器 | 规划器 + 执行器 + 反思器 + 工具集 |

| 决策机制 | 预定义规则 | 动态推理决策 |

2. 工作流程对比

传统 RAG 流程

用户查询 → 向量检索 → 文档召回 → 上下文注入 → LLM生成 → 返回结果

Agentic RAG 流程

用户查询 → 任务分析 → 制定计划 → 动态工具选择 → 多轮信息收集 → 推理决策 → 答案合成 → 质量评估 → 返回结果

详细技术特性对比

3. 检索策略

传统 RAG

- • 静态检索:固定的相似度阈值和召回数量

- • 单轮检索:一次性获取所有相关文档

- • 被动适应:无法根据查询复杂度调整策略

Agentic RAG

- • 动态检索:根据查询类型智能调整参数

- • 多轮检索:迭代式信息收集

- • 主动适应:实时评估并调整检索策略

4. 推理能力

传统 RAG

- • 直接映射:检索到什么就基于什么回答

- • 缺乏验证:无法验证信息一致性

- • 单一视角:基于有限上下文生成答案

Agentic RAG

- • 多步推理:能够进行复杂的逻辑推导

- • 信息验证:交叉验证多个信息源

- • 多角度分析:综合多个视角形成答案

代码实现示例

传统 RAG 实现

from langchain.vectorstores import FAISSfrom langchain.embeddings import OpenAIEmbeddingsfrom langchain.llms import OpenAIfrom langchain.chains import RetrievalQAfrom langchain.document_loaders import TextLoaderfrom langchain.text_splitter import CharacterTextSplitterclass TraditionalRAG: def __init__(self, documents_path): self.embeddings = OpenAIEmbeddings() self.llm = OpenAI(temperature=0) self.setup_vectorstore(documents_path) self.setup_qa_chain() def setup_vectorstore(self, documents_path): # 加载文档 loader = TextLoader(documents_path) documents = loader.load() # 文档分割 text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=0) texts = text_splitter.split_documents(documents) # 创建向量库 self.vectorstore = FAISS.from_documents(texts, self.embeddings) def setup_qa_chain(self): # 创建检索器(固定参数) retriever = self.vectorstore.as_retriever( search_kwargs={"k": 5} # 固定检索5个文档 ) # 创建QA链 self.qa_chain = RetrievalQA.from_chain_type( llm=self.llm, chain_type="stuff", retriever=retriever, return_source_documents=True ) def query(self, question): """简单的单轮查询""" result = self.qa_chain({"query": question}) return { "answer": result["result"], "sources": result["source_documents"] }# 使用示例traditional_rag = TraditionalRAG("documents.txt")response = traditional_rag.query("什么是机器学习?")print(response["answer"])### Agentic RAG 实现import jsonfrom typing import List, Dict, Anyfrom langchain.agents import Tool, AgentExecutor, create_openai_functions_agentfrom langchain.memory import ConversationBufferMemoryfrom langchain.schema import BaseRetrieverfrom langchain.llms import OpenAIfrom langchain.prompts import ChatPromptTemplateimport loggingclass AgenticRAG: def __init__(self, vectorstores: Dict[str, Any]): self.llm = OpenAI(temperature=0.1) self.vectorstores = vectorstores self.memory = ConversationBufferMemory( memory_key="chat_history", return_messages=True ) self.setup_tools() self.setup_agent() def setup_tools(self): """设置智能工具集""" self.tools = [ Tool( name="precise_search", description="用于精确搜索特定技术概念和定义", func=self._precise_search ), Tool( name="broad_search", description="用于广泛搜索相关背景信息", func=self._broad_search ), Tool( name="cross_reference", description="交叉验证多个信息源的一致性", func=self._cross_reference ), Tool( name="summarize_findings", description="总结和整合搜索结果", func=self._summarize_findings ), Tool( name="fact_check", description="验证信息的准确性", func=self._fact_check ) ] def _precise_search(self, query: str) -> str: """精确搜索""" try: # 动态调整检索参数 if len(query) < 20: # 短查询用更高精度 k = 3 score_threshold = 0.8 else: # 长查询用更多候选 k = 7 score_threshold = 0.7 retriever = self.vectorstores["technical"].as_retriever( search_type="similarity_score_threshold", search_kwargs={ "k": k, "score_threshold": score_threshold } ) docs = retriever.get_relevant_documents(query) return self._format_search_results(docs, "精确搜索") except Exception as e: return f"精确搜索失败: {str(e)}" def _broad_search(self, query: str) -> str: """广泛搜索""" try: retriever = self.vectorstores["general"].as_retriever( search_kwargs={"k": 10} # 获取更多相关文档 ) docs = retriever.get_relevant_documents(query) return self._format_search_results(docs, "广泛搜索") except Exception as e: return f"广泛搜索失败: {str(e)}" def _cross_reference(self, topic: str) -> str: """交叉验证信息""" results = [] for store_name, store in self.vectorstores.items(): try: retriever = store.as_retriever(search_kwargs={"k": 3}) docs = retriever.get_relevant_documents(topic) results.append({ "source": store_name, "content": [doc.page_content[:200] for doc in docs] }) except Exception as e: logging.error(f"交叉验证失败 {store_name}: {e}") return json.dumps(results, ensure_ascii=False, indent=2) def _summarize_findings(self, findings: str) -> str: """整合搜索结果""" prompt = f""" 请整合以下搜索结果,提供一个连贯的总结: {findings} 要求: 1. 去除重复信息 2. 突出关键要点 3. 保持逻辑连贯性 4. 标注不确定的信息 """ try: response = self.llm(prompt) return response except Exception as e: return f"总结失败: {str(e)}" def _fact_check(self, statement: str) -> str: """事实验证""" # 简化的事实检查逻辑 verification_sources = [] for store_name, store in self.vectorstores.items(): try: retriever = store.as_retriever(search_kwargs={"k": 5}) docs = retriever.get_relevant_documents(statement) # 检查文档中是否有支持或反驳的证据 for doc in docs: if any(keyword in doc.page_content.lower() for keyword in statement.lower().split()): verification_sources.append({ "source": store_name, "evidence": doc.page_content[:300], "relevance": "支持" if statement.lower() in doc.page_content.lower() else "相关" }) except Exception as e: logging.error(f"事实检查失败 {store_name}: {e}") return json.dumps(verification_sources, ensure_ascii=False, indent=2) def _format_search_results(self, docs: List, search_type: str) -> str: """格式化搜索结果""" if not docs: return f"{search_type}未找到相关文档" results = [] for i, doc in enumerate(docs): results.append({ "rank": i + 1, "content": doc.page_content[:500], "metadata": getattr(doc, 'metadata', {}) }) return json.dumps({ "search_type": search_type, "total_results": len(results), "documents": results }, ensure_ascii=False, indent=2) def setup_agent(self): """设置智能代理""" # 定义代理的系统提示 system_prompt = """ 你是一个智能的RAG代理,具备以下能力: 1. **任务分析**: 分析用户查询的复杂度和类型 2. **策略规划**: 根据查询特点制定最优的信息检索策略 3. **工具使用**: 灵活选择和组合使用各种搜索工具 4. **质量控制**: 验证信息准确性并评估答案完整性 5. **迭代优化**: 根据中间结果动态调整策略 工作流程: 1. 首先分析查询类型(事实性、概念性、比较性等) 2. 选择合适的搜索策略(精确/广泛/交叉验证) 3. 执行搜索并评估结果质量 4. 如果需要,进行补充搜索或验证 5. 整合所有信息形成最终答案 6. 进行质量检查和准确性验证 请始终保持客观、准确、有条理的回答风格。 """ prompt = ChatPromptTemplate.from_messages([ ("system", system_prompt), ("user", "{input}"), ("assistant", "我来帮你分析这个问题并制定搜索策略。"), ("human", "{agent_scratchpad}") ]) # 创建代理 agent = create_openai_functions_agent( llm=self.llm, tools=self.tools, prompt=prompt ) self.agent_executor = AgentExecutor( agent=agent, tools=self.tools, memory=self.memory, verbose=True, max_iterations=5, # 限制最大迭代次数 handle_parsing_errors=True ) def query(self, question: str) -> Dict[str, Any]: """智能查询处理""" try: # 执行智能代理 result = self.agent_executor.invoke({"input": question}) return { "answer": result["output"], "reasoning_steps": self._extract_reasoning_steps(), "sources_used": self._extract_sources(), "confidence_score": self._calculate_confidence() } except Exception as e: logging.error(f"查询处理失败: {e}") return { "answer": "抱歉,处理您的查询时出现了错误。", "error": str(e) } def _extract_reasoning_steps(self) -> List[str]: """提取推理步骤""" # 从内存中提取推理过程 messages = self.memory.chat_memory.messages steps = [] for msg in messages[-10:]: # 获取最近的消息 if hasattr(msg, 'content') and 'Tool' in str(msg.content): steps.append(str(msg.content)[:200]) return steps def _extract_sources(self) -> List[str]: """提取信息源""" # 简化实现:从工具调用中提取源信息 return ["技术文档库", "通用知识库", "交叉验证结果"] def _calculate_confidence(self) -> float: """计算答案可信度""" # 简化的可信度计算 base_confidence = 0.7 # 根据使用的工具数量调整 tools_used = len(self._extract_reasoning_steps()) confidence_bonus = min(tools_used * 0.1, 0.3) return min(base_confidence + confidence_bonus, 1.0)# 使用示例def create_agentic_rag_system(): # 假设已经有多个向量库 vectorstores = { "technical": technical_vectorstore, # 技术文档向量库 "general": general_vectorstore, # 通用知识向量库 "specialized": specialized_vectorstore # 专业领域向量库 } agentic_rag = AgenticRAG(vectorstores) # 复杂查询示例 complex_query = """ 请详细解释机器学习中的过拟合问题,包括: 1. 产生原因 2. 识别方法 3. 解决策略 4. 与深度学习的关系 """ result = agentic_rag.query(complex_query) print("=== Agentic RAG 回答 ===") print(f"答案: {result['answer']}") print(f"\n推理步骤: {result['reasoning_steps']}") print(f"信息源: {result['sources_used']}") print(f"可信度: {result['confidence_score']:.2f}")# 运行示例# create_agentic_rag_system()

性能与适用性对比

5. 性能特征

| 指标 | 传统 RAG | Agentic RAG |

|---|---|---|

| 响应速度 | 快(单轮检索) | 较慢(多轮推理) |

| 准确性 | 中等 | 高(多重验证) |

| 成本 | 低 | 高(多次API调用) |

| 可解释性 | 低 | 高(推理过程透明) |

6. 适用场景

传统 RAG 适用于:

- • ✅ 简单的事实查询

- • ✅ 对响应速度要求高的场景

- • ✅ 成本敏感的应用

- • ✅ 文档内容相对静态

Agentic RAG 适用于:

- • ✅ 复杂的多步推理问题

- • ✅ 需要高准确性的关键应用

- • ✅ 要求可解释性的专业领域

- • ✅ 动态、多样化的知识源

总结

Agentic RAG代表了RAG技术的重要进步,通过引入智能代理的概念,大大提升了系统的推理能力和灵活性。虽然在计算成本和复杂性方面有所增加,但在准确性、可解释性和处理复杂查询方面具有显著优势。

关键优势:

-

- 智能决策:能够根据查询类型动态选择最优策略

-

- 多步推理:支持复杂的逻辑推导和信息整合

-

- 质量保证:通过多重验证确保答案准确性

-

- 透明可解释:提供完整的推理过程和决策依据

技术选择建议:

- • 简单应用 → 传统 RAG:成本低、速度快

- • 专业应用 → Agentic RAG:准确性高、可解释性强

- • 混合场景 → 分层架构:根据查询复杂度动态选择

选择哪种方案需要根据具体的业务需求、性能要求和成本预算来决定。对于大多数简单应用,传统RAG已经足够;而对于需要高质量、可信赖答案的专业应用,Agentic RAG则是更好的选择。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

为什么要学习大模型?

我国在A大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着AI技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国AI产业的创新步伐。加强人才培养,优化教育体系,国际合作并进是破解困局、推动AI发展的关键。

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

更多推荐

已为社区贡献272条内容

已为社区贡献272条内容

所有评论(0)