ComfyUI 零基础保姆级教程:如何将二次元人物风格转化为写实人物风格

摘要:ComfyUI是一款开源节点式AI工作流工具,通过模块化设计实现StableDiffusion等模型的可视化操作。文章以"漫画转真人"为例,解析三大核心组件:K采样器(图像生成引擎)、VAE编解码(数据转换桥梁)和提示词系统(创作指令)。详细拆解8个关键节点的连接逻辑,包括模型加载、提示词设置、图像处理流程等,并重点讲解采样步数、CFG值等参数的优化技巧。该工具支持拖拽式

一、介绍

ComfyUI是一款免费开源的节点式AI工作流引擎,专注于Stable Diffusion等扩散模型的可视化操作。该工具将模型加载、提示词配置、采样计算和ControlNet调用等功能模块化为独立节点,用户通过简单的拖拽连线即可构建个性化生成流程,无需编程基础即可实现高度自由的参数精细调节。系统支持Python自定义节点开发、第三方插件扩展及多模型兼容,提供工作流保存复用功能,并支持本地化部署与API对接。凭借出色的资源优化和扩展灵活性,ComfyUI已成为AI绘画创作、创意内容生成及技术流程可视化领域的专业解决方案。

本文章旨在通过“接水管”式的逻辑拆解,帮小白读者彻底搞懂 ComfyUI 节点布局,实现从漫画角色到写实照片的一键高质量转化。

二、 核心概念讲解:像生活一样理解 AI

在动手连接你的第一个工作流之前,我们先通过三个生活化的类比,搞定 ComfyUI 的“三大支柱”。

1. K 采样器 (KSampler) —— “追求细节的雕刻师”

-

生活化类比: 想象一位雕刻师面对一整块粗糙的原始大理石(噪点),根据你的描述,一刀一刀地剔除多余的石屑,最终露出藏在里面的精美雕像 。

-

一句话定义: 它是 AI 绘画的核心引擎,负责通过多次迭代(Steps)将杂乱的随机噪点转化为清晰的图像 。

-

在工作流中的作用: 控制生成图片的画质、创意程度以及最终形态,是你所有参数调整的主战场。

2. VAE 编码/解码 —— “跨次元的翻译官”

-

生活化类比: 就像将一本厚重的纸质书压缩成一个极小的电子文档方便携带(编码),等到要看时再解压恢复成精美的排版(解码)。

-

一句话定义: 负责在“人类看得懂的像素图片”与“AI 看得懂的潜空间数据”之间进行转换的桥梁。

-

在工作流中的作用: 确保你能把自己的照片“喂”给 AI,并让 AI 把画好的结果“翻译”回你能保存的图片文件 。

3. 正反向提示词 (Prompts) —— “导演的拍摄指令”

-

生活化类比: 就像在咖啡店下单,“我要一杯拿铁,加冰、加全脂奶(正向)”,同时强调“不要糖、不要奶泡(反向)”。

-

一句话定义: 通过文字描述告诉 AI 画面中必须有什么以及绝对不能出现什么 6。

-

在工作流中的作用: 决定了角色的发色、服装、背景质感,以及排除掉“多出的手指”或“模糊的阴影”等瑕疵 。

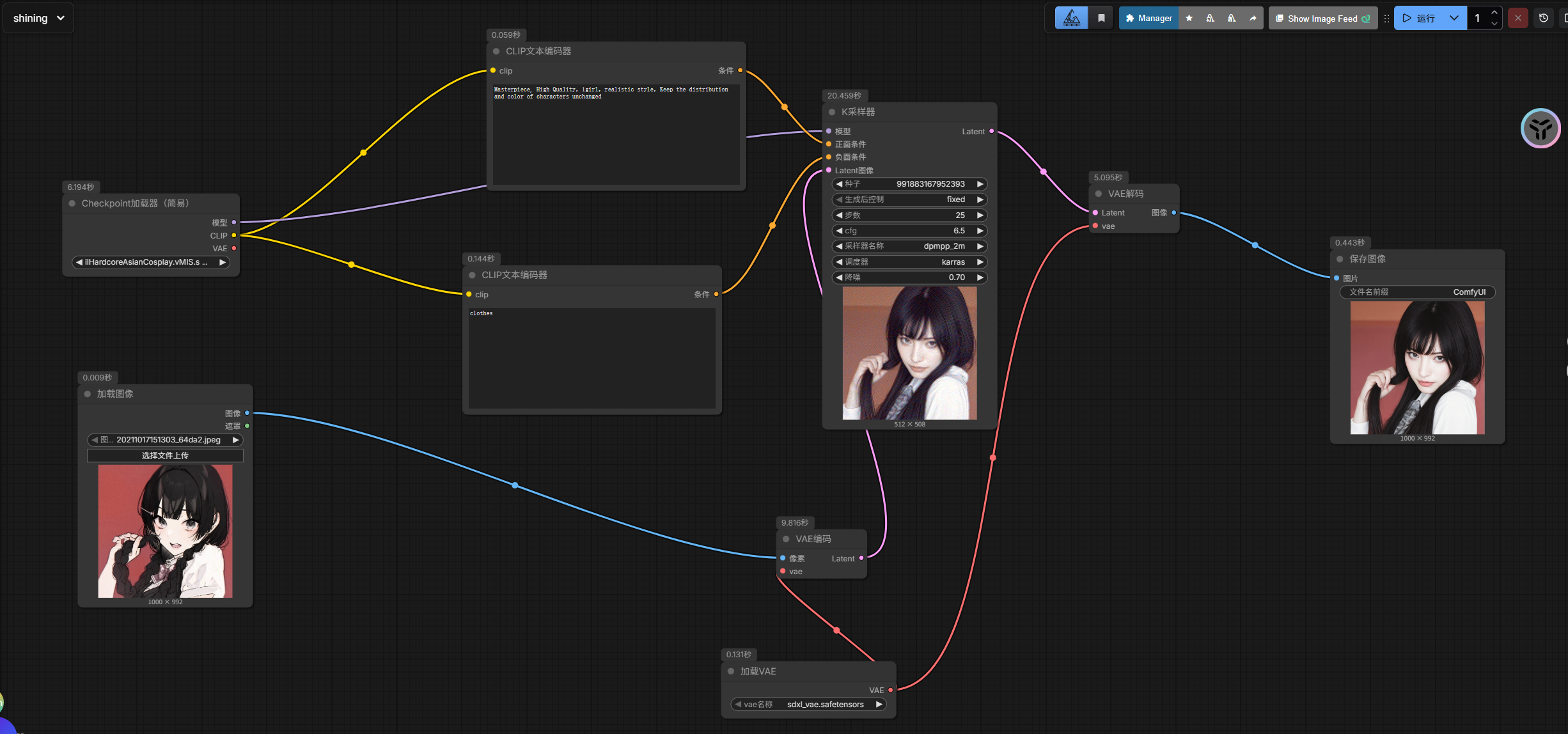

三、 实战拆解:精细化搭建“漫画转真人”生产线

我们将按照数据流动的顺序,逐一放置并讲解8 个核心节点 。

先看整个工作流:

1. Load Checkpoint (加载大模型)

-

作用:选择你的“画家”。

-

操作:选择一个写实类的大模型(如

majicmixRealistic)。 -

输出:它会流出三根线:MODEL模型(给采样器)、CLIP(给提示词)、VAE(给编解码器)。

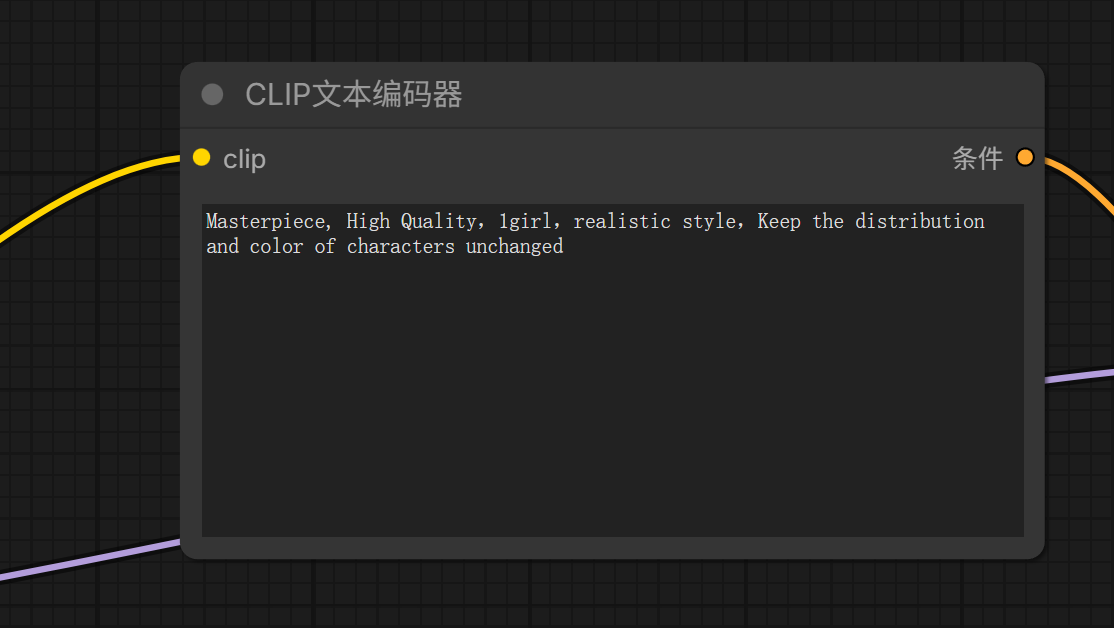

2. CLIP Text Encode (正向提示词)

-

作用:告诉 AI 你要画什么,比如

1girl, masterpiece, photorealistic, realistic skin texture。 -

输入:连接来自大模型的 CLIP 信号。

-

输出:输出 CONDITIONING(条件信号)给采样器的

positive接口。

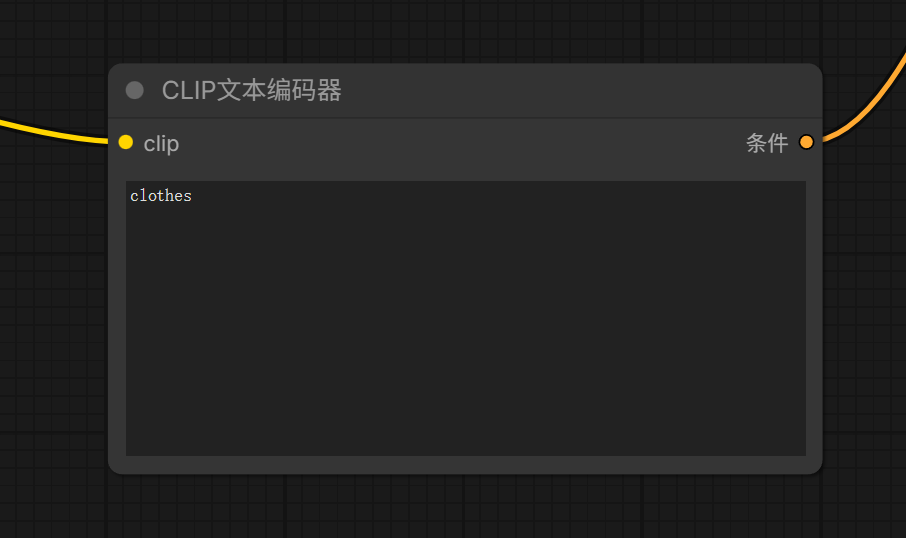

3. CLIP Text Encode (反向提示词)

-

作用:告诉 AI 你不要什么,比如

(worst quality, low quality:1.4), cartoon, anime, sketch。 -

操作:同样的节点,但输出要连到采样器的

negative接口,用来排除漫画感。

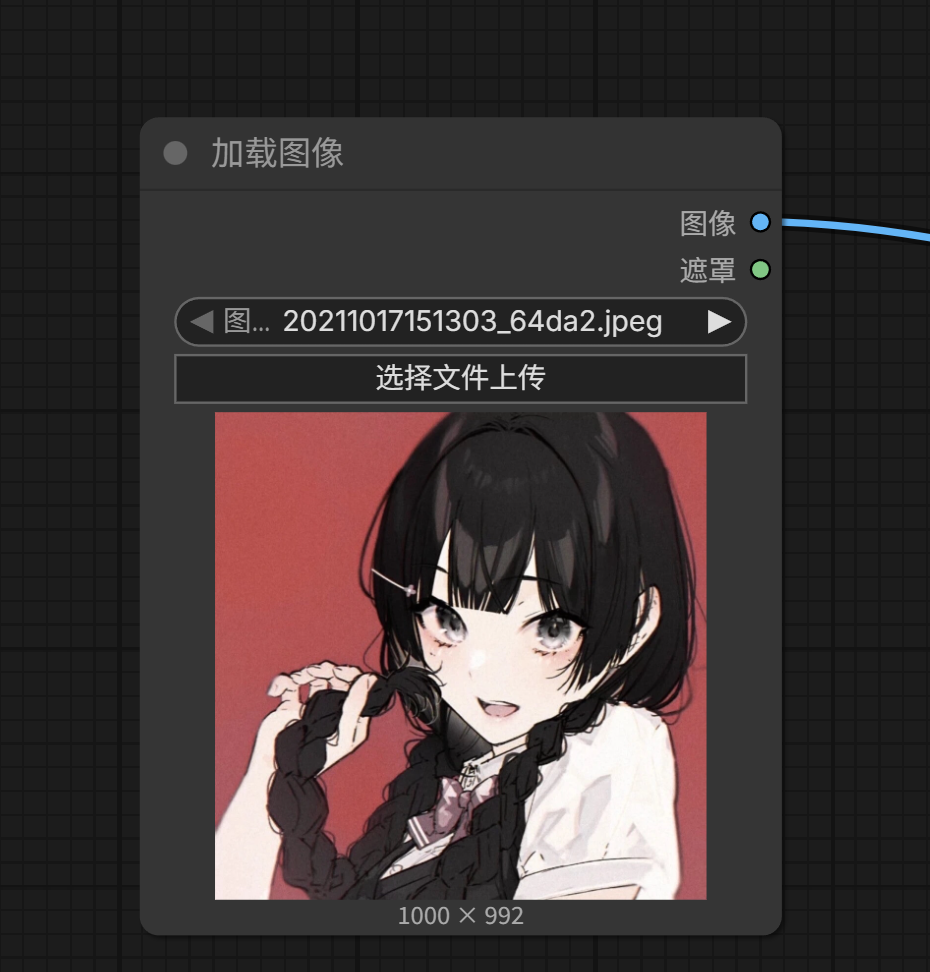

4. Load Image (加载图像)

-

作用:放入你的漫画原图。

-

操作:点击上传你的二次元角色图片 。

5. VAE Encode (VAE 编码)

-

作用:将“像素图”压缩成“潜空间草稿”。

-

输入:一头接 Load Image 的图像,一头接大模型的 VAE 信号。

-

输出:输出 LATENT(潜空间数据)给采样器。

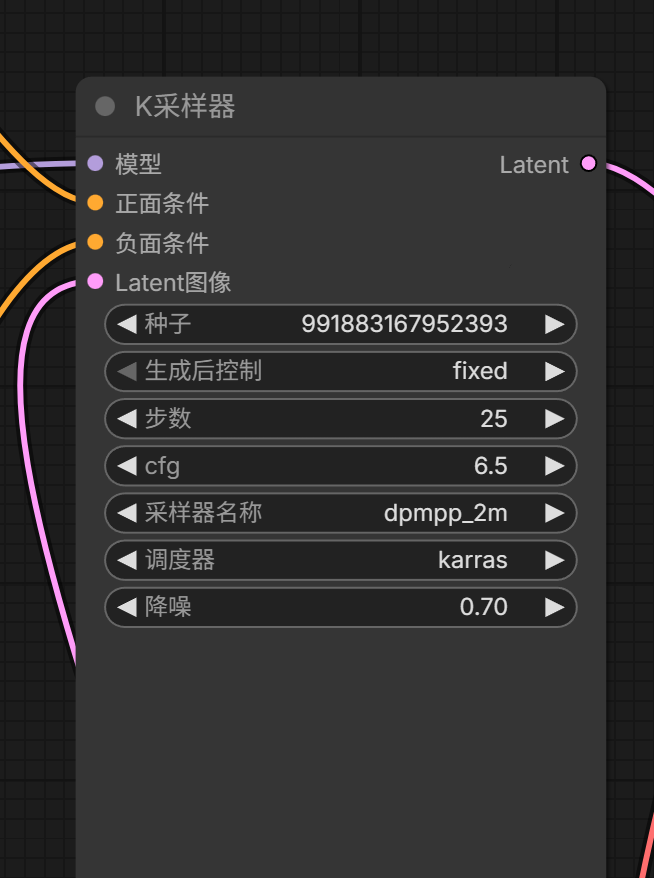

6. KSampler (K 采样器) —— 核心枢纽

-

作用:这是魔法发生的地方,负责把漫画草稿“洗”成真人照片 8。

关键参数设置:

-

Steps (步数):20-30 步,给 AI 足够的雕刻时间 。

-

Denoise (降噪):关键!设在 0.65-0.75。太低还是漫画,太高就认不出原图了 。

-

Sampler (采样器):推荐

dpmpp_2m,调度器选karras

-

核心参数详析

1. 种子与控制 (Seed & Control)

-

seed (种子):图像的随机初始状态(随机噪声基因)。完全相同的种子配合相同参数会生成完全一样的图。

-

control_after_generation (生成后控制):决定下次运行后种子的变化。

-

randomize: 每次随机变,适合找灵感。 -

fixed: 保持不变,适合微调提示词或参数。

-

2. 步数 (Steps)

-

定义:AI 进行去噪迭代的次数。

-

作用:步数越多,细节通常越丰富,但超过一定数值(如 50 步以上)收益递减,且耗时成倍增加。

-

推荐:常规模型建议 20-30 步。

3. CFG (引导系数)

-

定义:AI 对提示词的遵循程度。

-

作用:

-

数值低 (1-4):AI 更有创意,画风柔和,但可能不听指令。

-

数值高 (7-12):AI 死磕指令,但数值过高(>15)会导致色彩烧焦、出现高对比度怪影。

-

-

推荐:5.0 - 8.0 之间最稳健。

4. 采样器与调度器 (Sampler & Scheduler)

-

sampler_name (采样器名称):决定抹除噪点的方法(算法)。

-

dpmpp_2m: 平衡性极佳,出图快且质量稳。 -

euler_a: 适合二次元皮肤,画风平滑。

-

-

scheduler (调度器):控制每一阶段抹除噪点的多少(步长)。

-

karras: 让画面细节在最后几步更平滑,是目前的“黄金搭档”。

-

5. 降噪幅度 (Denoise)

-

定义:对潜空间初始数据的“破坏重造”比例。

-

文生图:必须设为 1.0(从纯随机噪点开始画)。

-

图生图 / 局部重绘:

-

0.4-0.6:保留原图构图,改变画风。

-

0.7-0.85:大幅改变内容,仅保留原图的大致色调和位置。

-

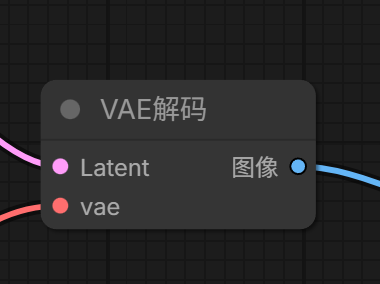

7. VAE Decode (VAE 解码)

-

作用:将 AI 画好的潜空间草稿还原成我们能看懂的像素图片 。

-

输入:接收采样器的 LATENT 和大模型的 VAE。

8. Save Image (保存图像)

-

作用:最终成品展示 13。

-

操作:点击“运行”,你就能在右侧看到你的漫画角色“活”了过来 。

四、 注意事项

-

连接法则:颜色对颜色,名字对名字。比如蓝色的 IMAGE 永远不要连到绿色的 MASK。

-

排雷技巧:如果生成的真人脸部扭曲,尝试稍微降低 CFG(设为 6.5-7.5)或者换一个更精准的写实 LoRA 15。

-

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)