ollama v0.14.0发布:全面进化的智能Agent、Anthropic API兼容、图像生成模型实验性支持震撼登场!

代码地址:github.com/ollama/ollama智能代理(Agent Loop)、Anthropic兼容、版本声明、显存优化、Swift高亮、安全嵌入、zstd压缩、图像生成(MLX引擎)。这次更新不仅增强了模型的实用性与开发体验,也让Ollama正式迈入多模态智能的探索阶段,对服务器、桌面应用与AI集成开发者均具有极大吸引力。Ollama v0.14.0的发布,预示着开源AI模型生态的

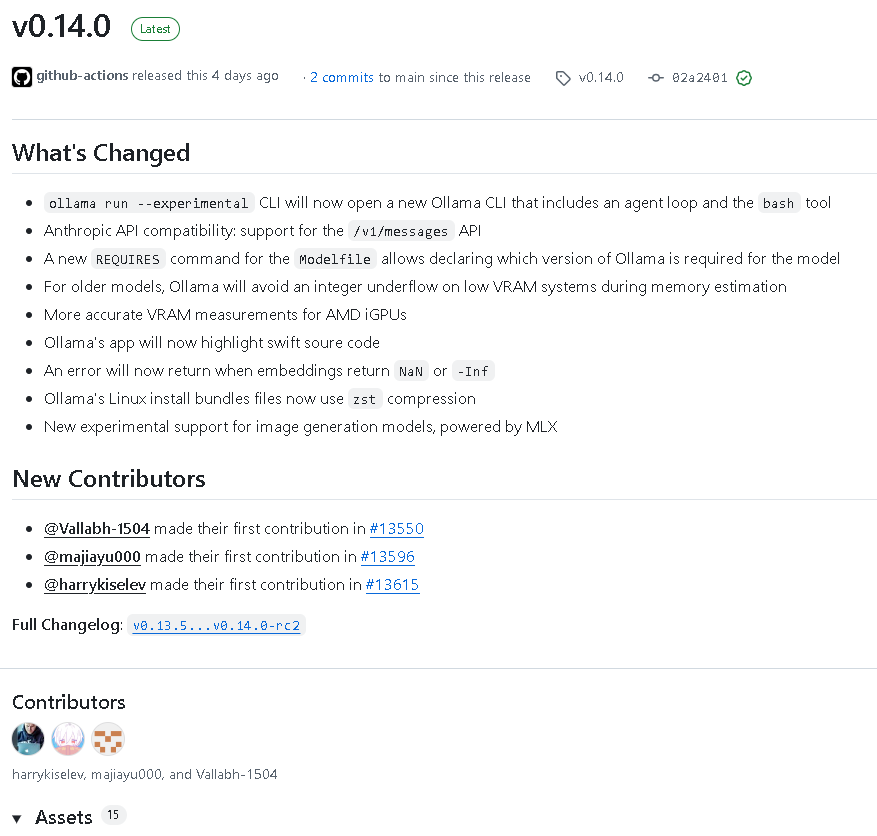

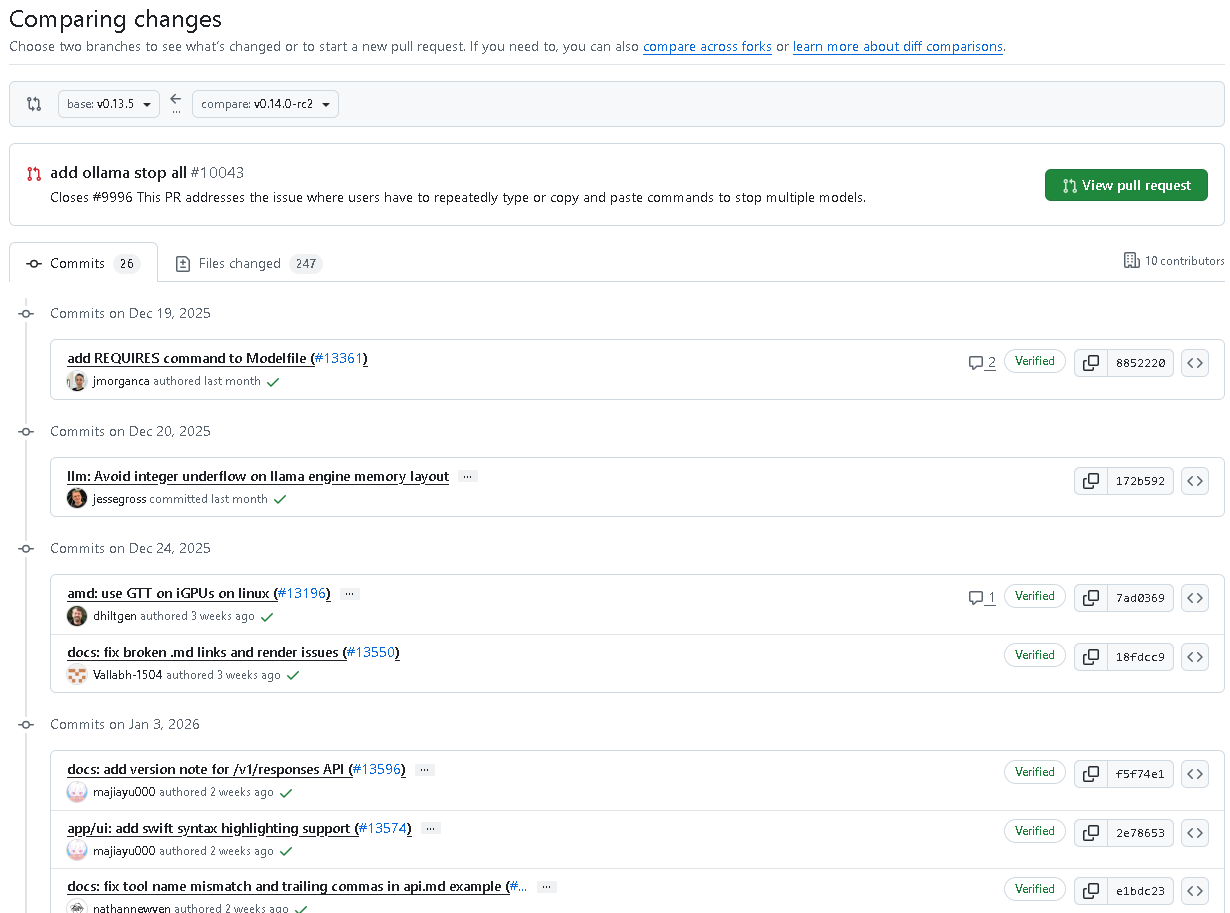

2026年1月14日,Ollama正式发布了 v0.14.0版本,这是一次里程碑式的更新。此次版本在智能代理能力、API兼容性、模型定义、安全性、安装性能以及视觉生成等多个方向都迎来了重大升级与优化。本次更新在2026年1月10日预发布,1月14日正式面向开发者推送。

让我们详细了解 v0.14.0 的更新亮点。

🚀 一、全新实验性CLI —— 智能Agent登场

在本次版本中,通过运行命令:

ollama run --experimental

即可开启全新的 Ollama CLI。它集成了一个 Agent Loop (智能代理循环机制)以及一个 bash工具。这意味着开发者可以在命令行环境下与模型进行更自然的互动与任务自动化,显著提升多任务处理与交流体验。

🧠 二、Anthropic API兼容性增强

Ollama v0.14.0新增了 对 /v1/messages API 的支持。这让使用Anthropic生态的开发者可以无缝接入Ollama的模型能力,实现跨API兼容与迁移。这一更新为构建更开放的多模型协作环境奠定了基础。

⚙️ 三、Modelfile新指令 —— REQUIRES版本声明

本次更新引入了一个重要的新特性:REQUIRES命令。

开发者现在可以在 Modelfile 中声明指定Ollama的版本要求,用于确保模型运行的兼容性和稳定性。这提升了模型部署时的版本管理能力,使项目环境更加可控。

💾 四、内存与显存优化

在硬件适配方面,Ollama v0.14.0带来了两项关键修复与优化:

- 避免旧模型在低显存系统上进行显存估算时出现整数下溢问题。

- 针对AMD集成显卡(iGPU)进行了显存测量精度提升,显著提高在Linux平台下的性能表现。

💻 五、UI与代码高亮新体验

Ollama的应用界面现在支持 Swift源码高亮。这让开发者在查看或编辑模型相关代码时拥有更直观且友好的体验,进一步丰富了多语言支持环境。

🧩 六、嵌入安全性检查机制

v0.14.0强化了嵌入数据的稳定性:

当生成的 embeddings 返回 NaN 或 -Inf 值时,系统将直接返回错误提示。此举有效防止下游模型处理异常数据,从源头保障计算稳定性。

📦 七、Linux安装包全面升级

Ollama的Linux安装文件现在采用 zstd压缩格式(.zst)。这不仅提升了压缩效率与安装速度,同时减小了文件体积,优化了分发体验。

🖼️ 八、实验性图像生成模型支持 —— MLX引擎加入

最大亮点之一是:

Ollama v0.14.0正式加入 MLX实验性后端引擎,并首次引入了 图像生成(image generation)模型 支持。开发者可使用新加入的“z-image”原型模型,体验图像生成能力的初步功能。这标志着Ollama开始跨越从文本到视觉的界限,迈向多模态智能阶段。

🔧 九、更多实用优化

除了主功能更新外,v0.14.0中还包括多项重要改进:

- 新命令:ollama stop all —— 一次性停止所有正在运行的模型,节省重复操作时间。

- 修复与优化 文档中的 Markdown 链接、API示例渲染、curl相关代码片段等。

- 改进模板渲染与工具调用JSON顺序保持,确保Agent循环与工具定义在执行过程中的数据一致性。

- 用户界面优化:Agent界面进行了重新设计,采用极简风格,改善交互流畅度。

- Docker构建优化与依赖更新,提升容器化部署的稳定性。

✨ 十、总结

代码地址:github.com/ollama/ollama

Ollama v0.14.0是一场全方位升级,关键词可以总结为:

智能代理(Agent Loop)、Anthropic兼容、版本声明、显存优化、Swift高亮、安全嵌入、zstd压缩、图像生成(MLX引擎)。

这次更新不仅增强了模型的实用性与开发体验,也让Ollama正式迈入 多模态智能 的探索阶段,对服务器、桌面应用与AI集成开发者均具有极大吸引力。

结语:

Ollama v0.14.0的发布,预示着开源AI模型生态的进一步成熟。从命令行智能助手到图像生成的实验支持,Ollama正在加速扩展其能力边界。

更多推荐

已为社区贡献37条内容

已为社区贡献37条内容

所有评论(0)