【从 “完形填空”(MLM) 到 “即兴演讲”(CLM):揭秘 GPT 碾压 BERT 的底层逻辑】

摘要:NLP领域的关键路线之争是BERT的双向理解(MLM)与GPT的单向生成(CLM)。BERT通过完形填空任务训练,能双向分析但生成能力弱;GPT通过文字接龙任务训练,专注单向生成但通用性更强。GPT胜出的三大原因:1)生成任务兼容理解任务;2)数据利用率更高;3)训练与推理场景一致。最终,当模型规模足够大时,GPT不仅保持生成优势,理解能力也超越BERT,使CLM路线成为大模型时代的主流选择

引言:

“你可能以为 GPT 赢过 BERT,是因为它更‘聪明’,理解能力更强?错了!

这根本不是‘谁更懂语言’的问题,而是一场从出生就注定结果的路线战争。

BERT 就像个拿着剧本的审稿编辑,能前后对照着补全空缺,但让它即兴演讲就会当场卡壳;而 GPT 是天生的即兴表演者,只靠前面说过的话就能一直说下去。今天我们就拆解这场 NLP 圈最核心的路线之争,告诉你为什么 GPT(CLM)能一统天下,而 BERT(MLM)只能退居幕后。”

自然语言处理(NLP)领域过去五年最核心的路线之争:BERT 的“双向理解”路线 vs. GPT 的“单向生成”路线。

最终 GPT (CLM) 之所以在通用大模型之战中胜出,并不是因为它的“理解能力”比 BERT 强,而是因为它的通用性和上限更高。

一、 逻辑上如何理解?

核心区别在于**“可见范围”和“训练目标”**。

1. MLM (Masked Language Modeling) - 代表:BERT

-

逻辑:完形填空 (Cloze Task)。

-

比喻: 像是一个**“审稿编辑”或“侦探”。它拿着一整页写好的文章,把其中几个字涂黑(Mask),然后根据上下文(即看前面,也看后面)**来推断涂黑的字是什么。

-

双向性 (Bidirectional): 它能同时利用“过去”和“未来”的信息。

-

公式逻辑:

2. CLM (Causal Language Modeling) - 代表:GPT

-

逻辑:文字接龙 (Next Token Prediction)。

-

比喻: 像是一个**“即兴演讲者”**。它只能看见已经说出的话,必须立刻想出下一个字说什么。它绝对不能看“剧本的后半部分”。

-

单向性 (Unidirectional): 严格的时间因果,只能利用“过去”的信息。

-

公式逻辑:

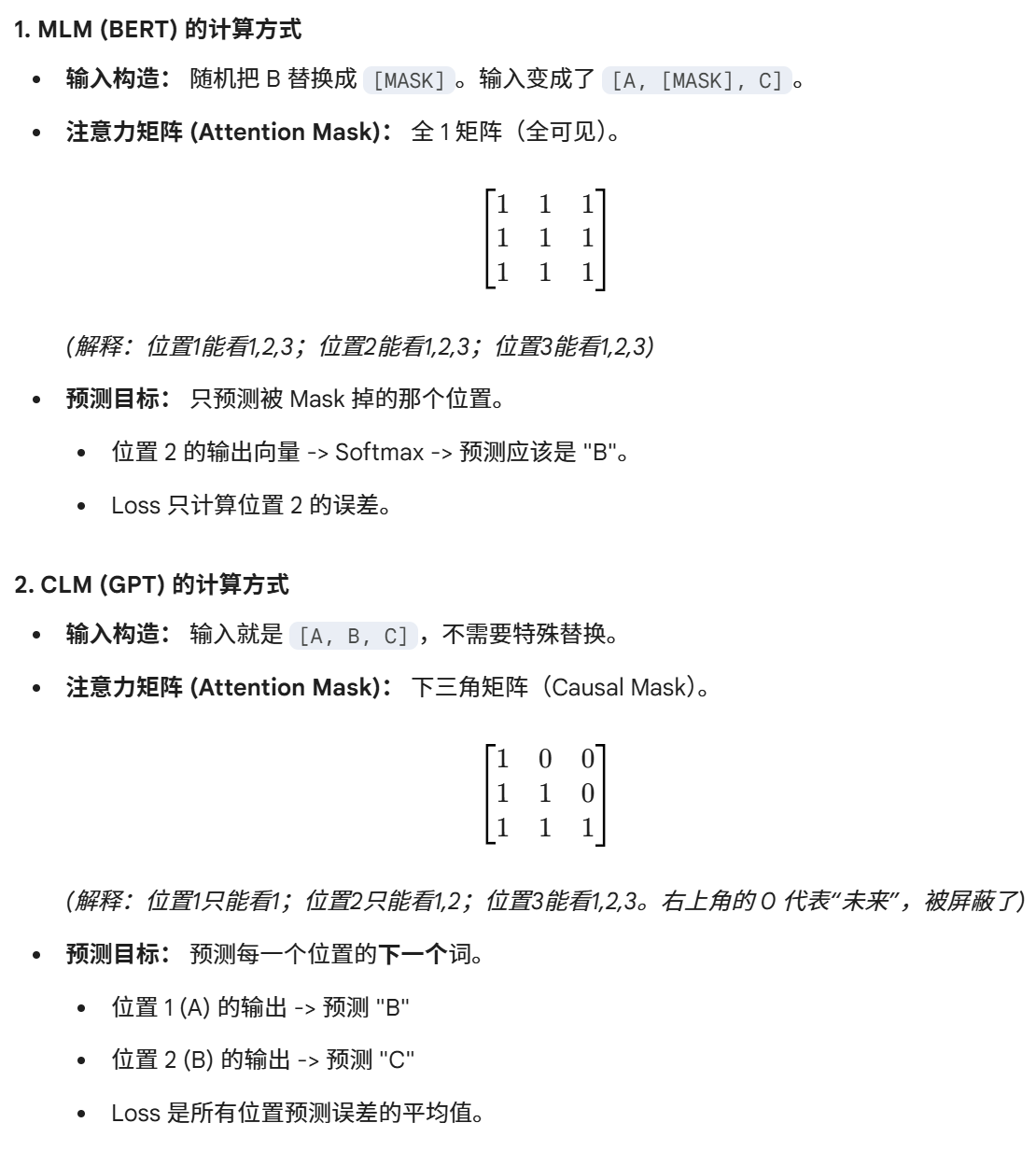

二、 数值计算举例

为了展示区别,我们需要引入**注意力掩码(Attention Mask)**的概念,这是两者计算上最本质的不同。

假设句子: [A, B, C] 词表映射: A=1, B=2, C=3 任务: 训练模型处理这三个词。

三、 为什么 GPT (CLM) 战胜了 BERT (MLM)?

1. 任务的普适性 (Generality)

-

MLM (BERT) 的局限: 它非常擅长做选择题(分类、情感分析、实体抽取)。但它很难说话。因为说话是单向生成的,而 BERT 训练时习惯了“看答案(后文)”,一旦让它生成,它没有后文可看,能力就崩塌了。

-

CLM (GPT) 的优势: 生成式任务(写文章、写代码)本质就是预测下一个词。而理解任务(做选择题)也可以转化为生成任务(生成选项 "A" 或 "B")。CLM 也就是目前的 Generative AI,它包容了理解,而 MLM 很难包容生成。

2. 训练数据的利用效率

-

MLM: 每次训练只预测 15% 被 Mask 掉的词。也就是读了一本书,只练了其中 15% 的字,效率低。

-

CLM: 每一个词都是下一个词的标签。读一本书,每一个字都在参与训练,数据利用率极高。

3. 预训练与推理的一致性 (Mismatch Problem)

-

BERT 的硬伤: 训练时输入里有很多

[MASK]标记,但真实应用(推理)时,用户说的话里没有[MASK]。这种训练和推理的不一致限制了模型的上限。 -

GPT 的优势: 训练时是预测下一个词,使用时还是预测下一个词。训练和应用场景完美统一。

四、 MLM与CLM在流程中的位置与作用对比

在现代大模型应用流程中,它们的位置完全不同:

| 特性 | BERT (MLM 路线) | GPT (CLM 路线) |

| 主要架构 | Transformer Encoder (编码器) | Transformer Decoder (解码器) |

| 在流程中的位置 | 通常作为特征提取器。后面必须接一个“下游任务网络”(比如分类头、序列标注头)。 | 本身就是端到端的系统。输入 Prompt,直接输出结果,不需要外接其他网络。 |

| 微调方式 | Fine-tuning:需要针对不同任务(分类、摘要)设计不同的输出层并重新训练。 | Prompting / SFT:模型结构不变,只改变输入的指令(Prompt),模型就能完成不同任务。 |

| 目前的地位 | 退居幕后。主要用于不需要生成的纯分析任务(如搜索引擎的向量召回、简单的文本分类),因为它小巧且速度快。 | 绝对统治。所有的主流大模型(DeepSeek, ChatGPT, Claude, Llama)全部采用 CLM。 |

五、总结

-

BERT (MLM) 像是把文章拆碎了研究结构的语言学家,懂得多但不会写。

-

GPT (CLM) 像是读了万卷书的畅销书作家,不仅懂(为了续写必须懂逻辑),而且能滔滔不绝地写出来。

当模型规模大到一定程度(Scaling Laws),我们发现“畅销书作家”的理解能力也涌现了,甚至超过了“语言学家”,于是 CLM 彻底接管了时代。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)