YOLO26重磅开源!边缘AI新标杆,43%提速+端到端无NMS推理

YOLO26重磅开源!边缘AI新标杆,43%提速+端到端无NMS推理

《博主简介》

小伙伴们好,我是阿旭。

专注于计算机视觉领域,包括目标检测、图像分类、图像分割和目标跟踪等项目开发,提供模型对比实验、答疑辅导等。

《------往期经典推荐------》

二、机器学习实战专栏【链接】,已更新31期,欢迎关注,持续更新中~~

三、深度学习【Pytorch】专栏【链接】

四、【Stable Diffusion绘画系列】专栏【链接】

五、YOLOv8改进专栏【链接】,持续更新中~~

六、YOLO性能对比专栏【链接】,持续更新中~

《------正文------》

目录

引言

当计算机视觉技术从云端逐步下沉到终端设备, latency(延迟)、可靠性与部署成本成为行业核心诉求。2026年,Ultralytics正式推出新一代YOLO26模型——这是迄今为止最先进、最易部署的YOLO系列产品,首次亮相于2025年伦敦YOLO视觉大会(YV25),标志着计算机视觉模型在训练、部署与规模化应用上的根本性变革。

Ultralytics创始人兼CEO Glenn Jocher在发布会上强调:“最顶尖的AI技术不该被束之高阁,大型企业垄断创新的时代即将结束。我们希望让AI走进每个人的生活——从手机到交通工具,从低功耗设备到边缘终端,让所有解决方案开发者都能轻松获取强大的计算机视觉能力。”

YOLO26正是这一愿景的落地之作:它不执着于实验室环境的性能峰值,而是聚焦于视觉AI真正的部署场景,以“轻量化、高速化、易部署”为核心,为边缘计算量身打造。

开源地址:https://github.com/ultralytics/ultralytics

一、YOLO26核心亮点:五大维度全面升级

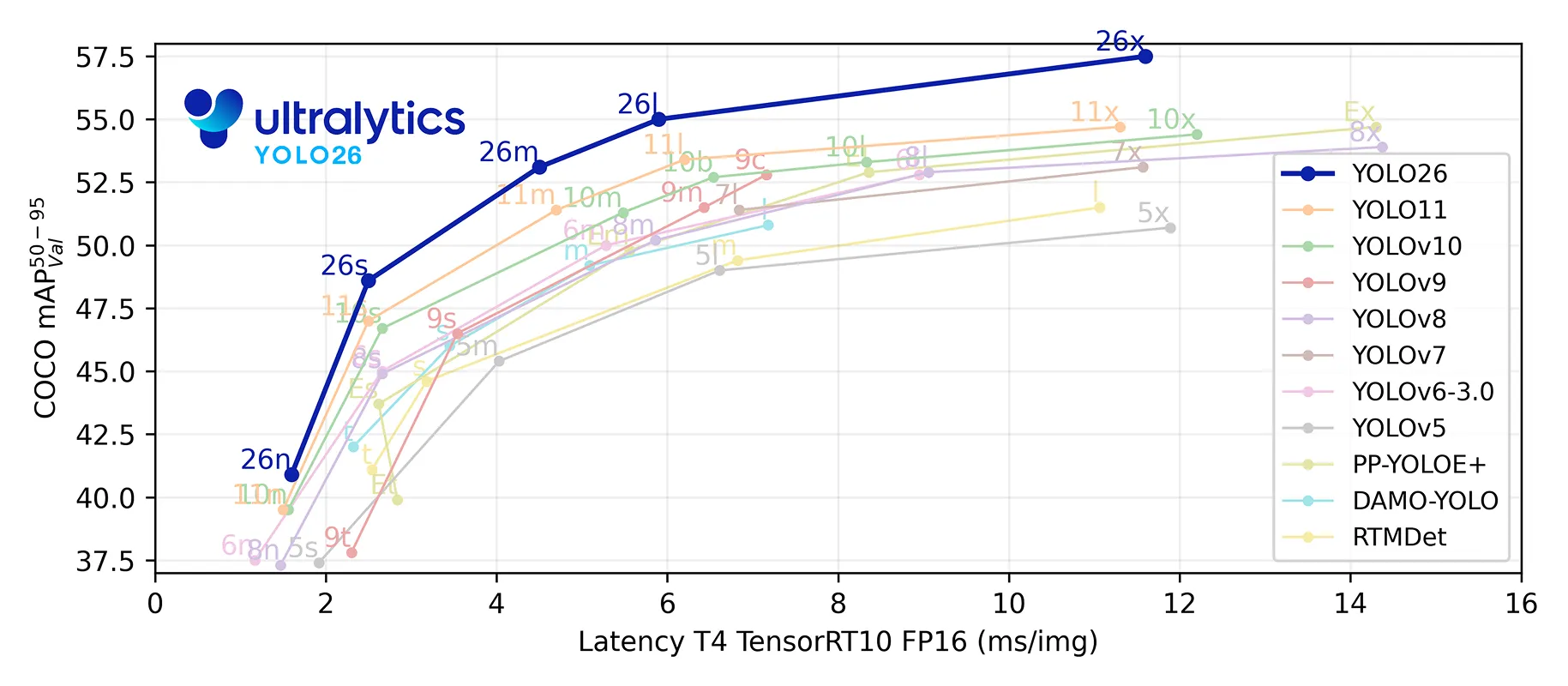

作为新一代标杆级视觉模型,YOLO26延续了Ultralytics YOLO系列的统一架构优势,同时在性能、效率与部署灵活性上实现跨越式提升。

1. 多尺寸模型家族,适配全场景需求

YOLO26提供五种尺寸规格,从Nano(n)到Extra Large(x),开发者可根据部署设备的硬件限制,灵活平衡运行速度、检测精度与模型体积:

- Nano(n):极致轻量化,专为低功耗边缘设备设计

- Small(s)/Medium(m):兼顾速度与精度,适用于多数终端场景

- Large(l)/Extra Large(x):高精度优先,满足复杂场景检测需求

2. 43% CPU推理提速,边缘实时性再突破

相较于上一代YOLO11,YOLO26 Nano模型的CPU推理速度提升高达43%,成为目前边缘设备与CPU部署场景中,兼具高速与高精度的顶尖目标检测模型。这一优化让无GPU设备(如摄像头、机器人、嵌入式系统)也能实现实时视觉处理,彻底打破“高性能依赖云端算力”的桎梏。

3. 一站式支持六大核心视觉任务

YOLO26以统一模型架构支撑多种计算机视觉任务,训练、验证、推理与导出流程高度统一,降低技术落地门槛:

- 图像分类:分析整图场景,精准匹配类别标签

- 目标检测:定位并识别图像/视频中的多个目标

- 实例分割:以像素级精度勾勒目标轮廓

- 姿态估计:识别人体及物体关键点,还原姿态信息

- 旋转边界框(OBB)检测:精准识别倾斜目标,适配航拍、卫星影像等场景

- 目标追踪:结合Ultralytics Python工具包,实现视频流与直播中的目标连续追踪

二、创新揭秘

YOLO26的性能飞跃源于四大核心技术创新,从模型架构到训练机制全面优化:

1. 移除DFL模块,简化预测流程

早期YOLO模型依赖分布焦点损失(DFL)提升边界框精度,但这一模块增加了部署复杂度,且存在固定回归限制。YOLO26彻底移除DFL,不仅简化了边界框预测逻辑,提升了硬件兼容性,还解决了超大目标检测的可靠性问题,让模型在边缘设备上的导出与运行更顺畅。

2. 端到端无NMS推理,降低 latency

传统目标检测需通过非极大值抑制(NMS)进行后处理,过滤重叠预测框——这一步骤会增加延迟、提升部署难度。YOLO26采用原生端到端架构,直接输出最终预测结果,内部自动处理重复预测,彻底省去NMS环节,大幅降低推理延迟与集成风险,完美适配实时边缘场景。

3. ProgLoss+STAL,提升检测精度

- 渐进式损失平衡(ProgLoss):让模型训练过程更稳定,收敛更平滑,减少训练波动

- 小目标感知标签分配(STAL):针对小目标、低可见度目标优化学习机制,解决边缘场景中“难检测”问题

两项技术结合,让YOLO26在复杂场景中仍能保持高可靠检测,尤其适用于物联网、机器人、航拍等小目标密集场景。

4. MuSGD优化器,强化训练稳定性

YOLO26采用全新混合优化器MuSGD,融合传统随机梯度下降(SGD)的强泛化能力与大语言模型(LLM)训练中的先进优化思路。该优化器灵感源自Moonshot AI的Kimi K2,能让模型更快达到高性能水平,同时降低训练不稳定性,尤其在大型复杂数据集训练中表现突出。

三、全场景任务支持

除核心架构创新外,YOLO26针对三大关键任务进行专项优化,进一步提升实用价值:

1. 实例分割:多尺度信息融合,掩码更精准

通过语义分割损失优化训练过程,升级原型模块(proto module),实现多尺度信息联动,让模型在复杂场景中也能精准处理不同尺寸目标,输出更一致、准确的实例掩码。

2. 姿态估计:集成RLE, keypoint预测更可靠

引入残差对数似然估计(RLE)建模关键点预测不确定性,优化解码流程,在保证实时性的同时,显著提升 keypoint 检测精度,适用于人体动作分析、机器人交互等场景。

3. OBB检测:角度损失优化,旋转预测更稳定

新增专用角度损失函数,解决方形目标 orientation 模糊问题;优化OBB解码逻辑,避免旋转边界附近的角度突变,让倾斜目标的方向估计更稳定,适配航拍测绘、工业检测等场景。

四、YOLOE-26:基于YOLO26的开放词汇分割模型

Ultralytics同步推出YOLOE-26系列——基于YOLO26架构的开放词汇分割模型,支持文本提示、视觉提示与无提示三种推理模式。该模型家族覆盖全尺寸规格,相比前代开放词汇分割模型,在真实场景中的精度与可靠性大幅提升,为跨领域分割任务提供更灵活的解决方案。

五、全平台部署支持:一次开发,多端运行

YOLO26专为边缘部署设计,通过Ultralytics Python工具包实现全平台适配,支持多种主流导出格式,轻松对接不同硬件:

- NVIDIA GPU:导出为TensorRT格式,实现高性能推理

- Apple设备:CoreML格式原生部署,适配手机、平板等终端

- Intel硬件:OpenVINO优化,提升CPU与边缘加速器性能

- 专用边缘芯片:支持多种边缘AI加速器,实现高吞吐量、低功耗运行

一次模型开发,即可部署到摄像头、机器人、嵌入式系统、无人机等各类设备,大幅简化生产流程。

六、行业应用场景

YOLO26的轻量化与高适应性,使其在多行业落地中具备独特优势:

- 机器人:导航避障、目标交互,支撑动态环境下的安全运行

- 制造业:生产线缺陷检测、零部件缺失识别,本地实时处理,减少云端依赖

- 航拍无人机:飞行中实时分析影像,适配巡检、测绘、勘探等远程场景

- 嵌入式/IoT:运行于低功耗硬件,赋能智能摄像头、联网传感器、自动化监控设备

- 智慧城市:交通流量监测、公共安全预警、基础设施管理,边缘端实时响应

七、快速上手YOLO26

通过Python包快速安装使用,兼容ONNX、TensorRT等主流格式:

pip install ultralytics

from ultralytics import YOLO

# 加载COCO预训练YOLO26n模型

model = YOLO("yolo26n.pt")

# 对图像进行推理

results = model("path/to/bus.jpg")

完整文档与开发指南可参考Ultralytics官方文档。

结束语

YOLO26以“边缘优先”为核心设计理念,通过架构创新、性能优化与部署简化,重新定义了视觉AI模型的落地标准。它不仅是一款更快、更准、更轻的检测模型,更是一套覆盖全场景、全任务的边缘视觉解决方案。

好了,这篇文章就介绍到这里,喜欢的小伙伴感谢给点个赞和关注,更多精彩内容持续更新~~

关于本篇文章大家有任何建议或意见,欢迎在评论区留言交流!

更多推荐

已为社区贡献177条内容

已为社区贡献177条内容

所有评论(0)