KAIST团队推出Upsample Anything:一个神奇的图像细节恢复技术

KAIST团队推出Upsample Anything:一个神奇的图像细节恢复技术

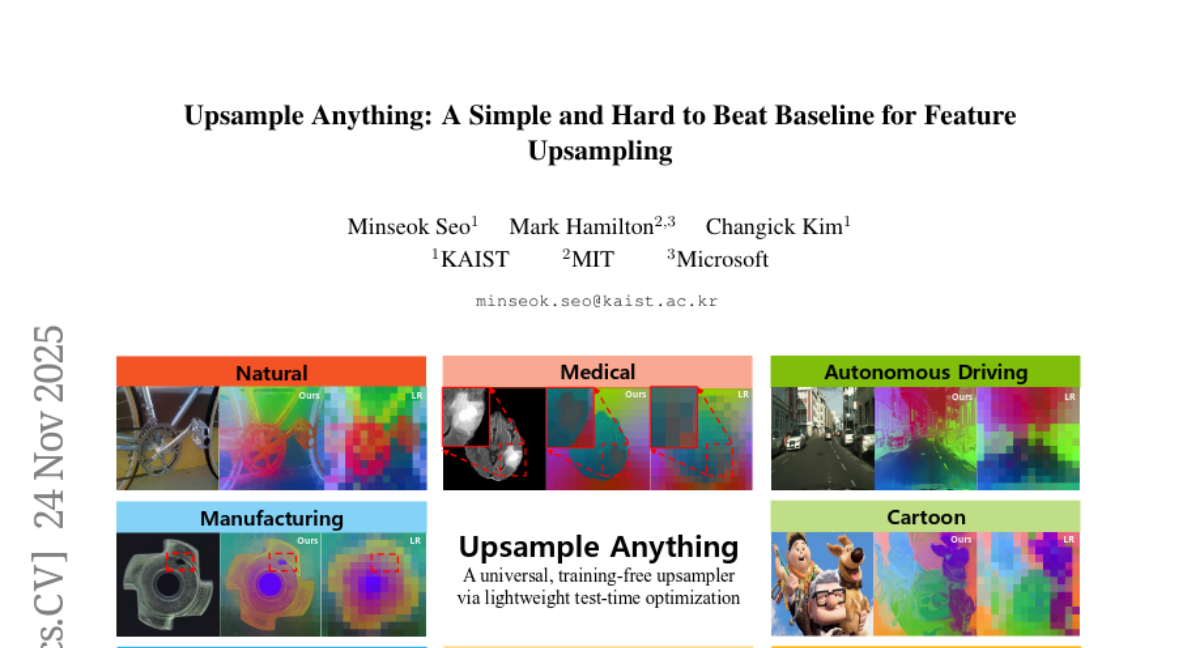

这项突破性研究由韩国科学技术院(KAIST)的徐敏石(Minseok Seo)、麻省理工学院的马克·汉密尔顿(Mark Hamilton)以及微软的金昌益(Changick Kim)共同完成,并于2025年11月24日发表在计算机视觉领域的顶级学术会议上。有兴趣深入了解的读者可以通过论文编号arXiv:2511.16301v2查询完整研究内容。

想象一下,你有一张珍贵的老照片,但因为年代久远而变得模糊不清,细节几乎看不见。现在,计算机科学家们开发出了一种神奇的技术,能够像魔法师一样,在短短0.4秒内就把这些丢失的细节重新"变"回来,而且效果好得令人难以置信。这就是KAIST团队最新研发的"Upsample Anything"技术——一个能够让任何模糊图像重获新生的创新方法。

这项技术的核心在于解决一个困扰计算机视觉领域多年的难题。当今最先进的人工智能视觉系统,比如大名鼎鼎的ViT(Vision Transformer),虽然在识别图像内容方面表现卓越,但它们有个致命弱点:为了提高处理效率,这些系统会将输入图像大幅缩小到原来的1/14或1/16大小。这就好比你拿着一副望远镜看远方的风景,虽然能识别出那是山还是树,但要看清树叶的纹理就不可能了。

当需要处理像素级别的精细任务时——比如医学影像分析、自动驾驶中的道路细节识别,或者卫星图像的精确测量——这种信息丢失就成了大问题。传统的解决方案要么需要大量的训练数据和计算资源,要么在面对新领域的图像时效果大打折扣,就像一个只会做川菜的厨师突然要做法式料理一样手忙脚乱。

研究团队的创新思路源于一个巧妙的观察:与其试图从零开始训练一个万能的图像恢复系统,不如让计算机在遇到每张新图像时,花几毫秒时间"学习"一下这张特定图像的特点,然后用这些临时学到的知识来恢复细节。这种方法被称为"测试时优化"(Test-Time Optimization),就像一位经验丰富的修复师在动手修复每幅画作前,都会先仔细观察这幅画的独特风格和损坏特点。

一、核心技术:Gaussian Splatting遇上Joint Bilateral Upsampling

Upsample Anything技术的核心可以用做拼图的过程来理解。假设你有一盒1000片的拼图,但只给你看了其中100片的大致位置,现在要求你还原出完整的图案。传统方法就像是先看很多其他拼图的完成品,然后试图根据这些经验来猜测缺失部分应该是什么样子。但Upsample Anything采用了一种更聪明的策略。

研究团队将两种看似不相关的数学技术巧妙结合:Gaussian Splatting和Joint Bilateral Upsampling。如果把图像恢复比作烹饪,Gaussian Splatting就像是选择合适的锅具和火候,而Joint Bilateral Upsampling则像是掌握调料的精确比例。单独使用任何一种技术都有局限,但把它们结合起来,就能创造出令人惊艳的效果。

Joint Bilateral Upsampling原本是一种经典的图像处理技术,工作原理类似于一个智能的图像"放大镜"。它不是简单地把像素复制粘贴来放大图像,而是会观察每个像素周围的颜色和亮度变化,然后决定如何最自然地填补空白区域。就像一位技艺精湛的画家在修复古画时,不会随意添色,而是仔细观察周围的笔触和色调,确保新添加的部分与原作浑然一体。

但传统的Joint Bilateral Upsampling有个限制——它使用的是固定的"观察窗口",就像戴着一副固定焦距的眼镜看世界,虽然大部分情况下还不错,但遇到特殊情况就不够灵活了。研究团队的创新在于引入了"各向异性"的概念,让每个像素都有自己专属的"观察窗口"。

这种各向异性的处理方式可以用调音师的工作来类比。传统方法就像用同一套音响设置播放所有类型的音乐,而新方法则像一位专业调音师,会根据每首歌曲的特点调整不同频段的音量。对于图像中的边缘区域,系统会使用更窄更精准的"观察窗口"来保持线条的锐利;对于平滑区域,则使用更宽的"观察窗口"来保证过渡的自然。

Gaussian Splatting技术则为这种灵活性提供了数学基础。每个低分辨率的像素都被表示为一个椭圆形的"高斯核",这个椭圆可以是圆形的、扁平的,可以水平放置也可以倾斜,完全根据当前像素周围的图像内容来决定。研究团队为每个像素分配了四个关键参数:两个控制椭圆的宽度和高度(σx, σy),一个控制椭圆的旋转角度(θ),还有一个控制颜色敏感度(σr)。

这四个参数的组合就像是给每个像素配备了一套个性化的"工具包"。对于包含细节线条的区域,椭圆会变得狭长并沿着线条方向排列;对于包含复杂纹理的区域,椭圆会调整其敏感度参数,确保能够捕捉到微妙的颜色变化;对于平坦区域,椭圆则会变得更圆更大,帮助创建平滑的过渡效果。

二、测试时优化:让AI成为快速学习的专家

Upsample Anything最令人印象深刻的特点是其"测试时优化"策略。这种方法的工作原理可以用专业摄影师的工作方式来理解。当一位经验丰富的摄影师到达一个新的拍摄地点时,他不会立刻开始拍照,而是会花几分钟时间观察当前的光线条件、背景特点和主题特色,然后调整相机设置以获得最佳效果。

系统首先将输入的高分辨率图像按照设定的比例缩小,模拟Vision Foundation Model处理后的低分辨率特征图。然后,它开始一个快速的"学习"过程:系统试图使用当前的参数设置来重建原始图像,观察重建结果与真实图像的差异,然后调整参数以减少这种差异。

这个过程就像一位艺术修复师在工作:面对一幅损坏的画作,修复师不会马上动手,而是先在一块小画布上做实验,尝试不同的颜料配比和笔法,直到找到最接近原作风格的方法,然后才在真正的画作上施展技艺。

整个优化过程惊人地快速,仅需50次迭代就能收敛到最佳效果。研究团队发现,系统在前几次迭代中就能掌握图像的基本特征,随后的迭代主要是在精细调整细节。这就像一位天才画家,只需要几笔就能抓住画面的精髓,然后用剩余的时间来完善细节。

值得注意的是,这种优化是完全自动化的,不需要任何人工干预或预设标准。系统使用简单但有效的L1损失函数作为优化目标,这相当于告诉系统:"尽可能让重建的图像在颜色上与原图接近"。虽然优化目标看似简单,但由于使用了灵活的各向异性高斯核,系统能够自动学会复杂的结构和纹理模式。

三、跨域通用性:一招鲜吃遍天

Upsample Anything最令人惊讶的特性是其强大的跨域通用性。一旦系统在某张图像上完成了参数优化,学到的这套"工具包"不仅可以用来恢复图像本身,还能直接应用到来自Vision Foundation Model的抽象特征图上,甚至可以处理深度图、分割图等完全不同类型的数据。

这种通用性可以用语言学习来类比。当你学会了某种语言的语法规则和表达习惯后,你不仅能用它来写日记,也能写商务邮件、诗歌或技术文档。同样,Upsample Anything学到的空间结构知识不仅适用于彩色图像,也适用于任何需要保持空间一致性的数据类型。

在语义分割任务中,系统展现出了卓越的表现。语义分割就像给图像中的每个像素贴标签,告诉计算机这里是"天空"、那里是"树木"、这边是"汽车"。传统方法在处理这类任务时,往往在物体边界处表现不佳,就像用粗笔画细线一样力不从心。但Upsample Anything能够精确地保持物体边界,确保分割结果既准确又细腻。

在深度估计领域,系统的表现更是令人印象深刻。深度估计就像给每个像素标注它到相机的距离,这对于自动驾驶、机器人导航等应用至关重要。研究团队在NYUv2数据集上的实验显示,Upsample Anything在深度估计精度(RMSE 0.498)和表面法线估计准确度方面都达到了最佳水平。这意味着系统不仅能准确判断物体的远近,还能精确理解表面的朝向和角度。

更有趣的是,系统还能处理概率图上采样任务。在这种应用中,系统不是直接放大特征图,而是先在低分辨率上进行预测,得到每个像素属于不同类别的概率,然后再将这些概率图放大到原始分辨率。这种"先预测再放大"的策略不仅计算效率更高,在某些数据集上的表现甚至超过了传统的"先放大再预测"方法。

四、技术优势:快速、精确、通用

Upsample Anything相比现有方法的优势就像高速列车相比传统火车的优势一样显著。在速度方面,系统处理一张224×224像素的图像只需要约0.419秒,而之前需要测试时优化的方法(如FeatUp Implicit)需要49秒才能完成同样的任务。这种速度提升使得该技术具备了实际应用的可能性。

在内存效率方面,系统的设计也相当巧妙。传统的注意力机制方法在处理高分辨率图像时会遇到内存爆炸的问题,就像试图在小房间里展示大型展品一样困难。但Upsample Anything使用的各向异性高斯绘制方法具有线性的内存复杂度,即使处理1024×1024像素的图像也能轻松胜任,而竞争方法在512×512分辨率下就会出现内存不足的问题。

在精度方面,系统在多个标准数据集上都达到了最佳或接近最佳的性能。在COCO、PASCAL-VOC和ADE20K等语义分割数据集上,即使使用简单的1×1卷积作为分割头,系统也能取得优异成绩。这证明了高质量特征上采样的重要性——有了好的特征,即使用简单的后续处理也能得到很好的结果。

系统的另一个重要优势是其分辨率无关性。传统的训练基础方法通常在特定分辨率下训练,换到其他分辨率时性能会下降。但Upsample Anything由于是基于测试时优化的,天然具备处理任意分辨率的能力。研究团队展示了从4×4像素到896×896像素的各种分辨率下的处理效果,系统在极低分辨率下仍能保持良好的重建质量。

五、实验验证:在多个战场上的胜利

研究团队进行了全面而细致的实验验证,就像一位严格的考官从各个角度测试学生的能力。实验涵盖了语义分割、深度估计、表面法线估计、深度图上采样等多个任务,使用了包括COCO、PASCAL-VOC、ADE20K、NYUv2、Middlebury等在内的标准数据集。

在语义分割实验中,研究团队采用了更严格的评估协议。他们发现之前研究中常用的10轮训练对于现代强大的backbone来说明显不够,会导致分割头欠拟合。因此,他们将训练轮数增加到100轮,并使用余弦学习率调度策略。在这种更公平的比较条件下,虽然所有方法的提升都相对有限,但Upsample Anything仍然在所有数据集上取得了最佳成绩。

特别有趣的是概率图上采样的实验结果。研究团队发现,与其在高分辨率特征上进行分割,不如先在低分辨率上生成分割概率图,然后使用Upsample Anything将这些概率图放大。这种策略不仅计算效率更高,在准确度上也有显著提升。在COCO数据集上,这种方法将mIoU从61.41提升到63.40,精度从81.34提升到83.73。

在深度估计任务中,系统的优势更加明显。深度估计对细节的要求极高,因为即使微小的误差也可能导致自动驾驶系统做出错误判断。实验结果显示,Upsample Anything在RMSE指标上达到了0.498,显著优于竞争方法的0.513-0.796。在表面法线估计这个更具挑战性的任务上,系统同样表现出色,在各个角度阈值下都取得了最佳成绩。

研究团队还专门测试了系统在不同backbone架构下的表现。他们使用了DINOv1、DINOv2、DINOv3、CLIP以及ConvNeXt等不同的Vision Foundation Model,结果显示Upsample Anything在所有backbone上都能保持一致的优异表现。这种一致性证明了该方法的确是"backbone无关"的通用解决方案。

六、创新的3D扩展:从平面到立体的跨越

Upsample Anything最令人兴奋的扩展应用是其在3D特征处理方面的能力。研究团队展示了如何将原本设计用于2D图像的技术扩展到3D空间,这就像将平面画家的技能扩展到雕塑创作一样具有挑战性。

在3D扩展中,系统使用RGB-D数据(彩色图像加深度信息)作为指导信号。优化过程不仅考虑XY平面上的空间关系,还加入了Z轴(深度)方向的约束。每个低分辨率特征被扩展为一个3D的各向异性高斯核,能够沿着深度方向进行精确的插值和重建。

这种3D扩展的工作原理可以用考古学的层析重建来理解。考古学家通过分析不同深度的土层来重建古代遗址的三维结构,而Upsample Anything则是通过分析2D特征图来重建3D特征体积。系统学会了如何根据深度信息将2D特征"拉伸"到3D空间中,同时保持空间一致性和语义连贯性。

实验结果显示,即使没有显式的3D监督信号,重建出的3D特征体积也呈现出良好的深度连续性和边界保持能力。研究团队使用PCA可视化技术展示了不同深度层的特征,发现相邻深度层之间的特征变化平滑自然,而在物体边界处则保持了清晰的分界。

七、局限性与未来方向:技术的边界与可能

尽管Upsample Anything表现出色,但研究团队也诚实地指出了其局限性。最主要的限制出现在处理严重损坏或噪声极大的图像时。由于系统依赖于测试时优化来重建输入图像,当输入图像本身质量很差时,系统可能会"学习"到错误的模式。

这种限制可以用音乐教学来类比。如果你让一位音乐学生听一段严重失真的录音来学习演奏技巧,他很可能会把失真也当作音乐的一部分学会。同样,当输入图像包含大量椒盐噪声或严重模糊时,Upsample Anything可能会将这些伪影误认为是图像的真实特征。

研究团队通过对比实验展示了这种限制。在清晰图像上,Upsample Anything表现出色;但当图像包含10%或20%的随机噪声时,系统的重建结果也会包含相应的噪声。相比之下,预训练的方法如AnyUp由于已经在大量数据上学习了去噪能力,在噪声环境下表现更稳定。

另一个潜在限制是计算时间。虽然0.419秒的处理时间已经相当快,但对于需要实时处理的应用(如视频流处理或实时增强现实)来说,仍然可能不够理想。研究团队通过分析发现,大部分计算时间用于优化过程,而实际的特征渲染阶段非常快速。

未来的改进方向包括几个方面。首先是提高对噪声和损坏图像的鲁棒性,可能的解决方案包括在优化过程中引入去噪先验或使用更鲁棒的损失函数。其次是进一步提升计算效率,可以通过改进优化算法或使用更好的初始化策略来减少所需的迭代次数。

此外,研究团队也指出了一些有趣的扩展可能性。例如,可以将该技术应用到视频处理中,利用时间一致性约束来提升效果;或者扩展到其他类型的数据,如音频频谱图或医学影像的多模态数据。

八、实际应用前景:从实验室到现实世界

Upsample Anything的技术特性使其在多个实际应用领域具有巨大潜力。在医学影像领域,该技术能够帮助提升低分辨率扫描图像的质量,这对于远程医疗和资源受限地区的医疗服务具有重要意义。医生可以使用较低分辨率的设备获取初步图像,然后通过该技术获得足够清晰的细节进行诊断。

在自动驾驶领域,系统的快速处理能力和高精度深度估计能力使其成为理想的感知模块组件。车载计算资源往往受限,但安全性要求极高。Upsample Anything能够在有限的计算资源下提供高质量的环境理解能力,帮助车辆更准确地识别道路状况、行人位置和障碍物距离。

在卫星图像分析领域,该技术可以用来提升历史卫星数据的分析精度。许多珍贵的历史卫星图像由于技术限制分辨率较低,但使用Upsample Anything可以从中提取出更多有用信息,用于环境监测、城市规划和地质研究。

在消费电子领域,该技术可以集成到智能手机、平板电脑或增强现实设备中,为用户提供实时的图像增强功能。例如,在拍照时自动提升细节清晰度,或在视频通话中改善图像质量。

制造业也是一个重要的应用领域。质量控制和缺陷检测往往需要高分辨率图像,但高分辨率相机成本昂贵且产生的数据量巨大。使用Upsample Anything,制造商可以使用相对便宜的设备获取图像,然后通过算法提升到检测所需的分辨率。

说到底,Upsample Anything代表了计算机视觉领域的一个重要进步。它不是简单地提出了另一种图像处理算法,而是展示了如何巧妙地结合不同的数学技术,创造出既高效又通用的解决方案。这种"测试时学习"的思路也为其他领域的研究提供了启发,告诉我们有时候最好的解决方案不是预先训练一个万能模型,而是让系统具备快速适应新情况的能力。

研究团队的工作证明了,在人工智能快速发展的今天,创新往往来自于对现有技术的重新组合和深入理解,而不一定需要完全重新发明轮子。通过将Joint Bilateral Upsampling的经典智慧与Gaussian Splatting的现代技术相结合,他们创造出了一个既强大又实用的工具,为图像处理和计算机视觉的未来开辟了新的道路。

对于普通用户来说,这项技术最终可能体现在更好的相机应用、更清晰的视频通话和更准确的导航系统中。虽然大多数人不会直接与Upsample Anything打交道,但这项技术的影响将通过各种产品和服务渗透到日常生活的方方面面,让我们的数字世界变得更加清晰和精确。

Q&A

Q1:Upsample Anything的0.4秒处理速度是怎么做到的?

A:Upsample Anything使用了高效的各向异性高斯绘制技术,具有线性内存复杂度,避免了传统注意力机制的内存爆炸问题。同时,测试时优化只需要50次迭代就能收敛,大大减少了计算时间。

Q2:为什么说这个技术是"通用"的?

A:一旦系统在某张图像上学会了空间结构规律,这些规律不仅适用于彩色图像,还能直接应用到深度图、分割图等任何需要保持空间一致性的数据类型,甚至可以扩展到3D特征处理,就像掌握了通用的"空间语法"。

Q3:Upsample Anything在什么情况下效果不好?

A:当输入图像包含大量噪声或严重损坏时,系统可能会将这些伪影当作真实特征学习。由于依赖测试时优化重建输入图像,如果输入质量很差,系统就会"学坏",这是其主要局限性。

更多推荐

已为社区贡献398条内容

已为社区贡献398条内容

所有评论(0)