Context Engineering大模型开发实战:从Manus团队经验到6大核心技巧!

本文分享了Manus团队放弃传统Fine-tuning,转而通过Context Engineering挖掘LLM潜力的实战经验。详细介绍了六大核心策略:围绕KV-Cache的架构设计、Logit Masking解决工具爆炸、文件系统作为外置显存、背诵对抗注意力衰减、保留错误轨迹作为学习样本、引入结构化噪声避免少样本陷阱。核心观点是Agent开发应专注于Context的构建与管理,而非端到端模型训练

简介

本文分享了Manus团队放弃传统Fine-tuning,转而通过Context Engineering挖掘LLM潜力的实战经验。详细介绍了六大核心策略:围绕KV-Cache的架构设计、Logit Masking解决工具爆炸、文件系统作为外置显存、背诵对抗注意力衰减、保留错误轨迹作为学习样本、引入结构化噪声避免少样本陷阱。核心观点是Agent开发应专注于Context的构建与管理,而非端到端模型训练,以平衡成本、延迟、准确性和鲁棒性。

这篇文章是基于 Manus 团队的技术文章《Context Engineering for AI Agents[1]》整理而成。原文分享了他们在构建通用 Agent(Manus)过程中,如何放弃传统的 Fine-tuning 路线,转而通过深度优化的 Context Engineering 来挖掘前沿 LLM 潜力的实战经验。

个人觉得,这篇文章透露出的 insights 对于从事 Agent 开发、RAG 及推理优化的人很有参考价值。

用文章结尾的一句话做引言:

“The agentic future will be built one context at a time. Engineer them well.”

- Why Context Engineering?

===========================

在 LLM 应用开发中,通常面临两条路径:

- • Fine-tuning:训练端到端模型。缺点是反馈循环慢(周级),且容易被基座模型的升级淘汰。

- • In-Context Learning:基于强基座模型进行语境构建。

Manus 团队选择了后者,他们认为 Agent 开发的核心在于 Context Engineering,即如何构建和管理输入给模型的 Context。作者将这种通过人工尝试、Prompt 调整和架构搜索的过程戏称为 Stochastic Graduate Descent。

- 核心技术策略

=========

文章详细阐述了六个核心工程实践,来解决 Agent 在长周期任务中的 成本、延迟、准确性 和 鲁棒性 问题。

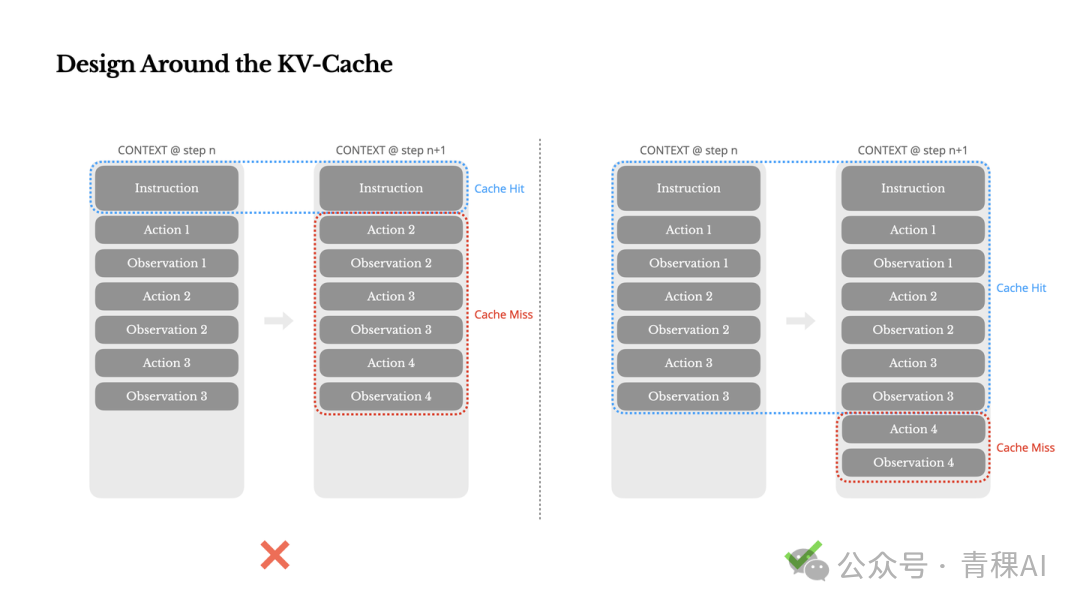

2.1 围绕 KV-Cache 进行架构设计

背景:Agent 场景的 Token 特征是 Input 极长(Context),Output 较短(Action),比例可达 100:1。因此,KV-Cache Hit Rate 是决定 TTFT (Time-to-First-Token) 和推理成本的最关键指标。

优化策略:

保持前缀稳定 (Prefix Stability):

- • 由于 Transformer 的自回归特性,Token t_i 的变更会导致 t_i 之后所有 KV Cache 失效。

- • ❌ Anti-Pattern:在 System Prompt 头部放入精确到秒的时间戳。

- • ✅ Best Practice:将动态信息移后,保持头部静态。

Append-only Context:

- • 严禁修改历史 Action/Observation。

- • 保证序列化的确定性,防止 JSON key 顺序变化导致 Cache Miss。

显式 Cache Breakpoints:

- • 在 System Prompt 结束等关键位置手动插入断点,适配不支持自动增量缓存的框架。

KV-Cache 在多轮对话中如何被复用及失效的示意图

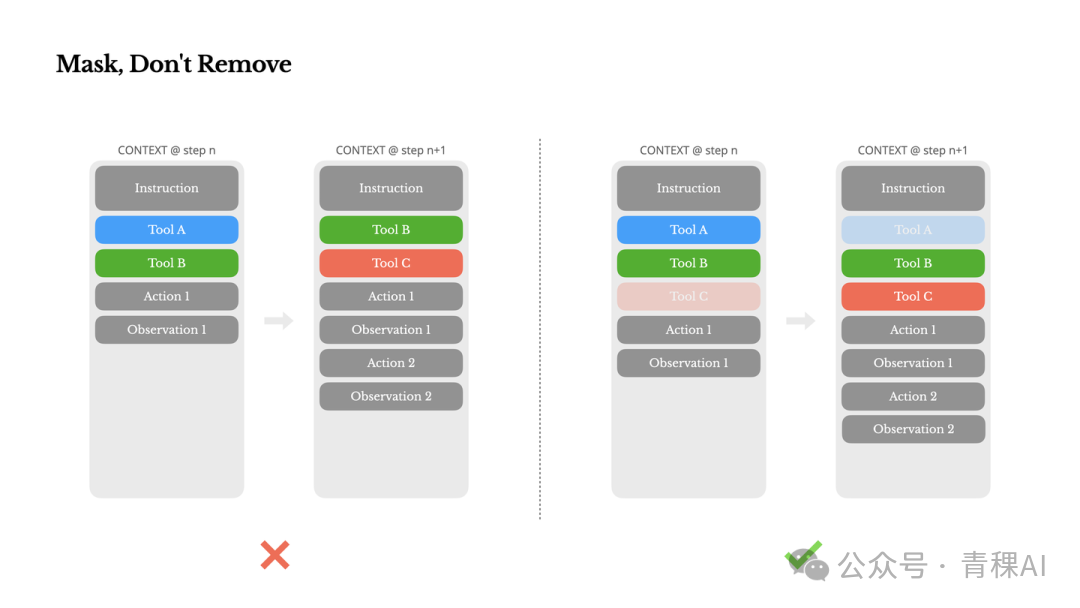

2.2 对 Logits 做 mask 解决 Tool 爆炸的问题

挑战:Agent 随能力扩展,Tool 数量爆炸。若全部放入 Context,会增加干扰;若动态移除(RAG-style),会导致 Cache 失效且模型困惑(Context 中有历史调用但定义已消失)。

解决方案:Logit Masking (Constrained Decoding) 利用有限状态机管理当前状态下可用的工具,在 Decoding 阶段直接修改 Logits 分布,将不可用工具的概率置为 -\infty,而不是修改 Prompt 中的工具定义。

实现细节:

- • 利用 im_start 等 token 进行 Response Prefill。

- • 工具命名规范化(如 browser_, shell_),便于基于前缀进行 Masking。

- • 三种调用模式控制:Auto (可选), Required (必选), Specified (指定子集)。

如何通过 Logit Masking 限制模型在特定状态下的动作选择

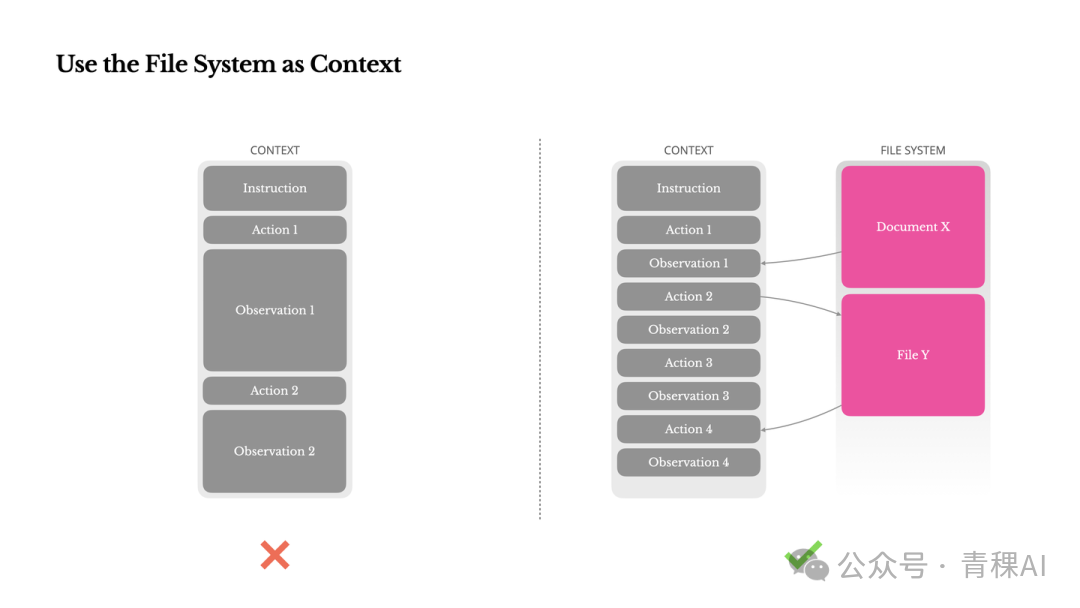

2.3 文件系统即外置显存

痛点:尽管 Context Window 达到 128k+,但 Observation(如网页、PDF)过大且昂贵,且长窗口会导致 Lost-in-the-middle 现象。

策略:

FS as Memory:

- • 将文件系统视为无限、持久的 Context。

可恢复压缩:

- • 在 Context 中不直接放入网页全文,而是保留 URL 或文件路径。

- • 模型学会使用工具 read_file(path) 按需加载数据。

- • 思想延伸:作者认为这种机制使得 Transformer 模拟了 Neural Turing Machine,并推测具备文件读写能力的 SSM (State Space Models) 可能是未来 Agent 的形态。

文件系统作为外部存储与 Context 交互的架构图

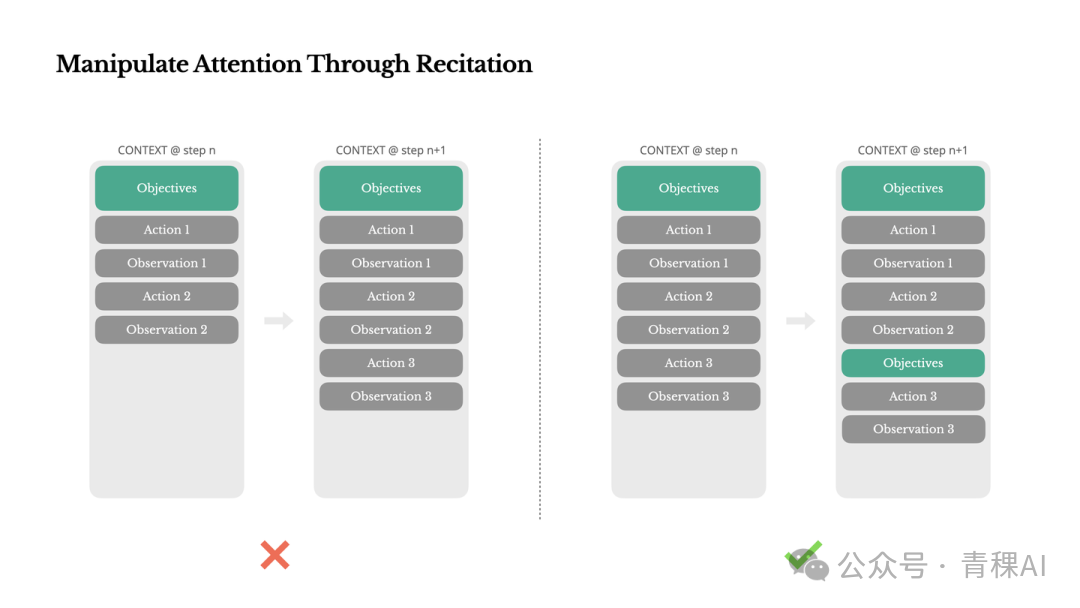

2.4 通过背诵(Recitation)对抗注意力衰减

现象:长任务(50+ steps)中,模型容易遗忘初始目标。

机制:Todo List Recitation。 Agent 维护一个 todo.md 文件,并在每一步更新它。这不仅仅是记录,更是一种 Attention Engineering。通过不断在 Context 末尾背诵当前进度和剩余目标,强行将 Global Plan 拉入模型的 最近注意力区域。

注:通过将目标放在 K, V 的末端,利用 Recency Bias 增强模型对目标的关注。

Manus 运行过程中 todo.md 的动态更新示例

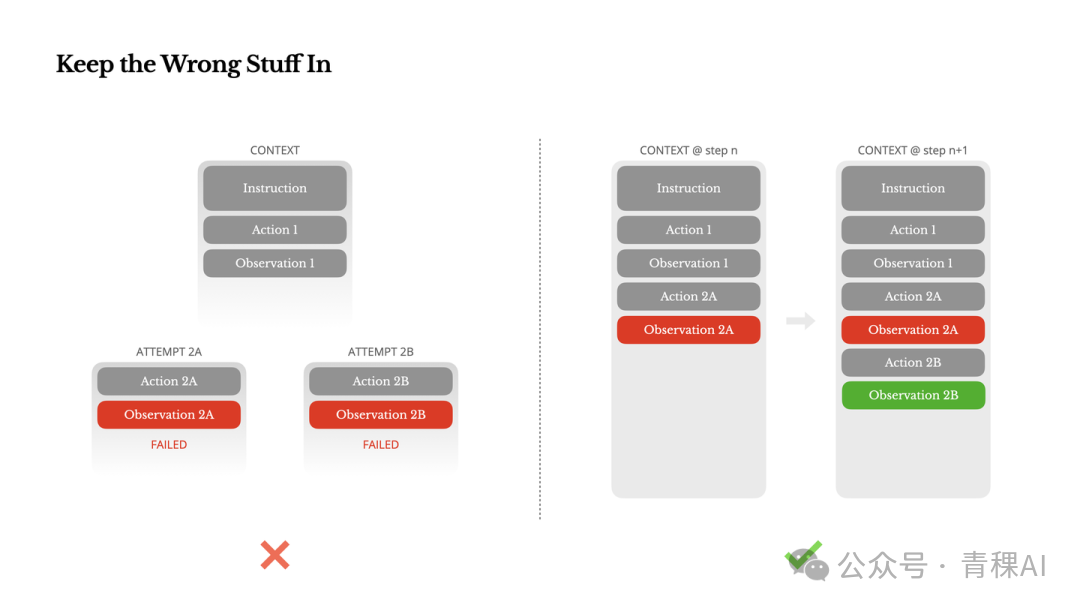

2.5 保留错误轨迹

反直觉洞察:Agent 犯错是必然的。

- • ❌ 常见做法:隐藏错误,重置状态重试(以此保持 Context 干净)。

- • ✅ Manus 做法:保留错误的 Action 和报错的 Observation。

原理:错误轨迹构成了负样本(Negative Prompting)。当模型看到 Action A -> Error,它会更新内部信念,降低再次选择 A 的概率。Error Recovery 是 Agent 智能的重要体现,抹除错误等于抹除学习机会。

展示保留错误轨迹如何帮助模型进行自我修正

2.6 避免少样本陷阱

风险:LLM 是强模仿者。如果 Context 中充满了重复的、类似的“动作-观察”对(例如批处理20份简历),模型会陷入 Pattern Repetition,导致过拟合、死循环或幻觉。

对策:引入结构化噪声。

- • 在序列化模板、措辞、顺序上引入微小的随机变化。

- • 目的:打破 Context 的单一模式,强迫模型每次都进行推理而非单纯的补全。

- 个人总结

=======

这篇文章讨论当前 Agent 系统从 Demo 走向 Production 中遇到的核心问题:如何在有限的 Context Window 和昂贵的推理成本下,维持 Agent 的长期规划能力和稳定性。

文章中给出了 Manus 自己的解法:

1、KV-Cache 是生命线:Agent 的系统设计必须向 Cache 机制妥协(如放弃 System Prompt 中的动态时间戳)。

2、推理时干预好过提示词工程:通过 Logit Masking 控制生成,比单纯写复杂的 System Prompt 更可靠、更节省 Context。

3、Context 并非越大越好:学会利用外部存储(文件系统)和动态加载,保持 Context 的流动性和高信噪比。

4、接受错误:Agent 的鲁棒性来自于从错误中恢复的能力,而非仅仅依靠一次成功的规划。

最后唠两句

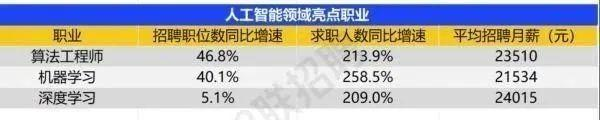

为什么AI大模型成为越来越多程序员转行就业、升职加薪的首选

很简单,这些岗位缺人且高薪

智联招聘的最新数据给出了最直观的印证:2025年2月,AI领域求职人数同比增幅突破200% ,远超其他行业平均水平;整个人工智能行业的求职增速达到33.4%,位居各行业榜首,其中人工智能工程师岗位的求职热度更是飙升69.6%。

AI产业的快速扩张,也让人才供需矛盾愈发突出。麦肯锡报告明确预测,到2030年中国AI专业人才需求将达600万人,人才缺口可能高达400万人,这一缺口不仅存在于核心技术领域,更蔓延至产业应用的各个环节。

那0基础普通人如何学习大模型 ?

深耕科技一线十二载,亲历技术浪潮变迁。我见证那些率先拥抱AI的同行,如何建立起效率与薪资的代际优势。如今,我将积累的大模型面试真题、独家资料、技术报告与实战路线系统整理,分享于此,为你扫清学习困惑,共赴AI时代新程。

我整理出这套 AI 大模型突围资料包【允许白嫖】:

-

✅从入门到精通的全套视频教程

-

✅AI大模型学习路线图(0基础到项目实战仅需90天)

-

✅大模型书籍与技术文档PDF

-

✅各大厂大模型面试题目详解

-

✅640套AI大模型报告合集

-

✅大模型入门实战训练

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(0基础到项目实战仅需90天)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤640套AI大模型报告合集

⑥大模型入门实战训练

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献464条内容

已为社区贡献464条内容

所有评论(0)