【AI课程领学】第九课 · 激活函数(课时6) RReLU:训练时随机斜率的正则化激活;(课时7) ELU:用指数形式让负区间更“柔和”,提升收敛(含与 ReLU/LeakyReLU 对比)

【AI课程领学】第九课 · 激活函数(课时6) RReLU:训练时随机斜率的正则化激活(适合小数据的“带噪激活”)(课时7) ELU:用指数形式让负区间更“柔和”,提升收敛(含与 ReLU/LeakyReLU 对比)

·

【AI课程领学】第九课 · 激活函数(课时6) RReLU:训练时随机斜率的正则化激活(适合小数据的“带噪激活”)(课时7) ELU:用指数形式让负区间更“柔和”,提升收敛(含与 ReLU/LeakyReLU 对比)

【AI课程领学】第九课 · 激活函数(课时6) RReLU:训练时随机斜率的正则化激活(适合小数据的“带噪激活”)(课时7) ELU:用指数形式让负区间更“柔和”,提升收敛(含与 ReLU/LeakyReLU 对比)

文章目录

欢迎铁子们点赞、关注、收藏!

祝大家逢考必过!逢投必中!上岸上岸上岸!upupup

大多数高校硕博生毕业要求需要参加学术会议,发表EI或者SCI检索的学术论文会议论文。详细信息可扫描博文下方二维码 “

学术会议小灵通”或参考学术信息专栏:https://ais.cn/u/mmmiUz

详细免费的AI课程可在这里获取→www.lab4ai.cn

前言

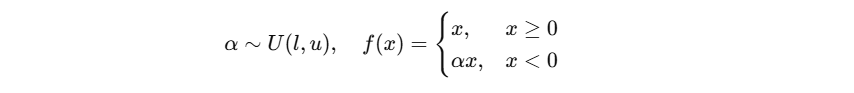

- RReLU(Randomized ReLU)把负区间斜率设为随机变量:

训练时:

- 推理时使用期望 α = l + u 2 α=\frac{l+u}{2} α=2l+u。

它的直觉是:

- 在激活层注入随机性,起到类似 dropout 的正则化作用。

1. PyTorch 使用

import torch.nn as nn

act = nn.RReLU(lower=0.1, upper=0.3)

2. 适用场景与注意点

适用:

- 小数据集、容易过拟合

- 希望引入轻量正则化

注意:

- 并非所有任务都稳定收益

- 与 BN/Dropout 同时使用时需观察收敛

3. 可运行示例:训练/推理行为不同

import torch

import torch.nn as nn

act = nn.RReLU(0.1, 0.3)

x = torch.tensor([-2.0, -1.0, 1.0])

act.train()

print("train:", act(x))

act.eval()

print("eval :", act(x))

前言

ELU(Exponential Linear Unit)希望结合两点:

- 正区间像 ReLU 一样不饱和

- 负区间不为 0,输出更平滑且均值更接近 0

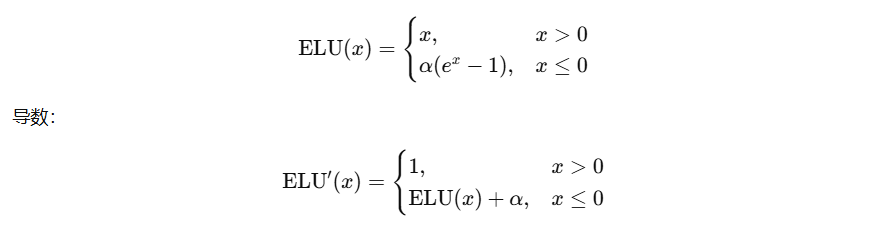

1. 定义

2. 直觉与优缺点

优点:

- 负区间输出为负值,均值更接近 0(有助优化)

- 比 ReLU 更平滑,可能收敛更稳定

- 不容易完全“死掉”

缺点:

- 计算比 ReLU 贵(exp)

- α 需要调(常用 1.0)

3. PyTorch 使用

import torch.nn as nn

act = nn.ELU(alpha=1.0)

4. 画 ELU 曲线

import numpy as np

import matplotlib.pyplot as plt

x = np.linspace(-5, 5, 400)

alpha = 1.0

elu = np.where(x > 0, x, alpha*(np.exp(x)-1))

plt.figure()

plt.plot(x, elu)

plt.title("ELU")

plt.show()

更多推荐

已为社区贡献35条内容

已为社区贡献35条内容

所有评论(0)