自动驾驶大模型---语音指令如何传递给模型

本文探讨了自动驾驶中语音指令如何通过大模型实现车辆控制。首先介绍理想等多家车企的VLA大模型应用现状。随后详细解析语音控车流程:VLA模型通过整合摄像头、定位等多源数据,经视觉编码器、LLM和解码器处理后输出控制轨迹。重点对比了早期固定接口式语音控制与大模型时代的自然语言处理差异,并以限速15kph;指令为例说明文本特征到运动轨迹的转换机制。最后引用案例,说明其停车场自主寻路功能已突破固定指令限制

1 前言

在之前的车企大模型系列中,朋友们所熟知的VLA大模型的车企有理想,小鹏,元戎等几家公司,详细的模型架构见如下文章:

但目前实现语音控车的只有理想一家,特斯拉只是主动选择需要的声音去影响模型的决策,用户只能通过车机的Grok模型进行对话,确定导航信息。那么语音指令是如何传递给大模型,并且最终实现控车的任务呢?本篇博客主要介绍这方面的知识。

2 语音控车

笔者主要从VLA模型架构,信号传输过程,最终呈现在什么地方,实现控车的功能。在自动驾驶领域,目前量产的所有的大模型输出的最终产物均为轨迹,因此所有的信息几乎都体现在轨迹当中。

2.1 VLA大模型架构

输入:摄像头信息 + 定位信息 + 导航信息 + 地图信息 + 语音(文字)信息;

模型:Vision Encoder + LLM大语言模型 + Decoder;

输出:轨迹。

2.2 语音信息处理

(1)早期语音信息处理

语音控制智能辅助驾驶功能,如“开快点”、“开慢点”、“超车”等指令,是通过语音去调用辅助驾驶系统中固定且有限的接口,比如导航数据、功能的启动、速度设定、泊车位置选择等。这种交互,就像在操作一个有固定按键的计算器。

(2)大模型时代语音信息

用户输入的语音信息和摄像头看到的文字信息相似,有着相同的处理逻辑。

语音/文字--->llm的tokenlizer--->feature--->decoder

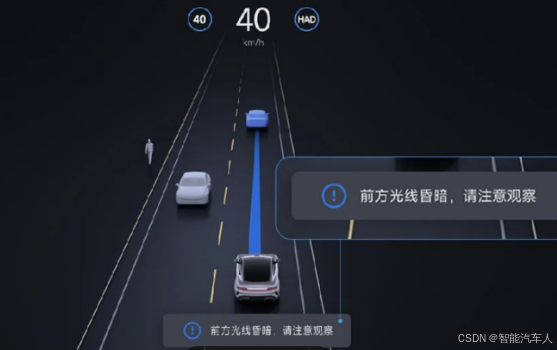

针对指令“将速度降到15kph”或者前视摄像头读取到的道路限速信息“15”,这里用语音指令举例。语音指令经过文本化之后,进入LLM,LLM会输出一个限速的feature,再经过解码器decoder解码,输出的每一个轨迹点的速度不能超过15kph。

2.3 厂家说明

某汽车企业在QA环节,简单的说明了其原理。

比如 “停车场自主寻路” 功能,超出了以上这些固定接口需求,在没有任何形式的地图、导航或记忆路线的情况下,听懂人的自然交互指令,看懂停车场里的标识和文字,理解环境,并且把这些思考转化为执行动作(其实并没有到action的层面),从操作固定按键的计算器变成了可以自然、自由交互的 “机器人司机”。

3 总结

本篇博客主要探讨了自动驾驶中语音指令如何通过大模型实现车辆控制。通过介绍理想、小鹏、元戎以及特斯拉等几家车企的大模型应用现状。

并且详细解析语音控车流程:VLA模型通过整合摄像头、定位等多源数据,经视觉编码器、LLM和解码器处理后输出控制轨迹。

更多推荐

已为社区贡献16条内容

已为社区贡献16条内容

所有评论(0)