PhysBrain:以人类自我中心数据为桥梁,连接视觉-语言模型和物理智能

25年12月来自香港科大(广州)、中关村学院、中关村AI研究所、北京机智赛博智能科技有限公司(DeepCybo)、哈工大和华中科大的论文“PhysBrain: Human Egocentric Data as a Bridge from Vision Language Models to Physical Intelligence”。机器人泛化依赖于物理智能:即在以自我为中心的感知和行动框架下,推

25年12月来自香港科大(广州)、中关村学院、中关村AI研究所、北京机智赛博智能科技有限公司(DeepCybo)、哈工大和华中科大的论文“PhysBrain: Human Egocentric Data as a Bridge from Vision Language Models to Physical Intelligence”。

机器人泛化依赖于物理智能:即在以自我为中心的感知和行动框架下,推理状态变化、进行丰富的接触式交互以及进行长远规划的能力。然而,大多数VLM主要基于第三人称视角数据进行训练,这导致人形机器人存在根本性的视角不匹配问题。由于成本高昂且数据多样性有限,大规模收集机器人以自我为中心的数据仍然不切实际,而大规模的人类以自我为中心的视频则提供一种可扩展的替代方案,能够自然地捕捉丰富的交互上下文和因果结构。关键挑战在于如何将原始的以自我为中心的视频转换为结构化且可靠的具身训练监督数据。因此,本文提出一种以自我为中心-到-具身的转换流程,该流程将第一人称视角视频转换为多级、议程(schema)驱动的视觉质量评估(VQA)监督数据,并强制证据落地和时间一致性,从而能够大规模构建以自我为中心-到-具身的数据集(E2E-3M)。通过E2E-3M数据集的训练,获得一个具有自我中心感知能力的具身大脑,称为PhysBrain。 PhysBrain展现出显著提升的自我中心理解能力,尤其是在EgoThink规划方面。它提供一种感知自我中心的初始化方法,能够实现更高效的VLA微调和更高的SimplerEnv成功率(53.9%),证明从人类自我中心监督到下游机器人控制的有效迁移。

由于机器人与操作员之间配置要求严格且依赖专家远程操作,机器人数据采集难以规模化。基于以自我为中心人类演示训练的以自我为中心的VLA,提供一条更具可扩展性的途径,具有提升感知-动作学习和实际应用能力的巨大潜力。EgoVLA(Yang,2025b)利用缩放后的以自我为中心的视频以及统一的人机动作空间,并结合轻量级的机器人微调,实现了高效的技能迁移和显著的性能提升。Being-H0(Luo,2025)利用离散的手部运动编码(毫米级)进行物理指令调优,并借助物理对齐的跨视图空间,支持从人类视频中进行精细的VLA训练。H-RDT(Bi,2025)使用3D手部姿态进行大规模的双手动预训练,并采用两阶段、2B参数的扩散策略,取得显著的性能提升。 GR-3(Cheang,2025)利用多源训练(网络、虚拟现实、机器人轨迹),实现了强大的泛化能力、快速的少样本自适应以及鲁棒的长时域双手动和移动控制。RynnVLA-001(Jiang,2025)基于大规模人类视频演示进行预训练,并以视频生成为目标,通过ActionVAE将动作压缩到连续的潜空间,从而使视频预测与下游机器人微调保持一致。VITRA(Li,2025c)将人手视为智体末端执行器,将自然场景中以自我为中心的手部视频转换为与机器人对齐的格式,并将VLM与基于扩散的动作专家相结合进行策略学习。

与成本高昂且难以扩展的机器人数据相比,人类第一人称视角视频提供一种天然可扩展自我为中心的监督数据来源,涵盖了各种日常行为和环境。这种数据模式能够提供与真实交互分布高度吻合的观察结果,从而用于学习具身大脑。诸如 Ego4D (Grauman et al., 2022)、BuildAI (BuildAI, 2025) 和 EgoDex (Hoque et al., 2025) 等大规模数据集表明,以自我为中心的视频能够大规模地捕捉长时程活动、人机交互以及精细的操作动态。一个尚未解决的问题是,如何利用人类以自我为中心视频中潜在的规划结构和手-物交互规律作为监督信息,在缺乏机器人数据的情况下增强以自我为中心的具身大脑,从而提高VLA 系统的样本效率和泛化能力。

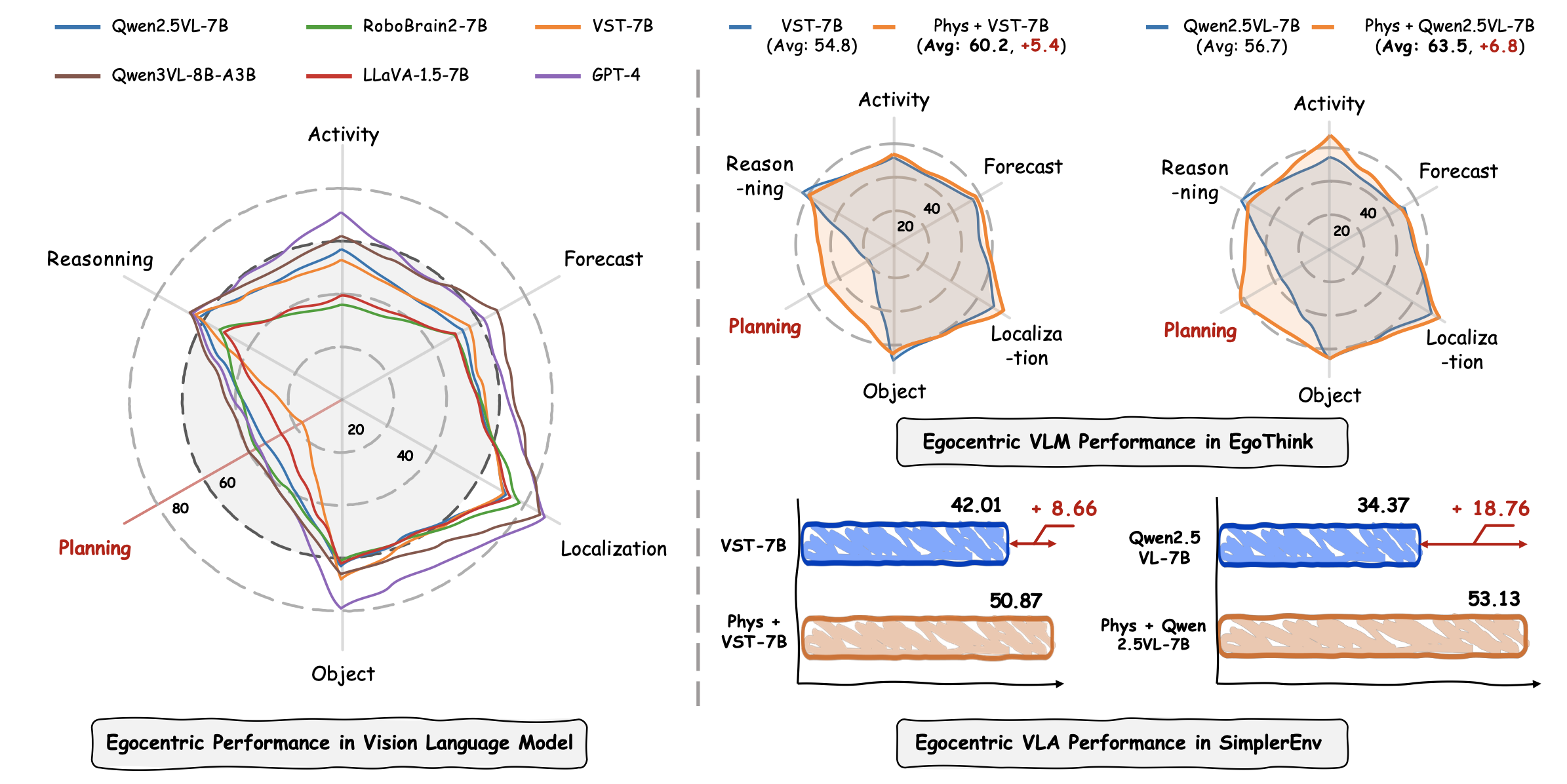

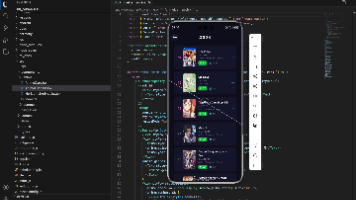

这些方法依赖于将人类演示与机器人动作空间显式对齐,而这种对齐本身受到人类与机器人之间具身差异的制约。相比之下,本文工作着眼于更上游的目标,将以自我为中心的人类数据转化为具身大脑的具身监督信号,从而提供了一个可扩展的基础,以补充基于机器人数据的管道。其开发一种可扩展的标注和指导流程,将人类以自我为中心的视频转换为结构化的、多级第一人称视角视频质量评估(VQA)监督信息,用于具身大脑学习。每个VQA实例编码多级的互补信息,包括规划分解、关键状态、交互约束和时间关系,从而提供超越静态视觉识别的监督信息。为了直接评估这种监督信息的有效性,仅使用EgoDex衍生的VQA数据进行一项受控评估,如图所示。基于不同VLM骨干网络训练的具身大脑模型在作为具身大脑进行评估时,始终优于其对应的基础模型。在此设置下,所得模型能够在第一人称视角VLA任务上实现高效的少样本自适应,并达到与使用大规模机器人数据训练的VLA系统相当甚至更高的性能,尽管没有任何机器人数据预训练。左图:EgoThink 雷达图比较代表性基线模型在六个维度(活动、预测、定位、对象、规划、推理)上的以自我为中心VLM 性能。右上图:“Phys”表示 VLM 在标注的第一人称(以自我为中心)数据上进行监督微调,VST-7B 和 Qwen2.5-VL-7B 的 EgoThink 性能均显著提升,尤其是在规划方面提升最为显著。右下图:当用作标准 VLA 微调流程中的 VLM 主干时,经过 Phys 增强的主干显著提高 SimplerEnv 的成功率,表明更好的以自我为中心规划和交互推理能够转化为更优的下游操作。

从自我中心-到-具身认知的转换流程

人类以自我为中心的视频编码丰富的具身经验,包括动作进程、手-物交互以及任务层面的结构。然而,这些经验无法直接用于训练具身大脑。原始视频缺乏明确的结构,自由形式的语言标注不稳定,而无约束的生成往往会引入时间上的歧义或幻觉般的交互。

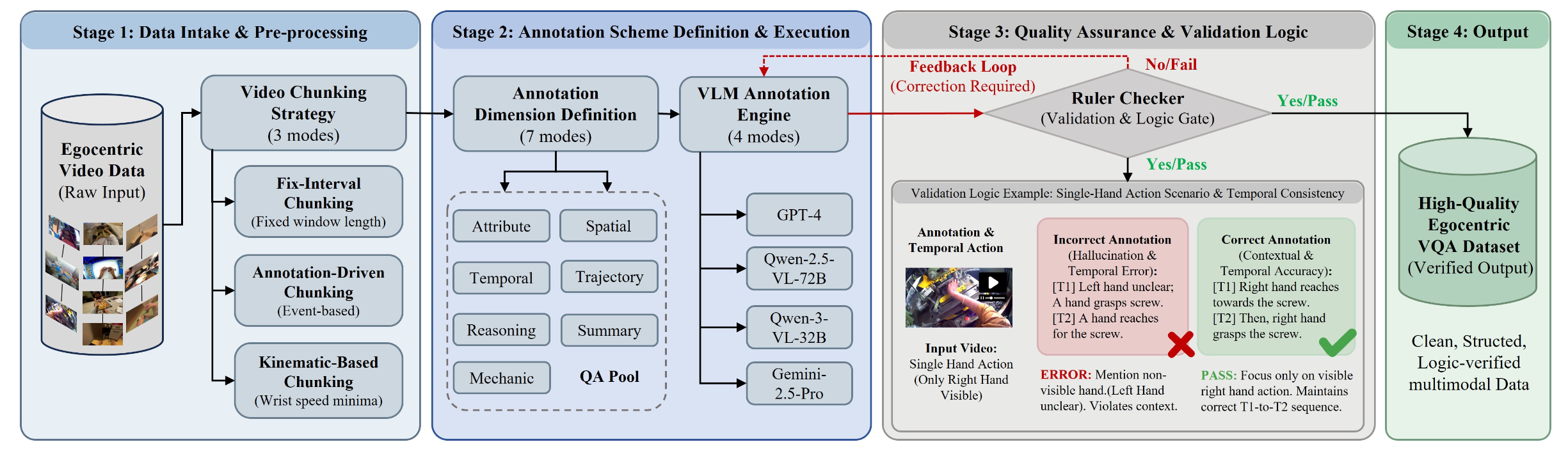

核心思想是将以自我为中心的人类数据转换为结构化且可验证的监督信息,以捕捉具身行为的分级结构,涵盖动作语义、时间组织、交互动态和任务层面的推理。为此,设计一个议程(schema)驱动、规则验证的以自我为中心的视频质量保证(VQA)数据引擎(如图所示),该引擎系统地将原始的以自我为中心的人类视频转换为与具身规划和交互推理相一致的多级监督信息。

自我中心-到-具身的数据集 (E2E-3M)

数据来源和领域覆盖范围

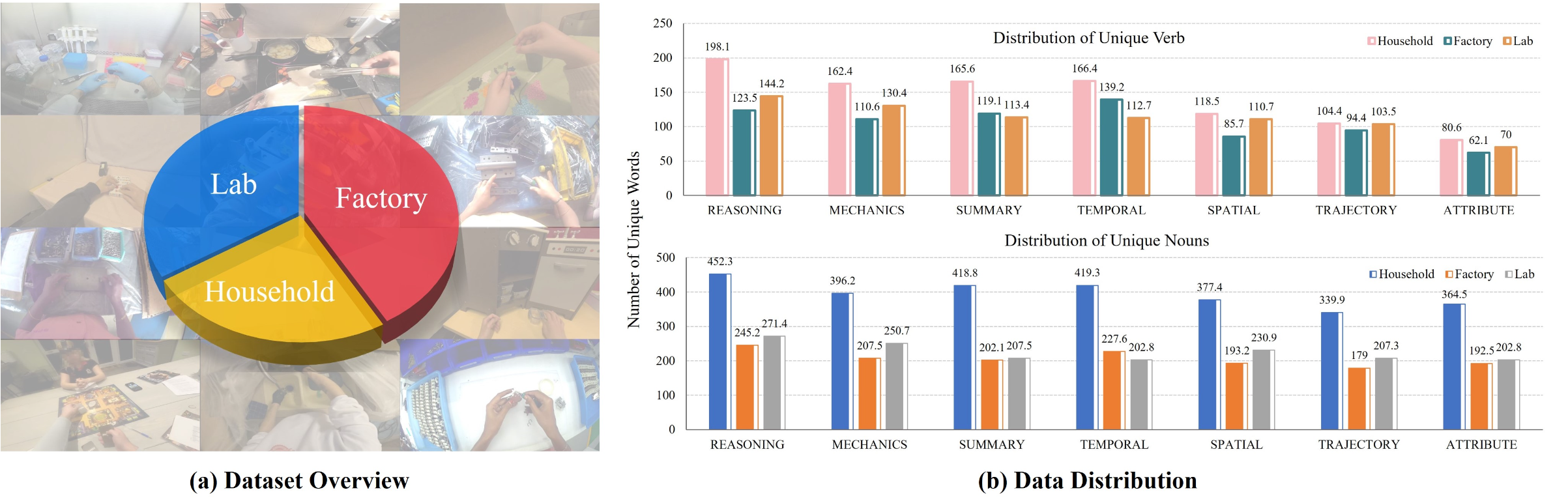

本文提出的自我中心-到-具身转换流程应用于大规模的人类自我中心视频语料库,这些语料库收集于三个互补领域:家庭、工厂和实验室环境,如图 (a) 所示。这些语料库总共包含数千小时的自我中心视频,并捕捉环境背景、物体组成和交互模式的显著差异。

具体而言,Ego4D 代表开放世界的家庭活动,提供广泛的地理和情境多样性。BuildAI 捕真实的工业工作流程,强调工厂环境中的程序规律性和密集的手部可见性。EgoDex 专注于实验室环境,并提供具有精细交互线索的高分辨率自我中心操作序列。这些数据源在空间布局、物体分布和任务结构方面存在系统性差异。聚合后得到的 自我为中心-到-具身数据集在自我中心具身化体验领域具有互补的覆盖范围。

多样性分析

为了评估数据集是否为具身规划和交互提供足够丰富的监督信息沿着两个可解释的维度分析多样性:目标覆盖率和动作(动词)覆盖率,如上图 (b) 所示。这些维度对应于交互中涉及的实体以及这些交互的执行方式。

目标覆盖率衡量数据集标注中出现的不同对象的数量。它反映了所捕获的感知和交互上下文的广度。对于每个领域 s,目标覆盖率ObjectDiv的计算公式为:Vnoun_s 是域 s 中唯一名词词元的数量,Tnoun_s 是域 s 中名词词元的总数。

目标覆盖率值被分为四个描述性范围:低级(< 200)、中级(200–300)、高级(300–350)和非常高级(≥ 350)。

如上图 (b) 所示,家庭数据处于高到非常高的覆盖范围,展现开放环境典型的广泛目标多样性。实验室数据处于中级范围,与较为有限的实验目标集相符。工厂数据则呈现低级到中级的覆盖率,反映特定域部件和工具的重复使用。这些域差异证实,不同来源的目标覆盖率是互补的,而非统一的。

动作覆盖率量化交互动词的多样性,并反映操作语义的丰富性。根据 VQA 模式评估动词多样性,因为不同的模式旨在强调具身行为的不同方面。在功能子集内测量覆盖率符合词汇多样性分析的标准做法,并能够实现模式感知的比较。

动词多样性VerbDiv通过计算得出,其中 |Vverb_m| 表示模式 m 中唯一动词词条的数量,N_m 表示该模式下的 QA 对数量。得分以每 1000 个 VQA 对中不同动词的数量表示。VerbDiv 值被归纳为四个描述性范围:低 (< 80)、中 (80-120)、高 (120-160) 和非常高 (≥ 160)。

根据 VerbDiv 指标衡量,包括推理、机制、时间性和概括在内的动作为中心模式在各个域普遍表现为极高水平。空间、轨迹和属性模式则大多处于中等水平。这种区分在各个域保持一致,并且与每种模式的预期作用相符。这表明动词覆盖率是模式特定的且受控的,而不是均匀分布在所有标注中。

E2E-3M 数据集通过提供具有广泛场景覆盖和丰富动作多样性的结构化监督,将人类自我为中心的视频与具身大脑学习联系起来。发布此数据集能够支持未来对自我为中心VLA和物理智能的研究。

利用这个数据标注流程,将自我为中心视频中的具身经验转化为适用于学习具身大脑的结构化监督信息。这一过程生成 E2E-3M 数据集,其中包含约 300 万个 VQA 语料库。为了在监督微调 (SFT) 过程中保持通用的视觉语言能力,还混合一个从 FineVision(一个大规模的精选视觉-语言语料库)中抽取的等量子集。然后,用该混合数据集对基础视觉-语言模型(例如 Qwen2.5-VL-7B)进行监督微调,从而得到一个以自我为中心视觉-语言模型骨干(PhysBrain),该模型具有更强的第一人称理解、推理和规划能力。

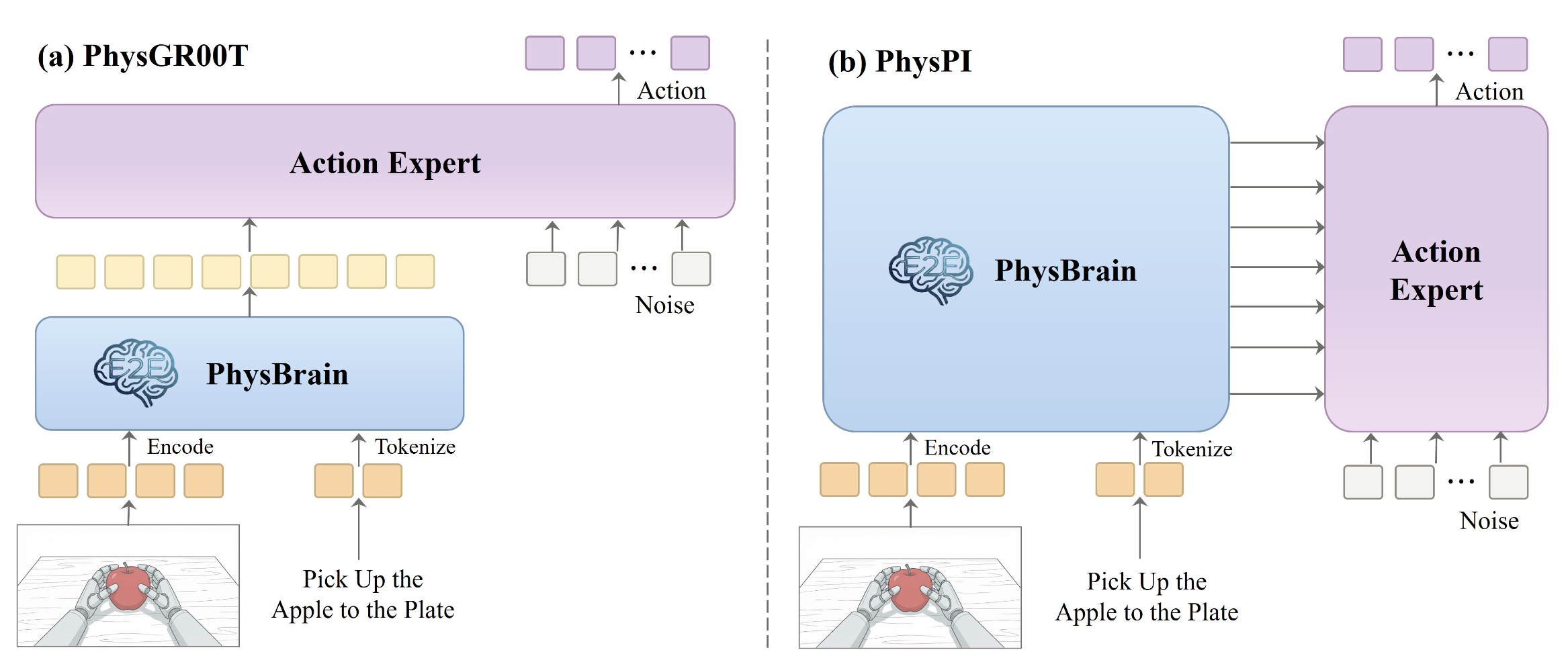

有了 PhysBrain,研究这些自我为中心的改进如何在VLA实例化下迁移到下游控制。目标并非提出新的VLA架构,而是在尽量减少额外启发式方法或手工设计先验信息带来的混淆因素同时,评估其可迁移性。遵循两种被广泛采用的社区范式:GR00T风格和Pi风格,并保持动作专家在两种范式中轻量级且一致。建在PhysBrain之上的VLA架构如图所示:

将观测值(一段简短的以自我为中心的图像序列)记为o_t,语言指令记为x,VLM参数记为φ。VLM生成token级隐状态Hl_t = VLM_φ(o_t,x)[l]。动作策略预测未来的动作块a_t:t+K。

PhysGR00T(GR00T风格的VLA)。引入 PhysGR00T,它遵循 GR00T N1.5(Bjorck,2025)中的双系统设计:VLM 作为系统 2,用于生成高层多模态表示;而流匹配(FM)动作专家(Liu,2022)作为系统 1,用于生成连续动作。具体而言,PhysGR00T 使用 VLM 的最后一层隐状态 Z_t = HL_t 作为条件信号。

流匹配(FM)专家采用扩散transformer(DiT)(Peebles & Xie,2023)实现,它通过交叉关注 Z_t 来对动作轨迹进行去噪(VLM 特征是K/V对,动作token是查询 Q)。在整流参数化下,对高斯噪声 ε ∼ N (0, 1) 和时间标量 τ ∈ (0, 1] 进行采样,然后在噪声和目标动作块之间进行线性插值,得到带噪声的轨迹 a ̃: a ̃ = (1 − τ ) ε + τ a, v = a − ε,这里 v 是目标(与时间无关)速度,它在该参数化下将噪声轨迹传递到数据轨迹。动作专家模型基于 VLM 特征(以及可选的本体感觉状态 s_t)预测该速度场:vˆ = f_θ(a ̃, τ; Z_t, s_t),并使用简单的回归目标 L_FM 进行训练。

在推理阶段,从噪声开始,应用少量 FM 去噪步骤(用 steps = 8)来获得动作块 a_t:t+K。 K=16。此设计提供一个受控环境,用于检验自我为中心 VLM 表示 Z_t 对动作预测的信息量。

PhysPI(一种 Pi 风格的 VLA)。还实例化一个 Pi 风格的 VLA,称为 PhysPI,其设计理念与 π0(Black,2024)类似,其中 VLM 主干与动作专家更紧密地耦合。与仅使用最后一层 VLM(如 PhysGR00T)不同,PhysPI 使用多个 VLM 层来约束 DiT 块。设 M 为动作 DiT 中 Transformer 块的数量;取最后 M 个 VLM 隐状态 Z_t = HL−M+1_t,…,HL_t,并通过交叉注意机制,逐层将它们注入到 DiT 中:u(i+1) = DiTBlock _i (Q = u(i), KV = HL−M+i_t), i = 1,…,M,其中u(0) 是嵌入的(带噪声的)动作 token序列。FM 训练目标保持不变,仍为 L_FM。

PhysPI 中的逐层条件化增强中间 VLM 表征与动作专家之间的耦合。这能够测试分布在 VLM 层上自我为中心的改进是否能更有效地用于控制。

自我中心理解评估

为了在公平且无泄漏的环境下验证自我中心理解,用 EgoThink(Cheng,2024)进行评估。EgoThink 是一个广泛使用的自我中心推理基准数据集,基于 Ego4D 构建。由于 Ego4D 包含在 E2E 数据集中,因此在准备 PhysBrain 以进行 EgoThink 评估时,训练方案排除 Ego4D 部分。PhysBrain 仅使用非 Ego4D 子集进行训练,包括 EgoDex(实验室)和 BuildAI(工厂),并与等规模的通用指令数据样本混合,以保留其通用的视觉语言能力。

基线。主要将本文方法与两类基线模型进行比较:(i) VLM,包括 GPT-4 等闭源模型和广泛使用的开源模型(MiniGPT-4-7B、LLaVA-1.5-7B、LLaMA-3.2-11B 和 Qwen2.5-VL-7B);(ii) 具身认知模型,包括 VST-RL-7B (Yang,2025a) 和 RoboBrain2.0-7B (Team,2025),以便进行全面评估。

评估。用已发布的权重进行直接推理来评估比较方法。所有模型的评估条件均已标准化。所有模型均使用相同的提示模板,并且所有 EgoThink 子任务的生成输出均使用单一的 GPT-4o (Hurst,2024b) 评判协议进行评分。这些控制措施确保性能差异反映的是模型能力,而非数据泄露、提示性变化或评分不一致。

基于 E2E 数据集的补充评估

为了进一步验证所提出的 E2E 数据集有效性和补充性,仅使用 E2E 数据在视觉空间微调(VST)模型进行监督微调 (SFT),而不引入任何空间能力训练 (SAT) 特有的训练样本,从而评估SAT。VST作为基础模型,因为它在大规模、高质量的空间智能数据集上进行预训练,因此为静态和目标为中心的空间推理提供强大的先验知识。这种设置能够评估 E2E 监督是否能提供补充优势,尤其是在自我中心和动态空间推理方面,超越现有的空间智能训练。

VLA仿真评估

为了验证模型作为机器人控制的VLA部署有效性,采用PhysBrain作为VLM骨干网络,并使用下游机器人数据在VLA范式中对其进行微调。然后,用WidowX机器人,在SimplerEnv(Li,2024c)仿真基准上进行评估。

实验设置

架构。用PhysGR00T 和 PhysPI 架构实例化 VLA 模型。VLM 组件使用 PhysBrain 的权重进行初始化,而动作专家组件则使用随机权重进行初始化。

训练。为了使 VLM 适应 VLA 架构和目标机器人平台,遵循 starVLA (starVLA Community, 2025) 框架的训练配置,并在 Open X-Embodiment (OXE) (O’Neill et al., 2024) 数据集的两个子集上对 VLA 进行微调:Bridge (Walke et al., 2023) 和 Fractal (Brohan et al., 2023)。每次训练运行大约需要 22 小时,使用 8 个 NVIDIA H100 GPU。

评估。该基准测试包含四个操作任务:“将勺子放在毛巾上”、“将胡萝卜放在盘子上”、“将绿色积木堆放在黄色积木上”、“将茄子放入黄色篮子中”。对于每个任务,用 SimplerEnv 代码库提供的官方评估脚本(Li ,2024c)来评估 VLA 策略。为了降低随机性,运行五次独立的试验,并报告平均性能。

基线。主要将方法与两类基线进行比较:(i)VLA 基线,其中包括几个广泛使用的 VLA 模型(RT-1-X、Octo、OpenVLA、RoboVLM、TraceVLA、SpatialVLA、CogACT、VideoVLA 和 π0);以及(ii)VLM 基线,其中在 VLA 范式下微调几个常用的 VLM 模型(RoboBrain2.0、VST-RL 和 Spatial-SSRL),并使用与方法相同的训练配置对其进行评估。

更多推荐

已为社区贡献172条内容

已为社区贡献172条内容

所有评论(0)