大模型如何避免“幻觉”(编造事实)?

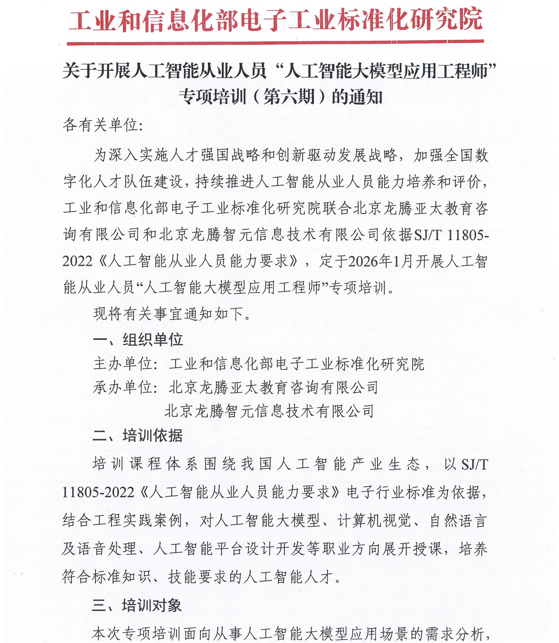

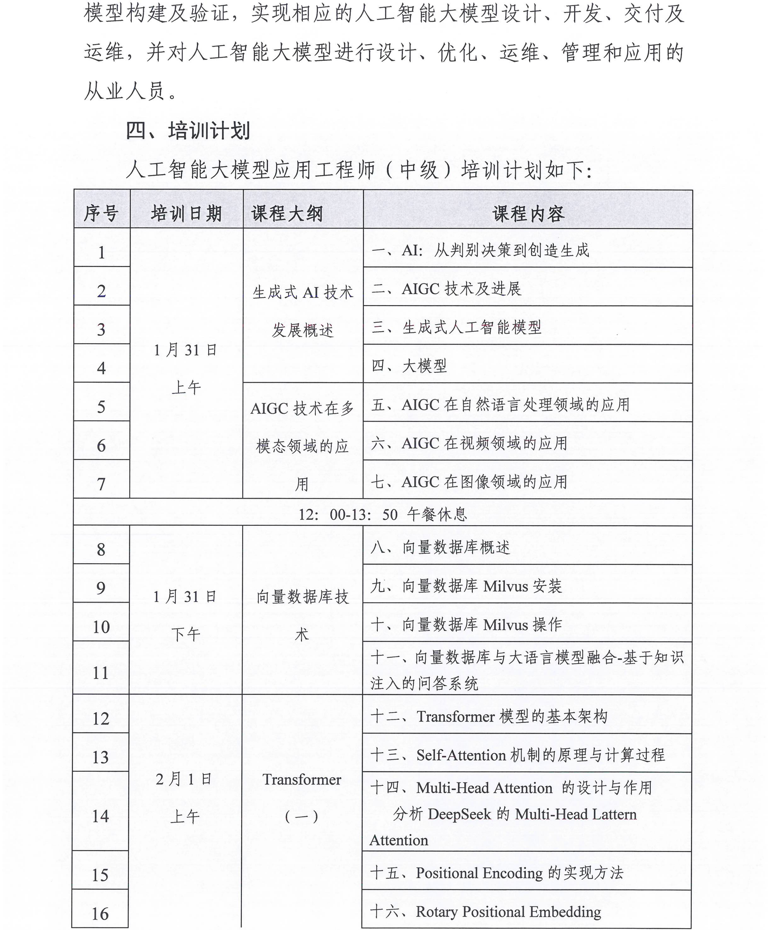

相关学习推荐:工业和信息化部电子工业标准化研究院关于开展人工智能从业人员 “人工智能大模型应用工程师”专项培训

大模型“幻觉”指生成内容看似语法流畅、逻辑连贯,但实际存在事实错误、无法验证或与上下文矛盾的现象,本质是其概率驱动的生成机制、训练数据缺陷及人机交互逻辑共同作用的结果。要有效规避幻觉,需从“数据-训练-推理-验证”全生命周期入手,通过多维度技术手段构建系统性防控体系,以下是核心实施策略:

一、数据层:筑牢事实基础,从源头降低噪声干扰

高质量数据是大模型规避幻觉的前提,核心思路是提升训练数据的真实性、权威性与一致性,减少错误信息的输入。

- 精准数据清洗与过滤:建立多阶段数据校验流程,移除互联网语料中的虚假信息、谣言、逻辑矛盾内容及错误标注数据;对多源重复信息进行去重处理,避免模型学习冗余冲突知识。可采用自监督清洗与人工审核结合的方式,重点强化权威来源数据(如学术论文、官方报告、维基百科)的权重,降低非可信来源内容的影响。

- 引入结构化知识增强:将知识图谱、领域权威数据库等结构化信息融入训练过程,为模型提供明确的事实锚点。例如在医疗领域,嵌入临床指南、药品数据库;在法律领域,整合法律法规条文,约束模型生成范围,避免脱离事实的自由编造。

- 保障数据时效性与完整性:定期更新训练数据,补充最新事实信息,解决模型“知识滞后”导致的幻觉(如对新政策、新事件的错误描述);针对长尾领域的小众知识,通过专项数据采集与标注,减少模型因知识稀疏而产生的编造行为。

二、训练层:优化模型机制,强化事实一致性认知

通过改进训练目标与架构,引导模型建立“事实优先”的生成逻辑,而非单纯追求文本流畅性。

- 针对性监督微调(SFT):使用经过人工严格验证的高质量指令数据集进行微调,重点包含“事实性问答”“幻觉案例修正”等任务;引入“诚实样本”训练,让模型学习在信息不足时输出“不知道”,而非强行编造完整答案。同时可采用对比学习方法,让模型区分“事实性回答”与“幻觉回答”,强化对事实错误的敏感度。

- 优化人类反馈强化学习(RLHF):调整RLHF的奖励机制,将“事实准确性”置于“用户满意度”之上,对幻觉内容实施惩罚,对准确且有依据的回答给予更高奖励。组织专业标注团队针对不同领域的事实性问题进行评分,引导模型摒弃“刻意逢迎用户需求而虚构信息”的倾向。

- 引入因果一致性正则化:通过技术手段强化模型推理过程与输出结果的逻辑关联性,例如采用反事实敏感性正则化(CSR),在训练中对推理轨迹进行微小扰动(如替换逻辑运算符),若模型仍输出原答案则进行惩罚,迫使模型依赖真实推理而非概率猜测生成内容,提升推理可信度。

三、推理层:实时约束生成,弥补模型固有缺陷

在模型生成答案的过程中,通过外部工具辅助与生成规则约束,实时规避幻觉风险。

- 检索增强生成(RAG):将模型“闭卷考试”转为“开卷考试”,在生成前先检索外部权威知识库(如企业内部政策库、实时新闻数据库),基于检索到的真实信息构建回答。该方法能有效突破模型参数化知识边界,大幅降低因知识缺失或滞后导致的幻觉,是当前产业界的主流实用方案。例如用户询问“最新行业政策”时,模型可通过RAG实时获取官方发布信息,避免编造过时或错误的政策内容。

- 约束解码与不确定性校准:采用约束解码技术,限制输出内容必须符合预定义规则(如禁止生成不在知识库中的学术引用);同时让模型输出置信度分数,对低置信度(如概率低于阈值)的回答添加警告提示,或直接拒绝回答,避免“一本正经地胡说八道”。

- 强化推理过程显式化:通过提示工程引导模型采用“分步思考”(Chain-of-Thought)模式,暴露推理逻辑链。例如要求模型按照“依据XX信息→推导得出XX结论”的格式生成内容,既便于发现逻辑漏洞,也能提升事实追溯性,减少隐性的错误推理。

四、验证层:事后核查纠错,构建闭环优化体系

通过多维度验证机制检测并修正已生成的幻觉内容,同时反哺模型迭代优化。

- 多模态幻觉检测:针对生成内容中的关键事实(如命名实体、数据、事件),构建白盒与黑盒结合的检测体系。白盒方案通过分析token概率、注意力分配比例、隐藏状态熵值等模型内部指标识别风险;黑盒方案采用“采样一致性检测”(同一问题多次生成,不一致则标识风险)、规则引擎对比(如ROUGE/BLEU指标与知识源重叠度),或调用搜索引擎、计算器等外部工具进行交叉验证。

- 多模型交叉验证与自验证:对高风险领域(如医疗、法律)的输出内容,采用多个不同架构的模型进行交叉校验,若结果差异较大则触发人工审核;同时训练模型进行自我验证,让模型主动质疑自身输出(如“上述结论是否有可靠来源支持?”),实现闭环纠错。

- 持续反馈迭代:建立用户反馈机制(如“错误标记”按钮),收集真实场景中的幻觉案例,定期用于模型微调与RLHF优化;在高风险场景中设置人工审核流程,将模型输出与专家知识库比对,确保事实准确性后再交付用户。

五、实践补充:场景适配与成本权衡

幻觉防控需结合具体应用场景调整策略:闲聊等低风险场景可容忍轻度幻觉,而医疗、法律、金融等领域需追求“零幻觉”,需针对性强化领域微调与人工审核;同时需平衡技术成本,例如RAG方案需维护实时检索系统,SFT与RLHF依赖大量标注资源,企业可根据场景重要性选择核心策略组合(如“RAG+提示工程”快速见效,“高质量数据+RLHF”长期提升模型本质可靠性)。

综上,大模型幻觉无法完全根除,但其风险可通过“源头防控(数据)-过程约束(训练+推理)-事后纠错(验证)”的全链路体系有效降低。未来随着知识图谱约束推理、可解释性增强等技术的发展,模型的事实一致性将进一步提升,推动大模型向更可靠的方向进化。

相关学习推荐:工业和信息化部电子工业标准化研究院关于开展人工智能从业人员 “人工智能大模型应用工程师”专项培训

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)