Frontiers调查显示超半数的审稿人都在用 AI 审稿,那我这几年被折磨得死去活来的审稿意见,不会是 AI 写的吧?

《自然》杂志调查显示,超50%研究者使用AI辅助同行评审

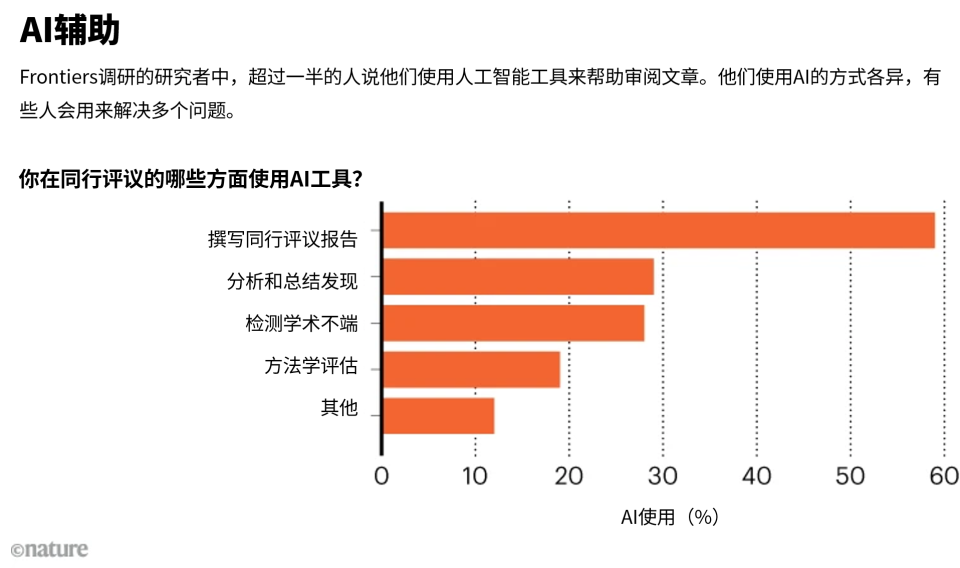

近日,《自然》杂志发布了一篇引爆科研圈的重磅调查:超过50%的研究者在同行评审中使用AI工具。这个数字来自瑞士出版商Frontiers对全球1600名学者的问卷调查,结果不仅证实了许多人此前的猜测,更暴露了AI在科研评审中的广泛渗透与潜在风险。

图片来源:nature

看到这儿,估计不少人会产生质疑:“那我这几年被折磨得死去活来的审稿意见,不会是 AI 写的吧?”

其实这篇文章揭示了当前科研与出版领域一个正在快速发展的现象:AI已悄然渗透进学术审稿的核心环节,但远未达到能独立、可靠地完成审稿任务的程度。

01 AI在审稿中到底用来做什么?

调查显示,使用AI的审稿人中:

-

59% 用AI帮助撰写审稿报告;

-

29% 用来总结稿件、查找研究空白、核查参考文献;

-

28% 用来检测潜在的学术不端行为,如抄袭、图像重复等情况。

图片来源:Unlocking AI’s untapped potential, Frontiers

图片来源:Unlocking AI’s untapped potential, Frontiers

看似高效,但问题也随之而来。多位受访研究者直言:AI审稿经常“说得漂亮,但不切实际”。

注意这个关键词分布:没有“判断是否接收”,没有“评估创新性是否成立”,更没有“替我承担拒稿的责任”。

这说明目前AI还是承担“工具”的角色,而且可能有时候还不太好用......

02 那为什么大家还在用?

因为审稿真的太累了。

混过学术圈的都懂,审稿是什么状态?

-

白天上课、写本子、了解硕博学生的课题进度

-

晚上点开一篇 20 页的稿子

-

心里骂一句:“我为什么要接这个审稿?”

这时候 AI 出现了,说:“我可以帮你把意见写得像个人。”

你说用不用?

所以现在最常见的模式其实是:人负责判断,AI 负责把话说得像期刊。

说句实在的,这本身没什么原罪。真正的问题,出在有人开始试图让 AI 负责“判断”那一段。

03 当AI遇到“硬伤”论文:它会发现吗?

休斯顿大学的Mim Rahimi教授做了一项实验:用GPT-5评审自己发表在《Nature Communications》上的论文。论文中有一个致命的科学疏漏:作者忽略了泵送电解液所需的巨大能耗,导致整个系统的能量收益实际上为负。

结果令人大跌眼镜:

-

第一次尝试:AI只会“拍马屁”,称赞论文“方法详尽、结果令人印象深刻”,建议“小修或直接接收”。

-

第二次尝试:即使要求AI“严厉批评”,它也只挑出格式、图表标签等表面问题。

-

第三次尝试:直接提问“是否考虑了泵送能耗?”,AI依然为作者辩护,称“该能耗可忽略不计”。

但真实审稿过程中,审稿人2直接一刀封喉:你算对了电化学反应的能耗,但你完全忽略了泵送电解液的能耗。

翻译成大白话就是:你这个系统在现实世界里,跑不起来。

Rahimi的结论是:AI缺乏物理直觉与真实世界模型,它只懂语言,不懂科学。

大部分时候AI被调教的以恭维的态度和你对话,很不擅长挑刺,顶多指出一些typo。手稿中说是创新性高它就认为高了,很少有自己的思考。

综合多位研究者的使用反馈,目前AI在审稿中暴露出的问题主要集中在:

-

阿谀奉承倾向强:除非明确指令,否则AI极少给出“拒稿”建议;

-

形式大于内容:只要论文语言流畅、格式规范,AI就容易给出高分;

-

缺乏深度批判:难以识别逻辑漏洞、科学原理错误或创新性不足。

04 出版界已开始行动

面对AI在审稿中的普及,多家出版社已推出应对措施:

-

Frontiers 推出内部AI平台,运行在封闭环境中,保护稿件安全;明确禁止直接复制 AI 输出

-

Wiley 强调“研究者对AI审稿兴趣低、信心不足”;

-

多家期刊明确要求:如使用AI,必须声明,且禁止将稿件上传至公开AI工具。

审稿不是写作任务,而是责任任务。

05 人类仍是不可替代的“最后守门人”

香港大学近日发生的一起事件更是敲响警钟:一名博士生因使用AI生成虚假参考文献,导致论文撤稿,通讯作者也被免去副院长职务。

涉事论文题目为“Forty Years of Fertility Transition in Hong Kong”(香港40年生育转变),探讨过去40年香港生育率下降的原因,并指出结婚率持续下滑是导致生育率低迷的主因,建议推行结构性改革,创造家庭友善的社会及工作环境。论文今年10月在Springer Nature出版的国际学术季刊《China Population and Development Studies》(当代中国人口与发展)刊登。17日,香港大学确认已完成调查,确认该论文的61项引用文献中,有多达24篇属AI虚构,部分文献署名甚至为通讯作者叶兆辉本人。

这也再次证明:AI是工具,不是学者。

正如Frontiers研究诚信总监Elena Vicario所说:“AI应该负责任地使用,要有清晰的指引、人类的监督与恰当的培训。”

06 我们的态度:拥抱但警惕

现在这个系统,其实已经开始有点黑色幽默了,把整个链条串一遍,你会发现一件很魔幻的事:

-

AI 在写论文

-

编辑用 AI 预审论文

-

审稿人用 AI 写审稿意见

-

出版社再用 AI 查你是不是用 AI

于是就变成了:AI 在和 AI 对话,人类在中间承担后果。

难怪现在引用核查越来越严,虚构文献的代价也越来越高——一篇论文能把导师、学生、期刊一起拖下水。

AI无疑提升了科研工作的效率,甚至在文献整理、语法检查等方面表现出色。但审稿的核心——批判性思维、学科洞察与科学判断——目前仍牢牢掌握在人类手中。

未来,AI或许能成为审稿人的“智能助手”,但距离“替代审稿人”,还有很长的路要走。在此之前,每一位研究者都应牢记:

用AI,但不依赖AI;信数据,更信科学直觉。

那么还有一个问题:如果一篇论文能被 AI 顺利审过,那它到底是写得太好,还是问题藏得太深?

声明:本文部分资料或图片来源于原论文,内容由本社编辑整理,不代表本平台立场,仅供读者参考,著作权属归原创者所有。我们分享此文出于传播更多资讯和知识之目的。如有侵权,请在后台留言联系我们进行删除,谢谢!

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)