IT从业者如何应对AI带的冲击-入门篇

Ollama 是由 Ollama, Inc. 开发的,这是一家专注于本地运行 AI 模型的初创公司。该公司致力于让用户更方便地在本地设备(如个人电脑或服务器)上运行和管理大语言模型(LLM)。

接下来我们先从最简单AI入门篇部署开始:

先找了一台windows电脑搭建了一些AI实验环境,如通过AnythingLLM、Cherry Studio、Page Assist不同的AI助手平台或工具对接ollama windows版本的AI模型管理工具,通过ollam命令来下载不同模型. 如下载deepseek/qwen等LLM或一些词嵌入模型等做RAG模型,AI助手平也可以调用API对接公有云模型API(需要付费),对AI知识和各模型有了基本的了解之后,可以尝试做一些RAG实验等

1.1.部署LLM准备工作

拆封一台一直想拿来做实验的电脑

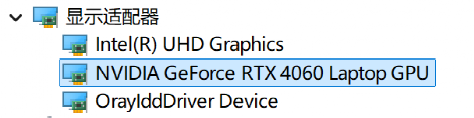

显存共16G(8G独显+8G集显)

注: 其实AI模型在较小显存的电脑也可以运行小模型或没有显卡的电脑上也可以运行(没有显存会使用CPU来处理计算任务,输出答案top会很慢)

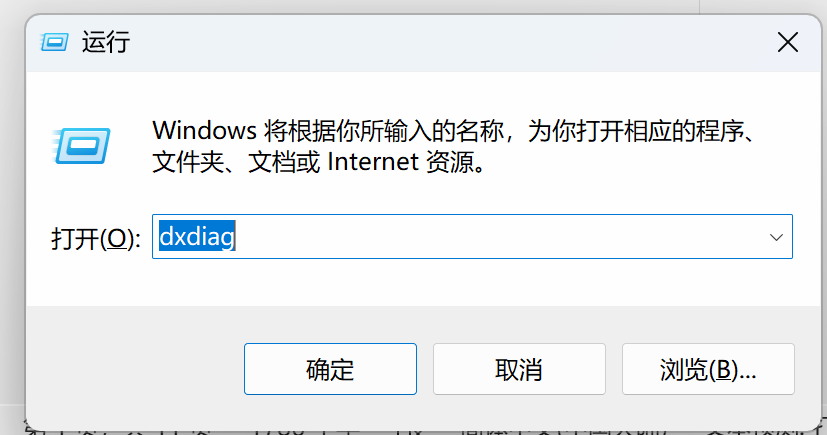

Dxdiag命令确认显存的运行状态

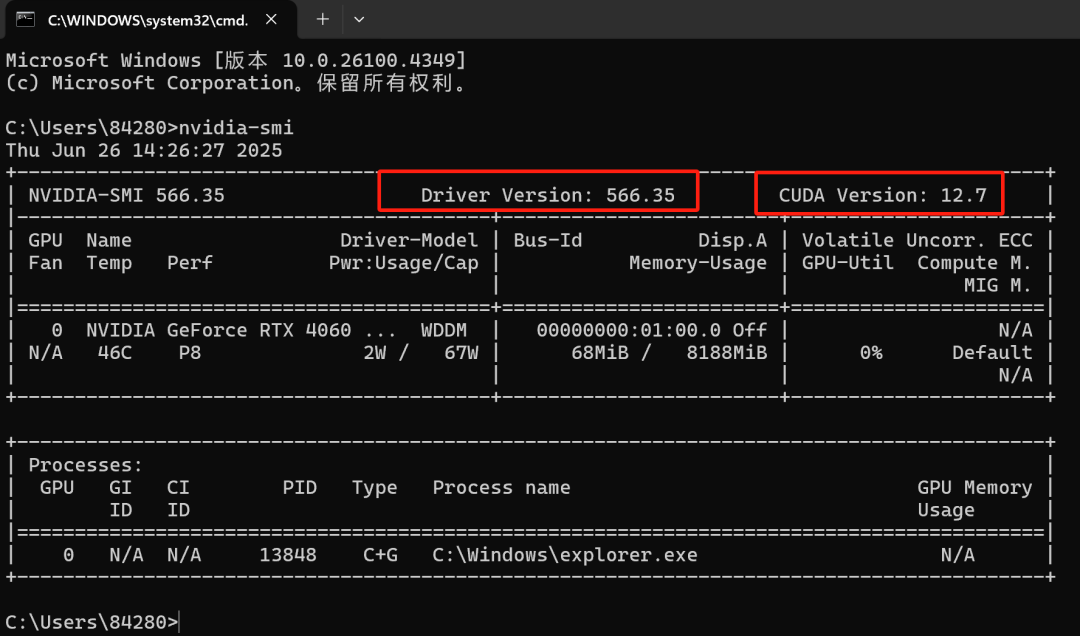

在cmd命令中用nvidia-smi查看驱动和CUDA版本

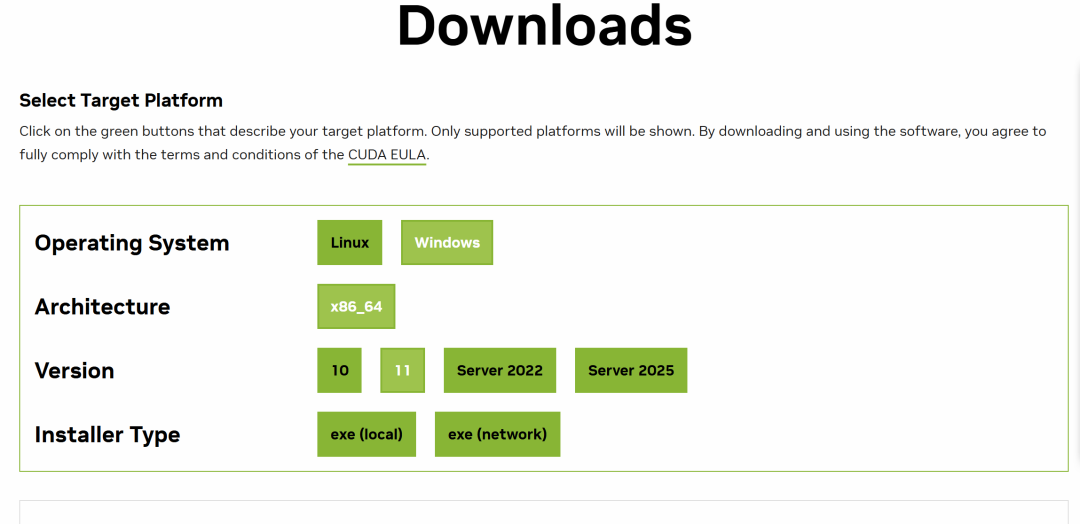

可以下载最新的Cuda驱动网站

https://developer.nvidia.com/cuda-downloads?target_os=Windows&target_arch=x86_64&target_version=11

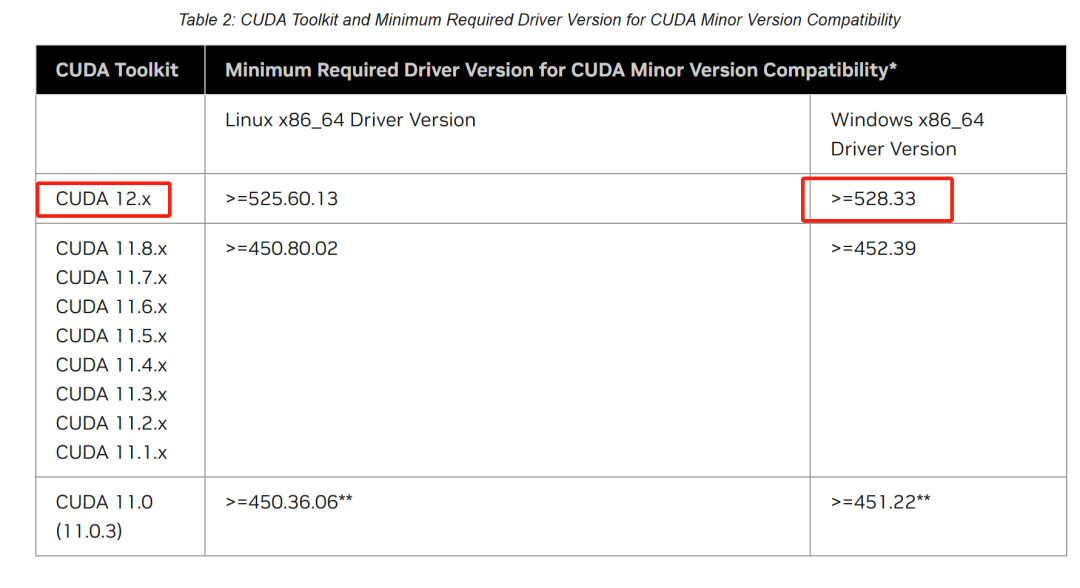

需要CUDA版本和对应的驱动版本查询网站

CUDA 12.8 Update 1 Release Notes — Release Notes 12.8 documentation

https://docs.nvidia.com/cuda/cuda-toolkit-release-notes/index.html

1.2.下载并安装Ollama

在部署大模型之前我们需要使用一个工具来拉取和管理大模型,此次我们使用ollam工具,当然市场上还有其他不同的工具,如vLLM等。

Ollama 是由 Ollama, Inc. 开发的,这是一家专注于本地运行 AI 模型的初创公司。该公司致力于让用户更方便地在本地设备(如个人电脑或服务器)上运行和管理大语言模型(LLM)。

虽然 Ollama, Inc. 目前仍是一家独立公司,但它的技术与开源 AI 生态紧密相关,支持多个热门开源模型,如Deepseek、Qwen、 LLaMA、Mistral、Gemma 等。该项目也受到开发者社区的广泛关注,被视为本地 AI 计算的重要工具。

Ollama 是一个用于本地运行和管理大语言模型(LLM)的开源工具。它允许用户在本地设备(如个人电脑或服务器)上轻松下载、部署和运行各种 AI 语言模型,而无需依赖云端服务。

Ollama 的主要特点

1.本地运行:无需联网即可运行大模型,提高隐私性和数据安全性。

2.模型管理:支持一键下载和切换不同的开源 LLM(如 Deepseek、Qwen、Gemma 等)。

3.简单易用:提供 CLI(命令行界面)和 API,方便开发者集成到各种应用中。

4.优化性能:支持 GPU 加速,提高推理速度,适用于桌面端和服务器端。

5.自定义模型:可以微调和创建自己的 AI 模型,满足特定需求。

Ollama 的常见用途

·本地聊天机器人

·代码辅助(类似 Copilot)

·文本摘要和内容生成

·AI 助理和自动化任务

下面简单展示在windows电脑上通过 Ollama+AnythingLLM部署聊天机器人和RAG系统。

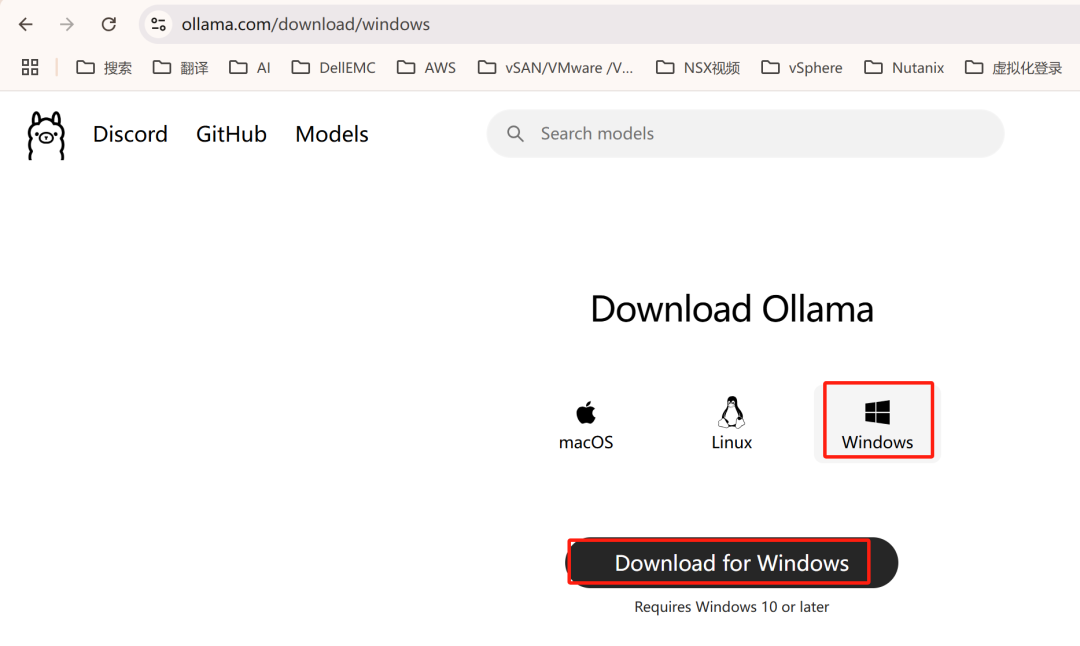

下载ollama并安装 :https://ollama.com/download

下载之后安装

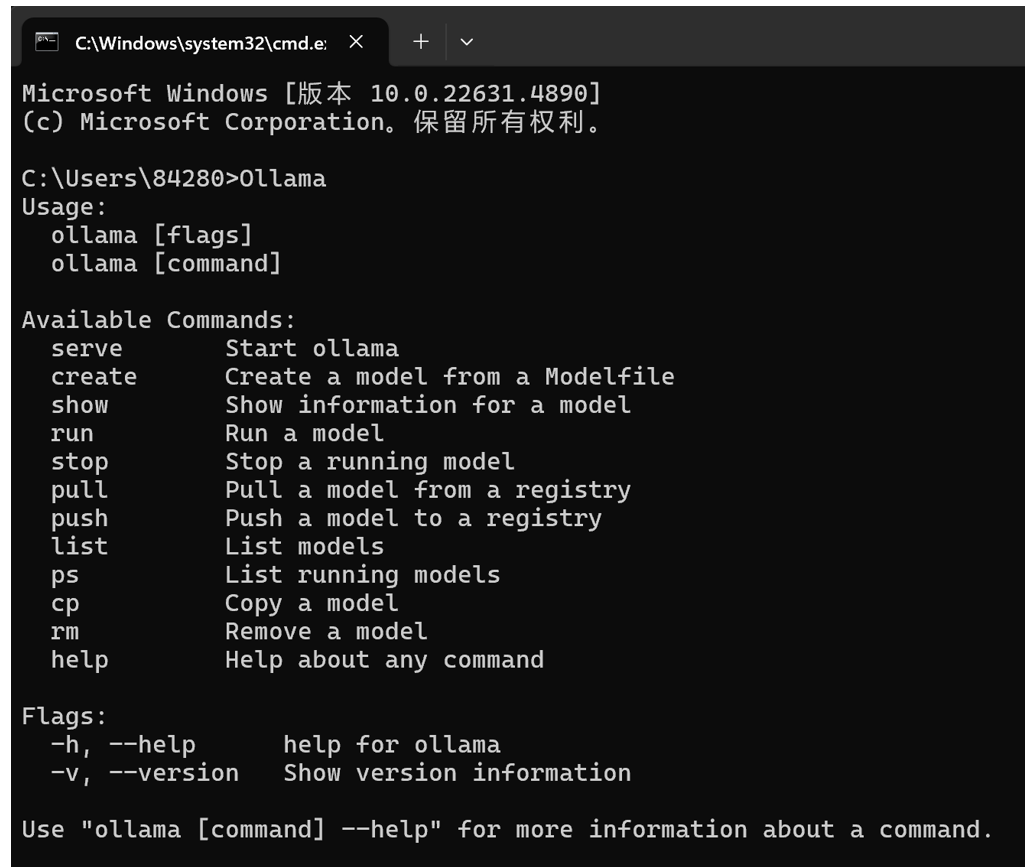

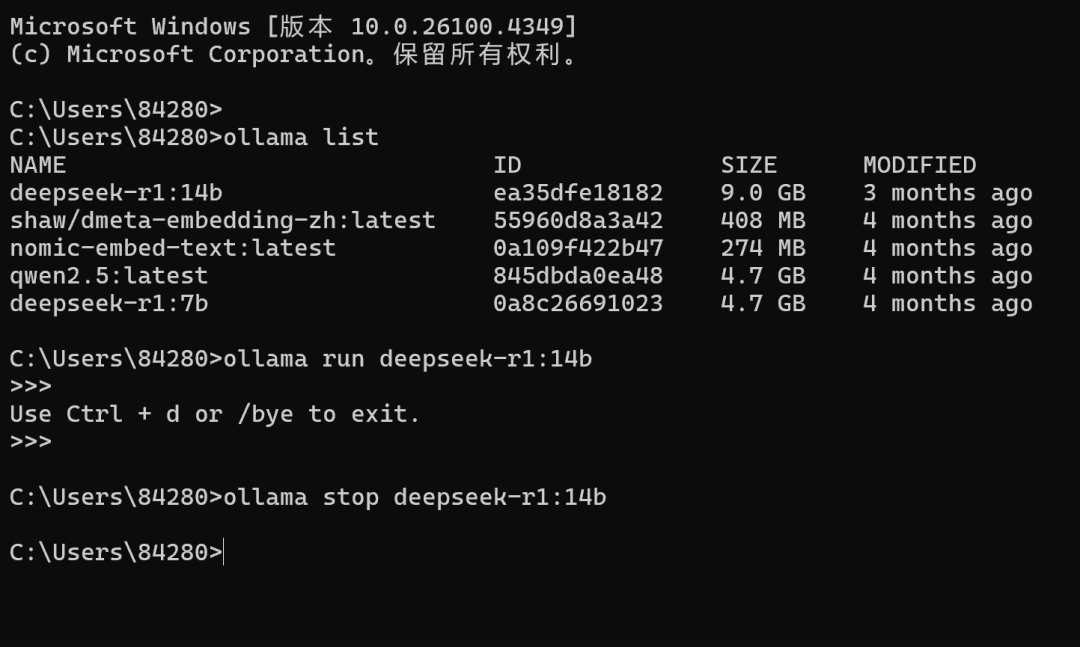

通过cmd命令中通过ollama下载管理各种模型(deepseek/qwen等),通过命令可以对模型运行、停止、删除等操作

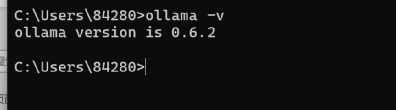

查看ollama版本

Deepseek AI模型目前有Deepseek v3 671B(满血版)和R1蒸馏版本,参考: DeepSeek版本对比和显存计算方法DeepSeek版本对比和显存计算方法介绍。

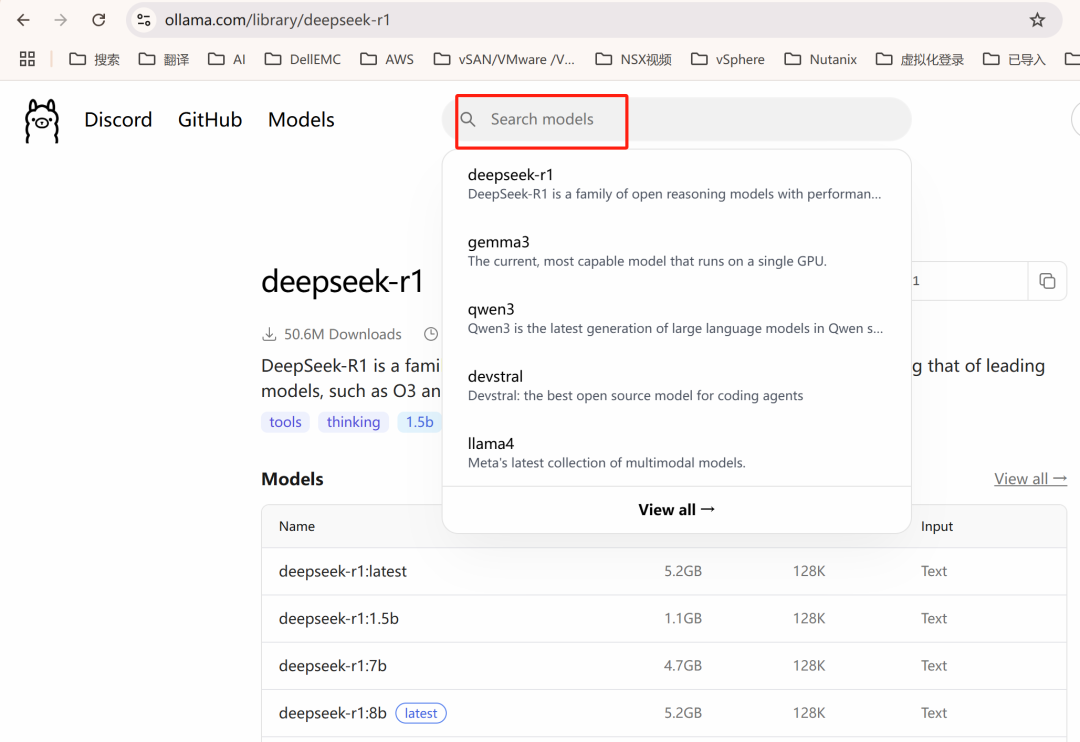

去ollama官网查找想要的相关的模型,如选择deepseek-r1:

https://ollama.com/library/deepseek-r1

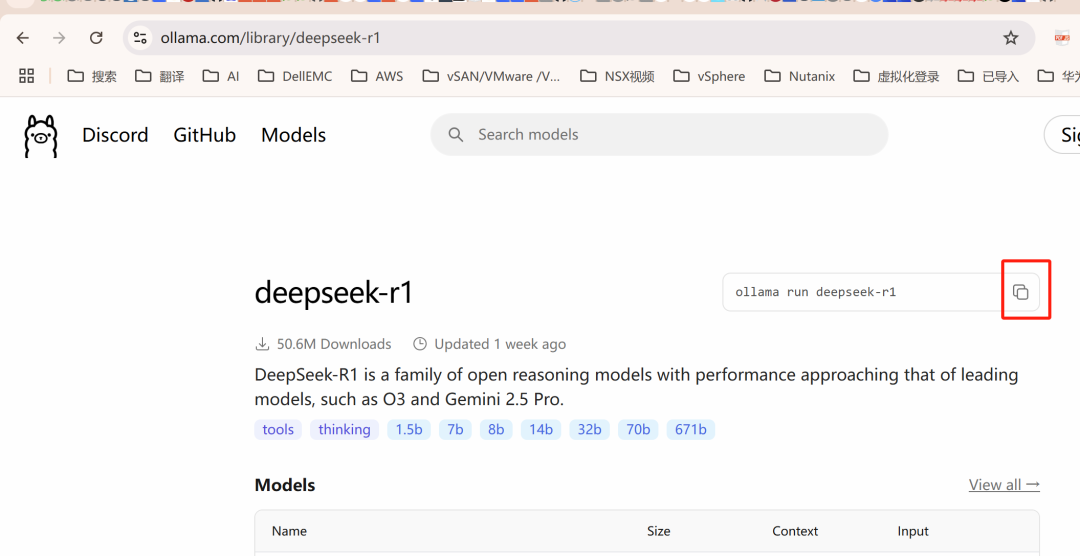

复制下载模型的命令

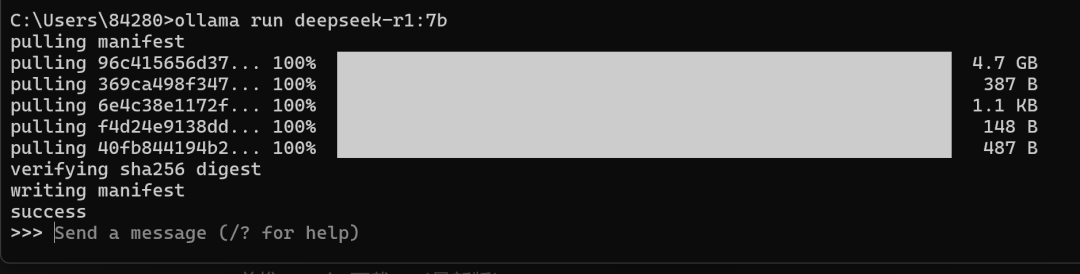

在命令行中拉取模型:

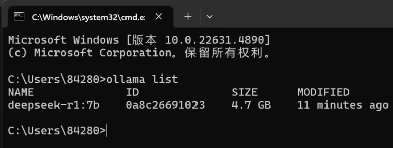

ollama list 命令查询已下载模型,和磁盘占用大小

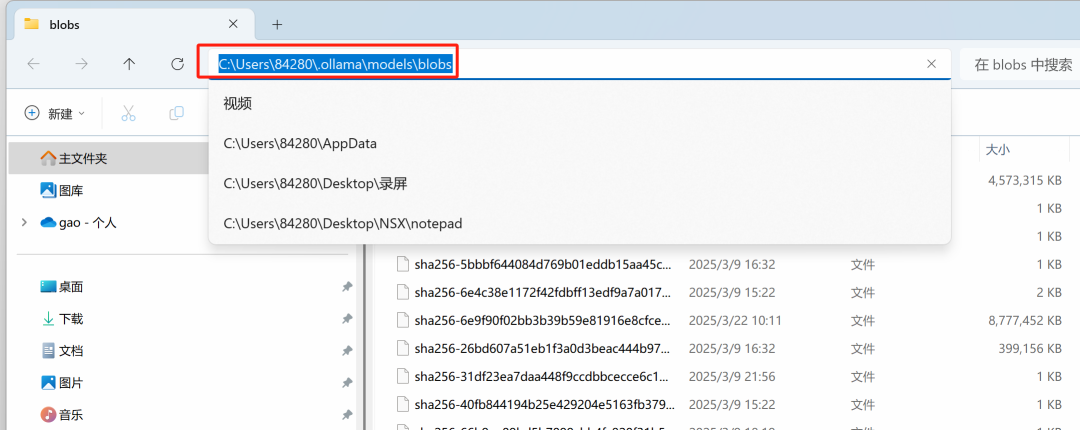

模型下载后的路径参考:C:\Users\用户名.ollama\models\blobs

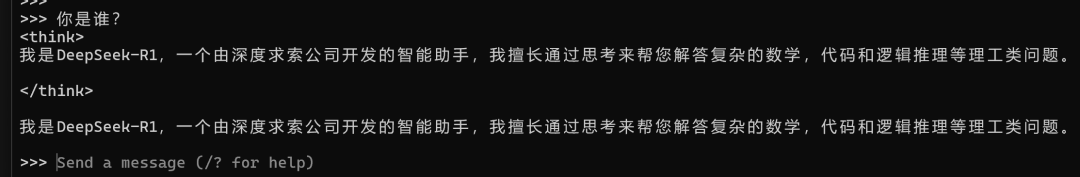

在cmd中可以直接与deepseek AI对话,但不够友好,如无法长期保存聊内容等

ollama常用命令

1.3.部署Anything LLM集成Ollama

在AnythingLLM、Cherry Studio、Page Assist、open-webui等不同的AI助手平台都可以通过ollama集成上面已经部署好的LLM,下面用AnythingLLM 集成Deepseek.

AnythingLLM是采用MIT许可证的开源框架,支持快速在本地部署基于检索增强生成(RAG)的大模型应用。 AnythingLLM推出了桌面应用,可以在自己的笔记本电脑上下载使用,目前支持的操作系统包括MacOS,Windows和Linux。

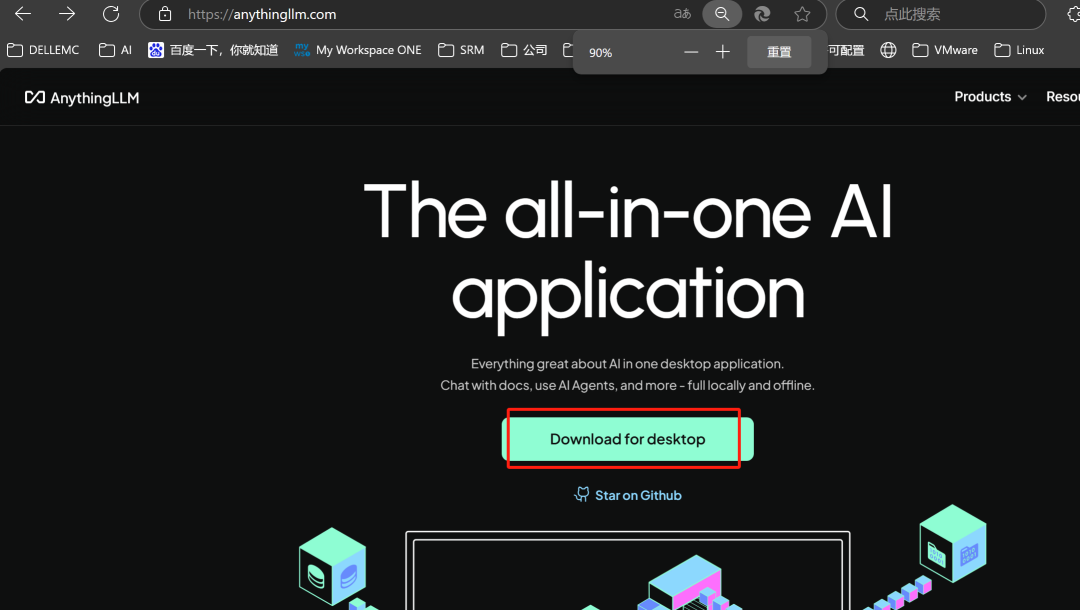

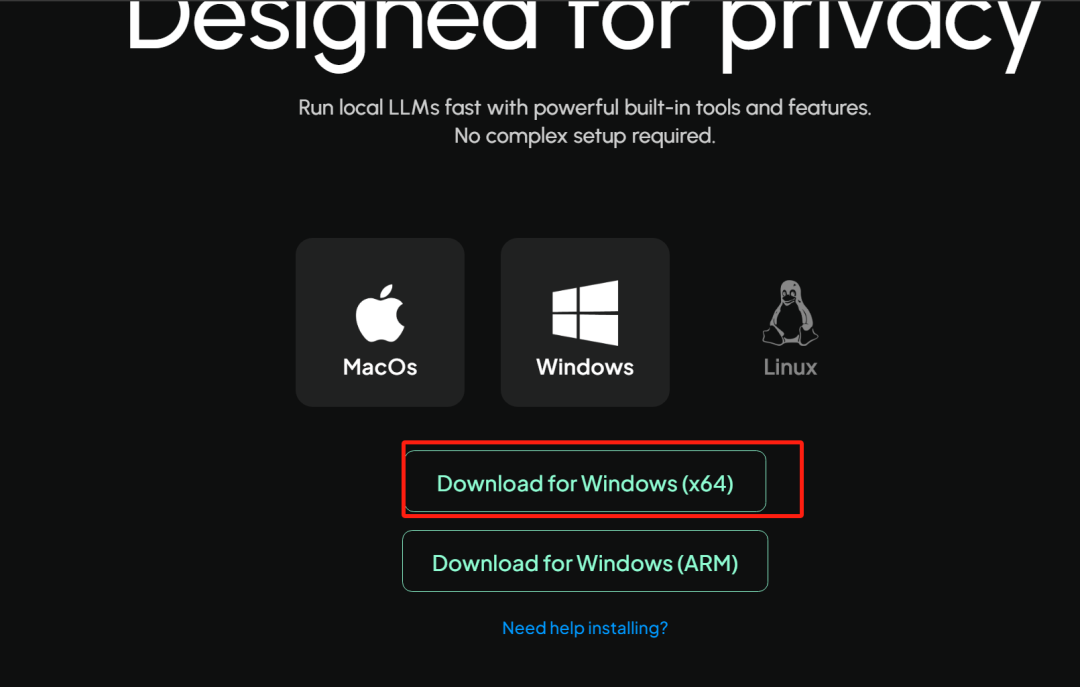

下载anythingllm:

https://anythingllm.com/

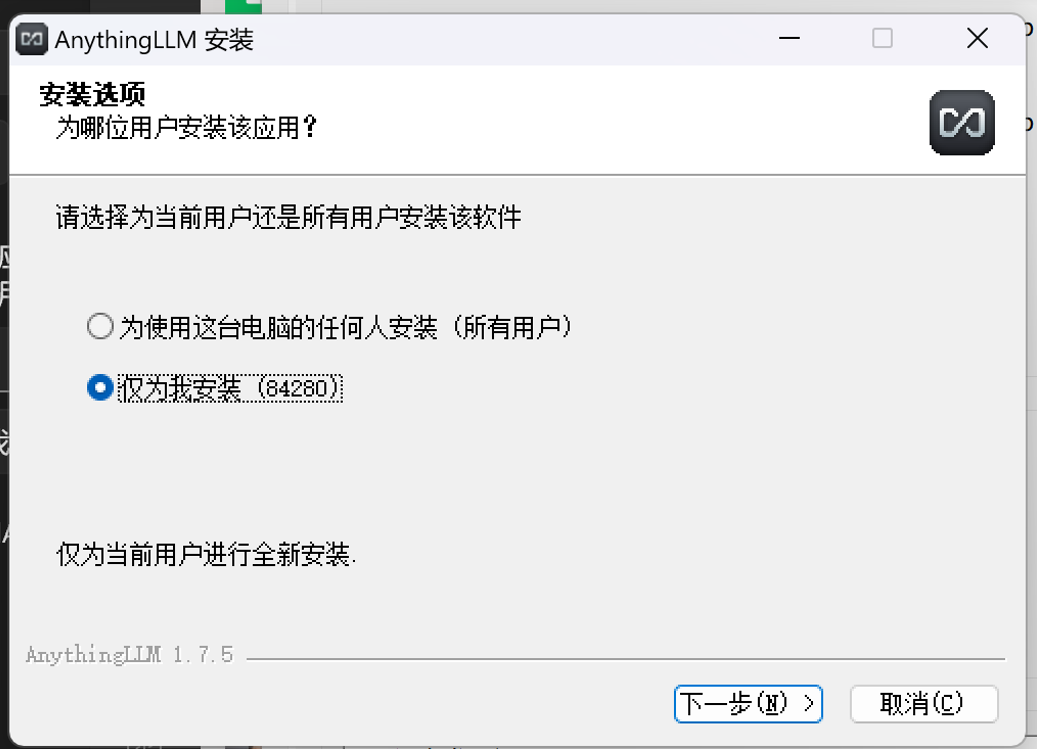

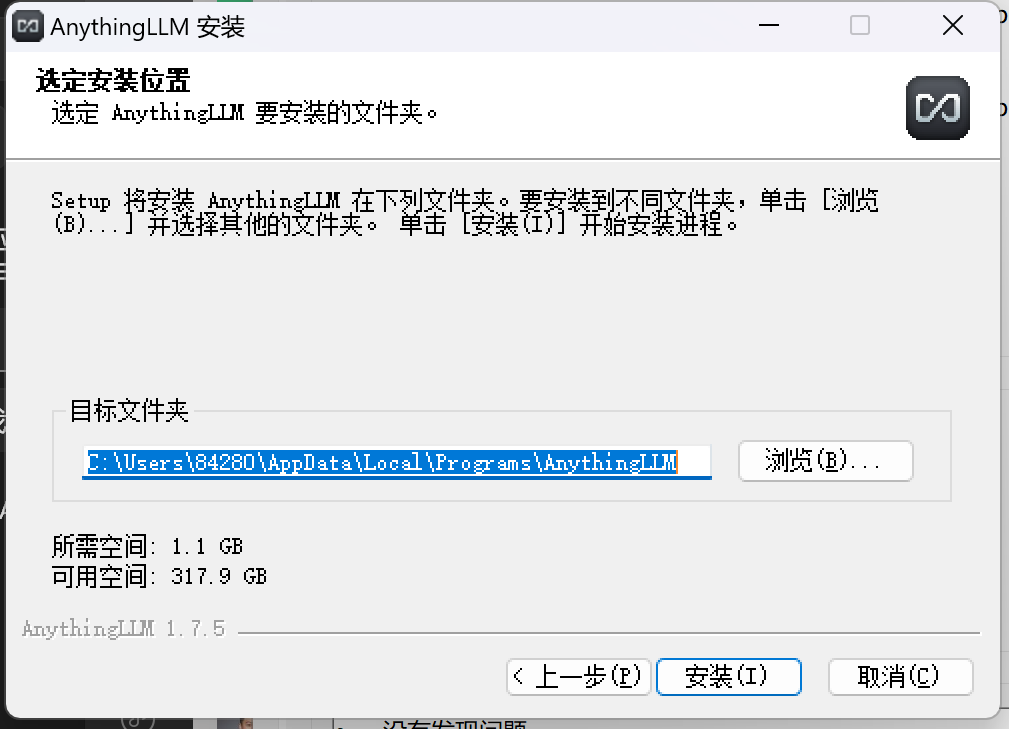

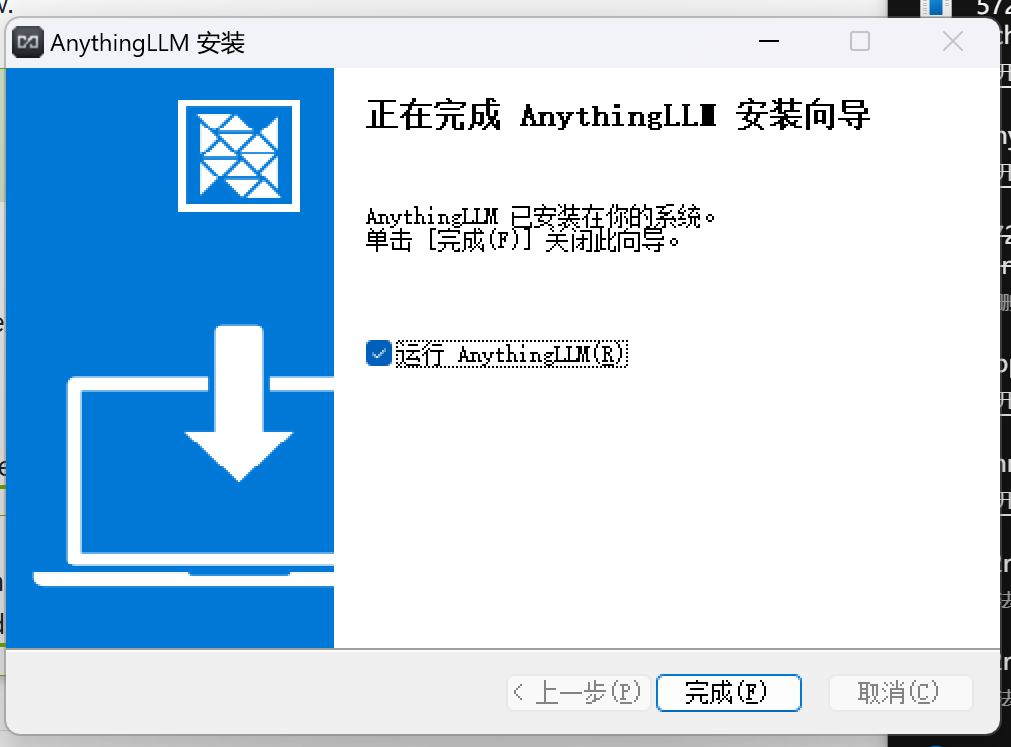

下载之后点安装

运行AnythingLlm 后点击 getstarted

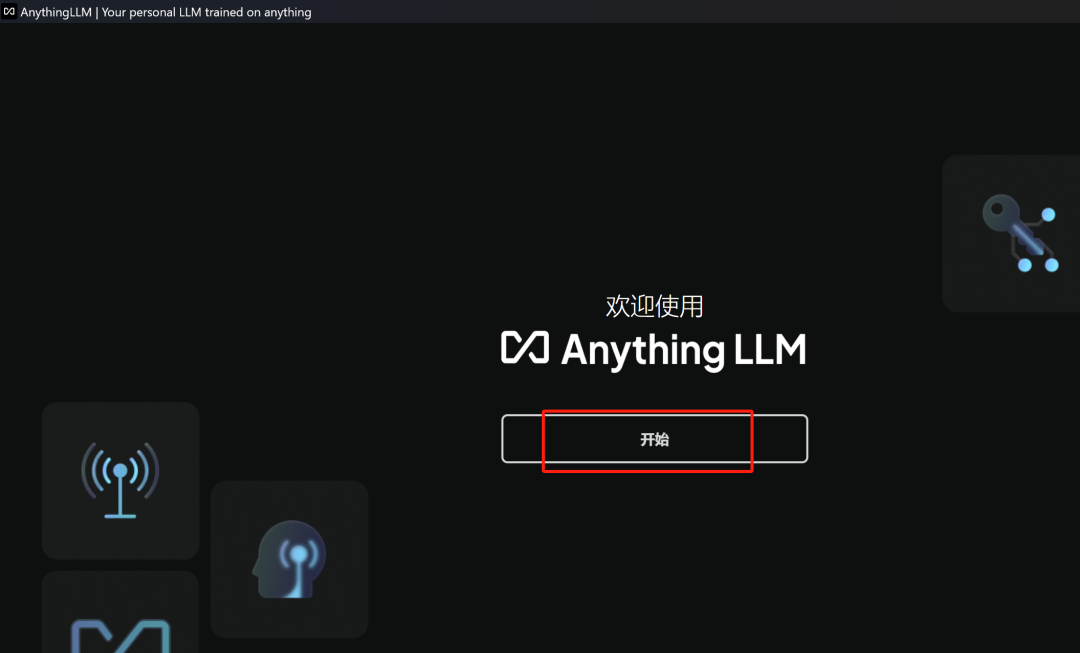

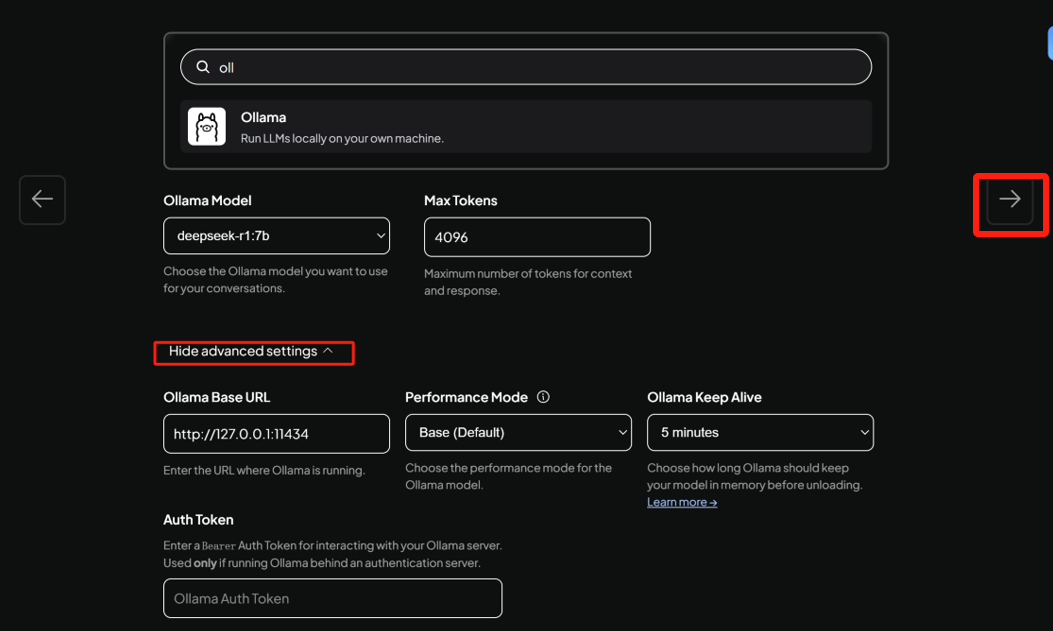

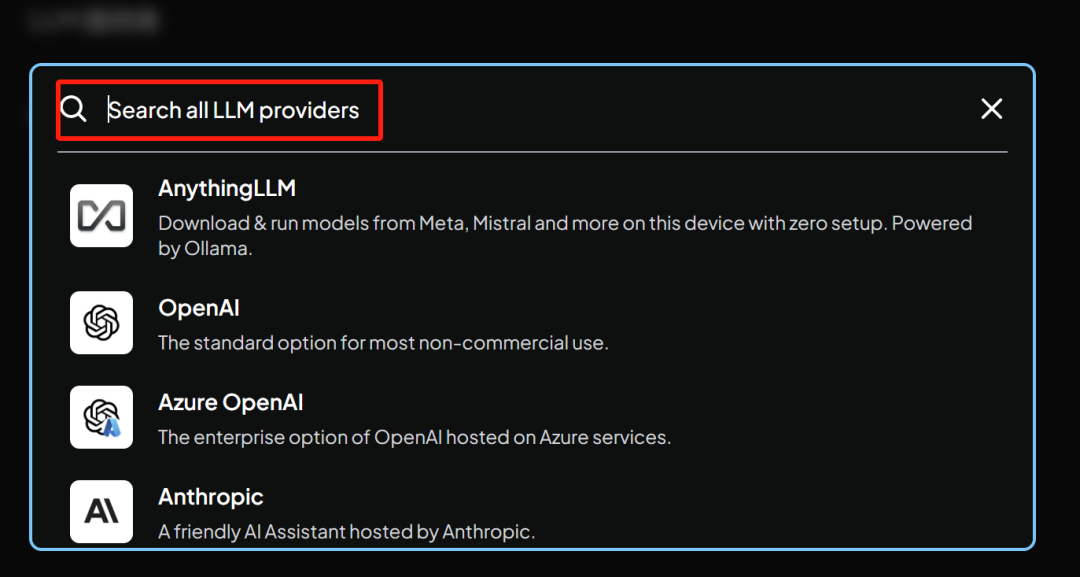

选择对接ollama管理的模型

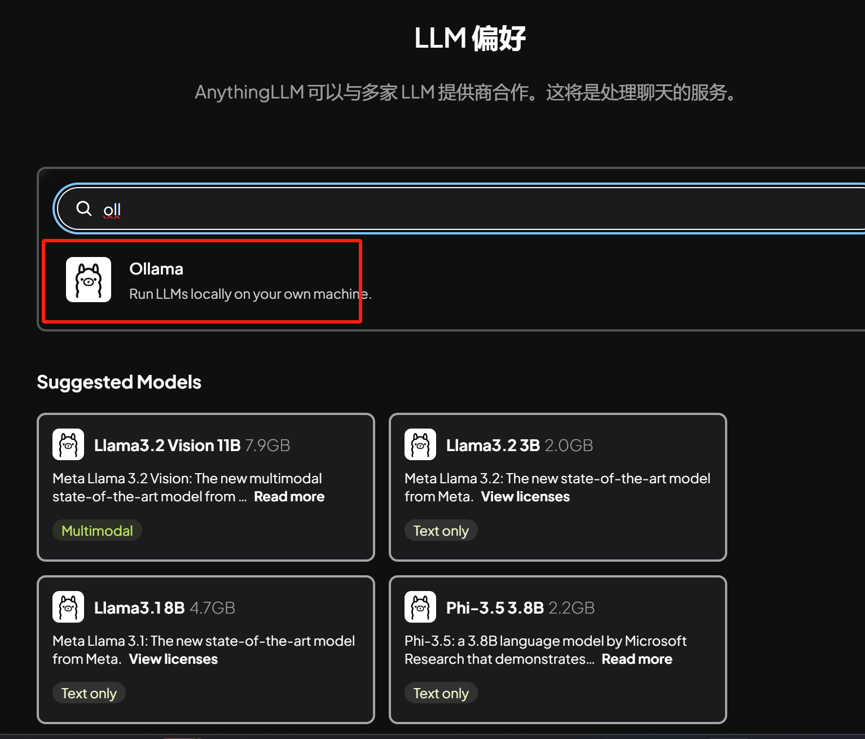

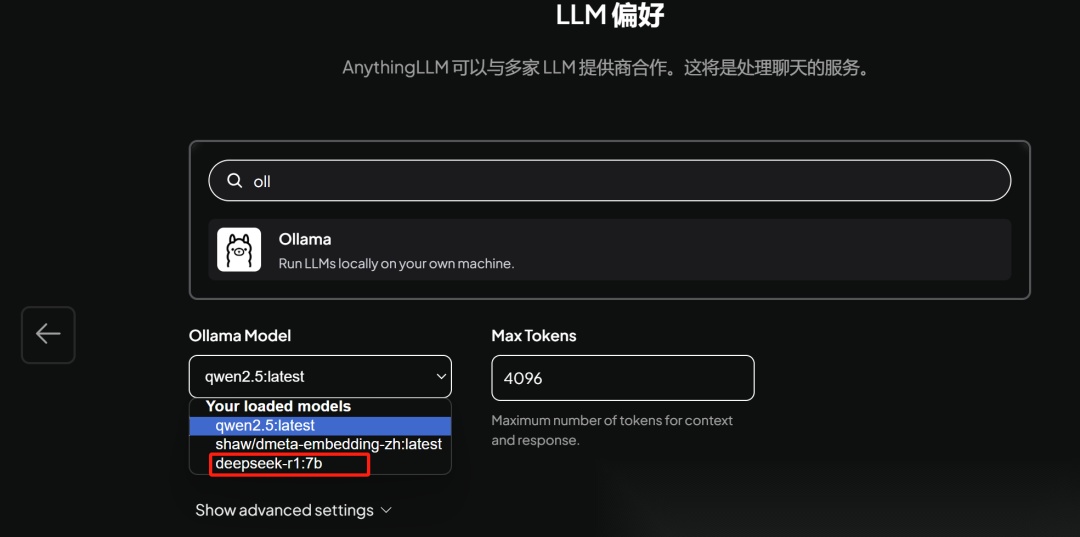

自动识别到已安装的模型,选择要对接的模型和修改相关参数:

单击右侧箭头

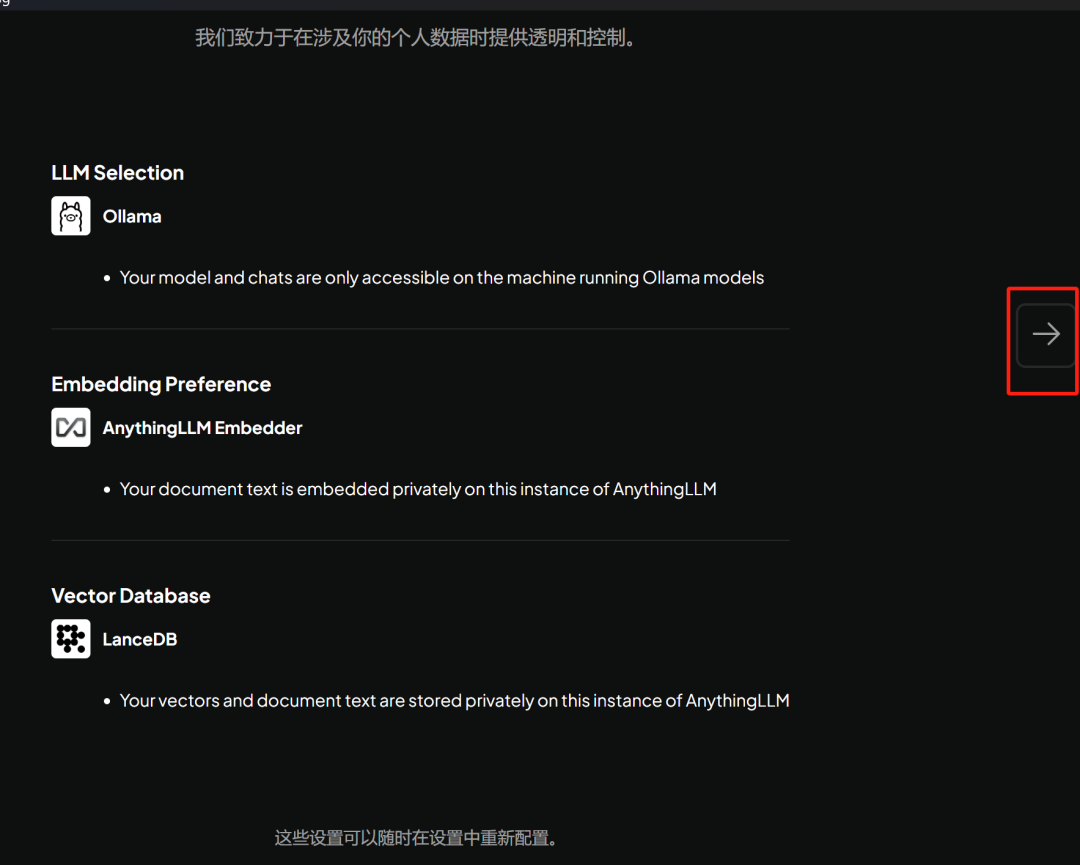

单击右侧箭头

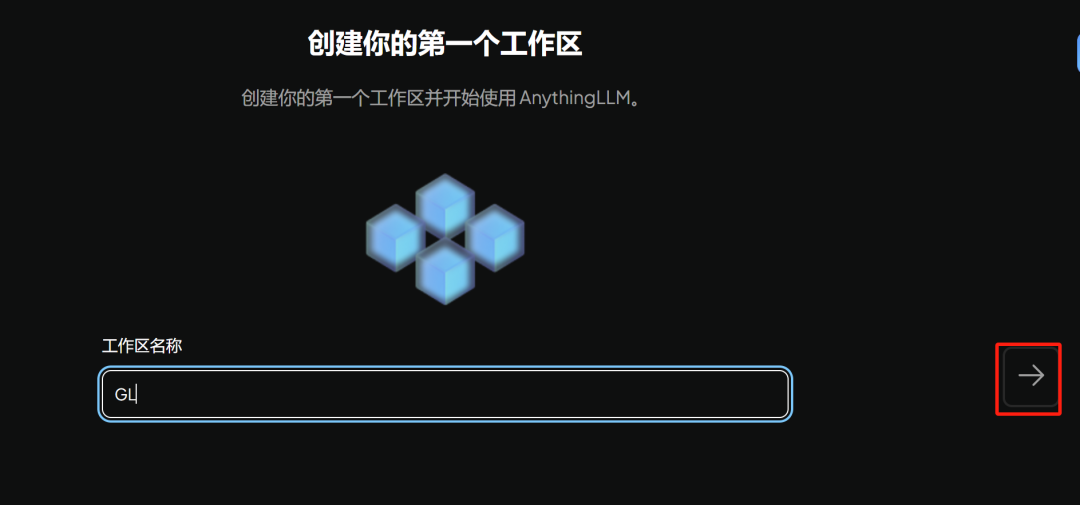

输出创建工作区的名称

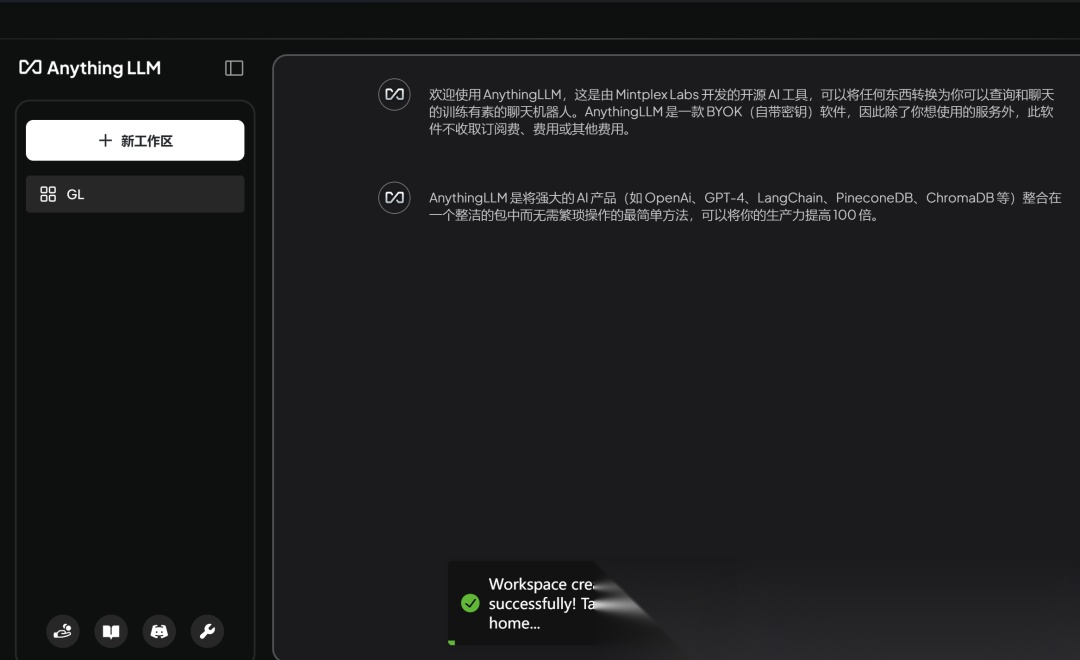

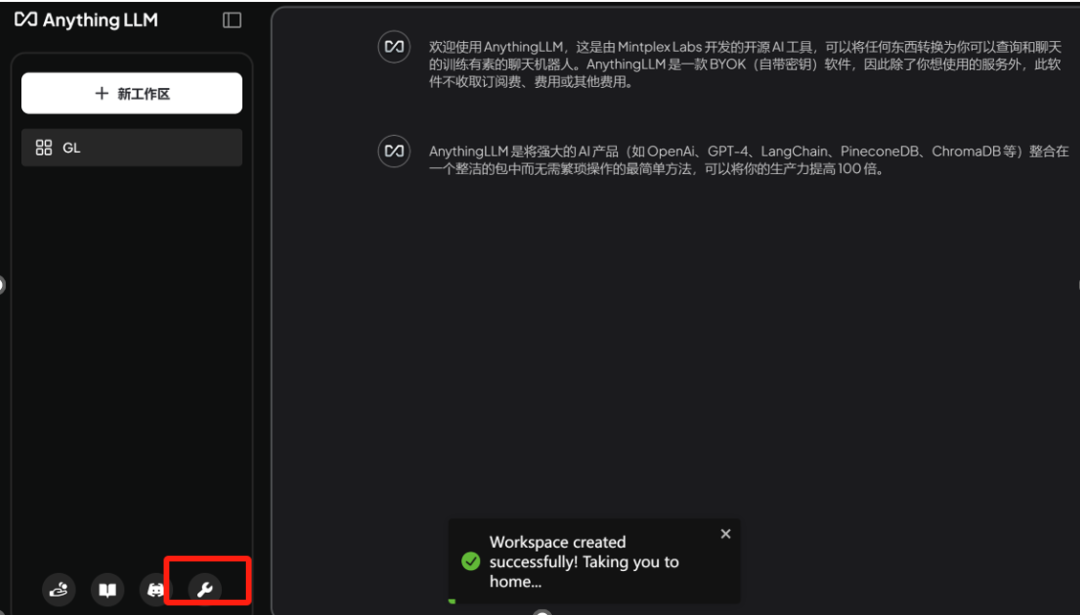

下面就是聊天的工作界面了

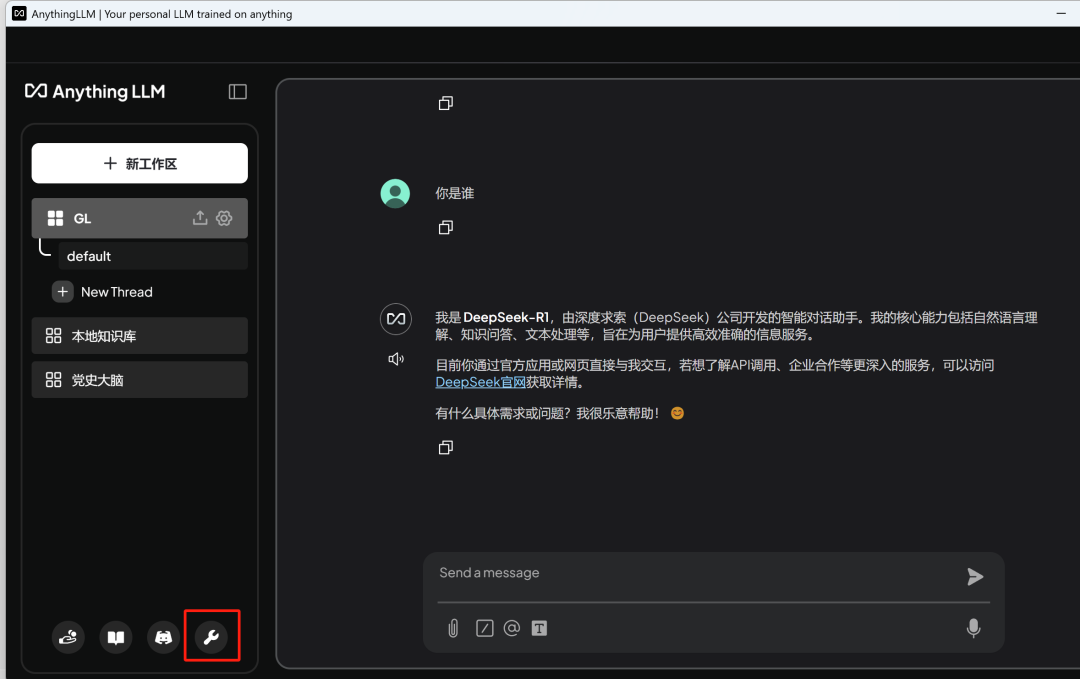

点击左下角设置

可以参考官方文档进行其他设置:https://docs.anythingllm.com/

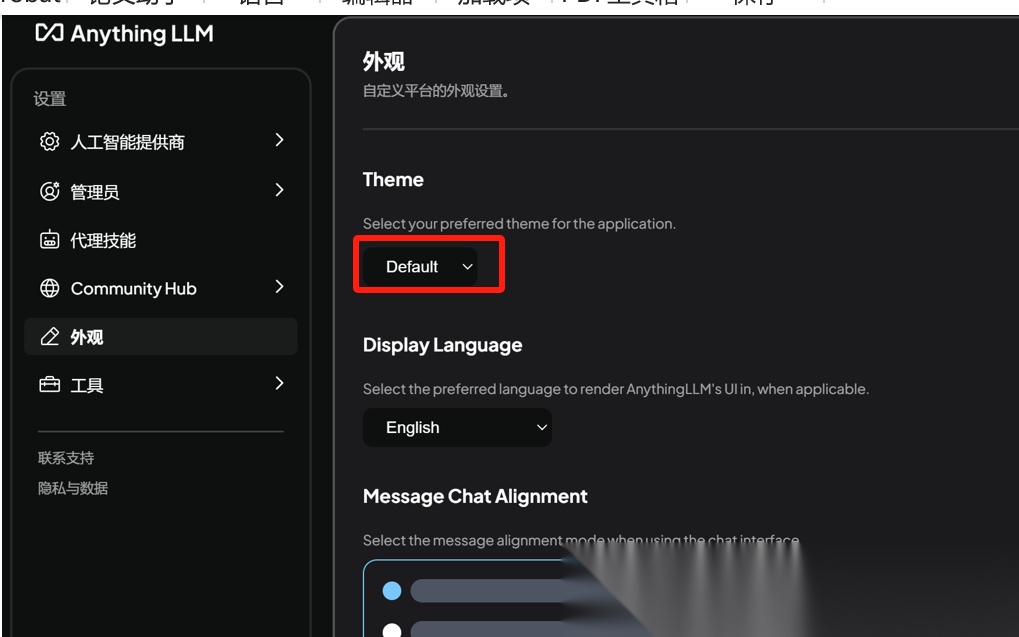

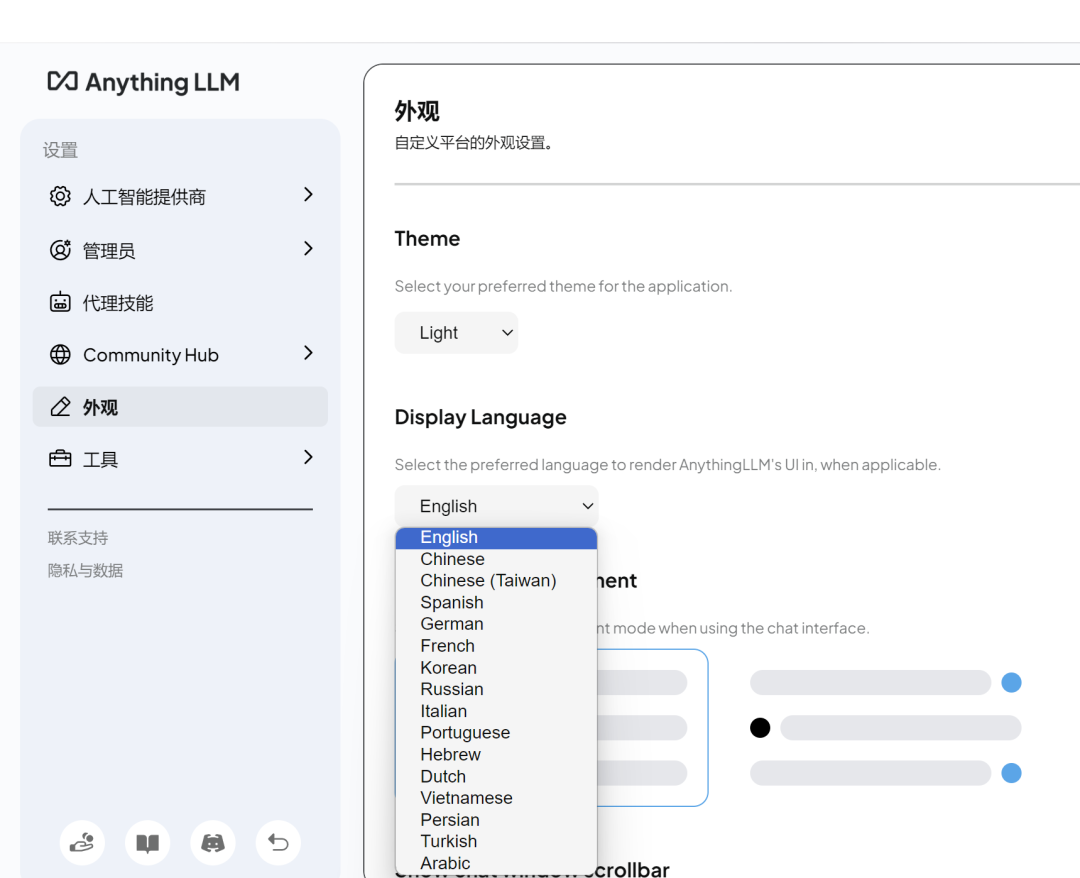

如根据自己的喜好设置:外观、语言等

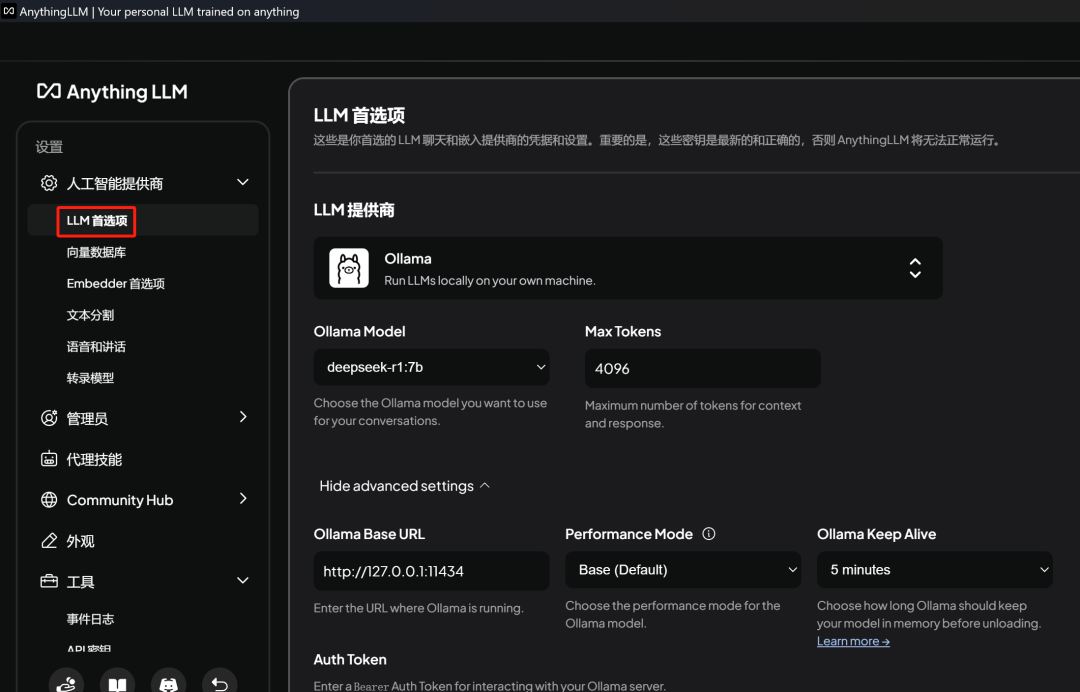

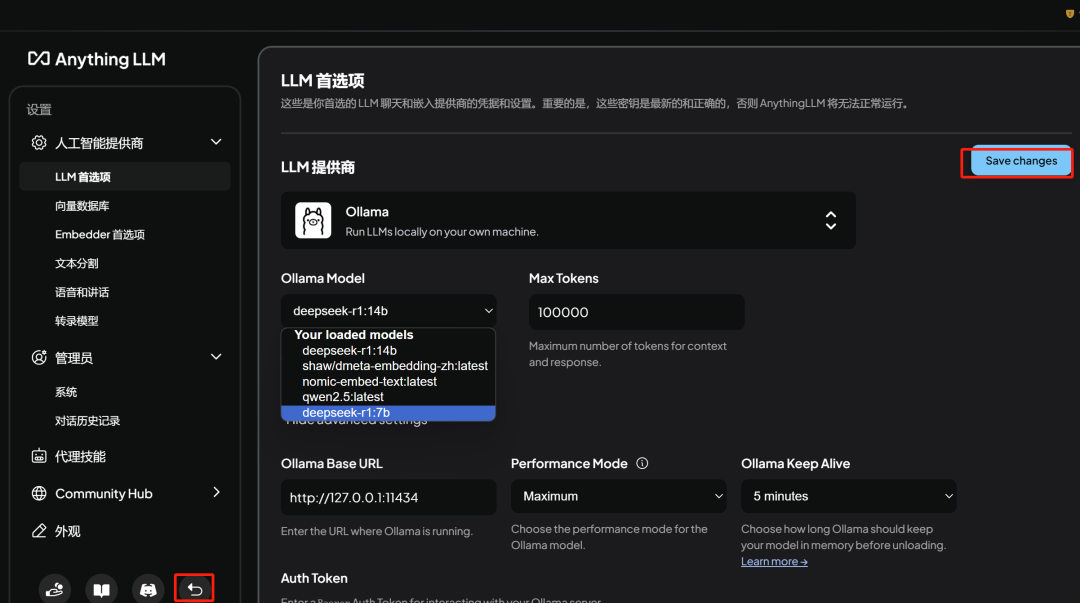

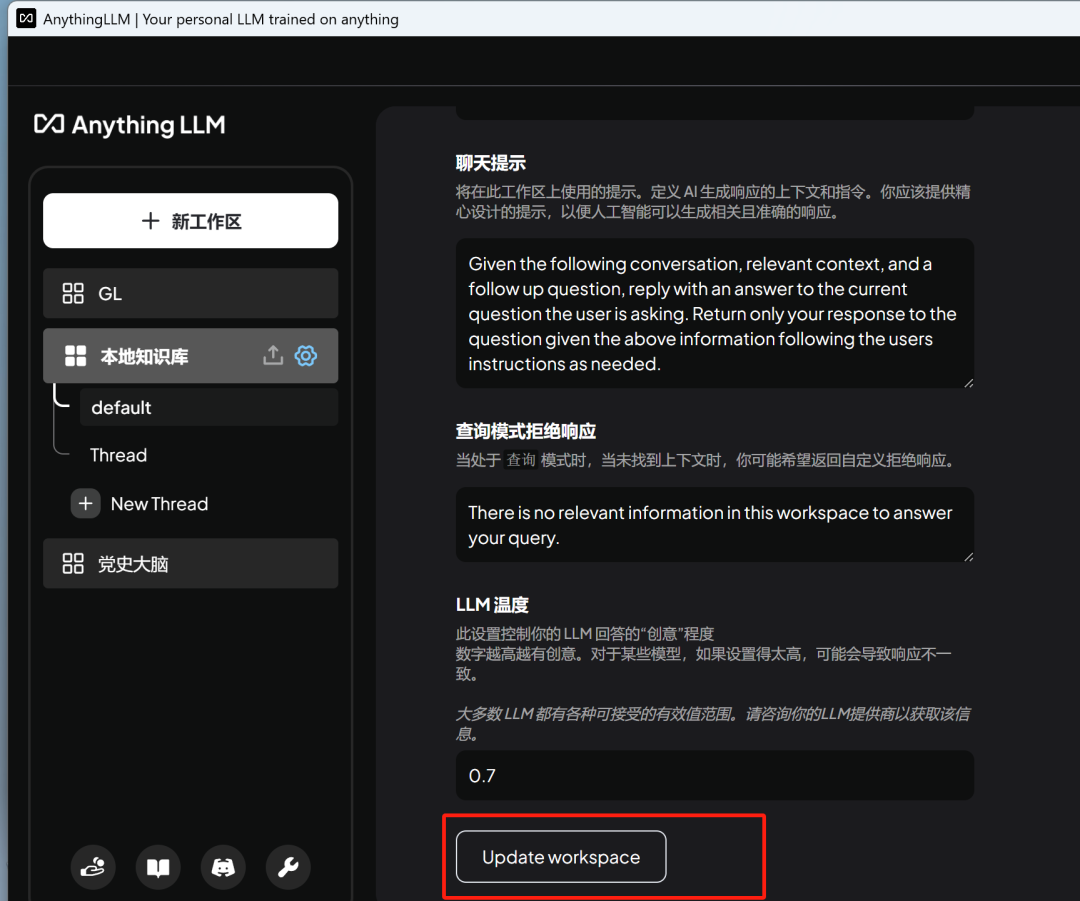

在LLM首选项中设置AI模型,将Deepseek-r1:7b设置为默认模型,如果下载了其他多种模型,如qwen2.5/3,也可以随时修改,设置完成后点击保存模型,然后点击返回,基本完成界面AnythingLlm设置。

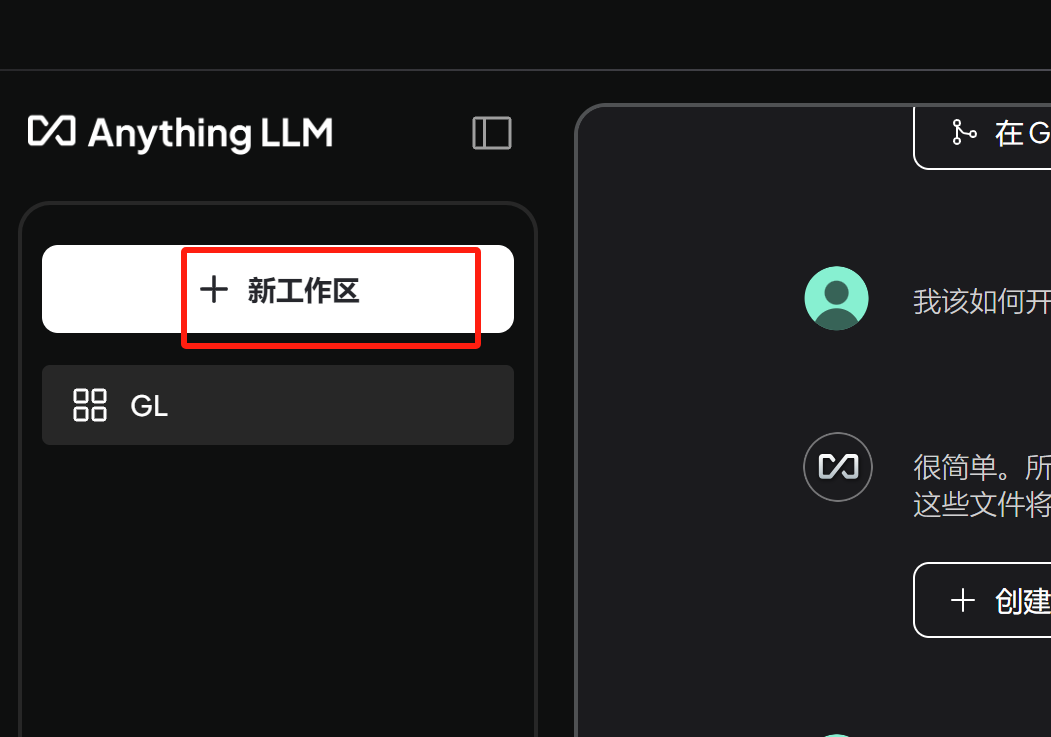

可以创建其他工作区和集成的ollama对话:

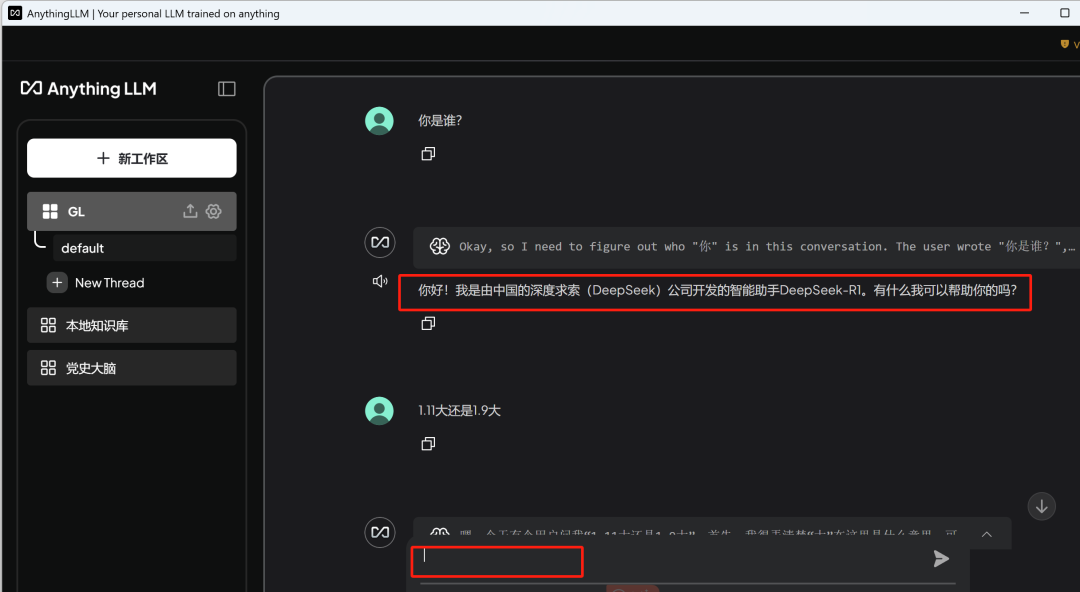

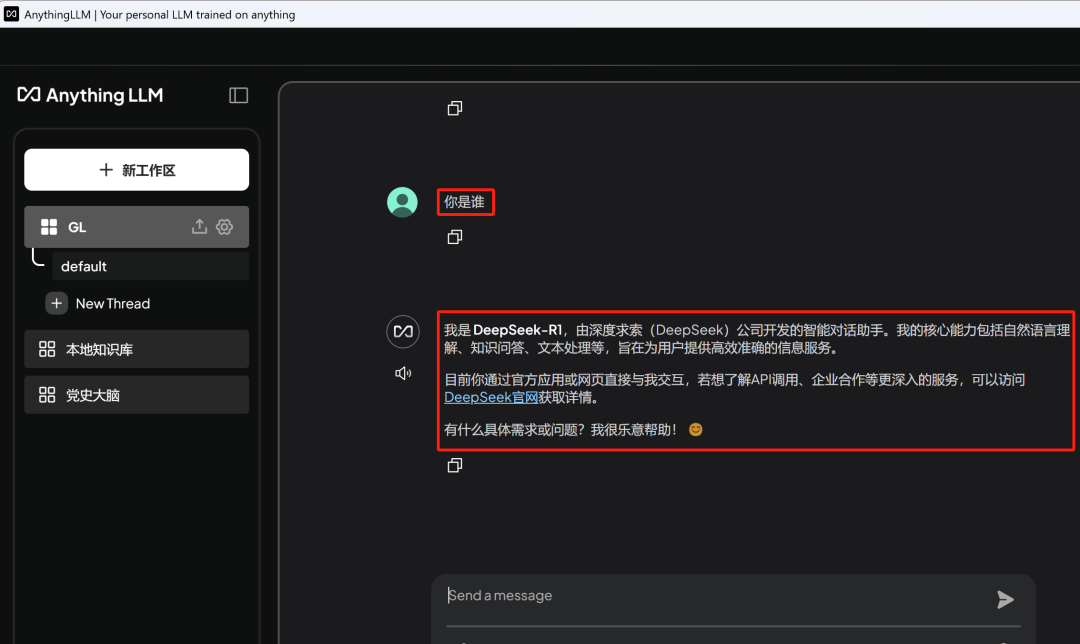

在下面的对话框中输入:你是谁?

将使用deepseek-r1:7b进行回答

你好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。有什么我可以帮助你的吗?

此时你的AI 对话机器人已经创建好了,当然由于本地算力有限,我们只使用了7b的模型进行对话,如果与公有云的Deepseek v3 671B的智能相比较弱,可能在有些问题上会出现幻觉,即答非所问,大家可以使用公有云的和本地部署进行对比。

1.4Anything LLM 对接公有云LLM API

我们知道公有云的deepseek v3和R1都是满血版本:https://chat.deepseek.com/

当然我们将公有云中满血满api对接到本地Anything LLM,实现和公有云同样的模型能力;但需要对公有云LLM API调用输出的tok进行付费。

当然我们将公有云中满血满api对接到本地Anything LLM,实现和公有云同样的模型能力;但需要对公有云LLM API调用输出的tok进行付费。

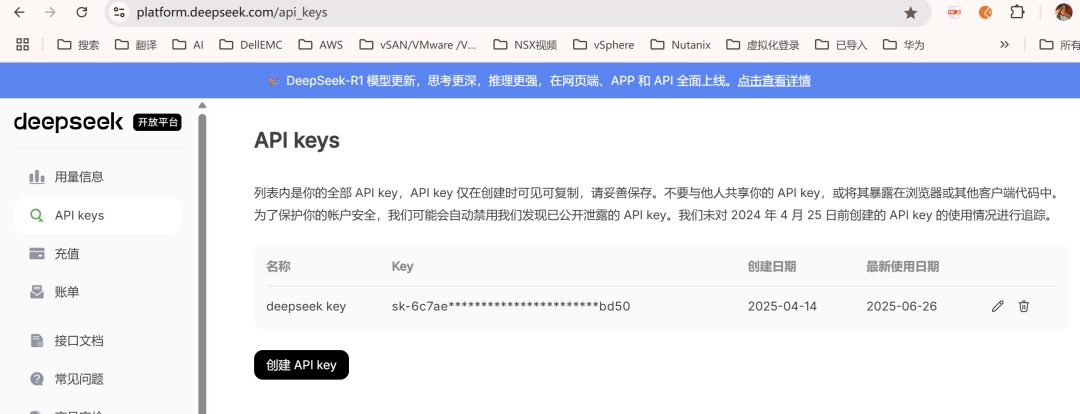

deepseek API注册地址:https://platform.deepseek.com/api_keys

创建对应的API Key

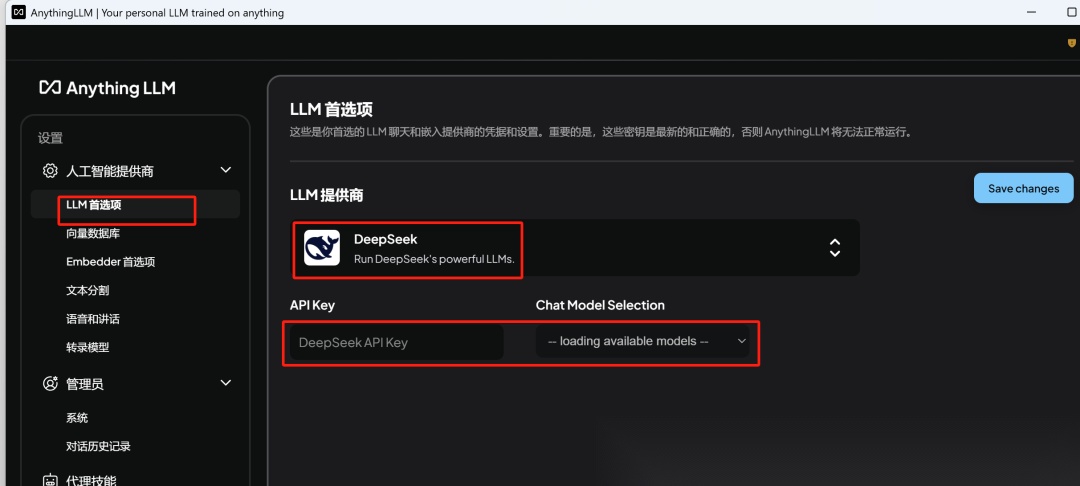

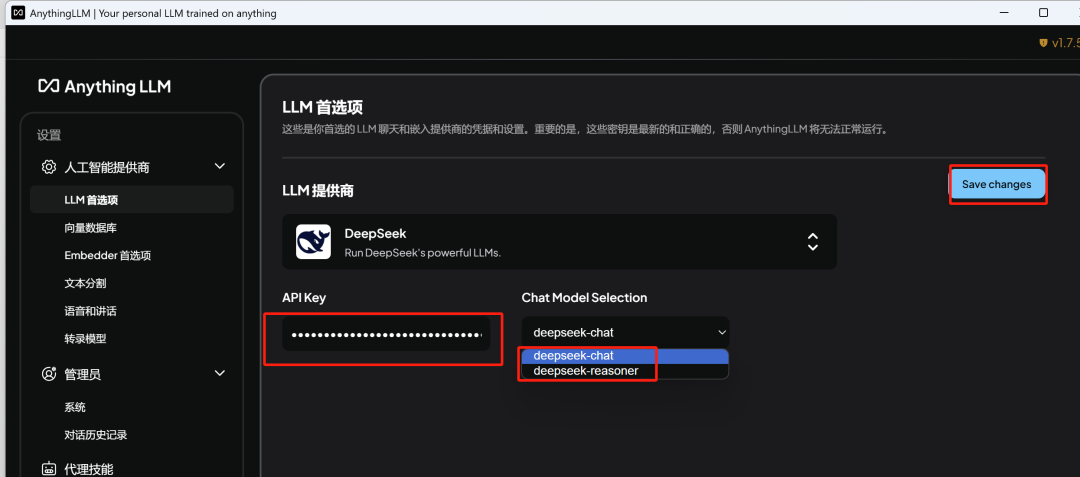

在本地设置对接API key ,选择设置

LLM的供应商选择deepseek

在LLM供应商中查看deekseek并确认

输入key之后,我们需要进行chat models的选择,如V3-Chat或 R1的reasoner

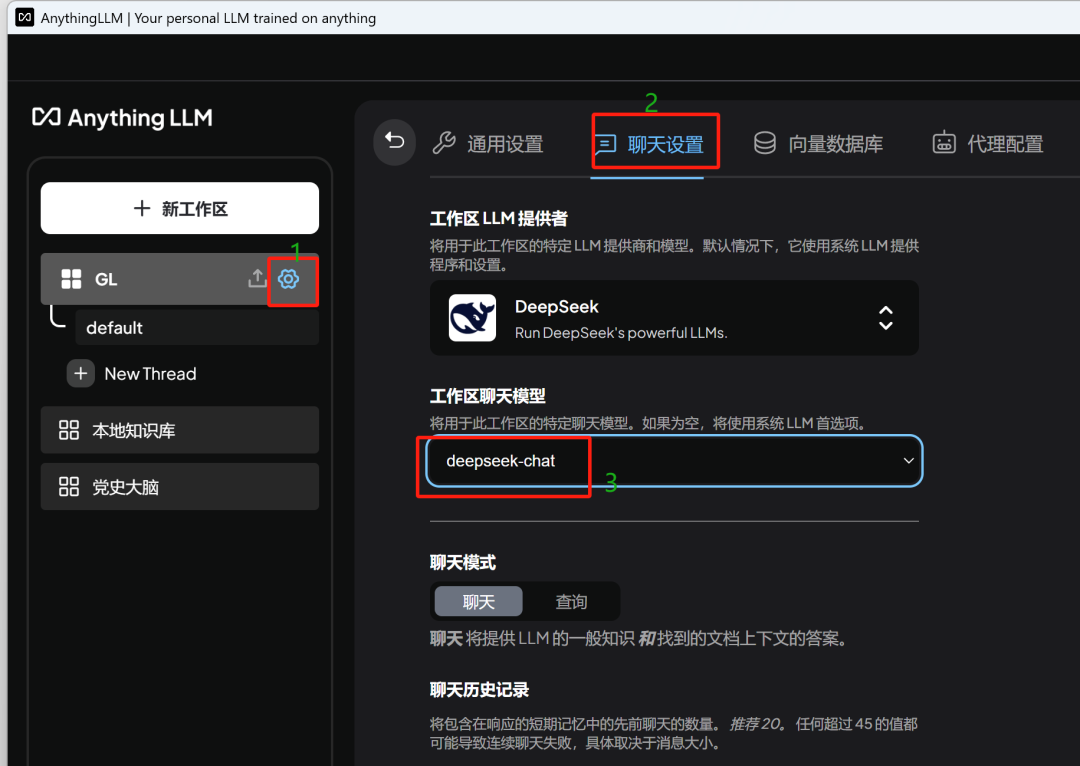

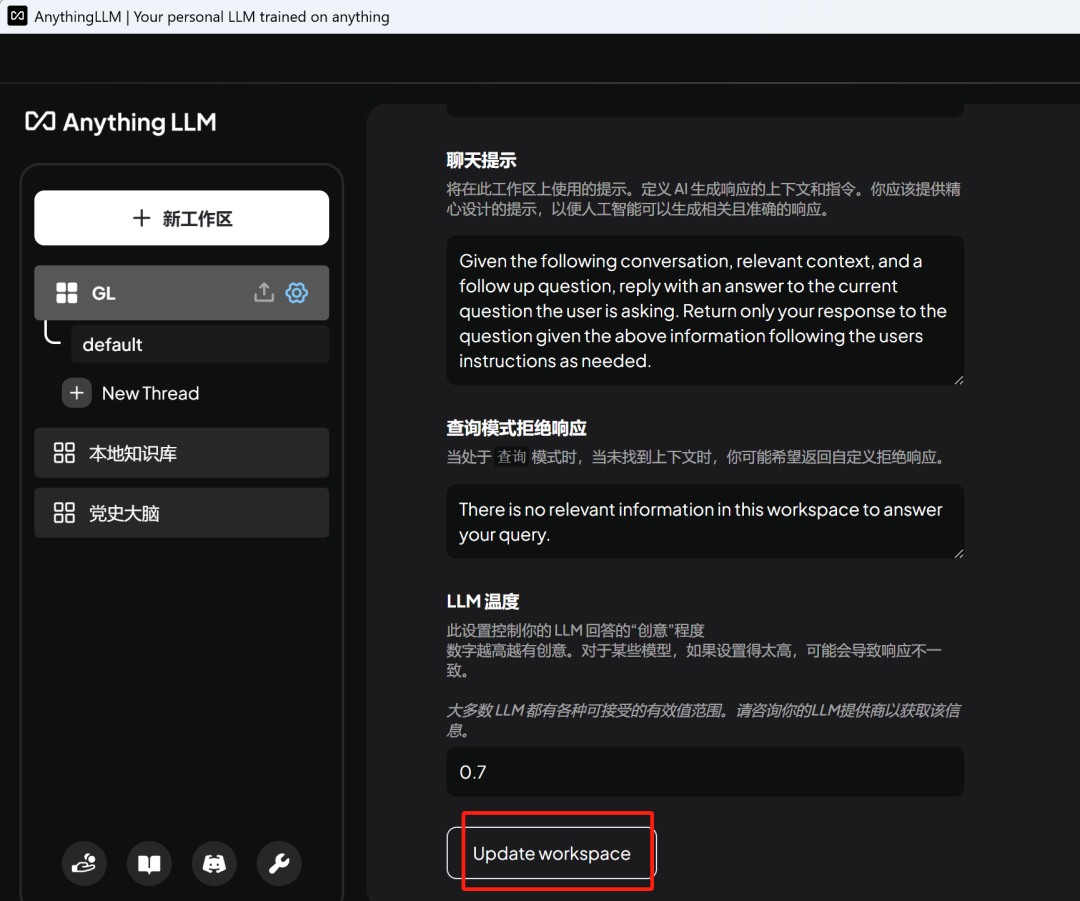

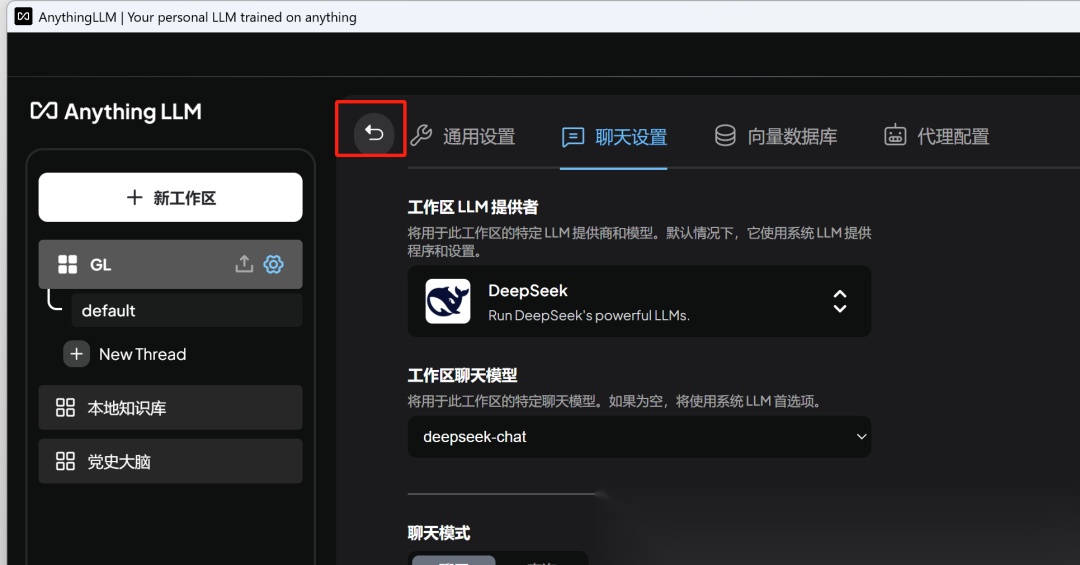

找到创建的聊天工作区,可以进行选择不同的模式

拉到最下面保存设置并返回

再次问:你是谁?调用的就是公有云API进行对话。

我是 DeepSeek-R1,由深度求索(DeepSeek)公司开发的智能对话助手。我的核心能力包括自然语言理解、知识问答、文本处理等,旨在为用户提供高效准确的信息服务。

目前你通过官方应用或网页直接与我交互,若想了解API调用、企业合作等更深入的服务,可以访问DeepSeek官网获取详情。

有什么具体需求或问题?我很乐意帮助! 😊

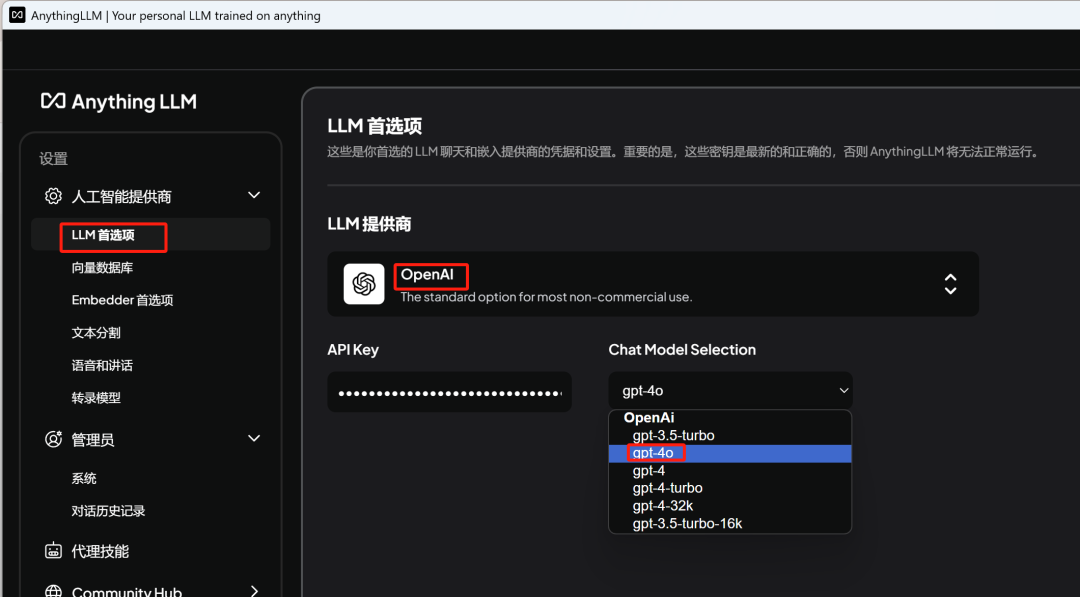

对接OpenAI,购买API key, 参考网站:https://vip.apiyi.com/

复制API key

设置方法与deepseek API key类似,选择模型OpenAI, 输入key并选择模型等

对本地知识库进行设置

保存更新

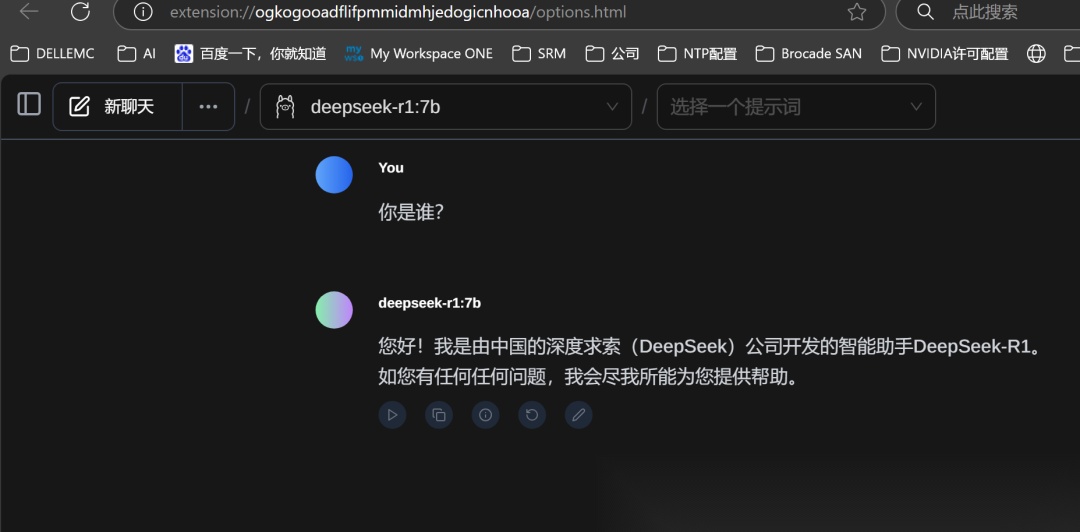

其他AI应用平台示例,如:Cherry Studio、Page Assist、open-webui等也都可以集成Ollama,功能都类似,如果大家感兴趣可以试试。

Cherry Studio界面展示

Edge Page Assist展示

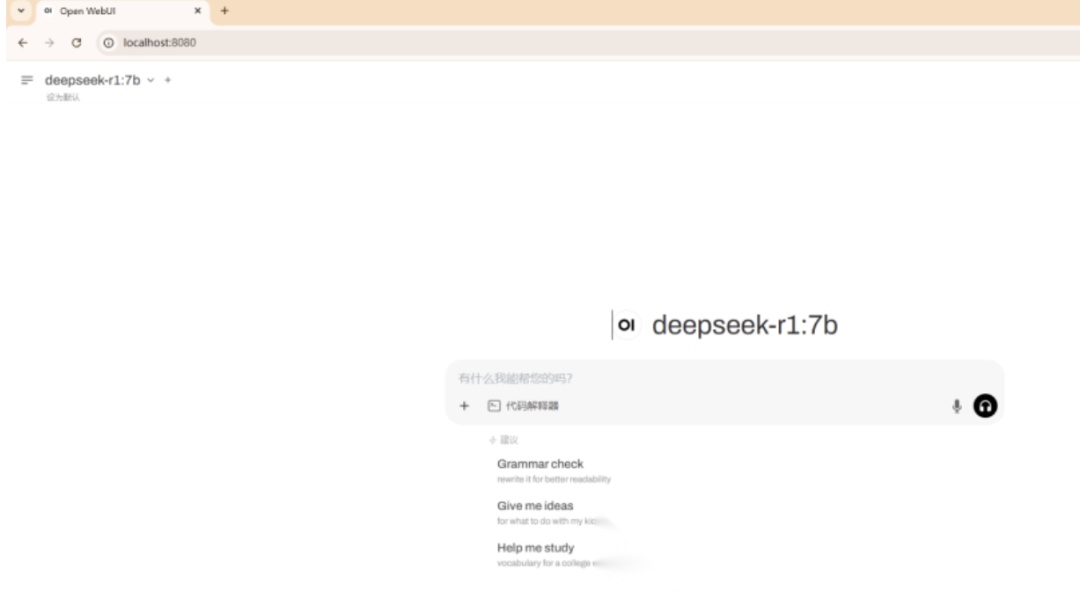

Open WebUI界面展示

想入门 AI 大模型却找不到清晰方向?备考大厂 AI 岗还在四处搜集零散资料?别再浪费时间啦!2025 年 AI 大模型全套学习资料已整理完毕,从学习路线到面试真题,从工具教程到行业报告,一站式覆盖你的所有需求,现在全部免费分享!

👇👇扫码免费领取全部内容👇👇

一、学习必备:100+本大模型电子书+26 份行业报告 + 600+ 套技术PPT,帮你看透 AI 趋势

想了解大模型的行业动态、商业落地案例?大模型电子书?这份资料帮你站在 “行业高度” 学 AI:

1. 100+本大模型方向电子书

2. 26 份行业研究报告:覆盖多领域实践与趋势

报告包含阿里、DeepSeek 等权威机构发布的核心内容,涵盖:

- 职业趋势:《AI + 职业趋势报告》《中国 AI 人才粮仓模型解析》;

- 商业落地:《生成式 AI 商业落地白皮书》《AI Agent 应用落地技术白皮书》;

- 领域细分:《AGI 在金融领域的应用报告》《AI GC 实践案例集》;

- 行业监测:《2024 年中国大模型季度监测报告》《2025 年中国技术市场发展趋势》。

3. 600+套技术大会 PPT:听行业大咖讲实战

PPT 整理自 2024-2025 年热门技术大会,包含百度、腾讯、字节等企业的一线实践:

- 安全方向:《端侧大模型的安全建设》《大模型驱动安全升级(腾讯代码安全实践)》;

- 产品与创新:《大模型产品如何创新与创收》《AI 时代的新范式:构建 AI 产品》;

- 多模态与 Agent:《Step-Video 开源模型(视频生成进展)》《Agentic RAG 的现在与未来》;

- 工程落地:《从原型到生产:AgentOps 加速字节 AI 应用落地》《智能代码助手 CodeFuse 的架构设计》。

二、求职必看:大厂 AI 岗面试 “弹药库”,300 + 真题 + 107 道面经直接抱走

想冲字节、腾讯、阿里、蔚来等大厂 AI 岗?这份面试资料帮你提前 “押题”,拒绝临场慌!

1. 107 道大厂面经:覆盖 Prompt、RAG、大模型应用工程师等热门岗位

面经整理自 2021-2025 年真实面试场景,包含 TPlink、字节、腾讯、蔚来、虾皮、中兴、科大讯飞、京东等企业的高频考题,每道题都附带思路解析:

2. 102 道 AI 大模型真题:直击大模型核心考点

针对大模型专属考题,从概念到实践全面覆盖,帮你理清底层逻辑:

3. 97 道 LLMs 真题:聚焦大型语言模型高频问题

专门拆解 LLMs 的核心痛点与解决方案,比如让很多人头疼的 “复读机问题”:

三、路线必明: AI 大模型学习路线图,1 张图理清核心内容

刚接触 AI 大模型,不知道该从哪学起?这份「AI大模型 学习路线图」直接帮你划重点,不用再盲目摸索!

路线图涵盖 5 大核心板块,从基础到进阶层层递进:一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

四、资料领取:全套内容免费抱走,学 AI 不用再找第二份

不管你是 0 基础想入门 AI 大模型,还是有基础想冲刺大厂、了解行业趋势,这份资料都能满足你!

现在只需按照提示操作,就能免费领取:

👇👇扫码免费领取全部内容👇👇

2025 年想抓住 AI 大模型的风口?别犹豫,这份免费资料就是你的 “起跑线”!

更多推荐

已为社区贡献540条内容

已为社区贡献540条内容

所有评论(0)