面向“病历生成 + CDI/ICD”多智能体系统的选型策略与落地实践(一)

本研究提出了一套完整的面向"病历生成+CDI/ICD"多智能体系统的架构设计与实施方案,主要贡献包括:1. **提出了"可控编排大于自由自治"的设计理念**,将医疗AI系统定位为可审计的工作流系统,而非自由对话体,确保了系统的安全性、可追溯性和可控性。2. **设计了"双轨同构迁移"架构**,使同一套技术栈能够根据不同的合规和弹性需求,灵活部署在院内环境或全院服务化环境,降低了技术复杂性和维护成本

摘要

本论文详细阐述了一套面向医疗领域“病历生成与临床文档改进(CDI)/国际疾病分类(ICD)”任务的多智能体系统架构设计与落地实施方案。针对医疗场景的特殊性——严格的合规要求、数据隐私保护、临床质量控制需求,我们提出了以“可控编排大于自由自治”为核心的设计理念,并构建了双轨同构迁移架构,使同一套技术栈既能满足院内闭环合规要求,又能平滑迁移到全院服务化弹性架构。论文重点阐述了基于Kubernetes的容器化部署方案、质量门禁体系设计、FHIR互操作标准集成以及针对Oracle数据库与SOAP WebService的具体实现方案,为医院智能化病历系统建设提供了完整的技术参考框架。

关键词:医疗多智能体、病历生成、临床文档改进、ICD编码、Kubernetes、医疗合规、FHIR、质量门禁

第一章 引言

1.1 研究背景与意义

随着人工智能技术在医疗领域的深入应用,智能化病历生成与临床文档改进成为医院信息化建设的重要方向。传统的病历书写与编码工作存在效率低下、质量参差不齐、编码准确性不足等问题。据统计,临床医生花费约35%的工作时间用于文书工作[1],而ICD编码错误导致的医疗费用损失占医院总收入的1-5%[2]。在此背景下,基于大语言模型的多智能体系统为自动化病历生成、临床文档质量改进和智能编码提供了新的技术路径。

然而,医疗AI应用面临多重挑战:1)数据隐私与合规性要求严格;2)临床决策责任重大,系统必须可控可审计;3)需要与现有医院信息系统深度集成;4)输出质量直接影响患者安全和医院运营。因此,设计一套既具备先进AI能力,又符合医疗行业特殊要求的系统架构至关重要。

1.2 研究目标与内容

本研究旨在提出一套完整的面向“病历生成+CDI/ICD”多智能体系统的选型策略与落地建议,具体包括:

- 提出“可控编排大于自由自治”的多智能体医疗应用设计原则

- 设计“双轨同构迁移”总体架构,兼顾院内合规与全院弹性

- 制定模块化智能体拆分策略,构建可验收的最小闭环

- 建立四层质量门禁体系,将医疗治理融入CI/CD流程

- 设计基于FHIR标准的互操作方案,支持系统间数据交换

- 提供基于具体技术栈(Oracle+SOAP)的详细实施方案

1.3 论文结构

本论文共分为七章:第一章为引言;第二章阐述多智能体系统的正确打开方式;第三章介绍双轨同构迁移总体架构;第四章详细说明智能体拆分方案;第五章深入探讨质量门禁体系;第六章分析互操作设计;第七章提供完整落地实施方案。最后是总结与展望。

第二章 医疗多智能体系统的正确打开方式:可控编排 > 自由自治

2.1 医疗场景的特殊性与风险

医疗AI应用区别于通用AI应用的核心在于其高风险性和强监管性。病历文档不仅是医疗记录,更是法律证据、医保结算依据和科研数据来源。智能体系统的任何错误都可能导致临床决策失误、医疗纠纷或经济损失。因此,医疗多智能体系统设计必须遵循以下核心原则:

- 安全性优先:避免生成误导性、矛盾性或不完整的医疗信息

- 可追溯性:每一个输出的生成过程必须可追溯、可审计

- 可控性:系统行为必须受控,避免不可预测的"自由发挥"

- 人在环路:关键决策必须保留人工审核确认环节

2.2 可审计的工作流系统架构

基于上述原则,我们建议将多智能体系统定义为可审计的工作流系统,而非自由对话体。具体实现方式包括:

2.2.1 编排形态选择

优先选择基于有向无环图(DAG)或状态机的步骤编排模式,确保:

- 每一步输入输出可记录、可回放

- 支持灰度发布与A/B测试

- 支持局部故障恢复与重试

2.2.2 关键能力设计

系统必须具备以下关键能力:

- 可观测性(Trace):全链路追踪,每个智能体操作都有唯一trace_id

- 可回滚性:提示词、知识库、模型版本的完整版本控制

- 可控性:严格的工具白名单、权限控制和操作限制

- 可度量性:离线评测与线上监控相结合的度量体系

2.2.3 人工介入机制设计

在以下关键环节必须设计人工介入点:

- 病历最终签署

- ICD编码确认

- CDI重要缺口确认(特别是可能影响DRG分组的项目)

- 系统低置信度输出

经验法则:越接近"收费、质控、法律责任"的环节,越需要将智能体降级为"流程节点",而非"自由对话体"。

2.3 技术选型建议

2.3.1 工作流编排引擎

| 引擎 | 适用场景 | 医疗场景优势 | 注意事项 |

|---|---|---|---|

| Temporal | 长期运行、需要状态持久化的工作流 | 强一致性、可回放、内置重试机制 | 学习曲线较陡 |

| Argo Workflows | Kubernetes原生工作流 | 与K8s生态集成好,资源调度灵活 | 状态管理相对简单 |

| Apache Airflow | 数据处理管道 | 成熟度高,社区活跃 | 更适合批处理而非实时交互 |

| Prefect | 现代数据工作流 | API设计友好,监控完善 | 医疗行业案例相对较少 |

对于医疗场景,推荐Temporal,因其提供:

- 确定性执行保证

- 工作流状态自动持久化

- 内置的错误处理和重试机制

- 支持长时间运行的工作流(病历生成可能涉及多轮人工交互)

2.3.2 智能体框架选择

| 框架 | 核心特点 | 医疗适用性 |

|---|---|---|

| LangChain | 工具链丰富,生态成熟 | 适合快速原型,但生产环境需加固 |

| LlamaIndex | 检索增强生成(RAG)优化 | 适合知识密集型任务 |

| AutoGen | 多智能体对话 | 学术研究有价值,生产环境风险较高 |

| Haystack | 文档处理管道 | 适合文档分析与提取任务 |

| 自研框架 | 完全可控,定制性强 | 适合有严格合规要求的大型医疗机构 |

推荐策略:基于成熟框架(如LangChain)进行二次封装,增加医疗特定约束:

- 输出JSON Schema强制验证

- 工具调用审计日志

- 证据引用强制要求

- 毒性内容过滤

第三章 "双轨同构迁移"总体架构:一套容器化栈,两种落地形态

3.1 架构设计理念

"双轨同构迁移"核心思想是:使用同一套容器化技术栈,通过配置切换实现在不同环境(合规优先 vs 弹性优先)的部署。这种设计避免了传统"两套系统"带来的维护成本和技术债务。

3.1.1 双轨定义

-

轨道A:全院服务化与弹性架构

- 目标:最大化资源利用率,支持弹性伸缩

- 场景:互联网医院、区域医疗平台、多院区统一部署

- 特点:多云/混合云部署,自动扩缩容,服务网格

-

轨道B:院内合规优先架构

- 目标:满足数据不出院、强审计、高可控性要求

- 场景:核心医疗业务、敏感数据处理、法规严格场景

- 特点:私有化部署,网络隔离,硬件加密

3.1.2 同构实现原理

通过以下技术实现同构:

- 统一容器镜像:使用相同的基础镜像和业务镜像

- 配置外部化:通过ConfigMap、Secret和环境变量区分环境

- 部署模板化:使用Helm Charts或Kustomize管理不同环境的部署配置

- 流水线一致:CI/CD流程相同,仅目标环境和参数不同

3.2 轨道A:全院服务化与弹性架构

3.2.1 核心组件选型

关键技术说明:

-

KServe (基于Knative):提供模型服务的标准化接口、自动伸缩和多版本管理

# KServe InferenceService示例 apiVersion: serving.kserve.io/v1beta1 kind: InferenceService metadata: name: medical-llm-service spec: predictor: minReplicas: 2 maxReplicas: 20 scaleTarget: 50 # 并发目标 containers: - image: registry/medical-llm:v2.1 args: - --model-id=clinical-bert - --max-batch-size=32 -

Triton Inference Server:NVIDIA的统一推理服务,优势包括:

- 支持多种框架模型(TensorRT, PyTorch, ONNX等)

- 动态批处理与并发执行

- 模型流水线编排

- 性能监控与优化

-

vLLM:专为大语言模型设计的高吞吐推理服务

- PagedAttention优化内存使用

- OpenAI兼容API

- 连续批处理提高GPU利用率

选型建议:

- vLLM:更适合"LLM专用高吞吐服务层",上手快、接口友好

- Triton:更适合"统一推理底座",异构模型支持好、批处理能力强

3.2.2 弹性伸缩策略

-

基于指标的自动伸缩(HPA):

apiVersion: autoscaling/v2 kind: HorizontalPodAutoscaler spec: scaleTargetRef: apiVersion: apps/v1 kind: Deployment name: medical-llm minReplicas: 2 maxReplicas: 20 metrics: - type: Resource resource: name: cpu target: type: Utilization averageUtilization: 70 - type: Pods # 自定义指标 pods: metric: name: requests_per_second target: type: AverageValue averageValue: 100 -

基于事件的自动伸缩(KEDA):响应消息队列、数据库事件等

-

定时伸缩:应对门诊高峰等可预测负载

3.3 轨道B:院内合规优先架构

3.3.1 核心设计要求

- 数据不出院:所有组件部署在院内网络边界内

- 最小权限原则:每个组件仅有完成其功能所需的最小权限

- 全链路审计:从数据访问到结果回写的完整审计日志

- 故障隔离:单一组件故障不影响核心医疗业务

3.3.2 合规性标准对齐

系统设计需对齐以下国内医疗数据安全标准:

-

GB/T 39725-2020《信息安全技术 健康医疗数据安全指南》

- 数据分类分级保护要求

- 数据生命周期安全管理

- 数据共享与交换安全要求

-

YD/T 6285-2024《医疗健康大数据平台数据安全治理能力成熟度评估方法》

- 数据安全治理框架

- 能力成熟度评估模型

- 实施指南与最佳实践

-

**《网络安全法》《数据安全法》《个人信息保护法》**相关要求

3.3.3 技术实现方案

# 院内部署网络隔离策略

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: med-ai-isolation

namespace: med-ai-prod

spec:

podSelector: {} # 应用于所有Pod

policyTypes:

- Ingress

- Egress

# 默认拒绝所有流量

ingress: []

egress: []

---

# 开放必要通信

apiVersion: networking.k8s.io/v1

kind: NetworkPolicy

metadata:

name: allow-ai-components

spec:

podSelector:

matchLabels:

app.kubernetes.io/part-of: medical-ai

ingress:

- from:

- podSelector:

matchLabels:

app.kubernetes.io/component: api-gateway

egress:

- to:

- podSelector:

matchLabels:

app.kubernetes.io/component: vllm

ports:

- protocol: TCP

port: 8000

- to:

- namespaceSelector:

matchLabels:

kubernetes.io/metadata.name: emr-system

ports:

- protocol: TCP

port: 1521 # Oracle

- protocol: TCP

port: 443 # SOAP WebService

3.3.4 同构迁移实现

通过环境配置实现轨道间迁移:

# values-prod-a.yaml (轨道A: 弹性架构)

global:

environment: production-a

domain: ai.medcloud.example.com

kserve:

enabled: true

autoscaling:

minReplicas: 2

maxReplicas: 20

networking:

egressPolicy: open

serviceMesh: istio

modelServer:

type: vllm

gpu: true

resources:

limits:

nvidia.com/gpu: 2

# values-prod-b.yaml (轨道B: 合规架构)

global:

environment: production-b

domain: ai.medlocal.example.com

kserve:

enabled: false # 院内环境可能不需要KServe

deployment:

replicaCount: 2 # 固定副本数

networking:

egressPolicy: restricted

allowedEgress:

- 10.0.100.0/24 # EMR网段

- 10.0.200.0/24 # 内部服务网段

modelServer:

type: vllm

gpu: true

resources:

limits:

nvidia.com/gpu: 1 # 院内GPU资源有限

3.4 双轨架构对比分析

| 维度 | 轨道A (弹性优先) | 轨道B (合规优先) | 同构实现方式 |

|---|---|---|---|

| 部署位置 | 公有云/混合云 | 院内私有云/一体机 | 同一容器镜像 |

| 网络策略 | 按需开放 | 严格限制,默认拒绝 | NetworkPolicy配置差异 |

| 数据存储 | 云存储服务 | 院内存储系统 | 存储类(StorageClass)抽象 |

| 模型服务 | KServe + 自动伸缩 | Deployment + 固定副本 | Helm values配置切换 |

| 监控系统 | 云原生监控栈 | 院内监控系统 | 统一OpenTelemetry标准 |

| 安全合规 | 云安全最佳实践 | 医疗行业特定合规 | 策略即代码 |

第四章 面向"病历生成 + CDI/ICD"的多智能体参考拆分

4.1 模块化拆分原则

将复杂任务拆分为可独立开发、测试和部署的模块,每个模块具备:

- 清晰的输入/输出契约:明确定义的接口规范

- 可度量的质量指标:每个模块都有对应的验收标准

- 独立的版本管理:模块可独立升级演进

- 故障隔离边界:单个模块故障不影响整体系统

4.2 核心智能体模块设计

4.2.1 上下文构建 Agent

功能职责:

- 从EMR系统提取患者就诊的结构化信息

- 整合关键自由文本内容(主诉、现病史等)

- 构建完整的就诊上下文摘要

输入输出规范:

{

"input": {

"patient_id": "123456",

"encounter_id": "789012",

"data_scopes": ["diagnosis", "lab", "medication", "procedure"]

},

"output": {

"encounter_summary": {

"demographics": {...},

"timeline": [...],

"problems": [...],

"evidence_sources": [

{"type": "structured", "field": "primary_diagnosis", "value": "I10"},

{"type": "text", "source": "chief_complaint", "snippet": "持续性头痛3天"}

]

}

}

}

关键技术实现:

class ContextBuilderAgent:

def __init__(self, emr_connector: EmrConnector):

self.emr = emr_connector

def build_context(self, patient_id: str, encounter_id: str) -> Context:

# 1. 提取结构化数据

structured_data = self.emr.fetch_structured_data(encounter_id)

# 2. 提取关键文本片段

text_snippets = self.extract_key_snippets(structured_data)

# 3. 构建时间线

timeline = self.build_timeline(structured_data)

# 4. 识别关键医疗事件

events = self.identify_medical_events(structured_data)

# 5. 证据溯源标记

evidence_map = self.create_evidence_map(structured_data, text_snippets)

return Context(

patient_id=patient_id,

encounter_id=encounter_id,

structured_data=structured_data,

text_snippets=text_snippets,

timeline=timeline,

events=events,

evidence_map=evidence_map

)

4.2.2 病历生成 Agent

功能职责:

- 基于科室模板生成结构化病历文档

- 确保生成内容与证据源对齐

- 保持医学专业性和格式规范性

模板化管理:

# 科室病历模板定义

template_id: internal_medicine_admission

sections:

- name: 主诉

required: true

constraints:

max_length: 200

must_contain: ["症状", "持续时间"]

evidence_mapping:

- source_field: chief_complaint

required: true

- name: 现病史

required: true

structure:

- onset_time

- progression

- treatment_history

evidence_mapping:

- source_field: history_of_present_illness

- source_field: previous_treatments

- name: 既往史

required: false

evidence_mapping:

- source_field: past_medical_history

- source_field: surgical_history

- name: 体格检查

required: true

evidence_mapping:

- source_field: vital_signs

- source_field: physical_exam_findings

生成过程控制:

class NoteGenerationAgent:

def generate_note(self, context: Context, template_id: str) -> ClinicalNote:

# 1. 加载模板

template = self.template_registry.get_template(template_id)

# 2. 按模板章节生成内容

sections = []

for section_template in template.sections:

# 2.1 收集相关证据

evidence = self.collect_evidence(

context,

section_template.evidence_mapping

)

# 2.2 生成章节内容

section_content = self.generate_section(

section_template,

evidence,

context

)

# 2.3 验证章节完整性

if not self.validate_section(section_content, section_template):

raise ValidationError(f"Section {section_template.name} validation failed")

sections.append({

"name": section_template.name,

"text": section_content,

"evidence": evidence,

"template_version": template.version

})

# 3. 组装完整病历

note = ClinicalNote(

encounter_id=context.encounter_id,

template_id=template_id,

sections=sections,

metadata={

"generated_at": datetime.now(),

"model_version": self.model_version,

"evidence_coverage": self.calculate_coverage(sections)

}

)

return note

4.2.3 事实一致性/证据对齐 Agent

功能职责:

- 检测生成内容与原始证据的矛盾

- 识别时间线不一致问题

- 发现数值逻辑错误

- 提供具体的修订建议而非重新生成

校验规则引擎:

class FactConsistencyValidator:

def __init__(self, rule_engine: RuleEngine):

self.rules = rule_engine

def validate(self, note: ClinicalNote, context: Context) -> ValidationResult:

violations = []

# 1. 时间线一致性检查

timeline_violations = self.check_timeline_consistency(note, context)

violations.extend(timeline_violations)

# 2. 数值逻辑检查

numeric_violations = self.check_numeric_logic(note, context)

violations.extend(numeric_violations)

# 3. 诊断-检查-治疗一致性

clinical_violations = self.check_clinical_consistency(note, context)

violations.extend(clinical_violations)

# 4. 证据覆盖检查

coverage_violations = self.check_evidence_coverage(note)

violations.extend(coverage_violations)

return ValidationResult(

is_valid=len(violations) == 0,

violations=violations,

suggestions=self.generate_suggestions(violations)

)

def check_timeline_consistency(self, note, context) -> List[Violation]:

violations = []

# 检查时间先后顺序逻辑

for section in note.sections:

time_mentions = self.extract_time_mentions(section.text)

for i in range(len(time_mentions) - 1):

if time_mentions[i].date > time_mentions[i+1].date:

violations.append(

TimelineViolation(

section=section.name,

description=f"时间顺序矛盾: {time_mentions[i]} 晚于 {time_mentions[i+1]}",

severity="high"

)

)

return violations

验证规则示例:

validation_rules:

- rule_id: timeline_consistency

description: "检查时间线逻辑一致性"

severity: high

condition: "任何后续事件时间早于先前事件"

action: "标记为时间线矛盾,建议修订"

- rule_id: lab_value_consistency

description: "检查检验数值与参考范围一致性"

severity: medium

condition: "检验值超出参考范围但未标记异常"

action: "建议添加异常标记或注释"

- rule_id: medication_dose_check

description: "检查药物剂量合理性"

severity: high

condition: "剂量超过常规治疗范围"

action: "标记为潜在剂量错误,需要人工确认"

- rule_id: diagnosis_support

description: "检查诊断是否有足够证据支持"

severity: high

condition: "主要诊断在检验/检查中无对应异常发现"

action: "建议补充诊断依据或重新评估诊断"

4.2.4 CDI 缺口发现 Agent

功能职责:

- 识别影响编码准确性的文档缺口

- 评估缺口严重程度(低/中/高)

- 提供具体的补充建议

- 关联相关证据源

CDI规则库设计:

class CDIRuleEngine:

def __init__(self, rule_repository: RuleRepository):

self.rules = rule_repository.load_rules()

def analyze_gaps(self, note: ClinicalNote, context: Context) -> List[CDIGap]:

gaps = []

for rule in self.rules:

# 应用规则检查

if not self.rule_applies(rule, note, context):

continue

# 检查规则条件是否满足

if not self.check_condition(rule.condition, note, context):

# 发现缺口

gap = CDIGap(

rule_id=rule.id,

title=rule.title,

severity=rule.severity,

description=rule.description,

question_to_clinician=rule.question,

recommended_fields=self.get_recommended_fields(rule),

evidence=self.collect_evidence_for_gap(rule, context)

)

gaps.append(gap)

# 按严重度排序

gaps.sort(key=lambda x: self.severity_weight(x.severity), reverse=True)

return gaps

CDI规则示例:

{

"rule_id": "CDI-RULE-001",

"title": "主要诊断支持证据不足",

"description": "主要诊断缺乏足够的实验室或影像学证据支持",

"severity": "high",

"impact": ["DRG分组", "医疗质量", "医保结算"],

"condition": {

"logic": "AND",

"conditions": [

{

"field": "primary_diagnosis.code",

"operator": "exists"

},

{

"field": "supporting_evidence_count",

"operator": "lt",

"value": 2

},

{

"field": "diagnosis.certainty",

"operator": "eq",

"value": "confirmed"

}

]

},

"recommended_actions": [

{

"action": "补充实验室检查结果",

"field": "lab_results",

"examples": ["血常规", "生化全项", "炎症指标"]

},

{

"action": "补充影像学发现",

"field": "imaging_findings",

"examples": ["CT", "MRI", "超声"]

}

],

"question_to_clinician": "主要诊断'I10 原发性高血压'的确诊依据是什么?是否已排除继发性高血压?"

}

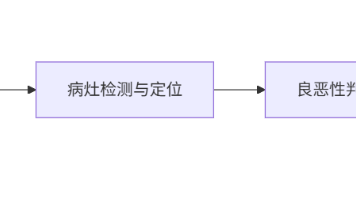

4.2.5 ICD 建议 Agent

功能职责:

- 基于病历内容推荐ICD编码

- 提供置信度评分

- 关联支持证据

- 标识需要人工审核的低置信度建议

ICD编码推荐算法:

class ICDRecommendationAgent:

def __init__(self,

embedding_model: EmbeddingModel,

icd_knowledge_base: ICDKnowledgeBase):

self.embedder = embedding_model

self.kb = icd_knowledge_base

def recommend_icd(self, note: ClinicalNote, context: Context) -> List[ICDRecommendation]:

recommendations = []

# 1. 提取临床特征向量

clinical_features = self.extract_features(note, context)

feature_vector = self.embedder.encode(clinical_features)

# 2. 在ICD知识库中检索相似病例

similar_cases = self.kb.search_similar_cases(

feature_vector,

top_k=50

)

# 3. 统计ICD分布

icd_distribution = self.analyze_distribution(similar_cases)

# 4. 生成推荐列表

for icd_code, stats in icd_distribution.items():

confidence = self.calculate_confidence(stats)

# 收集支持证据

supporting_evidence = self.collect_supporting_evidence(

icd_code, note, context

)

recommendation = ICDRecommendation(

code=icd_code,

description=self.kb.get_description(icd_code),

confidence=confidence,

supporting_evidence=supporting_evidence,

similar_cases_count=stats['count'],

need_human_review=confidence < self.review_threshold

)

recommendations.append(recommendation)

# 5. 按置信度排序

recommendations.sort(key=lambda x: x.confidence, reverse=True)

return recommendations[:10] # 返回Top-10建议

def calculate_confidence(self, stats: dict) -> float:

"""计算ICD编码置信度"""

base_confidence = stats['count'] / stats['total_cases']

# 考虑特征匹配度

feature_match = stats.get('feature_match', 0.5)

# 考虑编码历史准确性

historical_accuracy = self.kb.get_historical_accuracy(stats['code'])

# 综合置信度计算

confidence = (

0.4 * base_confidence +

0.3 * feature_match +

0.3 * historical_accuracy

)

return round(confidence, 3)

4.3 智能体间协作模式

4.4 模块拆分的优势

- 独立验收:每个模块可单独测试和验收

- 渐进式改进:可针对性优化弱模块而不影响整体

- 技术栈灵活性:不同模块可使用最适合的技术实现

- 故障隔离:单个模块故障不会导致整个系统崩溃

- 团队协作:不同团队可并行开发不同模块

第五章 质量门禁体系:将医疗治理融入CI/CD

5.1 质量门禁的重要性

在医疗AI系统中,质量门禁不仅是技术最佳实践,更是法规合规要求。缺乏有效质量控制的AI系统可能导致:

- 临床决策错误

- 医疗事故风险

- 医保欺诈风险

- 法律诉讼风险

- 患者安全威胁

5.2 四层质量门禁体系

5.2.1 第一层:离线回归测试

目标:确保每次代码/模型/配置变更不引入回归问题

实施要点:

-

测试数据集管理

- 覆盖不同科室、病种、病例复杂度

- 定期更新以反映真实病例分布

- 包含边界情况和异常案例

-

关键指标监控

# 离线测试指标计算 class OfflineEvaluator: def evaluate(self, generated_notes: List[ClinicalNote], gold_standards: List[GoldStandard]) -> EvaluationResults: results = {} # 事实一致性指标 results['fact_consistency'] = self.calculate_fact_consistency( generated_notes, gold_standards ) # 完整性指标 results['completeness'] = self.calculate_completeness( generated_notes, gold_standards ) # 安全性指标 results['safety_score'] = self.evaluate_safety( generated_notes ) # ICD编码准确性 results['icd_accuracy'] = self.evaluate_icd_accuracy( generated_notes, gold_standards ) # 证据覆盖度 results['evidence_coverage'] = self.calculate_evidence_coverage( generated_notes ) return results -

自动化执行集成

# CI流水线配置示例 stages: - test - build - evaluate - deploy evaluate: stage: evaluate script: - python run_offline_evaluation.py \ --test-set-path ./test_sets/v2.1 \ --model-version ${CI_COMMIT_SHA} \ --output-dir ./evaluation_results # 检查门禁阈值 - python check_gates.py \ --results ./evaluation_results/metrics.json \ --thresholds ./config/gate_thresholds.yaml artifacts: paths: - evaluation_results/ rules: - if: '$CI_COMMIT_BRANCH == "main"' - if: '$CI_PIPELINE_SOURCE == "merge_request_event"'

5.2.2 第二层:人工量表抽检

目标:获取临床专家的主观质量评估

实施要点:

-

评估量表设计

# 临床质量评估量表 class ClinicalEvaluationForm: sections = [ { "name": "临床准确性", "questions": [ { "id": "Q1", "text": "生成的病历是否准确反映了患者的临床情况?", "type": "likert", "options": ["完全准确", "基本准确", "部分准确", "不准确", "完全不准确"] }, { "id": "Q2", "text": "是否存在事实性错误或矛盾?", "type": "yes_no_with_comments" } ] }, { "name": "临床实用性", "questions": [ { "id": "Q3", "text": "生成的病历是否可以直接用于临床工作?", "type": "likert", "options": ["完全可用", "稍作修改可用", "需要大量修改", "不可用"] } ] } ] -

抽样策略

- 每次发布前至少抽样50份病历

- 覆盖不同科室和病例类型

- 双人独立评估,Kappa系数需>0.8

-

结果分析

def analyze_human_evaluations(evaluations: List[Evaluation]) -> HumanEvaluationResult: result = HumanEvaluationResult() # 计算平均分 result.average_score = np.mean([e.score for e in evaluations]) # 计算通过率 result.pass_rate = sum(1 for e in evaluations if e.score >= 4.0) / len(evaluations) # 分析问题模式 result.common_issues = self.identify_common_issues(evaluations) # 计算评估者一致性 result.inter_rater_reliability = self.calculate_kappa(evaluations) return result

5.2.3 第三层:灰度发布与可回滚

目标:小范围验证,快速发现问题并回滚

实施要点:

-

流量切分策略

# KServe多版本灰度发布 apiVersion: serving.kserve.io/v1beta1 kind: InferenceService metadata: name: medical-note-generation spec: predictor: canaryTrafficPercent: 10 # 10%流量到新版本 containers: - name: kserve-container image: registry/medical-ai:v2.1 args: - --model-version=clinical-llm-v3 - --enable-canary=true -

金丝雀发布监控

class CanaryMonitor: def __init__(self, metrics_client: MetricsClient, alert_rules: List[AlertRule]): self.metrics = metrics_client self.rules = alert_rules def monitor_canary(self, canary_version: str, baseline_version: str, duration_hours: int = 24) -> CanaryResult: # 收集关键指标 canary_metrics = self.collect_metrics(canary_version, duration_hours) baseline_metrics = self.collect_metrics(baseline_version, duration_hours) # 比较指标 comparison = self.compare_metrics(canary_metrics, baseline_metrics) # 检查是否触发回滚条件 should_rollback = False issues = [] for rule in self.rules: if rule.is_triggered(comparison): should_rollback = True issues.append(rule.description) return CanaryResult( should_rollback=should_rollback, issues=issues, metrics_comparison=comparison ) -

自动回滚机制

# Argo Rollouts配置 apiVersion: argoproj.io/v1alpha1 kind: Rollout metadata: name: medical-ai-rollout spec: replicas: 5 strategy: canary: steps: - setWeight: 10 - pause: duration: 1h # 观察1小时 - setWeight: 25 - pause: duration: 2h - setWeight: 50 - pause: duration: 4h - setWeight: 100 analysis: templates: - templateName: success-rate startingStep: 2 # 从第2步开始分析 args: - name: service-name value: medical-ai-service

5.2.4 第四层:线上监控与持续优化

目标:实时监控生产环境,持续改进系统

实施要点:

-

关键监控指标

# 线上监控指标定义 class ProductionMetrics: # 质量指标 FACT_CONSISTENCY_RATE = "medical_ai.fact_consistency_rate" HALLUCINATION_RATE = "medical_ai.hallucination_rate" COMPLETENESS_SCORE = "medical_ai.completeness_score" # 性能指标 RESPONSE_TIME_P95 = "medical_ai.response_time_p95" ERROR_RATE = "medical_ai.error_rate" THROUGHPUT = "medical_ai.throughput" # 业务指标 ICD_ACCURACY = "medical_ai.icd_accuracy" CDI_HIT_RATE = "medical_ai.cdi_hit_rate" HUMAN_OVERRIDE_RATE = "medical_ai.human_override_rate" # 医生效率指标 EDIT_DISTANCE = "medical_ai.edit_distance" TIME_SAVING = "medical_ai.time_saving" def collect_all(self) -> Dict[str, float]: metrics = {} # 从不同数据源收集指标 metrics.update(self.collect_quality_metrics()) metrics.update(self.collect_performance_metrics()) metrics.update(self.collect_business_metrics()) metrics.update(self.collect_efficiency_metrics()) return metrics -

异常检测与告警

class AnomalyDetector: def __init__(self, historical_data: pd.DataFrame, sensitivity: float = 0.95): self.history = historical_data self.sensitivity = sensitivity def detect_anomalies(self, current_metrics: Dict[str, float]) -> List[Anomaly]: anomalies = [] for metric_name, current_value in current_metrics.items(): # 获取历史分布 historical_values = self.history[metric_name] # 计算统计边界 mean = historical_values.mean() std = historical_values.std() lower_bound = mean - 3 * std upper_bound = mean + 3 * std # 检测异常 if current_value < lower_bound or current_value > upper_bound: anomaly = Anomaly( metric=metric_name, current_value=current_value, expected_range=(lower_bound, upper_bound), severity=self.calculate_severity(current_value, mean, std) ) anomalies.append(anomaly) return anomalies -

持续优化反馈循环

线上监控数据 → 异常检测 → 根因分析 → 改进措施设计 → A/B测试验证 → 全量发布

5.3 质量门禁指标详述

5.3.1 事实一致性指标

计算方法:

关键字段一致率 = (匹配的关键字段数) / (总关键字段数)

关键字段定义:

- 诊断(主要诊断、次要诊断)

- 手术/操作

- 关键检验值(异常值、趋势性变化)

- 用药(药物名称、剂量、频次)

- 时间点(发病时间、就诊时间、操作时间)

5.3.2 幻觉率指标

计算方法:

无证据断言率 = (无证据支持的医学事实断言数) / (总医学事实断言数)

医学事实断言识别:

- 诊断陈述

- 治疗建议

- 预后判断

- 病因推断

- 机制解释

5.3.3 完整性指标

计算方法:

模板必填覆盖率 = (已填写的必填项数) / (模板必填项总数)

模板必填项定义:

- 主诉(症状+持续时间)

- 现病史(起病情况、主要症状、伴随症状、诊治经过)

- 体格检查(生命体征、阳性体征)

- 辅助检查(关键异常发现)

- 初步诊断

5.3.4 ICD准确性指标

计算方法:

Top-1准确率 = (Top-1建议与金标一致的病例数) / (总病例数)

Top-3准确率 = (金标出现在Top-3建议中的病例数) / (总病例数)

置信度阈值设置:

- 高置信度(>0.9):可自动采纳

- 中置信度(0.7-0.9):建议人工审核

- 低置信度(<0.7):仅作为参考

5.4 质量门禁实施路线图

| 阶段 | 目标 | 关键活动 | 预计时间 |

|---|---|---|---|

| 第一阶段 | 基础门禁建立 | 1. 离线回归测试框架 2. 关键指标定义与计算 3. CI/CD集成 |

4-6周 |

| 第二阶段 | 人工评估体系 | 1. 评估量表设计 2. 抽样与评估流程 3. 结果分析与反馈 |

6-8周 |

| 第三阶段 | 灰度发布能力 | 1. 流量切分策略 2. 金丝雀发布机制 3. 自动回滚实现 |

8-10周 |

| 第四阶段 | 智能监控优化 | 1. 异常检测算法 2. 根因分析工具 3. 自动优化机制 |

12+周 |

5.5 质量门禁成功关键因素

- 领导支持:质量门禁需要资源投入和组织承诺

- 跨部门协作:需要临床、信息科、质控科多部门协作

- 持续投入:质量门禁不是一次性的,需要持续维护和改进

- 数据驱动:基于数据的决策,而非主观判断

- 文化转变:从"事后检查"到"事前预防"的质量文化

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)