基于模型强化学习的离网微电网终身控制Python源代码,保证正确 离网微网的终身控制问题包括两个任务

是一个专为离网微电网(off-grid microgrid)终身控制问题设计的开源仿真平台。该平台融合了设备状态估计与不确定性下的运行规划两大核心任务,支持多种智能体(Agent)策略的训练与评估,包括启发式规则、优化方法、监督学习以及主流的强化学习算法(如 DQN、PPO、MCTS 等)。其设计目标是为研究人员和工程师提供一个模块化、可扩展、贴近实际的微电网控制算法测试环境。是一个功能完备、设计

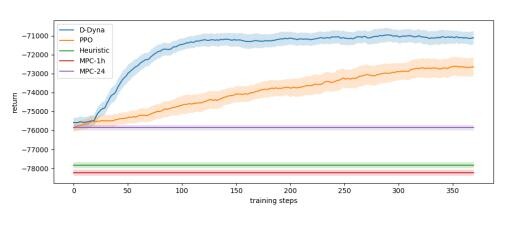

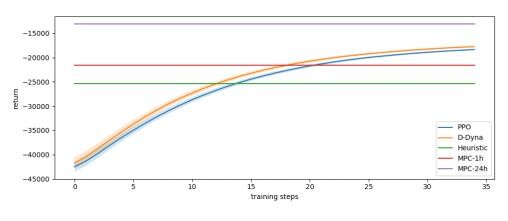

基于模型强化学习的离网微电网终身控制Python源代码,保证正确 离网微网的终身控制问题包括两个任务,即对微网设备的状态进行估计和通过预测未来消费量和可再生产量来考虑不确定性的运行规划。 有效控制的主要挑战来自于随时间发生的各种变化。 提出了一个用于农村电气化离网微电网建模的开源强化框架。 将孤立微电网的终身控制问题归结为马尔可夫决策过程。 我们对渐进式和突然性的变化进行分类。 提出了一种新的基于模型的强化学习算法,能够解决这两种类型的变化。 特别地,所提出的算法在快速变化的系统动态中表现出了泛化特性、传输能力和较好的鲁棒性。 将该算法与基于规则的策略和带有前瞻功能的模型预测控制器进行了比较。

概述

microgridRLsimulator 是一个专为离网微电网(off-grid microgrid)终身控制问题设计的开源仿真平台。该平台融合了设备状态估计与不确定性下的运行规划两大核心任务,支持多种智能体(Agent)策略的训练与评估,包括启发式规则、优化方法、监督学习以及主流的强化学习算法(如 DQN、PPO、MCTS 等)。其设计目标是为研究人员和工程师提供一个模块化、可扩展、贴近实际的微电网控制算法测试环境。

系统架构与核心模块

整个系统采用分层模块化设计,主要由以下五大组件构成:

1. **环境建模层(Model Layer)**

该层定义了微电网的物理构成,是仿真的基础。主要包括:

- 负载(Load):建模不可控负荷,仅包含名称与最大容量。

- 发电单元(Generator):

- 不可调度型(如光伏):输出功率由历史数据决定。

- 可调度型(如柴油发电机):支持最小稳定出力、燃料消耗曲线建模,并可模拟容量衰减。

- 储能系统(Storage):

- 基础储能模型支持充放电效率、最大充放电功率、荷电状态(SoC)等。

- DCAStorage(退化容量模型):引入循环次数与容量衰减的线性关系,更真实地反映电池老化过程。

所有设备由 Grid 类统一管理,并定义了微电网的关键经济参数,如切负荷成本与弃电成本,为后续的经济性优化提供依据。

2. **数据管理层(History Layer)**

该层负责对接外部数据源。通过 Database 类,系统读取包含时间戳、负荷、可再生能源出力等信息的 CSV 文件,并将其组织为 Pandas DataFrame。此模块确保了仿真过程能基于真实或合成的历史数据进行,是连接现实世界与数字仿真的桥梁。

3. **仿真引擎层(Simulate Layer)**

这是系统的核心执行单元,由 Simulator 类实现。其主要职责包括:

- 状态管理:维护微电网在每个时间步的完整状态(

GridState),包括 SoC、循环次数、各设备出力、成本等。 - 动作执行:接收来自智能体的动作指令(

GridAction),并根据设备物理模型(如储能的充放电动态、发电机的燃料消耗)计算实际响应。 - 经济核算:实时计算每一步的运行成本,包括燃料费、切负荷惩罚和弃电损失。

- 状态编码:将复杂的

GridState对象转换为智能体可处理的数值向量(decodestate),支持回溯(backcast)与预测(forecast)信息的融合。

此外,系统还提供了一个专为 MCTS(蒙特卡洛树搜索) 设计的轻量级仿真器 SimulatorMCTS,它能在内部生成带噪声的预测场景,用于支持基于模型的规划算法。

4. **智能体层(Agent Layer)**

该层实现了多种决策策略,是算法研究的重点。所有智能体均继承自抽象基类 Agent,并实现 trainagent 和 simulateagent 接口。

- 基准策略:

- IdleAgent:始终不动作。

- RandomAgent:随机选择动作。

- HeuristicAgent:基于“产大于耗则充电,反之则放电”的简单规则。

- 优化策略:

- OptimizationAgent:在每个决策点,基于未来若干步的精确或带噪声预测,构建并求解一个混合整数线性规划(MILP)问题,得到最优动作序列。这是性能的理论上限(Oracle)。

- 学习型策略:

- SLAgent(监督学习):通过模仿

OptimizationAgent的行为来训练回归模型(如随机森林、线性回归)。 - DQNAgent / PPOAgent:基于

Stable-Baselines库实现的深度强化学习算法,分别适用于离散和连续动作空间。 - MCTSAgent:实现蒙特卡洛树搜索,通过在内部仿真器中进行大量前向模拟来评估动作价值。

5. **交互与可视化层(Gym Wrapper & Plot Layer)**

- Gym Wrapper:将

Simulator封装成符合 OpenAI Gym 标准的环境(MicrogridEnv),使得任何兼容 Gym 的强化学习库都能无缝接入。 - Plotter:提供了一套完整的可视化工具,可自动生成电池 SoC、成本构成、功率流、电源结构等关键指标的图表,便于结果分析与展示。

工作流程

整个平台的工作流程清晰且灵活,主要分为训练与测试两个阶段:

- 初始化:用户通过命令行指定案例(case)、时间范围、智能体类型及参数。

- 环境构建:系统根据案例的 JSON 配置文件和 CSV 数据文件,实例化

Grid和Database,并创建Simulator。 - 智能体训练(可选):

- 对于学习型智能体(如 DQN、PPO、SL),在指定的训练时间段内与环境交互,更新其内部模型。

- 对于非学习型智能体(如 Heuristic、Optimization),此阶段直接跳过。 - 智能体仿真:

- 智能体在训练或测试时间段内,从env.reset()开始,循环调用env.step(action)与环境交互。

- 每一步,智能体根据当前状态(state)选择动作(action),环境返回下一状态、即时奖励(reward)和终止信号(done)。 - 结果存储与可视化:

- 仿真结束后,所有状态、动作、成本等数据被序列化为 JSON 文件。

-Plotter自动读取这些数据,生成一系列 PDF 格式的分析图表,直观展示微电网的运行效果。

总结

microgridRLsimulator 是一个功能完备、设计精良的微电网控制研究平台。它通过清晰的模块划分,将复杂的物理系统、数据管理、决策算法和结果分析有机地结合在一起。其对设备老化、经济成本、不确定性预测等现实因素的建模,使其仿真结果具有较高的参考价值。无论是用于验证新的强化学习算法,还是比较不同控制策略的优劣,该平台都提供了一个强大而便捷的实验环境。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)