数据工程与人工智能:高效数据供给方案

人工智能(AI)的核心竞争力在于数据的质量与供给效率,而数据工程是连接数据源与AI模型的“桥梁”。本文从第一性原理出发,系统解析数据工程与AI协同的底层逻辑,构建“需求-架构-实现-优化”的全链路数据供给体系。数据供给对AI的底层价值(理论框架);湖仓一体、实时管道等核心架构设计;特征工程、数据质量控制的实现细节;大模型、实时AI等场景的应用策略;安全、伦理与未来演化的高级考量。通过“理论推导+代

数据工程与人工智能协同:构建高效数据供给体系的理论与实践

元数据框架

标题

数据工程与人工智能协同:构建高效数据供给体系的理论与实践

关键词

数据工程;AI数据供给;湖仓一体;实时数据管道;特征工程;数据质量;自动数据工程

摘要

人工智能(AI)的核心竞争力在于数据的质量与供给效率,而数据工程是连接数据源与AI模型的“桥梁”。本文从第一性原理出发,系统解析数据工程与AI协同的底层逻辑,构建“需求-架构-实现-优化”的全链路数据供给体系。内容涵盖:

- 数据供给对AI的底层价值(理论框架);

- 湖仓一体、实时管道等核心架构设计;

- 特征工程、数据质量控制的实现细节;

- 大模型、实时AI等场景的应用策略;

- 安全、伦理与未来演化的高级考量。

通过“理论推导+代码示例+案例分析”的多层次解释,为企业构建高效数据供给体系提供可落地的实践指南。

1. 概念基础:数据供给是AI的“燃料系统”

1.1 领域背景化:AI的“数据依赖症”

AI模型的性能遵循“数据质量>算法设计>参数调优”的优先级(来自Google Brain的实证研究)。例如:

- 图像识别模型(如ResNet)的Top-1准确率从50%提升到90%,80%的贡献来自数据量的增加(ImageNet数据集从100万扩大到1400万);

- 大语言模型(如GPT-4)的参数量从1750亿增加到万亿级,但核心突破在于万亿token级别的高质量文本数据供给。

数据工程的核心目标是解决“AI模型需要什么数据?如何高效获取?”的问题,其本质是将原始数据转化为可被AI模型理解的“结构化燃料”。

1.2 历史轨迹:从“数据仓库”到“智能数据供给”

数据工程的演化与AI的需求升级密切相关:

-

1.0时代(2000-2010):传统数据仓库

目标:支持BI报表,采用“ETL+数据仓库”架构,强调数据的结构化与一致性。

局限:批处理延迟高(小时/天级),无法满足AI实时推理需求。 -

2.0时代(2010-2020):数据湖与实时处理

目标:处理非结构化数据(如日志、图像),采用“ELT+数据湖”架构,支持Spark批处理与Kafka流处理。

局限:数据湖的“元数据混乱”问题(被称为“数据沼泽”),导致AI模型难以高效检索数据。 -

3.0时代(2020至今):湖仓一体与智能供给

目标:融合数据仓库的结构化管理与数据湖的弹性存储,支持“批+流”统一处理,同时集成特征商店、数据目录等工具,为AI提供“按需取用”的数据服务。

1.3 问题空间定义:AI数据供给的四大挑战

AI模型对数据的需求具有“高维度、高实时性、高准确性、高多样性”的特点,数据工程需要解决以下核心问题:

- 数据孤岛:企业内部数据分散在MySQL、Hadoop、S3等系统中,无法统一访问;

- 数据质量差:原始数据存在缺失、重复、偏见等问题,导致模型泛化能力弱;

- 实时性不足:传统批处理无法满足推荐系统、 fraud detection等实时AI场景(要求延迟<1秒);

- 成本高企:大规模数据存储与处理的成本(如AWS S3的存储费用、Spark集群的计算费用)占AI项目总成本的60%以上。

1.4 术语精确性:关键概念辨析

- 数据供给(Data Feeding):从数据源到AI模型的全流程数据处理与交付,包括数据摄入、清洗、转换、存储、服务等环节;

- 湖仓一体(Data Lakehouse):融合数据湖(低成本存储)与数据仓库(结构化查询)的架构,代表产品有Databricks Delta Lake、Snowflake;

- 特征商店(Feature Store):存储与管理AI特征的系统,支持特征的复用、版本控制与实时获取,代表产品有Feast、Tecton;

- 实时数据管道(Real-time Data Pipeline):处理流数据的端到端流程,延迟<1秒,核心组件包括Kafka(消息队列)、Flink(流处理引擎)。

2. 理论框架:数据供给的第一性原理

2.1 第一性原理推导:AI模型的“数据价值公式”

从信息论出发,AI模型的性能(如准确率、召回率)取决于数据的信息量与数据的相关性。定义:

- 设数据集为( D = {x_i, y_i}_{i=1}^N ),其中( x_i )为特征,( y_i )为标签;

- 数据的信息量( I(D) = -\sum_{i=1}^N P(x_i) \log P(x_i) )(香农熵),表示数据的不确定性;

- 数据与任务的相关性( R(D, T) = \text{MI}(x_i, y_i) )(互信息),表示特征与标签的关联程度。

AI模型的性能( P_{AI} )可表示为:

PAI=f(I(D)×R(D,T)−C(D)) P_{AI} = f(I(D) \times R(D, T) - C(D)) PAI=f(I(D)×R(D,T)−C(D))

其中( C(D) )为数据处理成本(存储、计算、延迟等)。

结论:数据供给的核心目标是最大化( I(D) \times R(D, T) ),同时最小化( C(D) )。

2.2 数学形式化:数据管道的效率模型

数据管道的效率由吞吐量(Throughput)、延迟(Latency)、**可靠性(Reliability)**三个指标衡量:

- 吞吐量:单位时间内处理的数据量,公式为( T = \frac{N}{t} )(( N )为数据量,( t )为处理时间);

- 延迟:数据从数据源到AI模型的端到端时间,公式为( L = t_{\text{摄入}} + t_{\text{处理}} + t_{\text{存储}} + t_{\text{服务}} );

- 可靠性:数据管道成功处理请求的比例,公式为( R = 1 - \frac{F}{T_{\text{总请求}}} )(( F )为失败请求数)。

对于实时AI场景(如推荐系统),要求( L < 1 )秒,( T > 10^5 )条/秒,( R > 99.99% )。

2.3 理论局限性:传统架构的“能力边界”

-

批处理架构(如Hadoop+Hive):

优势:处理大规模数据的成本低;

局限:延迟高(小时级),无法满足实时AI需求;

边界:适合离线训练(如大模型的预训练)。 -

流处理架构(如Kafka+Flink):

优势:延迟低(毫秒级);

局限:处理复杂逻辑(如join多个流)的成本高;

边界:适合实时推理(如 fraud detection)。 -

数据湖架构(如S3+Spark):

优势:存储成本低(约0.02美元/GB/月);

局限:元数据管理困难(如数据版本、 schema 演化);

边界:适合非结构化数据存储(如图像、音频)。

2.4 竞争范式分析:湖仓一体vs传统架构

| 维度 | 传统数据仓库 | 传统数据湖 | 湖仓一体 |

|---|---|---|---|

| 存储成本 | 高(约0.1美元/GB/月) | 低(约0.02美元/GB/月) | 低(同数据湖) |

| 结构化查询能力 | 强(SQL支持完善) | 弱(依赖Spark等工具) | 强(支持ACID事务) |

| 实时处理支持 | 弱(批处理为主) | 中(流处理+批处理) | 强(统一批流处理) |

| 元数据管理 | 完善(如Hive Metastore) | 混乱(无统一元数据) | 完善(如Delta Lake的元数据) |

| AI支持能力 | 弱(无法直接供模型使用) | 中(需要额外处理) | 强(集成特征商店) |

3. 架构设计:高效数据供给体系的核心组件

3.1 系统分解:“六层架构”模型

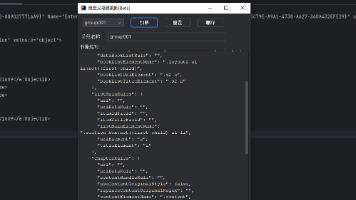

高效数据供给体系的核心是**“数据源-集成-处理-存储-服务-监控”**的六层架构(如图1所示):

图1:高效数据供给体系六层架构

3.2 组件交互模型:从“数据raw”到“模型可用”

以实时推荐系统为例,组件交互流程如下:

- 数据源层:用户点击、浏览、购买行为数据从APP端发送到Kafka(消息队列);

- 数据集成层:Debezium捕获MySQL中的用户信息变化(CDC),并发送到Kafka;

- 数据处理层:Flink消费Kafka中的行为数据与用户数据,进行窗口计算(如最近10分钟的点击次数)和特征融合(用户画像+行为特征);

- 数据存储层:处理后的特征存储到Delta Lake(湖仓一体),支持批处理(离线训练)与流处理(实时推理);

- 数据服务层:Feast特征商店从Delta Lake中提取实时特征(如“最近10分钟点击的商品类别”),通过API提供给推荐模型;

- AI模型层:TensorFlow Serving加载推荐模型,调用Feast API获取实时特征,返回推荐结果给APP端;

- 监控层:Great Expectations监控特征质量(如缺失值比例),Prometheus监控Flink作业的延迟与吞吐量。

3.3 设计模式应用:解决核心问题的“套路”

- 管道模式(Pipeline Pattern):将数据处理流程拆分为“摄入→清洗→转换→存储”多个步骤,每个步骤独立优化(如用Airflow调度管道);

- 观察者模式(Observer Pattern):监控层订阅数据管道的关键指标(如延迟、错误率),当指标异常时触发报警(如用Prometheus+Alertmanager);

- 适配器模式(Adapter Pattern):数据集成层用适配器对接不同数据源(如Debezium对接MySQL,Fivetran对接Salesforce);

- 工厂模式(Factory Pattern):特征工程层用工厂类生成不同类型的特征(如数值特征、类别特征),提高代码复用性。

4. 实现机制:从架构到代码的落地细节

4.1 算法复杂度分析:批处理vs实时处理

- 批处理(Spark):

假设处理1TB数据,每个步骤的时间复杂度为( O(N) )(( N )为数据量),总时间为( t = t_{\text{读取}} + t_{\text{清洗}} + t_{\text{转换}} + t_{\text{存储}} )。例如,用Spark处理1TB Parquet文件,读取时间约10分钟,清洗时间约5分钟,转换时间约15分钟,存储时间约10分钟,总时间约40分钟; - 实时处理(Flink):

假设处理10万条/秒的流数据,每个事件的处理时间为( O(1) )(固定窗口计算),延迟为( L = t_{\text{摄入}} + t_{\text{处理}} + t_{\text{存储}} )。例如,Kafka摄入延迟约10ms,Flink处理延迟约50ms,Delta Lake存储延迟约20ms,总延迟约80ms。

4.2 优化代码实现:Spark与Flink的最佳实践

4.2.1 Spark批处理:特征工程优化

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, when, window, count

# 初始化SparkSession(启用Delta Lake支持)

spark = SparkSession.builder \

.appName("FeatureEngineering") \

.config("spark.sql.extensions", "io.delta.sql.DeltaSparkSessionExtension") \

.config("spark.sql.catalog.spark_catalog", "org.apache.spark.sql.delta.catalog.DeltaCatalog") \

.getOrCreate()

# 读取原始数据(用户行为数据,Parquet格式)

df_behavior = spark.read.parquet("s3://my-bucket/raw/behavior/")

# 读取用户画像数据(MySQL)

df_user = spark.read.format("jdbc") \

.option("url", "jdbc:mysql://localhost:3306/user_db") \

.option("dbtable", "user_profile") \

.option("user", "root") \

.option("password", "password") \

.load()

# 数据清洗:处理缺失值(将gender列的缺失值替换为"unknown")

df_behavior_cleaned = df_behavior.withColumn(

"gender", when(col("gender").isNull(), "unknown").otherwise(col("gender"))

)

# 特征工程1:计算用户最近1小时的点击次数(窗口函数)

df_click_count = df_behavior_cleaned \

.groupBy(window(col("timestamp"), "1 hour"), col("user_id")) \

.agg(count("*").alias("recent_1h_click_count"))

# 特征工程2:融合用户画像(join)

df_feature = df_click_count \

.join(df_user, on="user_id", how="left") \

.select("user_id", "recent_1h_click_count", "gender", "age")

# 保存特征到Delta Lake(支持ACID事务与版本控制)

df_feature.write.format("delta").mode("overwrite").save("s3://my-bucket/features/user_click_features/")

# 停止SparkSession

spark.stop()

代码说明:

- 启用Delta Lake支持,解决数据湖的“元数据混乱”问题;

- 用窗口函数计算实时特征(最近1小时点击次数),支持离线训练;

- 融合用户画像数据,生成更丰富的特征;

- 保存到Delta Lake,支持后续的实时推理(通过Flink读取Delta Lake的流数据)。

4.2.2 Flink实时处理:延迟优化

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.table.api.EnvironmentSettings;

import org.apache.flink.table.api.Table;

import org.apache.flink.table.api.bridge.java.StreamTableEnvironment;

public class RealTimeFeatureEngineering {

public static void main(String[] args) throws Exception {

// 初始化Flink流执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

env.setParallelism(4); // 设置并行度(根据集群资源调整)

// 初始化Table环境(启用流模式)

EnvironmentSettings settings = EnvironmentSettings.newInstance()

.inStreamingMode()

.build();

StreamTableEnvironment tEnv = StreamTableEnvironment.create(env, settings);

// 注册Kafka数据源(用户行为数据)

tEnv.executeSql("CREATE TABLE behavior_stream ( " +

"user_id STRING, " +

"item_id STRING, " +

"timestamp TIMESTAMP(3), " +

" WATERMARK FOR timestamp AS timestamp - INTERVAL '5' SECOND " + // 定义水位线(允许5秒延迟)

") WITH ( " +

" 'connector' = 'kafka', " +

" 'topic' = 'user_behavior', " +

" 'properties.bootstrap.servers' = 'kafka:9092', " +

" 'properties.group.id' = 'flink_consumer', " +

" 'format' = 'json' " +

")");

// 注册Delta Lake sink(存储实时特征)

tEnv.executeSql("CREATE TABLE real_time_features ( " +

"user_id STRING, " +

"recent_10m_click_count BIGINT, " +

"window_start TIMESTAMP(3), " +

"window_end TIMESTAMP(3), " +

" PRIMARY KEY (user_id, window_start) NOT ENFORCED " + // 定义主键(支持UPSERT)

") WITH ( " +

" 'connector' = 'delta', " +

" 'path' = 's3://my-bucket/features/real_time_click_features/', " +

" 'table-type' = 'streaming' " +

")");

// 计算实时特征:用户最近10分钟的点击次数(滑动窗口,步长5分钟)

Table result = tEnv.sqlQuery("SELECT " +

"user_id, " +

"COUNT(*) AS recent_10m_click_count, " +

"TUMBLE_START(timestamp, INTERVAL '10' MINUTE) AS window_start, " +

"TUMBLE_END(timestamp, INTERVAL '10' MINUTE) AS window_end " +

"FROM behavior_stream " +

"GROUP BY TUMBLE(timestamp, INTERVAL '10' MINUTE), user_id");

// 将结果写入Delta Lake

result.executeInsert("real_time_features");

// 执行作业

env.execute("RealTimeFeatureEngineering");

}

}

代码说明:

- 定义水位线(Watermark),允许5秒的延迟(处理迟到的数据);

- 使用滑动窗口(Tumble Window)计算最近10分钟的点击次数,步长5分钟(每5分钟更新一次特征);

- 注册Delta Lake sink,支持UPSERT操作(更新已存在的窗口数据);

- 设置并行度为4(根据Kafka主题的分区数调整),提高吞吐量。

4.3 边缘情况处理:解决“数据异常”的关键

- 数据缺失值:

策略:数值特征用平均值/中位数填充(如Spark的agg函数),类别特征用“unknown”填充(如Flink的COALESCE函数); - 数据倾斜:

策略:重新分区(如Spark的repartition函数)、加盐(在键值后添加随机数,分散数据分布); - 实时数据迟到:

策略:定义水位线(如Flink的WATERMARK),允许一定延迟(如5秒),超过延迟的数据丢弃或存入“迟到数据”表; - 数据重复:

策略:用主键去重(如Delta Lake的MERGE操作)、用哈希函数去重(如Spark的dropDuplicates函数)。

4.4 性能考量:成本与效率的平衡

- 存储成本优化:

策略:使用湖仓一体的“冷热分层”(如AWS S3的Glacier存储类),将不常用的历史数据存入低成本存储; - 计算成本优化:

策略:用Serverless计算引擎(如AWS Glue、Databricks Serverless),按使用量付费; - 延迟优化:

策略:减少数据管道的步骤(如合并ETL与特征工程)、使用内存计算(如Flink的状态后端用RocksDB)。

5. 实际应用:不同AI场景的数据供给策略

5.1 大模型训练:大规模数据的高效处理

场景需求:大语言模型(如GPT-4)需要万亿token级别的文本数据,要求数据处理的高吞吐量(>10TB/天)与低存储成本。

数据供给策略:

- 数据源:爬取互联网文本(如Wikipedia、Common Crawl)、企业内部文档(如Confluence);

- 数据集成:用Apache Nutch爬取网页,用Fivetran同步企业文档;

- 数据处理:用Spark进行文本清洗(如去除HTML标签、分词)、去重(如用MinHash算法);

- 数据存储:用Delta Lake存储清洗后的文本数据(支持列式存储,减少存储成本);

- 数据服务:用Hugging Face Datasets库加载数据,供PyTorch训练使用。

5.2 实时推荐系统:低延迟数据供给

场景需求:推荐系统需要实时处理用户行为数据(如点击、浏览),生成实时特征(如最近10分钟的点击次数),要求延迟<1秒。

数据供给策略:

- 数据源:APP端的行为数据(通过Kafka发送);

- 数据集成:用Kafka摄入实时数据,用Debezium同步MySQL中的用户画像;

- 数据处理:用Flink进行窗口计算(如最近10分钟的点击次数)、特征融合(用户画像+行为特征);

- 数据存储:用Delta Lake存储实时特征(支持流读取);

- 数据服务:用Feast特征商店提供实时特征API,供TensorFlow Serving调用。

5.3 医疗AI:结构化与非结构化数据的融合

场景需求:医疗AI模型(如癌症诊断)需要融合结构化数据(如电子病历)与非结构化数据(如医学影像),要求数据的高准确性(无错误)与隐私保护(符合HIPAA)。

数据供给策略:

- 数据源:电子病历(MySQL)、医学影像(DICOM格式,存储在S3);

- 数据集成:用AWS Glue同步电子病历,用Apache NiFi摄入医学影像;

- 数据处理:用Spark清洗电子病历(如去除敏感信息),用PyTorch处理医学影像(如 resize、归一化);

- 数据存储:用Snowflake存储结构化数据(支持SQL查询),用S3存储非结构化数据(用Glacier分层存储);

- 数据服务:用FastAPI提供数据API,供医疗AI模型调用(支持身份验证与权限控制)。

6. 高级考量:安全、伦理与未来演化

6.1 扩展动态:大模型与实时AI的需求驱动

- 大模型的挑战:大模型需要更大规模的数据(万亿token)与更高效的数据处理(如用Spark的分布式计算),数据供给体系需要支持多模态数据融合(文本、图像、音频);

- 实时AI的挑战:实时AI需要更低延迟(<1秒)与更高可靠性(>99.99%),数据供给体系需要支持流批统一处理(如Flink的批流一体化)。

6.2 安全影响:数据隐私与合规

- 数据加密:静态数据加密(如S3的服务器端加密)、传输数据加密(如Kafka的SSL加密);

- 数据匿名化:用差分隐私(Differential Privacy)处理敏感数据(如医疗记录),确保个人信息不被泄露;

- 合规性:符合GDPR(欧盟)、CCPA(加州)等法规,要求数据可追溯(如Delta Lake的版本控制)、可删除(如根据用户请求删除数据)。

6.3 伦理维度:数据偏见与公平性

- 数据偏见的来源:历史数据中的偏见(如招聘数据中女性候选人比例低)、数据收集的偏见(如只收集城市用户的数据);

- 解决策略:

- 数据审计:用 fairness metrics(如 demographic parity、equal opportunity)检测数据偏见;

- 数据纠正:增加少数群体的数据(如收集更多女性候选人的数据)、去除与偏见相关的特征(如性别);

- 模型监控:用Prometheus监控模型的公平性指标(如不同群体的准确率差异)。

6.4 未来演化向量:自动数据工程与联邦学习

- 自动数据工程(AutoDE):用AI模型自动识别数据源中的有用特征(如用AutoML Data Prep)、自动设计数据管道(如用Google的Cloud Data Fusion)、自动优化处理流程(如用Spark的自适应查询优化);

- 联邦学习的数据供给:联邦学习(Federated Learning)要求在不泄露原始数据的情况下,共享模型参数。数据供给体系需要支持跨机构的数据共享(如用FedML框架)、加密数据处理(如用同态加密);

- 量子数据处理:量子计算(Quantum Computing)具有处理大规模数据的潜力(如用量子算法加速数据清洗),未来数据供给体系可能融合量子计算组件。

7. 综合与拓展:构建高效数据供给体系的战略建议

7.1 跨领域应用:从互联网到传统行业

- 互联网:推荐系统、 fraud detection、大语言模型;

- 传统行业:

- 制造业:用IoT传感器数据训练预测性维护模型;

- 金融:用交易数据训练风险评估模型;

- 医疗:用电子病历与医学影像训练诊断模型。

7.2 研究前沿:可解释性与自适应数据供给

- 数据供给的可解释性:解释“为什么选择这些数据给模型”(如用因果推断分析数据与模型性能的关系);

- 自适应数据供给:根据模型的反馈调整数据供给(如模型性能下降时,自动增加高质量数据的供给)。

7.3 开放问题:待解决的挑战

- 如何平衡数据的实时性与准确性?(如实时数据可能存在噪声,如何在低延迟与高质量之间权衡?);

- 如何处理异构数据的融合?(如文本、图像、音频数据的融合,如何保持数据的一致性?);

- 如何降低数据供给的成本?(如大规模数据存储与处理的成本,如何用Serverless与冷热分层优化?)。

7.4 战略建议:企业的行动指南

- 建立统一的数据供给平台:整合数据工程与AI团队,避免数据孤岛;

- 投资湖仓一体与实时管道:选择Databricks、Snowflake等湖仓一体产品,用Flink、Kafka构建实时管道;

- 重视数据质量与安全:用Great Expectations监控数据质量,用加密与匿名化保护数据隐私;

- 拥抱自动数据工程:用AutoML Data Prep、Cloud Data Fusion等工具,减少人工工作量;

- 关注未来趋势:跟踪自动数据工程、联邦学习、量子数据处理等前沿技术,提前布局。

结语

数据工程是AI的“燃料系统”,高效数据供给体系是AI成功的关键。本文从理论框架到实践细节,系统解析了数据工程与AI协同的底层逻辑,构建了“六层架构”的高效数据供给体系,并给出了不同AI场景的应用策略与未来演化的高级考量。

对于企业而言,构建高效数据供给体系需要技术投入(湖仓一体、实时管道)、组织协同(数据工程与AI团队的融合)与战略眼光(关注未来趋势)。只有这样,才能让AI模型充分发挥潜力,为企业创造真正的价值。

参考资料

- Databricks. (2021). The Data Lakehouse: A New Generation of Data Platforms.

- Apache Flink. (2023). Flink Documentation: Streaming Analytics.

- Google Brain. (2020). Scaling Laws for Neural Language Models.

- Feast. (2023). Feature Store Documentation.

- Great Expectations. (2023). Data Quality Documentation.

- AWS. (2023). Delta Lake on AWS.

更多推荐

已为社区贡献35条内容

已为社区贡献35条内容

所有评论(0)