智能体(Agentic AI)的进化之道:深度解读自适应框架与未来趋势

大型语言模型(LLM)的问世,将人工智能从被动响应的知识库推向了能够进行复杂规划(Planning)、推理(Reasoning)和工具使用(Tool Use)的智能体(Agentic AI)系统。

大型语言模型(LLM)的问世,将人工智能从被动响应的知识库推向了能够进行复杂规划(Planning)、推理(Reasoning)和工具使用(Tool Use)的智能体(Agentic AI)系统。然而,当这些智能体从封闭的训练环境跃入真实、动态且充满不确定性的世界时,它们立即遭遇了鲁棒性(Robustness)和泛化能力(Generalization)的严峻挑战。

现实世界充满了模糊的用户指令、不断更新的 API 接口以及漂移的环境状态。这些因素使得智能体的初始策略难以持续有效。因此,自适应(Adaptation)——即系统根据反馈信号自我修正和优化的能力——成为智能体从概念走向大规模商业部署的必然且核心的机制。

论文聚焦:统一智能体适应的蓝图

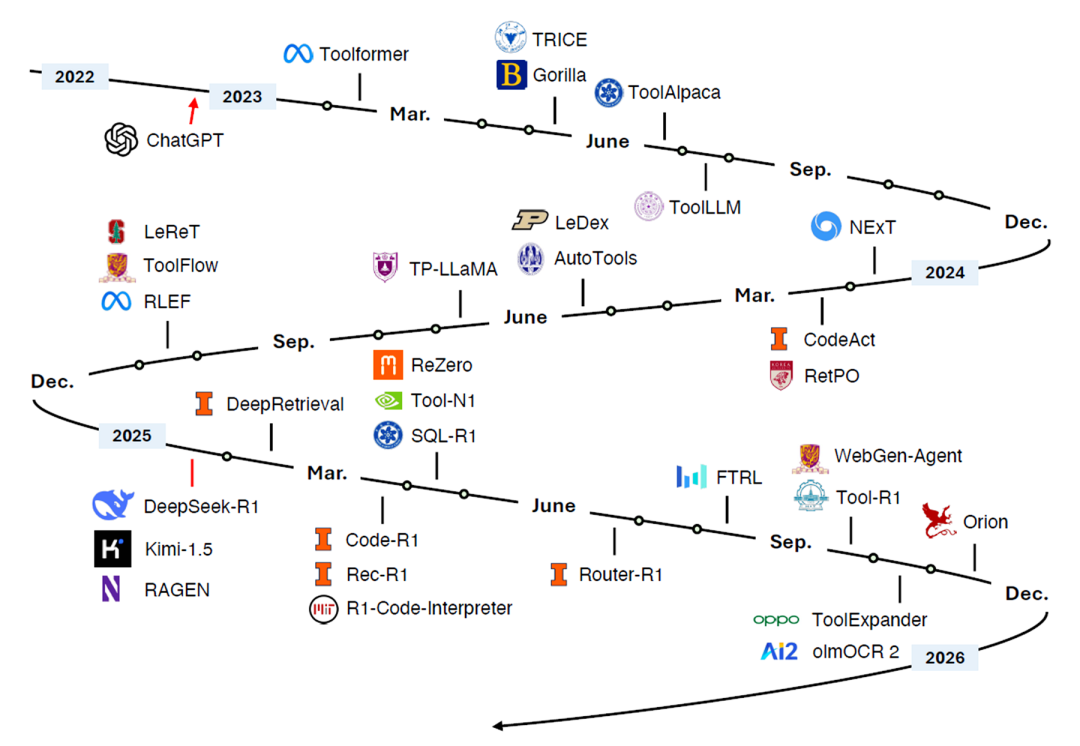

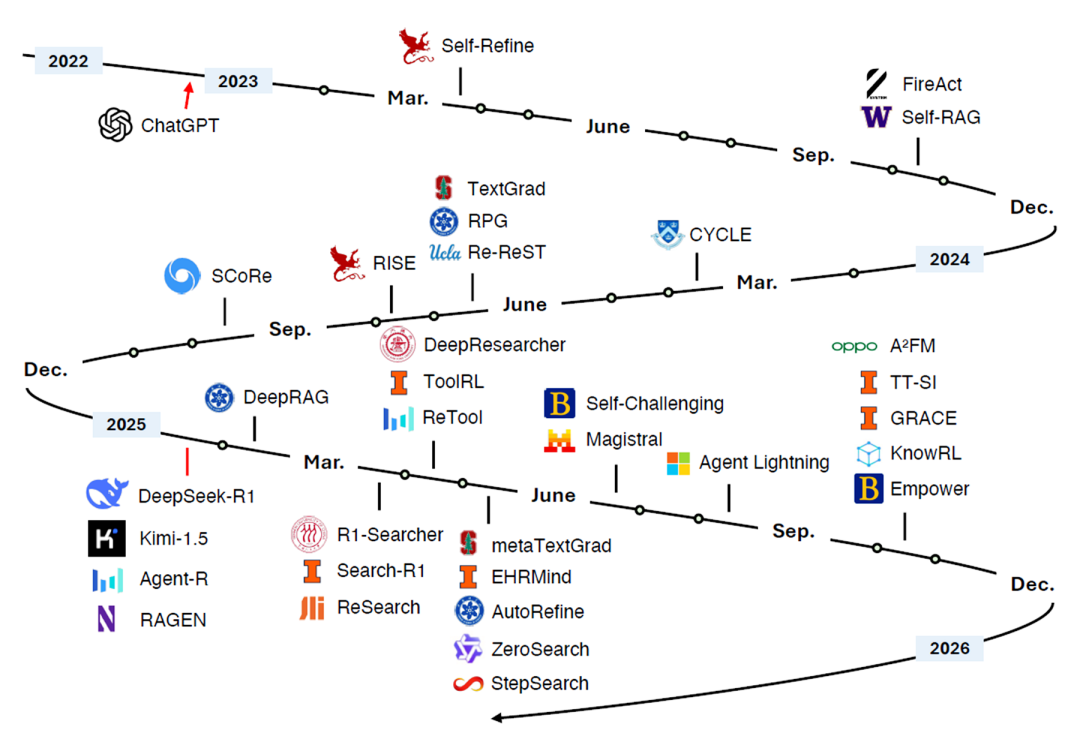

本次深度解读以一篇前沿研究论文为核心:《Adaptation of Agentic AI》。该论文由Pengcheng Jiang, Jiacheng Lin, Zhiyi Shi等人领衔,汇聚了来自 UIUC、斯坦福、普林斯顿、哈佛、UW 等顶尖机构的研究力量。

该研究的核心动机在于解决智能体适应策略的碎片化问题,首次提出了一个系统的统一框架。

- 论文:Adaptation of Agentic AI

- 原文链接:https://github.com/pat-jj/Awesome-Adaptation-of-Agentic-AI/blob/main/paper.pdf

核心摘要:当前前沿的智能体AI系统建立在基础模型之上,这些模型经过适应后,能够规划、推理并与外部工具交互,以执行日益复杂和专业的任务。随着这些系统的能力和范围的增长,适应成为提高性能、可靠性和泛化能力的核心机制。

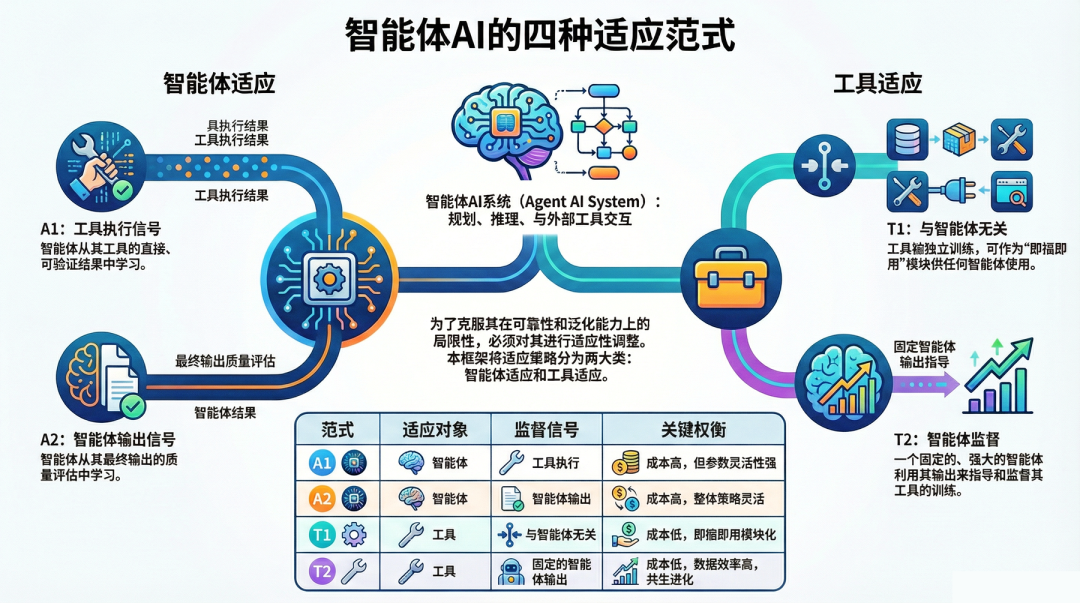

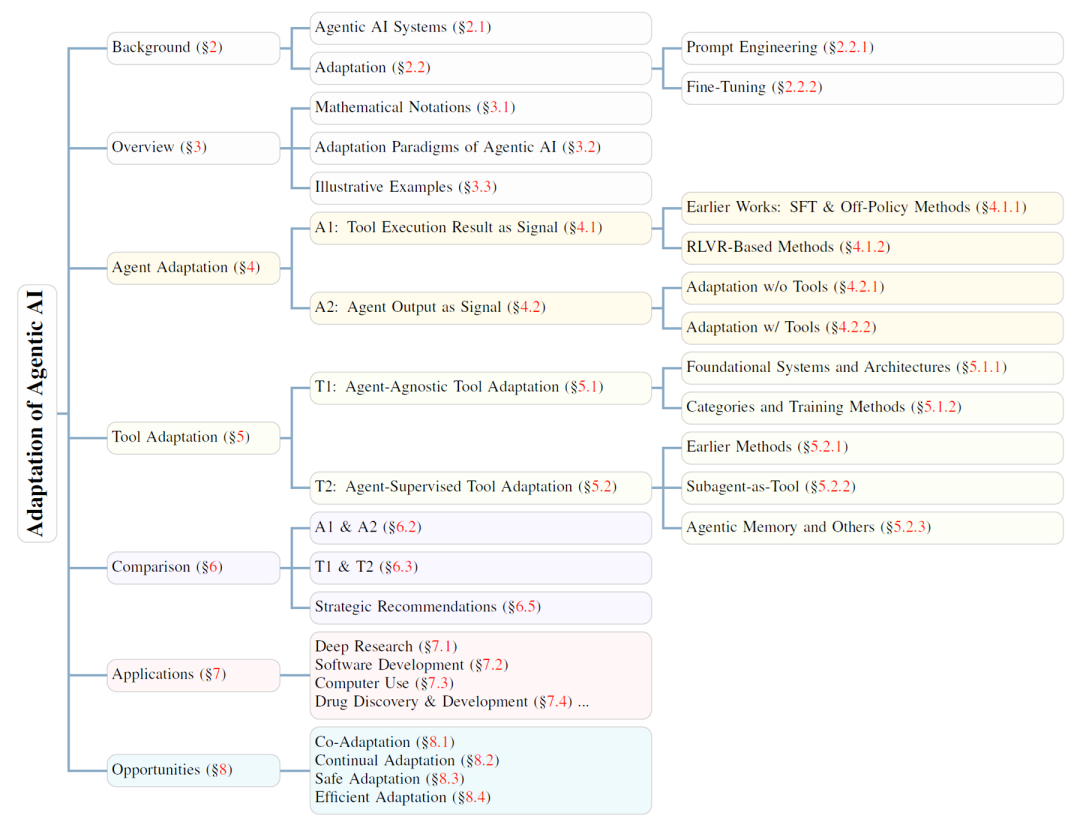

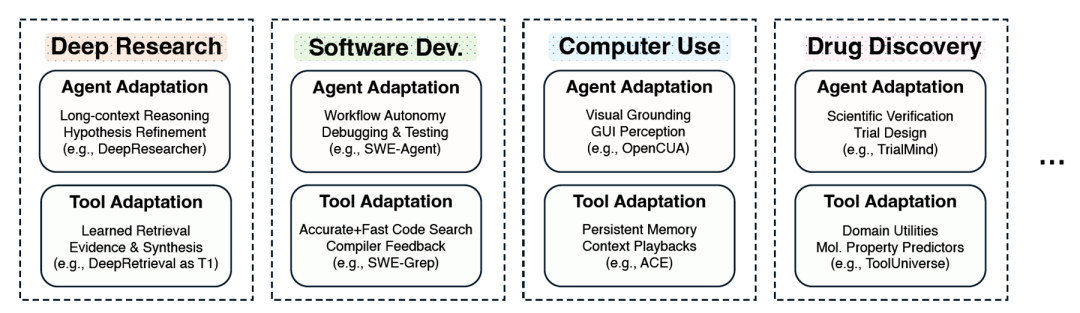

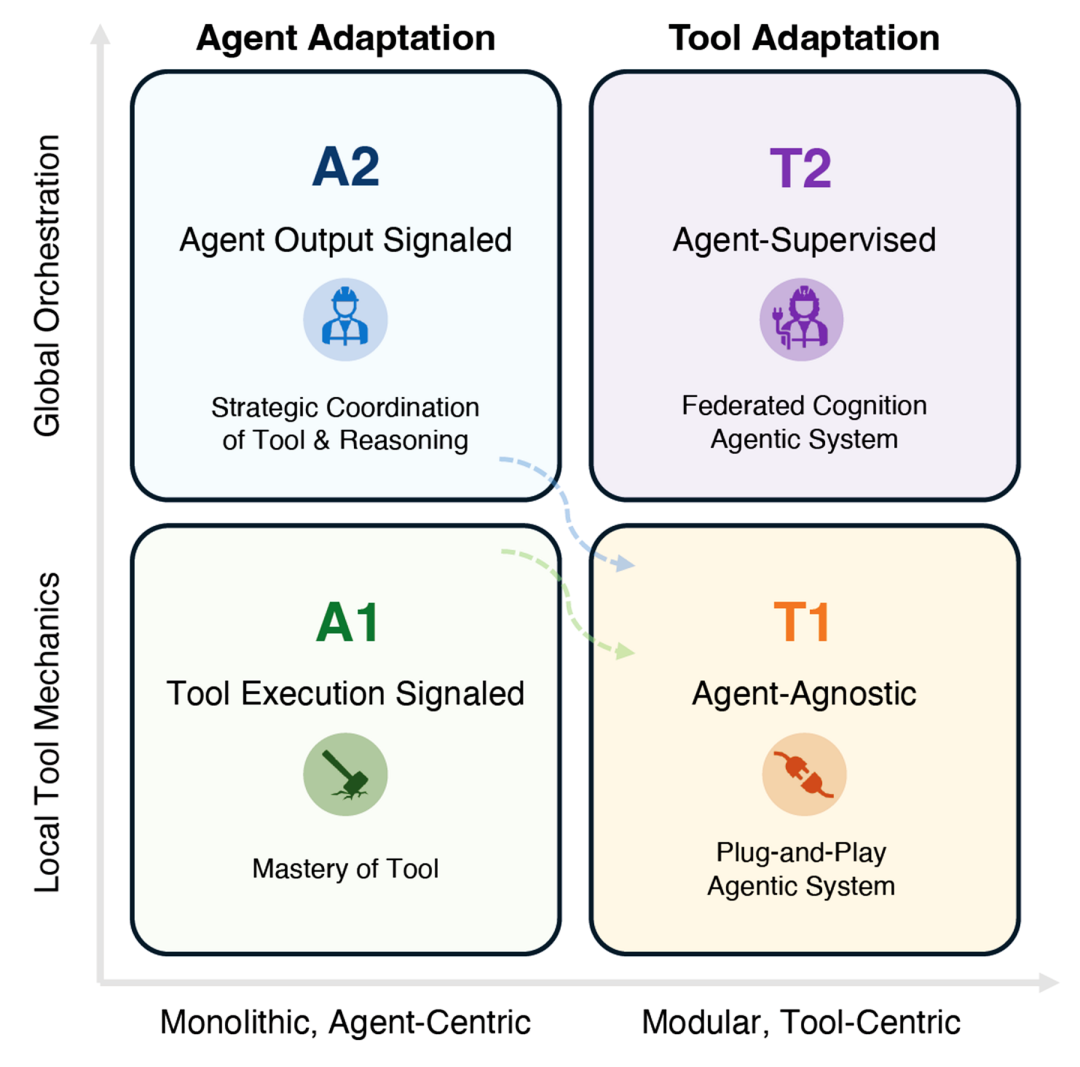

在文中,作者统一了快速扩展的研究领域,提出了一个系统的框架,涵盖智能体适应(Agent Adaptations)和工具适应(Tool Adaptations)两大维度。我们进一步将智能体适应分解为工具执行信号驱动(tool-execution-signaled)和智能体输出信号驱动(agent-output-signaled)两种形式,并将工具适应分解为智能体无关(agent-agnostic)和智能体监督(agent-supervised)两种形式。

本文证明,该框架有助于澄清智能体AI中适应策略的设计空间,明确其权衡取舍,并为在科学发现、软件开发、计算机使用和临床研究等应用中构建高效、可靠的智能体系统提供实践指导。

智能体面临的现实困境:必须跨越的三道核心鸿沟

适应机制的产生,直接针对智能体在实际运行中暴露出的三大结构性缺陷:

1.指令遵循鸿沟(Instruction-Following Gap)

用户指令通常是高层次、模糊或不完备的。智能体在执行复杂的多步骤任务时,需要持续优化对用户意图的理解,确保其内部规划逻辑能够精确地转化为正确的动作序列。

2.工具效能鸿沟(Tool Efficacy Gap)

智能体对外部工具(API、代码库)的“理论认知”与“实际运行”之间存在偏差。当工具因参数错误、格式不匹配或环境依赖缺失而执行失败时,智能体必须能够从错误信息中学习,修正其工具调用策略。

3.环境状态鸿沟(Environment State Gap)

在动态环境(如 GUI 自动化、机器人控制)中,环境的细微变化(状态漂移)或感知模型的错误(例如视觉识别错误)会导致智能体的规划无法“落地”(Grounding),从而使后续的推理全盘失效。

统一蓝图:双轴四象限的适应策略深度解析

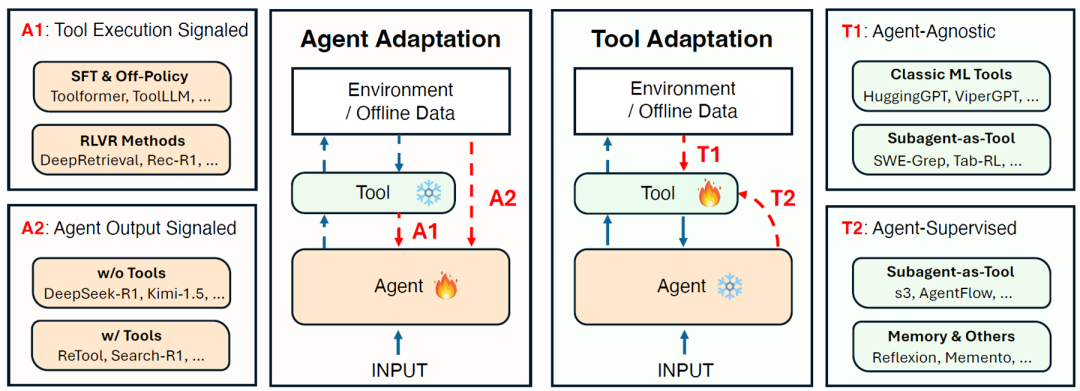

论文的核心在于将适应策略提炼为两个正交的维度:适应对象(智能体本身 vs.外部工具)和信号来源(外部执行结果 vs.内部输出评估)。由此构成了四种核心范式(A1, A2, T1, T2),每种范式都有其独特的优势和局限。

1.智能体适应:强化内部认知与决策能力

智能体适应旨在优化 LLM 核心的规划和推理能力。

A1:外部信号驱动——基于执行结果的强化学习

A1适应策略由外部环境的实际执行结果提供信号(如成功、失败、准确性评分)。这是一种基于结果的反馈学习,信号准确且具有高置信度。智能体将导致成功或失败的完整“动作轨迹”作为经验,通过强化学习(RL)或事后总结(Post-mortem Analysis)来修正规划。

案例与权衡:Toolformer利用API执行结果作为监督信号训练LLM;在长程任务(如WebArena)中,MobileGUI-RL采用在线强化学习来修正动作策略。A1的优势在于信号的客观准确性,但劣势是学习成本高昂,且信号稀疏,存在执行延迟。

A2:内部认知驱动——基于内省的即时校正

A2适应策略依赖智能体内部的认知过程作为信号,例如自我反思(Self-reflection)或批评模型(Critic Model)的评估。这是一种前瞻性、内省式的适应。智能体在执行前对自身的中间输出(规划、CoT、工具调用指令)进行评估和即时修正,属于一种“自我监督”的过程。

案例与权衡:Self-Refine通过自生成反馈来迭代精炼输出;CodePRM(Process Reward Model)被用来动态校正代码推理过程。A2的优势在于速度快、成本低、灵活性高,且具备一定的泛化潜力,但其准确性受限于模型自身的内省偏差(Self-reflection Bias)。

2.工具适应:实现工具的通用与定制进化

工具适应将优化重点放在外部组件上,保持智能体核心LLM相对稳定,从而实现高模块化和低计算成本。

T1:无关性的通用工具升级——即插即用

T1 工具独立于特定智能体训练,信号来源是开发者、通用数据集或全局系统监控。这些工具作为即插即用(Plug-and-Play)模块被引入,旨在普遍性地提升所有智能体的基线性能,提供水平可扩展性。

案例与权衡:HuggingGPT 协调调用各种独立训练的T1 AI模型(如CLIP、AlphaFold2 等);SciToolAgent通过知识图谱管理科学工具。T1的优势在于模块化强、影响范围广,但无法解决特定环境下的特异性挑战。

T2:智能体监督下的工具定制化——个性化进化

T2 工具使用特定智能体在任务中积累的经验和定制化反馈来指导工具的优化。智能体将运行中发现的工具选择偏好或错误模式,用于微调工具本身或其使用说明。

案例与权衡:REPLUG利用LLM降低困惑度(Perplexity Reduction)的反馈来训练检索器,优化检索工具;AAR(Agent Aligned Retrieval)利用代理的偏好来对齐检索结果。值得注意的是,智能体的记忆模块(Memory Module)也被视为一种T2工具,其检索、更新策略由智能体监督优化。T2的优势是高度定制化和专业化,但适应成果的局部性强,泛化性较差。

实践检验:混合范式与跨领域应用

在实际部署中,单一适应策略的局限性显而易见。研究表明,混合适应范式(Hybrid Paradigms)能够动态结合不同策略的优势,被证明是解决复杂现实问题的有效途径。

1.GUI 自动化:鲁棒性的混合挑战

图形用户界面(GUI)自动化是混合适应的最佳试验场,因为它必须同时解决长期规划(A1)、即时修正(A2)和视觉识别(T2)的挑战:

- 长期学习(A1):通过在线强化学习(如 MobileGUI-RL),利用执行信号实现跨会话的长期规划优化。

- 即时内省(A2):引入Critic模型(如 GUI-G1),评估智能体输出的动作质量,在执行前进行 CoT 修正。

- 工具定制(T2):InfiGUI-G1展示了智能体如何利用重复的视觉接地失败作为监督信号,反过来微调底层的视觉接地模型,实现对特定APP界面的高精度识别。

2.软件开发与科学发现

适应性框架已渗透到高价值领域:

- 软件开发与代码任务(SWE-bench):采用A1(代码执行反馈)和T2(代理监督的检索优化)的混合策略,显著提高了代码错误修复和功能实现的稳定性和性能。

- 深度研究与信息获取:在需要多轮迭代搜索的RAG场景中,A1+T2的混合适应被广泛应用,智能体利用最终答案的正确性反馈(A1)来优化其RAG系统的检索策略(T2)。

- 科学发现与模拟:结合T1工具(如 AlphaFold2)作为功能模块,并通过A1(分子模拟或实验结果)作为反馈,迭代优化实验参数,加速科学探索。

终局思考:商业价值、关键权衡与“元适应”路线图

该适应框架为构建面向未来的AI系统提供了一份重要的工程实践指导手册。

1.对商业部署的关键指导

动态平衡A1与A2:开发者必须在A1的高准确度和A2的低成本之间寻找动态平衡点。当环境不确定性低时,应优先使用快速的A2;当A2连续失败或任务风险高时,则应主动切换到高成本但高置信度的A1模式获取真实反馈。

模块化与成本控制:通过投资于T1/T2工具适应,将专业能力封装在可独立升级的模块中,能有效降低LLM的重复训练成本,极大提高系统的可维护性和可升级性。

2.元适应:未来的趋势

最终,适应框架将引领我们走向一个更高级的未来——元适应(Meta-Adaptation)。这意味着智能体不仅要学习如何解决特定任务,还要学习如何更有效地进行适应。这包括自动生成最有效的自反思提示,以及根据经验自动修改和替换其依赖的工具代码和使用指南。

拥抱这种双轴四象限的适应思维,是确保我们在下一代高度自治、高鲁棒性AI系统的竞争中保持领先地位的关键战略。未来的智能体将是能够自我诊断、自我修复、自我进化的,真正实现从“黑箱”到“生命体”的跨越。

想入门 AI 大模型却找不到清晰方向?备考大厂 AI 岗还在四处搜集零散资料?别再浪费时间啦!2025 年 AI 大模型全套学习资料已整理完毕,从学习路线到面试真题,从工具教程到行业报告,一站式覆盖你的所有需求,现在全部免费分享!

👇👇扫码免费领取全部内容👇👇

一、学习必备:100+本大模型电子书+26 份行业报告 + 600+ 套技术PPT,帮你看透 AI 趋势

想了解大模型的行业动态、商业落地案例?大模型电子书?这份资料帮你站在 “行业高度” 学 AI:

1. 100+本大模型方向电子书

2. 26 份行业研究报告:覆盖多领域实践与趋势

报告包含阿里、DeepSeek 等权威机构发布的核心内容,涵盖:

- 职业趋势:《AI + 职业趋势报告》《中国 AI 人才粮仓模型解析》;

- 商业落地:《生成式 AI 商业落地白皮书》《AI Agent 应用落地技术白皮书》;

- 领域细分:《AGI 在金融领域的应用报告》《AI GC 实践案例集》;

- 行业监测:《2024 年中国大模型季度监测报告》《2025 年中国技术市场发展趋势》。

3. 600+套技术大会 PPT:听行业大咖讲实战

PPT 整理自 2024-2025 年热门技术大会,包含百度、腾讯、字节等企业的一线实践:

- 安全方向:《端侧大模型的安全建设》《大模型驱动安全升级(腾讯代码安全实践)》;

- 产品与创新:《大模型产品如何创新与创收》《AI 时代的新范式:构建 AI 产品》;

- 多模态与 Agent:《Step-Video 开源模型(视频生成进展)》《Agentic RAG 的现在与未来》;

- 工程落地:《从原型到生产:AgentOps 加速字节 AI 应用落地》《智能代码助手 CodeFuse 的架构设计》。

二、求职必看:大厂 AI 岗面试 “弹药库”,300 + 真题 + 107 道面经直接抱走

想冲字节、腾讯、阿里、蔚来等大厂 AI 岗?这份面试资料帮你提前 “押题”,拒绝临场慌!

1. 107 道大厂面经:覆盖 Prompt、RAG、大模型应用工程师等热门岗位

面经整理自 2021-2025 年真实面试场景,包含 TPlink、字节、腾讯、蔚来、虾皮、中兴、科大讯飞、京东等企业的高频考题,每道题都附带思路解析:

2. 102 道 AI 大模型真题:直击大模型核心考点

针对大模型专属考题,从概念到实践全面覆盖,帮你理清底层逻辑:

3. 97 道 LLMs 真题:聚焦大型语言模型高频问题

专门拆解 LLMs 的核心痛点与解决方案,比如让很多人头疼的 “复读机问题”:

三、路线必明: AI 大模型学习路线图,1 张图理清核心内容

刚接触 AI 大模型,不知道该从哪学起?这份「AI大模型 学习路线图」直接帮你划重点,不用再盲目摸索!

路线图涵盖 5 大核心板块,从基础到进阶层层递进:一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

四、资料领取:全套内容免费抱走,学 AI 不用再找第二份

不管你是 0 基础想入门 AI 大模型,还是有基础想冲刺大厂、了解行业趋势,这份资料都能满足你!

现在只需按照提示操作,就能免费领取:

👇👇扫码免费领取全部内容👇👇

2025 年想抓住 AI 大模型的风口?别犹豫,这份免费资料就是你的 “起跑线”!

更多推荐

已为社区贡献571条内容

已为社区贡献571条内容

所有评论(0)