驭码CodeRider 接入 GLM-4.7 & MiniMax M2.1,Token 费用我们包了!

12 月 23 日与 25 日,智谱 AI GLM-4.7 与 MiniMax M2.1 相继发布,在代码生成、工具调用、多语言支持等维度刷新开源模型纪录。当朋友圈还在争论"谁才是国产 SOTA"时,极狐驭码 CodeRider 团队已连夜完成双模型接入。

驭码CodeRider 接入 GLM-4.7 & MiniMax M2.1,Token 费用我们包了!

摘要:

12 月 23 日与 25 日,智谱 AI GLM-4.7 与 MiniMax M2.1 相继发布,在代码生成、工具调用、多语言支持等维度刷新开源模型纪录。

当朋友圈还在争论"谁才是国产 SOTA"时,极狐驭码 CodeRider 团队已连夜完成双模型接入。

这篇文章不聊参数对比,只谈一个开发者最关心的问题:当最强模型出现时,你能否在下一秒就用上?

因为在 AI 编程这场无限游戏里,"第一时间响应"本身就是一种核心竞争力。

国产 AI 编程模型的"王炸时刻",到底强在哪?

最近几天,AI 编程圈被两个消息刷屏。

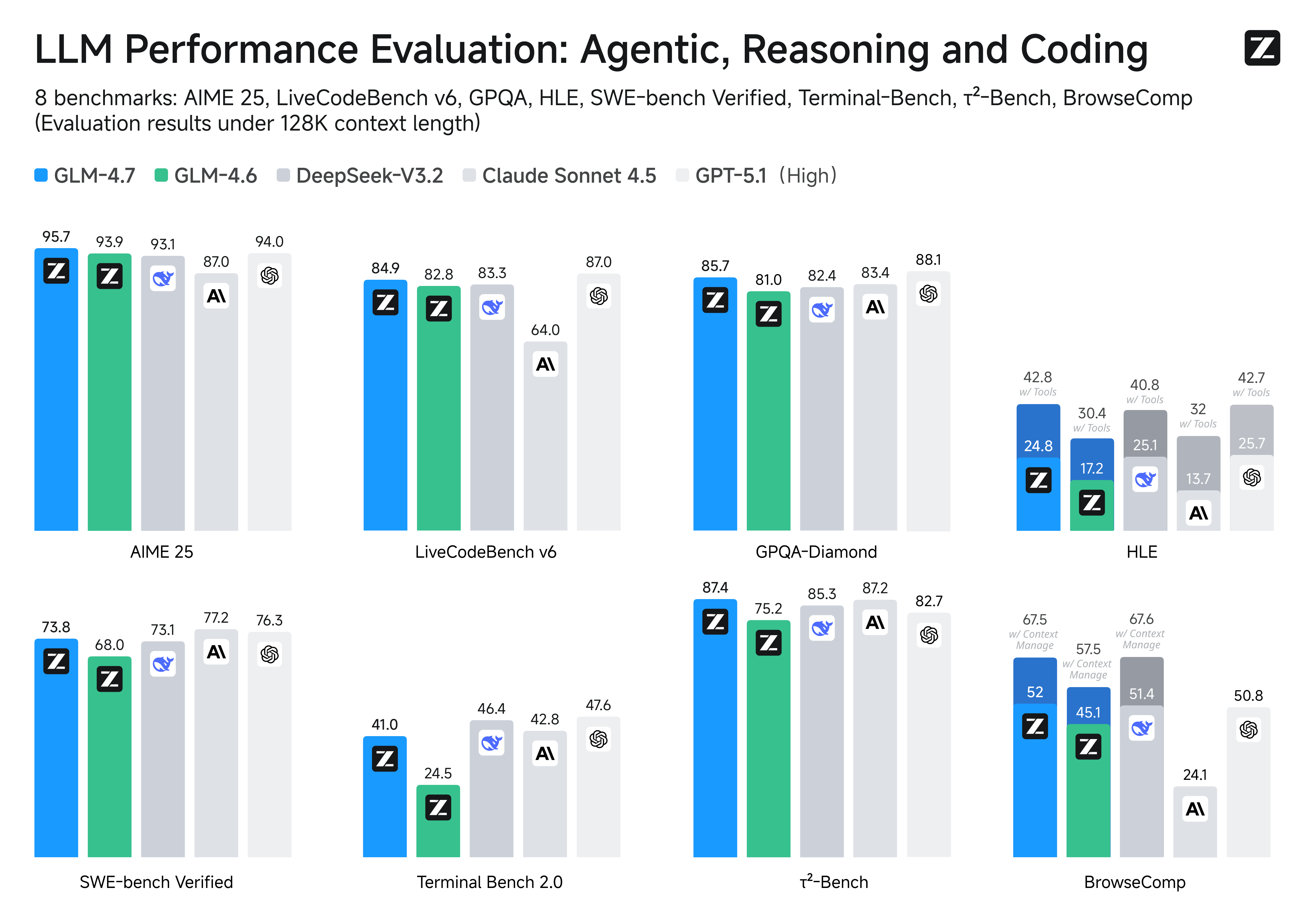

12 月 23 日,智谱 AI 发布 GLM-4.7,开源即王炸。官方推文里那句"更强的编码"不是客套——在 SWE-bench Verified 上拿下 73.8% 的开源 SOTA,LiveCodeBench V6 达到 84.9%,直接对标 Claude Sonnet 4.5。更让人眼前一亮的是前端审美提升:PPT 16:9 适配率从 52% 跃升至 91%,海报设计开始有"设计感"了。这意味着什么?意味着 AI 不再只是"能跑就行",而是开始理解"好看"这件事。

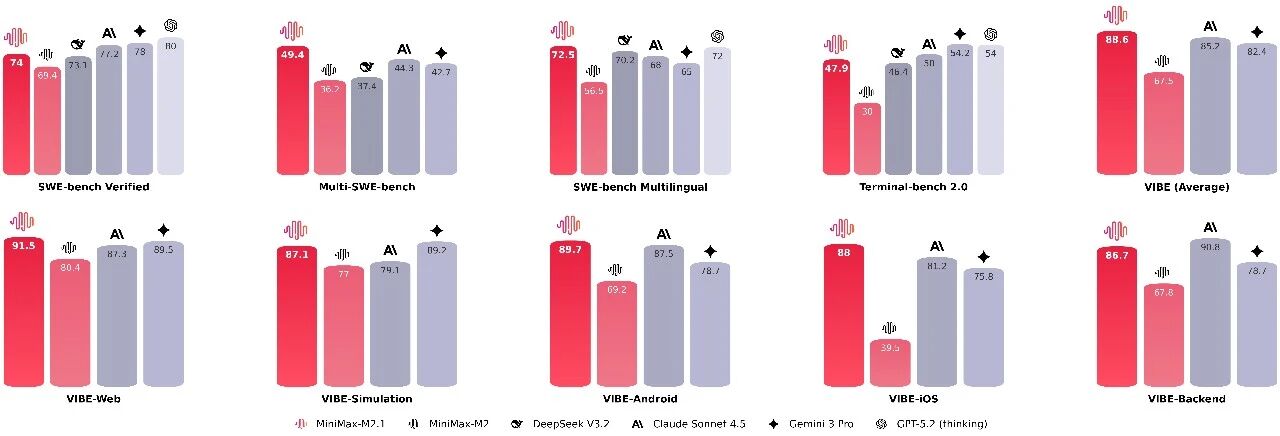

紧接着 12 月 25 日,MiniMax M2.1 登场。如果说 GLM-4.7 是全能选手,MiniMax 2.1 就是多语言领域的偏执狂——系统性提升了 Rust / Java / Golang / C++ / Kotlin / Objective-C / TypeScript / JavaScript 等语言的能力,覆盖了从底层系统到应用层开发的完整链路。在自建的 VIBE 基准测试中,M2.1 以 88.6 分的成绩展现出接近 Claude Opus 4.5 的全栈构建能力。更关键的是,它把"复合指令约束"能力玩出了花,在 AgentCompany Benchmark 里能主动在通讯软件收集设备请求、去服务器查文档算预算、更新项目状态——这不是 demo,这是真实办公场景的"数字员工"。

但等等,这些数据对开发者到底意味着什么?

**意味着 AI 编程正在经历从"能用"到"好用"的临界点。**GLM-4.7 的"保留式思考"让多轮对话成本更低,MiniMax M2.1 的"更简洁高效的回复"让 Token 消耗明显下降。这些特性指向同一个方向:

AI 编程正在从"玩具"升级为"工具",从"尝鲜"转向"依赖"。

基准测试到真实场景:AI 编程的"最后一公里"陷阱

然而,熟悉的开发者都知道,基准测试高分和真实体验顺滑之间,隔着一道深不见底的鸿沟。

你可能在 Twitter 上看过无数令人惊艳的 AI 编程 demo:一句话生成一个 3D 圣诞树、一个鼓机模拟器、一个 iOS 小组件。但回到自己的工位,面对公司那个积累了十年的祖传代码库,AI 给出的答案往往是"幻觉式完成"——看起来很美,跑起来就崩。这不是模型不够强,而是缺少了关键一环:场景适配。

GLM-4.7 的推文里藏着一个细节:“在 Claude Code 环境中,我们对 100 个真实编程任务进行了测试,覆盖前端、后端与指令遵循等核心能力”。MiniMax M2.1 的推文也强调:“在各类编程工具与 Agent 框架中均有出色表现,对 Skill.md、Claude.md / agent.md / cursorrule 等 Context Management 机制提供可靠支持”。

看到了吗?模型厂商们已经开始意识到:**脱离 IDE 生态和开发者工作流谈能力,就是耍流氓。**一个模型再强,如果不能在 Cursor、Claude Code、Cline、Kilo Code、Roo Code 这些主流框架里稳定运行,不能正确读取你的 .cursorrules、不能理解你的项目结构、不能调用你的私有工具链,那它的"强"就跟你没关系。

这就是 AI 编程的"最后一公里"陷阱。模型厂商负责把引擎造得足够强劲,但谁来把它装进你的车里,让它适配你的路况、你的驾驶习惯、你的安全规范?

答案很简单: AI 编程智能体(AI Coding Agent) 。

当最强模型,遇上最懂企业的编程智能体

驭码CodeRider,全球第一私有化 DevOps 平台推出的最流畅 AI 编程智能体。比 Cursor 更懂企业,比 Claude Code 更全面,比 Copilot 更安全,比大厂更极致——这不是贬低,是陈述事实。

我们的底气来自四个底层支撑:

一体平台·全域智能

从需求理解、跨文件代码补全、多角色智能体编程,到 CI/CD 流水线自动修复,所有环节在一个架构内完成。因为我们与 GitLab 原生融合,对代码仓库有完整控制能力,你的所有代码及元数据在 GitLab 端实现最终原生备份。单一可信数据源,让 GLM-4.7 的"任务交付"闭环和 MiniMax M2.1 的"数字员工"能力真正落地。

双轮驱动·效能倍增

AI Coding 和 AI DevOps 不是两个模块,而是双轮驱动。

在 IDE 侧,CodeRider-Kilo 通过 LSP-AST、编辑区历史等方式丰富上下文,让 GLM-4.7 生成"更准";在 GitLab UI 侧,AI DevOps 让 MiniMax M2.1 的 Agent 能力贯穿需求、提交、测试、部署全流程。代码智能生成与代码仓智能管理的联动,打破单点能力边界。某跨国汽车集团使用后,依托 GitLab 深度融合,研发人员能多引用稳定项目代码模块,生成代码既准确又符合规范,完美避免大模型幻觉。

三种部署·灵活安全

GLM-4.7 和 MiniMax M2.1 都是公有云 API,但企业级开发的核心诉求是数据主权。CodeRider 提供 SaaS、混合、私有化三种模式。某全球零售巨头选择私有化,看中我们能将历史项目解构,帮助快速理解架构,同时确保核心资产不离开内网;某自动驾驶头部企业要求物理隔离,联动多部门协同,实现全流程智能体赋能。平衡数据安全性、代码生成准确性与成本,我们在金融、政务、汽车、半导体等行业反复验证过。

SOTA模型·持续领先

重点来了。

CodeRider 具备业内独有的国内 SOTA 大模型灵活切换能力,GLM-4.7 和 MiniMax M2.1 的接入就是证明。我们不绑定任何单一模型,而是通过 AI Engine 基座,支持 DeepSeek V3.1/R1、Qwen3 Coder、Kimi K2 等顶尖模型无缝切换。当智谱发布 GLM-4.7,你不用改代码,直接在 IDE 里勾选;当 MiniMax 推出 M2.1-lightning,系统自动匹配更快的推理通道,价格不变。规避单一模型绑定风险,这是 CodeRider 给开发者的长期承诺。

更关键的是,我们支持接入用户自定义第三方模型。你有自己的微调模型?接入进来,CodeRider 的上下文工程会让它们如虎添翼。这才是开放式模型配置的终极意义。

在无限游戏里,选择"快"的伙伴

回到开头的问题:当 GLM-4.7 和 MiniMax M2.1 这样的最强模型出现时,开发者最需要什么?

不是参数解读,不是基准测试对比,而是一个能在下一秒就让它为你所用的工具。

我们只想做开发者背后那个"永远快一步"的工程团队。你负责探索技术的边界,我们负责把边界变成你 IDE 里的一个按钮、一个配置、一个开箱即用的默认设置。

现在,GLM-4.7 和 MiniMax M2.1 已经在 CodeRider 中等你。不用改配置,不用迁环境,打开 IDE,选择模型,开始编码。就是这么简单。

毕竟,生产力工具的唯一使命,就是让开发者少说"等等",多说"搞定"。

使用成本我们承担,开发者专注创造即可

最实际的福利来了。为了让开发者充分体验国产大模型的实力,CodeRider-Kilo 目前面向开发者承担全部 Token 费用,开放不限量体验。

这意味着智谱 GLM-4.7 和 MiniMax M2.1 的顶级能力,开发者可以零成本探索。

我们为用户买单,让创新不再受限于预算。

不用算 Token 用量,不用心疼钱包,直接 IDE 插件市场搜索下载 CodeRider-Kilo,就能在 IDE 里享受极致丝滑编程体验。

登录 CodeRider-Kilo,在模型列表中选择 GLM-4.7 或 MiniMax M2.1,开启你的下一代 AI 编程体验。

立即体验: 登录驭码 CodeRider,在模型列表中选择 GLM-4.7 或 MiniMax M2.1。

关于极狐驭码: 极狐驭码是中国领先的 AI DevOps 与 AI Coding 平台,旗下产品包括极狐 GitLab 企业级 DevOps 平台与驭码 CodeRider AI 编程智能体。公司致力于通过"双轮驱动"战略,赋能中国 1000 万开发者及 10 万家企业,推动软件研发进入 AI 原生时代。

官网:gitlab.cn

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)