别再乱试了!全参、LoRA、RAG:3张图看懂你的AI项目该选哪种方案

利用“低秩适应”的数学原理,认为模型为了学习新任务所需的改变(ΔW)是“低维度”的,可以用两个极小矩阵的乘积(B*A)来高效模拟。将持续为您提供最新的微调技术和自动化工具,让保持技术敏感度和实践迭代能力变得简单高效——毕竟,在这个快速演进的时代,持续进化的能力比一次完美的选择更为重要。最近收到最多的问题就是:“我有一个很棒的idea,想用大模型来实现,但ChatGPT/文心一言好像不太懂我的专业领

你好,我是你们的AI技术博主。

最近收到最多的问题就是:“我有一个很棒的idea,想用大模型来实现,但ChatGPT/文心一言好像不太懂我的专业领域,我到底需不需要、值不值得花精力去微调一个自己的模型?”

如果你也有同样的困惑,那么这篇文章就是为你写的。今天我们不谈晦涩的数学公式,就用最直白的语言,带你彻底搞懂大模型的三种“能力激活”方式:全参数微调、LoRA微调和RAG。看完后,你不仅能明白它们是什么,更能清晰地知道,你的项目究竟该选哪条路。

引言:你的大模型,为什么需要“开小灶”?

想象一下,你招了一位顶尖大学的通才毕业生(比如ChatGPT),他博古通今,能说会道。但现在,你需要他立刻上岗成为你公司的资深法律顾问或芯片设计专家。直接让他看合同、画电路图,他大概率会表现得像个“懂王”——说得多,但对得少。

这就是通用大模型的现状:广度惊人,深度不足。它们缺乏你业务场景中的私有数据、专业术语、内部流程和特定风格。

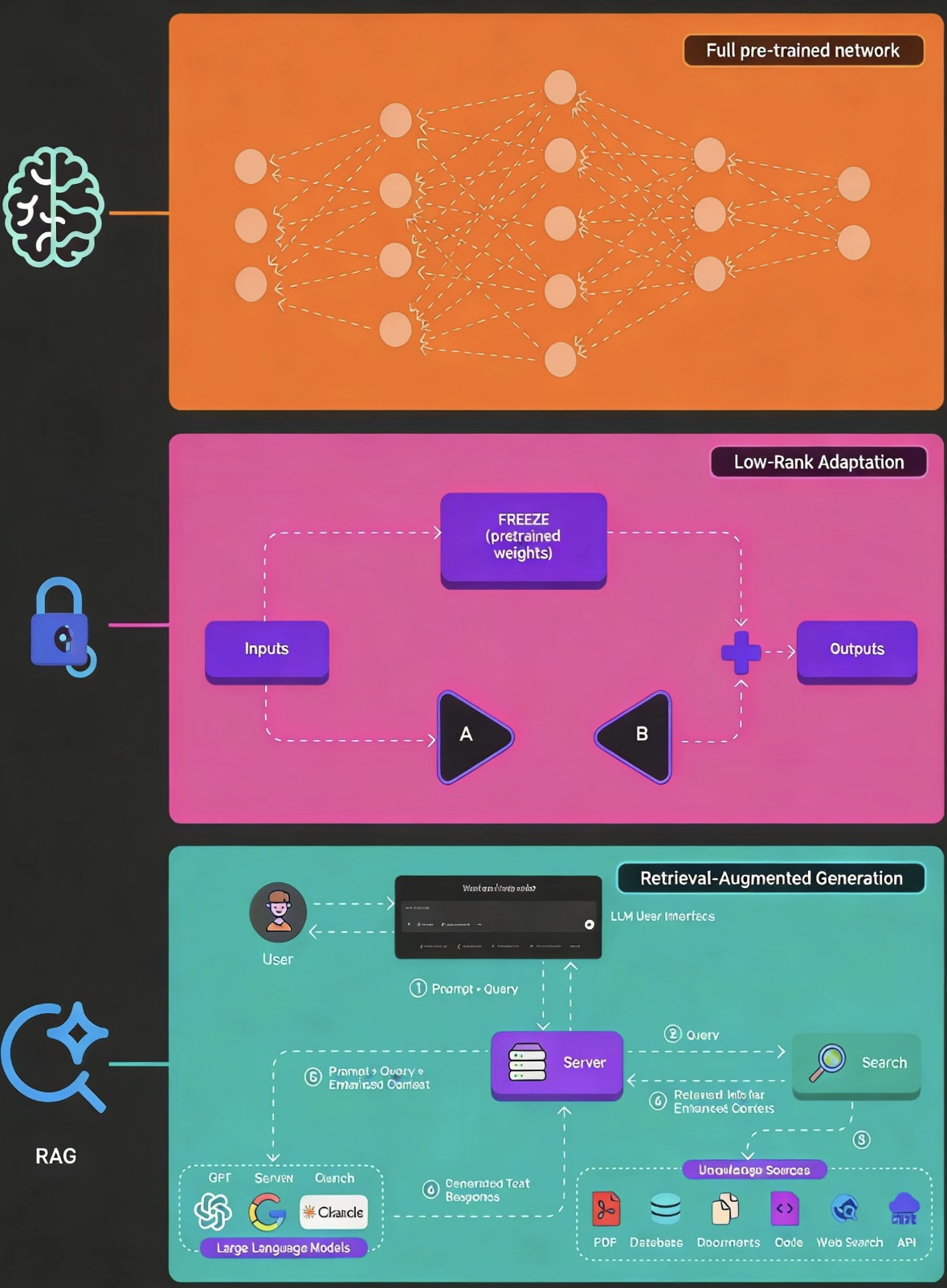

这时,你有三条路可以走,对应着我们今天要讲的三大技术:

- 全参数微调:送他回法学院/工程学院,花巨资让他重学一遍专业课程。(成本高,效果深)

- LoRA微调:给他报一个高效的“行业精英速成班”,只学习核心差异。(成本低,效果好)

- RAG:不培训他本人,而是给他配一个超级助理,随时帮他查阅最新的行业资料和公司文件。(成本最低,见效快)

选哪条路,直接决定了你的项目成本、周期和最终效果。下面,我们就来逐一拆解。

选哪条路,直接决定了你的项目成本、周期和最终效果。下面,我们就来逐一拆解。

技术原理:三大门派,各显神通

1. 全参数微调:脱胎换骨的“专家重塑”

- 核心比喻:让通才回炉重造,成为一名彻头彻尾的领域专家。

- 它在做什么:用你的专业数据集(如法律条文、医疗病例、客服对话),对预训练大模型的每一个参数(权重) 进行重新训练和调整。

- 技术本质:模型的所有“神经元连接强度”都被重新校准,以最大化在你数据上的表现。这相当于用你的数据,在通用知识的基础上,重建了模型的整个“世界观”。

- 优点:

- 效果上限最高:模型从底层逻辑上理解了你的领域,能进行深度推理。

- 部署简单:训练完就是一个独立的、功能完整的模型,拿来就用。

- 缺点(非常突出):

- “土豪”游戏:需要大量GPU(如多张A100),训练几天甚至几周,电费和云成本惊人。

- “灾难性遗忘”风险:学得太专注新知识,可能忘了原来的通用常识。

- 不灵活:每做一个新任务,就要从头训练一个庞然大物,存储都是问题。

2. LoRA微调:四两拨千斤的“技能插件”

- 核心比喻:给通才装备一个轻便的“专业技能扩展包”。

- 它在做什么:冻结大模型原有的所有参数(不动它的通用知识)。然后,在模型的某些关键层(比如注意力机制)旁边,插入一对小小的、可训练的“适配器”矩阵(A和B)。训练时,只更新这几个微型矩阵。

- 技术本质:利用“低秩适应”的数学原理,认为模型为了学习新任务所需的改变(ΔW)是“低维度”的,可以用两个极小矩阵的乘积(B*A)来高效模拟。只训练这极少量(通常不到原模型1%)的参数。

- 优点:

- 性价比之王:单张消费级显卡(如RTX 4090)就能玩转,训练速度提升数倍。

- 模块化神器:训练好的“技能包”(适配器权重)只有几MB到几百MB,可以轻松切换、组合、分享。一个基础模型可配无数个技能包。

- 保底能力强:因为原模型参数被冻结,通用能力得以完美保留。

- 缺点:

- 理论性能上限略低于全参数微调(但在绝大多数场景下差距微乎其微)。

- 需要选择对哪些层插入适配器(target_modules),有一定调参经验。

3. RAG:即插即用的“外挂知识库”

- 核心比喻:不给专家做培训,而是给他配一个能秒查所有资料的神级秘书。

- 它在做什么:完全不修改大模型本身。当用户提问时,系统先从一个外部知识库(你的文档、数据库、网页)中,通过检索找到与问题最相关的片段。然后,把这些片段和原始问题一起,作为“增强版提示词”喂给大模型,让它基于这些给定信息来生成答案。

- 技术本质:将模型的“记忆能力”和“推理能力”解耦。记忆(知识)放在外部可更新的向量数据库中,推理(组织语言、逻辑分析)交给大模型。核心是检索精度和提示词工程。

- 优点:

- 零训练成本:无需任何GPU训练,立即部署。

- 知识实时更新:更新知识库文档,模型回答立刻随之更新。

- 答案可溯源:能告诉用户答案出自哪份文档的哪一页,极大增强可信度。

- 有效减少“幻觉”:答案基于提供的事实,胡编乱造的概率降低。

- 缺点:

- 答案质量依赖检索:如果检索不到或检索错资料,模型再强也白搭。

- 推理链可能不深入:模型是在“复述”或“总结”你给的信息,而非从内部深度理解后推理。

- 提示词更长:每次问答都附带检索内容,消耗更多Token(API费用或算力)。

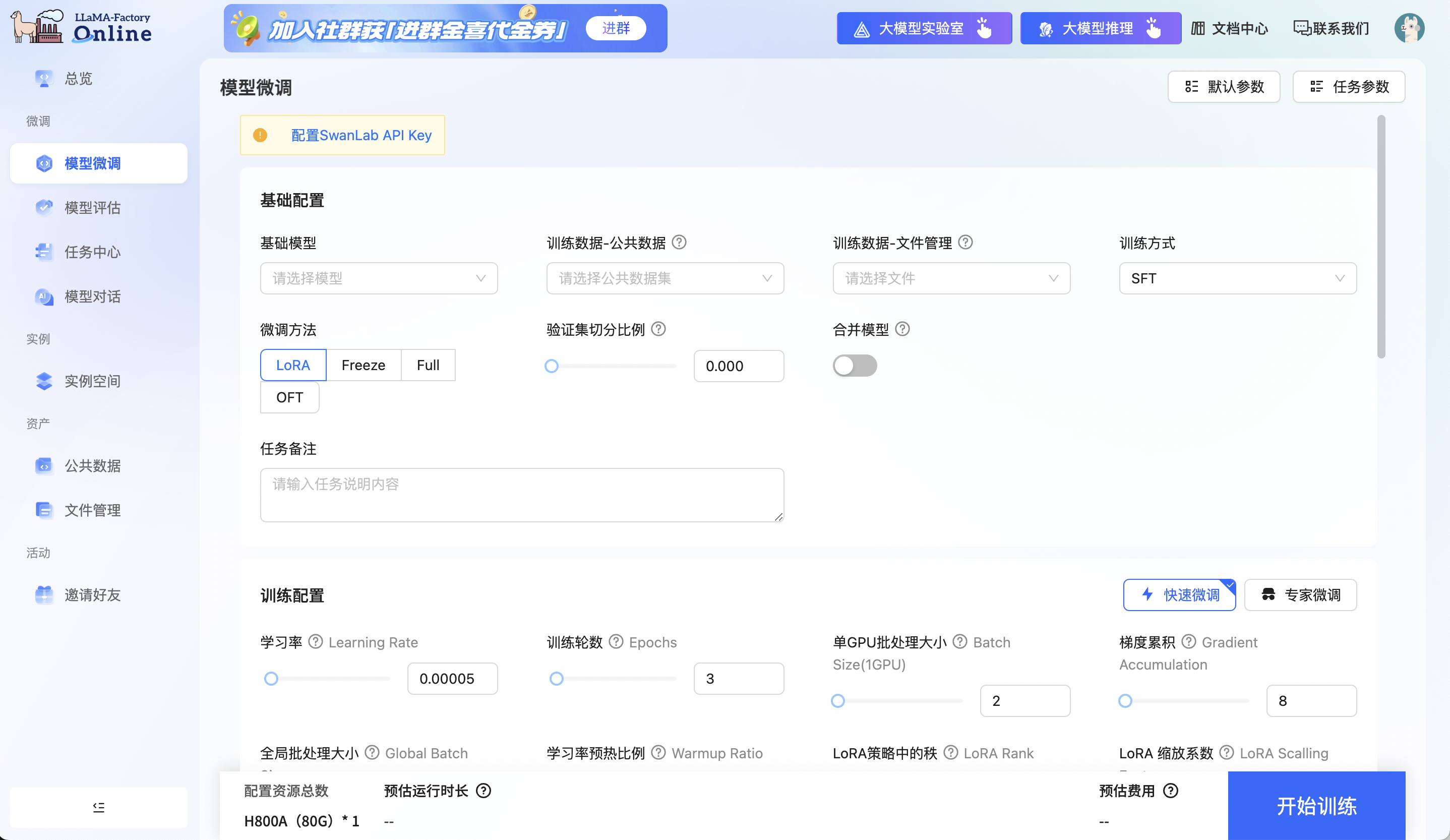

4. LLaMA-Factory:“模型微调”

实践步骤:我该如何动手?(以LoRA为例)

看到这里,我相信LoRA的平衡之美已经打动了许多人。它是在资源、效果和灵活性之间取得最佳平衡点的技术。下面,我们手把手看看如何实现一个LoRA微调。

【LLaMA-Factory】:对于想快速入门、不想折腾本地环境的同学,我强烈推荐使用Google Colab Pro或AutoDL这类云GPU平台。它们提供了预装好的PyTorch环境,按小时计费,特别适合做实验和中小规模训练。尤其是AutoDL,常有高性价比的RTX 4090/A100实例,是个人开发者的利器。

步骤一:准备你的“教材”(数据)

你的数据质量决定模型上限。准备一个JSON或JSONL文件,格式可以是:

- 指令跟随式(推荐):{"instruction": "翻译成英文", "input": "今天天气真好", "output": "The weather is really nice today."}

- 对话式:{"conversations": [{"from": "human", "value": "你好"}, {"from": "gpt", "value": "你好!我是助手。"}]} 收集几百到几千条高质量样本,涵盖你希望模型学会的各种情况。

步骤二:选择“基础模型”(Base Model)

根据你的语言(中/英)、领域和资源,选择一个合适的开源基座模型。例如:

- 中文偏好:Qwen(通义千问)、ChatGLM、InternLM

- 英文/代码强:Llama、Mistral、CodeLlama

- 尺寸选择:7B参数模型是入门甜点,13B/14B效果更好,70B是“巨人”。

步骤三:使用微调框架(LLaMA-Factory为例)

LLaMA-Factory是目前最流行、最易用的微调框架之一,支持全参、LoRA、QLoRA等多种方式。

# 1. 克隆项目git clone https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factory# 2. 安装依赖pip install -r requirements.txt# 3. 准备配置# 将你的数据文件放在 `data/` 目录下# 修改 `dataset_info.json` 配置文件,指明你的数据集路径和格式

步骤四:配置并启动训练

你可以使用其强大的Web UI(python src/webui.py)进行可视化配置,也可以通过命令行:

CUDA_VISIBLE_DEVICES=0 python src/train_bash.py \ --stage sft \ # 指令微调阶段 --do_train \ --model_name_or_path /path/to/your/base_model \ # 基座模型路径 --dataset your_dataset_name \ # 你的数据集名 --template default \ # 对话模板 --finetuning_type lora \ # 使用LoRA! --lora_target all \ # 或指定如 q_proj,v_proj --output_dir ./saves/your_lora_model \ # 输出目录 --overwrite_cache \ --per_device_train_batch_size 4 \ --gradient_accumulation_steps 4 \ --lr_scheduler_type cosine \ --logging_steps 10 \ --save_steps 100 \ --learning_rate 5e-5 \ --num_train_epochs 3.0 \ --plot_loss \ --fp16

训练结束后,在输出目录中,你会得到适配器权重文件(如adapter_model.bin),它就是你训练出的“技能包”。

如果你想挑战微调更大的模型(如70B),或者想在24G显存上玩转13B模型的微调,那么QLoRA是你的必选项。它结合了4-bit量化技术,能极大降低显存占用。只需在训练命令中加入--quantization_bit 4,框架会自动调用bitsandbytes库进行处理。这让你用一块RTX 4090就能完成过去需要A100才能做的事。

步骤五:加载与使用

from transformers import AutoModelForCausalLM, AutoTokenizerfrom peft import PeftModel# 加载基座模型和分词器base_model = AutoModelForCausalLM.from_pretrained("path/to/base_model", torch_dtype=torch.float16, device_map="auto")tokenizer = AutoTokenizer.from_pretrained("path/to/base_model")# 加载LoRA适配器model = PeftModel.from_pretrained(base_model, "./saves/your_lora_model")# 使用inputs = tokenizer("你的专业问题:", return_tensors="pt").to(model.device)outputs = model.generate(**inputs, max_new_tokens=200)print(tokenizer.decode(outputs[0], skip_special_tokens=True))

效果评估:如何判断“小灶”开得成功?

训练完了,别急着高兴,我们需要科学地验收成果:

- 定量评估:

- 看Loss曲线:训练损失是否平稳下降?验证损失是否也同步下降且没有过拟合(后期飙升)?

- 用测试集打分:预留一部分没训练过的数据做测试。如果是分类任务,看准确率;如果是生成任务,可以计算困惑度(PPL),越低越好;或者用BLEU/ROUGE分数与标准答案对比。

- 定性评估(更重要!):

- 构造“考试题”:设计一批涵盖你业务核心、边界情况和易错点的典型问题。

- A/B对比:将同一个问题,分别给原始基座模型、LoRA微调后的模型、以及(如果有)全参微调或ChatGPT来回答。进行盲测,看哪个回答更专业、更准确、风格更符合要求。

- 检查“遗忘”:问一些通用常识问题(“中国的首都是哪里?”),确保模型没有因为微调而变傻。

- 端到端验收:将模型集成到你的演示系统或产品原型中,让真实的目标用户(或同事)试用,收集反馈。这是最直接的评估。

总结与展望:你的最佳路径是什么?

让我们回到最初的问题:大模型微调有必要吗?选哪个?

答案是:“看菜下饭,量体裁衣”。我可以给你一个终极决策树:

你的知识是否需要实时更新(如股票信息、新闻)?或者答案是否需要严格溯源?

-

- 是 → 首选/必选 RAG。这是解决知识新鲜度和溯源问题的唯一正解。

- 否 → 进入下一步。

你的任务是高度专业化的深度推理(如法律判决预测、复杂代码生成),且你有充足的GPU预算和耐心?

-

- 是 → 考虑 全参数微调。为极致的性能付出极致的成本。

- 否 → 绝大多数人,请走向下一步。

你希望模型掌握一种特定技能、风格或领域知识,且希望成本可控、快速迭代?

-

- 是 → 这就是 LoRA 的主场! 它用1%的成本,实现了90%以上的全参微调效果,是个人开发者和中小企业的最优解。

未来展望: 技术正在飞速融合与进化。RAG + LoRA 的混合模式已成为业界标杆——用RAG接入最新、最准确的事实知识,用LoRA调教模型的思考方式和专业领域泛化能力。同时,自动化超参搜索、更高效的适配结构(如DoRA)以及多模态微调正在让“大模型平民化”的道路越来越宽。

记住,在这个时代,启动和迭代的速度,往往比追求一次性的完美更重要。在这个快速发展的领域,LLaMA-Factory Online将持续为您提供最新的微调技术和自动化工具,让保持技术敏感度和实践迭代能力变得简单高效——毕竟,在这个快速演进的时代,持续进化的能力比一次完美的选择更为重要。

希望这篇超长解析能帮你拨开迷雾。如果有更具体的问题,欢迎随时交流。我们下次见!

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)