dify使用指南

Dify 后端服务需要一系列用于存储(如 PostgreSQL / Redis / Weaviate(如果本地不可用))和扩展能力(如 Dify 的。综合案例,将知识库查询到的数据插入到数据库当中大模型通过查询rag,然后调用mcp工具完成了该流程。agent就是智能体,可以理解为大模型可以自主的调用其他工具来完成一些事情。而且有定时触发和webhook触发器,可以很好的完成一些定时复杂任务。工作

目录

1. 安装部署

官方有完整介绍不多讲 https://docs.dify.ai/zh/self-host/quick-start/docker-compose

curl -SL https://github.com/docker/compose/releases/download/v2.30.3/docker-compose-linux-x86_64 -o /usr/local/bin/docker-compose

#将可执行权限赋予安装目标路径中的独立二进制文件

sudo chmod +x /usr/local/bin/docker-compose

sudo ln -s /usr/local/bin/docker-compose /usr/bin/docker-compose

git clone --branch "$(curl -s https://api.github.com/repos/langgenius/dify/releases/latest | jq -r .tag_name)" https://github.com/langgenius/dify.git

cd dify

cd docker

cp .env.example .env

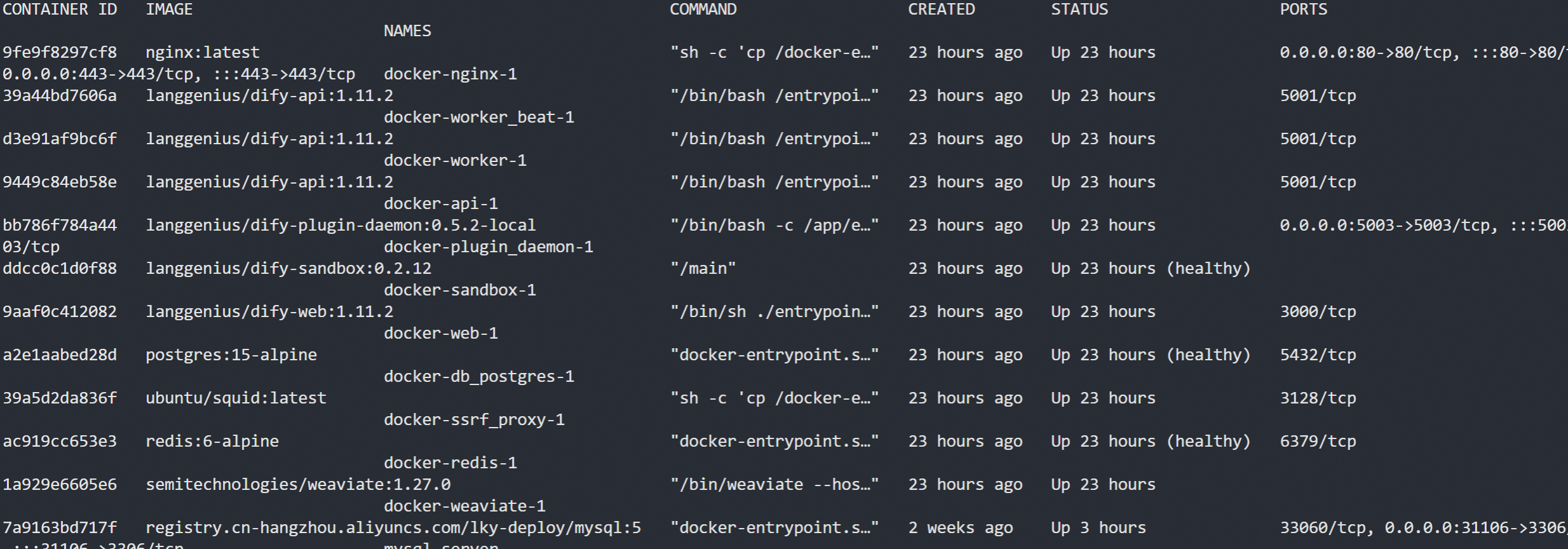

docker compose up -dDify 后端服务需要一系列用于存储(如 PostgreSQL / Redis / Weaviate(如果本地不可用))和扩展能力(如 Dify 的 sandbox 和 plugin-daemon 服务)的中间件

后端服务包括:

- API 服务:为前端服务和 API 访问提供 API 请求服务

- Worker 服务:为数据集处理、工作区、清理等异步任务提供服务

- beat 服务:调试 celery 定时任务或运行定时触发器节点

前端包括web服务还有nginx(可以不需要)

2. 基础环境配置

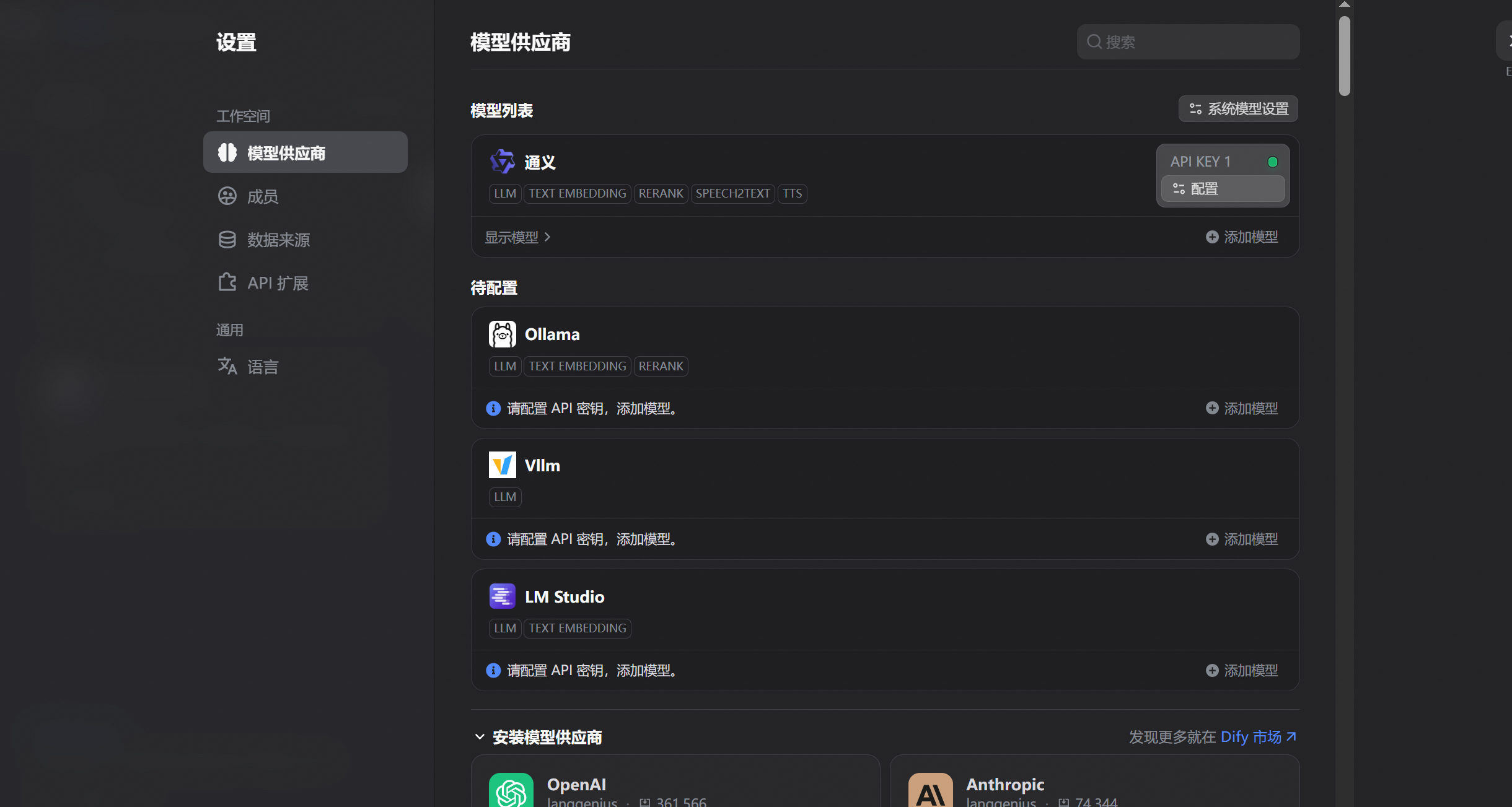

2.1 配置llm

登录后点击设置在模型供应商选择本地部署的llm还是云厂商的

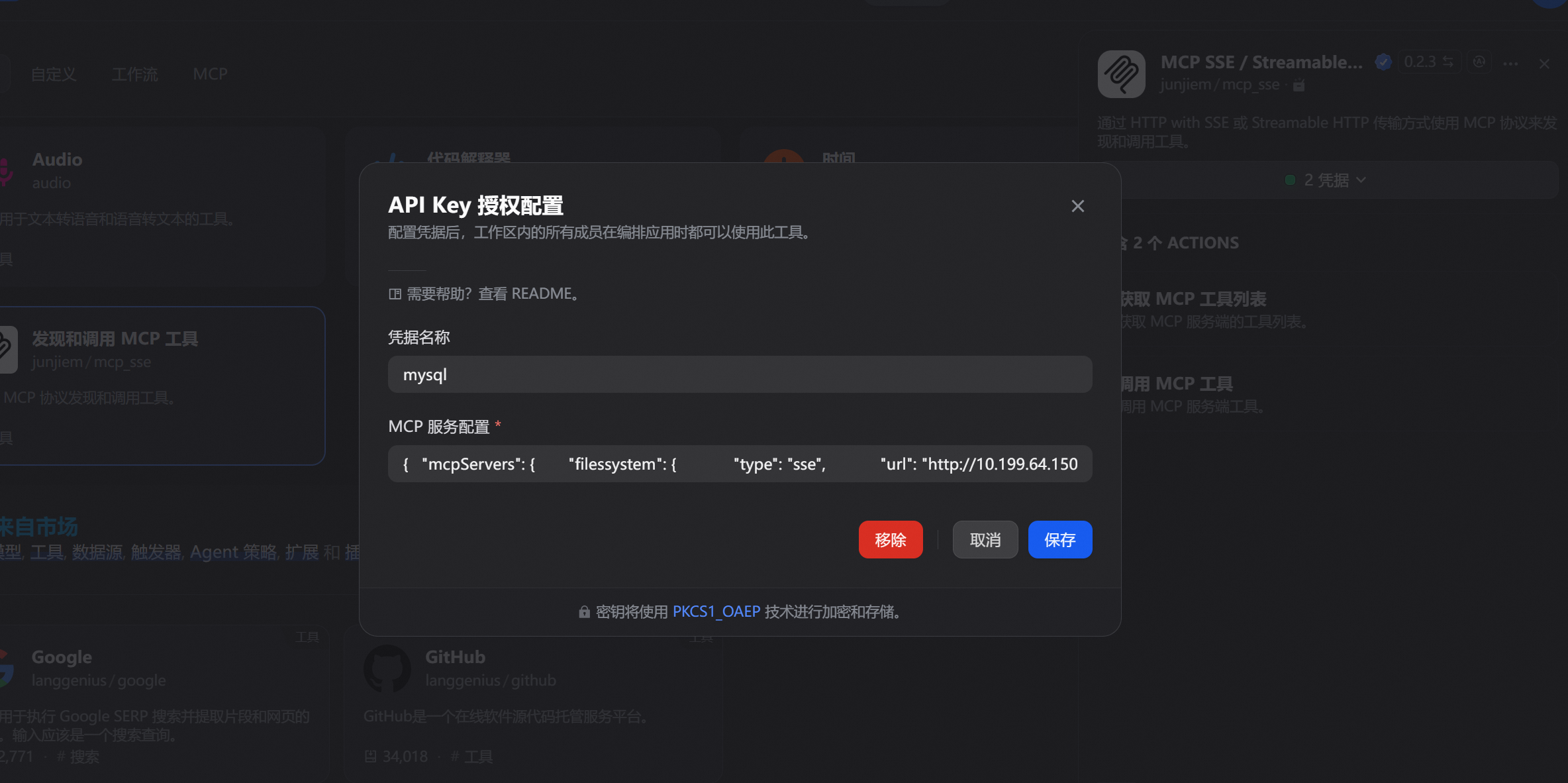

2.2 配置mcp

先去应用市场下载一个mcp插件

配置凭证确保dify能够访问到

{ "mcpServers": { "filessystem": { "type": "sse", "url": "http://10.199.64.150:8951/sse" } } } 3. 案例demo

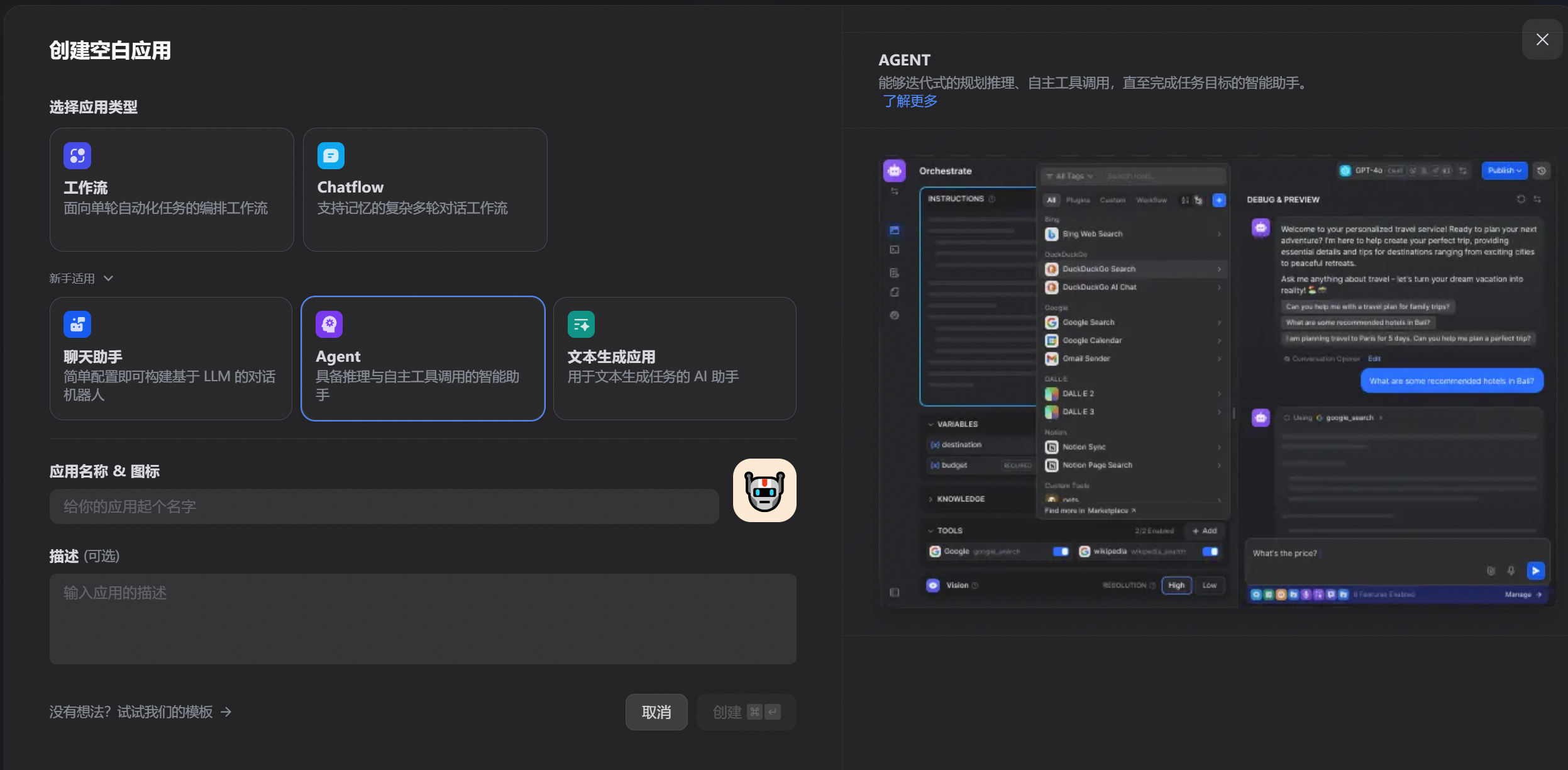

3.1 agent使用

agent就是智能体,可以理解为大模型可以自主的调用其他工具来完成一些事情

创建

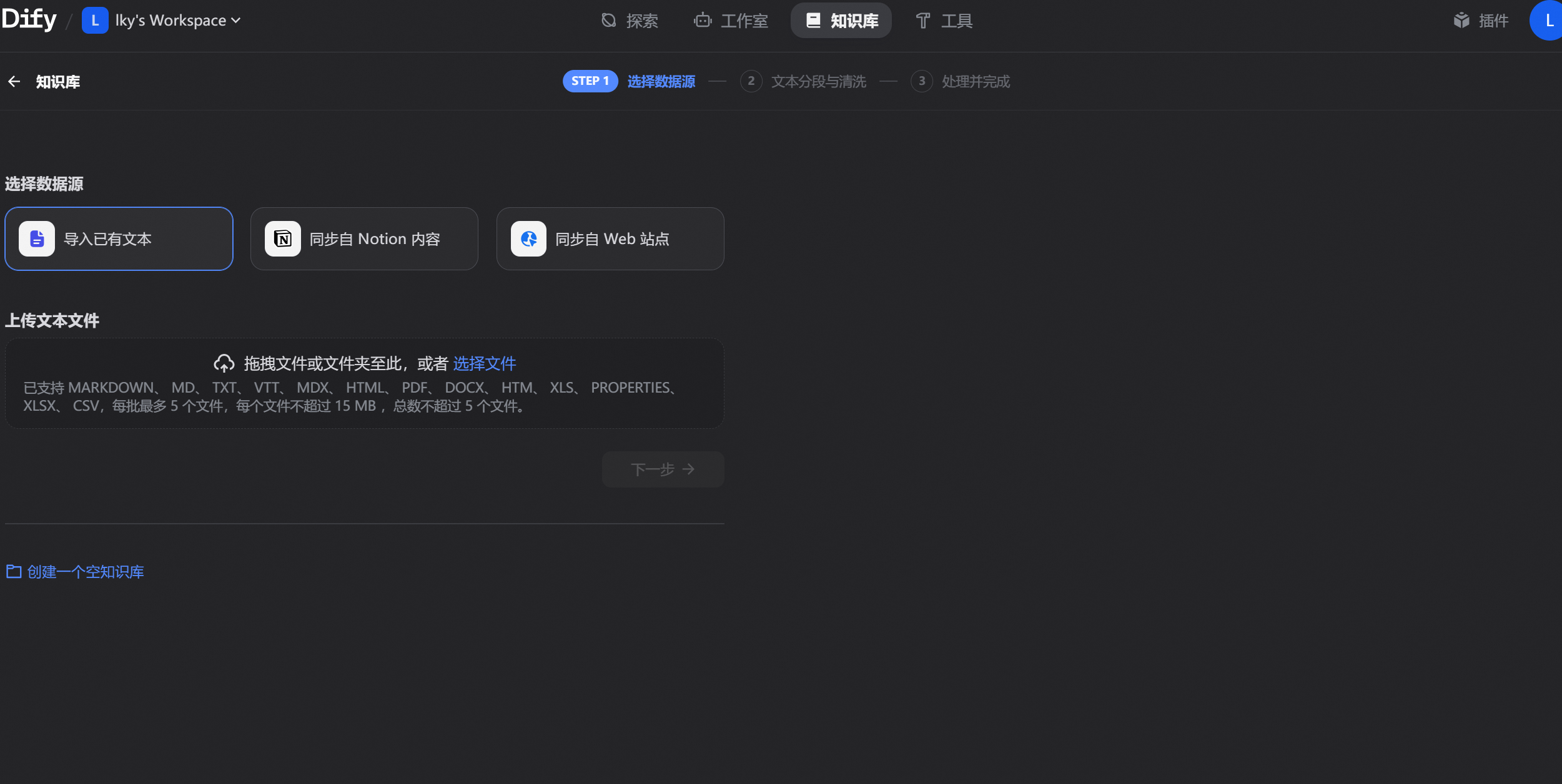

配置llm模型和mcp,知识库

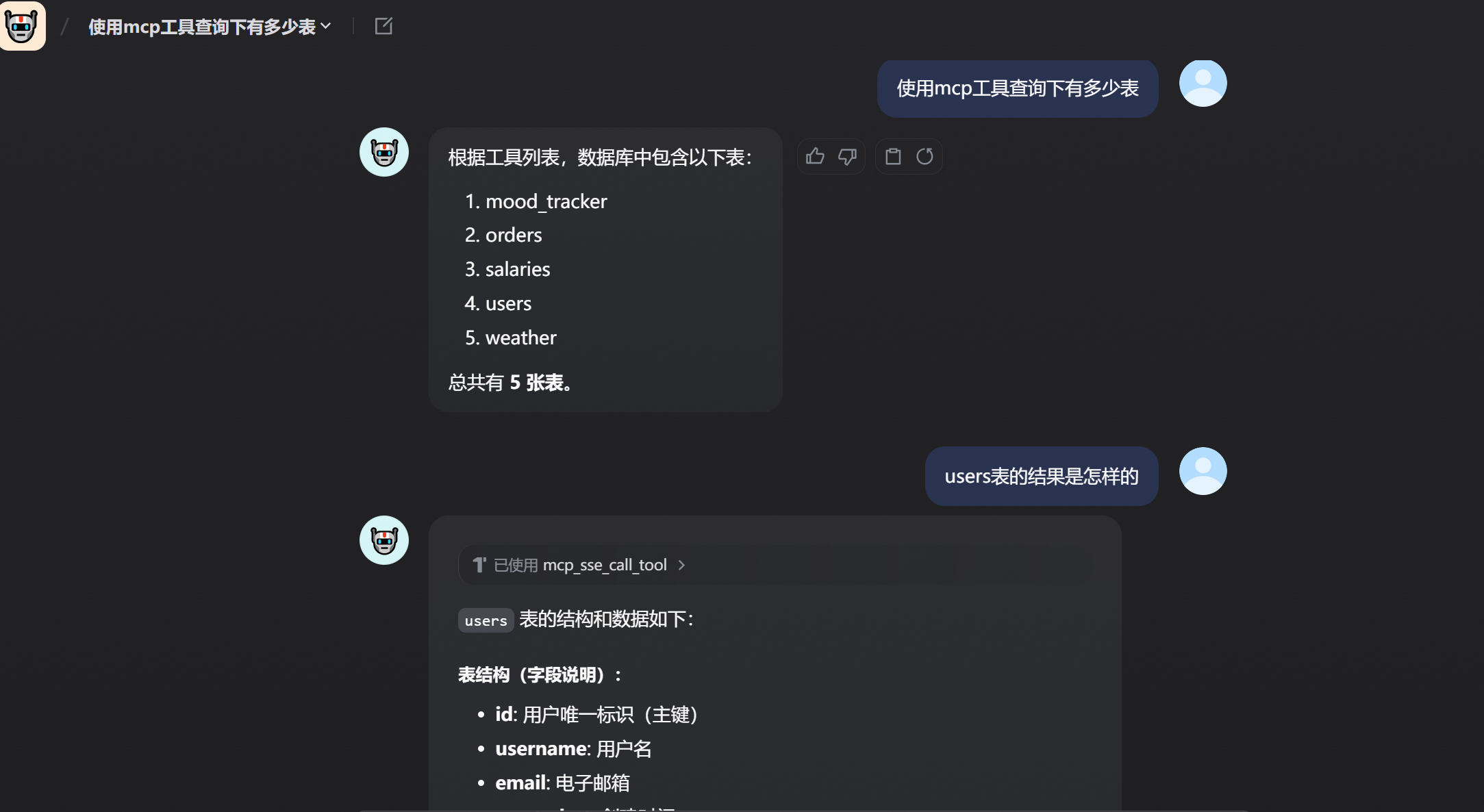

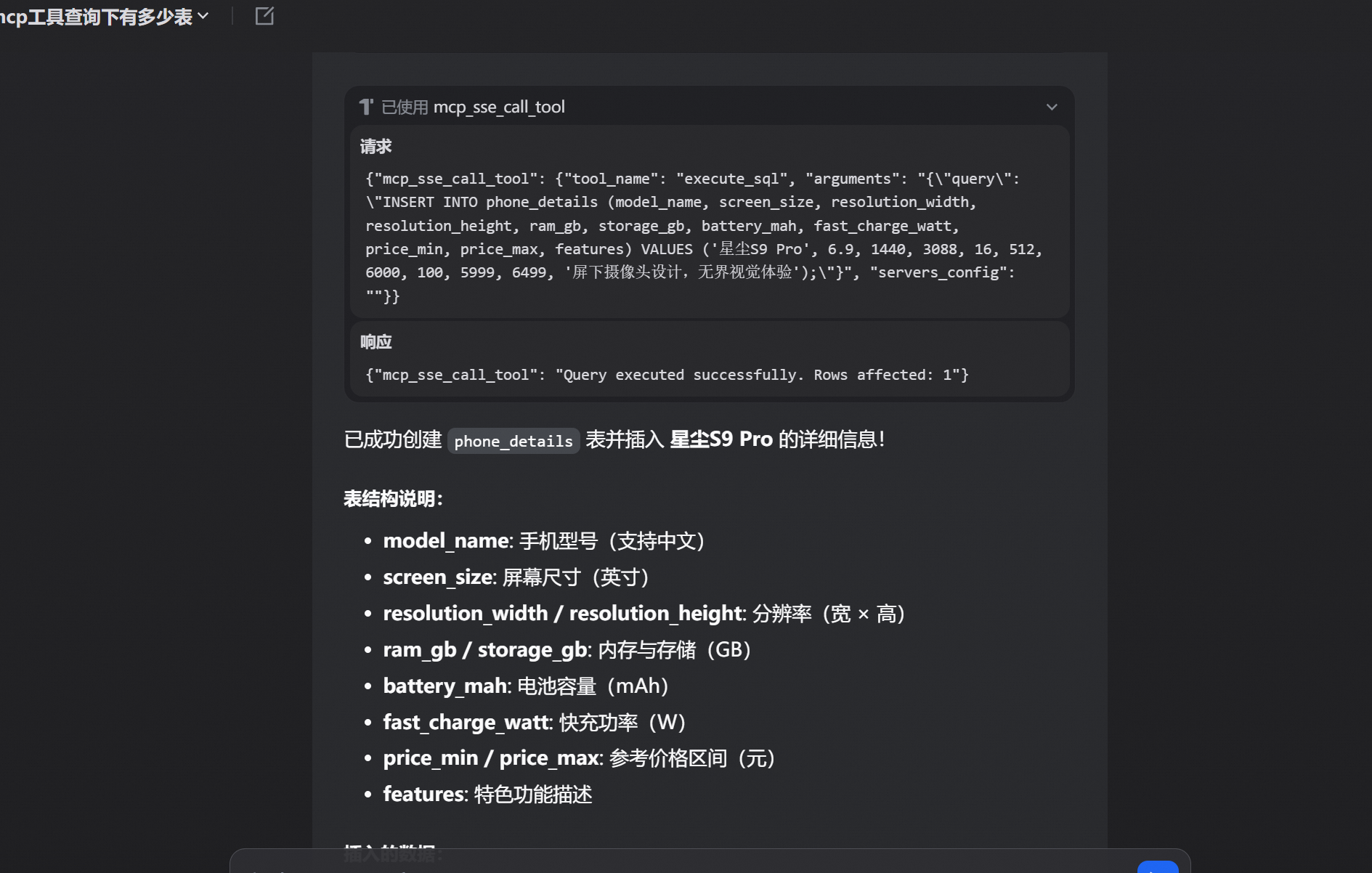

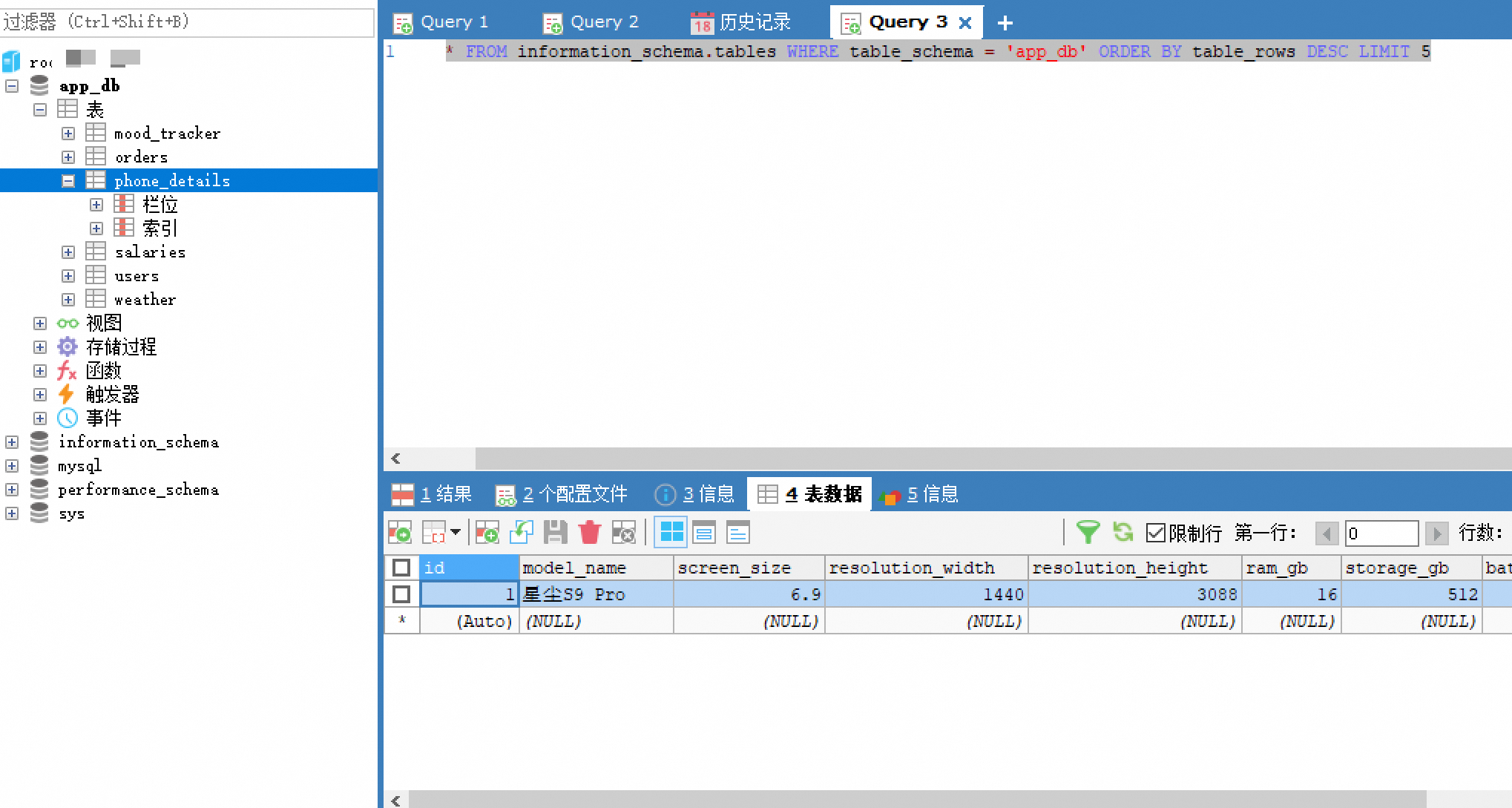

mcp测试

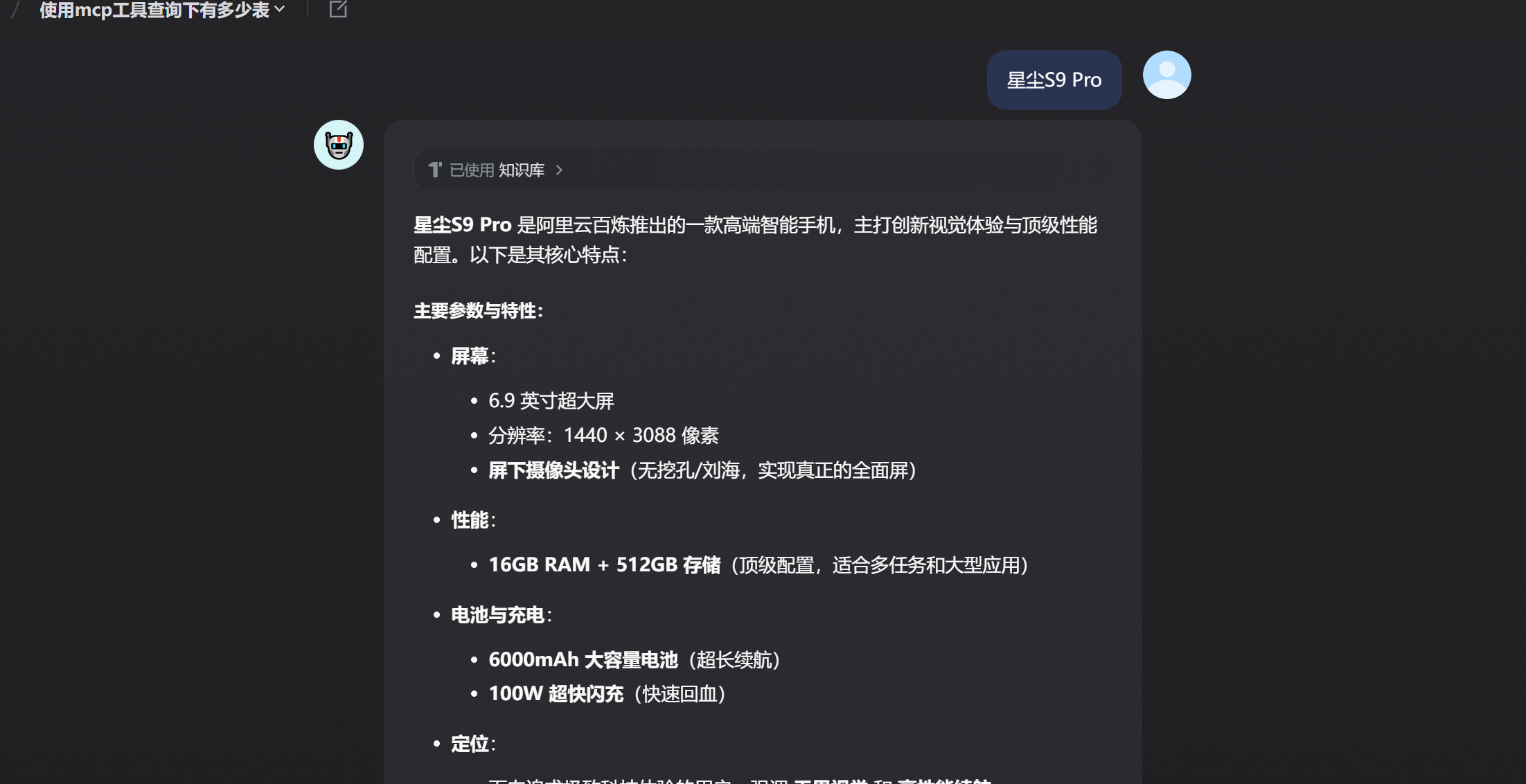

知识库测试

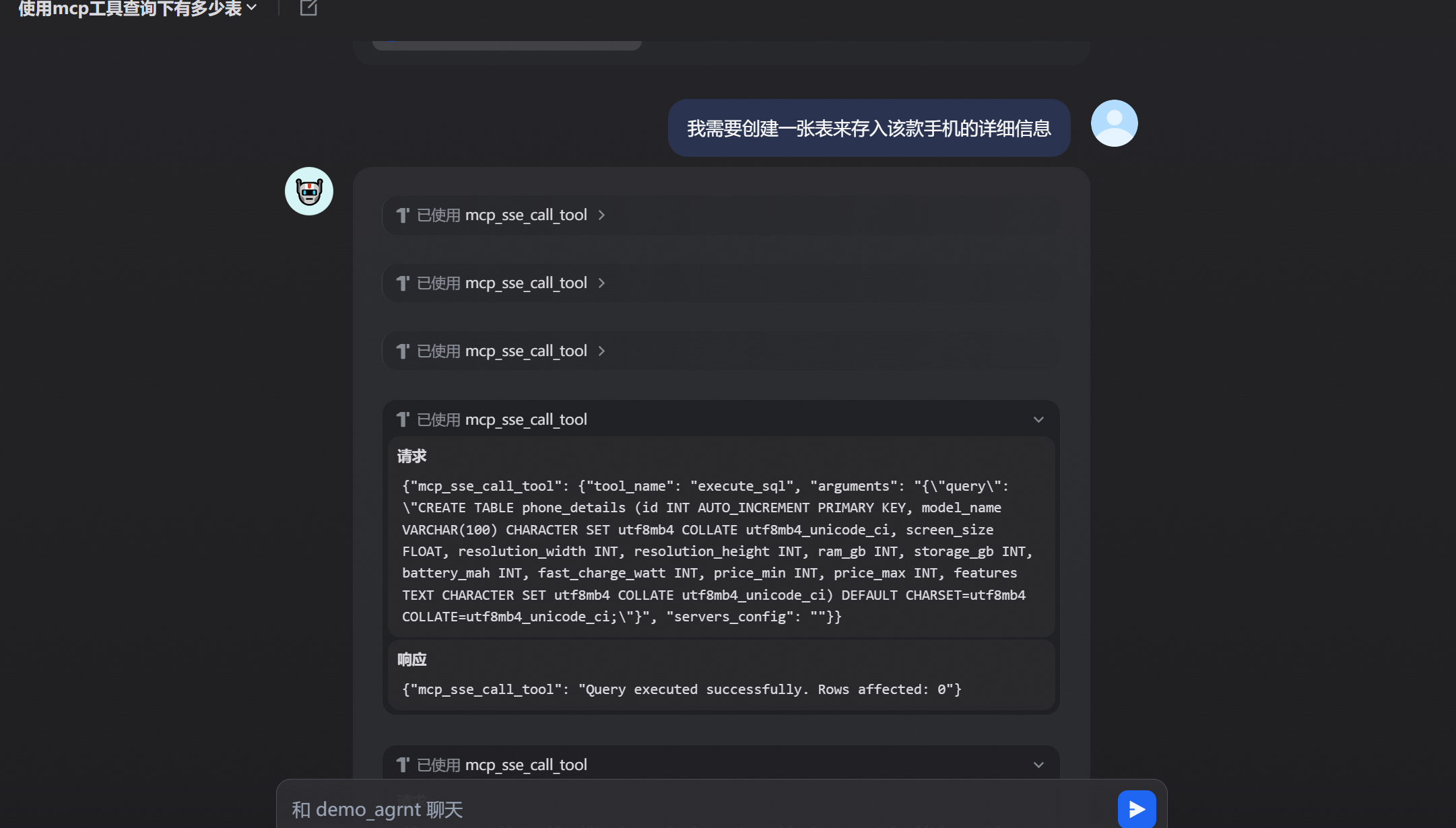

综合案例,将知识库查询到的数据插入到数据库当中大模型通过查询rag,然后调用mcp工具完成了该流程

另外可以通过api很好的集成到系统当中

3.2 工作流使用

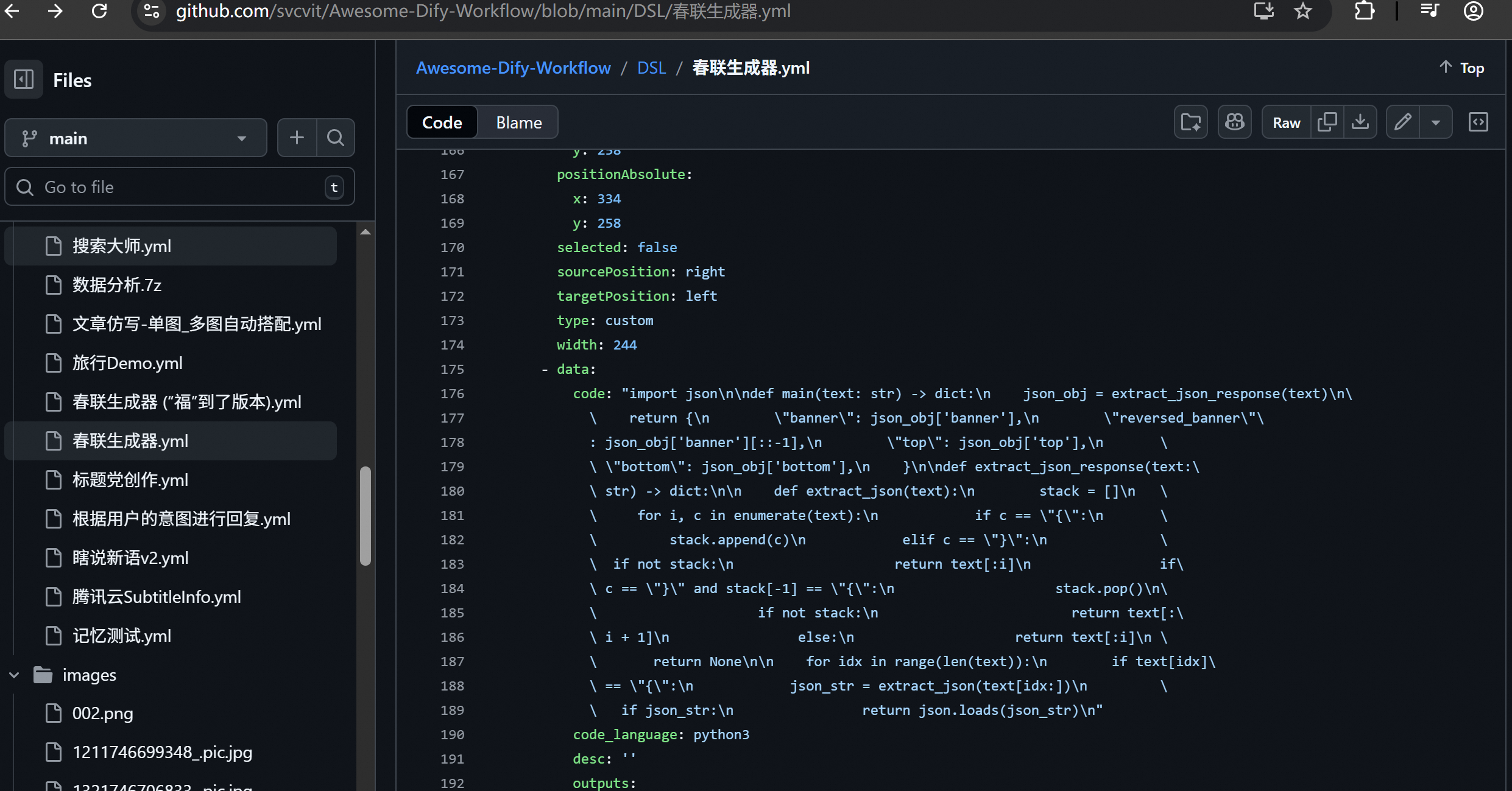

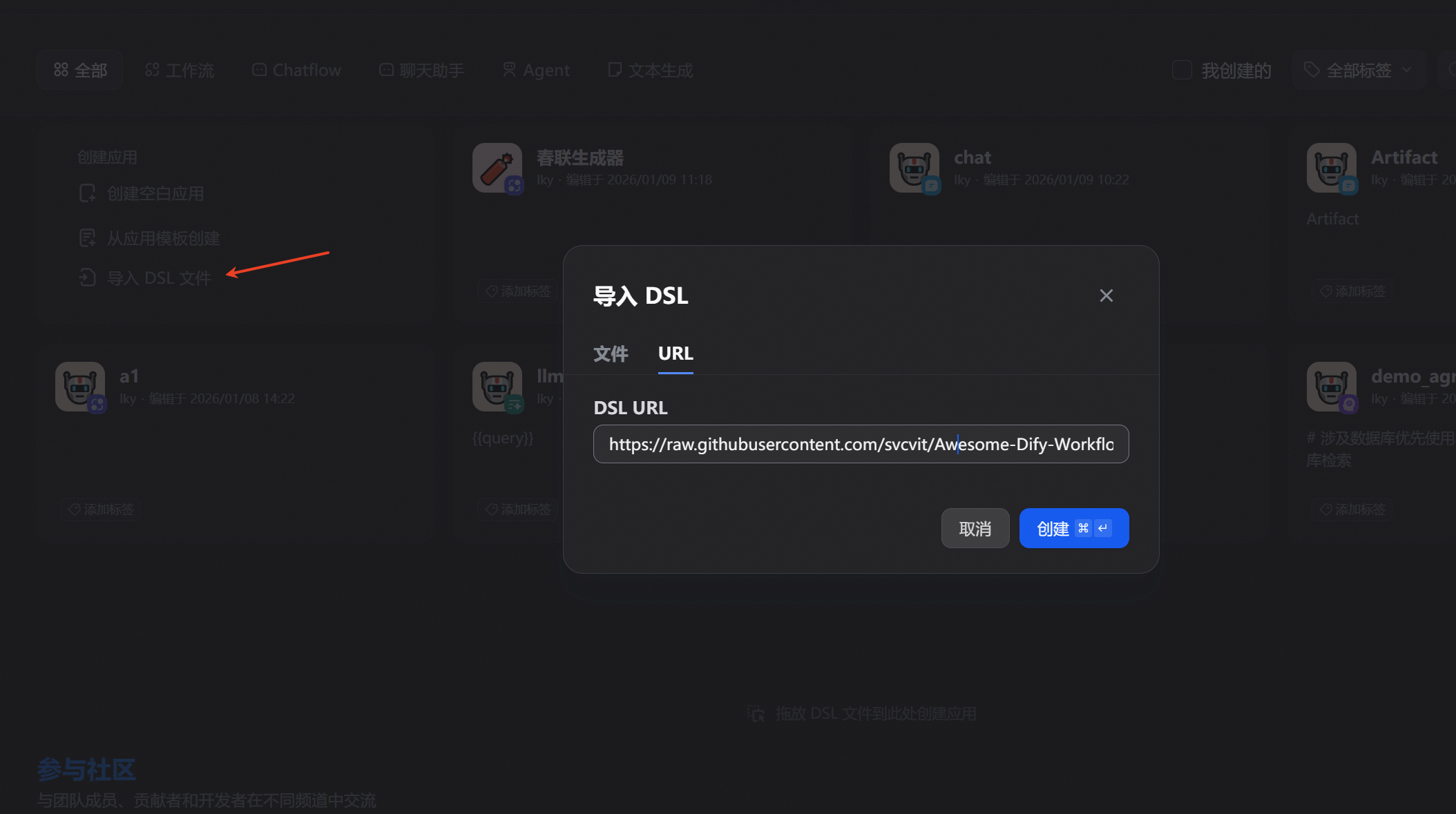

3.2.1 导入dsl

好用的 Dify DSL 工作流程

https://github.com/svcvit/Awesome-Dify-Workflow?tab=readme-ov-file

比如我随便找了一个

直接就可以使用

3.2.2 workflow使用

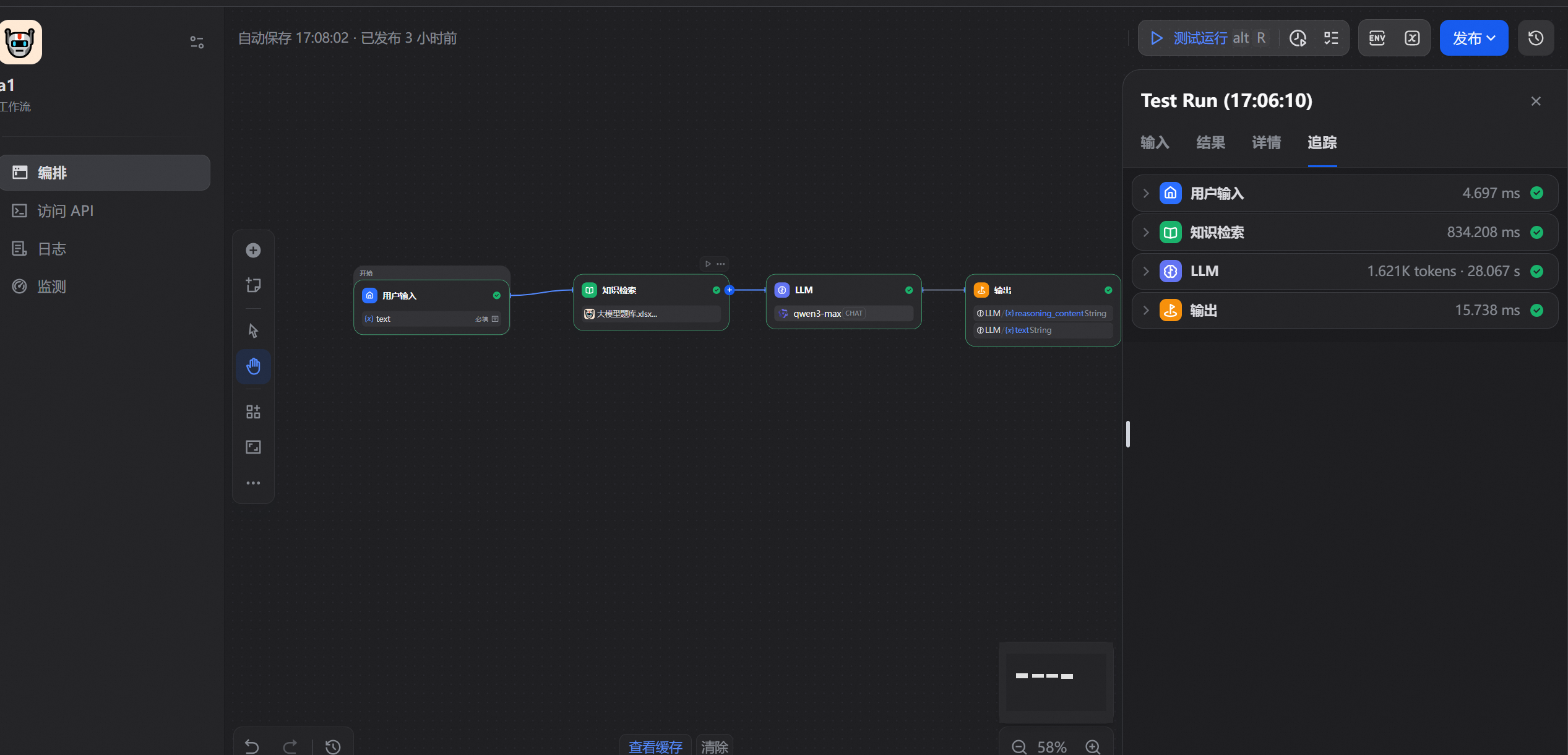

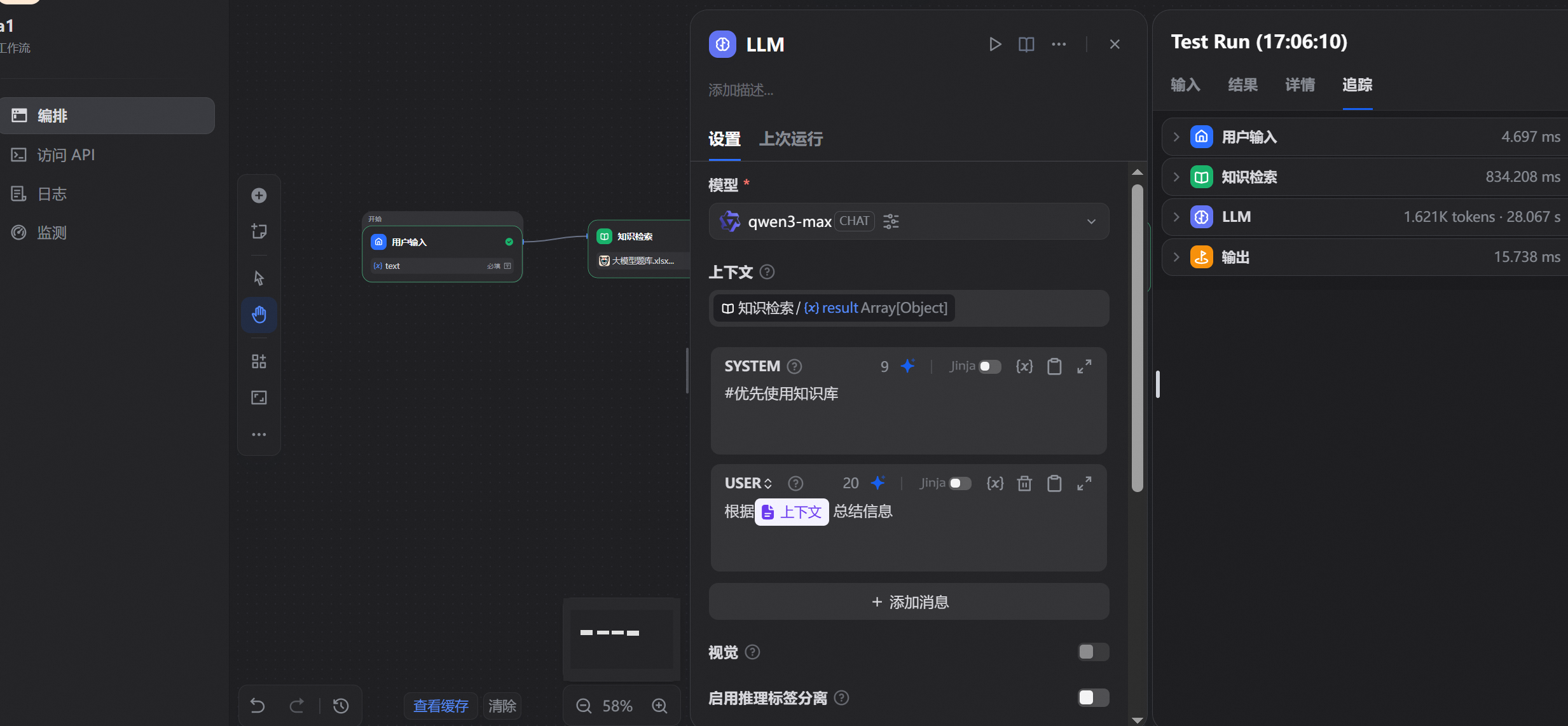

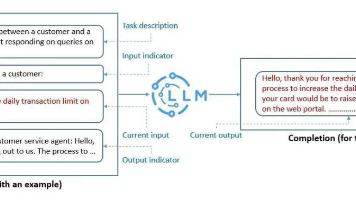

工作流可以理解成一个流水线,安装设定好的配置去跑

简单示例,通过用户输入查询知识库,然后传给大模型输出

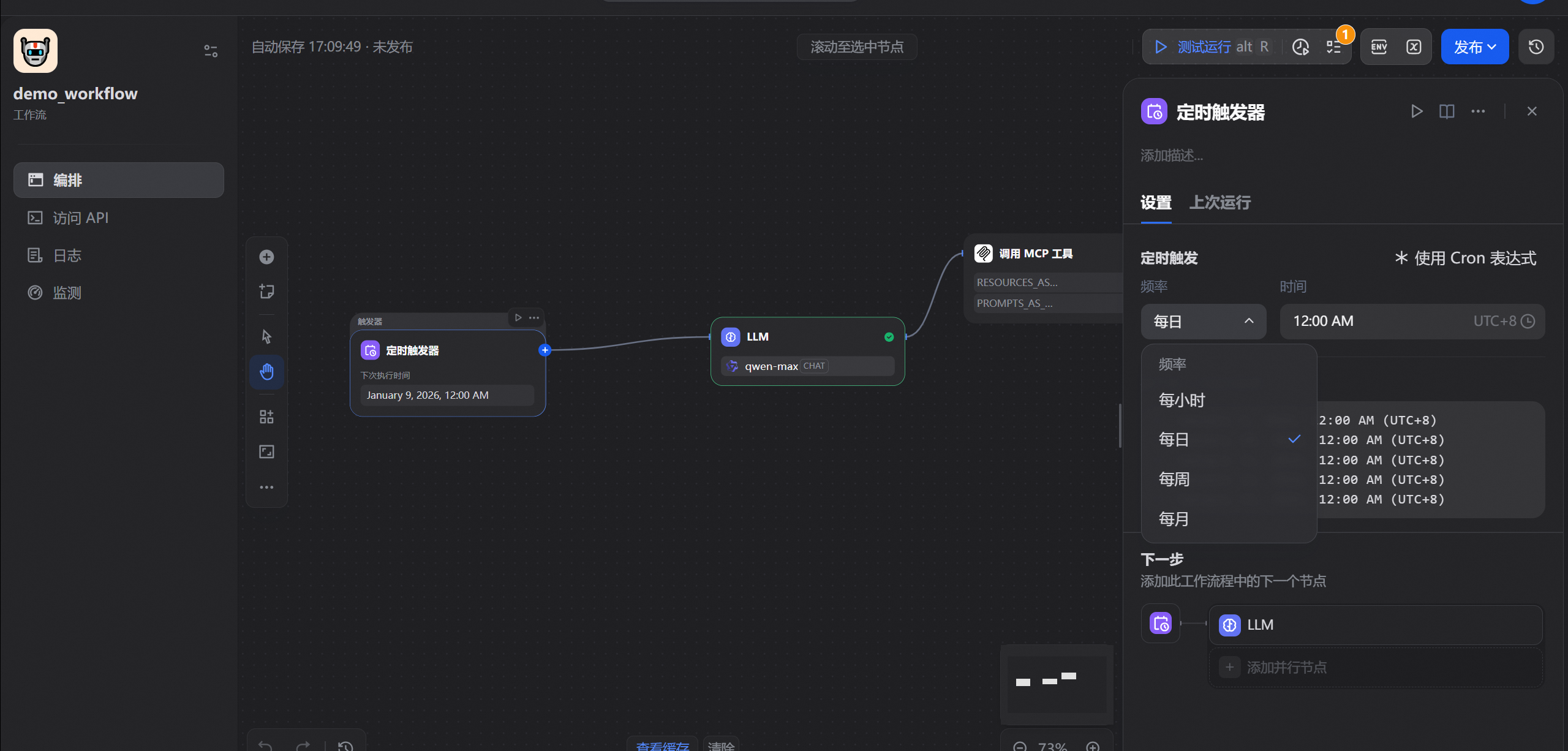

而且有定时触发和webhook触发器,可以很好的完成一些定时复杂任务

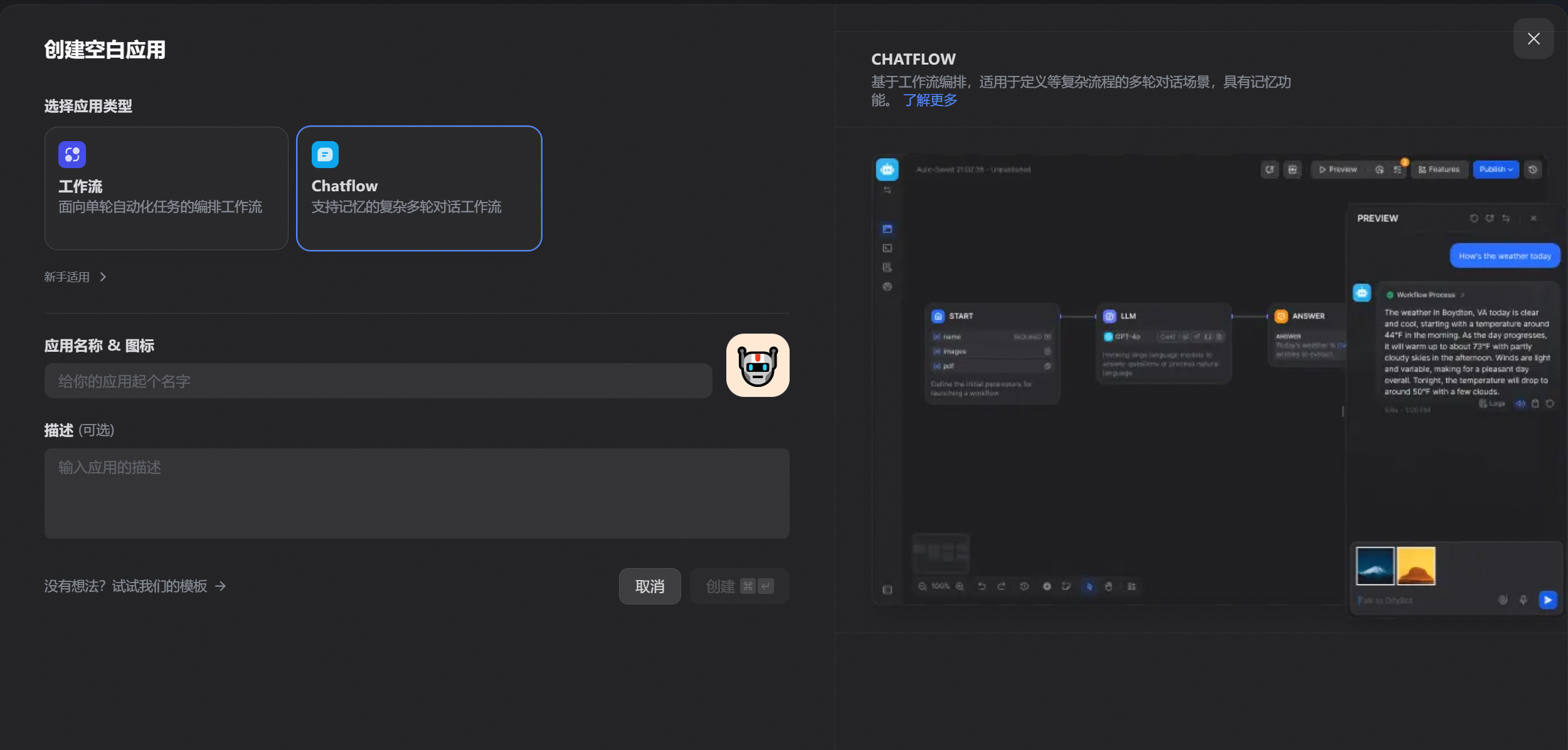

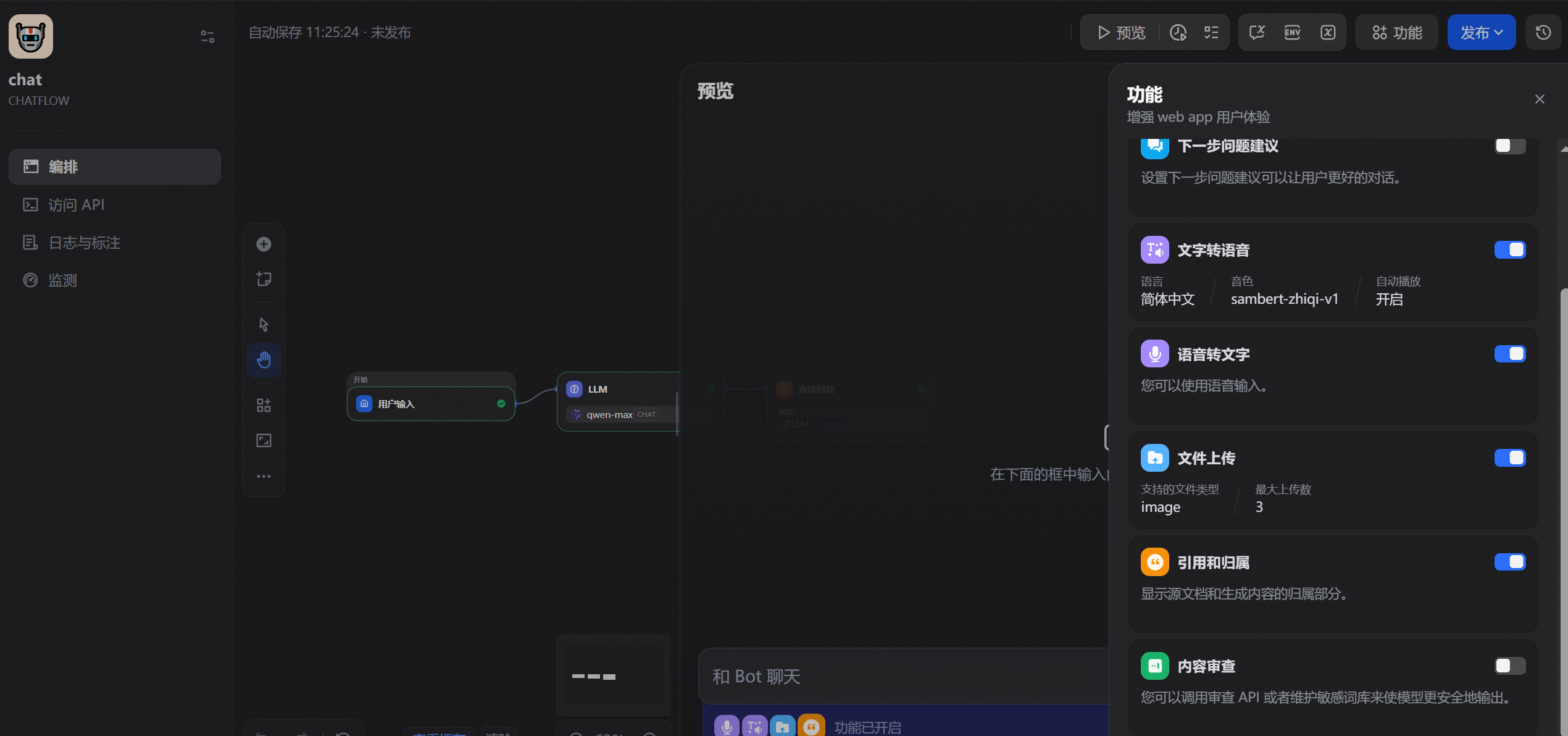

3.2.3 chatflow使用

有点类似于agent智能体,可以通过用户输入去跑工作流

4. 扩展

如果需要自行开发的可以使用LangChain框架

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)