好书推荐|LLM工程实践宝典:《动手构建大模型》详解,从基础到高阶,打造稳定工程系统的完整路线图!

《动手构建大模型》是一部面向生产环境的LLM工程实践指南,聚焦从Demo到生产级系统的完整落地路径。全书分为基础理论、核心技术(Prompt/RAG/框架)和高阶应用(智能体/微调/部署优化)三部分,强调"可用、可控、可评估、可持续演进"的系统设计理念。该书被一线工程师视为可"反复翻、随手查"的实践手册,是帮助开发者真正将大模型能力转化为稳定工程系统的完整路线图。

在大语言模型(Large Language Models,LLMs)从研究热点快速走向产业落地的过程中,业界逐渐形成一个共识:真正的挑战并不在于“是否能够调用模型”,而在于如何将模型能力转化为稳定、可控、可评估、可持续演进的工程系统。在这一背景下,《动手构建大模型》并非一本停留在概念层面的入门读物,而是一部明确以“工程可落地性”为核心目标、系统梳理 LLM 应用全流程的实践型技术书籍,是帮助开发者跨过「Demo 阶段」走向「生产级系统」的完整路线图。

本书英文原名 Building LLMs for Production: Enhancing LLM Abilities and Reliability with Prompting, Fine-Tuning, and RAG,从标题本身便清晰表明了其写作立场:关注的不是“如何训练一个更大的模型”,而是“如何在真实生产环境中构建可用的大模型系统”。中文版由人民邮电出版社引进出版,约 330 页,覆盖从 Transformer 基础到高级 RAG、智能体与部署优化的完整工程链路。

从英文原书到中文版,本书几乎覆盖了当下 AI 工程师所需的全部关键能力:Prompting、RAG、微调、智能体、部署与评估,被不少一线工程师视作可以「反复翻、随手查」的实践手册,而不是读完就束之高阁的理论教材。

一、这本书到底在讲什么?

一句话概括:它是一份面向生产环境的 LLM 端到端工程实践指南,重点解决「可用、可控、可评估、可持续演进」。

1.1 书籍定位

从整体风格来看,《动手构建大模型》显然并不试图成为一本传统意义上的 NLP 教科书,也并未将重点放在复杂的数学推导或模型结构细节上,而是采取了一种在当前阶段更具现实价值的写作策略:以工程实践为主线,将大语言模型视为系统中的核心能力组件,而非孤立存在的算法对象。

作者在行文中始终围绕一个核心问题展开:

当我们将 LLM 引入真实业务场景时,需要补齐哪些工程层面的能力,才能让系统真正“可用”而非“可演示”。

正是在这一问题意识的驱动下,本书在内容取舍上表现出高度一致性和明确的技术判断:凡是直接关系到「系统是否能在生产中稳定运行」的部分,都会被详细展开;而对短期噱头式的流行概念,则保持克制。

1.2 写作风格

与传统的 NLP 教材不同,《动手构建大模型》的写作风格更加注重实用性和工程化。作者在每章开头都详细介绍了该章节的核心内容,同时也会在代码示例中展示实际操作步骤。例如,在介绍 RAG 技术时,作者会先讲解其基本原理,然后展示如何使用 Python 实现一个简单的 RAG 系统。

二、谁应该读这本书?

结合中文版资料与英文原书官方介绍,本书主要面向以下读者群体:

- • 希望系统掌握 LLM 应用开发路径的 Python 开发者与后端工程师;

- • 已在业务中尝试接入大模型,希望从「能跑」走向「好用、可维护、可评估」的 AI 工程师;

- • 关注 LLM 在生产环境落地的高校师生、研究人员与架构师。

英文版官方介绍明确指出,本书尤其适合具备中级 Python 基础、希望构建生产级 LLM 产品的读者。

三、内容结构与学习路径

如果从学习路径和工程成长曲线的角度来看,《动手构建大模型》的目录结构可以被自然地分为三个层次:基础理论篇、核心技术篇与高阶应用篇。读者既可以从头到尾顺序阅读,也可以根据当前项目所处阶段「按需跳读」相关章节。

3.1 基础理论篇:从 LLM 概念到底层架构

基础理论部分主要对应第 1 ~ 3 章:

- • 第 1 章「LLM 简介」 从语言模型简史切入,依次介绍「什么是 LLM」「LLM 由哪些模块构成」,包括 Transformer、语言建模目标、分词、嵌入、训练与微调、预测与上下文窗口、规模法则、提示词与涌现能力等,并通过两个小项目——使用 GPT-3.5 API 做翻译、用小样本学习控制输出——让读者在实践中感受「提示 + 小样本」如何改变模型行为。

- • 第 2 章「LLM 架构和概况」 围绕论文 “Attention Is All You Need” 展开,对编码器–解码器、仅编码器、仅解码器三种 Transformer 结构进行对比,解释 GPT 为什么选择 Decoder-only 架构,并引入 Flamingo、LLaVA 等多模态模型,同时梳理 Cohere、OpenAI、Anthropic、Google DeepMind、Meta、Mistral 等主流模型与生态。

- • 第 3 章「LLM 实践」 则直面幻觉、偏见与评估问题,介绍如何通过控制输出格式、调整解码策略(如温度、Top-k、Top-p 等)来减轻幻觉,并系统梳理困惑度、基准测试等性能评估指标,为后续所有工程实践奠定「如何判断好坏」的客观基准。

这一部分的目标不是让读者记住所有公式,而是帮助你在设计系统时,真正理解每一个技术选择背后的约束与权衡:为什么要控制上下文窗口、为什么要做解码策略实验、为什么不能只看「感觉还不错的 Demo」。

3.2 核心技术篇:Prompt、RAG 与框架工具链

核心技术部分大致对应第 4 ~ 8 章,围绕 Prompting、RAG 以及 LangChain / LlamaIndex 等框架展开,是从「能用 LLM」到「会设计 LLM 应用」的关键跃迁阶段:

- • 第 4 章「提示技术简介」 系统讲解零样本提示、上下文学习与小样本提示、角色提示、链式提示、思维链(Chain-of-Thought)提示等核心技巧,并讨论提示注入与安全问题,帮助读者把「提示工程」从零散技巧提升为一套可复用的方法论。

- • 第 5 章「RAG」 从「为什么单靠模型参数不够」出发,带领读者从头构建一个 RAG 管道:数据预处理、文档切分、生成嵌入、向量检索、余弦相似度计算、提示增强等,真正理解「检索 + 生成」系统中的每一个工程环节。

- • 第 6 章「LangChain 和 LlamaIndex 简介」 在完整讲透 RAG 基础后,引入 LangChain、LlamaIndex 等框架,展示如何用它们快速搭建新闻摘要器、问答系统等应用,并解释数据连接器、节点、索引、查询引擎、路由器等概念,使读者在接触框架时不会被抽象概念淹没。

- • 第 7 章「使用 LangChain 进行提示」 进一步深入 LangChain 的提示模板、小样本提示、样例选择器、链与记忆管理,通过输出解析器、知识图谱构建等项目,让读者体验如何将 Prompting、结构化输出与下游系统真正打通。

- • 第 8 章「索引、检索与数据预处理」 则把视角拉回数据层面,讲解 PDF / 网页 / Google Drive 等多源数据的摄取、文本切分策略(按长度、按逻辑终点、按语言工具、按 Markdown、按 Token)、相似性搜索与开源 / 付费嵌入模型,并通过客服问答机器人、YouTube 视频摘要器、语音助手等项目,将索引、检索、安全控制串成完整场景。

这一部分的实践密度非常高,配套的 Colab Notebook 让读者可以「开箱即练」,从而把抽象的 LLM 概念沉淀为可复用的代码片段和工程模板。

3.3 高阶应用篇:高级 RAG、智能体、微调与部署优化

高阶应用部分集中在第 9 ~ 12 章,面向已经完成基础与核心技术学习、希望真正把 LLM 引入复杂业务系统的读者:

- • 第 9 章「高级 RAG」 重点讨论从概念验证到产品化过程中 RAG 系统面临的挑战,引入基于 LlamaIndex 的高级检索技术,包括嵌入模型与 LLM 微调、混合检索、查询构建与扩展、查询转换、重排序、递归检索与从小到大的检索逻辑,以及 RAG / 检索评估指标与 LangSmith 等评估工具。

- • 第 10 章「智能体」 将大模型视为推理引擎,介绍 AutoGPT、BabyAGI、LangChain 智能体仿真项目、分析报告生成智能体、数据库对话型智能体、OpenAI Assistants、LangChain OpenGPTs 以及多模态财务分析等完整案例,帮助读者理解「多轮推理 + 工具调用」如何在真实业务中创造增量价值。

- • 第 11 章「微调」 从理解微调与 LoRA 入手,通过 SFT、LoRA、金融情感分析、医疗场景 Cohere LLM 微调与 RLHF 项目,完整串起数据准备、参数高效微调、奖励模型训练与强化学习优化的闭环,让读者真正体验「从通用模型到领域模型」的工程路径。

- • 第 12 章「部署与优化」 则落脚在最容易被忽略、却决定系统成败的环节:模型蒸馏、量化、剪枝、投机解码、在谷歌云平台 CPU 上部署量化模型以及在云服务商上部署开源 LLM,完整覆盖从成本、延迟到可维护性的多重权衡。

可以说,如果你正准备把一个原型级别的 LLM 应用推向生产环境,高阶应用篇几乎把你会遇到的每一种典型挑战都提前拆解了一遍。

四、工程师视角下的三个高价值模块

这一节从工程师日常决策的角度,抽出三块最值得重点投入的能力:打牢认知地基、把模型能力升级为系统能力,以及在真实生产环境中做性能与成本的平衡取舍。

4.1 认知地基:理解能力边界与工程约束

基础理论篇在本书中扮演「认知地基」的角色。它的价值在于并不追求穷举所有细节,而是筛选出对工程实践具有长期影响的关键概念:Transformer 架构、Decoder-only 设计选择、上下文窗口与解码策略、规模法则与涌现能力,以及「为什么必须评估」等核心问题。这些内容帮助读者在做系统设计时,用“约束与权衡”的视角替代“盲试与碰运气”。

4.2 系统能力:用 Prompt 与 RAG 把模型能力变成可控能力

在当前 LLM 应用实践中,Prompt Engineering 与 RAG 已经成为事实上的基础设施。本书的特点在于,它没有把它们写成“技巧集合”,而是始终把 Prompt、检索、切分、重排序、输出结构化与评估放在同一个系统语境里讨论,强调建立可复用的方法论与工程闭环,避免停留在「感觉效果不错」的经验主义。

4.3 生产化能力:框架、微调、智能体与部署的多维权衡

在工具与框架层面,本书系统介绍 LangChain、LlamaIndex 等能力组件,同时明确强调框架的价值在于加速搭建,而不是替代工程思考。进一步地,微调、智能体与部署优化相关章节把问题放回到生产的现实约束中:性能、成本、稳定性与可维护性需要同时被度量与权衡;技术选型应服务系统目标,而不是追求形式上的先进性。

五、怎么读这本书?

这一节更偏「使用说明」,帮你根据自己的背景与项目阶段,快速选出一条合适的阅读路径,而不是从头到尾机械通读。

5.1 从零到一建立全景认知(新接触 LLM 应用)

- • 建议按顺序读第 1 ~ 8 章,先把「基础原理 → Prompt → RAG → 框架」贯通。

- • 在跑通配套项目后,再回到第 3 章与第 5 章复盘评估与失败模式,把“能跑”升级为“可解释、可迭代”。

5.2 重点补齐 RAG 与评估(已有 API Demo,要做生产化)

- • 快速浏览第 1 ~ 3 章后,重点研读第 5、8、9 章,把数据摄取、切分、检索、重排序与评估串成闭环。

- • 将书中的一套评估口径迁移到你的业务指标里,确保改动有可对比的收益基线。

5.3 走向高阶场景(智能体 / 微调 / 部署优化)

- • 智能体方向重点读第 10 章,把「工具调用 + 多轮推理」与安全控制、失败模式一起考虑。

- • 微调方向重点读第 11 章,按书中路径完成数据准备、参数高效微调与效果评估的闭环。

- • 部署与优化方向重点读第 12 章,从量化、蒸馏到云端部署,把延迟与成本纳入同一套决策框架。

六、国际口碑与读者反馈

从行业专家推荐到读者评分数据,这本书在海外社区已经积累了比较稳定的好评。一方面,深度参与 LLM 生态的一线工程师与研究者给出了高强度背书;另一方面,读书平台上的评分、长评和「正在阅读 / 想读」等行为数据,也侧面印证了它作为工程实战教材的受欢迎程度。

6.1 行业专家与企业工程师评价

- • LlamaIndex 联合创始人兼 CEO Jerry Liu 将其称为“迄今为止关于构建 LLM 应用最全面的教材之一”,强调覆盖 Prompting、RAG、智能体、微调与部署等核心主题。

- • Weights & Biases AI 布道者 Alex Volkov 等推荐者强调本书从理论到代码、从研究趋势到框架实践的覆盖范围,适合建立对现代 LLM 生态的整体直觉。

- • Meta 数据工程师 Shashank Kalanithi 认为本书是“良好的参考指南”,并肯定其对复杂概念的深入浅出讲解。

- • Serrano.Academy 创始人 Luis Serrano 强调本书包含详细概念解释与实例代码,能帮助读者更快使用与部署 LLM,并提升其性能。

- • 蒙特利尔学习算法研究所高级应用研究科学家 Jeremy Pinto 评价本书“以实用为导向”,在理论知识与应用知识之间取得平衡,适合希望高效掌握相关知识的读者。

- • The Neuron 联合创始人 Pete Huang 指出本书从基础到编程实践再到现代框架应用循序渐进,并帮助读者理解研究趋势与框架分析。

- • Learn Prompting 创始人兼 CEO Sander Schulhoff 表示其对本书的全面性感到惊叹,并认为其整合了生成式 AI 应用实践者所需的关键技术资源。

- • DataLemur 网站创始人 Nick Singh 认为本书对 LLM 落地过程中遇到的实际问题做了深入分析,并提供了多种解决方案。

6.2 平台数据与读者评价

- • 在 Goodreads / Amazon 等平台上,英文版整体评分处于 4 星以上区间,评论中高频出现的关键词集中在「结构清晰」「案例实用」「适合作为经常翻阅的参考工具」,整体反馈更偏向「工程实用性」而非纯概念介绍。

七、 总结

综合来看,《动手构建大模型》是一部立场明确、结构完整、工程取向清晰的大语言模型实践指南。它不追求浮夸的「一夜精通」,而是通过扎实而系统的内容组织,帮助读者逐步建立对 LLM 应用工程的整体认知框架,并在真实项目中不断迭代验证。

对于希望真正将大模型能力引入实际系统、并愿意为此进行深入思考与工程投入的读者而言,这本书无疑是一部值得反复阅读、长期放在桌边的工程实战「总纲」——当你在项目中遇到关于架构、RAG 设计、微调方案或部署优化的关键抉择时,翻开相应章节,往往都能找到一条相对稳妥、可操作的思路。

最后唠两句

为什么AI大模型成为越来越多程序员转行就业、升职加薪的首选

很简单,这些岗位缺人且高薪

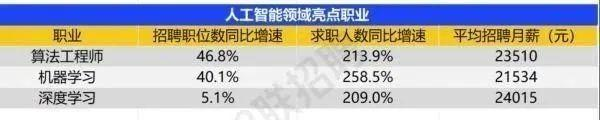

智联招聘的最新数据给出了最直观的印证:2025年2月,AI领域求职人数同比增幅突破200% ,远超其他行业平均水平;整个人工智能行业的求职增速达到33.4%,位居各行业榜首,其中人工智能工程师岗位的求职热度更是飙升69.6%。

AI产业的快速扩张,也让人才供需矛盾愈发突出。麦肯锡报告明确预测,到2030年中国AI专业人才需求将达600万人,人才缺口可能高达400万人,这一缺口不仅存在于核心技术领域,更蔓延至产业应用的各个环节。

那0基础普通人如何学习大模型 ?

深耕科技一线十二载,亲历技术浪潮变迁。我见证那些率先拥抱AI的同行,如何建立起效率与薪资的代际优势。如今,我将积累的大模型面试真题、独家资料、技术报告与实战路线系统整理,分享于此,为你扫清学习困惑,共赴AI时代新程。

我整理出这套 AI 大模型突围资料包【允许白嫖】:

-

✅从入门到精通的全套视频教程

-

✅AI大模型学习路线图(0基础到项目实战仅需90天)

-

✅大模型书籍与技术文档PDF

-

✅各大厂大模型面试题目详解

-

✅640套AI大模型报告合集

-

✅大模型入门实战训练

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(0基础到项目实战仅需90天)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤640套AI大模型报告合集

⑥大模型入门实战训练

如果说你是以下人群中的其中一类,都可以来智泊AI学习人工智能,找到高薪工作,一次小小的“投资”换来的是终身受益!

应届毕业生:无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型:非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能 突破瓶颈:传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

👉获取方式:

有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献448条内容

已为社区贡献448条内容

所有评论(0)