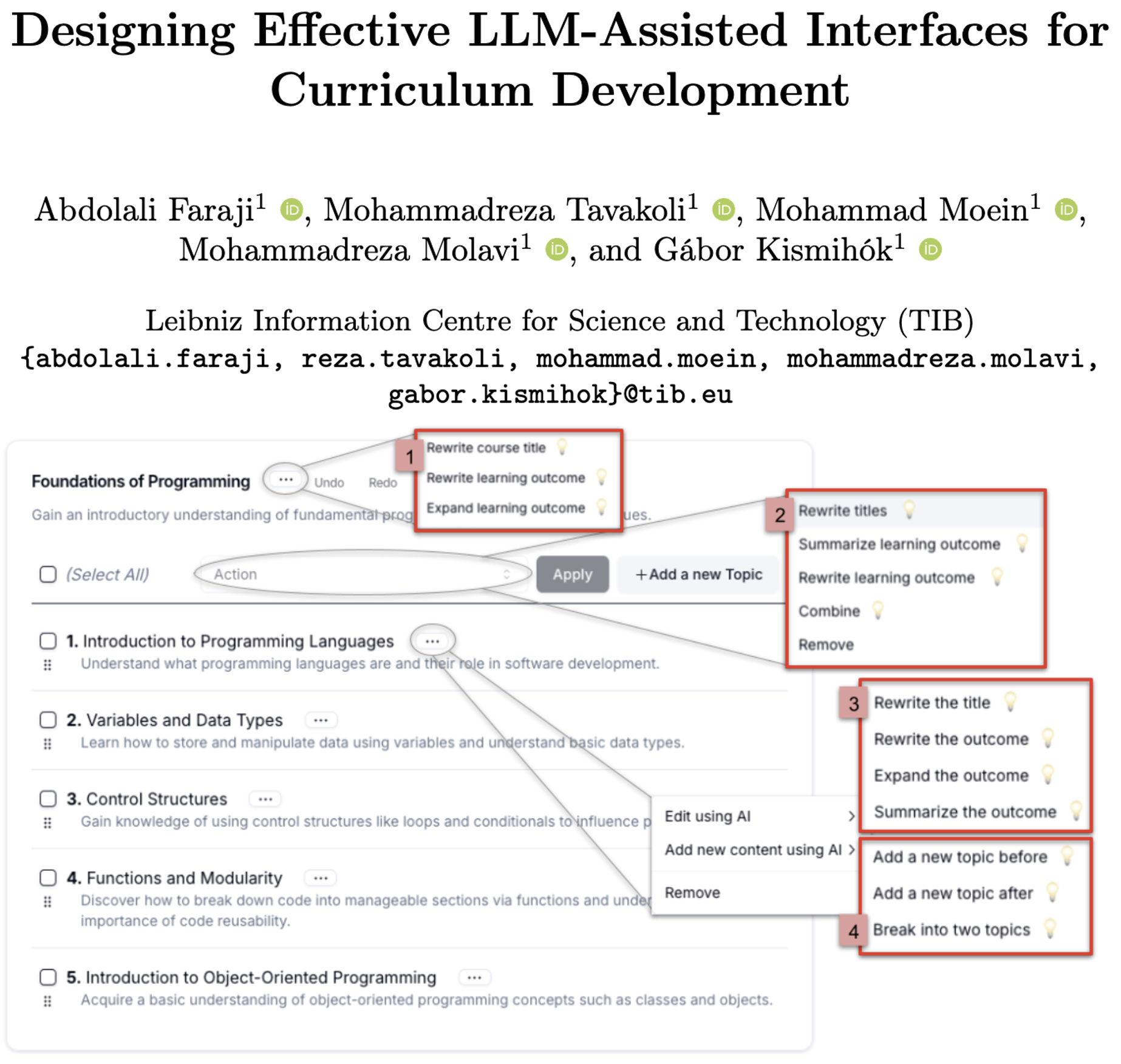

论文阅读:AIED 2025 Designing Effective LLM-Assisted Interfaces for Curriculum Development

该研究聚焦LLM辅助课程开发的界面设计挑战,提出两种基于直接操作(DM)原则的新型UI(UI Predefined和UI Open),以解决传统文本界面依赖复杂提示工程、认知负荷高的问题。通过20名不同教育背景参与者的对照实验,将其与标准ChatGPT界面(通过open-webui模拟)在可用性(SUS)和认知负荷(NASA RTLX)方面对比,结果显示UI Predefined显著优于其他两者(

总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://link.springer.com/chapter/10.1007/978-3-031-98414-3_31

https://arxiv.org/pdf/2506.11767

https://www.doubao.com/chat/35355062882701058

论文集下载:https://download.csdn.net/download/WhiffeYF/92543315

速览

1. 一段话总结

该研究聚焦LLM辅助课程开发的界面设计挑战,提出两种基于直接操作(DM)原则的新型UI(UI Predefined和UI Open) ,以解决传统文本界面依赖复杂提示工程、认知负荷高的问题。通过20名不同教育背景参与者的对照实验,将其与标准ChatGPT界面(通过open-webui模拟)在可用性(SUS)和认知负荷(NASA RTLX)方面对比,结果显示UI Predefined显著优于其他两者(SUS得分86.75,NASA RTLX均值2.25),兼具高可用性和低任务负荷;UI Open虽灵活性更高,但存在陡峭学习曲线,而两种新型UI均通过人机协作模式降低了LLM输出不准确的伦理风险,为教育工作者与LLM的高效交互奠定了基础。

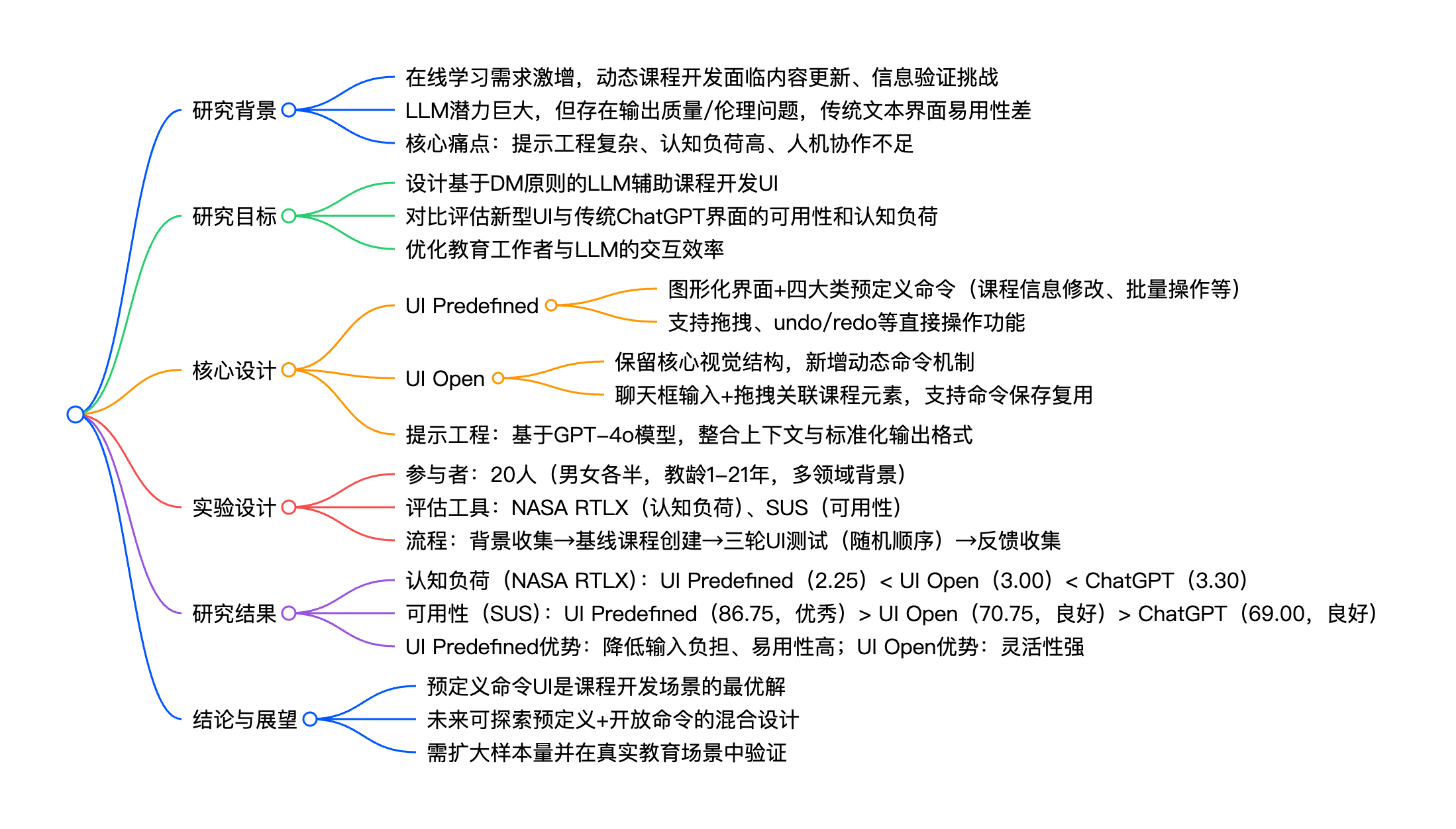

2. 思维导图

## 研究背景

- 在线学习需求激增,动态课程开发面临内容更新、信息验证挑战

- LLM潜力巨大,但存在输出质量/伦理问题,传统文本界面易用性差

- 核心痛点:提示工程复杂、认知负荷高、人机协作不足

## 研究目标

- 设计基于DM原则的LLM辅助课程开发UI

- 对比评估新型UI与传统ChatGPT界面的可用性和认知负荷

- 优化教育工作者与LLM的交互效率

## 核心设计

- UI Predefined

- 图形化界面+四大类预定义命令(课程信息修改、批量操作等)

- 支持拖拽、undo/redo等直接操作功能

- UI Open

- 保留核心视觉结构,新增动态命令机制

- 聊天框输入+拖拽关联课程元素,支持命令保存复用

- 提示工程:基于GPT-4o模型,整合上下文与标准化输出格式

## 实验设计

- 参与者:20人(男女各半,教龄1-21年,多领域背景)

- 评估工具:NASA RTLX(认知负荷)、SUS(可用性)

- 流程:背景收集→基线课程创建→三轮UI测试(随机顺序)→反馈收集

## 研究结果

- 认知负荷(NASA RTLX):UI Predefined(2.25)< UI Open(3.00)< ChatGPT(3.30)

- 可用性(SUS):UI Predefined(86.75,优秀)> UI Open(70.75,良好)> ChatGPT(69.00,良好)

- UI Predefined优势:降低输入负担、易用性高;UI Open优势:灵活性强

## 结论与展望

- 预定义命令UI是课程开发场景的最优解

- 未来可探索预定义+开放命令的混合设计

- 需扩大样本量并在真实教育场景中验证

3. 详细总结

一、研究背景与问题提出

- 在线学习与课程开发现状:在线学习因灵活性、时效性成为现代教育核心,但动态课程更新需消耗教师大量时间,且网络资源质量参差不齐,导致课程准确性与相关性难以保障。

- LLM的潜力与局限:LLM为动态课程开发提供新可能,但存在两大关键问题:①输出质量风险(不准确、伦理争议);②交互界面问题(传统文本界面依赖复杂提示工程,存在间接参与、语义距离等挑战,认知负荷高)。

- 研究核心需求:需设计用户友好的LLM界面,基于直接操作(DM)原则优化人机协作,降低提示工程依赖,平衡可用性与灵活性。

二、相关研究基础

| 研究领域 | 核心发现 | 局限性 |

|---|---|---|

| AI辅助课程开发 | 传统机器学习(LDA、随机森林)可推荐学习主题,但局限于特定教育领域 | 未结合LLM的泛化能力,缺乏用户友好界面 |

| LLM界面设计 | DirectGPT、SPROUT等工具通过可视化/功能优化提升交互效率 | 未针对课程开发场景定制,通用性强但针对性不足 |

| 人机交互(HCI) | DM原则(连续对象表征、物理操作、可逆反馈、直观操作)可解决命令行界面痛点 | 尚未系统应用于LLM辅助课程开发场景 |

三、研究设计与方法

- 界面设计(基于DM四大原则)

- UI Predefined:

- 布局:图形化界面,课程大纲以交互式表格呈现(DM1:连续对象表征);

- 功能:四大类预定义命令(课程信息修改、批量操作、单主题优化、内容生成),支持拖拽排序、直接编辑、undo/redo(DM2-4:物理操作、可逆反馈、直观操作);

- 优势:无需手动输入提示,降低认知负荷。

- UI Open:

- 布局:保留UI Predefined核心视觉结构,底部新增聊天框(DM1);

- 功能:支持动态命令输入,可拖拽课程元素关联命令(局部/全局应用),支持命令保存复用(DM2-3);

- 优势:灵活性高,适配个性化需求。

- 提示工程:采用GPT-4o-2024-08-06模型,系统提示定义LLM角色、任务边界与输出格式,确保上下文关联性与结果一致性。

- UI Predefined:

- 对照工具:使用open-webui模拟ChatGPT界面(控制组),保证模型一致性与交互可监测性。

- 实验设计

- 参与者:20人,男女各10名,教龄1-21年,覆盖计算机科学、数学、护理等多领域,ChatGPT熟悉度从低到高不等;

- 评估指标:

- 认知负荷:NASA RTLX(含心理需求、物理需求等6个维度,得分越低负荷越小);

- 可用性:SUS(满分100,≥80为优秀,68-79为良好);

- 实验流程:①10分钟研究介绍→②5分钟背景信息收集→③30分钟基线课程大纲创建→④3轮UI测试(每轮30分钟,UI顺序随机,含20分钟操作+10分钟问卷)→⑤5分钟最终反馈。

四、研究结果

- 认知负荷对比(NASA RTLX)

| 界面类型 | 平均得分 | 与ChatGPT差值 | 统计显著性 |

|---|---|---|---|

| UI Predefined | 2.25 | -1.05 | p<0.03 |

| UI Open | 3.00 | -0.30 | 不显著 |

| ChatGPT(对照) | 3.30 | - | - |

| 注:Performance维度已转换为Performance⁻¹(8-原始得分),统一得分越低表现越好。 |

- 可用性对比(SUS)

| 界面类型 | 平均得分 | 评级 | 与ChatGPT差值 | 统计显著性 |

|---|---|---|---|---|

| UI Predefined | 86.75 | 优秀 | +17.75 | p<0.009 |

| UI Open | 70.75 | 良好 | +1.75 | 不显著 |

| ChatGPT(对照) | 69.00 | 良好 | - | - |

- 定性反馈:

- UI Predefined:8名参与者认可其降低输入负担,10名强调易用性;

- UI Open:获灵活性相关正面评价,但参与者反映学习曲线较陡;

- 共同需求:所有参与者认为命令复用、输出可视化是关键优化点。

五、结论与展望

- 核心结论:①UI Predefined在可用性和认知负荷上显著优于传统ChatGPT界面,是课程开发场景的最优解;②UI Open虽灵活性更高,但因学习曲线问题未形成统计显著优势;③基于DM原则的界面设计可有效降低LLM交互门槛,人机协作模式能缓解输出质量风险。

- 研究局限:①实验环境为受控场景,与真实教育场景存在差异;②参与者数量有限(20人),虽覆盖多领域但代表性仍需提升。

- 未来方向:①探索“预定义命令+开放命令”的混合UI设计;②扩大参与者样本量,纳入更多教育场景测试;③研究UI设计对学习效果的间接影响。

4. 关键问题

问题1:两种新型UI(UI Predefined和UI Open)的核心设计差异是什么?各自适配什么样的教育工作者需求?

答案:核心差异在于命令交互模式与灵活性-易用性的权衡:①UI Predefined采用“图形化界面+预定义命令库”(四大类固定命令),支持拖拽、直接编辑等可视化操作,无需手动输入提示,适配追求高效、低学习成本的教育工作者,尤其适合快速完成标准化课程大纲优化;②UI Open保留核心视觉结构,新增动态聊天框输入,支持命令自定义、拖拽关联课程元素及复用,适配有个性化需求(如特殊课程主题、定制化修改逻辑)的教育工作者,但需投入时间学习命令设计。

问题2:实验中三种界面(UI Predefined、UI Open、ChatGPT)的可用性和认知负荷表现如何?关键数据差异是什么?

答案:①可用性(SUS):UI Predefined以86.75分(优秀)显著领先,UI Open(70.75分)与ChatGPT(69.00分)均为良好但无显著差异,前两者较ChatGPT分别高出16.00分和1.75分;②认知负荷(NASA RTLX):UI Predefined以2.25分(最低)表现最优,UI Open(3.00分)次之,ChatGPT(3.30分)负荷最高,UI Predefined较ChatGPT降低1.05分(p<0.03),差异具有统计显著性,而UI Open与ChatGPT的差异不显著。

问题3:该研究提出的LLM辅助课程开发界面设计,如何解决传统LLM交互在教育场景中的核心痛点?

答案:传统LLM交互的核心痛点是“提示工程复杂”“认知负荷高”“输出质量难把控”,解决方案如下:①通过DM原则设计简化交互:采用图形化界面、物理操作(拖拽、点击)替代文本提示,解决间接参与、语义距离等问题,降低认知负荷;②分场景优化灵活性与易用性:预定义命令覆盖标准化需求,开放命令支持个性化需求,平衡效率与适配性;③人机协作保障质量:界面设计预留人类审核环节,LLM输出仅作为辅助,结合教师专业判断,缓解输出不准确、伦理争议等风险,确保课程内容符合教育标准。

更多推荐

已为社区贡献79条内容

已为社区贡献79条内容

所有评论(0)