AI时代的人才悖论:为什么你的985学历团队在ChatGPT面前集体“失灵

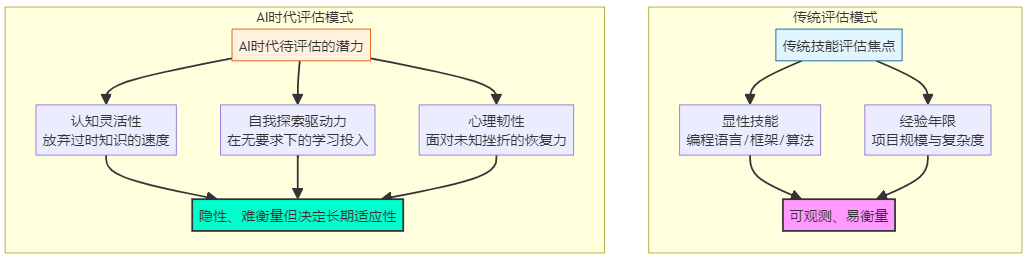

技术行业正面临AI变革带来的认知重构阵痛。传统人才选拔体系在AI时代暴露出三大缺陷:学历崇拜的认知陷阱、经验主义的时效性危机和显性技能评估的片面性。本文提出学习敏捷性作为AI时代人才核心标准,包括认知灵活性、自我驱动探索欲、抽象能力和心理韧性四大支柱,并给出识别和培养敏捷人才的方法论:通过数字足迹分析、场景化压力测试和行为模式分析选拔人才,同时构建学习型组织文化,建立安全失败机制和制度化探索时间。

开篇:始于一次真实的“降维打击”

76%的技术管理者正在经历“团队适应性焦虑”。 一个典型的场景是:某头部互联网公司(如阿里巴巴)的核心算法推荐团队,其成员清一色拥有985/211名校硕士及以上学历,在传统的搜索与推荐模型领域建树颇丰。然而,随着GPT系列及代码生成工具(如GitHub Copilot)的普及,团队内部出现了微妙而深刻的分裂。那些习惯于深耕TensorFlow、精心调参的资深工程师,在面对只需自然语言描述需求、就能生成80%基础代码的AI工具时,感到了前所未有的价值冲击。与此同时,几位非顶尖院校出身、但对AI工具抱有狂热好奇心的年轻工程师,却迅速将这些工具融入工作流,将部分重复性开发任务的效率提升了300%。项目经理发现,以往代表“可靠性”的资历与学历,在评估“谁能更快拥抱未来”时,突然成了一种沉默的负债。

这个现象揭示了一个尖锐的悖论:我们曾赖以成功的、基于高学历和深厚经验的传统人才选拔体系,在AI带来的指数级技术变革面前,正在系统性失灵。 这并非个例,而是整个技术行业正在经历的“认知重构”阵痛。

第一部分:系统性诊断——传统选拔体系的三大致命缺陷

当技术的半衰期从五年缩短至十八个月,我们评价人才的“尺子”却还停留在工业时代。问题的根源不在于人,而在于体系。

缺陷一:学历崇拜的认知陷阱——“向后看”的惯性

名校学历,本质上是对过去某个阶段标准化学习能力的认证。它衡量的是个体在确定性规则下的应试与记忆效能。然而,AI时代,尤其是生成式AI的崛起,首先瓦解的正是“记忆知识”的稀缺性价值。

- 理论支撑:库伯的学习圈理论。大卫·库伯提出,有效的学习是一个从具体经验,到反思观察,再到抽象概念化,最后主动实验的循环过程。传统教育体系强于“抽象概念化”(理论学习),却普遍弱化了“主动实验”(探索应用)环节,而后者恰恰是适应未知技术的核心。

- 数据印证:领英2023年的一份内部研究显示,在快速掌握并创造性使用ChatGPT、Midjourney等工具的早期使用者中,其专业背景与最终产出效果的相关性仅为0.2,而个人项目驱动的探索经历则显示出0.6以上的强相关性。学历与适应性之间存在一种微妙的“摩擦系数”。

- 对比分析:

|

评估维度 |

传统学历标准 |

AI时代所需标准 |

主要矛盾 |

|

能力指向 |

掌握已知知识体系 |

探索未知可能性 |

确定性 vs 不确定性 |

|

验证方式 |

标准化考试(有唯一解) |

开放式项目(有多解或未知解) |

收敛思维 vs 发散思维 |

|

时效性 |

反映历史成绩 |

预测未来潜力 |

静态标签 vs 动态能力 |

缺陷二:经验主义的时效性危机——当“十年经验”可能只是“一年经验重复十次”

在技术范式稳定期,经验是应对复杂问题的宝贵资产。但在范式迁移期,过时的经验可能成为认知的枷锁。一位拥有十年某特定框架(如Struts)开发经验的专家,在面对全新范式(如Serverless)时,其转型难度可能远大于一张白纸的新人,因为他需要先完成痛苦的“认知卸载”。

案例研究:某大厂云原生转型中的阵痛

1)背景与挑战:

- 关键数据:公司计划在2年内将70%的核心业务迁移至云原生架构。一个由15名平均司龄8年、主导过多次成功系统重构的资深中间件团队被委以重任。

- 核心矛盾:团队习惯于基于物理机的“稳、准、狠”的运维与调试思维,对容器化、声明式API、不可变基础设施等云原生理念存在本能的排斥与理解障碍。

2)解决方案:

步骤1(工具:四象限分析法诊断):管理者运用四象限从四个维度分析团队困境:

- 能力:具备强大的Java底层和复杂系统调试能力。

- 动机:出于对稳定性的执着和对未知风险的担忧,转型内在动机弱。

- 资源:拥有大量历史经验文档,但缺乏云原生的一手实践环境与学习时间。

- 机遇:公司全力支持转型,提供了充分的预算和外训机会。

步骤2(工具:强制性“新手体验”与结对编程):要求每位资深工程师与一名已熟悉K8s的年轻工程师结对,在隔离环境中从头搭建一个微服务并完成部署、监控全流程,强制性切换为“新手”视角。

3)实施成果:

- 直接效果:项目初期的技术决策效率提升了40%,因“想当然”基于旧经验导致的架构返工减少了60%。

- 长期价值:团队成功构建了混合型知识结构,并将这次“受挫-学习”过程沉淀为组织应对技术范式的迁移方法论。

缺陷三:显性技能评估的片面性——我们只测试了“冰山上的一角”

传统面试聚焦于算法题、系统设计题,这些都是“已知问题域”内的解决方案竞赛。AI时代,越来越多的问题属于“未知问题域”(例如:如何用大模型提升现有客服系统的智能水平?)。此时,比“解决问题能力”更底层的是“定义和探索问题”的能力。

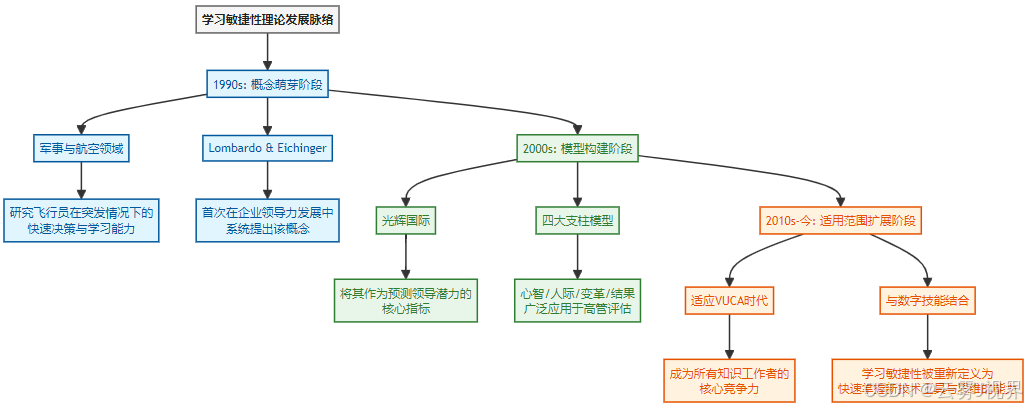

第二部分:理论重构——学习敏捷性:被低估的核心货币

如果说工业时代的人才资本是“知识存量”,那么AI时代的人才资本就是“知识流量的速度与方向”。这被定义为 “学习敏捷性” —— 个体在陌生、高挑战性情境下,快速学习并应用新知识以获得高绩效的能力。其理论演化脉络如下:

基于技术领域的特点,我们将技术人才的学习敏捷性解构为四大支柱:

支柱一:认知灵活性——勇于“杀死”昨天的自己

这不仅是学习新东西,更是主动卸载过时知识的能力。具备此特质的人,看待技术争议(如“微服务与单体架构之争”)时,较少陷入信仰般的站队,而是能基于具体场景分析优劣。评估时,可以观察候选人对“自己曾深信不疑但后来被证明是错误的技术观点”的反思深度。

支柱二:自我驱动的探索欲——内在动机的引擎

外在激励(如KPI)只能驱动常规任务。面对AI这种模糊、前沿的工具,唯有强大的好奇心与内在探索欲才能持续驱动深度学习。GitHub上的个人项目、持续更新的技术博客,其价值不在于stars或阅读量,而在于它们是否展现了一个持续进化的、由兴趣驱动的学习轨迹。

支柱三:化繁为简的抽象能力——提示词背后的元能力

AI工具的效能,尤其是大语言模型,极大程度上取决于使用者提出问题的能力(提示词工程)。这本质上是将模糊意图抽象为结构化、可执行逻辑链的能力。一个优秀的测试是:给候选人一份某新兴领域(如“量子计算”)的混乱资料,观察其能否在短时间内绘制出一幅清晰的概念关联图,并指出学习路径。这正是一门小型“提示词工程”。

# 示例:评估抽象能力的简单代码任务(从具体到抽象)

# 任务:面对一个需求“让用户感觉这个应用很智能”,缺乏经验的工程师可能直接开始编码复杂的规则。

# 而具备高抽象能力的工程师,会先将其分解为可衡量的子目标:

def deconstruct_intelligent_feeling():

# 1. 信息预见性

subgoal_1 = "预测用户下一步操作,并提前加载资源 (Predictive Loading)"

# 2. 交互自然度

subgoal_2 = "实现基于自然语言的模糊搜索与对话式引导 (NLQ & Conversational UI)"

# 3. 界面自适应

subgoal_3 = "根据用户使用习惯,动态调整主界面布局或信息密度 (Adaptive UI)"

# 4. 异常自处理

subgoal_4 = "对常见错误进行静默修复或提供一键解决方案 (Self-healing)"

subgoals = [subgoal_1, subgoal_2, subgoal_3, subgoal_4]

# 然后,针对每个子目标,再去评估技术可行性及优先级

return subgoals支柱四:抗挫折的心理韧性——在“专家”与“新手”身份间自由切换

学习新范式意味着短期内从“专家”退回“新手”,产出下降、错误频出。心理韧性决定了这个“学习凹地”的深度和时长。在面试中,可以请候选人详细描述一次“技术上的重大失败或判断失误”,重点聆听其归因方式(是归咎于外部,还是能客观分析自身认知局限)以及后续的补救和学习行动。

第三部分:实战方法论——构建你的敏捷人才识别体系

识别学习敏捷性,需要超越简历和常规面试,进入更深层的行为与模式观察。

方法一:数字足迹的深度解码(MECE原则下的全景扫描)

运用MECE原则,相互独立且完全穷尽地分析候选人在公开技术平台上的痕迹:

- GitHub:不仅看Star数。深挖Commit记录:是修复他人bug为主,还是发起新特性或项目?README是否清晰体现了项目的演进思考和设计取舍?

- Stack Overflow/技术社区:看提问的质量。是经过充分搜索和思考后的精准提问,还是草率的“伸手党”?回答问题是复制粘贴,还是融入了自己的理解和扩展?

- 技术博客/社交媒体:关注其知识更新的“频率曲线”和“主题迁移路径”。是长期深耕一点,还是能呈现出随技术趋势演进的学习脉络?

方法二:场景化的敏捷性压力测试

设计模拟未来不确定性的面试题:

- 实时学习测试:“给你一小时,使用这个我们团队都没用过的全新监控工具(如OpenTelemetry),对我们提供的这个简易API进行埋点并输出一个关键指标看板。” 观察其上手策略:是先通读文档,还是边做边查?是独自摸索,还是懂得寻求有效提问?

- 认知重构测试:提供一份与其擅长技术观点相悖的、但论据充分的行业报告(例如,对其擅长的微服务架构提出尖锐批评,并论证模块化单体的优势),要求其现场评述。评估其是防御性反驳,还是能接纳信息、重构自己的认知框架。

方法三:行为模式的预测性分析(基于STAR原则的深度追问)

使用STAR原则深挖过往经历中的“非舒适区”行为:

- 情境:“请描述一个你主动学习一项与当时工作没有直接关系的新技术的经历。”

- 任务:“你为自己设定的学习目标是什么?”

- 行动:“你是如何规划学习路径的?遇到了什么主要困难?如何克服?”(重点关注其自主学习策略)

- 结果:“这项学习后来产生了什么意料之中或之外的影响?”

第四部分:从选拔到培养——打造学习型技术组织

识别出敏捷人才只是第一步,更重要的是构建一个能让其蓬勃生长,并能提升整体团队敏捷性的组织环境。

组织层面的敏捷性基础设施建设

- 建立“安全失败”的文化机制:公开表彰那些因积极尝试新技术、新方法而导致的有价值的失败,并举办“复盘会”提炼学习成果。设定“失败预算”,允许团队在一定比例的资源内进行高风险探索。

- 制度化“技术探索时间”:借鉴谷歌的“20%时间”理念,但更结构化。例如,要求每个团队每月必须有固定比例(如10%)的工时用于研究与工作相关的、但未要求的前沿技术或工具,并需要产出简短的“技术雷达”报告。

- 用AI工具重构知识管理:不再是静态的文档库,而是利用AI构建动态的、场景化的知识图谱。例如,将过往的项目复盘、技术决策记录、代码评审意见喂给内部知识库大模型,新成员可以通过自然语言问答,快速理解项目上下文和设计哲学。

个人层面的持续进化飞轮

为技术人才设计清晰的SMART成长路径:

- S(具体):每季度,完成一个与当前主要技术栈无关的迷你学习项目(例如,后端工程师学习前端可视化库D3.js的基本原理)。

- M(可衡量):建立“个人学习敏捷性仪表盘”,追踪三个核心指标:①学习速度(掌握一个中等复杂新工具到能解决实际问题的平均时长);②知识迁移率(将A领域知识成功应用于B领域问题的次数);③创新提案频率(基于新学习内容提出的改进建议数)。

- A(可实现):路径设计从“深度专家”到“T型人才”(一专多能),最终迈向“π型人才”(拥有两个深入的专业技能支柱,并具备广泛的适应学习能力),每一步都有清晰的职级和能力定义对应。

- R(相关):所有学习与实践,最终需要与提升业务洞察力、系统设计能力或团队赋能等长期职业价值相关。

- T(有时限):为上述季度学习项目和指标追踪设定明确的回顾与复盘周期。

结语:从“向后看”的选拔,到“向前看”的赌注

历史的经验正在加速折旧。AI的洪流不是要淹没所有工程师,而是将水域分成了两个截然不同的区域:一边是基于确定性知识的“浅水区”,价值正在被自动化;另一边是充满未知与可能的“深水区”,那里急需探险家。

让我们回顾本文的三个核心观点:

- 诊断的尺度需要改变:问题不在于985团队不优秀,而在于我们评价他们的尺度还停留在过去。运用四象限分析法,从能力、动机、资源、机遇全面审视团队的AI适应瓶颈。

- 人才的货币已经切换:在确定性时代,经验是资产;在不确定性时代,学习敏捷性才是硬通货。它是认知灵活性、探索欲、抽象能力和心理韧性的综合体。

- 组织的进化必须同步:个人的敏捷需要组织的“安全网”和“加速器”。从基于MECE原则的精准识别,到提供遵循SMART原则的成长路径,企业必须系统性地投资于学习型生态的构建。

行动召唤:从下周一开始

- 技术Leader:在下次1对1沟通中,不再只问项目进展,而是增加一个问题:“最近三个月,你学到的最激动人心、但与手头工作不直接相关的东西是什么?它可能如何改变我们的工作?”

- 工程师个人:立即在你的笔记中开辟一个“学习敏捷性档案”,记录下你主动探索新工具时的困惑、突破和联想,定期复盘自己的学习模式。

- HR与团队建设者:推动一次人才盘点,在九宫格中,增加“学习敏捷性”作为纵轴,与“当前绩效”组成新的矩阵,发现那些被低估的“未来之星”。

最后,请思考:

- 在你的团队里,谁是最快拥抱新工具的人?驱动他/她的核心因素是什么?你如何放大这种因素?

- 如果明天,你当前岗位所需的核心技能有50%被AI工具高效替代,你的“学习敏捷性”准备如何帮助你找到剩下的、更具价值的50%是什么?

- 你的组织文化,是更奖励“不出错的执行”,还是更鼓励“有智慧的冒险”?

未来不属于AI,也不属于固守经验的人。未来属于那些善于驾驭AI、并永远保持敏捷学习的个人与组织。这场洗牌已经开始,而你手中的牌,需要重新评估。

更多推荐

已为社区贡献118条内容

已为社区贡献118条内容

所有评论(0)