论文阅读:AIED 2025 Scaling Curriculum Mapping in Higher Education: Evaluating Generative AI’s Role in Cu

课程映射在教育中发挥着关键作用,以确保学习结果、内容、毕业技能和评估之间的一致性。项目要求通常根据行业需求制定,并嵌入课程和评估任务中。课程分析(CA)主要通过机器学习(ML)模型为课程映射过程引入了一定程度的自动化。虽然这种CA方法有助于减轻工作负担,但它们在捕获毕业技能在整个项目中发展的细微程度方面仍然面临挑战。本研究引入了一种使用大语言模型(LLMs)作为协同课程审查者的新方法。

总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://link.springer.com/chapter/10.1007/978-3-031-98414-3_21

论文原文:https://download.csdn.net/download/WhiffeYF/92545402

论文集下载:https://download.csdn.net/download/WhiffeYF/92543315

Scaling Curriculum Mapping in Higher Education: Evaluating Generative AI’s Role in Curriculum Analytics

速览

1. 一段话总结

本研究聚焦高等教育课程图谱绘制,针对传统人工方法耗时、传统机器学习(ML)模型仅能实现二元映射的局限,引入生成式人工智能(GenAI,采用ChatGPT 4.0)作为联合课程评审者,以澳大利亚某大学会计学本科项目为研究对象,围绕7项企业技能生成技能与评估间的加权映射,并与基于BERT的RoBERTa模型对比,结果显示GenAI的映射与专家判断的一致性(Krippendorff’s alpha为0.76)显著高于ML模型(0.65),且在不同技能(如口头沟通达成近完美一致性)和学年(第三年一致性最高)中表现存在差异,为课程质量保障、认证对齐及个性化学习路径提供了更高效、精细的解决方案。

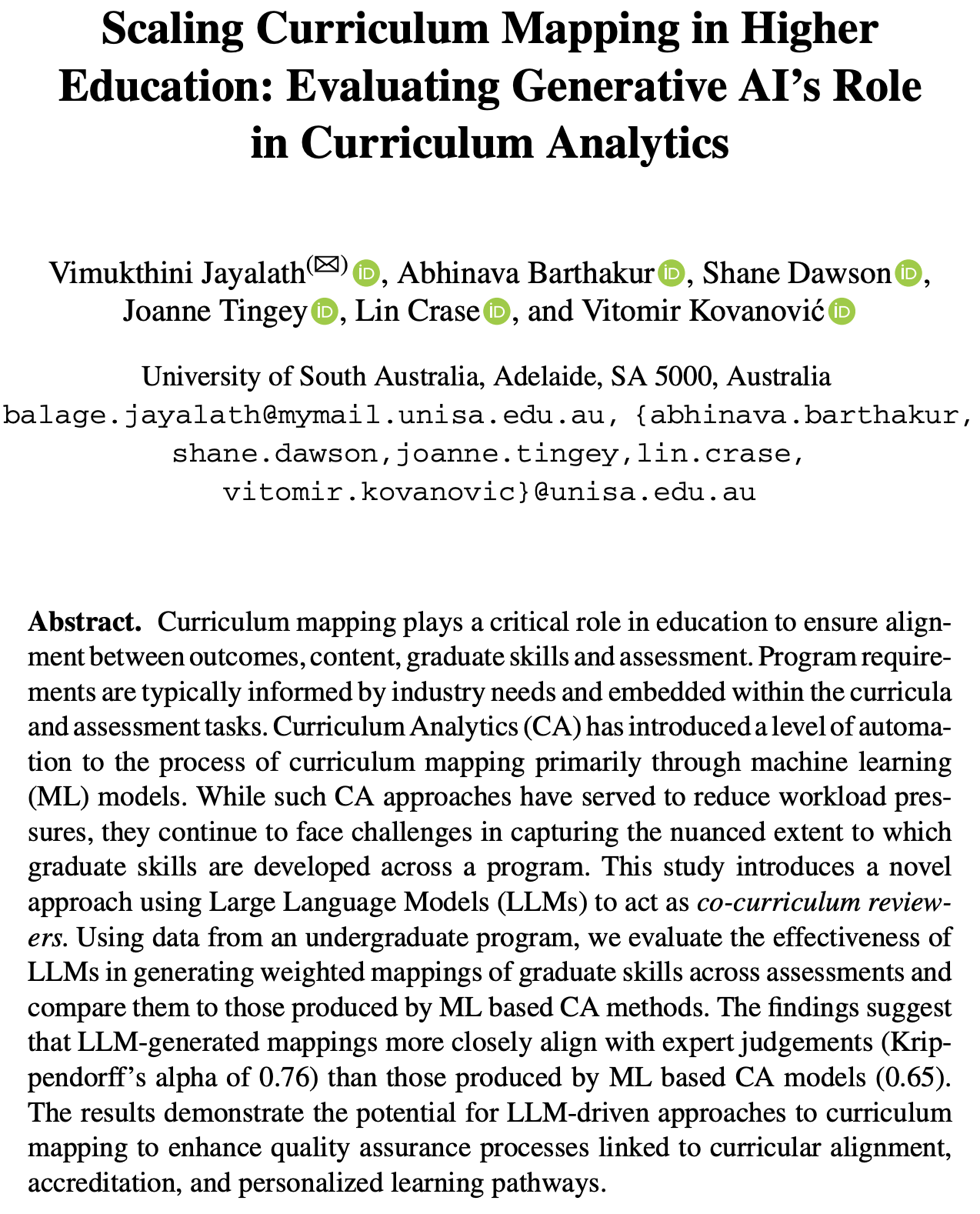

2. 思维导图

## 研究背景与目的

- 课程图谱绘制的重要性:衔接学习成果、技能与评估,支撑认证

- 传统方法局限:人工耗时、易不一致;ML模型仅二元映射,缺语境与粒度

- 研究目的:验证GenAI在加权技能映射中的效果,对比ML模型,探索技能与学年差异

## 研究设计

- 研究对象:澳大利亚某大学会计学本科项目(3年19门课程)

- 目标技能:7项企业技能(自我管理、问题解决等)

- 数据来源:课程描述、目标、作业详情等(不含评分细则)

## 研究方法

- 步骤1:专家标注(2名领域专家,Krippendorff’s alpha=0.70,确立金标准)

- 步骤2:ML模型(RoBERTa,基于余弦相似度,归一化得分作为权重)

- 步骤3:GenAI模型(ChatGPT 4.0,零样本提示,生成加权映射)

## 研究结果

- RQ1:GenAI(α=0.76)一致性高于ML模型(α=0.65)

- RQ2:技能差异(口头沟通α=0.86最优,国际视野α=0.26较差);学年差异(第三年最优,第二年存在负向一致性)

## 结论与意义

- 核心结论:GenAI优于传统ML,支持精细课程映射

- 实践意义:提升效率、减少课程漂移、支撑个性化学习与认证

- 局限性:单一模型与项目、数据有限、未深入探索提示工程

3. 详细总结

一、研究背景与核心问题

- 课程图谱绘制的重要性:课程图谱(Curriculum Mapping)是高等教育的关键环节,需系统衔接学习成果、课程内容、毕业生技能与评估方式,同时支撑专业认证,确保课程与行业需求、认证标准对齐。

- 现有方法的局限:

- 传统人工方法:耗时费力、易出现不一致,难以规模化应用,导致课程错位与技能培养碎片化。

- 课程分析(CA)中的机器学习(ML)方法:虽实现部分自动化,但多为二元映射(仅标注技能“存在/不存在”),无法捕捉技能培养的程度差异与语境细节。

- 研究核心目标:引入大型语言模型(LLMs)类生成式AI(GenAI),构建技能与评估间的加权映射(量化技能在评估中的权重占比),解决传统方法的粒度不足问题,并通过两大研究问题(RQ)展开验证:

- RQ1:GenAI能否有效为评估分配技能权重?与传统ML方法表现对比如何?

- RQ2:GenAI在不同技能类型、不同学年的映射表现是否存在差异?

二、研究设计与方法

| 核心要素 | 具体内容 |

|---|---|

| 研究对象 | 澳大利亚某大型公立大学,商科学士(会计学)项目,涵盖3年19门课程 |

| 目标技能 | 7项企业技能(Enterprise Skills):自我管理、问题解决、团队合作、伦理意识、书面沟通、口头沟通、国际视野 |

| 数据来源 | 课程大纲文档(含课程描述、学习目标、作业详情),不含评分细则(因三年间差异较大) |

| 研究步骤 | 1. 确立金标准:2名领域专家独立标注技能权重,通过讨论解决分歧,最终Krippendorff’s alpha=0.70(强一致性); 2. ML模型(基线):采用RoBERTa模型,生成技能短语与评估描述的嵌入向量,通过余弦相似度计算匹配度,阈值0.1过滤弱匹配,归一化得分作为技能权重; 3. GenAI模型:使用ChatGPT 4.0,设计零样本提示(含技能定义、权重求和100%等要求),生成加权映射表格 |

三、关键研究结果

- RQ1:GenAI与ML模型的性能对比

- 整体一致性:GenAI生成的映射与专家金标准的Krippendorff’s alpha为0.76(实质性一致),显著高于ML模型的0.65(中等一致)。

- 各技能一致性对比(Krippendorff’s alpha):

| 技能类型 | GenAI模型 | 一致性等级 | ML模型 | 一致性等级 |

|---|---|---|---|---|

| 口头沟通(Oral Communication) | 0.86 | 近完美一致 | -0.07 | 系统性不一致 |

| 团队合作(Teamwork) | 0.63 | 实质性一致 | -0.05 | 系统性不一致 |

| 问题解决(Problem-Solving) | 0.59 | 中等一致 | 0.24 | 一般一致 |

| 自我管理(Self-Management) | 0.50 | 中等一致 | -0.31 | 系统性不一致 |

| 伦理意识(Ethical Awareness) | 0.47 | 中等一致 | -0.12 | 系统性不一致 |

| 书面沟通(Written Communication) | 0.37 | 一般一致 | 0.04 | 微弱一致 |

| 国际视野(Int Perspective) | 0.26 | 一般一致 | 0.10 | 微弱一致 |

- RQ2:GenAI在技能类型与学年的表现差异

- 技能类型差异:

- 优势技能:口头沟通(α=0.86)、团队合作(α=0.63),因课程活动中相关描述明确(如“小组展示”直接关联团队合作与口头沟通)。

- 弱势技能:国际视野(α=0.26)、书面沟通(α=0.37),因技能多隐含于语境,课程文档中缺乏明确标注。

- 学年差异(Krippendorff’s alpha):

- 技能类型差异:

| 技能类型 | 第一年(Y1) | 第二年(Y2) | 第三年(Y3) |

|---|---|---|---|

| 口头沟通 | 0.80 | 0.77 | 0.98 |

| 团队合作 | 0.84 | -0.13 | 0.99 |

| 问题解决 | 0.57 | 0.44 | 0.72 |

| 自我管理 | 0.41 | -0.11 | 0.72 |

| 伦理意识 | 0.17 | 0.80 | 0.23 |

| 书面沟通 | 0.41 | -0.18 | 0.74 |

| 国际视野 | 0.38 | 0.50 | -0.08 |

| 整体特征 | 混合表现 | 部分技能系统性不一致 | 整体最优,一致性最高 |

四、研究结论与意义

- 核心结论:

- GenAI在加权课程映射中表现优于传统ML模型,能更精准捕捉技能与评估的关联粒度,与专家判断的一致性更高(0.76>0.65)。

- GenAI的表现受技能类型(明确标注技能更易识别)和学年(第三年课程设计更结构化,表现最优)影响。

- 实践意义:

- 提升效率:减少人工课程映射的工作量,支持规模化应用。

- 优化课程设计:识别技能培养的缺口与冗余,减少“课程漂移”(Curriculum Drift)。

- 支撑个性化学习:基于精细技能映射,为学生提供针对性的模块推荐。

- 助力认证合规:更清晰展示课程与技能标准的对齐,简化认证流程。

- 局限性:

- 研究范围有限:仅基于单一LLM(ChatGPT 4.0)和单一会计学项目,通用性待验证。

- 数据约束:课程大纲文档信息有限,未纳入评分细则等关键材料。

- 方法优化空间:未深入探索提示工程(如思维链提示)对结果的影响。

4. 关键问题

问题1:生成式AI(GenAI)在课程技能映射中相比传统机器学习(ML)模型的核心优势是什么?具体表现如何?

答案:核心优势是GenAI能捕捉课程内容的语境细节,生成量化的“加权映射”(而非ML模型的二元映射),更贴合技能培养的程度差异。具体表现为:GenAI与专家判断的Krippendorff’s alpha值(0.76)显著高于ML模型(0.65);ML模型对团队合作、自我管理等技能出现系统性不一致(alpha值为负),而GenAI所有技能的alpha值均为正,且在口头沟通(0.86)、团队合作(0.63)等技能上达成高一致性。

问题2:GenAI在不同技能类型和学年的映射表现存在哪些差异?背后的原因是什么?

答案:(1)技能类型差异:口头沟通(alpha=0.86,近完美一致)、团队合作(alpha=0.63,实质性一致)表现最优,因课程中相关活动(如小组展示)描述明确;国际视野(alpha=0.26)、书面沟通(alpha=0.37)表现较差,因技能多隐含于语境,缺乏明确标注。(2)学年差异:第三年表现最优(多数技能alpha>0.7),因课程设计更结构化,技能目标更清晰;第二年部分技能(如团队合作、书面沟通)出现负向一致性,因处于课程过渡阶段,技能期望未明确articulate;第一年表现混合,部分核心技能(如口头沟通)一致性较高。

问题3:本研究的成果对高等教育课程设计与质量保障有哪些实际应用价值?

答案:(1)提升课程映射效率:减少人工标注的时间与人力成本,支持大规模、跨学科的课程图谱绘制;(2)优化课程质量与合规性:精准识别技能培养的缺口、冗余或错位,减少“课程漂移”,确保课程与行业需求、认证标准对齐;(3)支撑个性化学习:基于技能加权映射,为学生推荐针对性模块,帮助强化薄弱技能;(4)简化认证流程:通过量化数据清晰展示课程与技能标准的对齐情况,为专业认证提供实证支持。

扩展高等教育中的课程映射:评估生成式AI在课程分析中的作用

Vimukthini Jayalath(✉), Abhinava Barthakur, Shane Dawson,

Joanne Tingey, Lin Crase, and Vitomir Kovanović

南澳大利亚大学,阿德莱德,南澳5000,澳大利亚

balage.jayalath@mymail.unisa.edu.au, {abhinava.barthakur,

shane.dawson,joanne.tingey,lin.crase,

vitomir.kovanovic}@unisa.edu.au

摘要

课程映射在教育中发挥着关键作用,以确保学习结果、内容、毕业技能和评估之间的一致性。项目要求通常根据行业需求制定,并嵌入课程和评估任务中。课程分析(CA)主要通过机器学习(ML)模型为课程映射过程引入了一定程度的自动化。虽然这种CA方法有助于减轻工作负担,但它们在捕获毕业技能在整个项目中发展的细微程度方面仍然面临挑战。本研究引入了一种使用大语言模型(LLMs)作为协同课程审查者的新方法。使用本科项目的数据,我们评估了LLMs在生成评估与毕业技能之间加权映射方面的有效性,并将其与基于ML的CA方法产生的映射进行比较。研究结果表明,LLM生成的映射与专家判断的一致性(Krippendorff’s alpha为0.76)高于基于ML的CA模型产生的映射(0.65)。结果表明,LLM驱动的课程映射方法有潜力增强与课程一致性、认证和个性化学习路径相关的质量保证过程。

关键词: 课程分析 · 课程映射 · 技能 · 生成式AI · 高等教育

1 引言

在高等教育中,精心设计的课程对于有效的学习体验至关重要。规定的课程概述了学生需要达到的知识、技能和能力。课程的表述和记录通常被称为课程映射。课程映射系统地识别特定知识、技能和能力在哪里以及如何嵌入课程和项目课程中[1]。课程映射也是学术认证过程的重要组成部分,其中学习成果、活动和评估在整个项目中的一致性至关重要。作为项目设计的初始步骤,课程映射确保课程和模块对齐,为学生实施渐进和分段的学习旅程[2]。

传统上,课程映射过程依赖于耗时且容易出现不一致的手动方法[3]。因此,课程映射通常仅限于少数课程,导致学习项目中的不一致、错位和碎片化的技能发展[4]。这些挑战促使了课程分析(CA)[5]的发展,它应用数据驱动的方法来改善课程设计、项目质量和学生成果。CA应用扩展到服务质量保证过程,允许大学将其课程与相关认证标准保持一致,其中一个关键组成部分是专业技能的映射。CA通过缓解与影响映射质量的更传统、手动、时间密集型方法相关的限制来增强映射过程[3]。各种机器学习(ML)方法已经证明了它们在CA中的潜力[6,7],从基于规则的方法[8]到基于transformer的模型如BERT[9]。

虽然在CA中使用ML方法有许多好处,但仍然存在重大问题。关键问题之一涉及课程映射中使用二元关系,该关系只允许记录课程特定部分中知识和技能的存在或缺失。这种关系无法真实地模拟实际的技能和知识发展,忽略了课程中不同程度的关联和上下文细微差别。随着大语言模型(LLMs)的最近出现,有很大的机会利用这些模型进行课程映射,以扩展CA的范围并提高正在产生的课程映射的质量。LLMs,如GPT系列模型,已显示出有望用作审查高等教育中课程映射过程的工具[10,11]。研究人员还使用LLMs将课程与学习目标保持一致[12]。然而,它们建立技能与课程之间加权映射并检查映射质量的能力仍有待探索。

本文基于Zamecnik及其同事[11]的早期工作,探讨LLMs作为协同课程审查者的潜力。该研究旨在探索使用LLMs创建加权课程映射,以捕获整个学习项目中技能获取的复杂性。与二元映射不同,加权映射允许对多个技能如何嵌入有更细致的洞察。例如,涉及团队演示的评估项目可能为评分分配权重。在这种情况下,团队合作占最终成绩的30%,口头沟通占70%。二元标签无法捕获这种粒度级别。更细粒度的洞察可以帮助课程设计者识别学生可能在其学术旅程中获得对关键技能的重复或平衡接触的位置,以及是否有任何技能被过度强调或忽视。使用来自三年制会计本科学习项目的数据,本研究通过比较LLM与传统ML方法的性能,探索其改善高等教育中课程映射实践的潜力。此外,它还研究了LLMs在不同学年水平上映射不同技能时的表现如何。通过在课程中实现更细粒度的技能映射,我们提出LLMs可以通过满足学生的多样化学术需求和背景来支持课程的个性化。

2 背景

2.1 课程分析和课程映射

课程映射旨在系统地对齐学习目标、评估和教学活动,确保技能发展的连贯性和有效性[13,14],同时也帮助教育工作者识别课程中的差距和错位。课程映射的一个常见应用是将课程链接到特定的技能集,通常被称为毕业属性、企业技能或专业标准,学生期望在毕业时展示这些技能[3]。在专业学位项目中,如商业教育,特别是会计学位,技能映射作为加强未来专业人员就业技能同时确保符合认证标准的关键方法受到关注[15]。

尽管有其好处,但由于孤立的课程设计,机构经常在课程映射的项目监督方面遇到困难,其中课程由不同的教师独立开发,导致项目级学习成果的错位[4]。随着时间的推移,这可能导致课程漂移,即个别课程中的微小、不协调的变化累积,导致与项目级目标的错位[16]。虽然课程和项目目标以及评估实践通常会定期审查以进行认证[17],但这可能是一个耗时且劳动密集的过程,可能也缺乏更广泛的视角来提供对项目级技能映射的洞察。通过解决这些问题,机构可以提高课程和项目的质量,确保学生获得必要的知识和技能。

课程分析[5]已作为学习分析(LA)[18]的一个子领域出现,它利用计算技术使教育工作者和其他利益相关者能够就课程改进做出基于证据的明智决策。CA在高等教育背景下获得了突出地位,因为它使用先进的数据驱动方法来改善课程决策和学位项目的整体质量[3]。一些最早的CA研究采用社交网络分析来帮助理解复杂的课程结构[5]。与课程映射集成的CA可以汇集必要的证据来证明教育项目已满足专业认证所需的标准和学习成果[3]。

2.2 用于课程分析和课程映射的ML和NLP

结构化课程映射的初始方法依赖于简单的基于规则的方法[8],这些方法在适应不同学习环境的能力方面受到限制。随着NLP技术的进步,基于transformer的模型,如BERT[19]和RoBERTa[7],使用上下文嵌入在课程映射中显示出合理的准确性。同样,特定领域的嵌入,如BioBERT[6]、JobBERT[20]和NER模型[21],提供了专门的用例,如医学教育的课程映射、工作的技能提取和非英语环境中的技能提取。虽然NLP方法可以针对特定领域进行优化,但它们在扩展到更广泛应用(如跨不同学科和技能水平的课程映射)的能力方面通常受到限制。SkillNER和TF-IDF等框架也被用于将课程内容与职业需求保持一致,为技能提取提供了强大的解决方案[9]。虽然句子嵌入模型(如BERT及其变体)和技能提取方法(如SkillNER)继续在文本映射过程中展现潜力[7,22],但它们严重依赖关键词匹配,可能会错过课程内容中的上下文细微差别。

这些CA研究缓解了与传统映射过程相关的一些限制,传统映射过程需要不同的利益相关者手动审查项目和课程文档,以确定教授和评估认证标准的位置。众所周知,这是一个耗时的过程[23],容易出现人为错误和偏见,缺乏可扩展性[3]。虽然这些CA方法简化了此类映射的实施,但人们对这些连接的粒度和深度提出了担忧[24]。映射过程的一个主要限制是它只表示课程/模块中技能的存在或缺失。因此,这无法捕获所评估技能与特定评估之间不同程度的关联。这一限制对商业教育特别相关,商业教育需要详细阐述毕业技能和成果以符合专业认证标准[15]。将先进的ML技术集成到课程映射中以量化毕业生的技能发展,为使用AI解决课程映射的复杂过程提供了基础[25]。

2.3 用于课程分析和映射的AI和GenAI

将AI集成到课程映射中已成为一种变革性方法,可根据劳动力需求将教育内容与技能保持一致。Lai[26]和Ketamo[27]利用AI分析课程描述、招聘广告和行业报告,使用外部资源确保课程与外部需求保持相关。而McLaren及其同事[10]通过关注课程文档、将内容与学习目标保持一致以及解决高质量课程的复杂性来扩展这一工作线。一项关于招聘目的的技能提取研究,比较了ML方法和带标记数据的微调LLMs[28],也展示了使用AI进行课程映射的有希望的结果。

ChatGPT已被探索在教育环境中的潜力。GPT-4已被用于为课程生成高质量的学习目标,研究结果表明这些AI生成的学习目标与最佳实践保持一致,并涵盖所需的认知水平[12]。另一项研究探讨了ChatGPT作为课程设计中的虚拟同事,强调了其在构建内容和头脑风暴方面的效率,同时注意到其局限性,如通用输出和需要人工干预[29]。Zamecnik及其同事[11]在将技能映射到26门高等教育课程方面达到了71%的准确率,只关注映射技能的存在或缺失。这些研究表明,通过使用人机协作以及使用大学提供的课程大纲文档和专家标注,将GenAI集成到课程映射过程中可以改善教育成果与实际教学实践之间的一致性。

然而,这种方法没有考虑每个技能与评估相关的重要性。例如,某些技能可能对给定任务更为核心,而其他技能只起次要作用。通过纳入技能权重,可以通过允许清楚地了解哪些评估强烈发展特定技能以及哪些仅提供最小技能发展,来实现对每个评估如何映射到技能的更细粒度理解。解决这一差距是本研究的主要目标,旨在改进技能映射方法,以捕获评估所针对的每个技能的深度和相关性。

3 研究问题

文献综述强调需要从二元技能-评估映射转向加权映射,以更好地理解技能发展。此外,它强调需要进行实证研究,以评估AI如何成功地将学术课程与数字经济的需求相匹配,以改善课程一致性[30]。为了解决这一差距,我们的目标是构建一个GenAI模型,使用大学门户上可用的课程大纲从评估中派生到技能的加权映射,并将性能与传统ML模型进行比较,以用于课程映射目的。更具体地说,本研究解决以下两个研究问题(RQs):

RQ1: GenAI能够多有效地基于课程大纲文档为评估分配技能权重?其性能与传统ML方法在将技能映射到课程内容方面相比如何?

第一个研究问题探讨使用GenAI开发加权技能-评估映射,将其输出与专家权重和传统ML方法进行比较,以确定扩展映射过程的可能性。

RQ2: 使用GenAI映射各种技能是否存在性能差异,其性能在不同学年水平上如何变化?

第二个研究问题检查GenAI在技能-评估映射中的性能是否因技能类型和学年水平而异,评估潜在偏见及其对可扩展课程映射的适用性。这个问题背后的理由是假设不同的技能在课程中具有不同的复杂性水平[31],评估复杂性在学位项目的不同年级水平上也有所不同。

4 方法论

4.1 研究设计

本研究在澳大利亚一所大型公立大学进行,重点关注商学学士(会计)项目及其相关课程。分析重点是确定商学院企业技能的整合,这些是以下高级技能:1) 自我管理,2) 问题解决,3) 团队合作,4) 道德意识,5) 书面沟通,6) 口头沟通,7) 国际视野。

为了解决研究问题,我们分析了项目中19门课程的所有课程数据,涵盖其完整的三年期间。对于每门课程,收集的数据包括课程描述、目标、作业详情以及关于每个作业中企业技能评估的二元信息。我们没有包括评估量规,因为这些在三年的课程提供中有所不同。

4.2 研究方法

在对大学课程管理系统中的映射数据进行初步评估后,我们发现了重大的数据质量问题,许多企业技能被错误地映射到课程中。因此,我们分析的第一步是创建整个课程技能映射的黄金标准。

步骤1:专家技能映射评估

为了创建关于企业技能评估的黄金标准数据集,两位在该项目中具有丰富教学经验的领域专家被委派识别七项企业技能中每一项在哪里以及在多大程度上被评估。专家被给予所有企业技能的定义,并被要求为每门课程评估的每项技能分配权重,交叉参考课程管理系统中的初始二元映射。这些权重使用Krippendorff’s alpha[32]作为评分者间可靠性度量进行比较。选择Krippendorff’s alpha而不是其他度量(如Cohen’s kappa),因为它适应多个评分者,处理缺失数据,并支持区间尺度或连续变量,使其更适合比较本研究中的技能权重。Krippendorff’s alpha的值范围从-1到+1,其中α = 1表示完全一致,α = 0反映随机一致,α < 0表示评分者之间的系统性不一致[33]。审查者标注的总体Krippendorff’s alpha值为0.70,反映了两位审查者之间的强共识。详细的技能级别一致性见表2,这些一致性的解释遵循[34]概述的基准值(表1)。

在独立审查后,专家标注者比较了他们的结果解决分歧,以建立统一的基本事实。这种协作开发的基准最小化了个人偏见,提高了基准数据集的可靠性和有效性,用于评估GenAI和基于NLP的ML模型生成的映射性能。

步骤2:使用基于BERT的NLP模型进行技能映射(基线)

研究的第二阶段侧重于根据评估描述的语义相似性分析它们,并将它们映射到预定义的技能类别以提供权重。代表特定技能的基于共识的种子短语/词由审查者开发,以确保与课程大纲文档中使用的术语保持一致(例如,“团队合作”:“小组演示”、“小组报告”、“进度报告(小组)”)。这些种子短语被用作参考,以与数据集中的描述进行匹配。

本研究利用来自Hugging Face的transformers库的预训练BERT[35]扩展"RoBERTa"模型来生成技能短语和评估描述的句子级嵌入[7],将文本转换为在此上下文中使用的高维数值向量(嵌入)。该模型对文本进行分词,平均token嵌入,并为文本返回单个向量。它存储在将每个技能名称映射到其相应嵌入向量的字典中。

评估描述的预处理阶段涉及两个主要步骤:数据提取和停用词删除。描述是从课程大纲文档中手动提取的。通过检查提供的评估名称是否有可用的描述来手动清理文本;如果没有,则表示为NA。本研究利用Python 'nltk’库从评估描述中删除不携带重要意义的停用词。最后,通过使用上述相同模型的迭代将描述转换为数值嵌入。使用余弦相似度将评估嵌入与每个技能嵌入进行比较[9,22]。如果相似度低于阈值(0.1),则将其设置为0,以过滤弱匹配。应用0.1的相似度阈值来抑制弱匹配。在计算所有技能的相似度后,相似度分数被归一化为总和为1,反映描述中每个技能的相对权重。这些分数被作为每个技能的权重进行比较。

步骤3:使用GenAI进行技能映射

在研究的第三阶段,使用GenAI(ChatGPT 4.0)生成技能与评估之间的加权映射。虽然我们通过利用确定性设置专注于提高研究的可重复性,但由于LLM响应生成的复杂性质,模型运行之间的模型输出存在变化的挑战。本研究中使用的提示(附录)经过迭代改进,以提高其根据定义识别技能并以清晰、用户友好的数据表格式呈现结果的能力。

零样本提示最初分配协同课程审查者的角色,然后指导模型审查每个课程大纲文档并分析评估,以估计每个技能的百分比权重,不适用的技能接收零,以及总权重总和为100%的标准。它包括每个技能的详细定义。这种方法旨在提高技能映射的准确性,并确保在将派生权重与手动和基于机器学习的估计进行比较时的一致性。

5 结果

5.1 RQ 1: 比较NLP和GenAI技能映射准确性

为了回答第一个研究问题,分析将开发的专家权重与GenAI和NLP提供的权重进行了比较。GenAI生成的技能权重表与专家标注的基本事实紧密一致,实现了0.76的总体Krippendorff’s alpha,而ML模型的总体Krippendorff’s alpha值为0.65,反映了与审查评分的中等程度的共识。

表2. GenAI和ML方法对每个技能的Krippendorff’s alpha比较

| 技能 | Krippendorff’s alpha和解释 | |

|---|---|---|

| GenAI模型 | 基于BERT的NLP模型 | |

| 问题解决 | 0.59 中等一致性 | 0.24 一般一致性 |

| 团队合作 | 0.63 实质性一致性 | −0.05 系统性不一致 |

| 书面沟通 | 0.37 一般一致性 | 0.04 轻微一致性 |

| 自我管理 | 0.50 中等一致性 | −0.31 系统性不一致 |

| 道德意识 | 0.47 中等一致性 | −0.12 系统性不一致 |

| 国际视野 | 0.26 一般一致性 | 0.10 轻微一致性 |

| 口头沟通 | 0.86 近乎完美一致性 | −0.07 系统性不一致 |

结果显示,考虑到Krippendorff’s alpha值的解释,GenAI在各技能的一致性水平上始终优于ML模型。对于使用NLP模型的大多数技能映射,alpha值低于0,而GenAI映射始终具有高于0的alpha值。一些技能(国际视野)映射在模型之间有一些一致性,alpha值分别为0.26和0.10,而其他技能(自我管理、团队合作)在两个模型之间存在差异,GenAI始终优于ML模型。

5.2 RQ 2: 检查GenAI映射在不同技能和学年中的性能

为了探索RQ2,我们检查了GenAI模型映射七项技能的不同能力。根据表2,口头沟通以近乎完美的一致性(k = 0.86)脱颖而出,展示了卓越的一致性,团队合作在AI的解释中达到了实质性一致性(k = 0.63)。问题解决、自我管理和道德意识属于中等范围,反映了强大的总体一致性。然而,书面沟通和国际视野的alpha值低于其他技能,并观察到一般一致性。

为了解决RQ2的第二部分,我们调查了模型在三个学年中映射技能的表现。结果(表3)显示Krippendorff’s alpha在学年水平上有显著的变化。第一年通常表现出较低的一致性,有一些非常高的alpha值(例如,团队合作和口头沟通)。第二年显示混合结果,有一些负值(例如,团队合作、书面沟通和自我管理)表明基于AI的映射存在不一致。第三年在所有三年中展示了最高的一致性,只有国际视野表明不一致。

表3. 每年基于AI方法的Krippendorff’s alpha比较

| 技能 | Y1 | Y2 | Y3 |

|---|---|---|---|

| 问题解决 | 0.57 | 0.44 | 0.72 |

| 团队合作 | 0.84 | −0.13 | 0.99 |

| 书面沟通 | 0.41 | −0.18 | 0.74 |

| 自我管理 | 0.41 | −0.11 | 0.72 |

| 道德意识 | 0.17 | 0.80 | 0.23 |

| 国际视野 | 0.38 | 0.50 | −0.08 |

| 口头沟通 | 0.80 | 0.77 | 0.98 |

6 讨论

6.1 解决技能映射的挑战:GenAI在提高效率和与行业标准一致性方面的潜力

本研究探讨了GenAI在高等教育学位项目中进行课程映射的潜力。传统的课程映射是一个手动、劳动密集的过程,如果不经常更新,可能导致与行业标准的错位。对这种映射的任何更新都需要教育利益相关者的认真工作。因此,本文提出GenAI作为协同课程审查者,将多个企业技能映射到整个学位项目的评估中。

与传统的ML方法相比,GenAI在与专家标注的一致性方面表现出更强的性能。GenAI达到了0.76的总体Krippendorff alpha,表明与专家标注的基本事实有实质性的一致性。事实上,这种一致性高于我们在两位人类标注者之间观察到的一致性(0.70)。虽然这可能看起来违反直觉,但重要的是要注意,本研究中的基线是由领域专家通过讨论协作开发的。需要进一步分析来探索LLM的性能是否能跨领域泛化,以及它在实践中如何补充人类判断。

相比之下,ML模型达到了0.65的较低alpha,反映了与专家评分的中等一致性。这种差异呼应了Herandi及其同事[28]的发现,GenAI可以捕获上下文细微差别,而传统ML方法可能难以整合课程大纲文档提供的完整上下文。这可能是由于ML模型的限制,它依赖于其种子短语来识别和提供权重,而GenAI可以浏览文档文本并在提供的定义的帮助下获得大多数短语的上下文理解[20]。先前的研究讨论了LLMs在没有训练数据的情况下如何表现不佳[20,21],这展示了在没有训练数据的情况下识别技能的困难。虽然具体背景不同(与Herandi等人[28]关于职位描述的研究相比,课程映射),但我们表明GenAI在技能识别方面优于传统ML模型。

评估在课程中发挥着重要作用。评估充当课程级成果和学生学习进展之间的桥梁。因此,有很大的重点确保评估活动为学生提供适当的机会来展示他们的学习(技能、知识和属性)。然而,个别教师通常有自主权来改变或变更评估实践或强调替代内容或技能。虽然修改课程文档的灵活性可以被认为是更新和保持相关性和真实性的一种手段,但这些变化也可能显著改变学生在学习项目中的支持方式。由于课程级别的评估实践经常与更广泛的项目目标孤立地设计[17],课程中的变化可能显著改变学生如何发展和展示专业标准和大学毕业素质。本研究展示了LLMs如何用于在开发和修订个别课程时提供主动支持和建议,以及这可能对项目级成果产生的潜在影响。

6.2 不同技能类别和学年水平的变化

结果突出显示,GenAI在将技能映射到评估方面的性能在不同技能和学年水平上有所不同,表明在高等教育中应用技能加权方面存在潜在的挑战和优势。我们的发现与Zamecnik及其同事[11]一致,他们在映射不同专业技能时报告了一致性的变化。

如表2所示,口头沟通等技能达到了近乎完美的一致性,这可能是由于与口语、演示和口头互动相关的课程活动的清晰性和具体性。这种清晰性有助于模型准确地将评估与正确的技能关联,正如会计和商业教育中一致的发现所示,其中口头演示量规定义明确[36]。同样,团队合作显示出实质性的一致性,而问题解决、自我管理和道德意识具有中等一致性。问题解决任务,如案例研究和财务计算,强调分析思维,但可能并不总是在课程材料中明确标注。自我管理和道德意识评估受益于明确的参考,因此,嵌入量规中或在课程文档中不太直接陈述的任务对GenAI的识别能力构成挑战[37]。

GenAI在书面沟通和国际视野方面的表现较弱,因为这些技能通常是从上下文线索推断出来的,而不是在课程描述中明确陈述的。课程文档中缺乏清晰度和上下文标注使GenAI难以映射。低一致性也可能是由于这些技能的训练数据有限[11]。研究结果表明,一些技能需要更深入的上下文解释,这可能在没有进一步微调或特定领域训练的情况下挑战AI模型。更详细的量规,特别是在会计课程中[38],可以提高AI准确映射技能的能力。

GenAI的性能在学年水平上有所不同,在第三年评估中达到最高一致性,表明后期年份的技能期望更加结构化。这通常是会计课程中职业准备技能发展增加的水平[38]。第一年显示混合结果,第二年最不一致,特别是在团队合作、书面沟通和自我管理等技能方面。这些不一致可能源于课程设计中的过渡阶段,没有明确阐述技能期望。这可能导致GenAI难以解释的模糊或隐含线索。第三年课程中性能的改善表明,这些项目后期年份的技能期望有更强的阐述和映射。

教育工作者经常设计课程,包括评估,假设学生清楚地了解对他们的要求以及他们需要展示的技能,而无需明确说明[3]。此外,正如我们的发现所示,不同学术水平使用的描述有所不同,使学生更难理解教师的期望。我们的研究展示了LLMs在突出课程和评估描述中的差异和上下文信息缺乏方面的能力。我们还观察到这些评估的复杂性在发展,进一步倡导在设计评估和更广泛的课程时进行项目级考虑。LLMs可以被训练进行项目考虑,以改善课程设计,从而增强认证过程并支持个性化学习。

6.3 启示

我们的发现提供了一种数据驱动的方法,支持教育工作者改进他们的教学,以便学生可以更好地理解课程作业与就业能力之间的联系。这种方法还减少了课程映射的手动工作,允许教育工作者更多地关注教学设计。它还可以通过清楚地表示跨课程和学术水平的技能分布来改善决策。最重要的是,它将解决孤立课程设计的问题,提供整个项目的全面视图。这将提高透明度并帮助识别差距或冗余,最终导致项目改进的更明智决策。这种方法还促进了可扩展性和效率,解决了课程漂移的问题,如果课程发生变化,可以快速更新,允许快速调整以确保它与学术标准和行业需求保持相关和最新。

6.4 局限性和未来工作

必须承认本研究的几个局限性。首先,该研究主要依赖于单个LLM、当前版本和单个项目来派生评估与技能之间的加权映射,这可能限制了研究结果的普遍性。其次,大学平台上可用的课程大纲可能无法提供足够的信息来理解潜在的技能发展以及特定技能在评估中的整合。第三,该研究没有广泛探索提示工程策略和LLM模型的变体,这可能显著影响响应的质量。在未来的工作中,我们旨在通过探索多个LLMs来增强我们的研究发现,以进行更好的分析。此外,我们计划将我们的方法扩展到多个项目,以提高我们发现的质量和普遍性。未来的工作可以探索结构化提示工程技术,如思维链提示,以及GPT o3-mini等模型,以理解分配权重背后的推理。此外,整合人在环中的过程将完善和排名理由的有用性,通过结合LLM答案的优势与人类专业知识来提高课程映射的质量,以获得更可靠的结果。

7 结论

本研究展示了GenAI在通过将评估与技能(特别是企业技能)保持一致来改善课程映射方面的潜力,在与专家标注的一致性方面超越了传统ML模型。虽然GenAI对某些技能显示出强大的性能,但挑战仍然存在,特别是对于需要更深入上下文解释或在课程文档中定义不太明确的技能。不同学年的变化突出了在设计课程时需要更一致的技能标注和项目考虑。此外,研究结果表明,GenAI可以在提高课程映射的效率和可扩展性方面发挥关键作用,帮助教育工作者改进课程与不断发展的行业需求的一致性。通过在多个评估和课程中生成更细粒度的技能级洞察,它为个性化学习路径奠定了基础,学生可以根据他们的个人进展被引导到针对他们需要加强的技能的评估或模块。未来的工作将集中在解决本研究的局限性、探索多个模型以及纳入以人为中心的分析,以进一步提高AI驱动的课程映射的有效性。

利益披露。 作者声明没有与本文内容相关的竞争利益。

附录

使用的提示:Link.

References

- Jacobs, H.H.: Mapping the Big Picture. Integrating Curriculum & Assessment K-12. Association for Supervision and Curriculum Development, 1250 N (1997)

- Harden, R.M.: AMEE Guide No. 21: curriculum mapping: a tool for transparent and authentic teaching and learning. Medical Teacher. 23, 123–137 (2001). https://doi.org/10.1080/0142159012003654 7

- Barthakur, A., Kovanović, V., Dawson, S., Deneen, C.C.: The application of curriculum analytics for improving assessments and quality assurance in higher education. Australasian J. Educ. Technol. (2024). https://doi.org/10.14742/ajet.9383

- Rawle, F., Bowen, T., Murck, B., Hong, R.: Curriculum mapping across the disciplines: differences, approaches, and strategies. CELT. 10, 75–88 (2017). https://doi.org/10.22329/celt.v10i0.4765

- Dawson, S., Hubball, H.: Curriculum analytics: application of social network analysis for improving strategic curriculum decision-making in a research-intensive university. Teach. Learn. Inq. 2, 59–74 (2014). https://doi.org/10.20343/teachlearninqu.2.2.59

- Cher, P.H., Lee, J.W.Y., Bello, F.: Machine learning techniques to evaluate lesson objectives. In: Rodrigo, M.M., Matsuda, N., Cristea, A.I., Dimitrova, V. (eds.) Artificial Intelligence in Education, pp. 193–205. Springer, Cham (2022). https://doi.org/10.1007/978-3-031-11644-5_16

- Sengupta, S., Das, A.K.: Automated mapping of course outcomes to program outcomes using natural language processing and machine learning. In: 2023 IEEE 3rd Applied Signal Processing Conference (ASPCON), pp. 44–48 (2023). https://doi.org/10.1109/ASPCON59071.2023.10396272

- Alshanqiti, A., Alam, T., Benaida, M., Namoun, A., Taleb, A.: A rule-based approach toward automating the assessments of academic curriculum mapping. IJACSA 11 (2020). https://doi.org/10.14569/IJACSA.2020.0111285

- Russell E., W.: Mapping curricula to skills and occupations using course descriptions. In: 2024 IEEE World Engineering Education Conference (EDUNINE), pp. 1–6 (2024). https://doi.org/10.1109/EDUNINE60625.2024.10500452

- McLaren, B.M., et al.: Community college information technology education: curriculum mapping, a learning science framework, and AI learning technologies (2024)

- Zamecnik, A., Barthakur, A., Wang, H., Dawson, S.: Mapping employable skills in higher education curriculum using LLMs. In: Ferreira Mello, R., Rummel, N., Jivet, I., Pishtari, G., Ruipérez Valiente, J.A. (eds.) Technology Enhanced Learning for Inclusive and Equitable Quality Education. pp. 18–32. Springer, Cham (2024). https://doi.org/10.1007/978-3-031-72312-4_2

- Sridhar, P., Doyle, A., Agarwal, A., Bogart, C., Savelka, J., Sakr, M.: Harnessing LLMs in curricular design: using GPT-4 to support authoring of learning objectives (2023). http://arxiv.org/abs/2306.17459. https://doi.org/10.48550/arXiv.2306.17459

- Oliver, B.: Assuring graduate outcomes. In: The Australian Learning and Teaching Council (2011)

- Stewart, J., Shanmugam, S., Seenan, C.: Developing 21st century graduate attributes: incorporating novel teaching strategies in a physiotherapy curriculum. Eur. J. Physiotherapy. 18, 194–199 (2016). https://doi.org/10.1080/21679169.2016.1181205

- Treleaven, L., Voola, R.: Integrating the development of graduate attributes through constructive alignment. J. Mark. Educ. 30, 160–173 (2008). https://doi.org/10.1177/0273475308319352

- Johns-Boast, L.: Curriculum drift: a multi-dimensional perspective (2014)

- Dawson, S., Pardo, A., Salehian Kia, F., Panadero, E.: An integrated model of feedback and assessment: from fine grained to holistic programmatic review. In: LAK23: 13th International Learning Analytics and Knowledge Conference, pp. 579–584. ACM, Arlington TX USA (2023). https://doi.org/10.1145/3576050.3576074

- Siemens, G., Long, P.: Penetrating the fog: analytics in learning and education. EDUCAUSE Rev. 46, 30–32+ (2011)

- Yang, A.C.M., Chen, I.Y.L., Flanagan, B., Ogata, H.: From Human Grading to Machine Grading (2021)

- Nguyen, K.C., Zhang, M., Montariol, S., Bosselut, A.: Rethinking skill extraction in the job market domain using large language models (2024). http://arxiv.org/abs/2402.03832. https://doi.org/10.48550/arXiv.2402.03832

- Matkin, N., et al.: Comparative analysis of encoder-based NER and large language models for skill extraction from Russian job vacancies (2024). http://arxiv.org/abs/2407.19816. https://doi.org/10.48550/arXiv.2407.19816

- Zaki, N., Turaev, S., Shuaib, K., Krishnan, A., Mohamed, E.: Automating the mapping of course learning outcomes to program learning outcomes using natural language processing for accurate educational program evaluation. Educ. Inf. Technol. 28, 16723–16742 (2023). https://doi.org/10.1007/s10639-023-11877-4

- Harvey, A., Kamvounias, P.: Bridging the implementation gap: a teacher-as-learner approach to teaching and learning policy. High. Educ. Res. Dev. 27, 31–41 (2008). https://doi.org/10.1080/07294360701658716

- Hughes, C., Barrie, S.: Influences on the assessment of graduate attributes in higher education. Assess. Eval. High. Educ.Eval. High. Educ. 35, 325–334 (2010). https://doi.org/10.1080/02602930903221485

- Jiang, Y., Xiao, F.: Intelligent optimization of curriculum system based on Washington accord graduate attribute. In: 2020 IEEE 9th Joint International Information Technology and Artificial Intelligence Conference (ITAIC), pp. 1815–1821 (2020). https://doi.org/10.1109/ITAIC49862.2020.9339107

- Lai, J.W., Zhang, L., Chan, Y.S., Sze, C.C., Lim, F.S.: Compelling educational offerings: a study on the efficacy of skills identification platforms with course descriptions. In: INTED2024 Proceedings, pp. 2553–2561 (2024). https://doi.org/10.21125/inted.2024.0709

- Ketamo, H., Moisio, A., Passi-Rauste, A., Alamäki, A.: Mapping the future curriculum: adopting artificial intelligence and analytics in forecasting competence needs. http://www.theseus.fi/handle/10024/172083. Accessed 10 Jun 2024

- Herandi, A., Li, Y., Liu, Z., Hu, X., Cai, X.: Skill-LLM: repurposing general-purpose LLMs for skill extraction (2024). http://arxiv.org/abs/2410.12052. https://doi.org/10.48550/arXiv.2410.12052

- Meron, Y., Tekmen Araci, Y.: Artificial intelligence in design education: evaluating ChatGPT as a virtual colleague for post-graduate course development. Des. Sci. 9, e30 (2023). https://doi.org/10.1017/dsj.2023.28

- Nyale, D., Karume, S., Kipkebut, A.: A comprehensive analysis of the role of artificial intelligence in aligning tertiary institutions academic programs to the emerging digital enterprise. Educ. Inf. Technol. (2024). https://doi.org/10.1007/s10639-024-12743-7

- Singh, D., Morkel, J.D.: Holistic student development powering the student journey: a model for graduate attributes, curriculum, and the second transcript. CE 15, 1784–1795 (2024). https://doi.org/10.4236/ce.2024.159109

- Krippendorff, K.: Computing Krippendorff’s Alpha-Reliability (2011)

- Marzi, G., Balzano, M., Marchiori, D.: K-Alpha calculator–Krippendorff’s alpha calculator: a user-friendly tool for computing Krippendorff’s Alpha inter-rater reliability coefficient. MethodsX. 12, 102545 (2024). https://doi.org/10.1016/j.mex.2023.102545

- Hughes, J.: krippendorffsalpha: An R Package for Measuring Agreement Using Krippendorff’s Alpha Coefficient (2021). http://arxiv.org/abs/2103.12170. https://doi.org/10.48550/arXiv.2103.12170

- Devlin, J., Chang, M.-W., Lee, K., Toutanova, K.: BERT: pre-training of deep bidirectional transformers for language understanding (2019). http://arxiv.org/abs/1810.04805. https://doi.org/10.48550/arXiv.1810.04805

- Kerby, D., Romine, J.: Develop oral presentation skills through accounting curriculum design and course-embedded assessment. J. Educ. Bus. 85, 172–179 (2009). https://doi.org/10.1080/08832320903252389

- Apostolou, B., Dull, R.B., Schleifer, L.L.F.: A framework for the pedagogy of accounting ethics. Acc. Educ. 22, 1–17 (2013). https://doi.org/10.1080/09639284.2012.698477

- Riebe, L., Jackson, D.: The use of rubrics in benchmarking and assessing employability skills. J. Manag. Educ.Manag. Educ. 38, 319–344 (2014). https://doi.org/10.1177/1052562913511437

更多推荐

已为社区贡献79条内容

已为社区贡献79条内容

所有评论(0)