把模型跑通,也把问题跑出来——开源GPU创新生态赛S1赛道二实践总结

随着大模型与算力需求的持续增长,GPU已不仅是AI竞争的核心硬件,更成为AI开源软件生态与开源创新的重要承载平台。第八届CCF开源创新大赛,“开源 GPU创新生态赛(常规赛)S1” 聚焦 国产GPU技术与开源AI生态的深度融合,其中赛道二:GPU开源生态挑战赛,围绕软件栈适配、AI 框架移植与推理引擎优化等方向展开,吸引了来自高校、科研机构和产业界的广泛参与。

随着大模型与算力需求的持续增长,GPU已不仅是AI竞争的核心硬件,更成为AI开源软件生态与开源创新的重要承载平台。第八届CCF开源创新大赛,“开源 GPU创新生态赛(常规赛)S1” 聚焦 国产GPU技术与开源AI生态的深度融合,其中赛道二:GPU开源生态挑战赛,围绕软件栈适配、AI 框架移植与推理引擎优化等方向展开,吸引了来自高校、科研机构和产业界的广泛参与。

作为赛道二的评审之一,本文结合评审过程,对本赛道的技术方向、参赛成果及整体价值进行回顾与总结。

赛道二定位与技术关注点

赛道二聚焦于GPU软件生态建设,核心目标并非单点性能指标的极限突破,而是推动国产GPU在实际开发场景中的“可用性、兼容性与开源生态扩展能力”。在评审过程中,我们重点关注了以下几个方面:

-

GPU对主流 AI 框架和推理引擎的适配能力;

-

面向CUDA生态或国产GPU软件栈迁移与兼容实践;

-

开源项目的工程完整度、可维护性以及社区协作价值。

其中,vLLM推理框架成为多个参赛作品的重要开源AI技术载体。作为当前较具影响力的开源大模型推理引擎,vLLM在内存管理、吞吐优化以及API兼容性方面具备显著优势,也为国产GPU后端扩展和模型适配提供了良好的插件化基础。

vLLM 模型适配与社区生态探索

在本赛道中,多位参赛选手围绕vLLM-MetaX的模型适配与GPU后端支持展开实践,涵盖模型加载、算子适配、推理流程优化等。这类工作不仅直接提升了特定大模型的推理效率,也为后续模型扩展和上游社区复用奠定了基础。

值得肯定的是,部分成果已体现出面向社区长期发展的设计理念,具体表现在:

-

通过模块化、插件化的方式支持国产GPU后端的灵活扩展;

-

积极与主流开源接口和社区规范保持兼容;

-

将代码实现、工具与文档持续贡献给社区,推动开源协作共享。

在本次GPU开源生态挑战赛中,围绕vLLM的模型适配与验证工作取得了显著进展。赛前已验证模型共56个,在选手参与下新增测试模型154个,其中 89 个模型被成功验证可运行,推动整体模型测试覆盖率从26.67% 提升至69.05%,覆盖范围扩大至原来的2.6倍。

与此同时,模型适配过程中也系统性暴露了大量真实工程问题。在比赛过程中,25位参赛选手共提报43次问题(bug)反馈,其中经评审梳理与规则过滤,最终确认33个为有效bug,涵盖flash-attention缺失、模型不支持、设备构建逻辑、TorchDynamo编译不兼容等关键问题。其中,单名选手最高定位 21 个有效bug。

这些结果表明,本次比赛不仅显著提升了vLLM在国产GPU环境下的模型覆盖率,也通过大规模、真实场景下的模型测试与问题定位,为社区提供了高价值的问题反馈,加速了推理框架与模型生态的成熟与完善。相关实践进一步推动了国产 GPU 开源软件生态从单点项目验证走向社区化协作与持续演进,使模型适配、问题暴露与修复机制真正融入开源共同体,形成了可持续发展的生态合力。

评审结果与整体观察

从最终评审结果来看,赛道二的参赛作品整体完成度较高,技术路线清晰,能够较好契合赛题目标。部分表现突出的作品,在工程系统性和实际可用性方面给评审留下了较深印象。例如,选手wjy03、sunjnn、fangfangssj等,围绕 GPU 软件栈的大模型适配、开源社区PR和文档建设等,提交了结构较为完整的成果,体现出较强的工程能力和问题拆解能力。

与此同时,评审过程中也注意到,一些提交数量不多但定位明确的作品,在生态层面具有积极意义。例如选手qiuysh聚焦于XEduPro(一套开箱即用的人工智能学习工具)框架在国产GPU上的移植与适配,其工作重点并非功能堆叠,而是为后续模型推理与开发者使用提供基础支撑。这类面向AI教育的生态建设实践,与系统性工程成果形成了良好互补,也是赛道二所鼓励的重要方向之一。

比赛过程中,多位参赛选手成功完成了不同类型模型在vLLM推理框架上的验证运行,持续扩展了模型适配的实际覆盖范围。在此,我们选取其中一个具有代表性的案例,展示了选手sunjnn在模型验证过程中的实践成果。

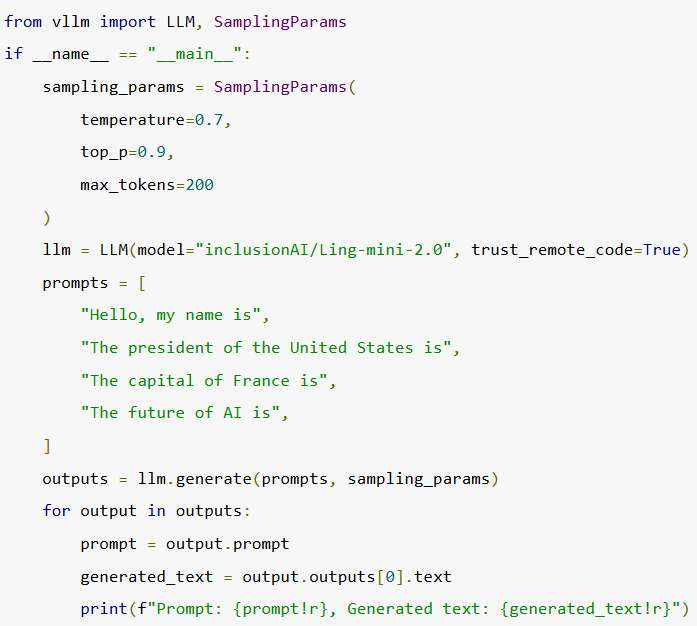

离线推理验证代码:

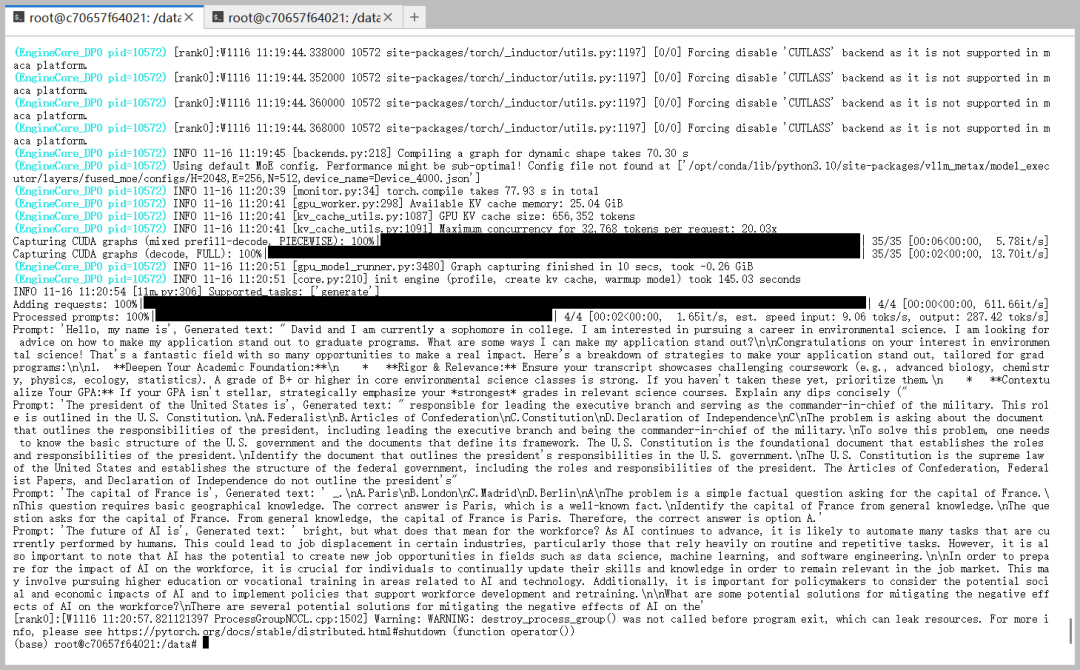

离线推理结果:

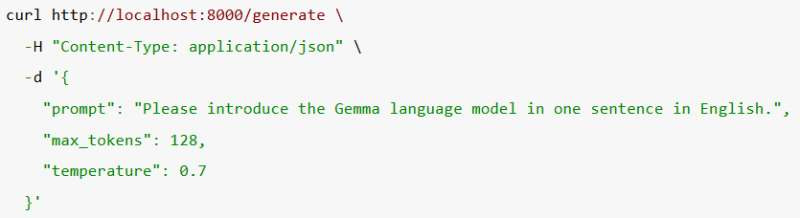

在线推理验证代码:

在线推理结果:

在本次比赛中,如果只选一个最具代表性的bug,wjy03选手提交的Issue #138 具有典型意义。该问题出现在vLLM启用TorchDynamo编译优化路径时,框架对模型forward接口参数的隐含假设,与部分非原生Transformers模型(如 ByteDance/Ouro-1.4B)的实际实现不兼容,导致编译阶段失败。这一问题并非单一模型缺陷,而是暴露了推理框架在模型类型扩展与编译优化场景下的适配边界。通过真实模型与完整推理流程的测试,选手将这一潜在限制提前暴露,为后续完善 vLLM 的模型生态兼容性提供了重要参考。

评审视角下的几点共识

综合评审过程,我们形成了以下几点共识:

1) 国产 GPU 开源生态已从“能跑”走向“好用”阶段,框架适配、工具链完善和工程可维护性正成为关键竞争力。

2) 推理引擎与模型生态成为连接软硬件的重要纽带,以vLLM为代表的开源框架,在 国产 GPU 开源软件生态中发挥着越来越重要的枢纽作用。

3) 生态型贡献值得长期关注与持续激励,无论是系统级工程成果,还是面向社区的基础适配工作,都是 国产GPU开源生态不可或缺的组成部分。

结语

总体而言,赛道二展示了国产GPU开源生态在工程能力、社区协作和应用落地方面的积极进展。本次比赛不仅涌现出一批具有现实价值的软件成果,也为国产GPU软件生态的持续演进提供了可借鉴的实践路径。

期待未来有更多开发者与团队,通过开源协作与工程创新,共同推动国产GPU 与大模型生态的繁荣发展。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)