Windows 下 Flash Attention “the provided PTX was compiled with an unsupported toolchain” 错误全面解决笔记

【摘要】本文针对Windows系统下RTX30/40系列显卡用户在使用FlashAttention2.x时出现的"the provided PTX was compiled with an unsupported toolchain"错误,提供了2026年1月最新解决方案。主要问题源于NVIDIA驱动对PTX版本检查更严格导致的兼容性问题。文章推荐三种优先级解决方案:1)首选降

Windows 下 Flash Attention “the provided PTX was compiled with an unsupported toolchain” 错误全面解决笔记(2026年1月版)

写给所有 Windows + RTX 30/40 系列用户 日期:2026年1月8日

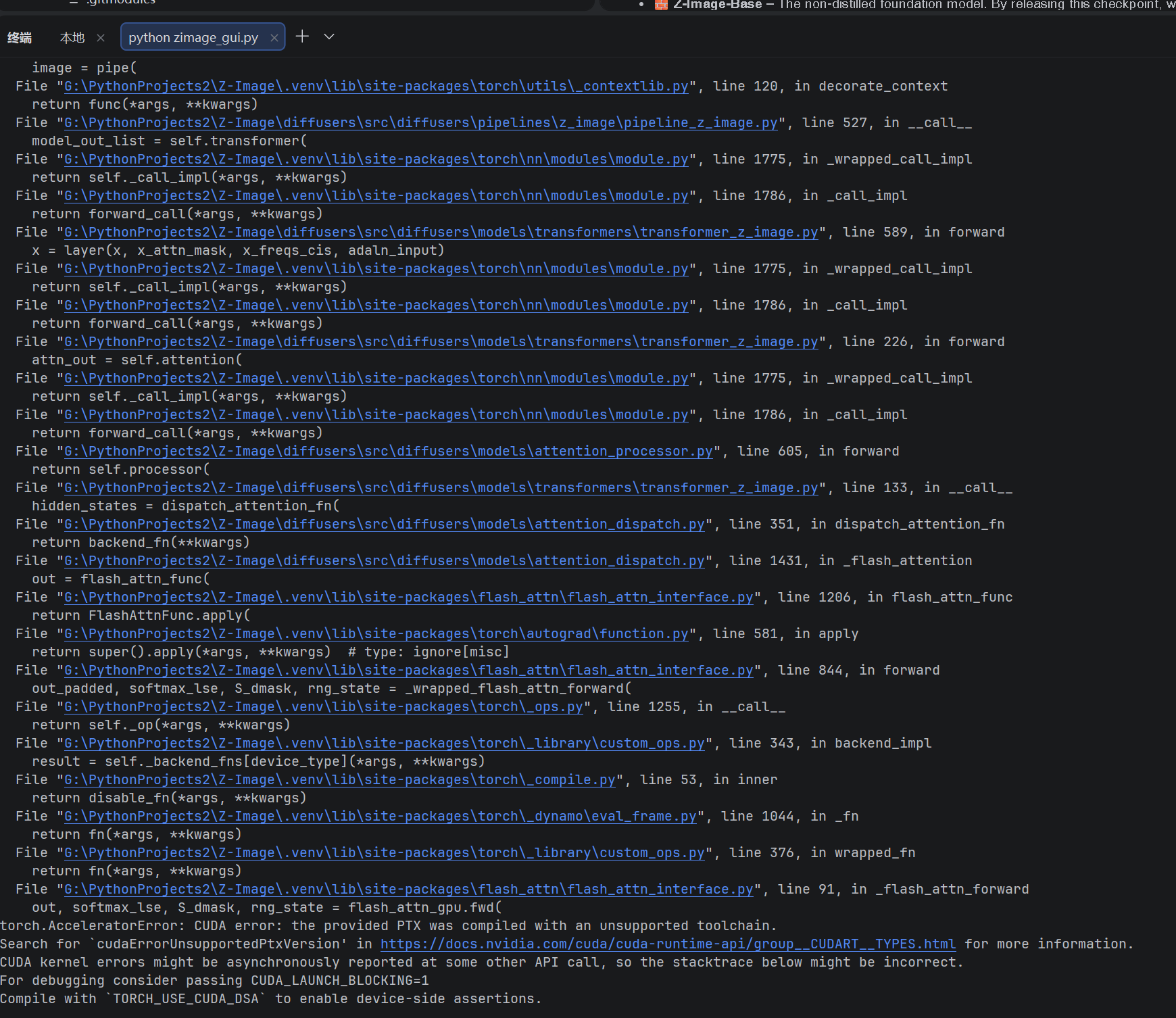

如果你在使用 Z-Image、Stable Diffusion 或其他依赖 Flash Attention 2.x 的项目时,模型加载正常(甚至提示 “✅ 已成功启用本地 Flash Attention 加速!”),但第一次生成图像就崩溃,报错如下:

……

torch.AcceleratorError: CUDA error: the provided PTX was compiled with an unsupported toolchain.

Search for `cudaErrorUnsupportedPtxVersion' in https://docs.nvidia.com/cuda/cuda-runtime-api/group__CUDART__TYPES.html for more information.

CUDA kernel errors might be asynchronously reported at some other API call, so the stacktrace below might be incorrect.

For debugging consider passing CUDA_LAUNCH_BLOCKING=1

Compile with `TORCH_USE_CUDA_DSA` to enable device-side assertions.别慌!这不是你的代码或模型问题,而是2025年底到2026年初 Windows 用户最常见的 Flash Attention 兼容性坑,这个错误绝大多数情况下是 Flash Attention 相关的!我(RTX 3090 用户)亲身踩过无数次,下面直接给你最实用的解决方案——从最简单、最安全的开始,不让你猜。

我的环境示例参考

- OS:Windows 11 专业工作站版

- GPU:NVIDIA RTX 3090 (Compute Capability 8.6, 24GB VRAM)

- CPU:Intel Core Ultra 9 285K

- RAM:128 GB

- Python:3.10.18 (.venv 虚拟环境)

- PyTorch:2.9.1+cu130

- CUDA Toolkit:13.1 (完整安装)

- Visual Studio:2022 Professional (带 C++ 桌面开发工作负载)

- ninja:已安装 (pip install ninja)

背景与现象

- 常见环境:Windows 11 + RTX 3090/4090 + PyTorch 2.9.x + CUDA Toolkit 13.x + Flash Attention 2.8.3

- 现象:加载模型正常,生成时崩溃,栈指向 flash_attn_func。

- 影响:无法使用 Flash Attention 高效加速,fallback 到慢速实现或直接报错。

报错原因分析

这个错误的核心是 Flash Attention 生成的 PTX(CUDA kernel 中间代码)与当前 NVIDIA 驱动不兼容:

- 驱动检查更严格:2026年初的新驱动(R560+ 系列,即使你没手动升级,系统补丁可能引入)对 PTX 的“toolchain 版本”(编译 flag 和元数据)检查更严。

- 仓库更新影响:Flash Attention 2025年12月更新(AMD ROCm 支持)间接改变了 kernel 编译参数,新编译的 wheel PTX 容易被拒。

- 版本不匹配:PyTorch CUDA 运行时、系统 CUDA Toolkit、驱动支持版本三者不一致,导致 PTX “太新”或“太旧”。

一句话:新环境编译的 wheel PTX 被驱动“嫌弃”,旧稳定 wheel 通常正常。

第一步:快速检查你的环境

打开 CMD:

nvcc --version # 系统 CUDA Toolkit 版本

nvidia-smi # 驱动支持的最高 CUDA 版本

python -c "import torch; print(torch.version.cuda); print(torch.cuda.is_available())" # PyTorch CUDA 版本兼容原则(避免坑的关键)

一句话小结: 强烈建议系统安装的 CUDA Toolkit 版本与虚拟环境中 PyTorch 的 CUDA 运行时版本保持一致(或 Toolkit 略高),避免跨大版本使用——太新或太旧都容易引发兼容性问题。优先选择社区经验证的稳定组合。

示例说明:

- 如果系统安装了 CUDA Toolkit 13.1,虚拟环境中使用 PyTorch +cu130(CUDA 13.0)通常兼容良好;

- 但如果使用 PyTorch +cu129(CUDA 12.9)或更低,跨大版本(13.1 → 12.9)大概率会出现 PTX toolchain 不兼容或其他隐蔽问题。

- 反之,如果 Toolkit 是 12.4,却用 PyTorch +cu130,也可能因“toolchain 太新”被驱动拒绝。

推荐稳定组合(2026年1月经验证):

- CUDA Toolkit 13.1 + PyTorch 2.9.1+cu130(需自己编译)

- CUDA Toolkit 12.8 + PyTorch 2.9.1+cu128(有社区 wheel 文件可用)

- 或驱动支持的最高版本 + 匹配的 Toolkit/PyTorch

解决方案(直接上手,按优先级推荐)

首选方案:降级虚拟环境 PyTorch + CUDA 版本,安装社区预编译 wheel(最推荐,大多数人适用)

由于我的组合较新(PyTorch 2.9.1+cu130),社区 wheel 很少覆盖——大多数 wheel 针对旧稳定组合(如 cu121/cu124 + torch2.4/2.5)。

操作:

- 卸载当前 torch:

pip uninstall torch torchvision torchaudio -y - 安装旧稳定 CUDA PyTorch(例如 cu124 + torch2.5,社区 wheel 多):

pip install torch==2.5.0 torchvision==0.20.0 torchaudio==2.5.0 \ --index-url https://download.pytorch.org/whl/cu124 --force-reinstall - 卸载旧 flash-attn,安装社区 wheel:

pip uninstall flash-attn -y

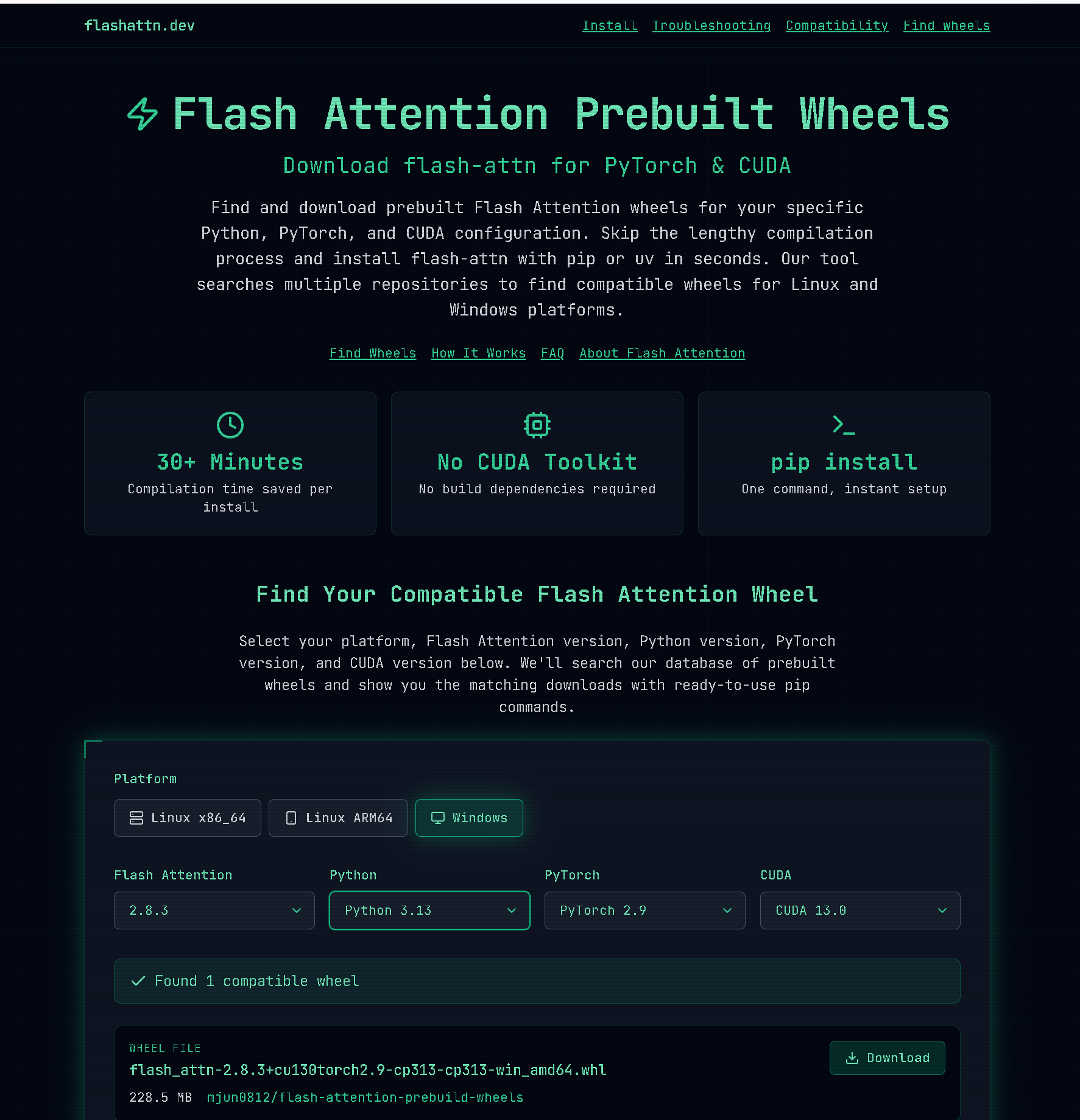

推荐社区 wheel 下载链接(2026年1月活跃):

- https://huggingface.co/lldacing/flash-attention-windows-wheel/tree/main (支持多种 cu121/cu124等)

- https://flashattn.dev/ (官方推荐,选匹配版本)

选择文件名带 +cu124torch2.5 或类似旧组合的 wheel,直接 pip install。

为什么首推:无需编译,秒装;社区 wheel 已验证兼容旧驱动检查。

次选方案:降级系统 CUDA Toolkit + 统一版本,再用社区 wheel

如果首选没匹配 wheel,或想保持统一:

- 卸载当前 CUDA Toolkit(控制面板 → 程序和功能)。

- 安装旧版(如 CUDA 12.4):https://developer.nvidia.com/cuda-12-4-0-download-archive

- 更新环境变量(CUDA_HOME + PATH)。

- 虚拟环境安装匹配 PyTorch(如 +cu124)。

- 安装对应社区 wheel。

风险警示:系统级改动,可能影响其他项目(旧项目用新 CUDA 会崩溃)。建议备份系统或用虚拟机测试。

最后方案:本地编译(较新组合专用,上手难度大)

Windows 下成功编译 Flash Attention 2.8.3 (flash-attn /flash_attn)个人复盘记录

如果你的组合太新(cu130),社区 wheel 少,只能自己编译。但 CUDA Toolkit 有一定向下兼容(非跨大版本),成功率较高。

用 v2.8.3 tag 编译(详见我的另一笔记),或加 flag 尝试。

Flash Attention 2.8.3 在 Windows + RTX 3090 上成功编译与运行复盘笔记(2026年1月版)

风险:编译失败率高(路径、VS 配置坑多),新编译 PTX 仍可能被拒。

方案对比表格

| 方案优先级 | 方案描述 | 操作难度 | 风险级别 | 适用场景 | 推荐指数 |

|---|---|---|---|---|---|

| 首选 | 降级虚拟环境 PyTorch + CUDA,装社区 wheel | 低 | 低(仅虚拟环境) | 大多数用户(社区 wheel 多) | ★★★★★ |

| 次选 | 降级系统 CUDA Toolkit + 统一版本 | 高 | 高(系统级改动) | 想长期统一版本,用户少 | ★★★ |

| 最后 | 本地编译新 wheel | 高 | 中(可能仍报错) | 较新组合,无匹配 wheel | ★★ |

| 临时应急 | set ATTENTION_BACKEND=sdpa | 极低 | 无 | 立即生成图像,速度略慢 | ★★★★ |

Z-Image-Turbo 项目 Windows 下从 CPU-only 到完整 CUDA + Flash Attention 部署教程(2026年1月回忆版)

临时应急(立即生成图像)

set ATTENTION_BACKEND=sdpa

python zimage_gui.py速度仍快,零风险。

总结

这个错误本质是“版本兼容性坑”,首选降级虚拟环境 PyTorch 用社区 wheel(最稳、最快)。次选系统级统一(慎重)。本地编译放最后(难度大)。

免责声明:以上方案基于个人经验和社区反馈,仅供参考。操作前备份环境,系统级改动(如降级 CUDA Toolkit)可能导致其他项目不兼容或系统问题,作者不承担任何责任。请根据自身情况谨慎操作。

解决后,Flash Attention 加速会让你爱不释手!有问题评论区交流~🚀

更多推荐

已为社区贡献62条内容

已为社区贡献62条内容

所有评论(0)