大模型突破“玻璃杯中之脑“:MCP如何让AI真正连接物理世界

大模型正从"智力内卷"转向"基础设施交接",通过MCP协议实现与物理世界的连接。MCP作为"万能USB接口",经历了从只读到工具调用再到感官流打通的进化,使大模型拥有了"手"、"眼"、"耳"。这种架构逆转让大模型成为客户端,物理设备成为服务端,实现"专家会诊"模式。未来,App将弱化为底层接口,人类通过Agent直接调度后端能力,大模型的终点是真正"连接世界"。

大模型正从"智力内卷"转向"基础设施交接",通过MCP协议实现与物理世界的连接。MCP作为"万能USB接口",经历了从只读到工具调用再到感官流打通的进化,使大模型拥有了"手"、“眼”、“耳”。这种架构逆转让大模型成为客户端,物理设备成为服务端,实现"专家会诊"模式。未来,App将弱化为底层接口,人类通过Agent直接调度后端能力,大模型的终点是真正"连接世界"。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

一场真正的技术革命,往往不是从更炫目的能力开始的,而是从“终于连上世界”的那一刻开始。

导语:一场被低估的“基建交接”

2025 年 12 月,AI 圈发生了一件看似不起眼、实则未来可能影响深远的事。

一边是模型参数的疯狂内卷:DeepSeek V3.2 在 12 月 1 日发布,不仅把推理成本打到了地板价,更整合了复杂的工具使用和思考模式;Google 的 Gemini 3 Flash 紧随其后,以极低的成本实现了媲美前沿模型的性能;而 OpenAI 的 GPT-5.2 则在基准测试上再次封顶。

但就在大家盯着“智商”卷的时候,Anthropic 做了一个反常的决定:将 MCP(Model Context Protocol)正式捐赠给 Linux 基金会。

11 月 25 日,MCP 发布了周年规格更新,优化了多模态支持;12 月 10 日,Google Cloud 宣布官方支持 MCP 接入。这一系列动作标志着 AI 从单纯的“脑力内卷”转向了“基础设施交接”。

这件事的重要性,可能远高于又一个 SOTA(State of the Art)。因为它触碰的不是“模型有多聪明”,而是一个更底层的问题:

大模型,终于有可能真正接触到物理世界了。

一、困境:被困在云端的“玻璃杯中之脑”

今天的大模型已经足够聪明。但作为一个工程师,也会时常感到一种深深的“无力感”。

这些天才般的大模型,能在一秒内推导数学证明,能写出核反应堆代码,却被困在云端服务器里。它们就像“高位截瘫”的天才:

- 它们不知道你此刻房间是冷是热,也没法帮你关掉台灯。

- 即便有了 Agent(智能体),它们依然是在“数字孤岛”里打转。会话一关,记忆和动态状态就会消失,一切归零。

人们曾寄希望于“具身智能”(如特斯拉 Optimus或者智元或者宇树的机器人),但现实很骨感:机器人太贵、迭代太慢。2025 年,人形机器人仍处于原型阶段。

难道在机器人普及前的这之前的时间,大模型只能陪我们聊聊天吗,一直待在互联网世界吗?

二、真正的转折:连接方式的革命

AI 接管现实世界的瓶颈不在智力,而在连接方式。MCP 的出现,提供了一根连接物理设备的“神经线”。

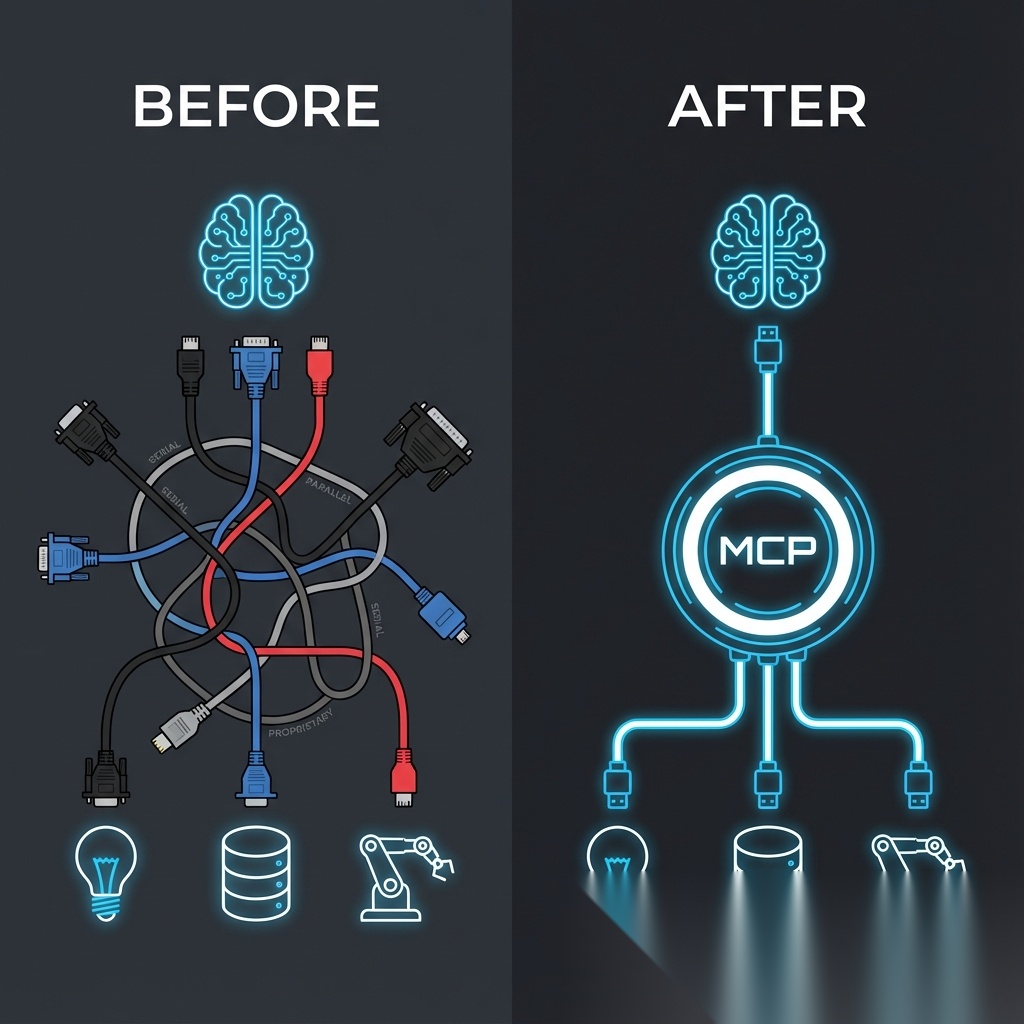

很多人低估了 MCP,是因为把它当成了一个普通 API。但更准确的理解是:MCP 是数字世界的“万能 USB 接口”。

回想一下 USB 之前:鼠标是圆口的,打印机是并口的。每接一个新设备都是一场驱动灾难。以前大模型也如此:控制灯得写一套 API,控制冰箱得写另一套。这种 N×M 的复杂度,锁死了 AI 的手脚。

MCP 制定了标准。为了实现这次“突围”,它经历了三个关键的进化阶段:

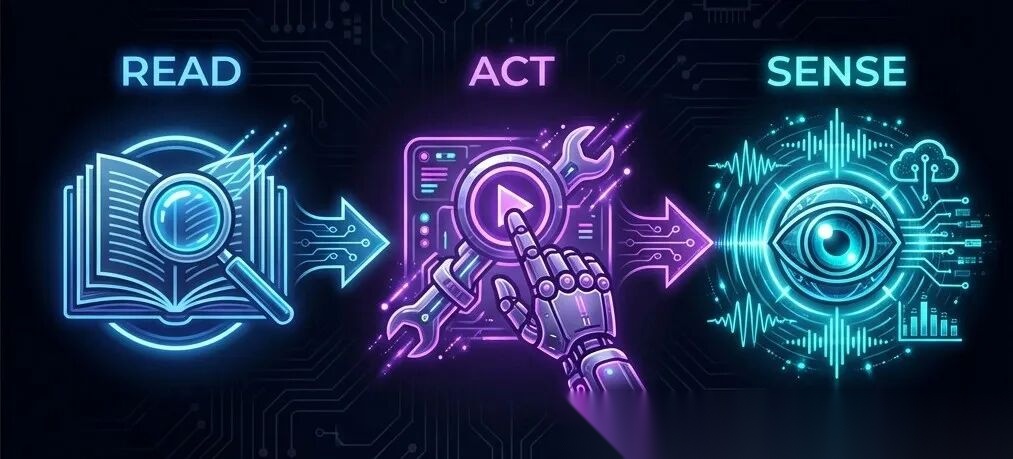

1. 第一阶段:只读世界 (Text & Resources)

最初的 MCP 让模型读取 GitHub 代码或数据库表格。此时模型只是“阅读者”。2025 年 6 月,该阶段加强了 OAuth 授权规范,提升了安全性。他就像手机时代最开始大家频繁的发短信一样,来回往返沟通。

2. 第二阶段:工具调用标准化 (Tools & Functions)

MCP 加入了 Tool Use 规范。模型不再只是“建议”,而是发出标准化指令。设备端 MCP Server 收到 JSON 指令并翻译成电压或数字信号。此时,它有了“手”。 目前社区已有数千个 MCP Server 实现,覆盖了从 IoT 到机器人的各种设备。他就像4G时代大家开始发微信了,什么格式都开始有了。

3. 第三阶段:感官流打通 (Sampling & Streaming)

最新的突破。现在的 MCP 支持采样和流式传输。摄像头画面、麦克风声音可以直接通过这条“线”传给 Gemini 3 这样的多模态模型。此时,它有了“眼睛”和“耳朵”。他就像现在他可以语音、视频等无所不能了。

三、架构的艺术:模型不再是中心

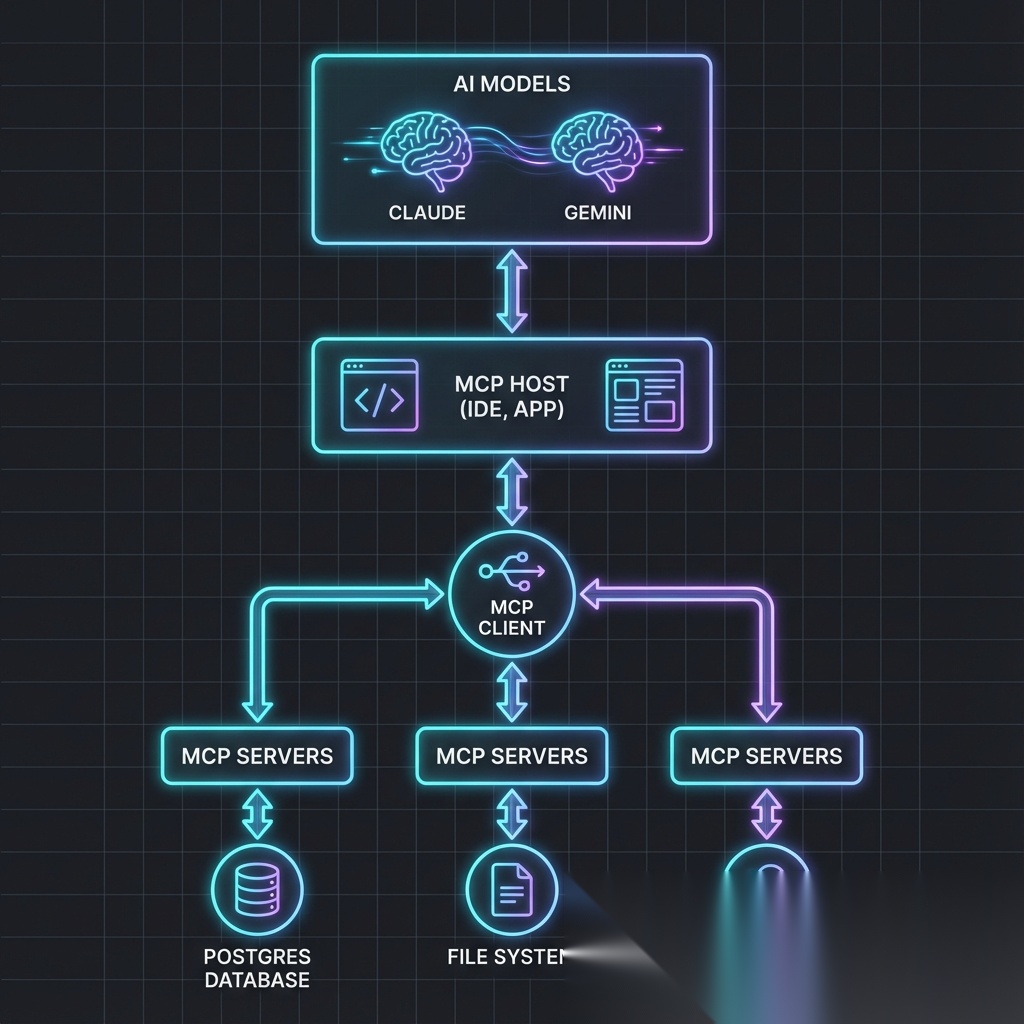

MCP 定义了一套清晰的架构:

在这套架构里,有一个被大多数人忽略的角色反转:

大模型和 Agent 变成了 Client(客户端);而物理设备和外部系统成了 Server(服务端)。

物理设备不再是等待被理解的对象,而是主动暴露能力的“服务节点”。AI 并不是统治物理世界,而是学会了调度它。目前,OpenAI 已在 3 月宣布将 MCP 全面集成到其 Agents SDK 中。

四、场景推演:从“黑灯工厂”到全屋智能

现实世界的问题是复杂的,未来不再是单一模型包打天下,而是通过 MCP 实现的“专家会诊”模式。

🏭 场景一:真正的“黑灯工厂”

在 OpenServAI 与 Arduino MCP 集成的案例中,我们看到了自动化供应链的雏形:

- 感知层:传感器通过 MCP 实时上传震动、温度数据。

- 决策层:工业模型发现轴承异常。

- 行动层:模型通过 MCP 直接调用机床接口降速,并指挥 AGV 小车送备件。

整个过程在毫秒级完成,是数据驱动了物理实体,而非人类操作员。

🏠 场景二:把家变成“巨大的机器人”

别再满足于语音喊“Hi Siri”。在 Home Assistant 等平台集成 MCP 后(包括 Ecovacs 等设备的 Server):

推门进屋,感叹一句“累死了”。

- 感知:麦克风发现疲惫,视觉发现瘫坐。

- 决策:Agent 判定需要休息。

- 执行:自动调低灯光,让空调转入静音,甚至电饭煲开始工作。

我们没有下达指令,但房间“读懂”了你。

🏥 场景三:有温度的适老化

当毫米波雷达监测到老人滑倒,Agent 瞬间判断风险,调用“电话 MCP”报警,同时开启“门锁 MCP”等待救护,整个过程无需老人进行任何复杂操作。

五、终局:App 不会消失,但会“隐形”

未来,App 将会“弱化”为功能的接口(API / MCP Server)。

交互路径从

人 -> 找 App -> 点按钮

进化为

人 -> 告诉 Agent -> Agent 调度后端能力

当你对 Agent 说“打车去公司”,它会在后台通过 MCP 握手滴滴的云端服务,规划路线。你全程可能根本看不到滴滴的界面。 App 变成了像水电煤一样的底层基建。智谱 AutoGLM 2.0 和字节豆包手机助手正加速这一过程。

大模型的这场突围,终点是“连接世界”。

人们不需要几百万的实验室,一台运行本地模型的电脑,和几块几十块钱的 ESP32 开发板。GitHub 上 awesome-mcp-servers 已经有了超过 7000 个项目供你挑选。

未来的机会,属于敢于打破“屏幕边界”的人。

未来不会突然到来,你也学可以尝试让AI接管你你家灯光开始让AI第一次“理解”和接管这个物理世界。

CSDN独家福利

最后,感谢每一个认真阅读我文章的人,礼尚往来总是要有的,下面资料虽然不是什么很值钱的东西,如果你用得到的话可以直接拿走:

更多推荐

已为社区贡献87条内容

已为社区贡献87条内容

所有评论(0)